- 1武汉科技大学自动控制原理2007_武汉科技大学各专业历年考研专业课真题汇编...

- 2微信小程序| 打造ChatGPT英语四六级背单词小程序_小程序搭建chatapp

- 3yolov8 tracking编码为web 和 rtsp流输出_yolov8 rtsp

- 4Spring Boot 快速实现 IP 地址解析!_springboot获取ip地址

- 5wsl装ubuntu的home目录在哪,如何更改home?_wsl ubuntu 安装路径

- 6react+ echarts 轮播饼图

- 7人机协同的“星火”,何时能有燎原之势?

- 8数据结构学习(考研408)

- 9remix Web3 provider连接不上探究_remix没有web3

- 10报错解决error: OpenCV(4.8.0) D:\a\opencv-python\opencv-python\opencv\modules\highgui\src\window.cpp:1255_error: opencv(4.9.0) d:\a\opencv-python\opencv-pyt

GPU(国内外发展,概念参数(CUDA,Tensor Core等),类别,如何选型,NPU,TPU)_gpu服务器主要型号

赞

踩

目录

前言

从目前的市场看,人工智能(大模型)发展的快慢主要取决于算力,其次是算法。而算力又受限于GPU。

1.国内外GPU发展简述

预计到2030年,GPU市场将从现在的几百亿美元规模成长至数千亿美元规模。而当下GPU市场全面被国外垄断,其中桌面级GPU市场被英伟达、AMD和英特尔所垄断,移动级GPU市场被Arm、Imagination和高通所垄断。

随着国际对抗加剧,美国亚脱钩政策频频,2022年8月,美国政府出台新政策,禁止美国公司向中国出高端GPU和其他制造设备。国内现在买不到如NVIDIA的A100 H100等高端GPU。英伟达针对禁令做了应对措施,推出了A100/H100的阉割版本,A800、H800 GPU,主要是在NVLink模式下的带宽从600GB/s下降到400GB/s,其他参数均保持致。我今年3月份问价A800服务器价格在110万/台,6月现货价格在135万/台,期货130万每台,还需要全款后2月内交付。三季度又放出A800停止发货消息,芯片之争愈演愈烈。

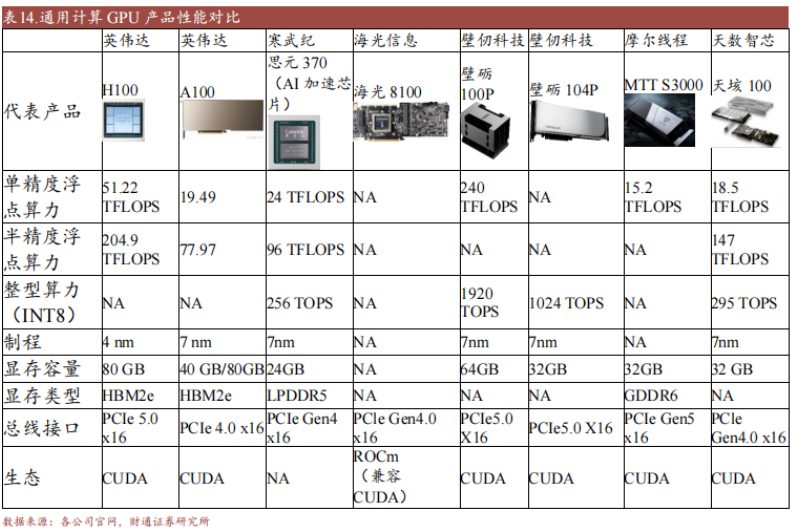

在此背景下,国内也加快了国产替代进程,但目前相比主流产品,国产GPU还处于起步阶段。受限于工艺制程、EDA等技术封锁,国内厂商目前在自主研发领域的成果与国际一流水平还有着很大的差距。但随着国内自研GPU的领军企业景嘉微、壁仞科技、芯动科技等逐渐崭露头角,各厂家已发展出了一系列的产品线,并且均采用国内成熟制程工艺及自主架构。

GPU的研发并不是立竿见影,我们要做好苦战的准备,也要避免好高骛远,夸大宣传。科工力量曾指出,为了在宣传中超越英伟达,国产GPU存在田忌赛马式比拼,如某款标榜超越国际旗舰级算力的GPU,却不支持双精度浮点运算,只能用于人工智能方向,短期选择局部突破或是无奈之举,长远而言,还是应该全面超越。。

从短期来看,人工智能的快速发展离不开高端GPU算力的支持,美国的限制政策给予我国一定压力,但长远来看,只有攻克芯片行业,才能不受制于人,真正在人工智能的革命中站稳脚步、引领潮流。

2.GPU概念参数和选择标准

概念:GPU又叫做图形处理器,专门设计用于处理计算机图形和图像的处理器。它可以加速计算机图形渲染和处理操作,提高计算机图形和图像的性能和质量。此外,理解GPU指的是负责处理各种任务的那颗芯片,显卡指的是把GPU芯片、显存、接口等集合在一起的那张板卡。

GPU和CPU:GPU具有更多的处理单元和更高的并行处理能力,因此可以更快地处理大量的图形和图像数据。但GPU无法单独工作,需要依赖CPU控制调用。参考

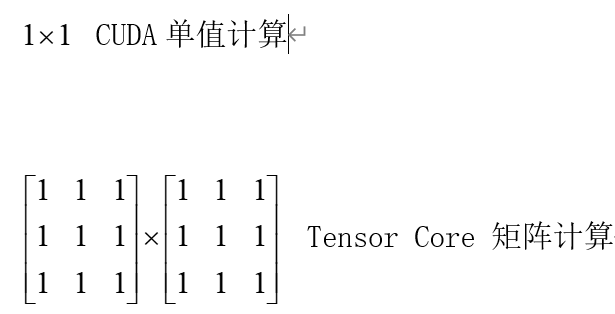

2.1 CUDA

2006年NVIDIA推出以CUDA为核心的GPU,拉开了一个时代的序幕。CUDA是一种通用并行计算架构,而深度学习,强化学习需要大量且复杂的计算,CUDA的架构大大提高了运算速率,而且CUDA核心数量越多并行计算的能力越大,简单理解,之前需要一年的计算量,CUDA推出之后仅需一天。

2.2 Tensor Core

2017年引入Tensor Core,为大模型的出现奠定了坚实的基础,这也是专为深度学习所设计。深度学习所采用的核心计算主要由张量和矩阵组成,而Tensor Core为了他们专门设计了执行单元,Tensor Core在训练方面能够提供高达12倍的teraflops(兆亿浮点计算) 峰值,而在推理方面则可提供6倍的leraflops(兆亿浮点计算)峰值。每个Tensor Core在每个时钟周期可执行64次浮点混合乘加 (FMA) 运算。Tensor Core使用的计算能力要比Cuda Core高得多。

补充:FLOPS,即每秒浮点运算次数(亦称每秒峰值速度)是每秒所执行的浮点运算次数,被用来评估电脑性能,尤其是在使用到大量浮点运算的科学计算领域中。

图1 CUDA和Tensor Core计算区别

2.3 显存容量和显存位宽

显存容量:其主要功能就是暂时储存GPU要处理的数据和处理完毕的数据。显存容量决定了我们一次读入显卡进行运算的数据多少(batch size)和我们能够搭建的模型大小(网络层数、单元数),是对深度学习研究人员来说很重要的指标

显存位宽:显存在一个时钟周期内所能传送数据的位数,位数越大则瞬间所能传输的数据量越大,这是显存的重要参数之一。

2.4 精度

半精度:如果对运算的精度要求不高,那么就可以尝试使用半精度浮点数进行运算。这个时候,Tensor核心就派上了用场。Tensor Core专门执行矩阵数学运算,适用于深度学习和某些类型的HPC。Tensor Core执行融合乘法加法,其中两个4*4 FP16矩阵相乘,然后将结果添加到4*4 FP16或FP32矩阵中,最终输出新的4*4FP16或FP32矩阵。NVIDIA将Tensor Core进行的这种运算称为混合精度数学,因为输入矩阵的精度为半精度,但乘积可以达到完全精度。Tensor Core所做的这种运算在深度学习训练和推理中很常见。

单精度: Float32 是在深度学习中最常用的数值类型,称为单精度浮点数,每一个单精度浮点数占用4Byte的显存。

双精度:双精度适合要求非常高的专业人士,例如医学图像,CAD。

2.5 如何选择GPU

卷积网络和Transformer:Tensor核心数>单精度浮点性能>显存位宽>半精度浮点性能

循环神经网络:显存位宽>半精度浮点性能>Tensor核心数>单精度浮点性能

其他配置选择参考(CPU,硬盘):地址

3.常见GPU类别和价格

3.1 GPU类别

NVIDIA将其产品定位三类,GeFore用于家庭娱乐,Quadro用于工作站,而Tesla系列用 于服务器。Tesla的k型号卡为了高性能科学计算而设计。

Quadro: Quadro系列显卡一般用于特定行业,比如设计、建筑等,图像处理专业显卡,比如CAD、Maya等软件。

Quadro常见系列:

NVIDIA RTX Series系列: RTX A2000、RTX A4000、RTX A4500、RTX A5000、RTX A6000

Quadro RTX Series系列: RTX 3000、RTX 4000、RTX 5000、RTX 6000、RTX 8000

GeForce: 这个系列显卡官方定位是消费级,常用来打游戏。但是它在深度学习上的表现也非常不错,很多人用来做推理、训练,单张卡的性能跟深度学习专业卡Tesla系列比起来其实差不太多,但是性价比却高很多。

GeForce常见系列:

Geforce 10系列: GTX 1050、GTX 1050Ti、GTX 1060、GTX 1070、GTX 1070Ti、GTX 1080、GTX 1080Ti

Geforce 16系列:GTX 1650、GTX 1650 Super、GTX 1660、GTX 1660 Super、GTX 1660Ti

Geforce 20系列:RTX 2060、RTX 2060 Super、RTX 2070、RTX 2070 Super、RTX 2080、RTX 2080 Super、RTX 2080Ti

Geforce 30系列: RTX 3050、RTX 3060、RTX 3060Ti、RTX 3070、RTX 3070Ti、RTX 3080、RTX 3080Ti、RTX 3090 RTX 3090Ti

暂未添加40系列。

补充1:GTX 到RTX:RTX20显卡采用的“图灵”架构引入了RT计算单元,使其光线追踪性能超越上一代显卡的六倍,拥有了即时处理游戏光追的条件,NVIDIA认为这是一个划时代的进化,于是把沿用多年的“GTX”改名为“RTX”。

补充2:GeForce的显卡型号是不同的硬件定制,越往后时钟频率越高显存越大,也就越能充分发挥其计算性能,其G/GS<GT<GTS<GTX<RTX。

Tesla: Tesla系列显卡定位并行计算,一般用于数据中心,具体点,比如用于深度学习,做训练、推理等。Tesla系列显卡针对GPU集群做了优化,像那种4卡、8卡、甚至16卡服务器,Tesla多块显卡合起来的性能不会受>很大影响,但是Geforce这种游戏卡性能损失严重,这也是Tesla主推并行计算的优势之一

Tesla常见系列:

A-Series系列: A10、A16、A30、A40、A100

T-Series系列: T4

V-Series系列: V100

P-Series系列: P4、P6、P40、P100

K-Series系列: K8、K10、K20c、K20s、K20m、K20Xm、K40t、K40st、K40s、K40m、K40c、K520、K80

补充:Geforce系列,也就是RTX序列目前并无Tensor Core,主流Tesla系列有Tensor Core

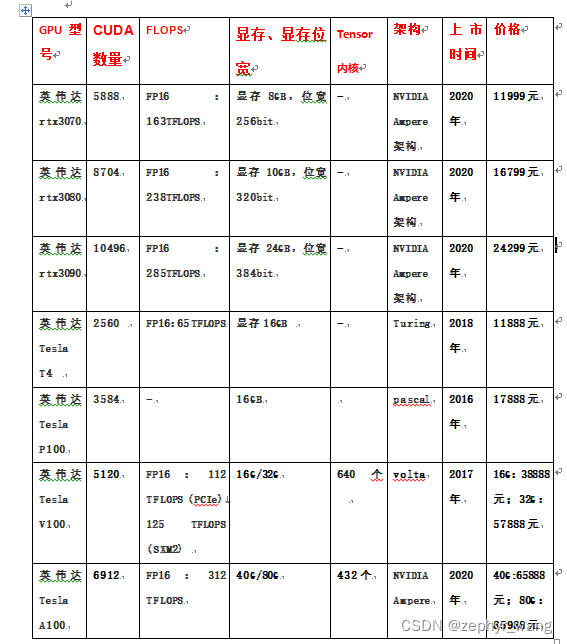

3.2 GPU价格(部分)

3.3 GPU云服务器收费标准(以阿里云为例)

因为服务器和GPU价格不菲,在做一些小模型时,常考虑使用云服务器,国内大厂都有这项服务。本文以阿里云为例,价格如下所示,可月租也可时租。地址

3.4 国内外GPU对比

图片来源:地址

4.延深(NPU和TPU)

简单理解CPU和GPU是通用芯片,其他PU是专用芯片。

4.1 NPU

神经网络处理器,是一种专门用于进行深度学习计算的芯片。思路是,模仿人的大脑神经网络,使之具备智能,NPU工作原理是在电路层模拟人类神经元和突触,并且用深度学习指令集直接处理大规模的神经元和突触,一条指令完成一组神经元的处理。相比于CPU和GPU,NPU通过突触权重实现存储和计算一体化,从而提高运行效率。NPU处理器最明显的优势就是信息处理能力块采用“数据驱动并行计算”的架构(颠覆了冯诺依曼计算机架构),特别擅长处理视频、图像类的海量多媒体数据。

NPU的典型代表有国内的寒武纪芯片和IBM的TrueNorth。

4.2 TPU

全称是Tensor Processing Unit,即张量处理器。谷歌希望更好发挥它们的深度学习框TensorFlow的性能,所以希望找到更好的硬件,而GPU是一种通用芯片,于是针对谷歌的深度学习框架TensorFlow专门定制TPU芯片,TPU与同期的CPU和GPU相比,可以提供15-30倍的性能提升,以及30-80倍的效率(性能/瓦特)提升。据称Google提供的服务,都使用了Google的TPU加速计算

4.3 其他PU

APU — Accelerated Processing Unit, 加速处理器,AMD公司推出加速图像处理芯片产品。

BPU — Brain Processing Unit, 地平线公司主导的嵌入式处理器架构。

CPU — Central Processing Unit 中央处理器, 目前PC core的主流产品。

DPU — Deep learning Processing Unit, 深度学习处理器,最早由国内深鉴科技提出;另说有Dataflow Processing Unit 数据流处理器, Wave Computing 公司提出的AI架构;Data storage Processing Unit,深圳大普微的智能固态硬盘处理器。

FPU — Floating Processing Unit 浮点计算单元,通用处理器中的浮点运算模块。

GPU — Graphics Processing Unit, 图形处理器,采用多线程SIMD架构,为图形处理而生。

HPU — Holographics Processing Unit 全息图像处理器, 微软出品的全息计算芯片与设备。

IPU — Intelligence Processing Unit, Deep Mind投资的Graphcore公司出品的AI处理器产品。

MPU/MCU — Microprocessor/Micro controller Unit, 微处理器/微控制器,一般用于低计算应用的RISC计算机体系架构产品,如ARM-M系列处理器。

NPU — Neural Network Processing Unit,神经网络处理器,是基于神经网络算法与加速的新型处理器总称,如中科院计算所/寒武纪公司出品的diannao系列。

RPU — Radio Processing Unit, 无线电处理器, Imagination Technologies 公司推出的集合集Wifi/蓝牙/FM/处理器为单片的处理器。

TPU — Tensor Processing Unit 张量处理器, Google 公司推出的加速人工智能算法的专用处理器。目前一代TPU面向Inference,二代面向训练。

VPU — Vector Processing Unit 矢量处理器,Intel收购的Movidius公司推出的图像处理与人工智能的专用芯片的加速计算核心。

WPU — Wearable Processing Unit, 可穿戴处理器,Ineda Systems公司推出的可穿戴片上系统产品,包含GPU/MIPS CPU等IP。

XPU — 百度与Xilinx公司在2017年Hotchips大会上发布的FPGA智能云加速,含256核。

ZPU — Zylin Processing Unit, 由挪威Zylin 公司推出的一款32位开源处理器。

参考文献

1.GPU基本介绍与各GPU性能、价格比较_gpu型号-CSDN博客

2.免费GPU汇总及选购_colab gpu型号-CSDN博客

4.国产GPU的发展历程及芯片性能详解_Finovy Cloud 的博客-CSDN博客

5.什么是GPU?GPU和显卡的关系?GPU国产化布局?_张巧龙的博客-CSDN博客

6.国产高端GPU,国产替代加速(附国产厂家汇总)_gpu芯片_huzia的博客-CSDN博客

7.阿里云GPU服务器收费标准、学生价格及一个小时费用大全-CSDN博客

8.主流国产GPU产品及规格概述(2023)_架构师技术联盟(Hardy)的博客-CSDN博客