- 1Oracle又裁员!_oracle裁员

- 2KeeperErrorCode = ConnectionLoss 问题解决

- 37 Series FPGAs Integrated Block for PCI Express IP核基本模式配置详解

- 4If you want an embedded database (H2, HSQL or Derby), please put it on the classpath.

- 5python数组求和函数_python数据分析之Numpy数据库第三期数组的运算

- 6第三阶段应用层——1.7 数码相册—电子书(2)—编写通用的Makefile_在主目录下创建dianzi1和dianzi2两个文件夹,在dianzi1文件夹中创建file1 fi

- 7<网络安全>《70 微课堂<第11课 0day、1day、nday(精华版)>》_0day、1day、n day

- 8计算机领域顶级会议归纳(计算机视觉CV、机器学习ML、人工智能AI)_wacv

- 9RabbitMQ消费者Consumer实现_java rabbitmq consumer

- 10CKA 06_Kubernetes 工作负载与调度 Pod 管理 yaml 资源清单 标签 Pod 生命周期 容器探针_kubernetes工作负载 yaml

分布式消息中间件RocketMQ的安装与启动_rocket启动

赞

踩

RocketMQ 安装与启动

基本概念

- 消息(Message):消息是指,消息系统所传输信息的物理载体,生产和消费数据的最小单位,每条消息必须属于一个主题。

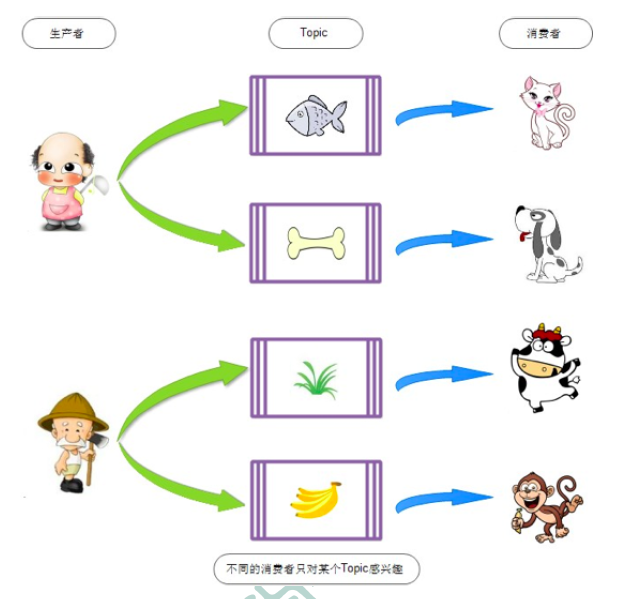

- 主体(Topic):

- Topic表示一类消息的集合,每个主题包含若干条消息,每条消息只能属于一个主体,是RocketMQ进行消息订阅的基本单位。topic:mesage 1:n message:topic 1:1

- 一个生产者可以同时发送多种Topic的消息,而一个消费者只对某种特定的Topic感兴趣,即只可以订阅和消费一种Topic的消息。producer:topic 1:n consumer:topic 1:1

-

标签(Tag):为消息设置的标签,用于同一主题下区分不同类型的消息。来自同一业务单元的消息,可以根据不同业务的目的在同一主题下设置不同标签。标签能够有效的保持代码的清晰度和连贯性,并优化RocketMQ提供的查询系统。消费者可以根据Tag实现不同的子主题的不同消费逻辑,实现更好的扩展性。

- Topic是消息的一级分类,Tag是消息的二级分类

-

生产者示例:

- Topic:货物

- Tag = 上海

- Tag = 江苏

- Tag = 浙江

-

消费者示例

- Topic = 货物 Tag = 上海

- Topic = 货物 Tag = 上海|浙江

- Topic = 货物 Tag = *

-

- Topic是消息的一级分类,Tag是消息的二级分类

-

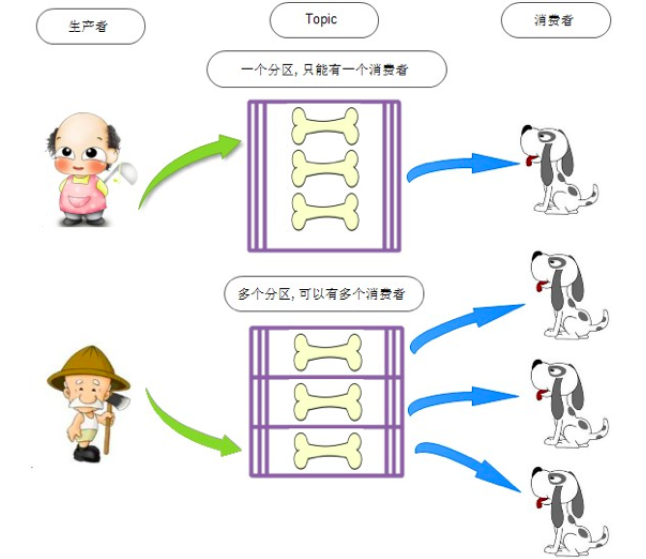

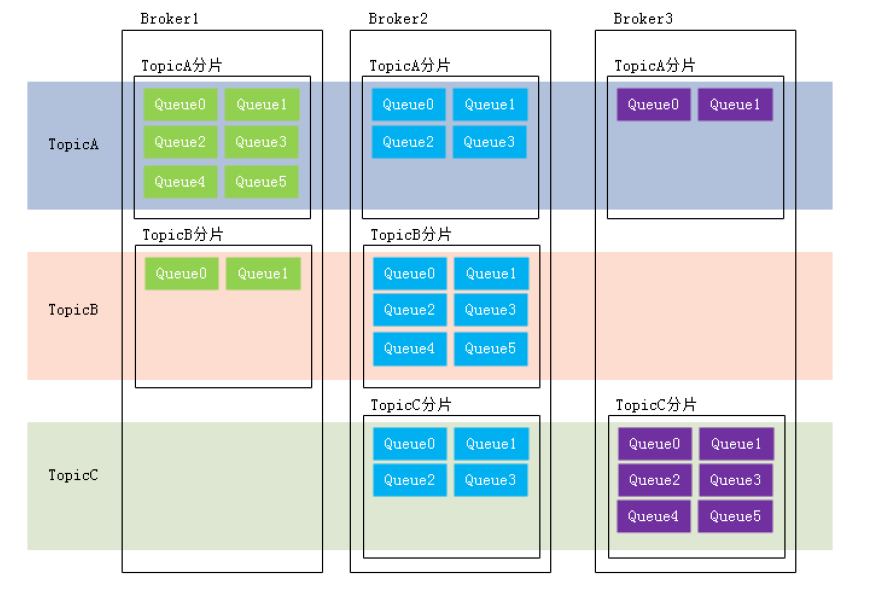

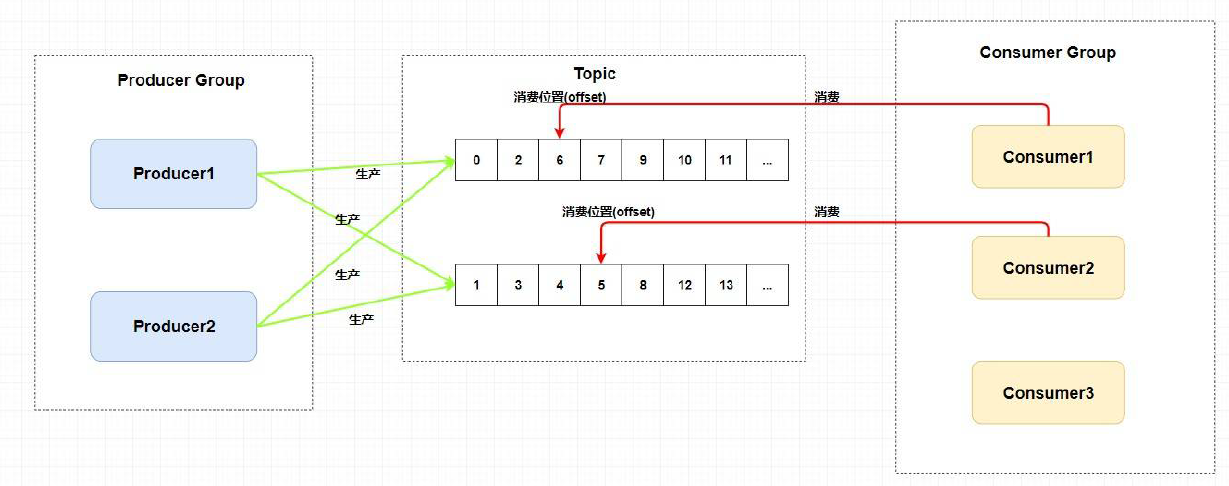

队列(Queue):

- 存储消息的物理实体。一个Topic中可以包含多个Queue,每个Queue中存放的就是该Topic的消息。一个Topic的Queue也被称为一个Topic中消息的分区(Partition)

- 一个Topic的Queue中的消息只能被一个消费者组中的一个消费者消费。一个Queue中的消息不允许同一个消费者组中的多个消费者同时消费。

- 在学习参考其他相关资料时,还会看到一个概念:分片(Sharding)。分片不同于分区。在RocketMQ中,分片指的是存放相应Topic的Broker。每个分片中会创建出相应数量的分区,即Queue,每个Queue的大小都是相同的。

-

消息标识(MessageId/Key):RocketMQ中每个消息拥有唯一的MessageId,且可以携带具有业务标识的Key,以方便对消息的查询。不过需要注意的是,MessageId有两个:在生产者send()消息时会自动生成一个MessageId(msgId),当消息到达Broker后,Broker也会自动生成一个MessageId(offsetMsgId)。msgId、offsetMsgId与key都称为消息标识。

- msgId:由producer端生成,其生成规则为:producerIp+进程pid+MessageClientIDSetter类的ClassLoader的hashCode+当前时间+AutomicInteger自增计数器

- offsetMsgId:由broker端生成,其生成规则为:brokerIp+物理分区的offset(Queue中的偏移量)

- key:由用户指定的业务相关的唯一标识

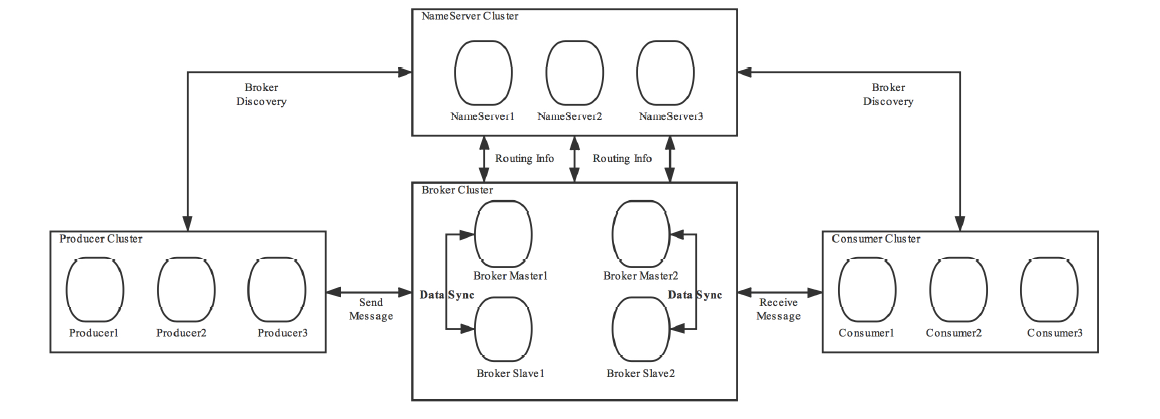

系统架构

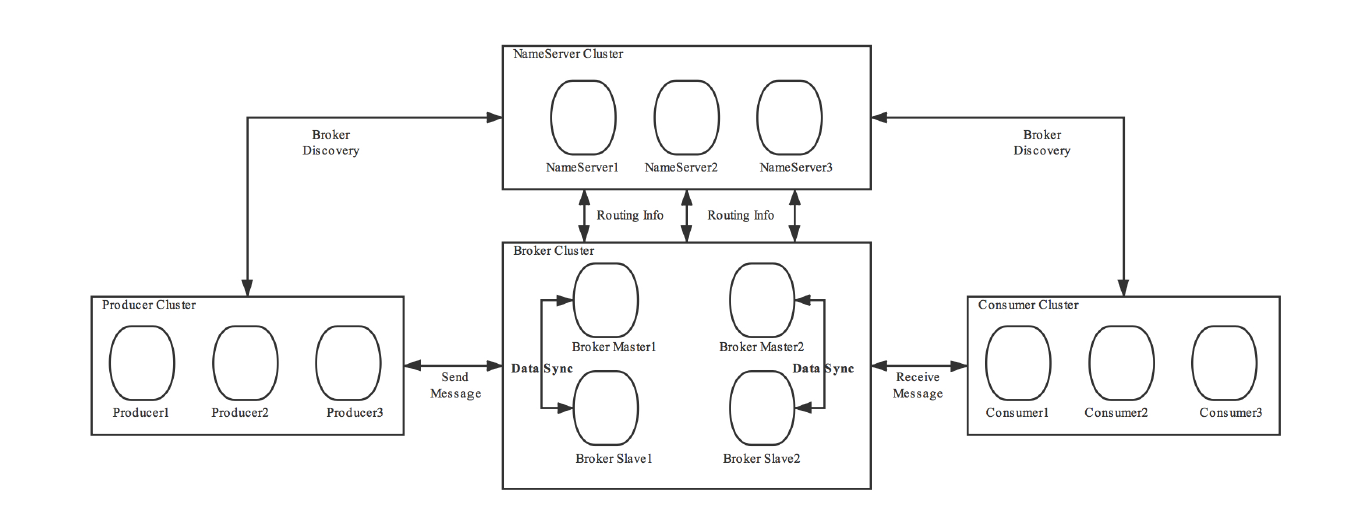

RocketMQ架构上主要分为四部分构成

Producer

消息生产者,负责生产消息。Producer通过MQ的负载均衡模块选择相应的Broker集群队列进行消息投递,投递的过程中支持快速失败并且低延迟。

例如,业务系统产生的日志写入到MQ的过程,就是消息生产的过程

再如,电商平台中用户提交的秒杀请求写入到MQ的过程,就是消息生产的过程。

RocketMQ中的消息生产者都是以生产者组(Producer Group)的形式出现的。生产者组是同一类生产者的集合,这类Producer发送相同Topic类型的消息。一个生产者组可以同时发送过个主题的消息。

Consumer

消息消费者,负责消费消息。一个消息消费者会从Broker服务器中获取到消息,并对消息进行相关业务处理。

例如,QoS系统从MQ中读取日志,并对日志进行解析处理的过程就是消息消费的过程。

再如,电商平台的业务系统从MQ中读取到秒杀请求,并对请求进行处理的过程就是消息消费的过程。

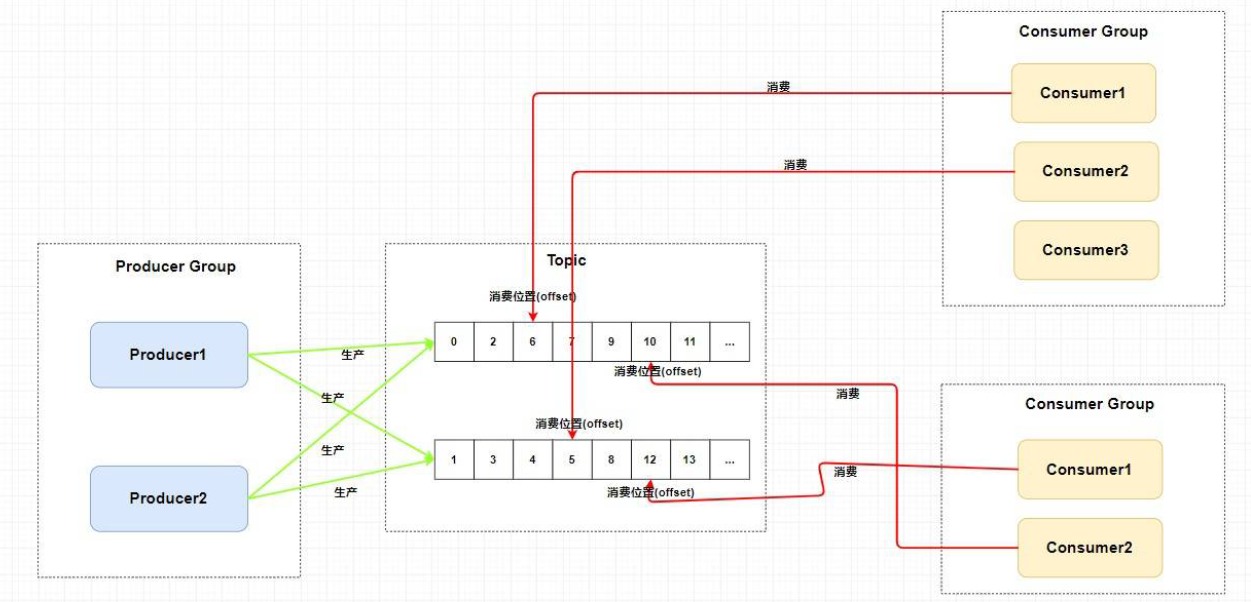

RocketMQ中的消息消费者都是以消费者组(Consumer Group)的形式出现的。消费者组是同一类消费者的集合,这类Consumer消费的是同一个Topic类型的消息。消费者组使得在消息消费你方面,实现负载均衡(将一个Topic中的不同Queue平均分配给同一个Consumer Group中的不同Consumer,注意,并不是将消息负载均衡)和容错(一个Consumer挂了,该Consumer Group中的其他Consumer可以接着消费原Consumer消费的Queue)的目标变得非常容易。

消费者组中的Consumer的数量应该小于等于订阅Topic的Queue数量。如果超出Queue数量,则多出的Consumer将不能消费消息。

不过,一个Topic类型的消息可以被多个消费者组同时消费。

注意:

1)消费者组只能消费一个Topic的消息,不能同时消费多个Topic消息

2)一个消费者组中的消费者必须订阅完全相同的Topic

Name Server

功能介绍

NameServer是一个Broker与Topic路由的注册中心,支持Broker的动态注册与发现。

RocketMQ的思想来自Kafka,而Kafka是依赖了Zookeeper的。所以在RocketMQ的早期版本,即在MetaQ v1.0与v2.0版本中,也是依赖于Zookeeper的。从MetaQ v3.0,即RocketMQ开始去掉了Zookeeper的依赖,使用了自己的NameServer

主要包括两个功能:

- Broker管理: 接受Broker集群的注册信息并且保存下来作为路由信息的基本数据;提供心跳监测机制,检查Broker是否还存活。

- 路由信息管理: 每个NameServer中都保存着Broker集群的整个路由信息和用于客户端查询的队列信息。Producer和Consumer通过NameServer可以获取整个Broker集群的路由信息,从而进行消息的投递和消费。

路由注册

NameServer通常也是以集群的方式部署,不过,NameServer是无状态的,即NameServer集群中的各个节点间是无差异的,各节点间相互不进行消息通讯。那各节点中的数据是如何进行数据同步的呢?在Broker节点启动时,轮询NameServer列表,与每个NameServer节点建立长链接,发起注册请求。在NameServer内部维护着一个Broker列表,用来动态存储Broker的信息。

注意,这是与其他像zk、Eureka、Nacos等注册中心不同的地方。

这种的NameServer无状态的方式,存在以下优缺点:

优点:NameServer集群搭建简单,扩容简单

缺点:对于Broker,必须明确指出所有NameServer地址,否则未指出的将不会去注册。也正因为如此,NameServer并不能随便扩容。因为,若Broker不重新配置,新增的NameServer对于Broker来说是不可见的,其不会向这个NameServer进行注册。

Broker节点为了证明自己是活着的,为了维护与NameServer的长链接,会将最新的信息以心跳包的方式上报给NameServer,每30秒发送一次心跳。心跳包中包含BrokerId、Broker地址(IP+Port)、Broker名称、Broker所属集群名称等等。NameServer在接收到心跳包后,会更新心跳时间戳,记录这个Broker的最新存活时间。

路由剔除

由于Broker关机、宕机或网络抖动等原因,NameServer没有收到Broker的心跳,NameServer可能会将其从Broker列表中剔除。

NameServer中有一个定时任务,每隔10秒就会扫描一次Broker表,查看每一个Broker的最新心跳时间戳距离当前时间是否超过120秒,如果超过,则会判定Broker失效,然后将其从Broker列表中剔除。

扩展:对于RocketMQ的日常运维工作,例如Broker升级,需要停掉Broker的工作,OP需要怎么做?

OP需要将Broker的读写权限禁掉,一旦Client(Consumer或Producer)向Broker发送请求,都会收到Broker的NO_PERMISSION响应,然后client会进行对其他Broker的重试。

当OP观察到这个Broker没有流量后,再关闭它。实现Broker从NameServer的移除。

OP:运维工程师

SRE:Site Reliability Engineer:现场可靠性工程师

路由发现

RocketMQ的路由发现采用的是Pull模型。当Topic路由信息出现变化时,NameServer不会主动推送给客户端,而是客户端定时拉取主题最新的路由。默认客户端每30秒会拉取一次最新的路由。

扩展:

1)Push模型:推送模型。其实时性较好,是一个“发布-订阅”模型,需要维护一个长连接、而长连接的维护是需要资源成本的。该模型适合于的场景:

- 实时性要求较高

- Client数量不多,Server数据变化比较频繁

2)Pull模型:拉取模型。存在的问题是:实时性较差。

3)Long Polling模型:长轮询模型。其是对push与pull模型的整合,充分利用了这两种模型的优劣,屏蔽了他们的劣势。

客户端NameServer选择策略

这里的客户端指的是Producer和Consumer

客户端在配置时必须要写上NameServer集群的地址,那么客户端到底连接的是那个NameServer节点呢?客户端首先会产生一个随机数,然后在与NameServer节点数量取模,此时得到的就是所要连接的节点索引,然后会进行连接。如果链接失败,则会采用round-robin策略,逐个尝试去连接其他节点。

首先采用的是随机策略进行的选择,失败后采用的是轮询策略。

扩展:Zookeeper Client是如何选择Zookeeper Server的?

简单来说,经过两次shuffle,然后选择第一台Zookeeper Server

详细来说,将配置文件中的zk srver地址进行第一个shuffle,然后随机选择一个。这个选择出的一般都是一个hostname。然后获取到该hostname对应的所有ip,再对这些IP进行第二次shuffle,从shuffle过的结果中取第一个Server地址进行连接。

Broker

功能介绍

Broker充当着消息中转的角色,负责存储消息、转发消息。Broker在RocketMQ系统中负责接收并存储从生产者发送来的消息,同时为消费者的拉取请求作准备。Broker同时也存储着消息相关的元数据,包括消费者组消费进度偏移offset、主题、队列等。

Kafka 0.8版本之后,offset是存方在Broker中的,之前版本是存放在Zookeeper中的。

模块构成

下图是Broker Server的功能模块示意图。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-KhjEwp3v-1684484292631)(C:/Users/ruozhuliufeng/AppData/Roaming/Typora/typora-user-images/image-20230503202003285.png)]

- Remoting Module: 整个Broker的试题,负责处理来自clients端的请求。而这个Broker实体则由一下模块构成。

- Client Manager: 客户端管理器。负责接收、解析客户端(Producer/Consumer)请求,管理客户端。例如,维护Consumer的Topic订阅信息。

- Store Service: 存储服务。提供方便简单的API接口,处理消息存储到物理硬盘和消息查询功能。

- HA Service: 高可用服务,提供Master Broker和Salve Broker之间的数据同步功能。

- Index Service: 索引服务。根据特定的Message Key,对投递到Broker的消息进行索引服务,同时也提供根据Message Key对消息进行快速查询的功能。

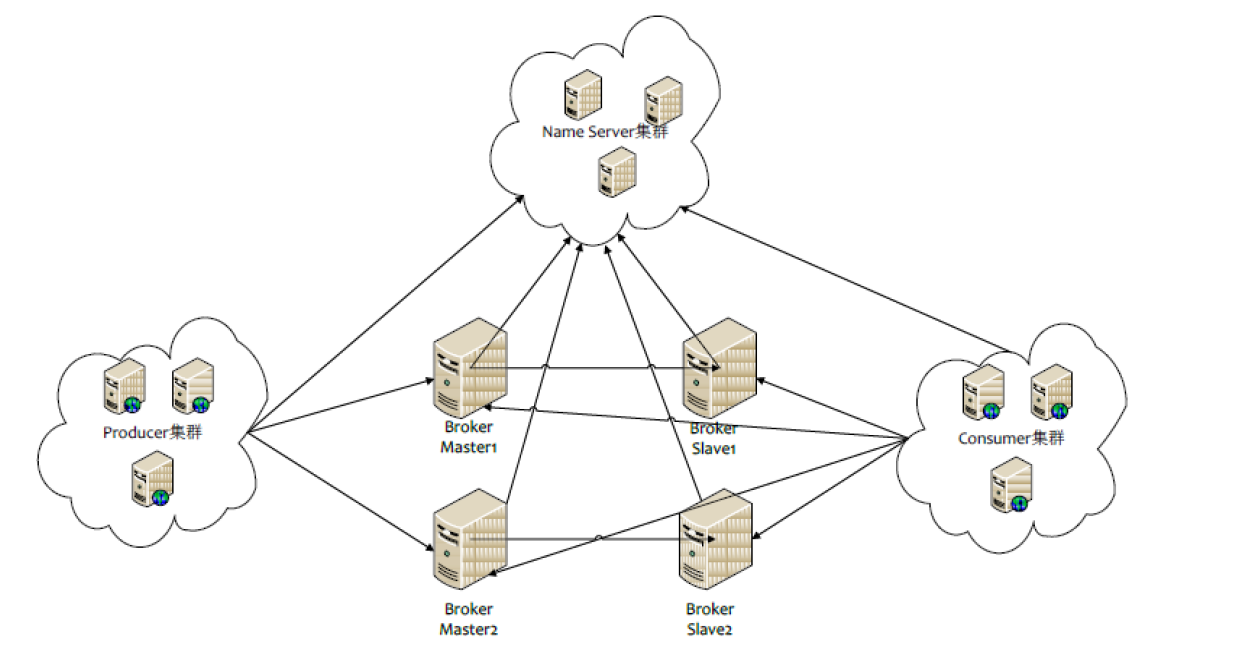

集群部署

为了增强Broker性能与吞吐量,Broker一般都是以集群形式出现的。各集群节点中可能存放着相同Topic的不同Queue。不过,这里有个问题,如果某Broker节点宕机,如何保证数据不丢失呢?其解决方案是,将每个Broker集群节点进行横向扩展,即将Broker几点再建为一个HA集群,解决单点问题。

Broker节点集群是一个主从集群,即集群中具有Master和Slave两种角色。Master负责处理读写操作请求,Slave负责对Master中的数据进行备份。当Master挂掉了,Slave则会自动切换为Master去工作。所以这个Broker集群是主备集群。一个Master可以包含多个Slave,但一个Slave只能隶属于一个Master。Mater与Slave的对应关系是通过指定相同的BrokerName、不同的BrokerId来确定的。BrokerId为0表示Master,非0表示Slave。每个Broker与NameServer集群中的所有节点建立长连接,定时注册Topic信息到所有NameServer。

工作流程

具体流程

- 1)启动NameServer,NameServer启动后开始监听端口,等待Broker、Producer、Consumer连接。

- 2)启动Broker,Broker会与所有的NameServer建立并保持长连接,然后每30秒向NameServer定时发送心跳包

- 3)发送消息前,可以先创建Topic,创建Topic时需要指定该Topic要存储在哪些Broker上,当然,在创建Topic时也会将Topic与Broker的关系写入到NameServer中。不过,这一步是可选的,也可以在发送消息时自动创建Topic。

- 4)Producer发送消息,启动时先跟NameServer集群中的一台建立长连接,并从NameServer中获取路由信息,即当前发送的Topic信息的Queue与Broker的地址(IP+Port)的映射关系。然后根据算法策略从队列中选择一个Queue,与队列所在的Broker建立长连接从而向Broker发送消息。当然,在获取到路由信息后,Producer会首先将路由信息缓存到本地,再每30秒从NameServer更新一次路由信息。

- 5)Consumer与Producer类似,跟其中一台NameServer建立长连接,获取其所订阅Topic的路由信息,然后根据算法策略从路由信息中获取到其所要消费的Queue,然后直接跟Broker建立长连接,开始消费其中的消息。Consumer在获取到路由信息后,同样也会每30秒从NameServer更新一次路由信息。不过不同于Producer的是,Consumer还会向Broker发送心跳,以确保Broker的存活状态。

Topic的创建模式

手动创建Topic时,有两种模式:

- 集群模式:该模式下所创建的Topic在该集群中,所有Broker中的Queue数量是相同的。

- Broker模式:该模式下创建的Topic在该集群中,每个Broker中的Queue数量可以不同。

自动创建Topic时,默认采用的是Broker模式,会为每个Broker默认创建4个Queue。

读/写队列

从物理上来将,读/写队列是同一个队列。所以,不存在读写队列数据同步问题。读写队列是逻辑上进行区分的概念。一般情况下,读写队列数量是相同的。

例如,创建Topic时设置的写队列数量为8,读队列数量为4,此时系统会创建8个Queue,分别为 0,1,2,3,4,5,6,7。Producer会将消息写入到这8个队列,但Consumer只会消费0,1,2,3 这4个队列中的消息,4,5,6,7中的消息是不会消费到的。

再如,创建Topic时设置的写队列数量为4,读队列数量为8,此时系统会创建8个Queue,分别为 0,1,2,3,4,5,6,7。Producer会将消息写入到0,1,2,3 这4个队列,Consumer只会消费0,1,2,3,4,5,6,7这8个队列中的消息,但是4,5,6,7中是没有消息的。假设Consumer Group中包含两个Consumer,Consumer1消费0,1,2,3,而Consumer2消费4,5,6,7。但实际情况时,Consumer2是没有消息可消费的。

也就是说,当读写数量设置不同时,总是有问题的。那么为什么要这样设计呢?

其这样设计的目的是为了方便Topic的Queue的缩容。

例如,原来创建Topic中包含16个Queue,如何能够使其Queue缩容为8个,还不会丢失消息?可以动态修改写队列数量为8,读队列数量不变。此时新的消息只能写入到前8个队列,而消费者消费的却是16个队列中的数据。当发现后8个Queue中的消息消费完毕后,就可以再将读队列数量动态设置为8。整个缩容过程中,没有丢失任何消息。

perm用于设置对当前创建Topic的操作权限:2表示只写,4表示只读,6表示读写

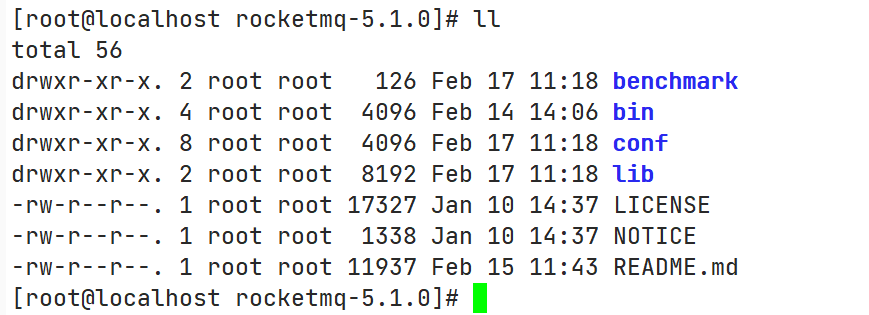

单机安装与启动

准备工作

软硬件要求

根据RocketMQ的官方文档,安装的系统要求是64位的,JDK要求是1.8及其以上版本。

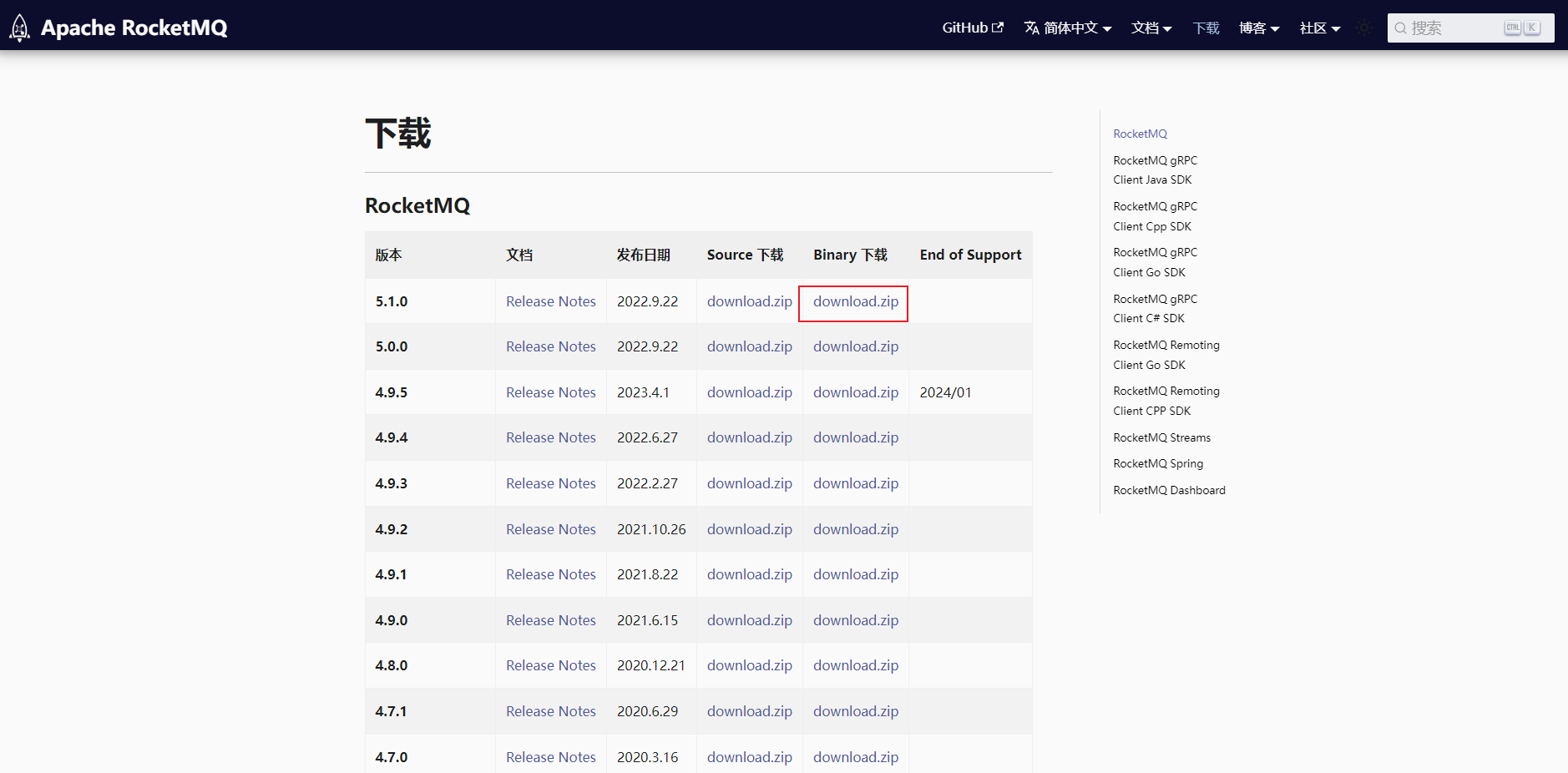

下载RocketMQ安装包

官方下载地址:https://rocketmq.apache.org/zh/download/

RockerMQ的安装包有两种,源码包需要编译构建二进制可执行文件后执行,二进制包是已经编译完成后可以直接运行的。

下载源码包后上传至服务器并编译:

$ unzip rocketmq-all-5.1.0-source-release.zip

$ cd rocketmq-all-5.1.0-source-release/

$ mvn -Prelease-all -DskipTests -Dspotbugs.skip=true clean install -U

$ cd distribution/target/rocketmq-5.1.0/rocketmq-5.1.0

- 1

- 2

- 3

- 4

下载最新版本的二进制包上传至服务器(无需编译)

$ unzip rocketmq-all-5.1.0-bin-release.zip

# 若提示 -bash: unzip: command not found ,使用yum 安装unzip

$ yum install -y unzip

- 1

- 2

- 3

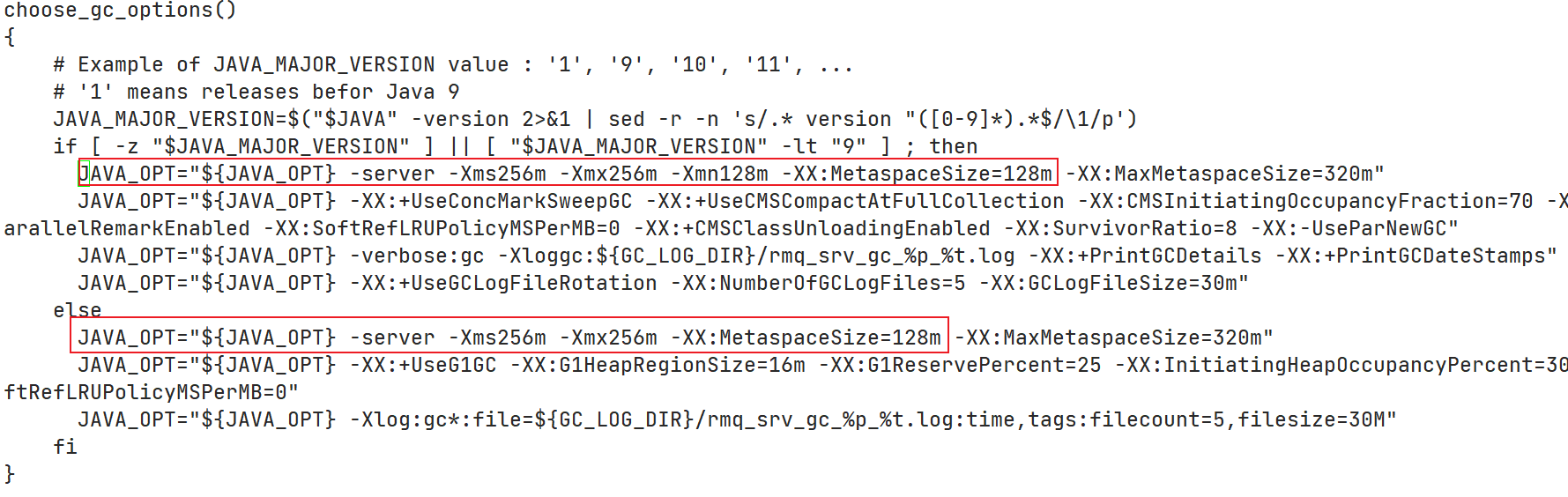

修改初始内存

修改 runserver.sh

使用vim命令打开 bin/runserver.sh文件,修改起始内存如下:

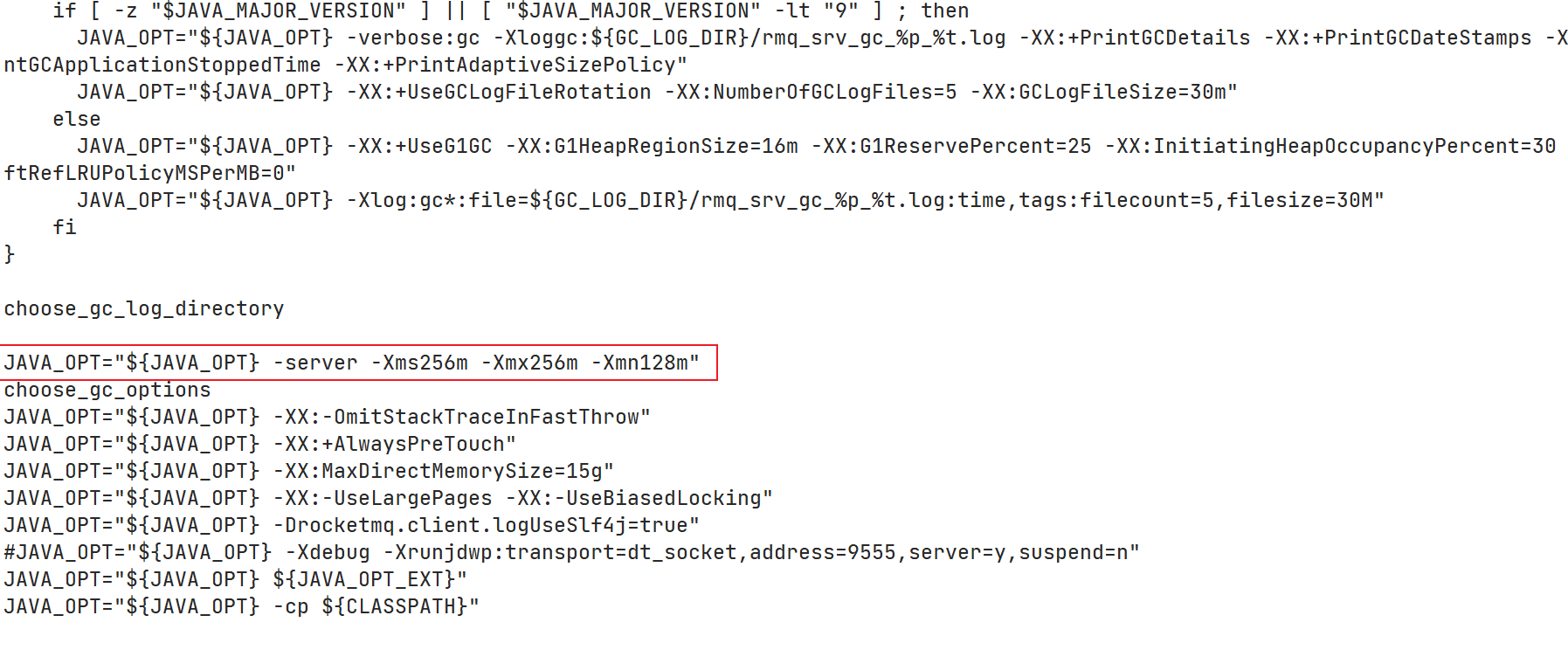

修改runbroker.sh

使用vim命令打开bin/runbroker.sh文件,修改起始内存如下:

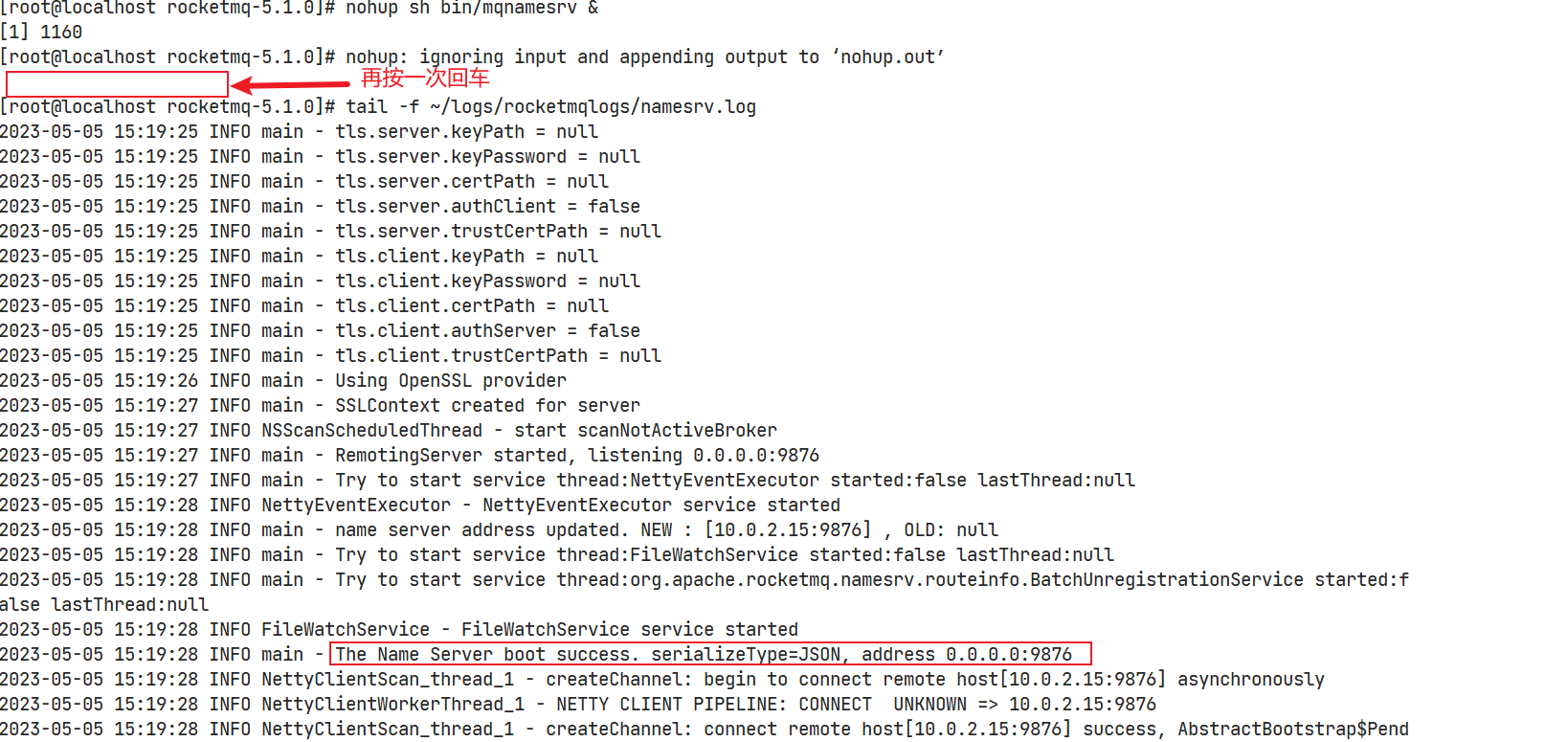

启动

启动NameServer

$ nohup sh bin/mqnamesrv &

$ tail -f ~/logs/rocketmqlogs/namesrv.log

- 1

- 2

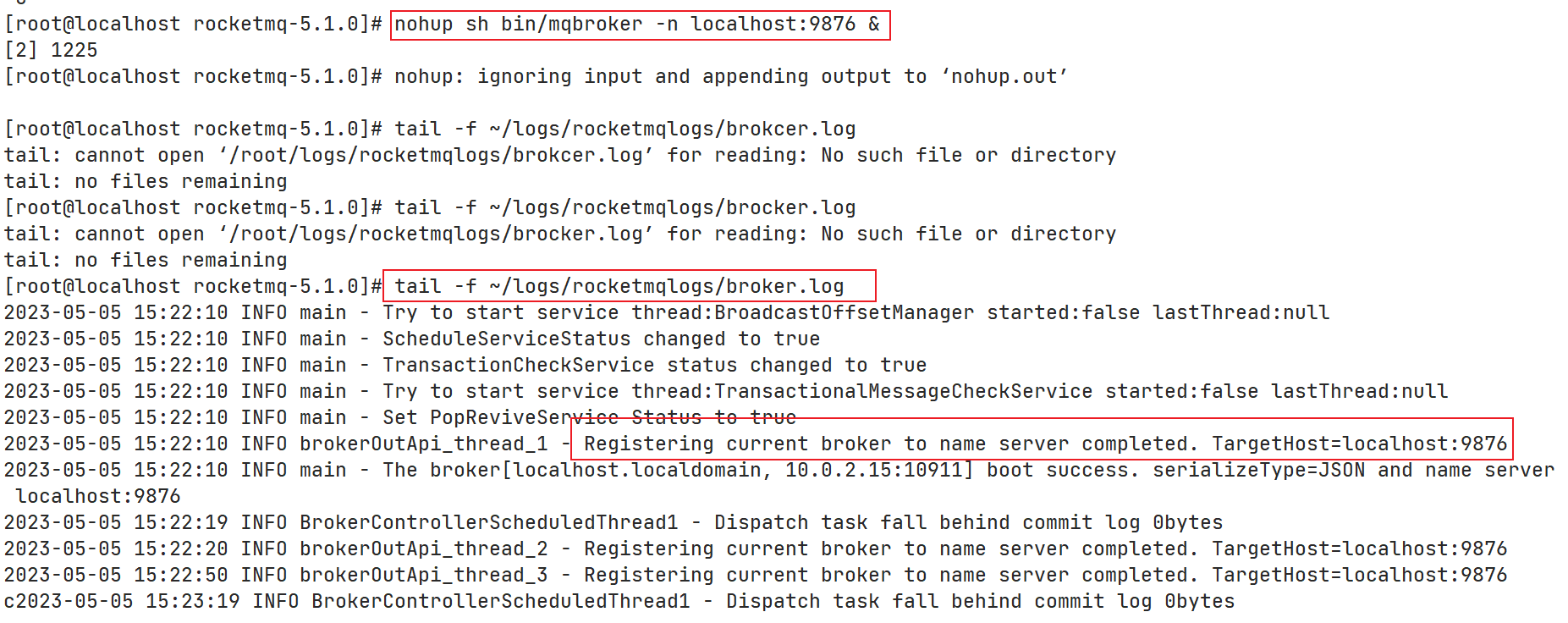

启动Broker

# 先启动Broker,5.x版本

$ nohup sh bin/mqbroker -n localhost:9876 --enable-proxy &

$ tail -f ~/logs/rocketmqlogs/proxy.log

- 1

- 2

- 3

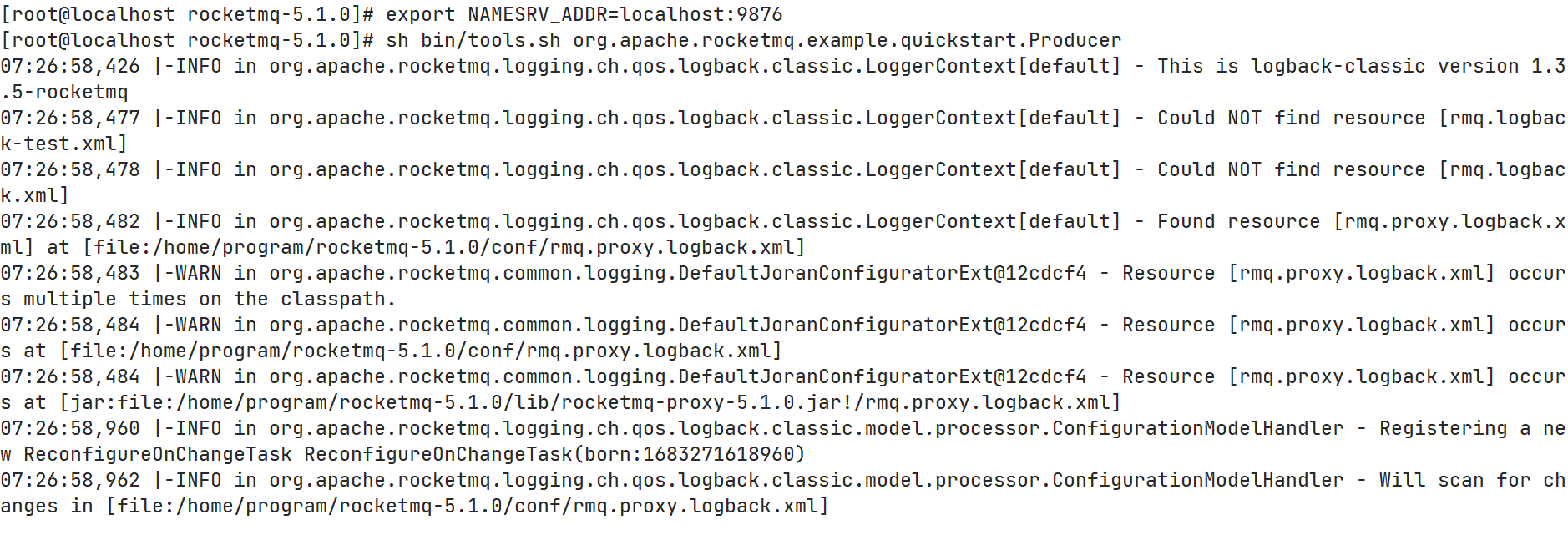

发送/接受消息测试

发送消息

$ export NAMESRV_ADDR=localhost:9876

$ sh bin/tools.sh org.apache.rocketmq.example.quickstart.Producer

- 1

- 2

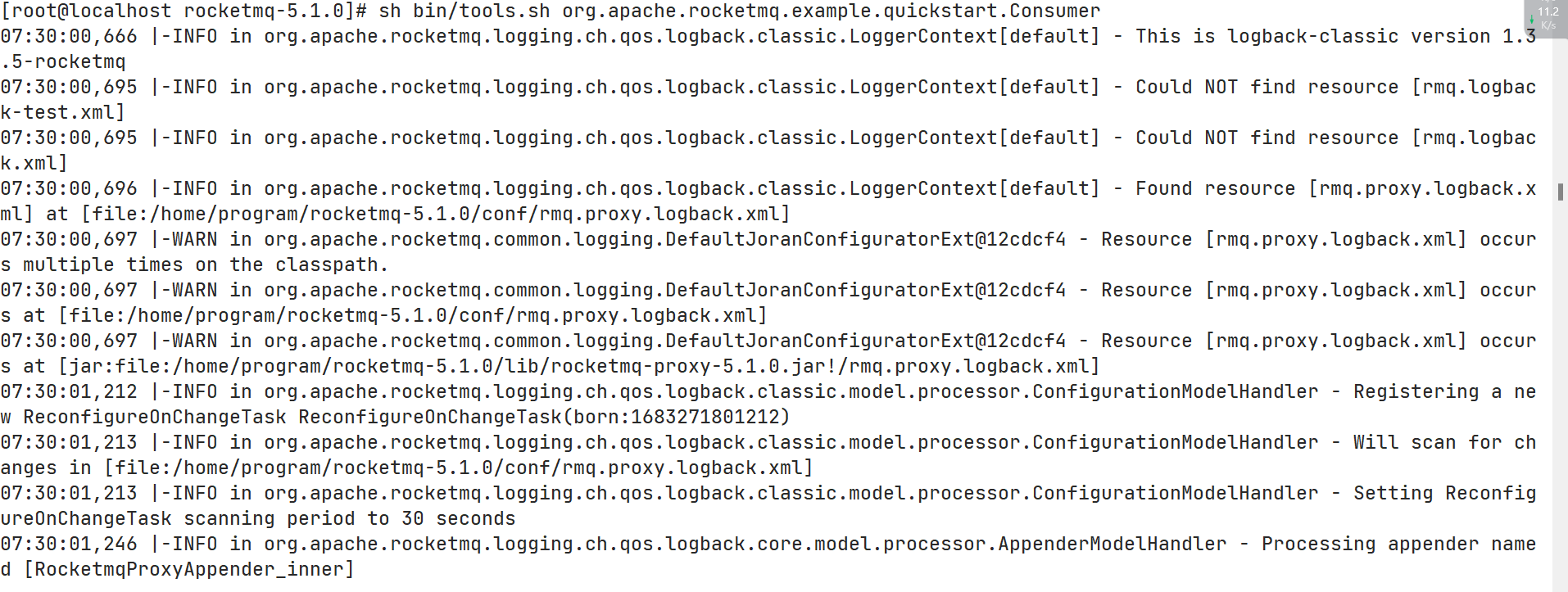

接收消息

$ sh bin/tools.sh org.apache.rocketmq.example.quickstart.Consumer

- 1

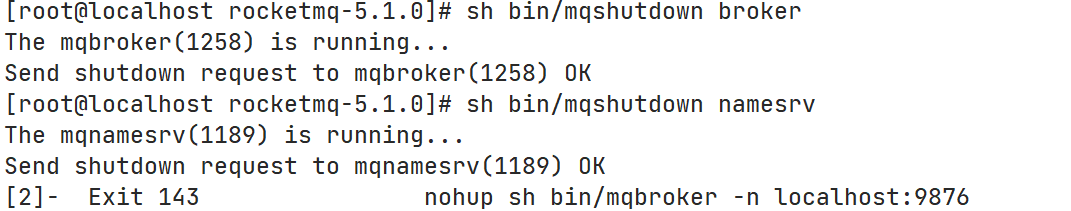

关闭Server

无论是关闭NameServer还是Broker,都是使用bin/mqshudown命令

$ sh bin/mqshutdown broker

$ sh bin/mqshutdown namesrv

- 1

- 2

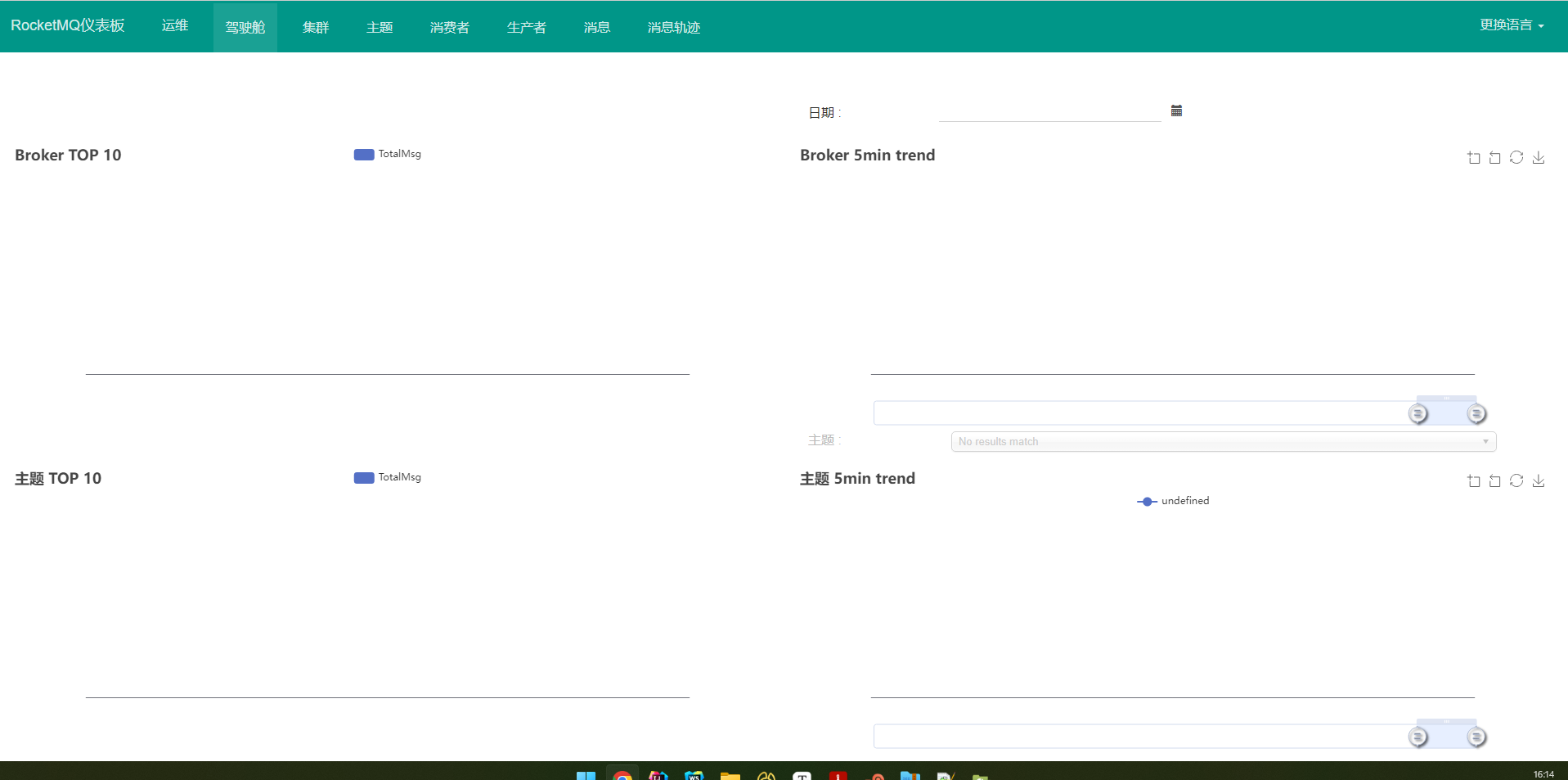

控制台的安装与启动

RocketMQ 有一个可视化的dashboard,通过该控制台可以直观地查看到很多数据

可以使用Docker部署或者下载源码编译

Docker部署

# 从DockerHub上拉取镜像

$ docker pull apacherocketmq/rocketmq-dashboard:latest

# 配置端口与NameServer地址

docker run -d --name rocketmq-dashboard -e "JAVA_OPTS=-Drocketmq.namesrv.addr=127.0.0.1:9876" -p 8080:8080 -t apacherocketmq/rocketmq-dashboard:latest

- 1

- 2

- 3

- 4

下载源码

GitHub:https://github.com/apache/rocketmq-dashboard

官网:https://rocketmq.apache.org/zh/download/#rocketmq-dashboard

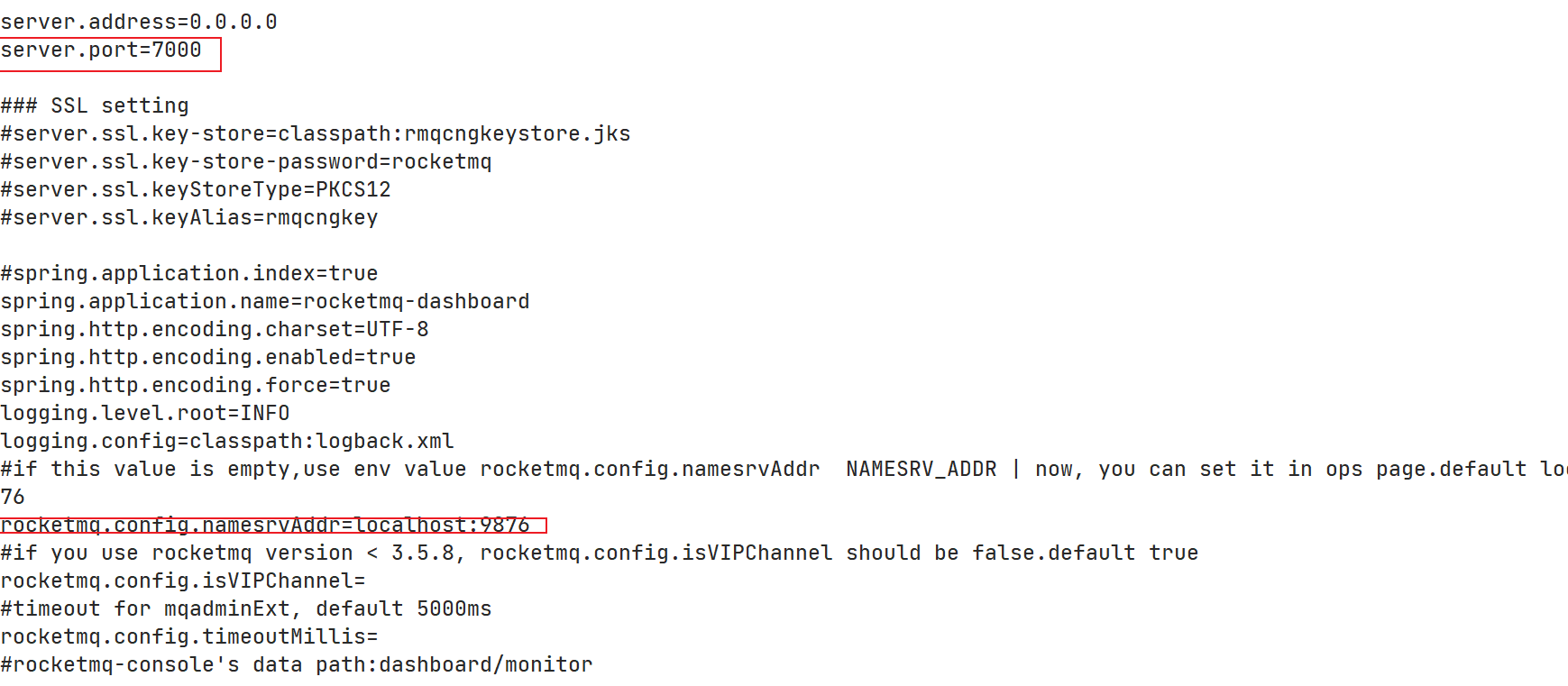

修改配置

修改其src/main/resources中的application.properties配置文件

- 原端口号为8080,若与已有系统冲突,可修改为一个不常用的端口,若不冲突,可不更改

- 指定RocketMQ的name server地址

添加依赖

在目录的pom.xml中添加如下JAXB依赖

JAXB,Java Architechture for Xml Binding,用于XML绑定的JAVA技术,是一个业界标准,是一项可以根据XML Schema生成JAVA类的技术

<dependency> <groupId>javax.xml.bind</groupId> <artifactId>jaxb-api</artifactId> <version>2.3.0</version> </dependency> <dependency> <groupId>com.sun.xml.bind</groupId> <artifactId>jaxb-impl</artifactId> <version>2.3.0</version> </dependency> <dependency> <groupId>com.sun.xml.bind</groupId> <artifactId>jaxb-core</artifactId> <version>2.3.0</version> </dependency> <dependency> <groupId>javax.activation</groupId> <artifactId>activation</artifactId> <version>1.1.1</version> </dependency>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

打包

在rocketmq-dashboard目录下运行maven的打包命令

$ mvn clean package -Dmaven.test.skip=true

- 1

启动

$ cd target/

$ java -jar rocketmq-dashboard-1.0.0.jar

- 1

- 2

访问

访问地址:服务器IP:配置的端口号

集群搭建理论

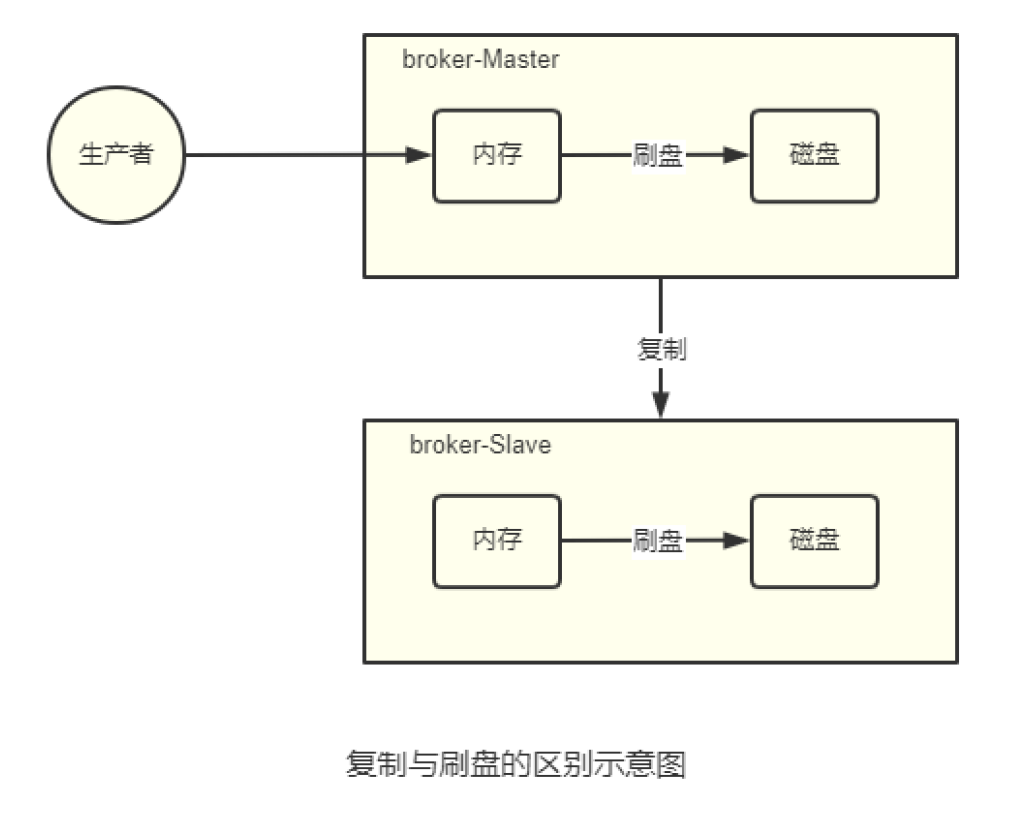

数据复制与刷盘策略

数据复制

复制策略是Broker的Master与Slave之间的数据同步方式。分别为同步复制与异步复制:

- 同步复制:消息写入Master后,Master会等待Slave同步数据成功后才向Producer返回成功ACK

- 异步复制:消息写入Master后,Master立即向Producer返回成功ACK,无需等待Slave同步数据成功

异步复制策略会降低系统的写入延迟,RT变小,提高了系统的吞吐量。

刷盘策略

刷盘策略指的是Broker中的消息的落盘方式,即消息发送到Broker内存后消息持久化到磁盘的方式。分为同步刷盘与异步刷盘:

- 同步刷盘:当消息持久化到Broker的磁盘后才算是消息写入成功

- 异步刷盘:当消息写入到Broker的内存后即表示消息写入成功,无需等待消息持久化到磁盘。

1)异步刷盘策略会降低系统的写入延迟,RT变小,提高了系统的吞吐量

2)消息写入到Broker的内存,一般是写入到了PageCache

3)对于异步刷盘策略,消息会写入到PageCache后立即返回成功ACK。但并不会立即做落盘操作,而是当PageCache到达一定量时会自动进行落盘。

Broker集群模式

以下基类:根据Broker集群中各个节点关系的不同,Broker集群可以分为

单Master

只有一个Broker(其本质上就不能称为集群)。这种方式也只能是在测试时使用,生产环境不能使用,因为存在单点问题。

多Master

Broker集群仅由多个Master构成,不存在Slave。同一Topic的各个Queue会平均分布在各个Master节点上。

- 优点:配置简单,单个Master宕机或重启维护对应用无影响,在磁盘配置为RAID10时,即使机器宕机不可恢复情况下,由于RAID10磁盘非常可靠,消息也不会丢(异步刷盘丢失少量消息,同步刷盘一条不丢),性能最高

- 缺点:单台机器宕机期间,这台机器上未被消费的消息在机器恢复之前不可订阅(不可消费),消息实时性会收到影响

以上优点的前提是,这些Master都配置了RAID磁盘阵列。如果没有配置,一旦出现某Master宕机,则会发生大量消息丢失的情况。

多Master多Slave模式异步复制

Broker集群由多个Master构成,每个Master又配置了多个Slave(在配置了RAID磁盘阵列的情况下,一个Master一般配置一个Slave即可)。Master与Slave的关系是主备关系,即Master负责处理消息的读写请求,而Slave仅负责消息的备份与Master宕机后的角色切换。

异步复制即前面提及的复制策略中的异步复制策略,即消息写入Master成功后,Master立即向Producer返回成功ACK,无需等待Slave同步数据成功。

该模式的最大特点之一是,当Master宕机后,Slave能够自动切换为Master。不过由于Slave从Master的同步有短暂的延迟(毫秒级),所以当Master宕机后,这种异步复制方式可能会存在少量消息的丢失问题。

Slave从Master同步的延迟越短,其可能丢失的消息就越少

对于Master的RAID磁盘阵列,若使用的也是异步复制策略,同样存在延迟问题,同样也可能会丢失消息。但RAID阵列的秘诀是微秒级的(因为是由硬盘支持的),所以其丢失的数据量会更少。

多Mater多Slave模式同步双写

该模式是多Master多Slave模式的同步复制实现。所谓同步双写,指的是消息写入Master成功后,Master会等待Slave同步数据成功后才向Producer返回成功ACK,即Master与Slave都要写入成功后才会返回成功ACK,也即双写。

该模式与异步复制模式相比,优点是消息的安全性更改,不存在消息丢失的情况。但单个消息的RT略高,从而导致性能略低(大约低10%)。

该模式存在一个大的问题:对于当前版本,Master宕机后,Slave不会自动切换到Master。

最佳实践

一般会为Master配置RAID磁盘阵列,然后再为其配置一个Slave。即利用了RAID10磁盘阵列的高效、安全性,又解决了可能会影响订阅的问题。

1)RAID磁盘阵列的效率要高于Master-Slave集群。因为RAID是硬件支持的。也正因为如此,RAID阵列的搭建成本较高。

2)多Master+RAID阵列,与多Master多Slave集群的区别是什么?

- 多Master+RAID阵列,其仅仅可以保证数据不丢失,即不影响消息写入,但其可能会影响到消息的订阅。但其执行效率要远高于 多Master多Slave集群

- 多Master多Slave集群,其不仅可以保证数据不丢失,也不会影响消息的写入。其运行效率要低于多Master+RAID阵列

磁盘阵列RAID

RAID历史

1988年美国加州大学伯克利分校的D.A.Patterson教授等首次在论文“A Case of Redundant Array of Inexpensive Disks"中提出了RAID概念,即廉价冗余磁盘阵列(Redundant Array of Inexpensive Disks)。由于当时大容量磁盘比较昂贵,RAID的基本思想是将多个容量较小、相对廉价的磁盘进行有机组合,从而以较低的成本获得与昂贵大容量磁盘相当的容量、性能、可靠性。随着磁盘成本和价格的不断降低,”廉价“已经毫无意义。因此,RAID咨询委员会(RAID Advisory Board,RAB)决定用”独立“代替“廉价”,于是RAID变成了独立磁盘冗余阵列(Redundant Array of Independent Disks)。但这仅仅是名称的变化,其实质内容没有改变。

RAID等级

RAID这种设计思想很快被业界接纳,RAID技术作为高性能、高可靠的存储技术,得到了非常广泛的应用。RAID主要利用镜像、数据条带和数据校验三种技术来获取高性能、可靠性、容错能力和扩展性,根据对这三种技术的使用策略和组合架构,可以把RAID分为不同的等级,以满足不同数据应用的需求。

D.A.Patterson等的论文中定义了RAID0 ~ RAID6原始RAID等级。随后存储厂商又不断推出RAID7、RAID10、RAID01、RAID50、RAID53、RAID100等RAID等级,但这些并无统一的标准。目前业界与学术界公认的标准是RAID0~RAID6,而在实际应用领域中使用最多的RAID等级是RAID0、RAID1、RAID3、RAID5、RIAD6与RAID10.

RAID每一个等级代表一种实现方法和技术,等级之间并无高低之分。在实际应用中,应当根据用户的数据应用特点,综合考虑可用性、性能和成本来选择核实的RAID等级,以及具体的实现方式。

关键技术

镜像技术

镜像技术是一种冗余技术,为磁盘提供数据备份功能,防止磁盘发生故障而造成数据丢失。对于RAID而言,采用镜像技术最典型的用法就是,同时在磁盘阵列中产生两个完全相同的数据副本,并且分布在两个不同的磁盘上。镜像提供了完全的数据冗余能力,当一个数据副本失效不可用时,外部系统仍可正常访问另一副本,不会对应用系统运行和性能产生影响。而且,镜像不需要额外的计算和校验,故障修复非常快,直接复制即可。镜像技术可以从多个副本进行开发读取数据,提供更高的读I/O性能,但不能并行写数据,写多个副本通常会导致一定的I/O性能下降。

镜像技术提供了非常高的数据安全性,其代价也是非常昂贵的,需要至少双倍的存储空间。高成本限制了镜像的广泛应用,主要应用于置管重要的数据保护,这种场合下的数据丢失可能会造成非常巨大的损失。

数据条带技术

数据条带化技术是一种自动将I/O操作负载均衡到多个物理磁盘上的技术。更具体的说就是,将一块连续的数据分成很多小部分并把它们分别存储到不同磁盘上。这就能使多个进程可以并发访问数据的多个不同部分,从而获得最大程度上的I/O并行能力,极大的提升性能。

数据校验技术

数据校验技术是指,RAID要在写入数据的同时进行校验计算,并将得到的校验数据存储在RAID成员磁盘中。校验数据可以集中保存在某个磁盘或分散存储在多个不同磁盘中。当其中一部分数据出错时,就可以对剩余数据和校验数据进行反校验计算重建丢失的数据。

数据校验技术相对于镜像技术的优势在于节省大量开销,但由于每次数据读写都要进行大量的校验运算,对计算机的运算速度要求很高,且必须使用硬件RAID控制器。在数据重建恢复方面,校验技术比镜像技术复杂的多且慢得多。

RAID分类

从实现角度看,RAID主要分为软RAID、硬RAID以及混合RAID三种。

软RAID

所有功能均有操作系统和CPU来完成,没有独立的RAID控制处理芯片和I/O处理芯片,效率自然最低。

硬RAID

配备了专门的RAID控制处理芯片和I/O处理芯片以及阵列缓冲,不占用CPU资源。效率很高,单成本也很高。

混合RAID

具备RAID控制处理芯片,但没有专门的I/O处理芯片,需要CPU和驱动程序来完成。性能和成本在软RAID和硬RAID之间。

常见RAID等级详解

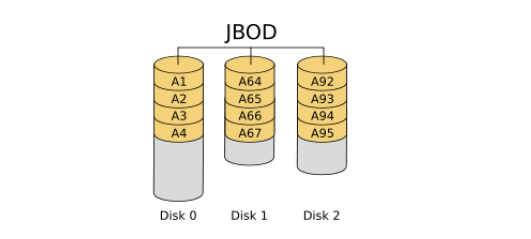

JBOD

JBOD,Just a Bunch of Disks,磁盘簇。表示一个没有控制软件提供协调控制的磁盘集合,这是RAID区别于JBOD的主要因素。JBOD将多个物理磁盘串联起来,提供一个巨大的逻辑磁盘。

JBOD的数据存放机制是由第一块磁盘开始顺序往后存储,当前磁盘存储空间用完后,再一次往后面的磁盘存储数据。JBOD的存储性能完全等同于单块磁盘,而且也不提供数据安全保护。

其只是简单提供一种扩展空间的机制,JBOD可用存储空间容量等于所有成员磁盘的存储空间之和。

JBOD常指磁盘柜,而不论其是否提供RAID功能。不过,JBOD并非官方术语,官方成为Spanning。

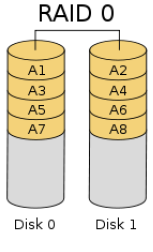

RAID0

RAID0是一种简单的、无数据校验的数据条带化技术。实际上不是一种真正的RAID,因为它并不提供任何形式的冗余策略。RAID0将所在磁盘条带化后组成大容量的存储空间,将数据分散存储在所有磁盘中,以独立访问方式实现多块磁盘的并读访问。

理论上来将,一个由n块磁盘组成的RAID0,它的读写性能是单个磁盘性能的n倍,但由于总线带宽等多种因素的限制,实际的性能提升低于理论值。由于可以并发执行I/O操作,总线带宽得到充分利用。再加上不需要进行数据校验,RAID0的性能在所有RAID等级中是最高的。

RAID0具有低成本、高读写性能、100%高存储空间利用率等优点,但是它不提供数据冗余保护,一旦数据损坏,将无法恢复。

应用场景:数据的顺序读写要求不高,对数据的安全性和可靠性要求不高,但对系统性能要求很高的场景。

RAID0与JBOD的相同点:

- 存储容量:都是成员磁盘容量总和

- 磁盘利用率:都是100%,即都没有做任何的数据冗余备份

RAID0与JBOD的不同点:

- JBOD:数据是顺序存放的,一个磁盘存满后才会开始存放到下一个磁盘

- RAID0:各个磁盘中的数据写入是并行的,是通过数据条带技术写入的,其读写性能是JBOD的N倍

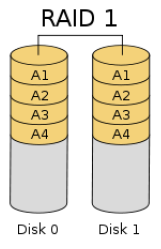

RAID1

RAID1就是一种镜像技术,它将数据完全一致的分别写到工作磁盘和镜像磁盘,它的磁盘空间利用率为50%。RAID1在数据写入时,响应时间会有所影响,但是读数据时没有影响。RAID1提供了最佳的数据保护,一旦工作磁盘发生故障,系统将自动切换到镜像磁盘,不会影响使用。

RAID1是为了增强数据安全性使两块磁盘数据呈现完全镜像,从而达到安全性好、技术简单、管理方便。RAID1拥有完全容错的能力,但是实现成本高。

应用场景:对顺序读写性能要求高,或对数据安全性要求较高的场景。

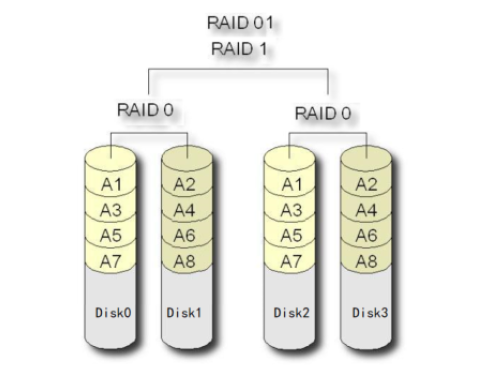

RAID10

RAID10是一个RAID1与RAID0的组合体,所以它继承了RAID0的快速和RAID1的安全。

简单来说就是,先做条带,再做镜像。即将进来的数据先分散到不同的磁盘,再将磁盘中的数据做镜像。

RAID01

RAID01是一个RAID1与RAID0的组合体,所以它继承了RAID0的快速和RAID1的安全。

简单来说就是,先做镜像,再做条带。即将进来的数据先做镜像,再将镜像数据写入到与之前数据不同的磁盘,即再做条带。

RAID10要比RAID01的容错率在高,所以生产环境下一般是不使用RAID01的。

集群搭建实践

集群架构

这里搭建一个双主双从异步复制的Broker集群。为了方便,这里使用两台主机来完成集群的搭建。

这两台主机的功能与Broker角色分配如下表:

| 序号 | IP | 功能 | BROKER角色 |

|---|---|---|---|

| 1 | 192.168.56.11 | NameServer+Broker | Master1+Slave2 |

| 2 | 192.168.56.12 | NameServer+Broker | Master2+Slave1 |

克隆生成RocketMQOS1

克隆虚拟机,并修改配置,指定主机名为RocketMQOS1

修改RocketMQOS1配置文件

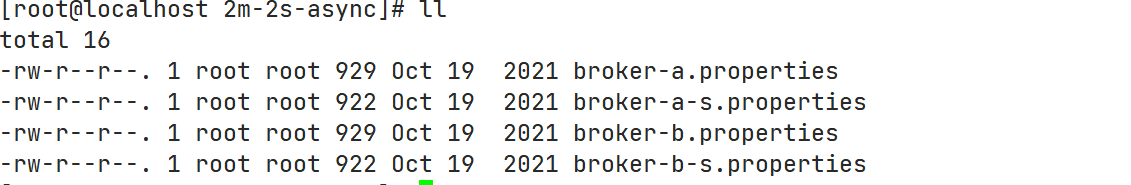

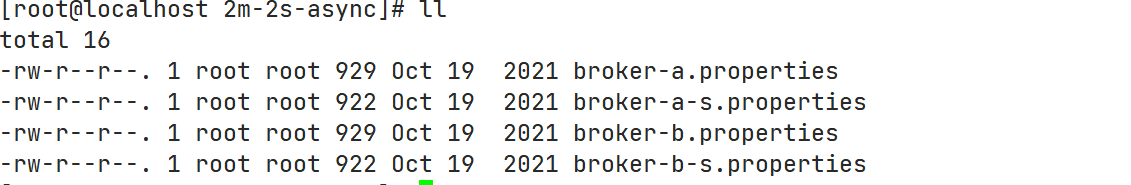

配置文件位置

要修改的配置文件在RocketMQ解压目录的conf/2m-2s-async目录中

修改broker-a.properties

将该配置文件内容修改为如下:

# 指定整个broker集群的名称,或者说是RocketMQ集群的名称 brokerClusterName=DefaultCluster # 指定master-slave集群的名称。一个RocketMQ集群可以包含多个master-slave集群 brokerName=broker-a # master的brokerId为0 brokerId=0 # 指定删除消息存储过期文件的时间为凌晨4点 deleteWhen=04 # 指定未发生更新的消息存储文件的保留时长为48小时,48小时后过期,将会被删除 fileReservedTime=48 # 指定当前Broker为异步复制master brokerRole=ASYNC_MASTER # 指定刷盘策略为异步刷盘 flushDiskType=ASYNC_FLUSH # 指定NameServer的地址 namesrvAddr=192.168.56.11:9876;192.168.56.12:9876

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

修改broker-b-s.properties

将该配置文件内容修改如下

brokerClusterName=DefaultCluster # 指定这是另一个master-slave集群 brokerName=broker-b # slave的brokerId为非0 brokerId=1 deleteWhen=04 fileReservedTime=48 # 指定当前Broker为slave brokerRole=SLAVE flushDiskType=ASYNC_FLUSH namesrvAddr=192.168.56.11:9876;192.168.56.12:9876 # 指定Broker对外提供服务的端口,即Broker与Producer与Consumer通信的端口。默认为10911.由于当前主机同时充当着master1与slave2,而前面的master1使用的是默认端口,这里需要将两个端口加以区分,以区分master1与slave2 listenPort=11911 # 指定消息存储相关的路径。默认路径为~/store目录。由于当前主机同时充当着master1与slave2,master1使用的是默认路径,这里需要指定一个不同的路径 storePathRootDir=~/store-s storePathCommitLog=~/store-s/commitLog storePathConsumeQueue=~/store-s/consumequeue storePathIndex=~/store-s/index storeCheckpoint=~/store-s/checkpoint abortFile=~/store-s/abort

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

其他配置

除了以上配置外,这些配置文件中还可以设置其他属性。

# 指定整个broker集群的名称,或者说是RocketMQ集群的名称 brokerClusterName=DefaultCluster # 指定master-slave集群的名称。一个RocketMQ集群可以包含多个master-slave集群 brokerName=broker-a # 0表示Master,>0 表示Salve brokerId=0 # 指定NameServer的地址,以分号分割 namesrvAddr=192.168.56.11:9876;192.168.56.12:9876 # 默认为新建Topic所创建的队列数 defaultTopicQueueNums=4 # 是否允许 Broker 自动创建Topic,建议生产环境关闭 autoCreateTopicEnable=true # 是否允许 Broker 自动创建订阅组,建议生产环境关闭 authoCreateSubscriptionGroup=true # 指定Broker对外提供服务的端口,即Broker与Producer与Consumer通信的端口。 listenPort=11911 # HA高可用监听端口,即Master与Slave间通信的端口,默认值为listerPort+1 haListenPort=10912 # 指定删除消息存储过期文件的时间为凌晨4点 deleteWhen=04 # 指定未发生更新的消息存储文件的保留时长为48小时,48小时后过期,将会被删除 fileReservedTime=48 # 指定commitLog目录中每个文件的大小,默认1G mapedFileSizeCommitLog=1073741824 # 指定ConsumeQueue的每个Topic的每个Queue文件中可以存放的消息数量,默认30w条 mapedFileSizeConsumeQueue=300000 # 在清除过期文件时,如果该文件被其他线程所占用(引用数大于0,比如读取消息),此时会阻止此次删除任务,同时在第一次试图删除该文件时记录当前时间戳。该属性则表示从第一次拒绝删除后开始计时,该文件最多可以保留的时长。再次时间内若引用数仍不为0,则删除仍会被拒绝。不过时间到后,文件将被强制删除。 destoryMapedFileIntervalForcibly=120000 # 指定commitlog、consumequeue所在磁盘分区的最大使用率,超过该值,则需立即清除过期文件 diskMaxUsedSpaceRatio=88 # 指定store目录的路径,默认在当前用户主目录中 storePathRootDir=~/store-s # commitLog目录路径 storePathCommitLog=~/store-s/commitLog # consumqueue目录路径 storePathConsumeQueue=~/store-s/consumequeue # index目录路径 storePathIndex=~/store-s/index # checkpoint文件路径 storeCheckpoint=~/store-s/checkpoint # abort文件路径 abortFile=~/store-s/abort # 指定消息的最大大小 maxMessageSize=65536 # Broker的角色 # - ASYNC_MASTER 异步复制Master # - SYNC_MASTER 同步双写Master # - SLAVE brokerRole=ASYNC_MASTER # 刷盘策略 # - ASYNC_FLUSH 异步刷盘 # - SYNC_FLUSH 同步刷盘 flushDiskType=ASYNC_FLUSH # 发消息线程池数量 sendMessageThreadPoolNums=128 # 拉消息线程池数量 pullMessageThreadPoolNums=128 # 强制指定本机IP,需要根据每台机器修改。官方介绍可为空,系统默认自动识别,但多网卡时IP地址可能读取错误。 brokerIp1=192.168.56.11

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

克隆生成RocketMQOS2

克隆RocketMQOS1主机,并修改配置。指定主机名为RocketMQOS2.

修改RocketMQOS2配置文件

配置文件位置

要修改的配置文件在RocketMQ解压目录的conf/2m-2s-async目录中

修改broker-b.properties

将该配置文件内容修改为如下:

brokerClusterName=DefaultCluster

brokerName=broker-b

brokerId=0

deleteWhen=04

fileReservedTime=48

brokerRole=ASYNC_MASTER

flushDiskType=ASYNC_FLUSH

namesrvAddr=192.168.56.11:9876;192.168.56.12:9876

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

修改broker-a-s.properties

将该配置文件内容修改如下

brokerClusterName=DefaultCluster

brokerName=broker-a

brokerId=1

deleteWhen=04

fileReservedTime=48

brokerRole=SLAVE

flushDiskType=ASYNC_FLUSH

namesrvAddr=192.168.56.11:9876;192.168.56.12:9876

listenPort=11911

storePathRootDir=~/store-s

storePathCommitLog=~/store-s/commitLog

storePathConsumeQueue=~/store-s/consumequeue

storePathIndex=~/store-s/index

storeCheckpoint=~/store-s/checkpoint

abortFile=~/store-s/abort

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

启动服务器

启动NameServer集群

分别启动RocketMQOS1与RocketMQOS2两个主机中的NameServer。启动命令完全相同。

$ nohup sh bin/mqnamesrv &

$ tail -f ~/logs/rocketmqlogs/namesrv.log

- 1

- 2

启动两个Master

分别启动RocketMQOS1与RocketMQOS2两个主机中的Broker Master。注意,它们指定所要加载的配置文件是不同的。

# RocketMQOS1

$ nohup sh bin/mqbroker -c conf/2m-2s-async/broker-a.properties &

$ tail -f ~/logs/rocketmqlogs/broker.log

# RocketMQOS2

$ nohup sh bin/mqbroker -c conf/2m-2s-async/broker-b.properties &

$ tail -f ~/logs/rocketmqlogs/broker.log

- 1

- 2

- 3

- 4

- 5

- 6

- 7

启动两个Slave

分别启动RocketMQOS1与RocketMQOS2两个主机中的Broker Slave。注意,它们指定所要加载的配置文件是不同的。

# RocketMQOS1

$ nohup sh bin/mqbroker -c conf/2m-2s-async/broker-b-s.properties &

$ tail -f ~/logs/rocketmqlogs/broker.log

# RocketMQOS2

$ nohup sh bin/mqbroker -c conf/2m-2s-async/broker-a-s.properties &

$ tail -f ~/logs/rocketmqlogs/broker.log

- 1

- 2

- 3

- 4

- 5

- 6

- 7