- 1spring的依赖检查(dependency-check属性)

- 2PLSA主题模型的EM算法推导_em算法推导出plsa的求解方案

- 3[ML-1]机器学习是什么?_ml机器学习什么意思

- 4ML模型3:逻辑回归模型

- 5【数据提取】 Python 提取PDF中的文字和图片_如何从pdf中提取rgba图片 python

- 62、STM32--EXTI(外部中断)&中断函数配置_stm32中断怎么配置

- 7hacker 入门指南_hacker怎么用

- 8oracle云数据库 免费的吗,使用免费的Oracle云服务-使用并监控ATP数据库

- 9(88)Part23-Nuxt.js服务器端渲染-01-服务端渲染技术_服务器端渲染技术

- 10超适合练手的一套JavaWeb项目 (超市后台管理系统)_luckyshop后台管理系统后台代码_前端小型超市管理后台

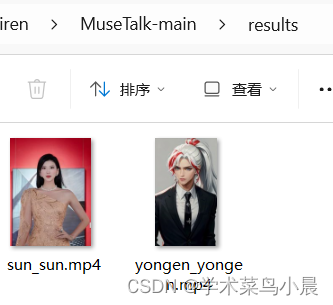

数字人实战第一天——最新数字人MuseTalk效果展示

赞

踩

最新数字人MuseTalk效果展示

MuseTalk 是由腾讯团队开发的先进技术,项目地址:GitHub - TMElyralab/MuseTalk: MuseTalk: Real-Time High Quality Lip Synchorization with Latent Space Inpainting,它是一个实时的音频驱动唇部同步模型。该模型能够根据输入的音频信号,自动调整数字人物的面部图像,使其唇形与音频内容高度同步。这样,观众就能看到数字人物口型与声音完美匹配的效果。MuseTalk 特别适用于256 x 256像素的面部区域,且支持中文、英文和日文等多种语言输入。在NVIDIA Tesla V100显卡上,MuseTalk 能够实现超过每秒30帧的实时推理速度。此外,用户还可以通过调整面部区域的中心点,进一步优化生成效果。

MuseTalk 可应用于多种场景,包括但不限于:

视频配音与唇同步:制作配音视频时,MuseTalk 能够根据音频调整人物的口型,从而提升视频的真实感和观看体验。

虚拟人视频生成:作为一整套虚拟人解决方案的一部分,MuseTalk 可以和 MuseV(视频生成模型)配合使用,创造出高度逼真的虚拟人演讲或表演视频。

视频制作与编辑:在视频制作和编辑中,当需要更改角色台词或语言而不愿重新拍摄时,MuseTalk 提供了一个高效的解决方案。教育和培训:在教育领域,MuseTalk 可以用于制作语言教学视频,帮助学习者更准确地学习语言发音和口型。

娱乐与社交媒体:内容创作者可以利用 MuseTalk 为照片或绘画作品添加口型动画,创造有趣的视频内容分享至社交媒体,为粉丝提供新颖的互动体验。

一、环境安装

- conda create -n vach python==3.10

-

- conda activate vach

-

- pip install -r requirements.txt

-

- pip install --no-cache-dir -U openmim

- mim install mmengine

- mim install "mmcv>=2.0.1"

- mim install "mmdet>=3.1.0"

- mim install "mmpose>=1.1.0"

二、模型下载

-

Download our trained weights.

-

Download the weights of other components:

- ./models/

- ├── musetalk

- │ └── musetalk.json

- │ └── pytorch_model.bin

- ├── dwpose

- │ └── dw-ll_ucoco_384.pth

- ├── face-parse-bisent

- │ ├── 79999_iter.pth

- │ └── resnet18-5c106cde.pth

- ├── sd-vae-ft-mse

- │ ├── config.json

- │ └── diffusion_pytorch_model.bin

- └── whisper

- └── tiny.pt

三、生成自己的数字人

- 修改configs/inference/realtime.yaml,将preparation改为True

- python -m scripts.realtime_inference --inference_config configs/inference/realtime.yaml

替换 realtime.yaml 的视频和语音就可是生成自己的数字人

- avator_1:

- preparation: True

- bbox_shift: 0

- video_path: "data/video/ce.mp4"

- audio_clips:

- #audio_0: "data/audio/yongen.wav"

- audio_1: "data/audio/sun.wav"