热门标签

热门文章

- 1什么是RPC?有哪些RPC框架?

- 2R9000P2021版拯救者 装ubuntu系统相关问题(WiFi、蓝牙、亮度调节,驱动安装)记录总结_r9000p重装蓝牙

- 3解决Spring Boot应用中的内存优化问题

- 4搭建hadoop+spark完全分布式集群环境

- 5软件测试除了做好功能测试自动化测试之外,如何在职位上获得提升?_测试工程师除了功能测试还能做什么

- 6BERT参数计算,RBT3模型结构

- 7Android Studio运行项目_android studio怎么运行当前项目csdn

- 8量化机器人能否实现多资产交易?

- 9深度学习环境配置_ubuntu18及以上_nvcc fatal : failed to preprocess host compiler pr

- 10数据库逻辑设计 完全函数依赖、部分函数依赖、传递函数依赖、码、候选码、主码、范式_数据库部分函数依赖

当前位置: article > 正文

[开源项目学习]langchain-chatchat学习笔记4_streamlit chatbox

作者:一键难忘520 | 2024-07-13 02:52:57

赞

踩

streamlit chatbox

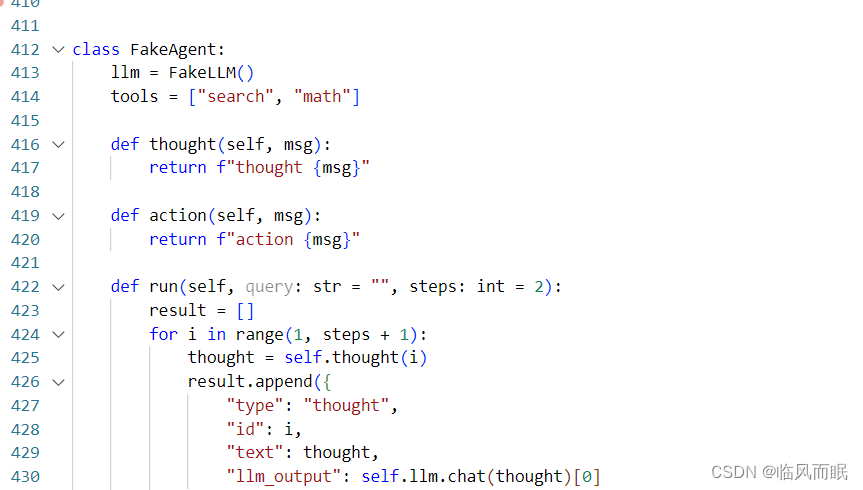

看看streamlit_chatbox这个组件

wok,github的readme里面写了这句话

这个比streamlit_chat好用

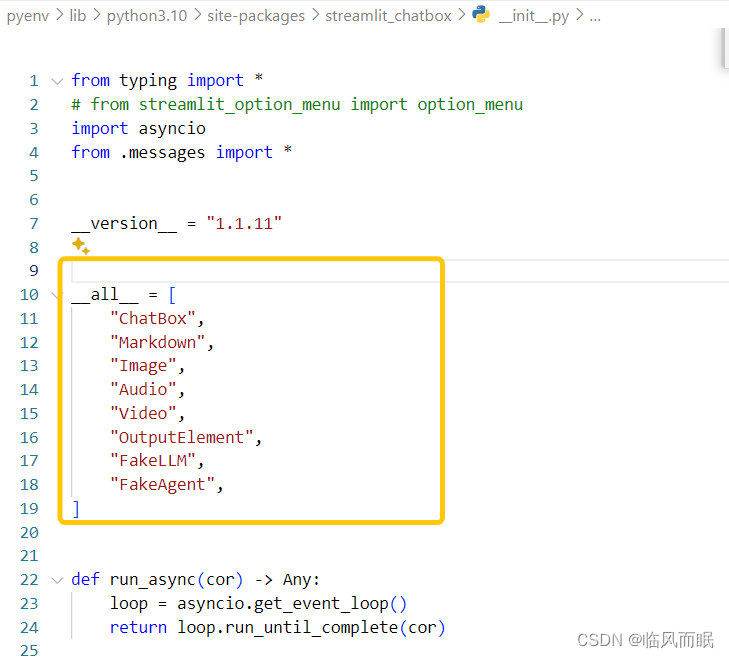

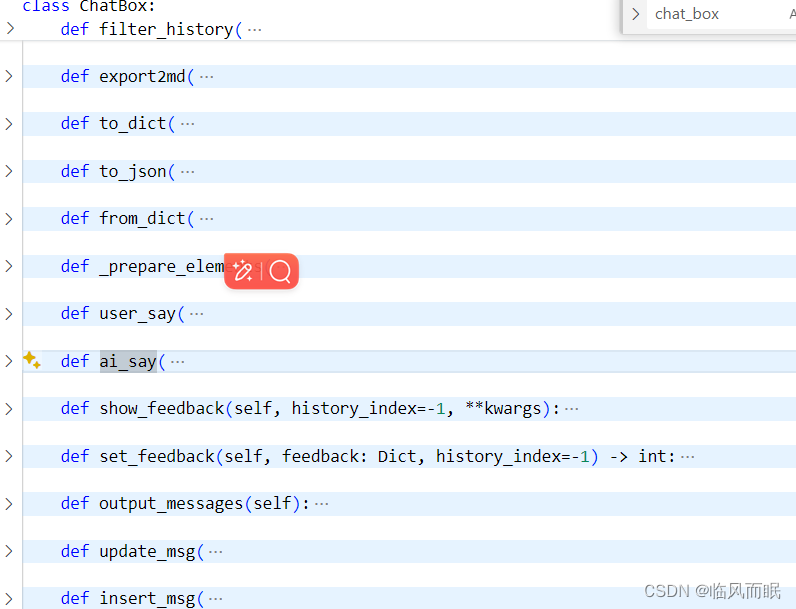

来看看源代码

变量__all__,其值为一个包含多个字符串的列表。这个变量定义了当其他模块使用from module import *语句导入当前模块时,哪些名称会被导入

能看出来确实是为LLM设计的hhh

还有不少类是空的,感觉很适合二次开发

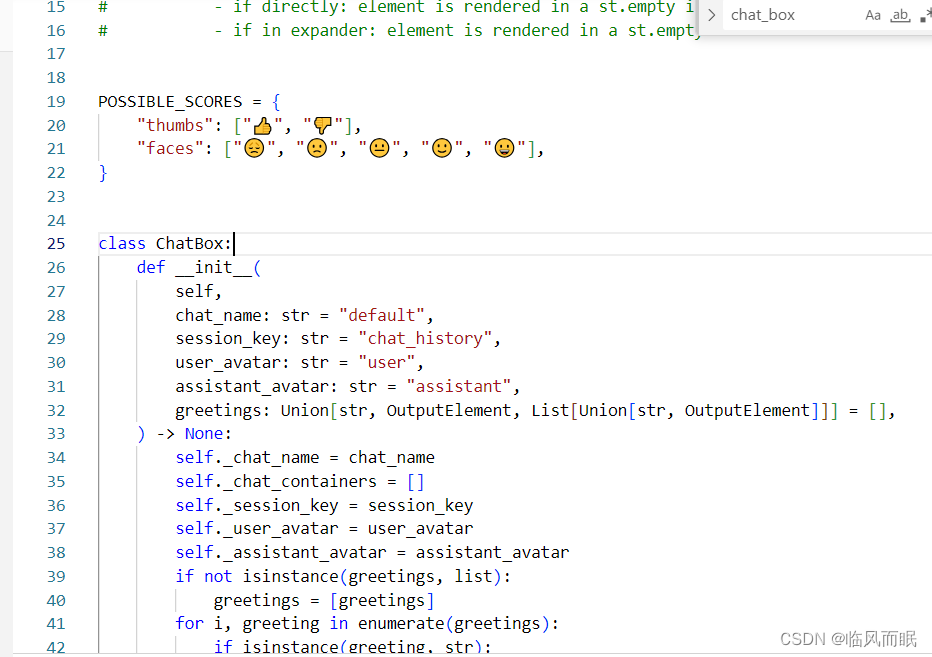

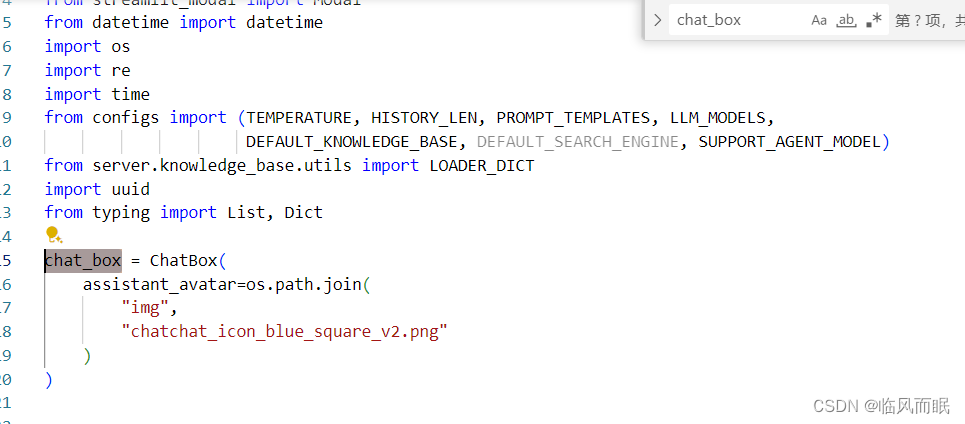

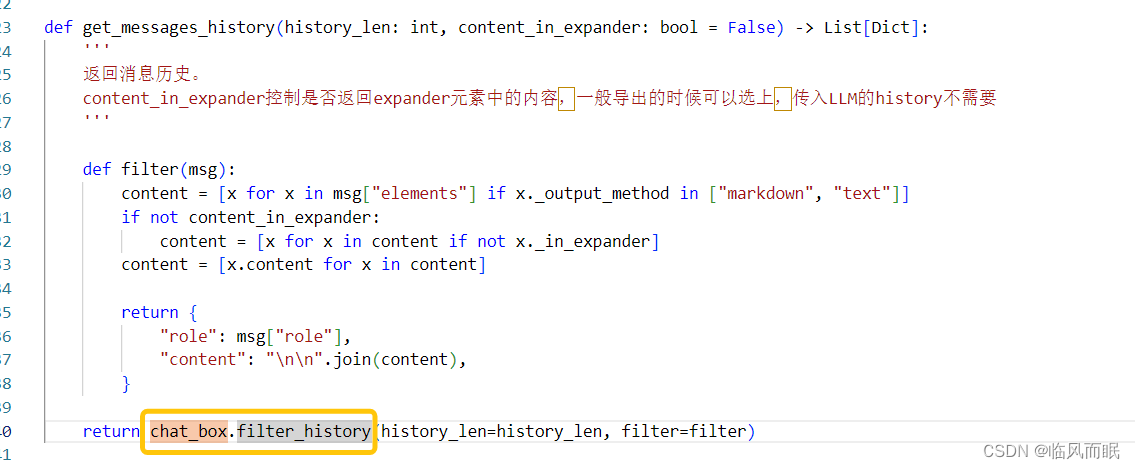

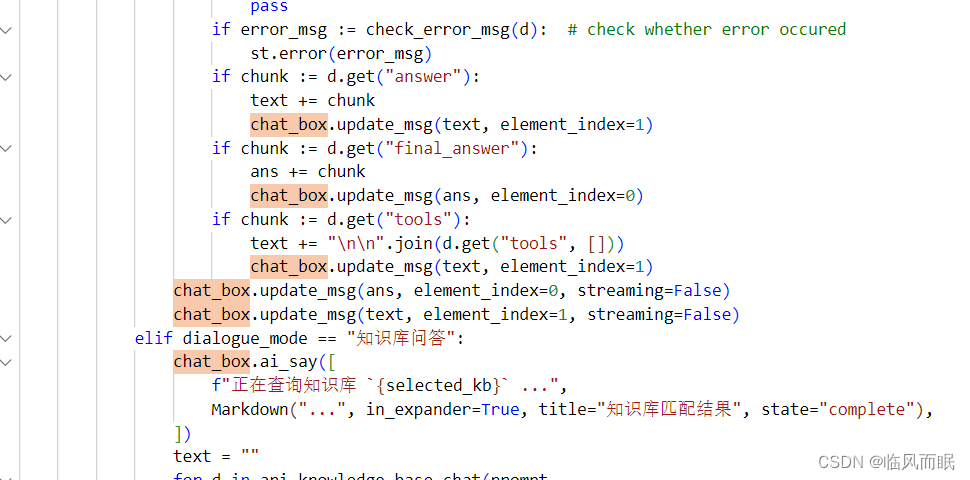

如何使用的ChatBox

核心在dialogue.py这个文件里面

ctrl+f 发现共有38处

都是调用的类中的方法

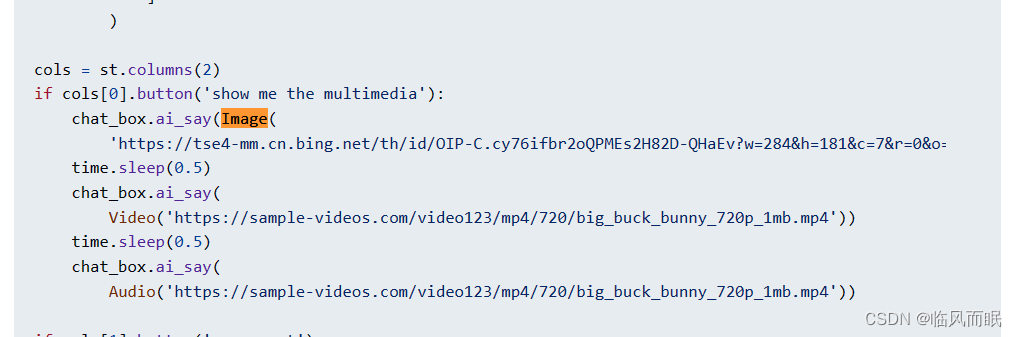

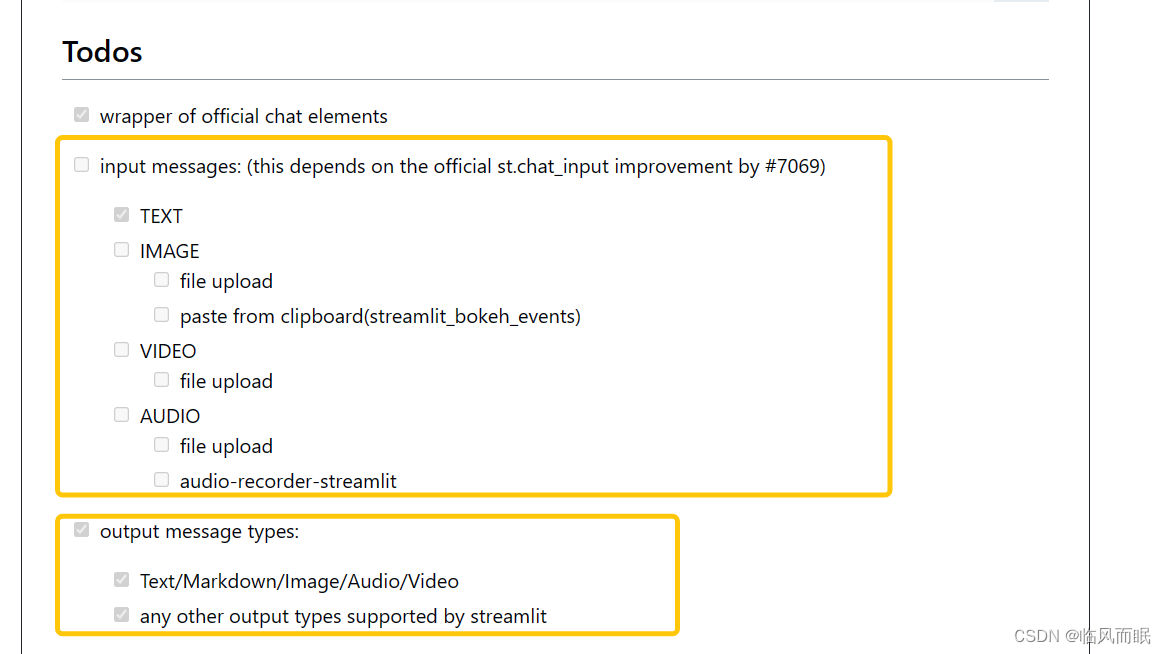

streamlit的其他chat组件

那个streamlit-chatbox目前输入只能是text,输出可以是很多种,看起来还挺方便的,发图片

- https://pypi.org/project/streamlit-chat-media/这个markdown,图片啥的都支持,但之前试了试,和很多别的环境版本冲突

- https://docs.streamlit.io/develop/api-reference/chat 官方论坛列举了很多,很多都是为了LLM而做了很多相应的设计,可以多看看官方blog

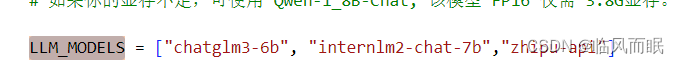

LLM切换

- 默认的是chatglm3-6b

- intern2lm-7b-chat支持200K上下文,下载下来玩玩

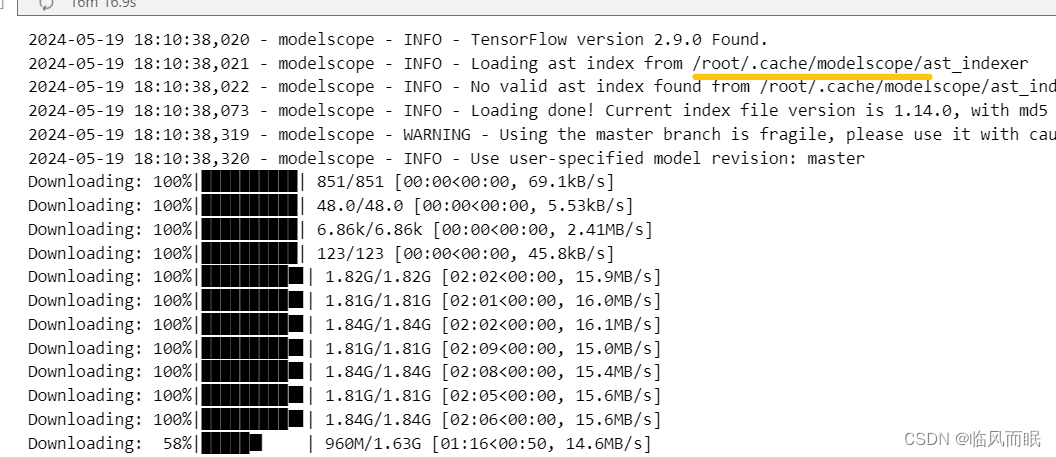

cache_dir可以下载到指定路径,不然是默认路径

from modelscope import snapshot_download

model_dir = snapshot_download('Shanghai_AI_Laboratory/internlm2-chat-7b', cache_dir='你的路径', revision='master')

- 1

- 2

- 3

网速快的时候还是挺爽的,划线画出来那个是默认路径

把用得上的放到list里面

emm internlm出现了很奇怪的bug,各种重复无止境循环… 换qwen玩了

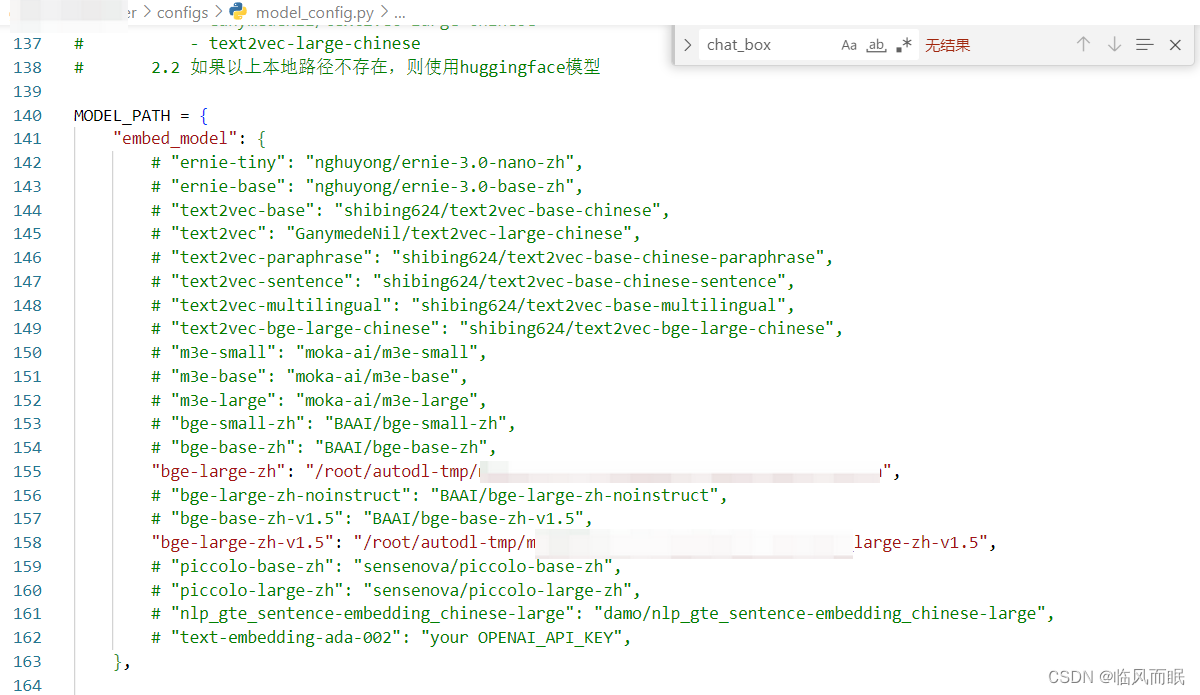

embedding模型切换

-

默认的是bge-large-zh

-

这个和前面的LLM的路径,都只需要在configs下的model_config.py添加就行

还有一种很好用的下载方式

HF_ENDPOINT=https://hf-mirror.com HF_HUB_ENABLE_HF_TRANSFER=1 huggingface-cli download` 模型名 --local-dir=想要存的路径 --cache-dir=./cache --local-dir-use-symlinks=False

- 1

参考

-

conda出现http429报错:CondaHTTPError: HTTP 429 TOO MANY REQUESTS for url <xxx> (我也遇到了这个错误)

-

报错:运行含有********的单元需要安装或更新ipykernel (pip比conda reinstall那个快)

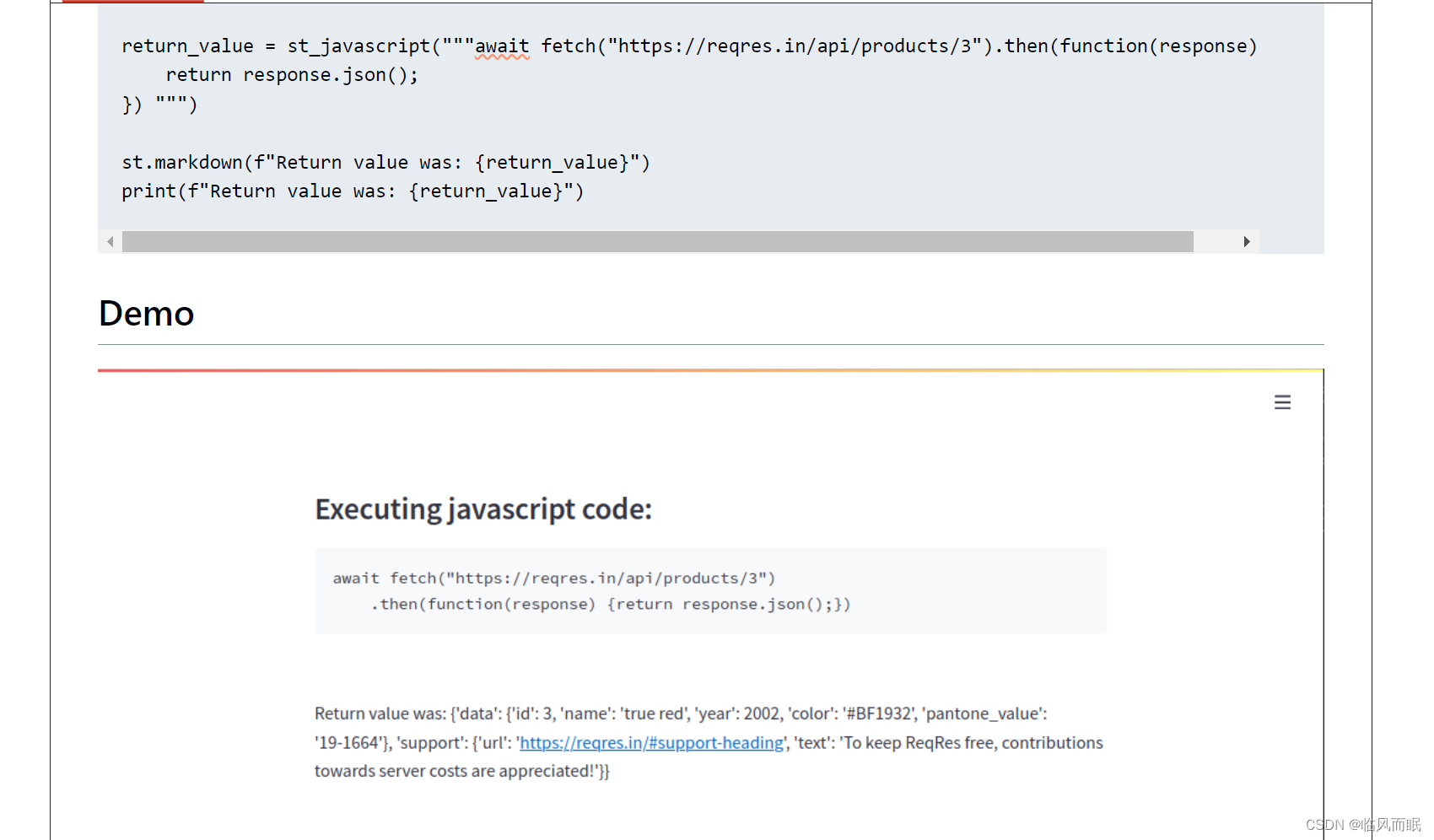

噢对昨天说的st中和js交互发现有人写了个包

之后试试效果

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/一键难忘520/article/detail/817290

推荐阅读

相关标签