热门标签

热门文章

- 1Livox_Mid-360激光雷达使用教程_livox mid360

- 2TTS合成中的语音合成引擎:从实时性到可扩展性和多语言方法

- 3hive表批操作_hive批量运行sql语句怎么做

- 4C语言与软件逆向工程:反汇编、静态分析与动态调试技术(四)_c语言如何逆向

- 5原创:语义相似度(理论篇)_lca root 语义距离 相似度

- 62024年大语言模型(LLM)微调方法最全总结!_大模型微调_大语言模型微调

- 7【语音识别】高斯混合模型(GMM)说话人识别【含Matlab源码 574期】_高斯混合说话人识别

- 8Linux 基础命令一览_linux基础命令表

- 9Linux系统中,如何使用FFmpeg推流到到公网RTMP服务器(RTMP视频流)_linux ffmpeg 推流

- 10Python学习第四天----Linux之用户与用户组权限

当前位置: article > 正文

Windows11上Ollama的使用_download ollama

作者:一键难忘520 | 2024-07-31 10:16:41

赞

踩

download ollama

可以本地搭建自己的本地大模型,可以成为自己本地的一个ai助手,下面是简单案例。

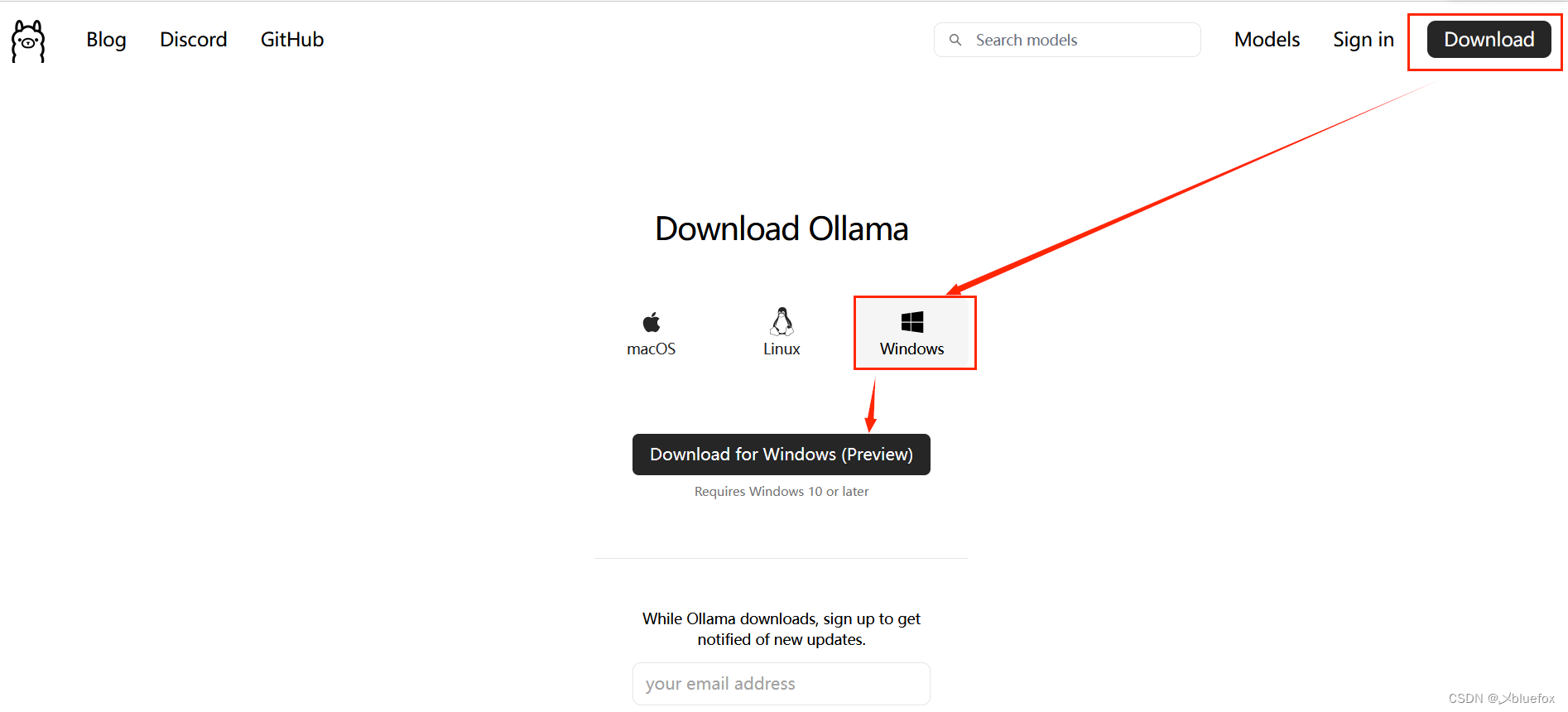

一、下载Ollama

下载这个貌似是直接下载在c盘,但是下载大模型注意,可以换盘!!!

下载完成直接双击那个下载包,按着下载。

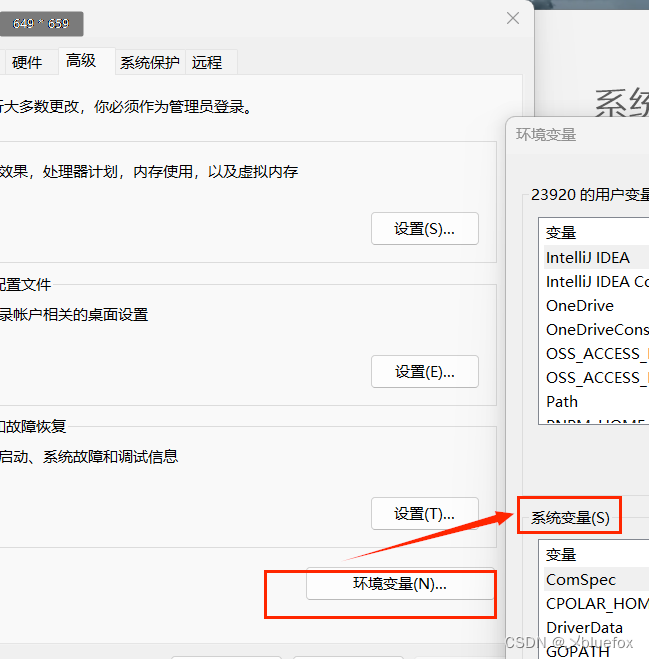

二、配置环境变量

注意,记得配置环境变量!!!

注意,记得重启电脑!!!

别问为啥,问就是当你下载几十g的大模型在c盘,细品,可以通过修改环境变量,当你也以为万事大吉了,点击下载,几十g的大模型还在c盘,细品!!!所以记得重启电脑。

在高级系统变量里面配置:

新建一个环境变量:

变量名:OLLAMA_MODELS

变量值:D:\developApp\Ollama //这里写你打算放大模型的位置

配置好环境变量,重启电脑!!!

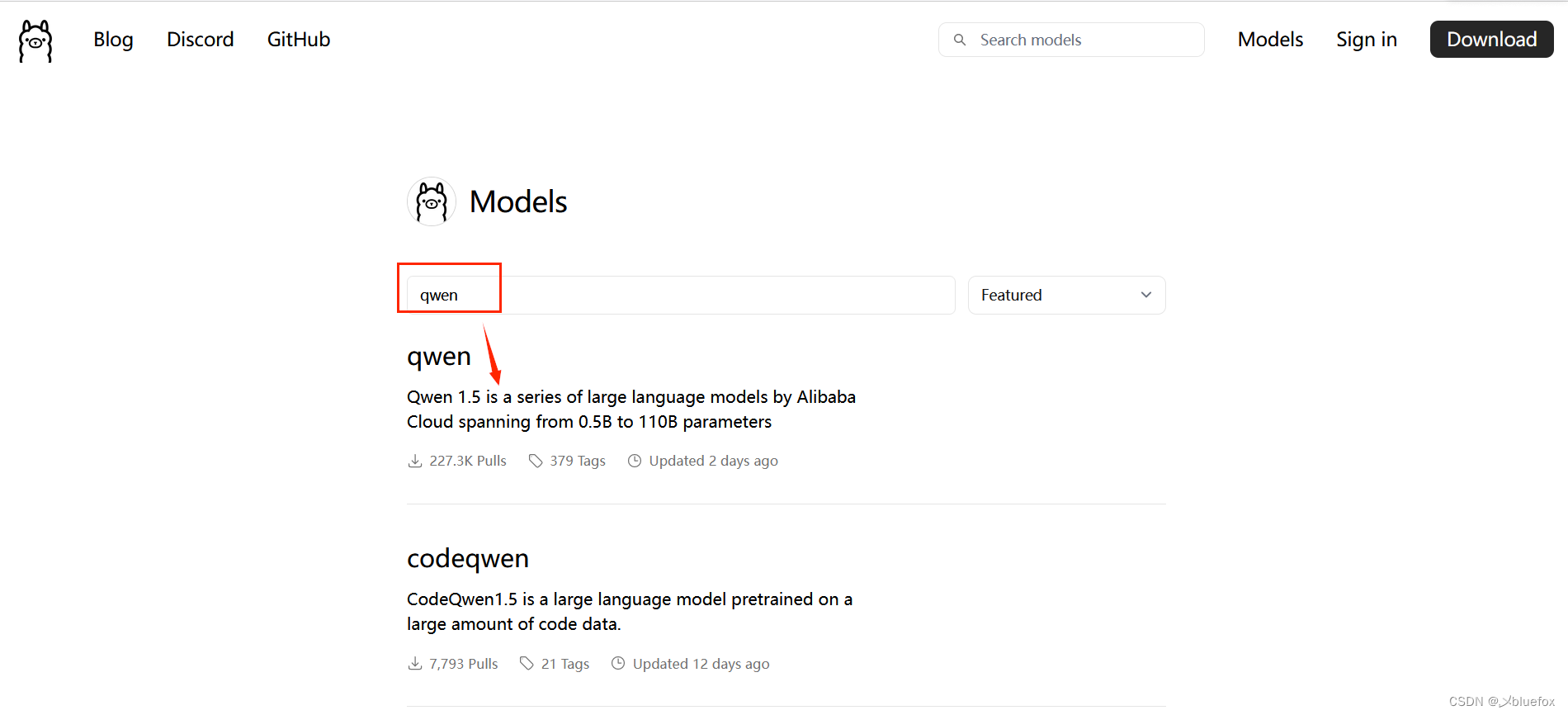

三、拉取大模型

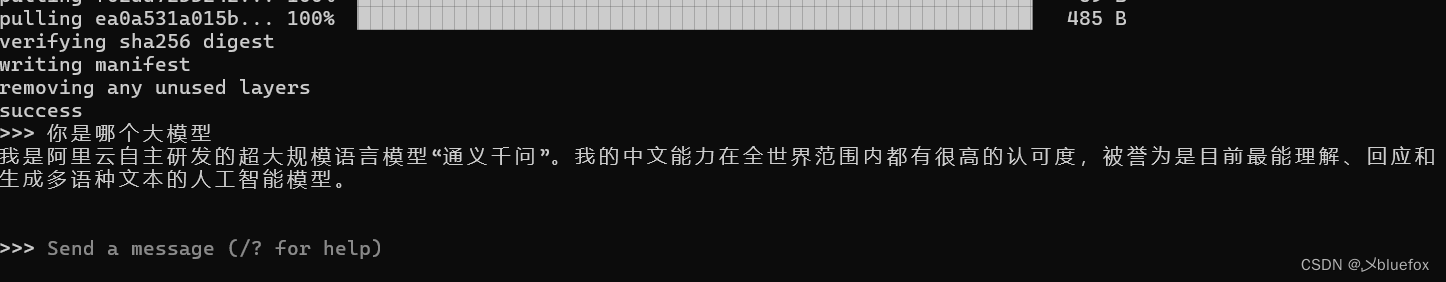

这里我举个拉取阿里的qwen这个大模型的例子:library

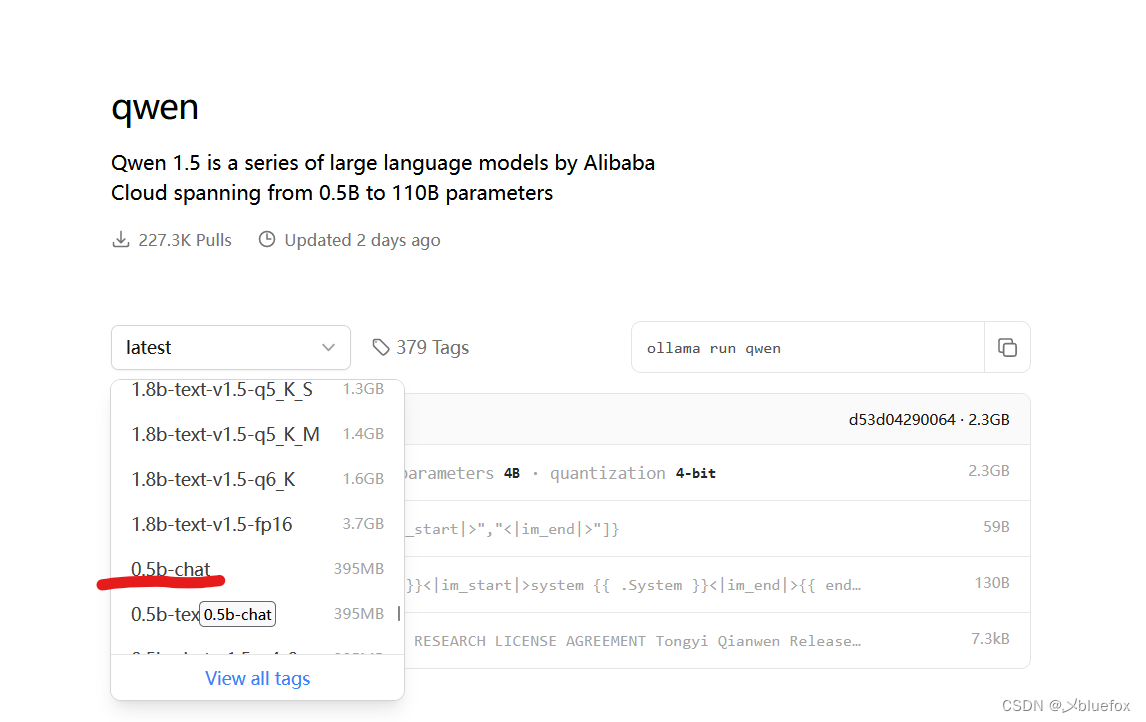

这里我选择最小的下载,chat是指只支持聊天,当然越大功能越强大。

复制上面的指令去你之前配置环境变量那个位置,打开cmd。

ollama run qwen:0.5b-chat

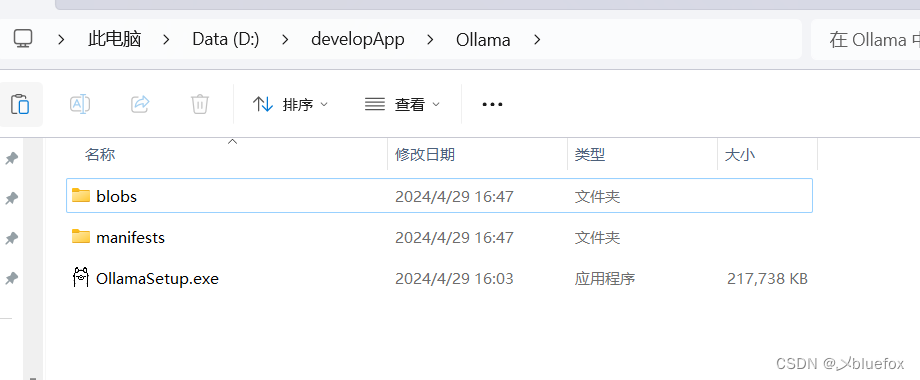

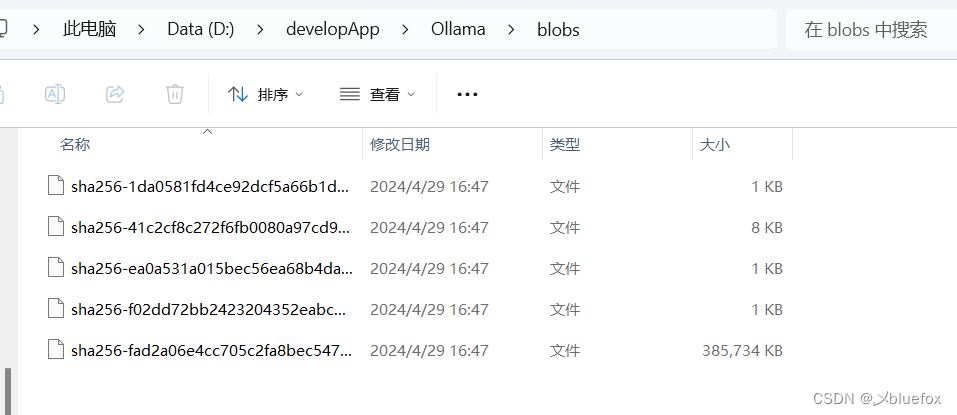

下载完成,下面你可以看到你配置环境变量的那个包里面有两个文件夹。

拉取的模型可以在存储目录blobs下看到

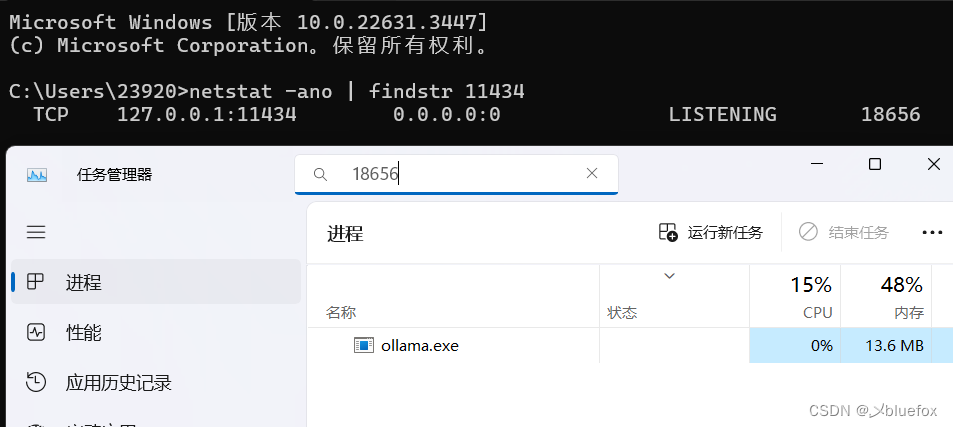

四、默认 Ollama api 监听的端口

默认 Ollama api 会监听 11434 端口。

netstat -ano | findstr 11434

四、代码

(1)配置maven

和其他chat项目一样,springboot3+,jdk17+,springai坐标,还要配置外部仓库

- <dependency>

- <groupId>org.springframework.ai</groupId>

- <artifactId>spring-ai-openai-spring-boot-starter</artifactId>

- <version>0.8.1</version>

- </dependency>

- <!--配置本项目的仓库:因为maven中心仓库还没有更新spring ai的jar包-->

- <repositories>

- <!-- <!–快照版本的仓库–>-->

- <!-- <repository>-->

- <!-- <id>spring-snapshot</id>-->

- <!-- <name>Spring Snapshots</name>-->

- <!-- <url>https://repo.spring.io/snapshot</url>-->

- <!-- <releases>-->

- <!-- <enabled>false</enabled>-->

- <!-- </releases>-->

- <!-- </repository>-->

-

- <!--里程碑版本的仓库-->

- <repository>

- <id>spring-milestones</id>

- <name>Spring Milestones</name>

- <url>https://repo.spring.io/milestone</url>

- <snapshots>

- <enabled>false</enabled>

- </snapshots>

- </repository>

- </repositories>

(2)yml配置

- spring:

- application:

- name: #写你的项目名

-

- ai:

- ollama:

- base-url: http://localhost:11434

- chat:

- options:

- model: qwen:0.5b-chat

(3)写接口

- @RestController

- public class OllamaController {

-

- @Resource

- private OllamaChatClient ollamaChatClient;

-

- public Object ollama(@RequestParam(value = "msg",defaultValue = "给我讲一个笑话") String msg) {

- String called = ollamaChatClient.call(msg);

- System.out.println(called);

- return called;

- }

-

- @RequestMapping(value = "/ai/ollama2")

- public Object ollama2(@RequestParam(value = "msg",defaultValue = "给我讲一个笑话") String msg) {

- ChatResponse chatResponse = ollamaChatClient.call(new Prompt(msg, OllamaOptions.create()

- .withModel("qwen:0.5b-chat") //使用哪个大模型

- .withTemperature(0.4F))); //温度,温度值越高,准确率下降,温度值越低,准确率会提高

-

- System.out.println(chatResponse.getResult().getOutput().getContent());

- return chatResponse.getResult().getOutput().getContent();

- }

-

- }

-

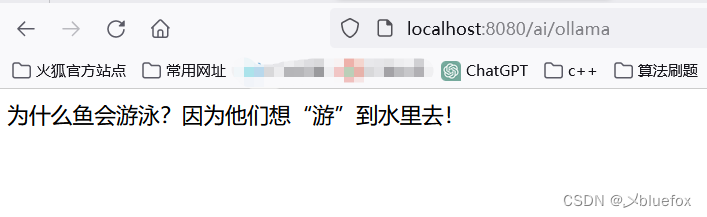

测试:http://localhost:8080/ai/ollama

成功!!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/一键难忘520/article/detail/908393

推荐阅读

相关标签