- 1CentOS7 中把yum源更换成163源_centos7-base-163.repo .

- 2redis6运行架构-多线程处理流程_redis的多线程处理过程

- 3AMD处理器下虚拟机VMware15安装macOS 10.14_macos mojave 10.14 18a391 lazy installer

- 4第四章 程序的控制结构_程序流程图中的控制结构

- 5【chrome】 谷歌小技巧 谷歌浏览器 自带 滚动截图 chrome滚动截屏(全屏截图)

- 6Python多线程爬虫——数据分析项目实现详解_python如何多线程爬虫

- 7代码随想录训练营day06|哈希表part06

- 8python with的使用方法_python with的用法

- 9算术操作符+,-,*,/,%_+-*/

- 10基于 Java Web 的毕业设计选题管理平台--选题报告与需求规格说明书

【AIGC专题】Stable Diffusion 从入门到企业级实战0402_stable diffusion-从入门到案例实

赞

踩

一、概述

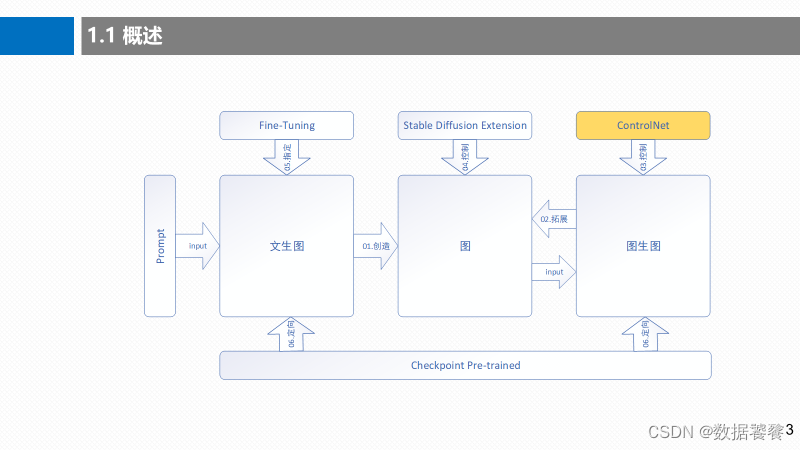

本章是《Stable Diffusion 从入门到企业级实战》系列的第四部分能力进阶篇《Stable Diffusion ControlNet v1.1 图像精准控制》第02节, 利用Stable Diffusion ControlNet Openpose模型精准控制图像生成。上一节,我们介绍了《Stable Diffusion ControlNet Inpaint模型精准控制》,本部分内容,位于整个Stable Diffusion生态体系的位置如下图黄色部分所示:

二、定义

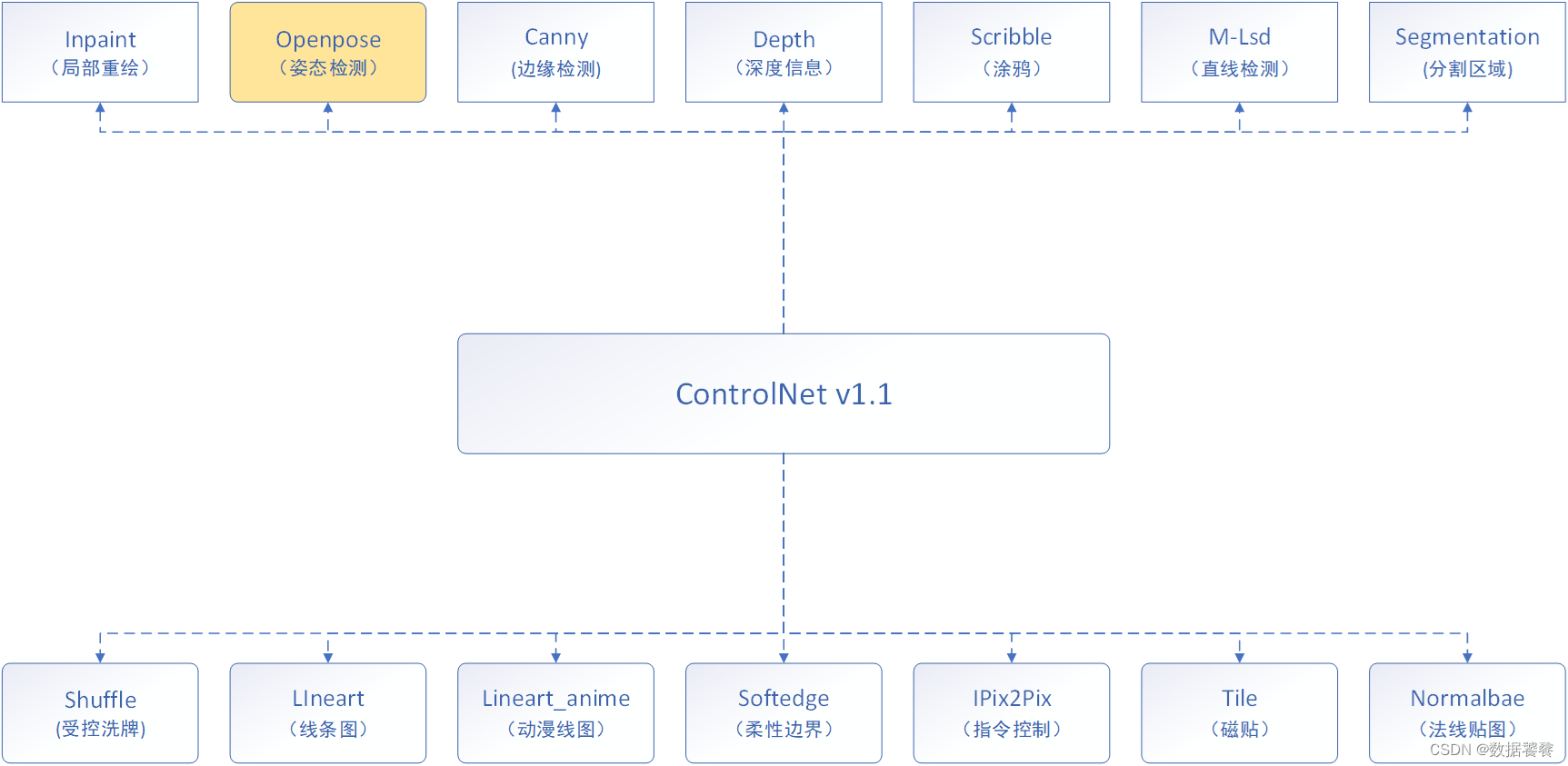

ControlNet v1.1 共提供了14个功能模型,每一个模型对应一个适用的业务场景,具体的模型信息如下图所示:

本文介绍的是ControlNet Openpose模型,Stable Diffusion openpose是在Stable Diffusion的图像生成过程中,结合openpose姿态估计技术,从而实现基于人体姿态的图像生成。

Openpose是一个通过深度学习来进行人体姿态估计的工具。它可以检测图片或视频中的人体,定位关键点,输出人体的骨架图和姿态。

三、工作流程

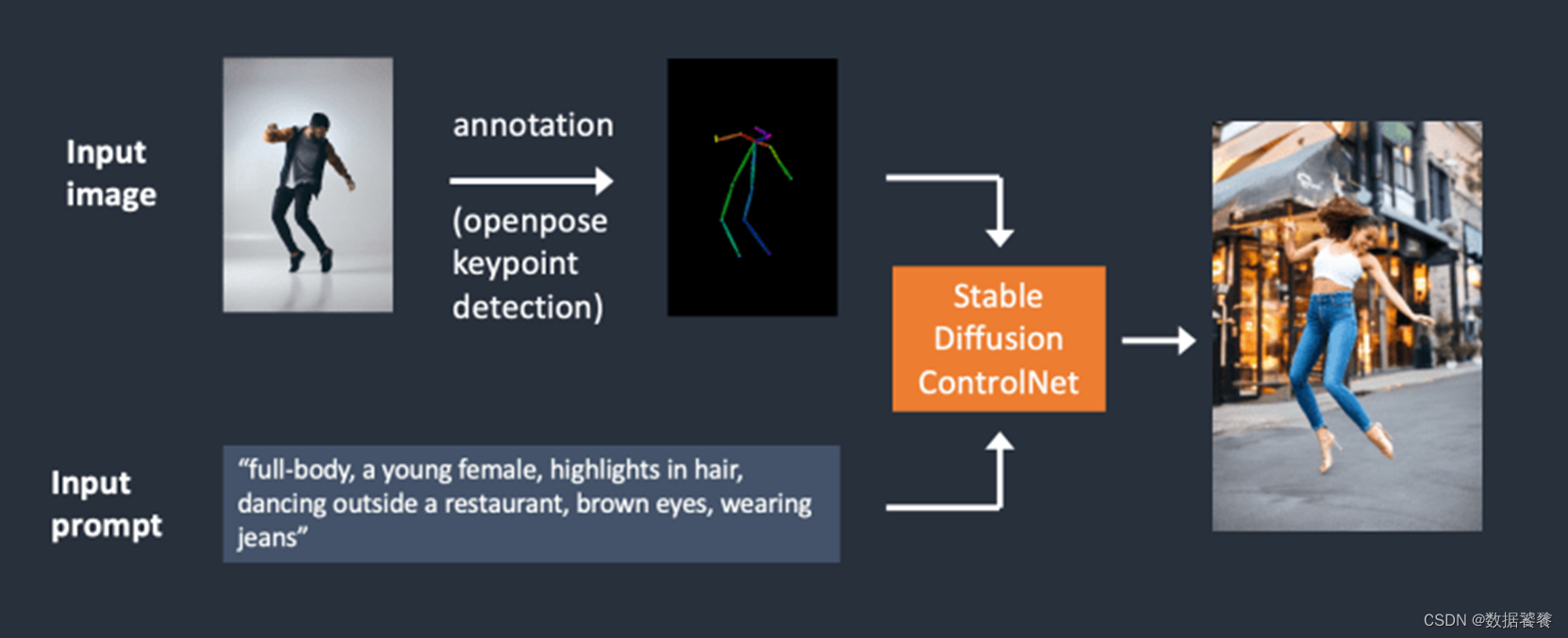

使用ControlNet Openpose工作流程如下图所示:

完整的工作流程描述,如下所示:

- 使用Openpose检测输入的人体姿态图片,提取出人体骨架关键点。

- 将提取出的骨架关键点作为条件,输入到Stable Diffusion中。

- Stable Diffusion结合关键点和其他文本描述,生成具有相应人体姿态的新图像。

四、创作成果

利用ControlNet Openpose技术,通过姿态检测,实现的图像精准控制效果如下图所示:

目标人物和源人物保持同样的姿态信息。

五、创作过程

5.1 工作步骤

整个的创作过程可以分为4个步骤,如下图所示:

环境部署:启动ControlNet Openpose WebUI服务;

模型下载:下载ControlNet Openpose WebUI模型;

操作实战:选择输入、配置参数和运行;

运行演示:展示图像生成的效果;

5.2 环境部署

为了降低集成封装对于我们了解底层实现的影响,我们采用的ControlNet v1.1 原生框架部署,而非集成可视化界面环境,具体的ControlNet Openpose服务程序如下图所示,我们只需要启动该程序即可:

5.3 模型下载

ControlNet v1.1 Openpose 预训练模型主要有两个,如下图所示:

5.4 操作实战

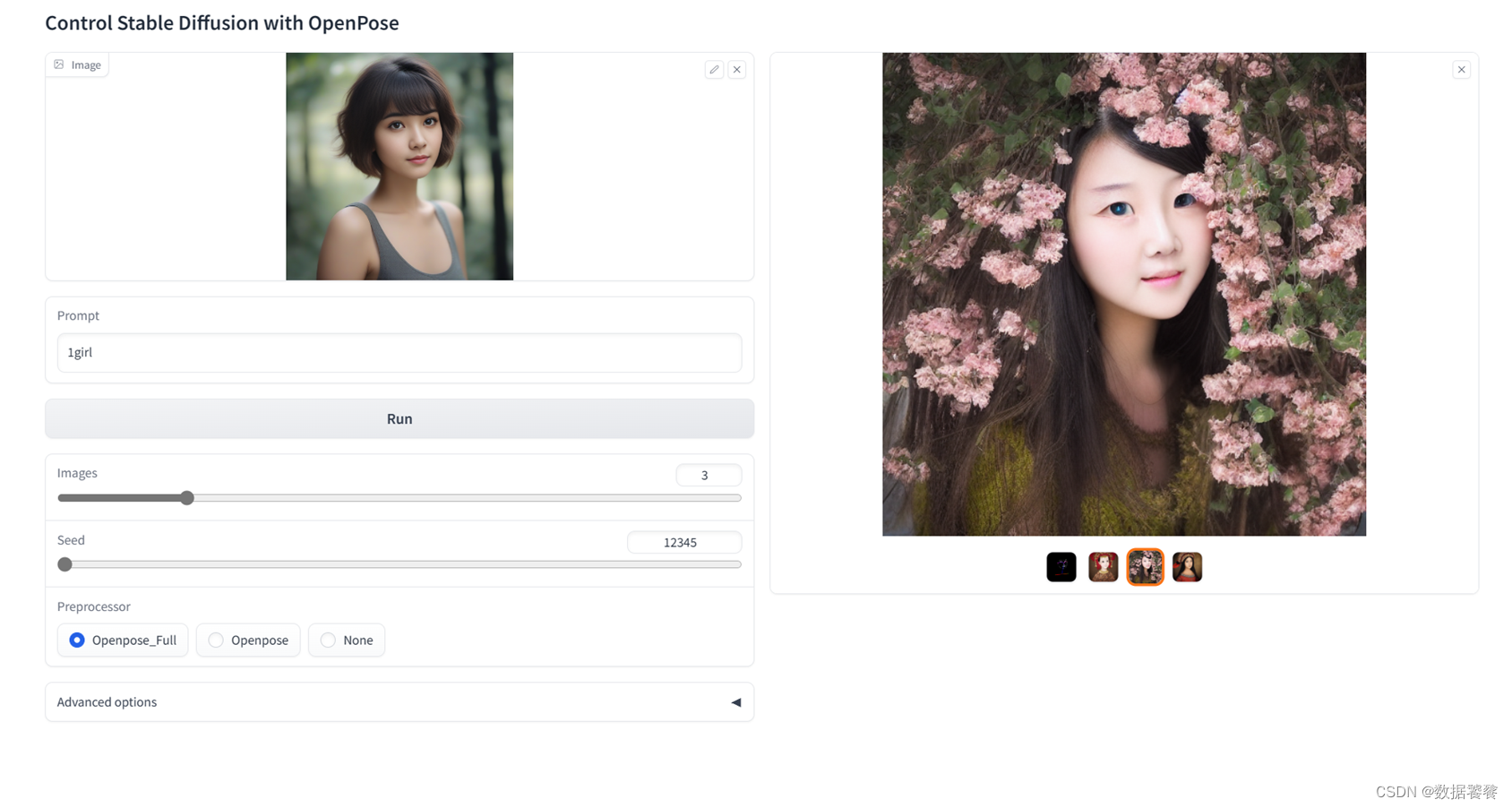

因为是可视化操作界面,可以一目了然的了解操作的方法和过程,具体细节我们不再赘述,直接上配置界面,如下图所示:

5.5 运行演示

六、小结

本章是《Stable Diffusion 从入门到企业级实战》系列的第四部分能力进阶篇《Stable Diffusion ControlNet v1.1 图像精准控制》第02节, 利用Stable Diffusion ControlNet Openpose模型精准控制图像生成。 上一节,我们介绍了《Stable Diffusion ControlNet Inpaint模型精准控制》,下一节,我们将给大家带来,利用《Stable Diffusion ControlNet Canny边缘检测精准控制图像生成》。