- 1德国汉堡科学院院士张建伟教授最新演讲:新时代的机器人技术创新_汉堡科学院院士张建伟的演讲

- 2js Blob、ArrayBuffer(Uint8Array、TypedArray、DataView)、Buffer、DataUrl_js bufferarray

- 3怪物猎人世界pc服务器在哪个文件夹,关于PC怪物猎人世界拆包文件的一些问题...

- 4CentOS 7 SSH 免密登录的方法_centos7 ssh免密登录

- 5当创作者遇上 Crypto:开启「创作者经济」的新范式

- 6java版gRPC实战之五:双向流,rabbitmq持久化原理_responseobserver.oncompleted();

- 7C语言 fclose 函数 - C语言零基础入门教程_fclose()

- 8让你的简历不落窠臼,精雕细镂写一份真正的技术简历(Python向)_python简历项目经验

- 9钉钉电脑版扫描登录不了出现二维码失效和手机上确认登录电脑端没反应_203.119.129.47:443

- 10【附源码】Java计算机毕业设计微信小程序的商城管理系统(程序+LW+部署)_java+ 微信小程序物资管理系统

使用镜像源下载Hugging Face模型_hugging face 国内镜像

赞

踩

使用国内的网络甚至使用科学上网在hugging face中transformer上下载模型参数往往会失败,这个时候就需要我们手动去hugging face的model hub中下载需要的模型参数,这样十分费时费力。本博客旨在解决这个问题,使研究者们在使用模型下载模型参数上少花时间,将更多的精力花费在更有价值的地方。

方法:

主要参考

(11 封私信 / 78 条消息) 如何看待huggingface.co已无法访问? - 知乎 (zhihu.com)

我结合博文以及评论大神给的代码,构建了属于自己的下载模型方法。

1. 下载git lfs

这个东西用来下载大的模型权重文件,比如几个G的pytorch_model.bin文件,我的这个场景是linux,不知道windows需不需要。下载这个东西的方法有很多,搜索git lfs安装一大堆,这里我是在实验室服务器上,没有sudo权限,用的和这个从local user安装到使用的git-lfs采坑小结 - 一个兔子洞 | Y's Blog (hua-ys.github.io)差不多的方法。主要的点是1.将install.sh文件prefix后面的路径修改为local user下的自定义路径 2.bash xxx/install.sh之后一定要注意要有export PATH=$PATH:your_path这个命令,比如你install xxx/install.sh之后,安装到了自定义的路径/home/xxx/git-lfs/bin/git-lfs,要在终端使用export PATH=$PATH:/home/xxx/git-lfs/bin导入到全局变量里(这是我踩过的坑和大家说一下)

2. 在要下载模型配置的文件夹下使用 git lfs install

这一步的命令是为了把这个文件夹变成一个git文件夹,便于从网上拉取文件

3. 使用脚本下载模型文件

脚本在这里Command-line Tool for Easy Downloading of Huggingface Models (github.com)

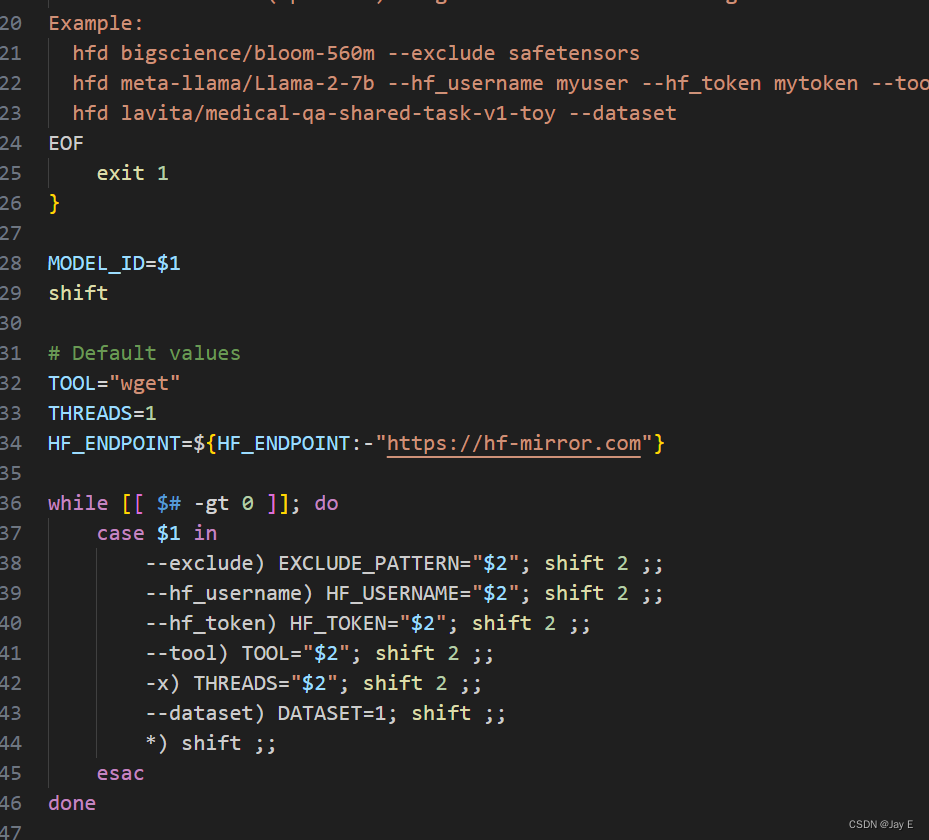

我直接跑这个脚本因为网络的原因跑不通,需要对脚本稍作修改,改成下图所示,使用镜像网站。

然后使用下面这条命令,在终端里跑

xxx/hdf.sh meta-llama/Llama-2-7b --hf_username xxx --hf_token xxx

这里给了个例子,把上面的“meta-llama/Llama-2-7b”换成你要的模型配置路径, hf_username换成你hugging face账号的user name,hf_token换成你账号中的token,在这里可以查看到Hugging Face – The AI community building the future.

通过上面的步骤就可以下载模型啦!希望这篇博客在帮助我自己回忆解决方案的同时,对大家也有点帮助!