热门标签

热门文章

- 1Android Studio 报错(Installed Build Tools revision 3X.0.0 is corrupted)解决方法_please install the android sdk platform "platforms

- 22018年河北省对口高考计算机专业,2018年河北省普通高职单招考试十类和对口电子电工类、计算机类联考考试时间...

- 3JVM监控及诊断工具--- JProfiler_jprofiler多少钱一年

- 4linux内核网络协议栈--网卡报文收发(十六)_ixgbe_poll

- 5【自学Jetpack Compose 系列】Compose 介绍以及开发环境搭建与项目创建_jetpact compose项目

- 6零一万物API开放平台出场!通用Chat多模态通通开放,还有200K超长上下文版本...

- 7Cause: java.sql.SQLException: 无法转换为内部表示(Mybatis)

- 8yolov5环境配置:cuda(GPU)+anaconda+pytorch+pycharm的安装_yolov5环境搭建pycharm

- 9Ubuntu grub2的启动配置文件grub.cfg,为了修改另人生厌的时间

- 10《教育学原理》知识框架整理_我们已经知道,知识,德行

当前位置: article > 正文

ChatGLM3的部署(windows版)_glm3 half quantize(4)

作者:不正经 | 2024-03-16 19:41:06

赞

踩

glm3 half quantize(4)

1.环境准备

python环境

参考:python环境安装(windows版)-CSDN博客

cuda环境(使用GPU调试时需要使用,使用cpu可以不装)

2.工具准备

Git安装:Git下载和安装-CSDN博客

pycharm安装:pycharm的下载和安装-CSDN博客

3.下载源码

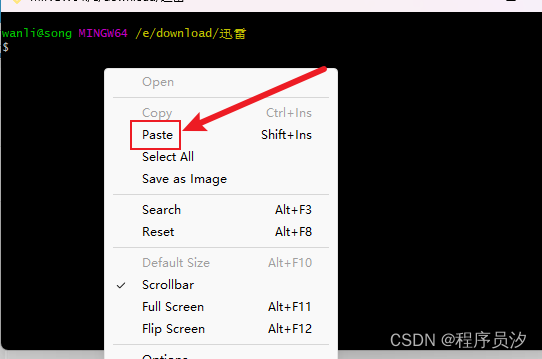

1.进入想下载到的路径后右键选择Open Git Bash Here

2.复制Git路径并粘贴进去

Git路径:

git clone https://github.com/THUDM/ChatGLM3由于不能使用ctrl+v,只能右键粘贴进去

3.git路径粘贴进去后回车

如图就已经下载完了

4.下载完毕

可以在文件夹中看到ChatGLM3文件夹

4.运行项目

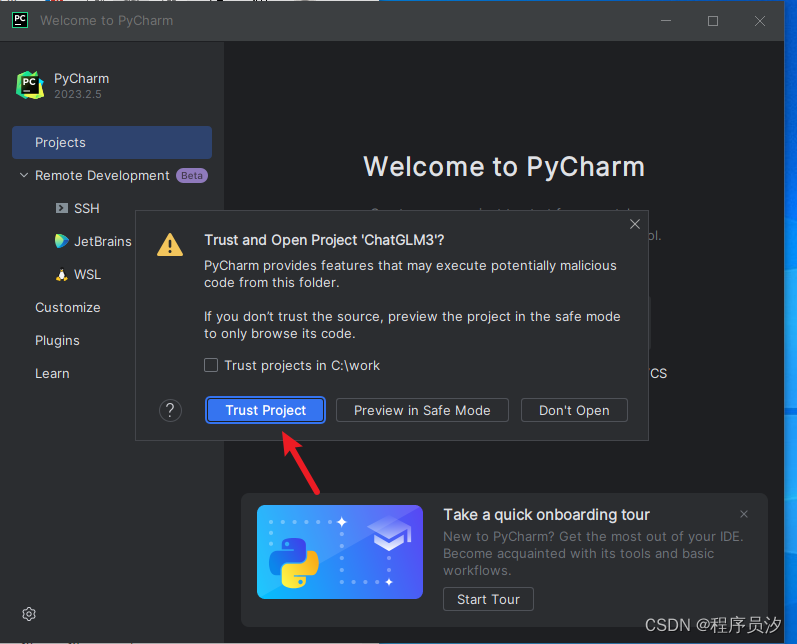

1.使用pycharm打开

1.点击open

2.选择文件

选中后点击ok

3.项目打开

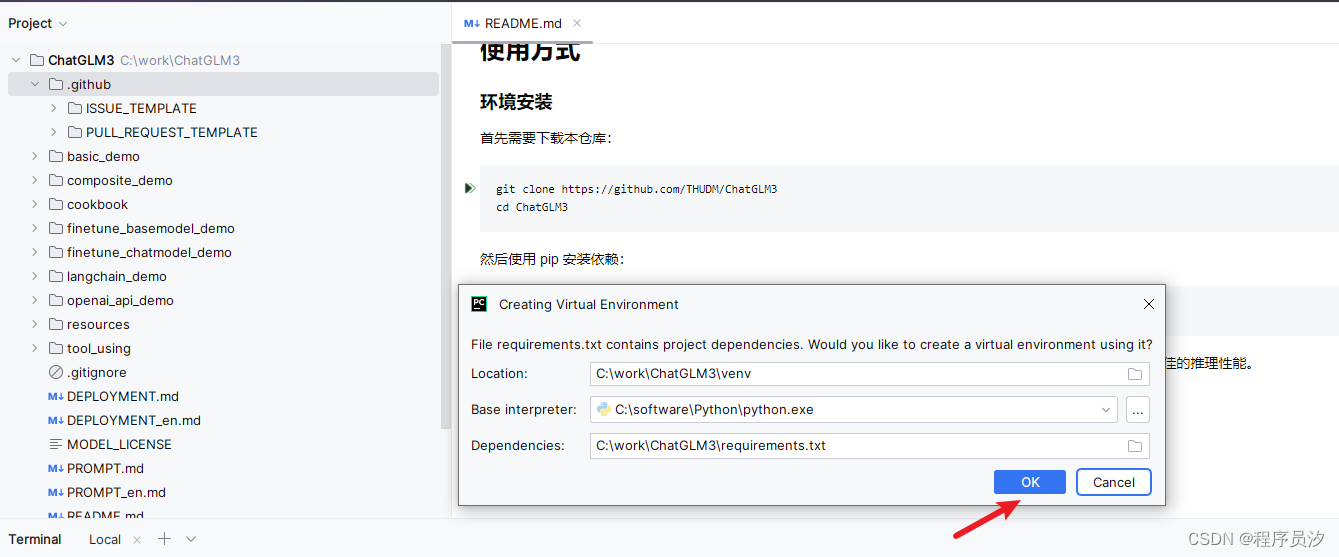

4.创建虚拟环境

项目加载完毕后自动弹出,点击OK

5.下载项目中所需要的依赖

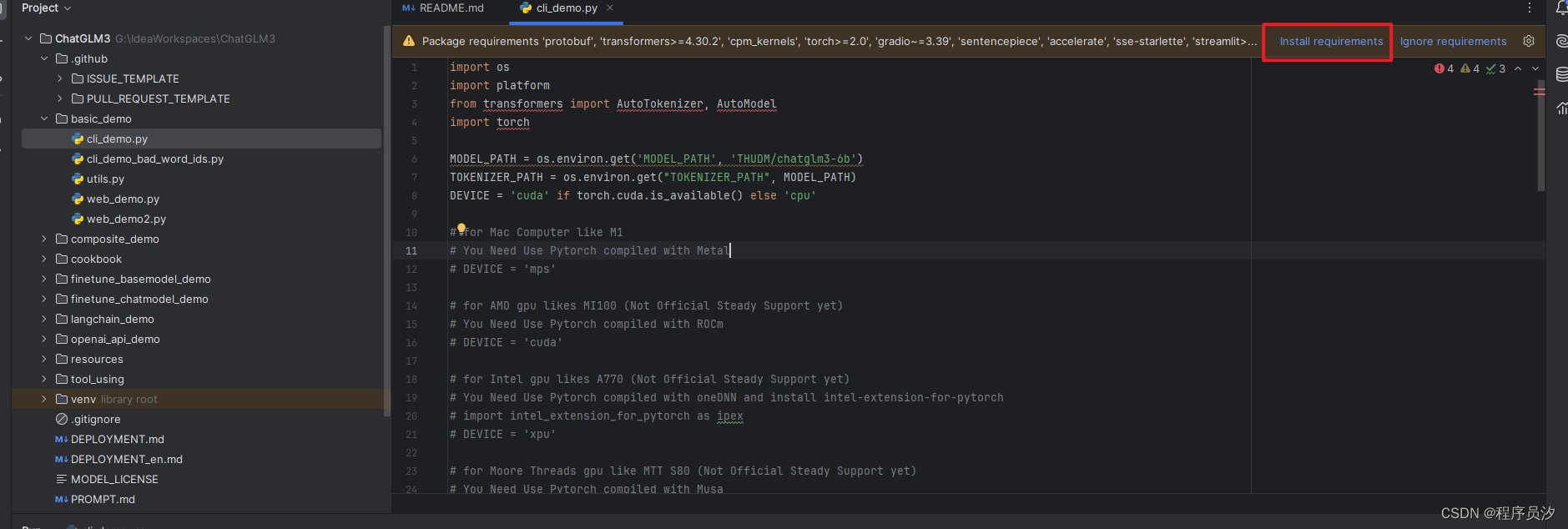

打开basic_demo的任意一个demo文件(cli_demo.py/web_demo.py)会出现如下图所示,点击框选处

点击后入下图所示,全选后点击install。如果没有通过这种方式安装,需要在终端一个一个安装

2.下载依赖

1.打开终端

2.输入命令行加载依赖

pip install -r requirements.txt整个过程下载较慢,如果上面的下载失败可以使用豆瓣

pip install -r requirements.txt -i http://pypi.douban.com/simple --trusted-host pypi.douban.com3.下载完成

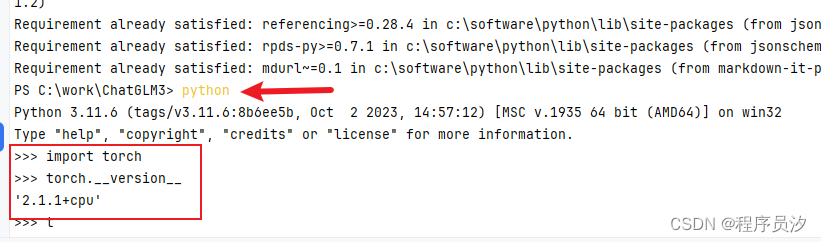

4.查看torch版本(使用cpu运行可忽略,GPU运行则需要验证)

控制台输入

- --控制台输入

- python

- 然后输入

- import torch

- 查看torch版本

- torch.__version__ (注意这里是两个横线组成的下划线,不是一根!!!)

'2.1.1+cpu'则代表torch是cpu版本的,如果需要使用gpu调试则需要安装GPU版本

5.安装GPU版torch(需使用GPU运行时安装)

- 卸载torch

- pip uninstall torch torchvison torchaudio

-

- 安装GPU版本torch

- pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

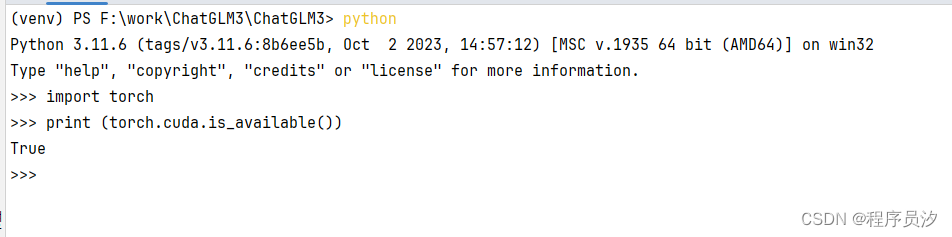

6.验证cuda是否和torch兼容(GPU运行需验证)

- 如果程序中出现报错:Torch not compiled with CUDA enabled

- 也是torch 和cuda版本不配对的问题,解决问题期间可以用上述代码测试新安装的版本是否配对。显示True时,说明已配对,在运行程序多半就不会出现这个报错了。

- python

- import torch

- print (torch.cuda.is_available())

如图,cuda和torch兼容(参考cuda安装教程安装的cuda和上面安装的torch是兼容的)

3.GPU运行注意事项

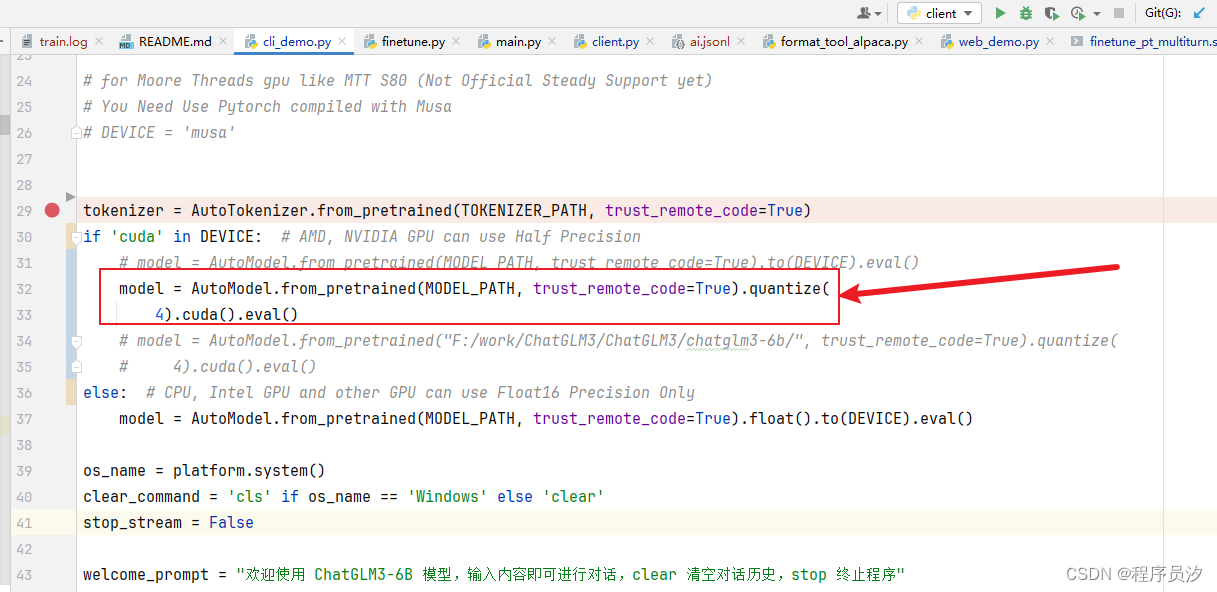

如果你的GPU内存在8g及以上可以不用调代码,如果低于8g我们需要调整代码;使用GPU运行GPU内存最小4g,如果你的GPU内存小于4g那你就别为难他了......

ChatGLM3\basic_demo\cli_demo.py文件中

- model = AutoModel.from_pretrained(MODEL_PATH, trust_remote_code=True).quantize(

- 4).cuda().eval()

如图修改

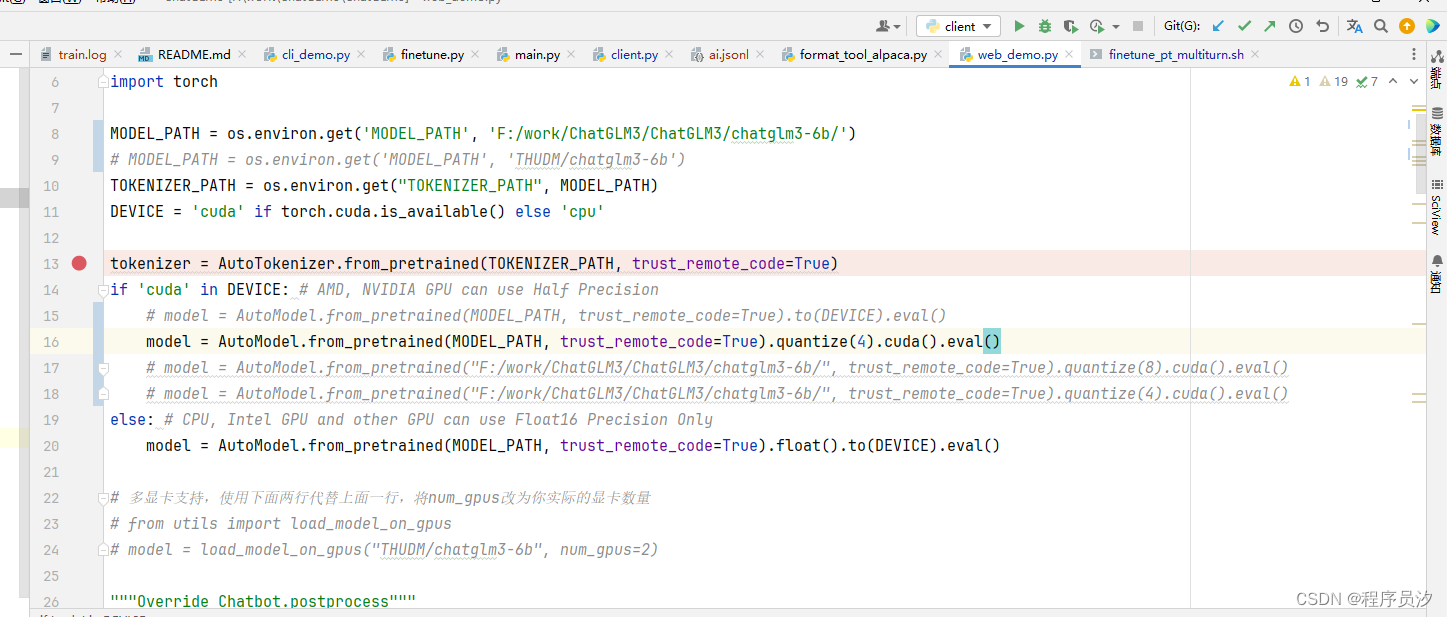

ChatGLM3\basic_demo\web_demo.py文件中

4.运行demo

1.打开终端,输入命令cd basic_demo,进入到basic_demo目录下

- 运行控制台的demo

- python cli_demo.py

-

- 运行web端的demo

- python web_demo.py

PS:第一次运行时需要使用代理(俗称翻墙)

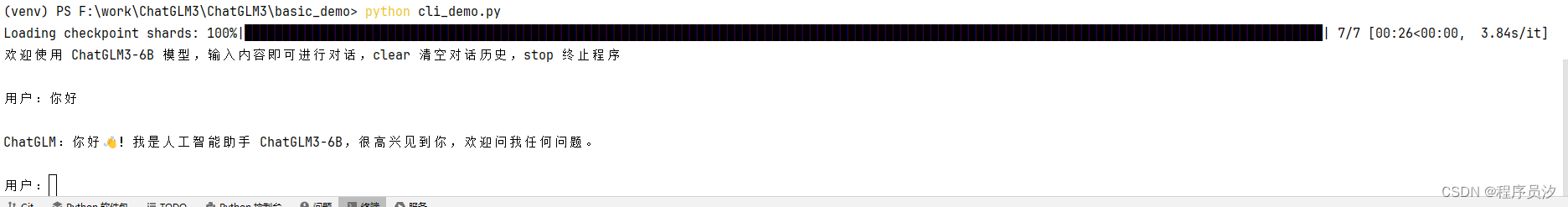

2.控制台后效果如下,可以进行对话

3.web运行效果如下

4.复制到浏览器中可以打开

5.GPU显存使用

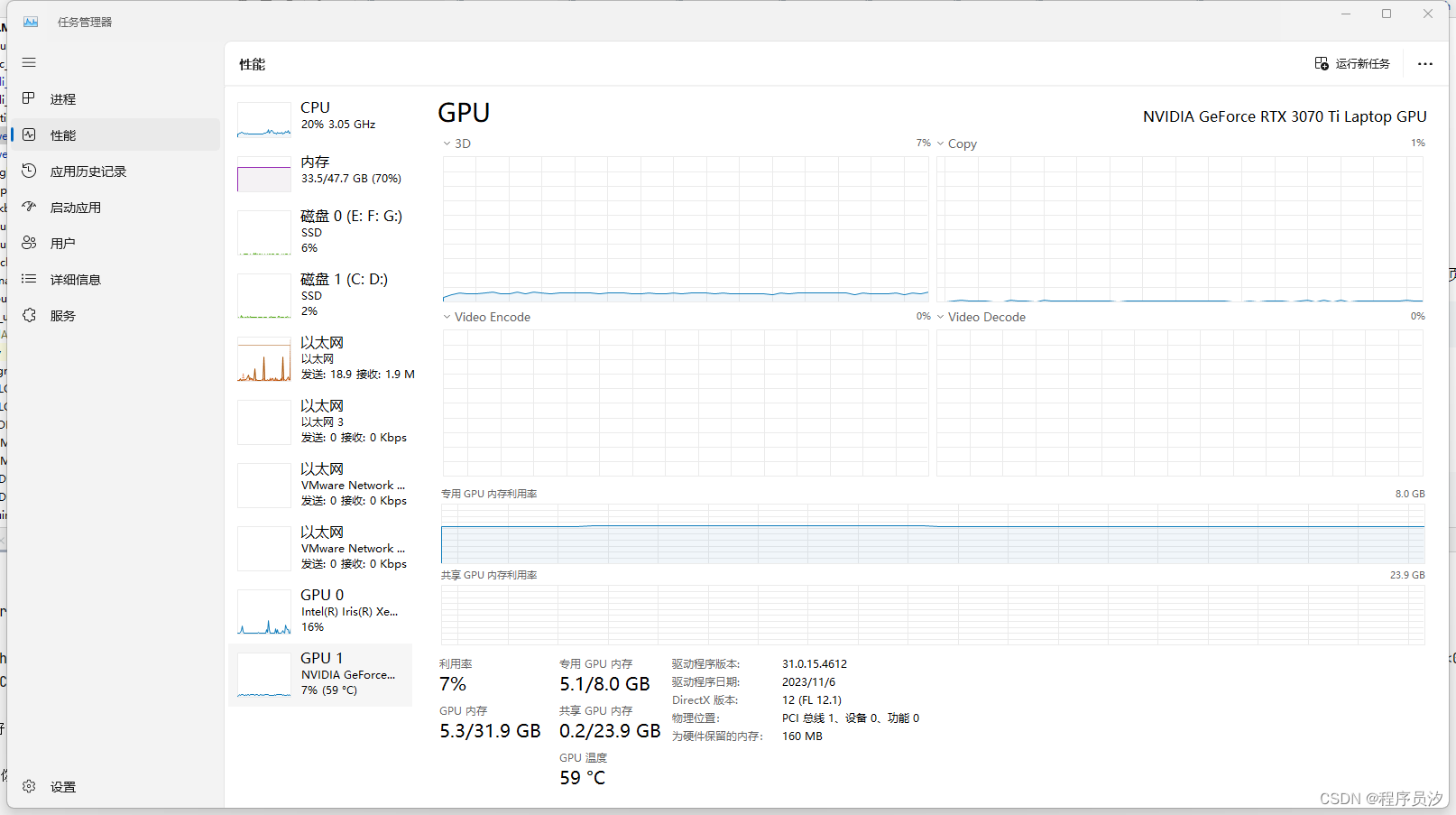

根据3.GPU运行注意事项调为quantize(4)之后,GPU内存使用5.1

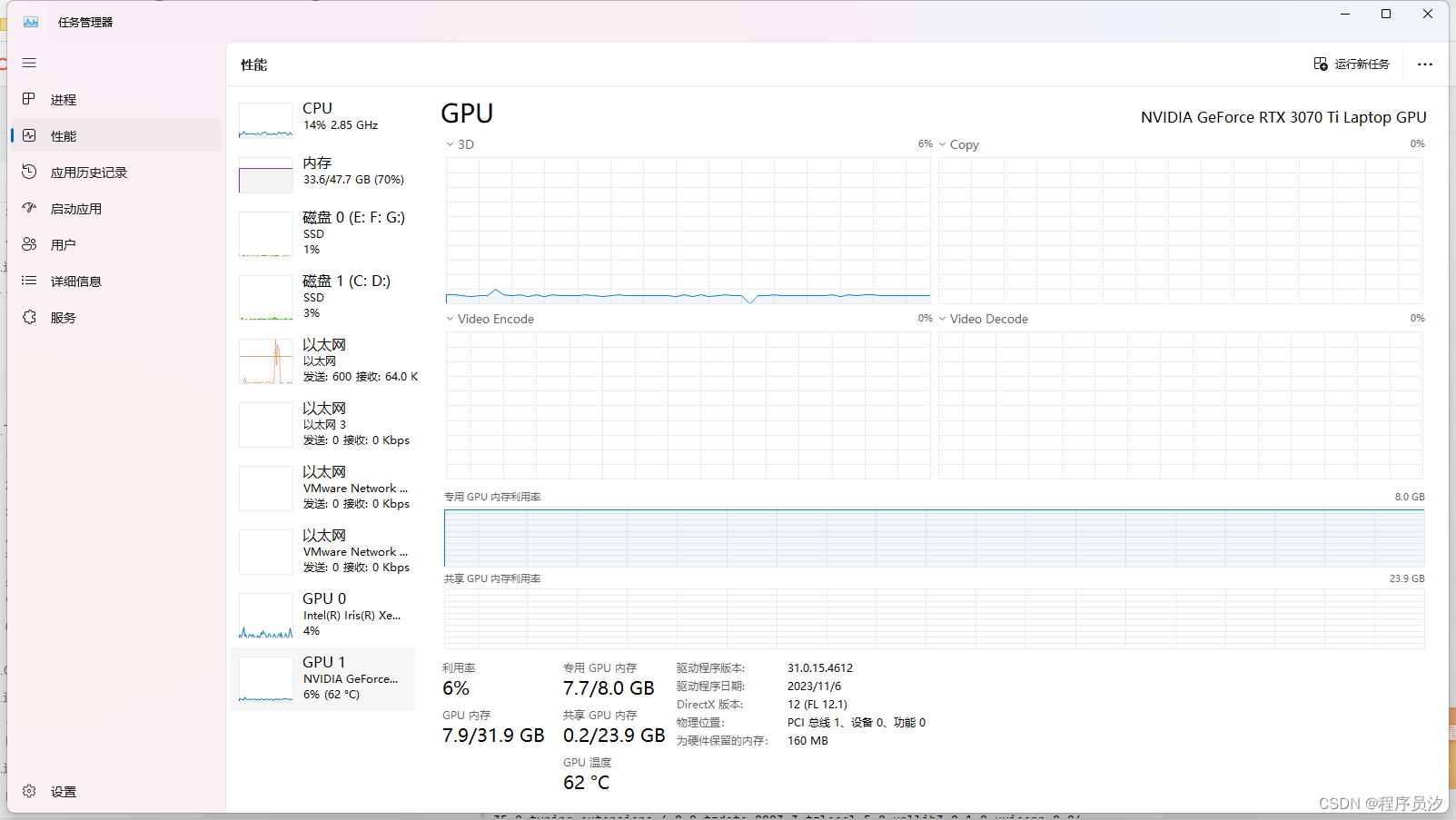

未调整代码或者使用quantize(8)之后,GPU内存使用7.7

使用GPU会比cpu快很多

8.运行时的问题

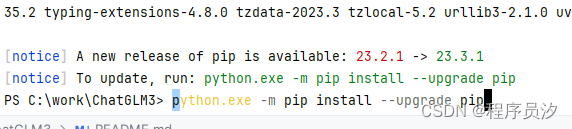

问题1:下载依赖时报错

将下方代码复制出来运行即可

如图便已升级成功

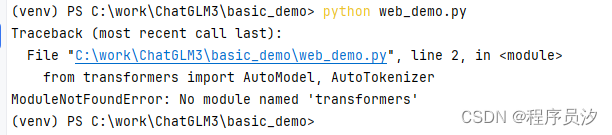

问题2:No module named 'xxxx'

在控制台执行下方命令

pip install xxx

问题3:运行web.demo时回答的文字未呈现

输入你好后,下方出现“你”,然后就被清除了,这是由于gradio版本较低的问题

- 卸载gradio

- pip uninstall gradio

-

- 安装gradio==3.40.0

- pip install gradio==3.40.0

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/不正经/article/detail/251625

推荐阅读

相关标签