热门标签

当前位置: article > 正文

LMDeploy 量化部署 LLM-VLM 实践(InternLM 实战营第五次作业)

作者:不正经 | 2024-04-15 16:49:52

赞

踩

LMDeploy 量化部署 LLM-VLM 实践(InternLM 实战营第五次作业)

1、创建conda环境

InternStudio开发机创建conda环境,由于环境依赖项存在torch,下载过程可能比较缓慢。InternStudio上提供了快速创建conda环境的方法。打开命令行终端,创建一个名为lmdeploy的环境,环境创建成功后,提示如下:

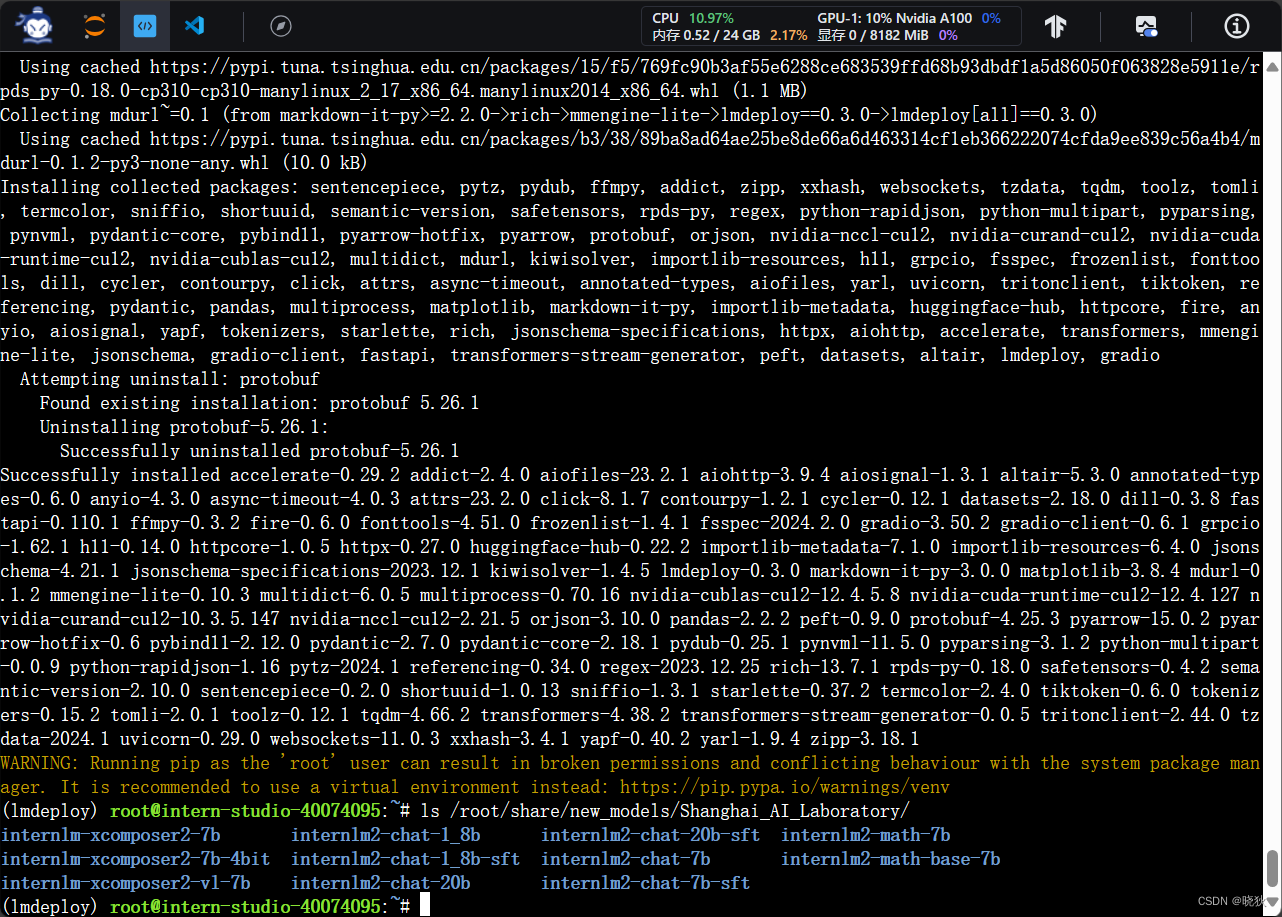

2、安装LMDeploy

激活刚刚创建的虚拟环境,安装0.3.0版本的lmdeploy。

3、下载InternLM2-Chat-1.8B模型

首先进入一个你想要存放模型的目录,本教程统一放置在Home目录。执行如下指令:

cd ~

然后执行如下指令由开发机的共享目录软链接或拷贝模型:

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b /root/ # cp -r /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b /root/

执行完如上指令后,可以运行“ls”命令。可以看到,当前目录下已经多了一个internlm2-chat-1_8b文件夹,即下载好的预训练模型。

ls

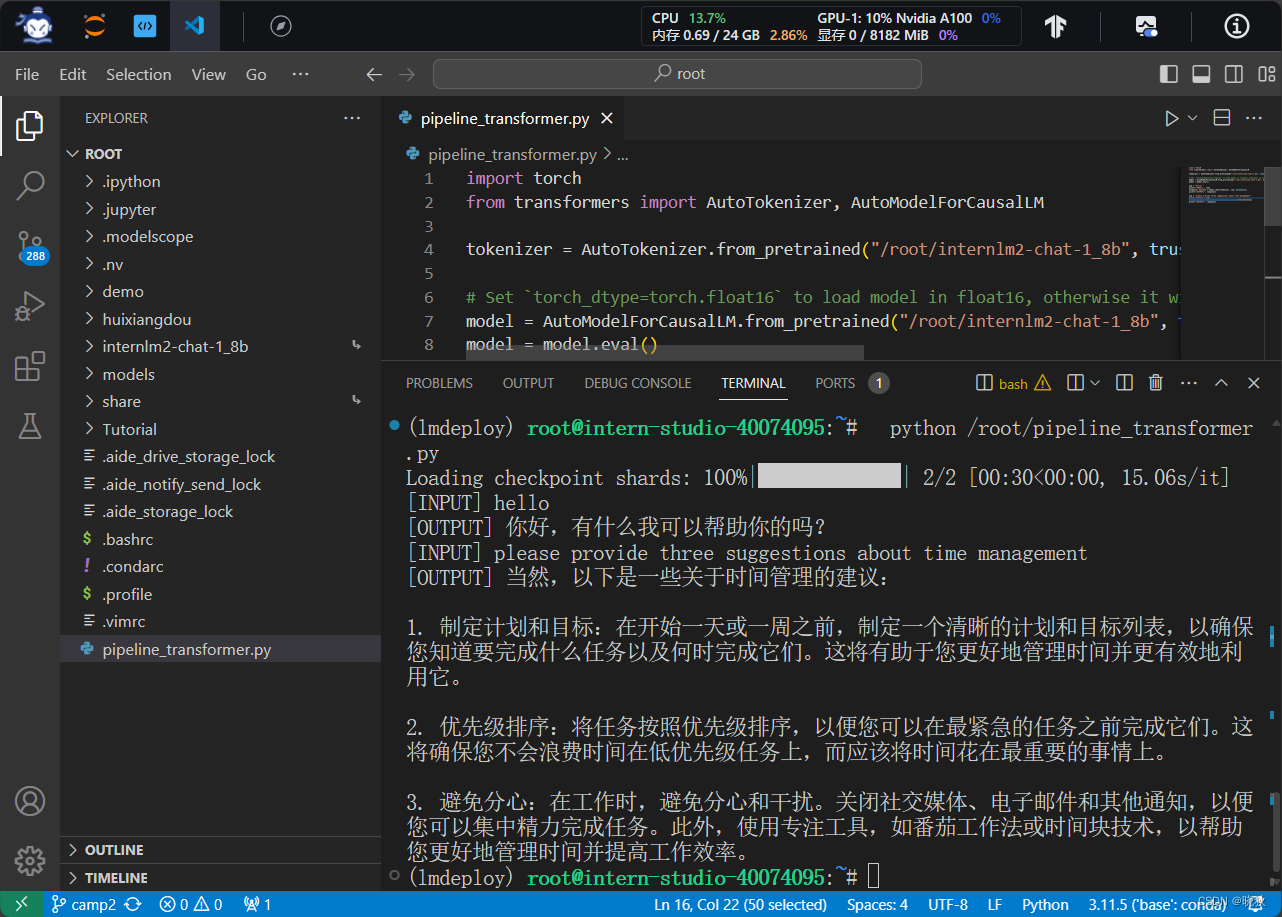

4、使用Transformer库运行模型

Transformer库是Huggingface社区推出的用于运行HF模型的官方库。

在3中,我们已经下载好了InternLM2-Chat-1.8B的HF模型。下面我们先用Transformer来直接运行InternLM2-Chat-1.8B模型,后面对比一下LMDeploy的使用感受。

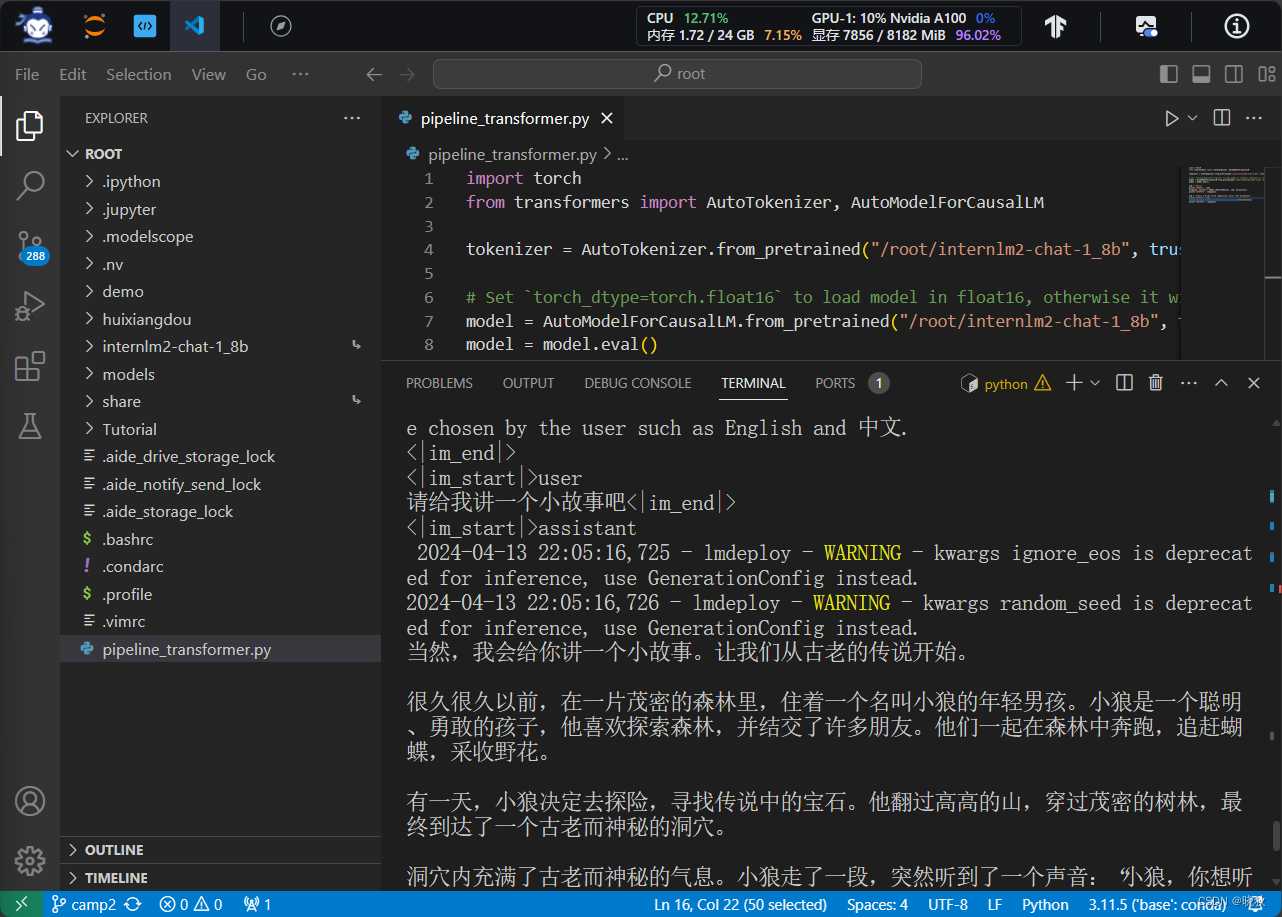

5、 使用LMDeploy与模型对话

InternLM2-Chat-1.8B大模型对话。比如输入“请给我讲一个小故事吧”,然后按两下回车键。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/不正经/article/detail/428971

推荐阅读

相关标签