- 1UE 导入ABC 精度低的问题_abc导入ue没有动画

- 2推荐一波计算机考研中外合作办学院校,考研难度不高!_计算机考研中外合作办学有哪些学校

- 3在线识别图片上的数学公式并且能转换成latex代码也能转换成可复制的以Word输出_图片转latex代码

- 4CSRF攻击原理&防御方法_查看代码通过什么方法防御 csrf攻击

- 52010年之前电脑ubuntu安装nvidia驱动黑屏处理

- 6计算机二级Python真题(七)_love.join

- 7mysys2 + windows + make + mips-gcc

- 8triton 部署yolov5模型_triton yolov5

- 9软件测试|神操作!用 Python 操作 xmind 绘制思_荣耀oc北部

- 10Cmake-Cookbook学习笔记_cmake cookbook

【赠书】重磅神经机器翻译“百科全书”,你想学习的机器翻译内容,都在这里...

赞

踩

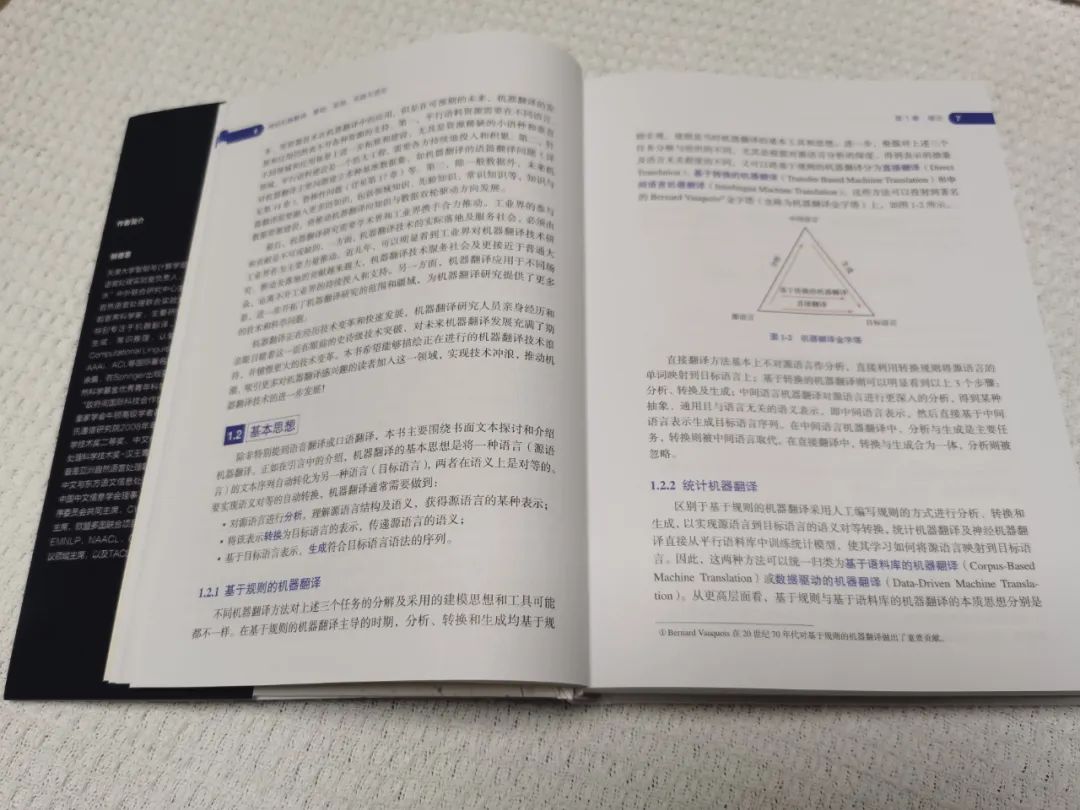

机器翻译诞生于二十世纪四五十年代,纵观机器翻译70多年的发展历程,从最初的朴素统计模式,发展到基于规则的机器翻译、统计机器翻译,再到目前的深度学习驱动的神经机器翻译,不同技术范式在不同历史时期各领风骚。

时至今日,神经机器翻译已成为在线机器翻译的主要引擎,每天以数千亿单词量的翻译规模服务全世界各地用户。但即便如此,机器翻译仍然存在诸多挑战和难题。

一方面,全世界在使用的语言有几千种,即使像NLLB这样的大规模模型,目前也只能覆盖200余种语言,占比不到已有语言的1/30,大量语言在机器翻译版图里仍然被“Left Behind”。

另一方面,神经机器翻译虽然显著提升了译文质量,但仍然面临鲁棒性、可解释性、广域语境依赖性、多模态、资源稀缺等多种挑战和开放问题。

《神经机器翻译:基础、原理、实践与进阶》正是在这样的背景中写就的,本次我们给大家推荐和赠送本书。

本书内容

全书共480页,非常厚实,分为基础篇、原理篇、实践篇和进阶篇,覆盖神经机器翻译的基础知识、经典框架、原理技术、实践方法与技巧,以及无监督神经机器翻译、多语言神经机器翻译、语音与视觉多模态机器翻译等前沿研究方向。

全书理论与实践相结合,基础与前沿相交映。

第1章:绪论

第I部分:基础篇

第2章:神经网络基础

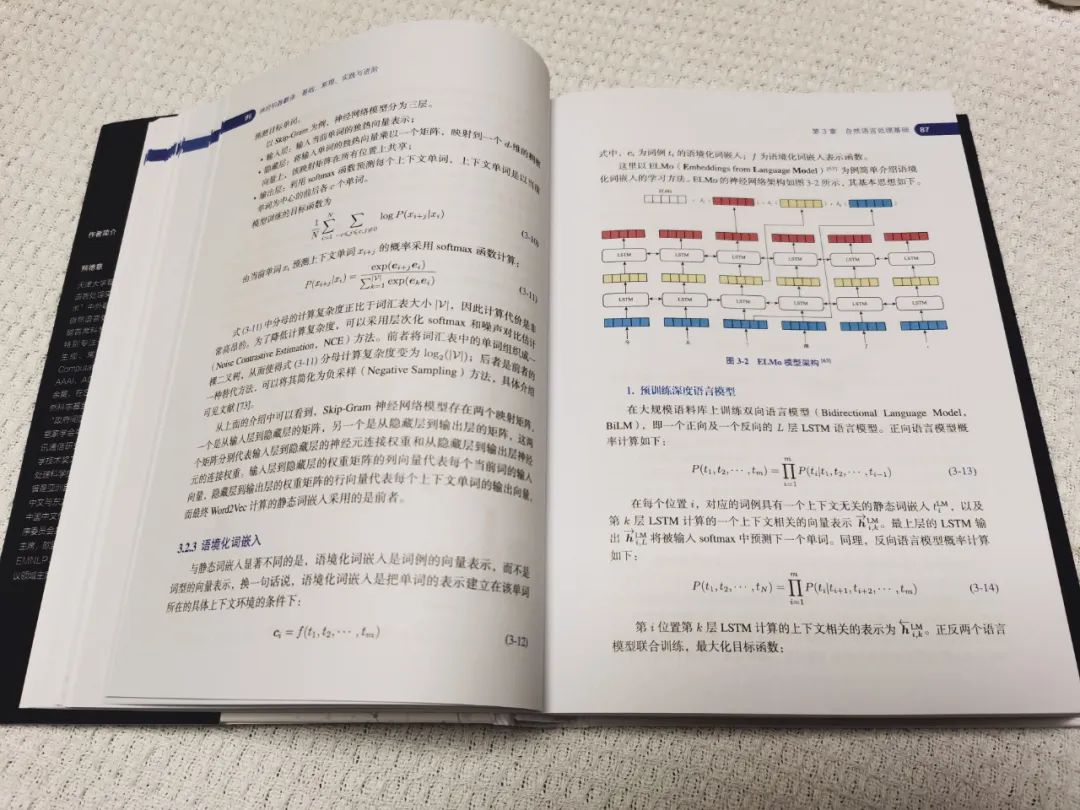

第3章:自然语言处理基础

第II部分:原理篇

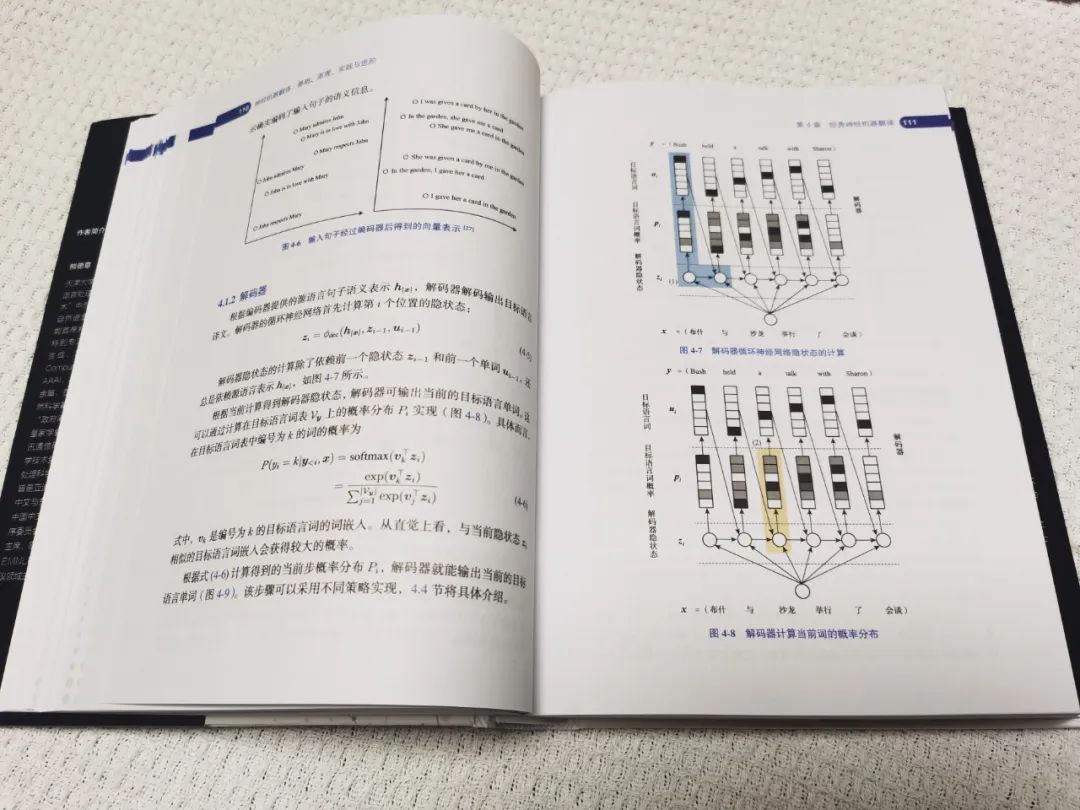

第4章:经典神经机器翻译

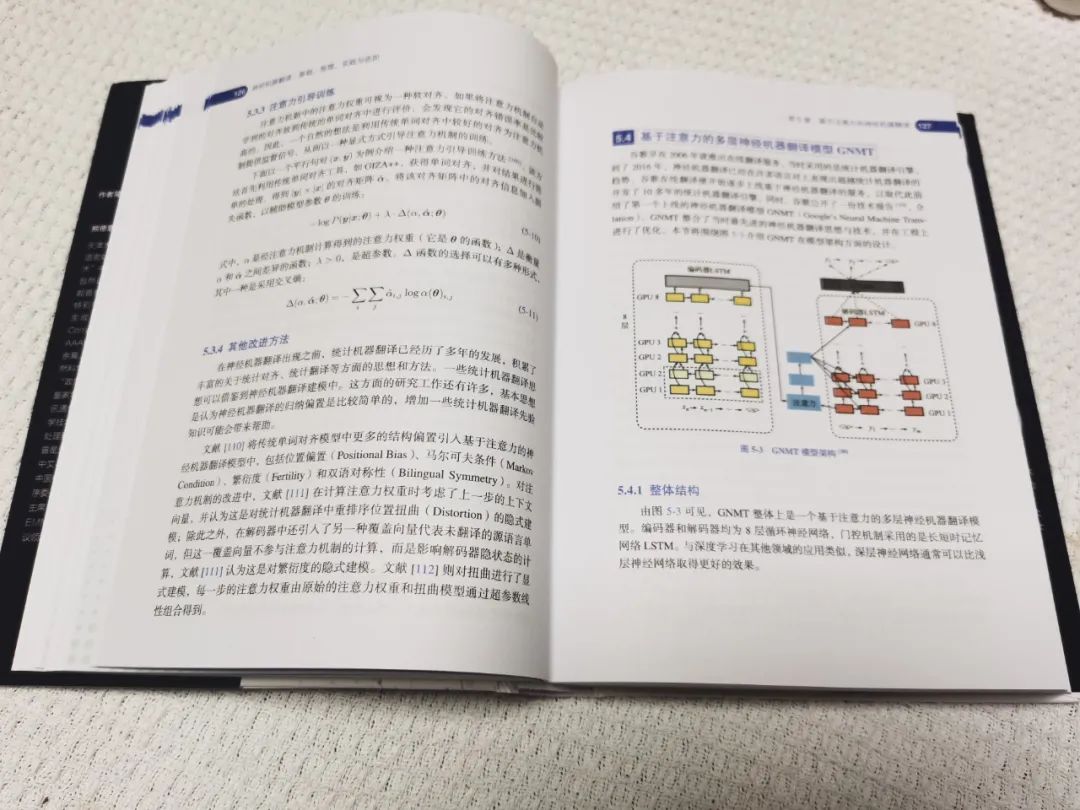

第5章:基于注意力的神经机器翻译

第6章:基于卷积神经网络的神经机器翻译模型

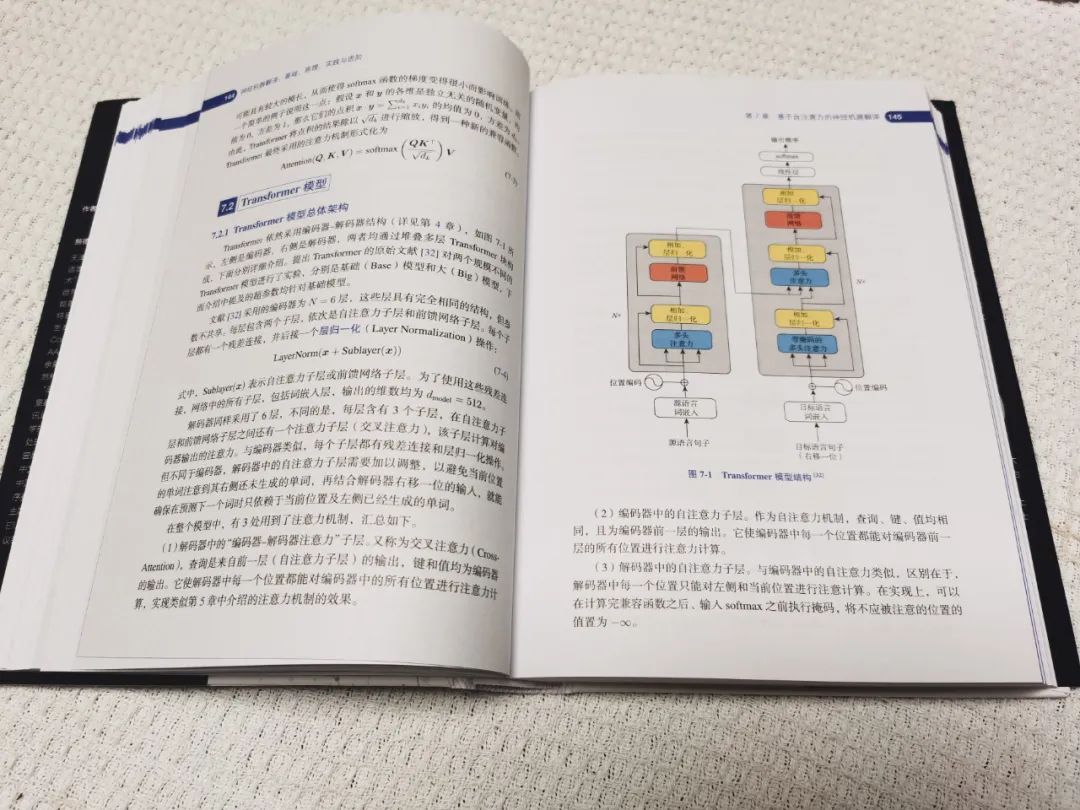

第7章:基于自注意力的神经机器翻译

第8章:神经机器翻译若干基础问题及解决方案

第III部分:实践篇

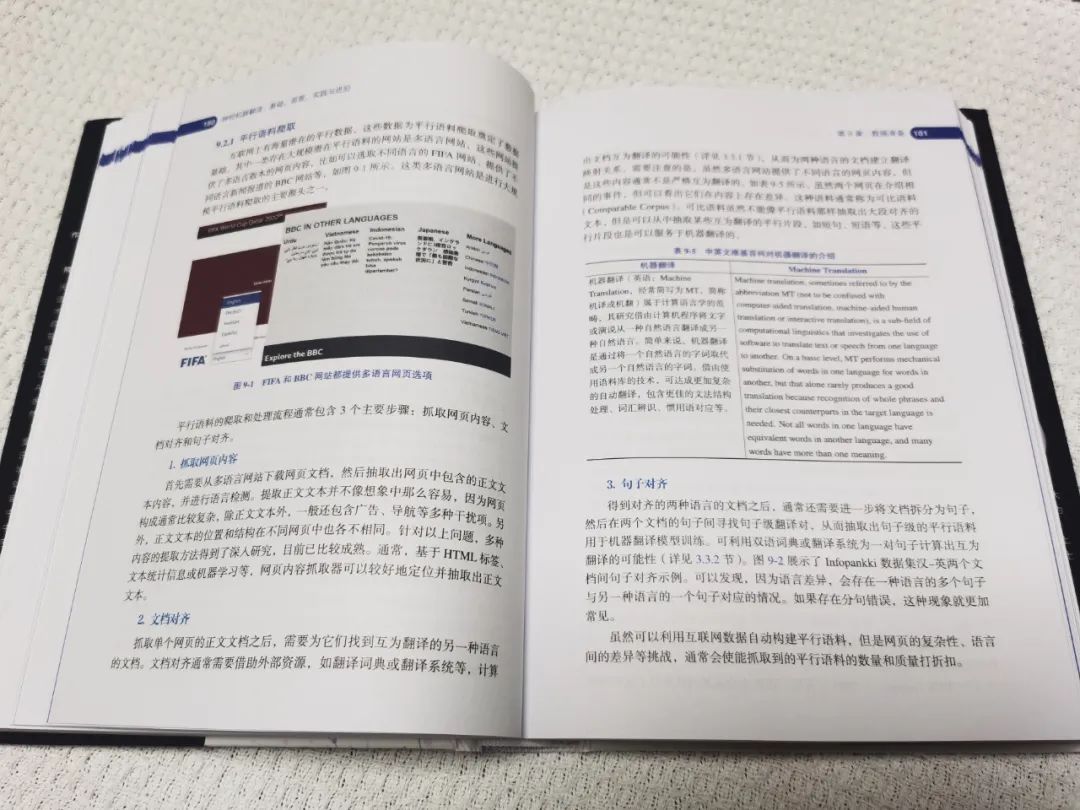

第9章:数据准备

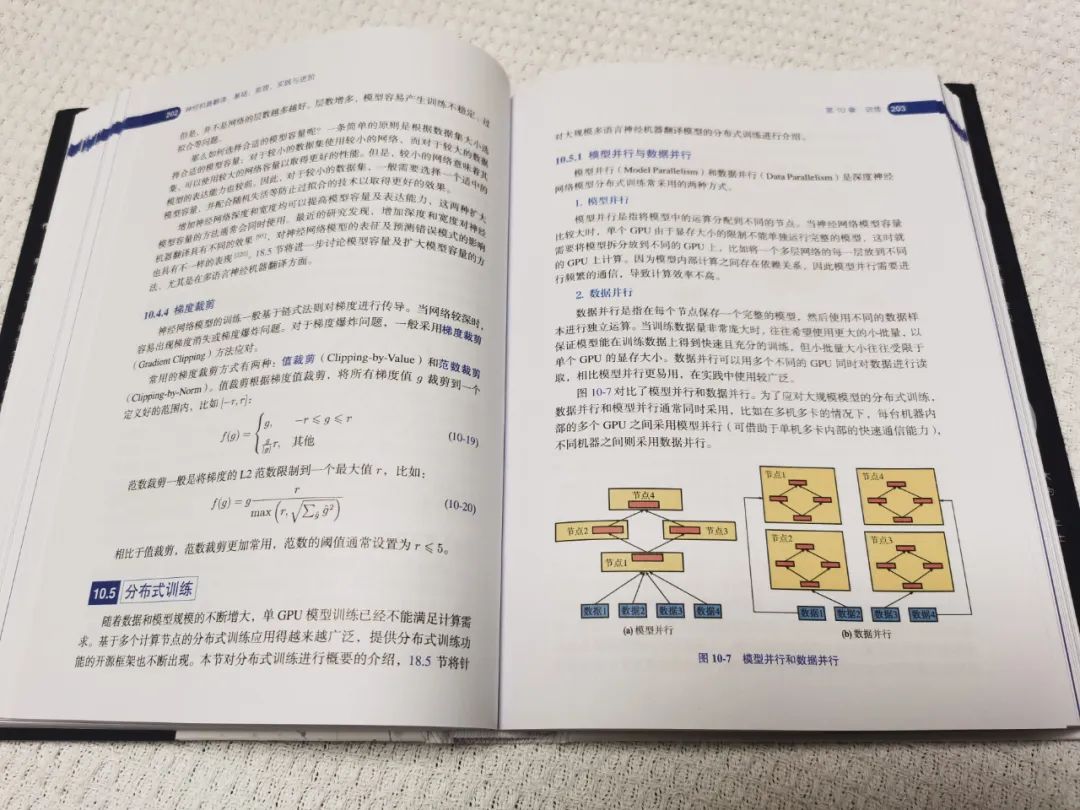

第10章:训练

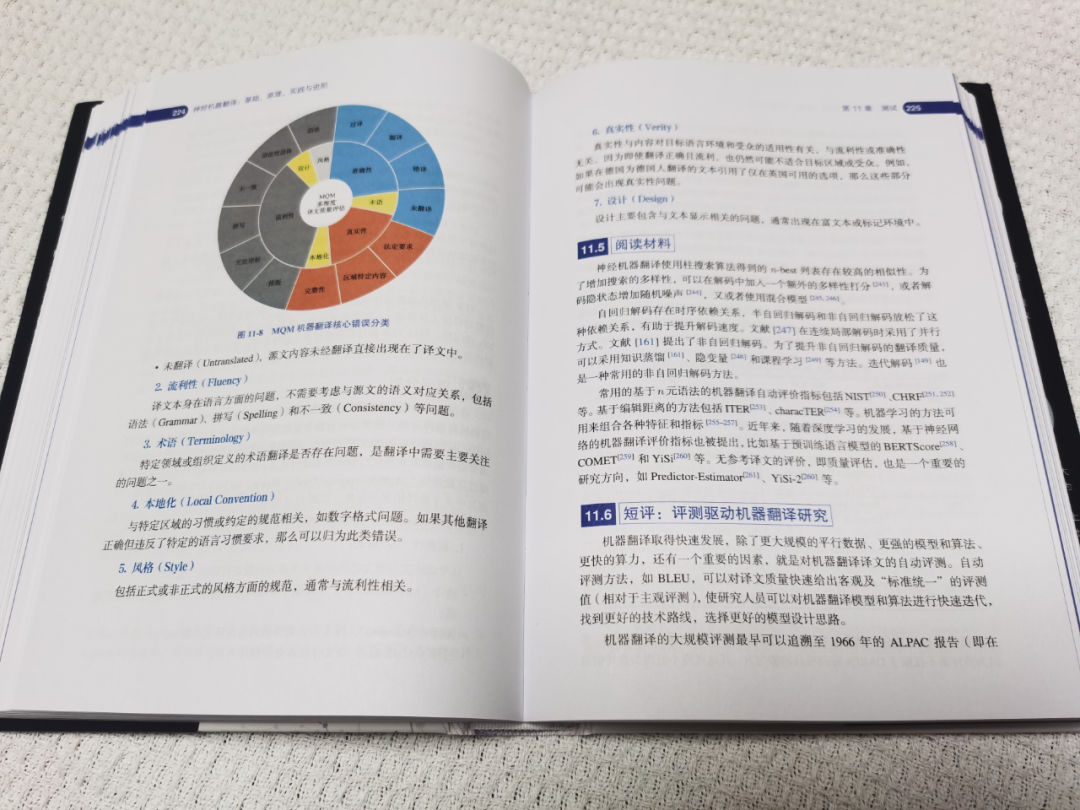

第11章:测试

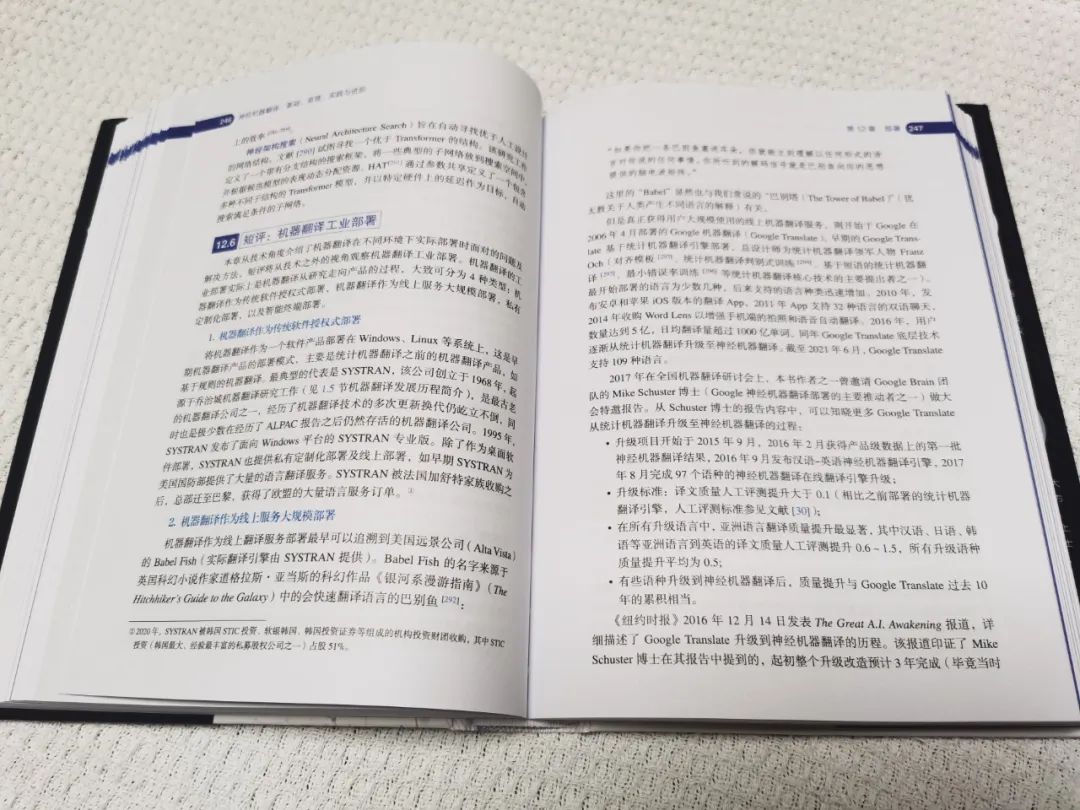

第12章:部署

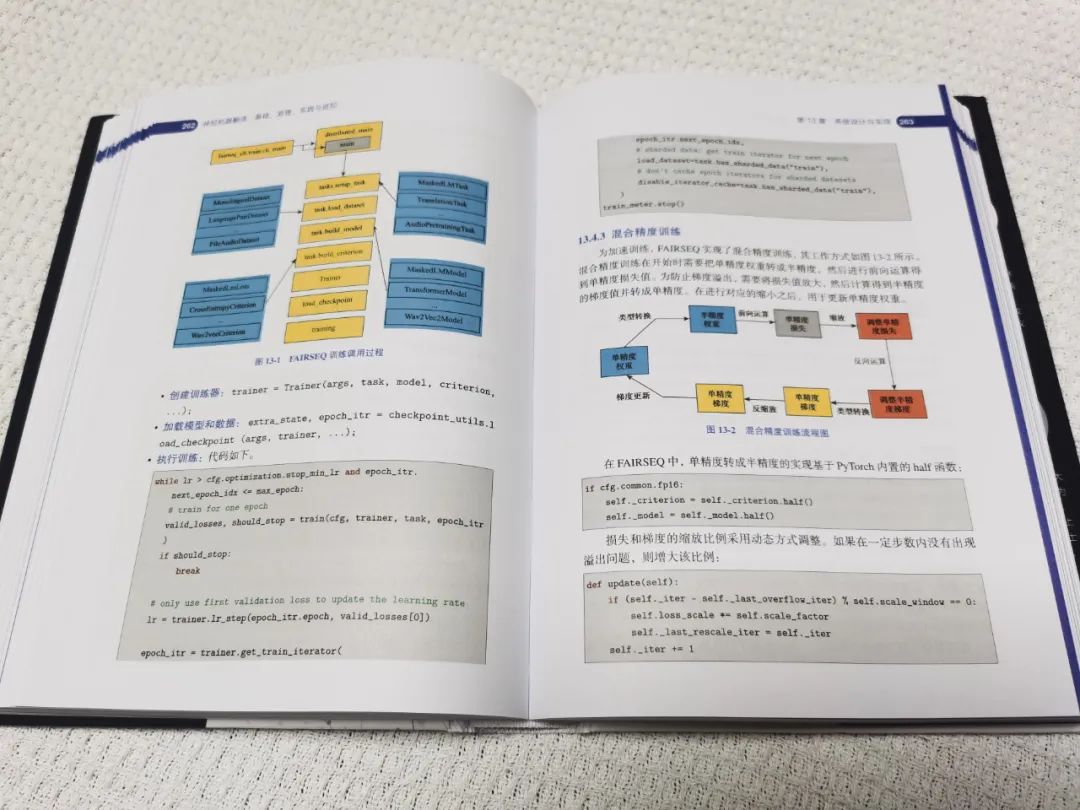

第13章:系统设计与实现

第IV部分:进阶篇

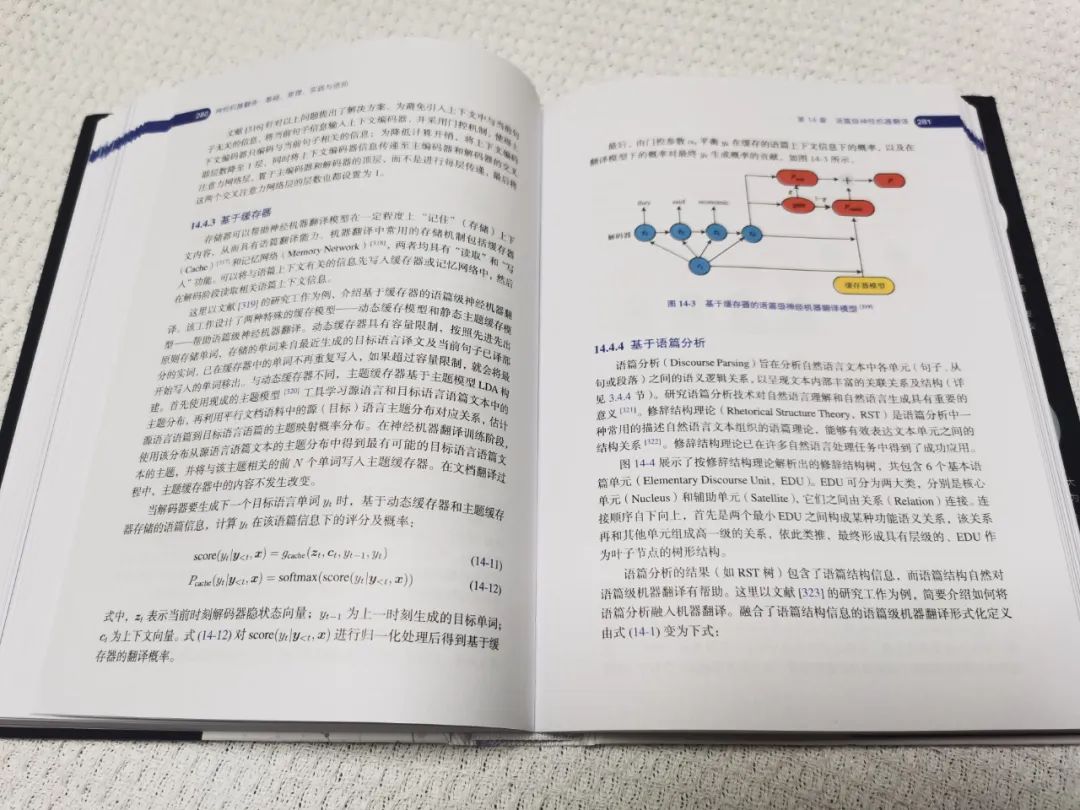

第14章:语篇级神经机器翻译

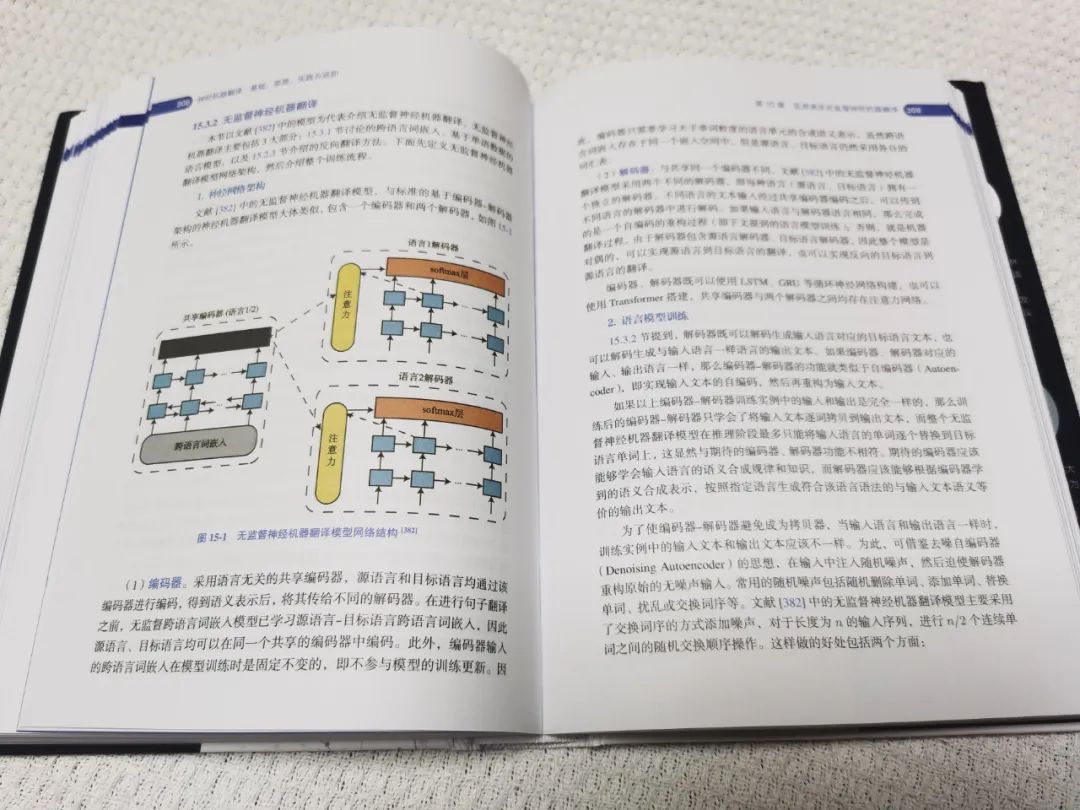

第15章:低资源及无监督神经机器翻译

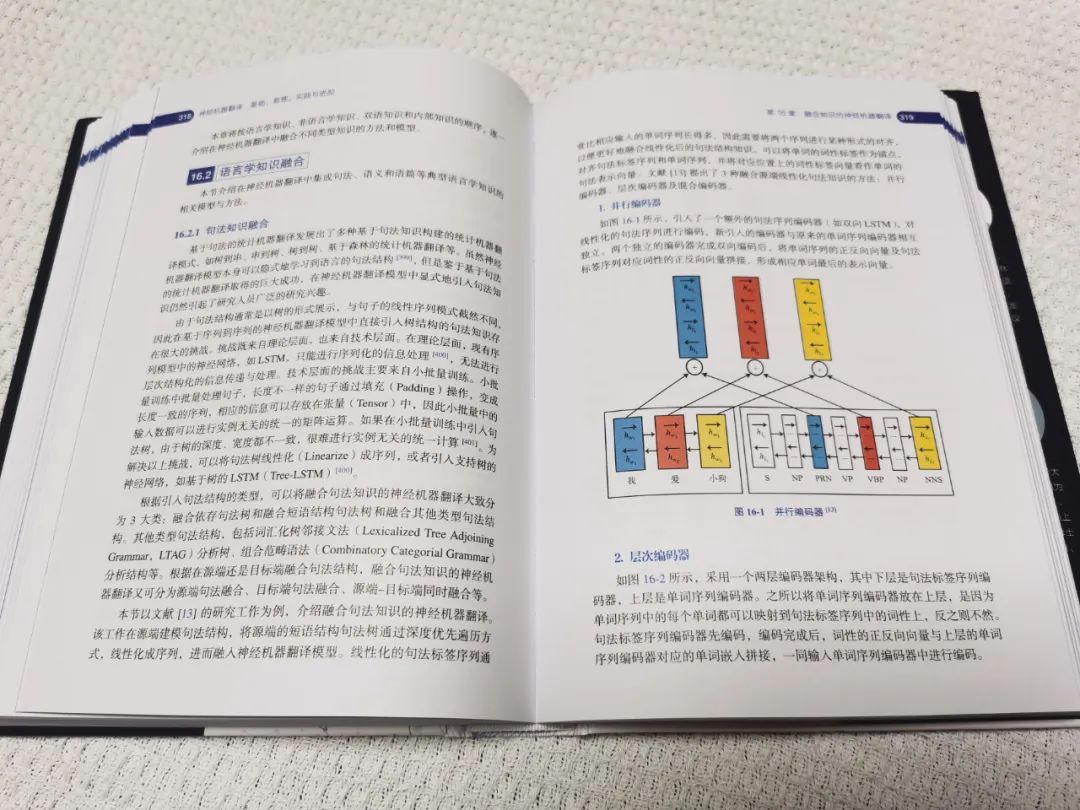

第16章:融合知识的神经机器翻译

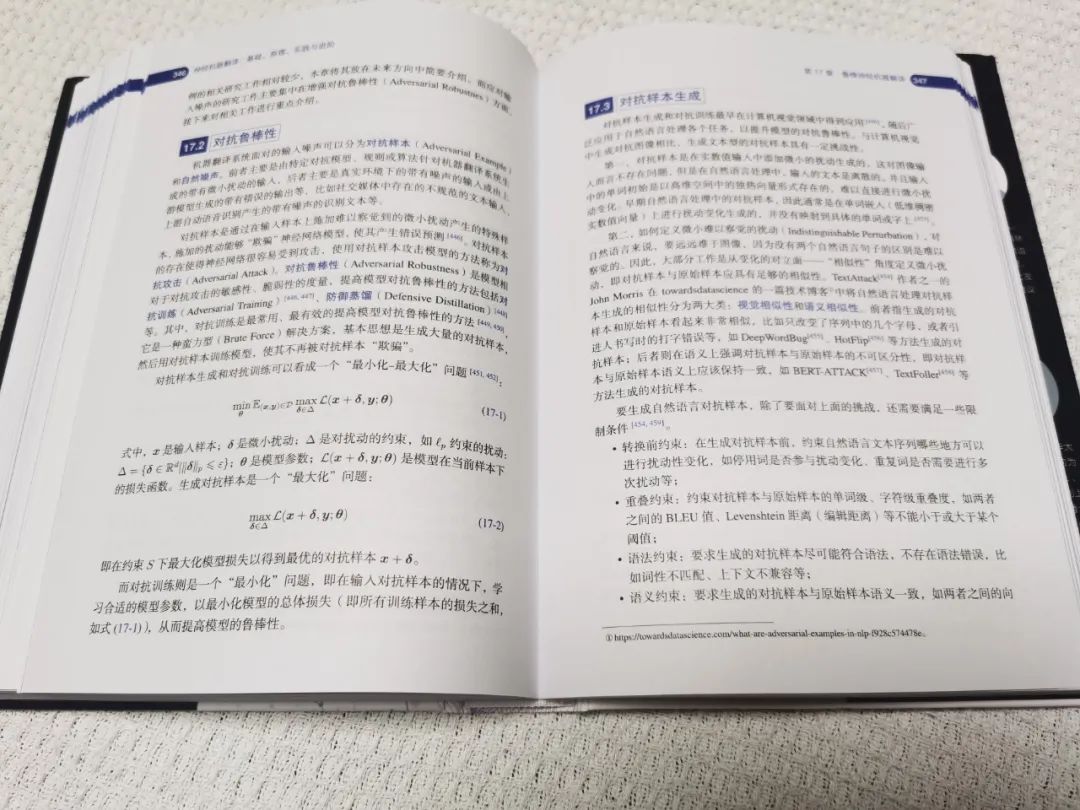

第17章:鲁棒神经机器翻译

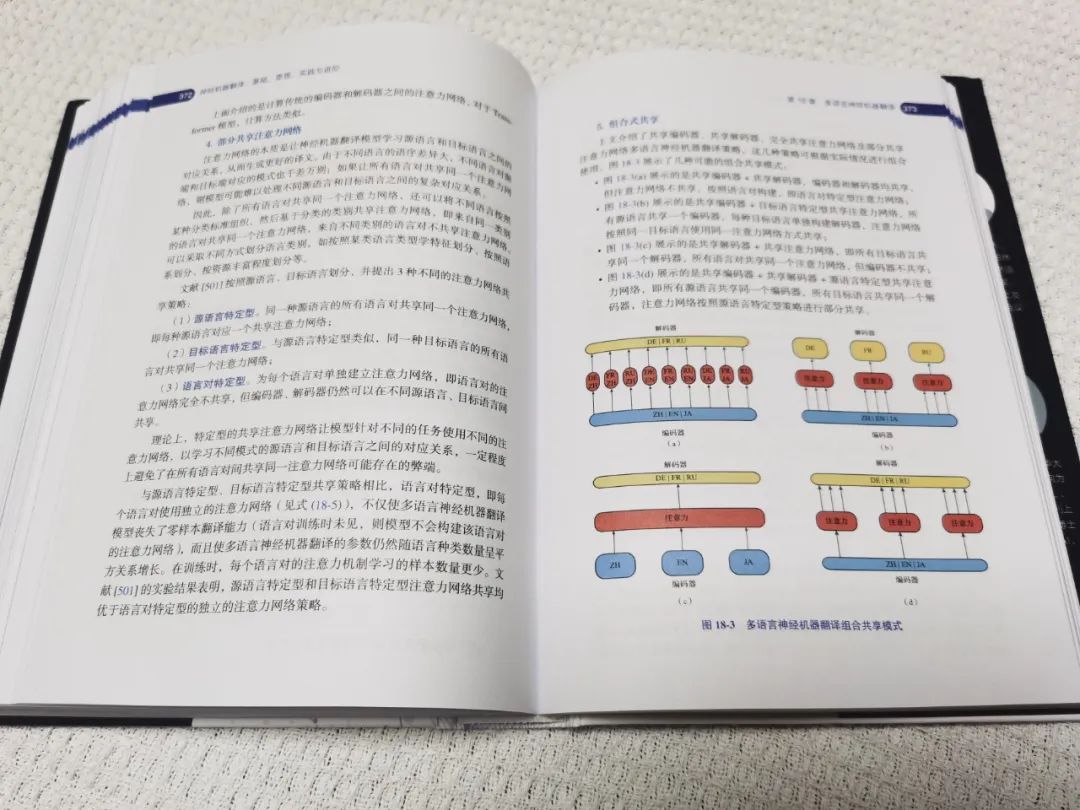

第18章:多语言神经机器翻译

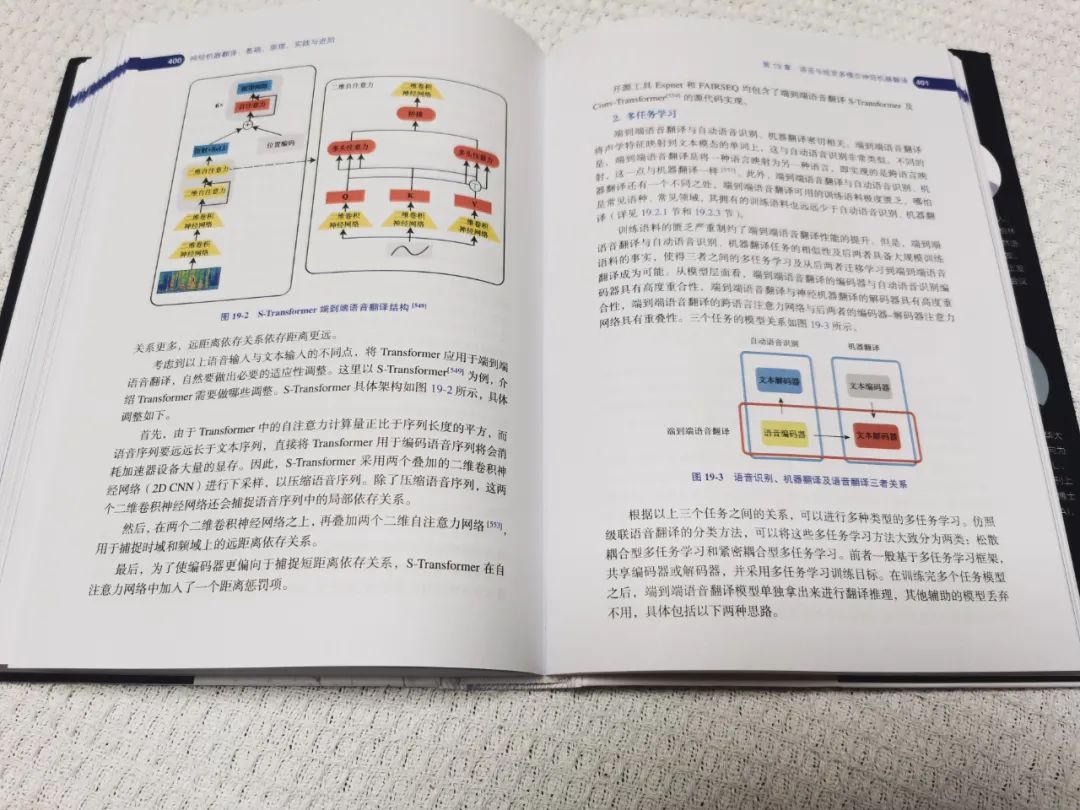

第19章:语音与视觉多模态神经机器翻译

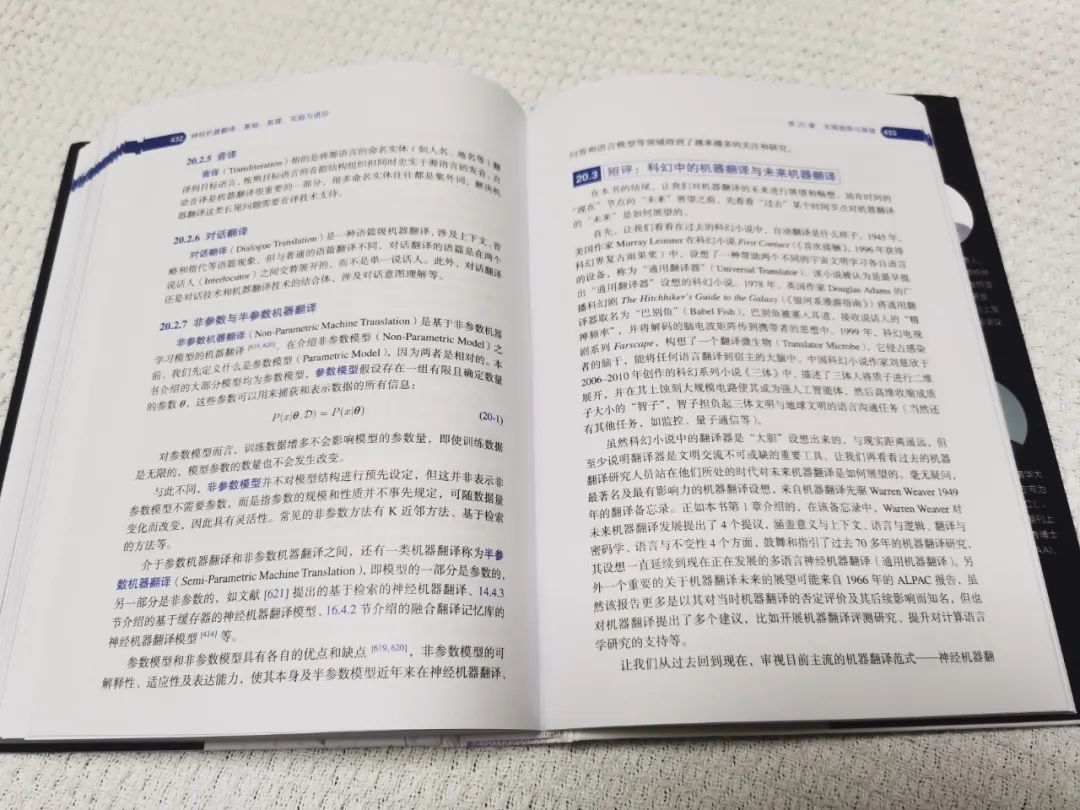

第20章:发展趋势与展望

本书作者:

熊德意

天津大学智能与计算学部教授、博士生导师、自然语言处理实验室负责人,天津大学“语言智能与技术”中外联合研究中心主任,天津大学-中译语通自然语言处理联合实验室主任、中译语通人工智能首席科学家。主要研究方向为自然语言处理,特别专注于机器翻译、对话、问答、自然语言生成、常识推理、认知计算等方向的研究。在Computational Linguistics、IEEE TPAMI、AI、AAAI、ACL等国际著名期刊和会议上发表论文100余篇,在Springer出版英文专著一部。获得国家自然科学基金优秀青年科学基金、国家重点研发计划“政府间国际科技合作创新合作”重点专项、英国皇家学会牛顿高级学者基金等资助。获得新加坡资讯通信研究院2008年年度研究贡献奖、北京市科学技术奖二等奖、中文信息学会“钱伟长中文信息处理科学技术奖-汉王青年创新奖”一等奖等奖项。曾是亚洲自然语言处理联合会AFNLP干事、新加坡中文与东方语文信息处理学会理事会成员,目前是中国中文信息学会理事。担任IALP 2012&2021程序委员会共同主席,CWMT 2017程序委员会共同主席,欧盟多国联合项目QTLeap咨询专家,ACL、EMNLP、NAACL、COLING等多个知名国际会议领域主席,以及TACL和ARR的Action Editor等。

李良友

华为诺亚FANGZHOU实验室研究员、机器翻译团队负责人。在欧盟玛丽居里项目资助下,于2017年获得都柏林城市大学计算机博士学位。主要研究方向为自然语言处理,特别专注于机器翻译相关技术领域的研发。在ACL、EMNLP等多个国际著名会议和期刊上发表论文10余篇,并担任ACL、EMNLP等国际会议领域主席和会议审稿人。

张 檬

华为诺亚FANGZHOU实验室研究员。于2018年获得清华大学计算机科学与技术系博士学位。主要研究方向为机器翻译和跨语言自然语言处理。在ACL、EMNLP、AAAI、TASLP等国际著名会议和期刊上发表论文10余篇。曾获中国中文信息学会优秀博士学位论文提名奖。担任ACL、EMNLP、AAAI、IJCAI等多个知名国际会议审稿人。

本书适合读者:

适合高等院校计算机专业高年级本科生,以及人工智能、自然语言处理方向的研究生阅读,也可供机器翻译研究者、实践者、使用者,以及机器翻译行业的管理者、人工翻译研究人员等对机器翻译技术感兴趣的读者参考。

赠书

接下来是福利时间,本次我们赠送出3本书籍(前3次获得赠书的朋友不能再参与本次赠书活动),想要获得书籍的同学,在本公众号下方留言,根据点赞数的高低,本周四8月25日早上10:00统计出获奖读者并进行公示,届时联系有三微信Longlongtogo即可。

如果没有获得赠书,也可以扫码下面的海报进行购买。

往期相关