- 1好文转载 ChatGPT被淘汰了?Auto-GPT到底有多强_agentgpt官方仓库

- 2【VHDL】Quartus18.0与ModelsimSE10.4联调仿真学习_modelsim vhdl仿真

- 3Qt中实用功能小合集_qt功能

- 4bitbake ERROR:No space left on device or exceeds fs.inotify.max_user_watches?

- 5Verilog实现减法器_verilog 减法

- 6STM32---SG90舵机控制(HAL库,含源码)

- 7C++的递增运算符和递减运算符_++是在完整表达式后递增吗

- 8MySQL- 创建可以远程访问的root账户_mysql root 远程访问

- 9菜鸟程序员,被无良HR欺骗,因祸得福,竟“意外”拿下【得物】offer_得物面试未通过

- 10PhotosCollage for Mac v1.4.1 照片拼贴工具

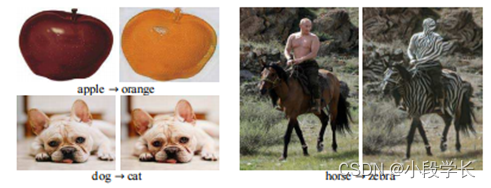

使用周期一致的对抗网络进行不成对的图像到图像转换_生成对抗网络输入图片是成对的吗

赞

踩

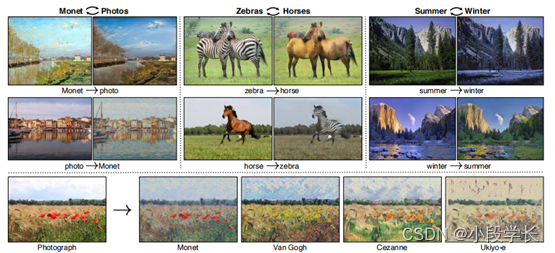

图 1:给定任意两个无序图像集合 X 和 Y,我们的算法学习自动将图像从一个图像“翻译”到另一个图像,反之亦然,示例应用程序(底部):使用著名艺术家的画作集,学习将用户的照片渲染成他们的风格。

摘要

图像到图像转换是一类视觉和图形问题,其目标是学习之间的映射输入图像和输出图像使用训练集对齐的图像对。但是,对于许多任务,配对的训练数据将不可用。我们提出了一种方法学习将图像从源域 X 转换为目标域 Y 在没有配对示例的情况下。我们的目标是学习映射 G : X → Y 使得分布来自 G(X) 的图像与使用对抗性损失的分布 Y 无法区分。因为此映射是高度约束不足,我们将其与逆映射 F : Y → X 耦合,并将循环一致性损失引入将 F(G(X)) ≈ X 推(反之亦然)。定性结果是在多个任务中呈现,其中配对的训练数据具有不存在,包括收藏风格转移、对象变形、季节转移、照片增强等。定量的与几种先前方法的比较表明我们方法的优越性。

1. 介绍

克劳德·莫奈在将画架放在阿让特伊附近的塞纳河畔,在一个可爱的春日里1873年(图1,左上角)一张彩色照片,如果是

发明,可能已经记录了一片湛蓝的天空和玻璃状河流倒映着它。莫奈表达了他对同样的印象场景通过轻柔的笔触和明亮的调色板。什么如果莫奈碰巧在卡西斯的小港口上凉爽的夏夜(图1,左下角)短暂漫步通过莫奈绘画画廊,让人很容易想象他将如何渲染场景:也许是粉彩阴影,带有突兀的油漆并且有点扁平动态范围。

我们可以想象这一切,尽管从未见过一个侧面场景照片旁边的莫奈画作的侧面示例他画了。相反,我们了解了莫奈的集合绘画和风景照片集。我们可以关于这两组之间的文体差异的原因,从而想象一下,如果我们是这样的场景,那会是什么样子。将其从一个集合“翻译”到另一个集合。

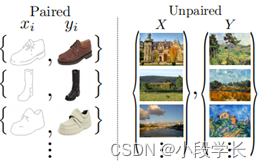

图 2:配对训练数据(左)由训练示例组成

{xi, yi}Ni=1,其中对应于每个 xi 的 yi 被给出 [20]。我们而是考虑由源集组成的未配对训练数据(右图){xi}Ni=1 ∈ X 和目标集 {yj}Mj=1 ∈ Y ,未提供信息至于哪个 xi 匹配哪个 yj 。

在本文中,我们提出了一个可以学习执行相同:捕获一个图像集合的特殊特征并弄清楚如何翻译这些特征进入其他图像集合,全部在没有任何配对的情况下训练示例。

这个问题可以更广泛地描述为图像图像转换[20],将图像从给定场景x的一种表示转换为另一种表示,y,例如灰度。到颜色,图像到语义标签,边缘映射到照片。在计算机视觉、图像处理和图形在监督设置中产生了强大的转换系统,其中示例图像对 {x, y} 可用(图 2 左),例如 [9, 17, 20, 21, 24, 29, 41, 52, 54, 57]。但是,获取配对训练数据可能很困难,并且贵。例如,仅存在几个数据集像语义分割这样的任务(例如,[4]),它们相对较小。获取图形任务的输入-输出对像艺术风格化可能更加困难,因为所需的输出非常复杂,通常需要艺术性创作。对于许多任务,如对象变形(例如,斑马→马,图1中上),所需输出不是甚至定义明确。

因此,我们寻求一种可以学习翻译的算法。在没有成对输入-输出示例的域之间(图 2,右)。我们假设存在某种潜在的关系域之间 – 例如,它们是两个不同的域同一潜在世界的渲染 - 并寻求学习这种关系。虽然我们缺乏形式的监督的成对示例,我们可以在以下级别上利用监督:集合:我们在域 X 中给定一组图像,在域 Y 中给定另一组图像。我们可以训练一个映射 G : X → Y使得输出 yˆ = G(x),x ∈ X,是不可区分的从图像 y ∈ Y 由经过训练的对手将 yˆ 分开从 y.从理论上讲,该目标可以诱导与经验分布 pY (y) 相匹配的 yˆ 上的输出分布 (in一般情况下,这要求 G 是随机的)[14]。最佳因此,G 将域 X 转换为分布域 Yˆ与 Y 相同。但是,这样的转换并不能保证单个输入和输出 x 和 y 是配对的以有意义的方式向上 - 有无限多的映射G 将在 yˆ 上诱导相同的分布。此外,在实践中,我们发现很难优化对抗孤立的目标:标准程序通常会导致众所周知的模式崩溃问题,其中所有输入图像映射到相同的输出图像,优化失败取得进步[13]。

这些问题要求为我们的目标增加更多的结构。

因此,我们利用翻译应该是“周期一致”,从某种意义上说,如果我们翻译,例如,一个句子从英语到法语,然后将其翻译回来从法语到英语,我们应该回到原来的句子[3]。从数学上讲,如果我们有一个转换器G:X→Y和另一个转换器F:Y→X,那么G和F应该彼此反转,并且两个映射都应该是双射。我们通过训练来应用这种结构假设同时映射 G 和 F,并添加一个循环一致性损失 [60],鼓励 F(G(x)) ≈ x 和G(F(y)) ≈ y.将这种损失与对抗性损失结合起来在域 X 和 Y 上,我们实现了未配对的完整目标图像到图像的翻译。

我们将我们的方法应用于广泛的应用,包括样式转移,对象变形,属性转移和照片增强。我们还与以前的比较依赖于手动定义的因式分解的方法样式和内容,或共享嵌入功能,并显示我们的方法优于这些基线。我们的代码可在https://github.com/junyanz/CycleGAN。在 https://arxiv.org/abs/1703.10593.

查看论文的完整版本。

2. 相关研究

生成对抗网络(GAN)[14,58]有在图像生成 [5, 35]、图像方面取得了令人印象深刻的效果编辑[61]和表示学习[35,39,33]。最近方法采用相同的想法进行条件图像生成应用程序,例如 text2image [36]、图像内嵌 [34]、和未来预测[32],以及其他领域,如视频 [50] 和 3D 模型 [53]。GAN成功的关键是强制生成图像的对抗性损失的想法原则上,与真实图像无法区分。这对于图像生成任务特别强大,因为这正是许多计算机图形学的目标优化。我们采用对抗性损失来学习映射使得翻译后的图像无法与目标域中的图像。图像到图像的转换 图像到图像的思想翻译至少可以追溯到赫兹曼等人的图像类比[17],他们使用非参数纹理。模型 [8] 在单个输入-输出训练图像对上。最近更多的方法使用输入输出示例的数据集来使用 CNN 学习参数化平移函数,例如 [29]。我们的方法建立在Isola et的“pix2pix”框架之上。[20],它使用条件生成对抗网络[14]来学习从输入到输出图像的映射。类似的想法已被应用于各种任务,例如从草图[40]或从属性和语义布局 [22].。但是,与这些先前的作品不同,我们学习映射,无需配对训练示例。

未配对的图像到图像转换 其他几个方法还可以解决不成对的设置,其目标是关联两个数据域,X 和 Y 。罗萨莱斯等人[37]提出一个贝叶斯框架,包括一个基于基于补丁的马尔可夫随机场的先验,从源图像计算出来,以及从多个样式图像获得的可能性项。最近,耦合GAN [28]和跨模态场景网络 [1] 使用权重共享策略来学习一个共同的跨域表示。与我们的方法并行,Liu等人[27]通过组合扩展了这个框架。变分自动编码器 [23] 和生成对抗网络。另一条并行工作线[42,45,2]鼓励输入和输出共享某些“内容”功能。即使它们在“风格”上可能有所不同。他们还使用对抗性网络,并附加条款来强制执行输出。接近预定义的度量空间中的输入,例如作为类标签空间 [2]、图像像素空间 [42] 和图像特征空间 [45]。

与上述方法不同,我们的配方不依赖于在任何特定于任务的预定义相似性函数上输入和输出,我们也不假设输入和输出必须位于同一个低维嵌入空间中。这使得我们的方法成为许多人的通用解决方案。视觉和图形任务。我们直接与几个进行比较第 5.1 节中的先前方法。与我们的工作同时,在同样,Yi等人[55]独立介绍不成对的图像到图像翻译的类似目标,灵感来自机器翻译中的对偶学习[15]。

循环一致性 使用传递性作为一种方式的想法规范结构化数据具有悠久的历史。在视觉跟踪中,强制实施简单的向前向后一致性几十年来的标准伎俩[44]。在语言域中,通过“回溯翻译和改进翻译和改进翻译重新协调“是人工翻译人员使用的一种技术 [3](幽默地包括马克吐温[47]),以及通过机器 [15].最近,高阶循环一致性已被用于运动结构[56],3D形状匹配 [19]、共分割 [51]、密集语义对齐 [59, 60] 和深度估计 [12]。其中,周等人[60]和Godar等人[12]与我们的工作最相似,因为他们使用循环一致性损失作为使用传递性的一种方式监督CNN培训。在这项工作中,我们引入了一个类似的损失推动G和F彼此一致。

神经风格转移 [11, 21, 48, 10] 是另一种方式以执行图像到图像转换,这将合成通过将一个图像的内容与另一幅图像(通常是一幅画)的样式,通过匹配预先训练的深层特征的Gram矩阵统计。我们的主要另一方面,重点是学习两者之间的映射域,而不是在两个特定图像之间,通过尝试捕获更高级别外观之间的对应关系结构。因此,我们的方法可应用于其他任务,如绘画→照片,物体变形等。其中单个样品转移方法表现不佳。我们在第 5.2 节中比较了这两种方法。

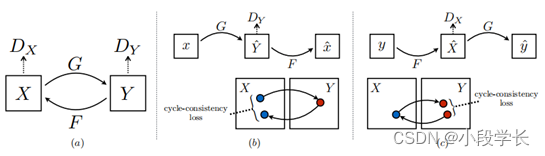

图 3:(a) 我们的模型包含两个映射函数 G : X → Y 和 F : Y → X,以及相关的对抗性鉴别器 DY 和 DX。断续器鼓励 G 将 X 转换为与域 Y 无法区分的输出,反之亦然,用于 DX、F 和 X。为了进一步规范映射,我们引入两个“周期一致性损失”,它们抓住了一种直觉,即如果我们从一个域转换到另一个域,然后再转换回来,我们应该到达我们的地方。开始:(b) 前向循环一致性损失:x → G(x) → F(G(x)) ≈ x,以及 (c) 后向循环一致性损失:y → F(y) → G(F(y)) ≈ y

3. 配方

我们的目标是学习两个域 X 和 Y 之间的映射函数,给定训练样本 {xi}Ni=1 ∈ X 和{yj}Mj=1 ∈ Y 。如图3(a)所示,我们的模型包括两个映射G:X→Y和F:Y→X。此外,我们引入了两个对抗性鉴别器DX和

DY ,其中 DX 旨在区分图像 {x} 和翻译图像 {F(y)};同样,DY旨在区分{y}和{G(x)}。我们的目标包含两项的种类:对抗性损失[14],用于匹配将生成的图像分发到数据分发目标域;和一个循环一致性损失,以防止从相互矛盾中学习映射 G 和 F。

3.1对抗性损失

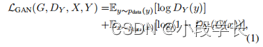

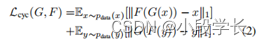

我们将对抗性损失 [14] 应用于两个映射函数。对于映射函数 G : X → Y 及其鉴别器DY,我们将目标表示为:

其中 G 尝试生成与域 Y 中的图像相似的图像 G(x),而 DY 旨在区分已翻译的样本 G(x) 和真实样本 y。我们介绍一个映射函数 F : Y → X 的类似对抗性损失以及其鉴别器DX:即LGAN(F,DX,Y,X)。

3.2循环一致性损失

从理论上讲,对抗训练可以学习映射G和产生输出的输出分别与目标域 Y 和 X 相同(严格地说,这需要G 和 F 将是随机函数) [13]。但是,与大型容量足够,一个网络可以映射同一组输入图像到目标中图像的任何随机排列域,其中,任何学习的映射都可以诱导与目标分布匹配的输出分布。进一步减少可能的映射函数的空间,我们认为学习的映射函数应与周期一致:如图 3 (b) 所示,对于域 X 中的每个图像 x,图像翻译周期应该能够将 x 带回原始图像,即 x → G(x) → F(G(x)) ≈ x。我们称之为正向循环一致性。同样,如图 3 所示(c),对于域Y、G和F中的每个图像y,还应满足向后循环一致性:y →F(y) →G(F(y)) ≈ y。我们可以使用循环一致性来激励这种行为损失:

在初步实验中,我们还尝试更换L1范数在此损失中与 F(G(x)) 之间的对抗性损失

和 x,以及 G(F(y)) 和 y 之间,但没有观察到性能的提高。在 arXiv 版本中可以观察到由循环一致性损失引起的行为。

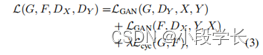

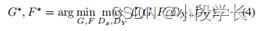

3.3完整目标

我们的完整目标是:

其中 λ 控制两个目标的相对重要性。

我们的目标是解决:

请注意,我们的模型可以被视为训练两个“自动编码器”[18]:我们学习一个自动编码器F ◦ G : X → X与另一个 G ◦ F : Y → Y 联合使用 。但是,这些自动编码器各自具有特殊的内部结构:它们映射图像通过中间表示到自身,该表示是将图像转换为另一个域。这样的设置也可以被视为“对抗性自动编码器”的特例[30],使用对抗性损失来训练瓶颈层的自动编码器以匹配任意目标分布。在我们的例子中,X → X 自动编码器的目标分布是域 Y 的分布。在第 5.1.3 节中,我们比较了我们的方法反对全目标的消融,并经验表明两个目标在到达时起着关键作用高质量的结果。

4. 实现

网络架构:我们调整架构以适应我们的架构来自Johnson等人的生成网络[21],他们有在神经风格转移和超分辨率方面显示出令人印象深刻的结果。该网络包含两个步幅 2 卷积,几个残余块 [16]和两个 12步幅卷积。与 Johnson 等人 [21] 类似,我们使用实例规范化 [49]。对于鉴别器网络,我们使用70×70个PatchGAN [20,26,25],旨在对70×70进行分类。重叠的图像补丁是真的还是假的。这样的补丁级别鉴别器架构的参数比完全图像鉴别器少,可以应用于任意大小的完全卷积方式的图像[20]。

培训细节 我们应用了最近的两种技术致力于稳定我们的模型训练过程。首先,对于LGAN(等式1),我们替换负对数似然目标由最小二乘损失[31]。这种损失表现更多在训练期间稳定,并产生更高质量的结果。然后,等式 1 变为:

其次,为了减少模型振荡[13],我们遵循Shrifastava等人的策略[42]并更新鉴别器DX和 DY 使用生成的图像的历史记录,而不是由最新的生成网络产生的。我们保留存储以前生成的 50 个图像的图像缓冲区。

请参阅我们的 arXiv 白皮书,了解有关数据集、架构和训练程序。

5. 结果

我们首先将我们的方法与最近的方法进行比较配对数据集上的未配对图像到图像转换,其中地真输入-输出对可用于评估。

然后,我们研究了对抗性损失的重要性和循环一致性损失,并比较我们的完整方法针对多种变体。最后,我们展示了我们的算法在广泛的应用中的通用性,其中配对数据不存在。为简洁起见,我们参考我们的方法作为CycleGAN。

5.1评估

使用与“pix2pix”[20],我们在定性和定量上将我们的方法与几个基线进行比较。我们还执行烧蚀研究的全部损失功能。

5.1.1基线

CoGAN [28] 此方法可学习一个 GAN 生成器域 X 和域 Y 的一个,在用于共享潜在表示的前几个层。译本从 X 到 Y 可以通过找到生成图像 X 的潜在表示,然后渲染此潜在表示来实现表示为样式 Y。

像素损失 + GAN [42] 像我们的方法一样,Shrivastava et[42]使用对抗性损失来训练来自X的翻译。到 Y 。正则化项 k X −Yˆ k 1 用于惩罚在像素级别进行大量更改。

特征丢失 + GAN 我们还测试了 [42] 的变体,其中L1 损耗是使用预训练网络 (VGG-16 relu4 2 [43]),而不是超过RGB像素值。

BiGAN/ALI [7, 6] 无条件 GAN [14] 学习生成器 G : Z → X,将随机噪声 Z 映射到图像 X。BiGAN [7]和ALI [6]也建议学习逆映射函数 F : X → Z.虽然他们最初是设计用于将潜在向量 z 映射到图像 x,我们实现了映射源图像的相同目标x 到目标图像 y。

pix2pix [20] 我们还与 pix2pix [20] 进行了比较,后者在配对数据上进行训练,看看我们能有多接近这个不使用配对数据的“上限”。

为了进行公平的比较,我们使用与我们的方法相同的架构和细节,除了科根 [28].我们使用CoGAN的公开实施由于结构的底层差异。

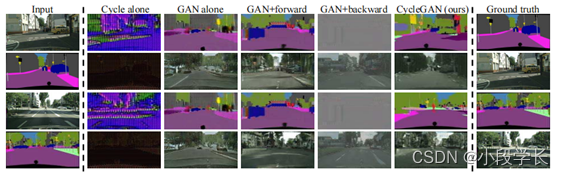

图4:映射标签的不同方法→照片城市景观。从左到右:输入,BiGAN/ALI[6,7],CoGAN [28],CycleGAN(我们的),pix2pix [20]在配对数据和地面事实上进行了训练。

图5:在Google上绘制航空照片↔地图的不同方法地图。从左到右:输入,BiGAN/ALI [6,7],CoGAN [28],CycleGAN(我们的),pix2pix [20]在配对数据和地面事实上训练。

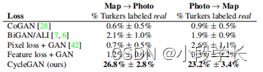

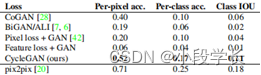

表1:AMT对地图模拟照片的“真实与虚假”测试。

表2:在城市景观上评估的不同方法的FCN得分

标签→照片。

表3:不同方法的照片→标签的分类性能(城市)

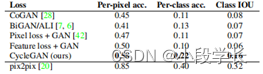

图 6:我们用于映射标签↔的方法的不同变体在城市景观上训练的照片。从左到右:输入,周期一致性损失单独,仅对抗性损失,GAN + 前向循环一致性损失 (F(G(x)) ≈ x),GAN + 向后循环一致性损失 (G(F(y)) ≈ y),CycleGAN (我们的完整的方法),以及基本事实。Cycle alone 和 GAN + back 都无法生成与目标域类似的图像。GAN单独和GAN +转发遭受模式崩溃,无论输入照片如何,都会生成相同的标签地图。

5.1.2与基线的比较

如图 4 和图 5 所示,我们无法使用任何基线实现令人信服的结果。我们另一方面,方法能够产生翻译通常与完全受监督的pix2pix具有相似的质量。我们排除了像素损失 + GAN 和特征损失 + GAN这些数字,因为这两种方法都无法在全部靠近目标域(完整结果可在https://junyanz.github.io/CycleGAN/)。

此外,我们的方法和基线是定量的在三个方面进行比较。首先,我们进行“真实与虚假”研究亚马逊机械土耳其(AMT)工人评估感知现实主义[20]。其次,我们在→上训练照片标签任务城市景观数据集,并将输出标签图像与使用城市景观标准指标基本事实基准[4]。最后,我们在同一个平台上训练标签→照片任务数据集并使用现成的评估输出照片全卷积语义分割网络[29]。我们发现我们的方法明显优于基线在所有三个实验中。表1 报告了AMT感知现实主义任务。在这里,我们看到我们的方法可以在大约四分之一的试验中欺骗参与者,在这两种情况下地图→照片方向和照片→地图方向。都基线几乎从未愚弄过参与者。表 2 和表 3 评估标签,照片任务的性能城市景观。在这两种情况下,我们的方法再次优于基线。每个实验的详细程序和结果可以在我们的arXiv版本中找到。

5.1.3烧蚀研究

我们将其与全部损失的消融进行比较。图 6显示了几个定性示例。消除 GAN 损失大大降低结果,消除循环一致性损失也是如此。因此,我们的结论是,这两个术语都是对我们的结果至关重要。我们还通过以下方式评估我们的方法仅一个方向的循环损失:GAN+正向循环loss Ex∼pdata(x)[k F(G(x)) − xk 1],或 GAN+ 反向循环损失 Ey∼pdata(y)[k G(F(y)) − yk 1] (等式 2),并发现它经常导致训练不稳定并导致模式崩溃,特别是对于已删除的映射的方向。我们还定量测量了城市景观的消融。照片→标签,其结果可以在我们的arXiv版本中找到。

5.2应用

我们在多个应用上演示了我们的方法,其中配对训练数据不存在。我们观察到翻译

训练数据通常比测试数据更具吸引力数据,以及训练和测试数据可以在我们的项目网站上查看。

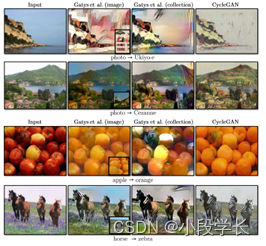

对象变形(图 7)模型被训练为将一个对象类从 Imagenet [38] 转换为另一个对象类(每个类包含大约 1000 个训练图像)。Turmukhambetov等人[46]提出了一个子空间模型来翻译一个对象进入同一类别的另一个对象,而我们的方法侧重于两个视觉上相似的类别之间的对象变形。

赛季转移(图 7)模型在Flickr上优胜美地的冬季和夏季照片。

集合样式转移(图 8)我们训练模型从Flickr下载的风景照片和维基艺术。请注意,与最近关于“神经风格转移”[11]的工作不同,我们的方法学会了模仿整个风格的风格。一套艺术品(例如梵高),而不是转移单件精选艺术作品的风格(例如星夜)。在图 5.2,我们将结果与 [11] 进行了比较。

从绘画中生成照片(图 9)用于绘画→照片,我们发现介绍一个额外的损失,以鼓励映射以保持颜色输入和输出之间的组合。特别是,我们采用泰格曼等人的技术[45] 并规范化生成器位于身份映射附近,当提供目标域的真实样本作为输入时生成器: 即 Lidentity(G, F) = Ey∼pdata(y)[k G(y) − yk 1] +Ex∼pdata(x)[k F(x) − xk 1].

没有 Lidentity,发电机 G 和 F 可以自由更改没有必要时输入图像的色调。例如在学习莫奈的画作和Flickr照片,生成器经常映射绘画白天到日落时拍摄的照片,因为这样的映射在对抗性损失和循环一致性损失。此标识映射的效果损失可以在我们的arXiv论文中找到。

在图 9 中,我们显示了将 Monetpaintings 转换为照片的其他结果。此图显示了训练集中包含的绘画的结果,而对于所有论文中的其他实验,我们只评估和显示测试设置结果。因为训练集不包括成对数据,为训练集提出合理的翻译绘画是一项不平凡的任务。事实上,由于莫奈不再是能够创作新画,概括为看不见,“测试集”,绘画不是一个紧迫的问题。

照片增强(图7)我们展示了我们的方法可用于生成景深较浅的照片。我们在从Flickr下载的花卉照片上训练模型。源域智能手机,由于以下原因,通常具有深景深小光圈。目标照片是用数码单反相机拍摄的具有更大的光圈。我们的模型成功生成从拍摄的照片中具有较浅景深的照片智能手机。

6. 局限性和讨论

虽然我们的方法可以在许多情况下,结果远非一致阳性。图 12 显示了几种典型的故障情况。涉及颜色和纹理更改的翻译任务,如许多在上面报道的那些中,该方法经常成功。我们有还探索了需要几何变化的任务,几乎没有什么成功。例如,在狗→猫变形的任务中,习得的翻译退化为最小化对输入的更改(图 12)。处理方式更多样化极端变换,特别是几何变化,是未来工作的一个重要问题。

某些失败案例是由训练数据集的分布特征引起的。例如,马→斑马图 12 中的任务已完全失败,因为我们的模型在ImageNet的野马,斑马合成集上训练,不包含骑马者的图像或斑马。

我们还观察到,通过配对训练数据可以获得的结果与通过我们的未配对方法实现的结果之间存在挥之不去的差距。在某些情况下,这种差距可能非常困难 - 或者甚至不可能 - 关闭:例如,我们的方法有时会在输出中排列树和建筑物的标签的照片→标签任务。要解决这种歧义,可能会需要某种形式的弱语义监督。整合弱或半监督的数据可能会导致更多功能强大的翻译人员,仅占注释成本的一小部分的全监督系统。

尽管如此,在许多情况下,完全不成对的数据是大量可用,应加以利用。本文突破了在这种“无监督”环境中可能的界限。

致谢

我们感谢Aaron Hertzmann,Shiry Ginosar,Deepak Pathak,Bryan Russell,Eli Shechtman,Richard张,和周婷辉对许多有益的评论。这工作部分由NSF SMA-1514512,NSF IIS-1633310,谷歌研究奖,英特尔公司和硬件英伟达的捐款。JYZ由Facebook支持研究生奖学金和TP由三星支持奖学金。风格转移中使用的照片是由AE拍摄,主要在法国。

图9:将莫奈画作映射到照片的结果。有关其他示例,请参阅我们的网站。

图 10:照片增强:从一组 iPhone 快照映射到专业的数码单反相机照片,系统经常学会制作浅层重点。在这里,我们展示了测试集中一些最成功的结果-平均性能要差得多。请访问我们的网站了解更多信息全面和随机的例子。

图11:我们将我们的方法与神经风格转移[11]进行了比较。留给右:输入图像,结果来自 [11] 使用单个代表性图像作为样式图像,使用目标域中的所有图像来自 [11] 的结果,和CycleGAN(我们的)

图 12:我们方法的一些失败案例。

参考文献

[1] Y. Aytar, L. Castrejon, C. Vondrick, H. Pirsiavash, and A. Torralba. Cross-modal scene networks. arXiv preprint arXiv:1610.09003, 2016. 3

[2] K. Bousmalis, N. Silberman, D. Dohan, D. Erhan, and D. Krishnan. Unsupervised pixel-level domain adaptation with generative adversarial networks. arXiv preprint arXiv:1612.05424, 2016. 3

[3]R. W. Brislin. Back-translation for cross-cultural research. Journal of cross-cultural psychology, 1(3):185–216, 1970. 2, 3

[4] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele.The cityscapes dataset for semantic urban scene understanding. In CVPR, 2016. 2, 6

[5] E. L. Denton, S. Chintala, R. Fergus, et al. Deep generative image models using a laplacian pyramid of adversarial networks. In NIPS, pages 1486–1494, 2015.2

[6] J. Donahue, P. Kr¨ahenb¨uhl, and T. Darrell. Adversarial feature learning. arXiv preprint arXiv:1605.09782, 2016.5

[7] V. Dumoulin, I. Belghazi, B. Poole, A. Lamb, M. Arjovsky, O. Mastropietro, and A. Courville. Adversarially learned inference. arXiv preprint arXiv:1606.00704, 2016. 5

[8] A. A. Efros and T. K. Leung. Texture synthesis by non-parametric sampling. In ICCV, volume 2, pages1033–1038. IEEE, 1999. 2

[9] D. Eigen and R. Fergus. Predicting depth, surface normals and semantic labels with a common multi-scale convolutional architecture. In ICCV, pages 2650–2658,2015. 2

[10] L. A. Gatys, M. Bethge, A. Hertzmann, and E. Shechtman. Preserving color in neural artistic style transfer.arXiv preprint arXiv:1606.05897, 2016. 3

[11] L. A. Gatys, A. S. Ecker, and M. Bethge. Image style transfer using convolutional neural networks. CVPR,2016. 3, 6, 8

[12] C. Godard, O. Mac Aodha, and G. J. Brostow. Unsupervised monocular depth estimation with left-right consistency. In CVPR, 2017. 3

[13] I. Goodfellow. Nips 2016 tutorial: Generative adversarial networks. arXiv preprint arXiv:1701.00160, 2016. 2, 4

[14] I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu,D. Warde-Farley, S. Ozair, A. Courville, and Y. Bengio. Generative adversarial nets. In NIPS, 2014. 2, 3, 4, 5

[15] D. He, Y. Xia, T. Qin, L. Wang, N. Yu, T. Liu, and W.-Y.Ma. Dual learning for machine translation. In NIPS,pages 820–828, 2016. 3

[16] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In CVPR, pages 770–778, 2016. 4

[17] A. Hertzmann, C. E. Jacobs, N. Oliver, B. Curless, and D. H. Salesin. Image analogies. In SIGGRAPH, pages 327–340. ACM, 2001. 2

[18] G. E. Hinton and R. R. Salakhutdinov. Reducing the dimensionality of data with neural networks. Science,313(5786):504–507, 2006. 4

[19] Q.-X. Huang and L. Guibas. Consistent shape maps via semidefinite programming. In Computer Graphics Forum, volume 32, pages 177–186. Wiley Online Library,2013. 3

[20] P. Isola, J.-Y. Zhu, T. Zhou, and A. A. Efros. Image-toimage translation with conditional adversarial networks.In CVPR, 2017. 2, 3, 4, 5

[21] J. Johnson, A. Alahi, and L. Fei-Fei. Perceptual losses for real-time style transfer and super-resolution. In ECCV, pages 694–711. Springer, 2016. 2, 3, 4

[22] L. Karacan, Z. Akata, A. Erdem, and E. Erdem. Learning to generate images of outdoor scenes from attributes and semantic layouts. arXiv preprint arXiv:1612.00215, 2016. 3

[23] D. P. Kingma and M. Welling. Auto-encoding variational bayes. ICLR, 2014. 3

[24] P.-Y. Laffont, Z. Ren, X. Tao, C. Qian, and J. Hays.Transient attributes for high-level understanding and editing of outdoor scenes. ACM Transactions on Graphics (TOG), 33(4):149, 2014. 2

[25] C. Ledig, L. Theis, F. Husz´ar, J. Caballero, A. Cunningham, A. Acosta, A. Aitken, A. Tejani, J. Totz, Z. Wang,et al. Photo-realistic single image super-resolution using a generative adversarial network. arXiv preprint

arXiv:1609.04802, 2016. 4

[26] C. Li and M. Wand. Precomputed real-time texture synthesis with markovian generative adversarial networks.ECCV, 2016. 4

[27] M.-Y. Liu, T. Breuel, and J. Kautz. Unsupervised image-to-image translation networks. arXiv preprint arXiv:1703.00848, 2017. 3

[28] M.-Y. Liu and O. Tuzel. Coupled generative adversarial networks. In NIPS, pages 469–477, 2016. 3, 5

[29] J. Long, E. Shelhamer, and T. Darrell. Fully convolutional networks for semantic segmentation. In CVPR, pages 3431–3440, 2015. 2, 3, 6

[30] A. Makhzani, J. Shlens, N. Jaitly, I. Goodfellow, and B. Frey. Adversarial autoencoders. arXiv preprint arXiv:1511.05644, 2015. 4

[31] X. Mao, Q. Li, H. Xie, R. Y. Lau, and Z. Wang. Multiclass generative adversarial networks with the l2 loss function. arXiv preprint arXiv:1611.04076, 2016. 4 2231

[32] M. Mathieu, C. Couprie, and Y. LeCun. Deep multi scale video prediction beyond mean square error. ICLR,2016. 2

[33] M. F. Mathieu, J. Zhao, A. Ramesh, P. Sprechmann, and Y. LeCun. Disentangling factors of variation in deep representation using adversarial training. In NIPS, pages 5040–5048, 2016. 2

[34] D. Pathak, P. Krahenbuhl, J. Donahue, T. Darrell, and A. A. Efros. Context encoders: Feature learning by inpainting. CVPR, 2016. 2

[35] A. Radford, L. Metz, and S. Chintala. Unsupervised rep resentation learning with deep convolutional generative adversarial networks. arXiv preprint arXiv:1511.06434, 2015. 2

[36] S. Reed, Z. Akata, X. Yan, L. Logeswaran, B. Schiele, and H. Lee. Generative adversarial text to image synthe sis. arXiv preprint arXiv:1605.05396, 2016. 2

[37] R. Rosales, K. Achan, and B. J. Frey. Unsupervised image translation. In iccv, pages 472–478, 2003. 3

[38] O. Russakovsky, J. Deng, H. Su, J. Krause, S. Satheesh,S. Ma, Z. Huang, A. Karpathy, A. Khosla, M. Bernstein,et al. Imagenet large scale visual recognition challenge.

IJCV, 115(3):211–252, 2015. 6

[39] T. Salimans, I. Goodfellow, W. Zaremba, V. Cheung,A. Radford, and X. Chen. Improved techniques for training gans. arXiv preprint arXiv:1606.03498, 2016.2

[40] P. Sangkloy, J. Lu, C. Fang, F. Yu, and J. Hays. Scribbler: Controlling deep image synthesis with sketch and color.In CVPR, 2017. 3

[41] Y. Shih, S. Paris, F. Durand, and W. T. Freeman. Data driven hallucination of different times of day from a single outdoor photo. ACM Transactions on Graphics(TOG), 32(6):200, 2013. 2

[42] A. Shrivastava, T. Pfister, O. Tuzel, J. Susskind,W. Wang, and R. Webb. Learning from simulated and unsupervised images through adversarial training. arXiv preprint arXiv:1612.07828, 2016. 3, 4, 5

[43] K. Simonyan and A. Zisserman. Very deep convolu tional networks for large-scale image recognition. arXiv preprint arXiv:1409.1556, 2014. 5

[44] N. Sundaram, T. Brox, and K. Keutzer. Dense point tra jectories by gpu-accelerated large displacement optical flow. In ECCV, pages 438–451. Springer, 2010. 3

[45] Y. Taigman, A. Polyak, and L. Wolf. Unsuper vised cross-domain image generation. arXiv preprint arXiv:1611.02200, 2016. 3, 6

[46] D. Turmukhambetov, N. D. Campbell, S. J. Prince, and J. Kautz. Modeling object appearance using context conditioned component analysis. In CVPR, pages 4156–4164, 2015. 6

[47] M. Twain. The Jumping Frog: in English, then in French,and then Clawed Back into a Civilized Language Once More by Patient, Unremunerated Toil. 1903. 3

[48] D. Ulyanov, V. Lebedev, A. Vedaldi, and V. Lempitsky.Texture networks: Feed-forward synthesis of textures and stylized images. In Int. Conf. on Machine Learning

(ICML), 2016. 3

[49] D. Ulyanov, A. Vedaldi, and V. Lempitsky. Instance nor malization: The missing ingredient for fast stylization. arXiv preprint arXiv:1607.08022, 2016. 4

[50] C. Vondrick, H. Pirsiavash, and A. Torralba. Generating videos with scene dynamics. In NIPS, pages 613–621,2016. 2

[51] F. Wang, Q. Huang, and L. J. Guibas. Image co segmentation via consistent functional maps. In ICCV,pages 849–856, 2013. 3

[52] X. Wang and A. Gupta. Generative image modeling using style and structure adversarial networks. ECCV,2016. 2

[53] J. Wu, C. Zhang, T. Xue, B. Freeman, and J. Tenenbaum.Learning a probabilistic latent space of object shapes via 3d generative-adversarial modeling. In NIPS, pages 82–90, 2016. 2

[54] S. Xie and Z. Tu. Holistically-nested edge detection. In ICCV, 2015. 2

[55] Z. Yi, H. Zhang, T. Gong, Tan, and M. Gong. Dual gan: Unsupervised dual learning for image-to-image translation. In ICCV, 2017. 3

[56] C. Zach, M. Klopschitz, and M. Pollefeys. Disambiguat ing visual relations using loop constraints. In CVPR, pages 1426–1433. IEEE, 2010. 3

[57] R. Zhang, P. Isola, and A. A. Efros. Colorful image colorization. In ECCV, 2016. 2

[58] J. Zhao, M. Mathieu, and Y. LeCun. Energy based generative adversarial network. arXiv preprint arXiv:1609.03126, 2016. 2

[59] T. Zhou, Y. Jae Lee, S. X. Yu, and A. A. Efros. Flowweb:Joint image set alignment by weaving consistent, pixel wise correspondences. In CVPR, pages 1191–1200,

2015. 3

[60] T. Zhou, P. Krahenbuhl, M. Aubry, Q. Huang, and A. A. Efros. Learning dense correspondence via 3d-guided cycle consistency. In CVPR, pages 117–126, 2016. 2, 3

[61] J.-Y. Zhu, P. Kr¨ahenb¨uhl, E. Shechtman, and A. A. Efros.Generative visual manipulation on the natural image manifold. In ECCV, 2016. 2