- 1HackerRank 算法刷题笔记(一),基于Go语言

- 2多源BFS

- 3移动应用开发技术课设(安卓开发课设)-基于Android平台的记事本软件(代码+课设报告+演示视频)_安卓课设总结

- 4Obsidian 多端免费同步方案_obsidian 同步

- 5java中的hash函数,常见的hash函数 :-D 非常经典!!

- 6一文读懂数据中台技术架构

- 7Windows环境部署MySQL_8.4.0 LTS的部署安装、验证连接以及卸载全过程实操手册_mysql community server 8.4.0 lts

- 8llama-factory学习个人记录_valueerror: please launch distributed training wit

- 9FPGA 设计篇(06-02)FPGA 开发流程_fpga设计流程

- 10【零基础学爬虫】学Python的第一周,自己编写用Python爬取vip小说付费章节,实现小说自由!_python爬取vip小说章节

智谱 GLM-4 大语言模型好用吗?

赞

踩

我替你尝试了它的基本对话、绘图、阅读长文档、数据分析和高级联网等几方面能力。

最近智谱的 GLM-4 大语言模型发布,成为了热门话题。一篇文章不断出现在我的朋友圈和各种群聊中。

这篇文章是由新智元发布的,介绍了GLM-4的特性。文章兴奋地宣称,现在我们也有了国产的「GPTs技术」。但我真正感兴趣的不仅仅是GLM-4的GPTs技术,而更看重它的实际性能。文章中提到了GLM-4的多项能力,特别是它在某些方面能够达到GPT-4的90%到99%的水平,还能进行所谓的“大海捞针”测试。

“大海捞针” 测试是一项针对大语言模型上下文记忆检索的特殊能力测试,我之前给你介绍的 Kimi Chat 是第一个在 128K 窗口大小上获得满分的国产 LLM 。

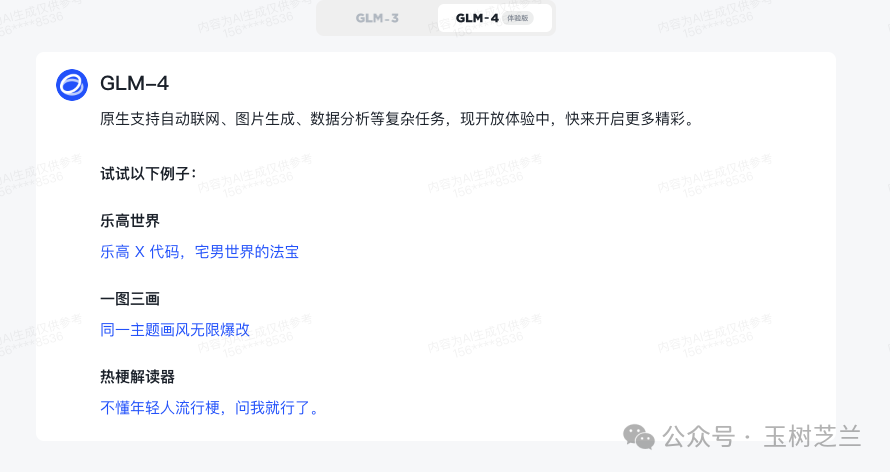

GLM-4 的主页上,提供了一些官方功能,包括绘图、解读长文档、数据分析和高级网络连接等。

我对 GLM-4 提供的这些功能特别感兴趣,于是逐一测试这些功能。我选择用日常工作中经常使用的一些功能来进行实际测试,最关心的是 GLM-4 是否能真正提高用户的工作效率。下面,我给你展示基本功能、绘图、阅读长文档、数据分析和高级联网等几个方面的测试结果。

基础

首先是基础功能。这是你一打开 GLM-4,看到的最基本界面。我选择 GLM-4 标签页进行测试。

从介绍上不难看出,GLM-4 在基本模式里能做的事情非常多,就像现在的 GPT-4 一样。它能够原生支持问答、联网查询、绘图、图像识别等多种操作。

GLM-4宣称具有「大海捞针」能力,即能处理超过100K字符的对话上下文窗口,而且不产生幻觉。这让我首先想到的是长文翻译功能。

我选了一篇 Markdown 格式的中文长文,包含了图片链接和其他一些元素。

我将这篇文章输入到 GLM-4 中,看看它是否能提供一个完整的翻译。我的提示词为:

请帮我将下面的文章翻译成英文,并注意保留所有细节,包括 Markdown 格式,以及图片和文内链接等。

无论是使用 GPT-4 原声对话,或是我自己开发的 GPTs「博客文章中译英」(已经发布在 GPTs Store 上),还是 Kimi Chat,我都尝试过输入这么长的文章,它们通常都能继续输出内容。当然由于对话上下文的长度限制,它们可能无法一次性完整输出整篇文章的翻译结果。

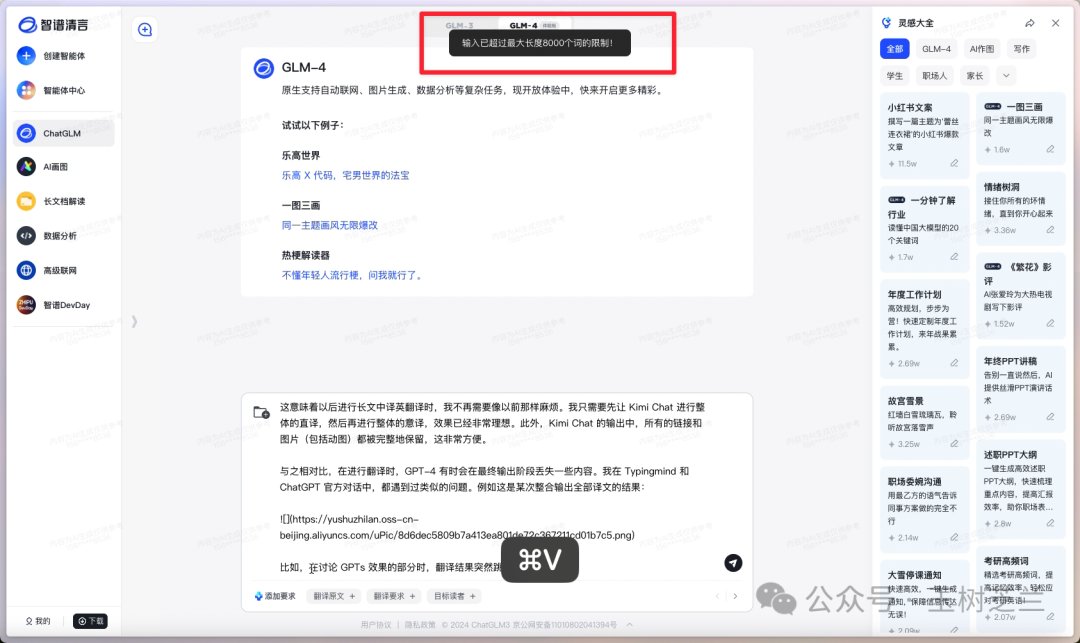

可是在 GLM-4 这里,当我尝试粘贴文章时,GLM-4 提示我输入的内容已经超过了最大长度限制,即 8000 个词。

我感到困惑,因为按照 128K 对话窗口的标准,这篇文章应该是可以完整粘贴进去的。

那咱们就凑合一下吧。既然无法翻译整篇文章,那能翻译多少算多少。在翻译过程中,你可以看到标题的格式得到了保留。

接下来,GLM-4 正常显示了图片,而且文章中的链接也都得到了保留。

它继续输出图片,以及后续文字。我看到这里时感到很高兴,似乎又发现了一款目前免费的长文翻译工具。GLM-4 继续输出,我就在旁边观察。但是,好景不长。

GLM-4 突然显示了一条消息,表示无法提供我所需的具体信息。如果我有其他问题或需要查询其他信息,它表示愿意协助。

如前所述,对话不能完整输出这种情况在我以前的翻译应用中也经常遇到。可是与其他大语言模型不同的是,GLM-4 会直接清空所有已经输出的内容,导致之前的翻译努力全都付诸东流。

这种情况让我感到非常苦恼。我想给智谱提个建议 —— 当 GLM-4 崩溃时,能否保留已经输出的文本内容?毕竟前面的内容已经输出了,我可以将其复制出来继续使用,然后指定从某个特定位置继续翻译。

画图

接下来,我们来看一个大家经常会使用的功能 —— 绘图。

无论是为公众号文章制作插图,还是为我的视频绘制封面,我现在都依赖 AI 来完成这些绘画工作。

我用的提示词是「驴肉火烧」。这个提示词有助于考察大语言模型对中华美食文化的理解能力。

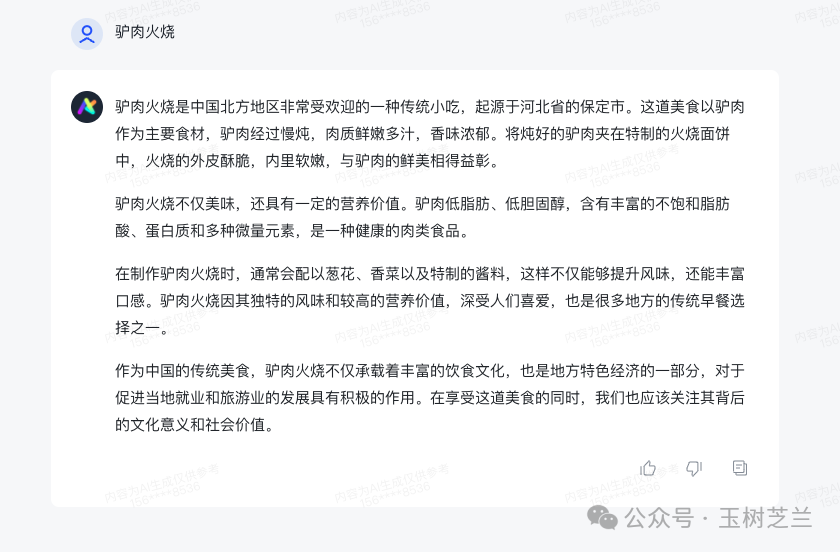

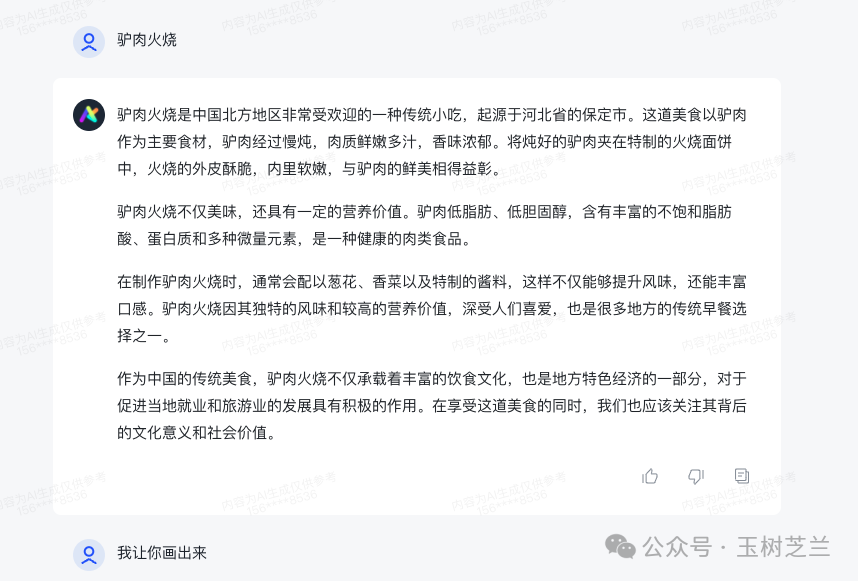

我输入 “驴肉火烧” 这四个字后,GLM-4 开始向我解释驴肉火烧是什么,它起源于河北省保定市,主要食材是什么,慢炖的方式使其鲜嫩多汁,香味浓郁,还谈到了它的文化意义和社会价值。

我看得一头雾水 —— 我这不是在绘图模式下吗?你倒是画啊?!

看来即使我在专用的绘图智能体中,如果不明确指出要求绘图,GLM-4 仍然会将我的输入当作是普通对话提问来处理。于是我只好直接告诉它我的要求。

GLM-4 使用了一个名为 CogView 的绘图功能。

我放大生成后的图片仔细观看,确实很诱人,鲜嫩多汁。

然而,我也发现了一些问题。首先,画中火烧外面的面饼,似乎与我们熟悉的样子不太一样。此外,尽管这是一个中文的大型语言模型,但在处理图片中的中文时,仍然存在问题。画中的文字,显然并不是真正的汉字。

这表明尽管 GLM-4 是中文模型,但在文字处理方面仍有待改进。画面右下角特意加了一个 “AI 生成” 标签,表明这是 AI 生成的,以防止滥用。

接下来我又尝试了另一个例子,是我前两天为一个视频制作的封面。

我当时请 GPT-4 绘制一个场景:一个机器人戴着博士帽,坐在电脑前认真地查阅文献和撰写文稿。旁边有一个中年男子正在喝咖啡,愉快地观察机器人工作。

我认为 GPT-4(借助 DALLE-3)总体上画得还不错。除了机器人面前这张纸不知为何飞起来了,其他方面挺好的。

我用同样的提示词在 GLM-4 中进行了测试。这是它为我绘制的结果。

放大来看,画面基本上符合我们的要求。

只是有一个小问题,机器人头顶上戴的那个东西真的像博士帽吗?

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。