热门标签

热门文章

- 1【面经】顺丰科技HR面(软件开发)_顺丰科技hr面试刷人吗

- 2前端面试准备(一)_前端面试需要做什么准备

- 3各种机器学习算法的应用场景分别是什么(比如朴素贝叶斯、决策树、K 近邻、SVM、逻辑回归最大熵模型)?...

- 4Vue.js框架+Axios发送异步请求+elementui前端布局框架

- 5Android开发如何学习,鸿洋推荐,必属精品!(1)

- 6Spark on YARN部署模式保姆级教程_yarn模式进行spark的部署原理图

- 7AWS云服务器的竞争优势

- 8导出域控的ntds.dit文件_域控数据文件

- 9Python(应用)网页爬虫之BS4(Beautiful Soup)用法及案例_bs4案例

- 10大神们分享STM32的学习方法_stm32完全学习教程

当前位置: article > 正文

自然语言处理实战项目28-RoBERTa模型在BERT的基础上的改进与架构说明,RoBERTa模型的搭建_roberta模型架构

作者:人工智能uu | 2024-07-16 17:23:04

赞

踩

roberta模型架构

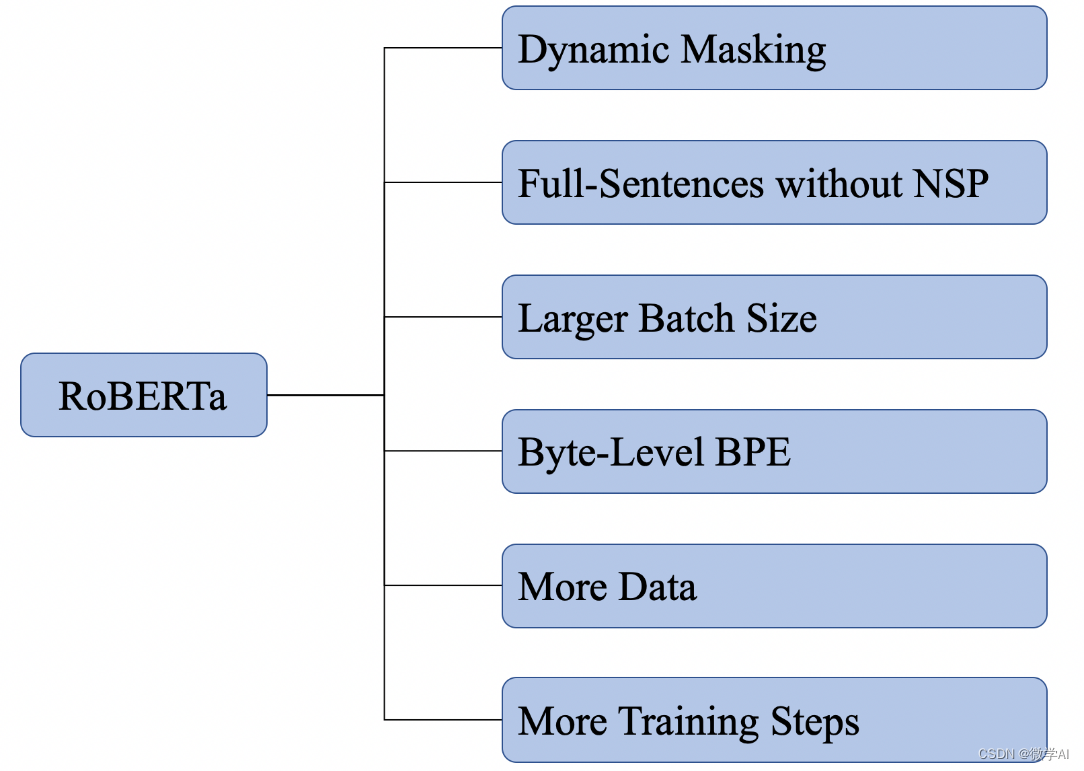

大家好,我是微学AI,今天给大家介绍下自然语言处理实战项目28-RoBERTa模型在BERT的基础上的改进与架构说明,RoBERTa模型的搭建。在BERT的基础上,RoBERTa进行了深度优化和改进,使其在多项NLP任务中取得了卓越的成绩。接下来,我们将详细了解RoBERTa的原理、架构以及它在BERT基础上的改进之处,并通过实战项目来演示如何搭建RoBERTa模型。让我们开始学习-RoBERTa模型吧!

一、RoBERTa模型的介绍

RoBERTa,全称是“Robustly Optimized BERT Pretraining Approach”,是一个强大的自然语言处理模型,它基于BERT架构,并在其基础上进行了改进和优化。让我们从BERT的基础讲起。BERT模型就像是拥有“火眼金睛”的孙悟空,能够洞察语言中的深层含义。它的“秘密武器”是Transformer,这是一种基于自注意力机制的深度神经网络结构,它允许模型在处理每个词时同时关注上下文中的其他所有词,就像孙悟空能够眼观六路、耳听八方一样。

BERT模型的两个任务

BERT模型通过两个主要任务进行预训练:掩码语言模型(Masked Language Model, MLM)和下一句预测(Next Sentence Prediction, NSP)。掩码语言模型就是随机遮盖输入文本中的一些词,然后让模型去预测这些被遮盖的词,这就好比是给孙悟空出了个难题,让他猜猜哪个词被遮住

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/人工智能uu/article/detail/835433?site

推荐阅读

相关标签