- 1 Git关联远程仓库

- 2SQL:DATE_FORMAT()函数_dateformat sql函数

- 3Python实战:wxauto与百度千帆大模型结合快速实现微信智能回复机器人_千帆大模型接入微信

- 4Hive和hdfs的关系与区别_hive hdfs

- 5Vue 2.0中封装Axios请求方法_vue2.0axios的写法

- 62024年Go最新怎么成为稚晖君?_稚辉君(2),2024年最新2024Golang面试总结_宇树科技面经

- 7ZYNQ7000学习——OSERDESE2原语学习_oserdese2原语的使用

- 8NTFS读写软件——Paragon NTFS For Mac_安装好paragon ntfs for mac15如何读写ntfs

- 9fiddler抓取微信小程序包_fiddler抓包小程序

- 10Android app 录音回音消除两种方法_安卓回声消除

2024年最全Python爬虫实战:批量下载网站图片(1)_python下载图片

赞

踩

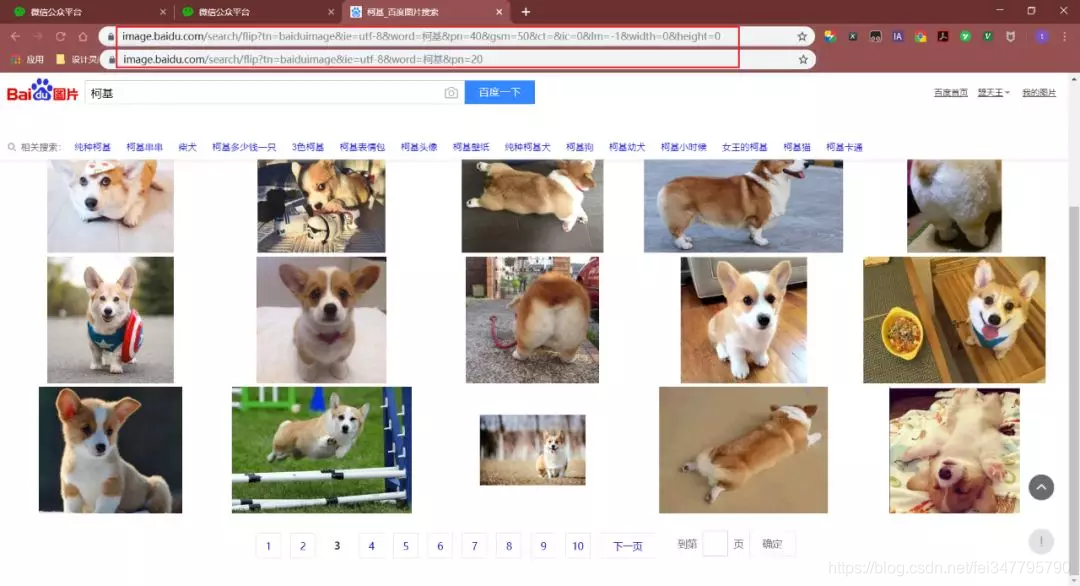

接着,把页面切换成传统翻页版(flip),因为这样有利于我们爬取图片!

对比了几个url发现,pn参数是请求到的数量。通过修改pn参数,观察返回的数据,发现每页最多只能是60个图片。

注:gsm参数是pn参数的16进制表达,去掉无妨

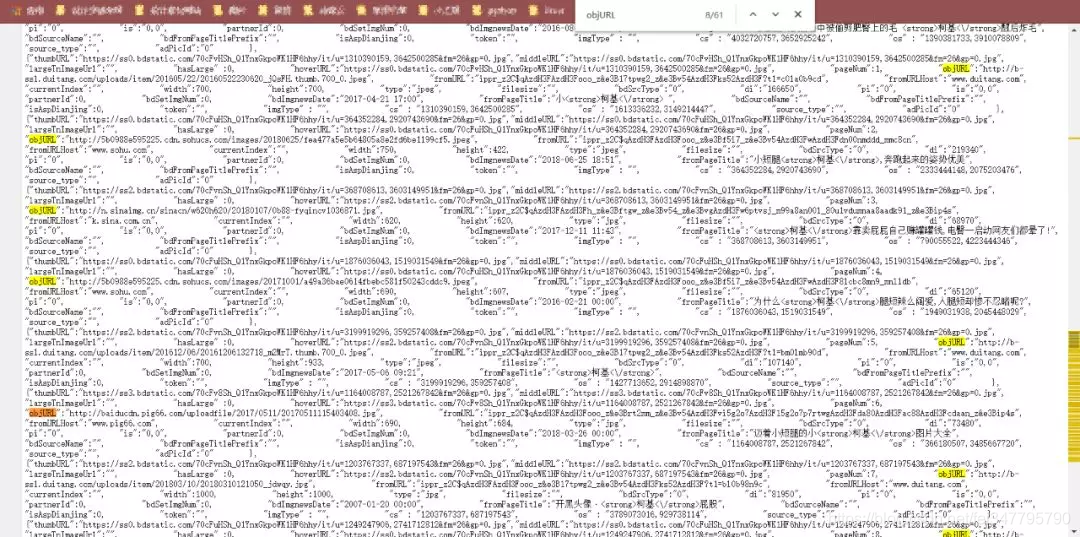

然后,右键检查网页源代码,直接(ctrl+F)搜索 objURL

这样,我们发现了需要图片的url了。

现在,我们要做的就是将这些信息爬取出来。

注:网页中有objURL,hoverURL…但是我们用的是objURL,因为这个是原图

那么,如何获取objURL?用正则表达式!

那我们该如何用正则表达式实现呢?其实只需要一行代码…

results = re.findall(‘“objURL”:“(.*?)”,’, html)

1.获取图片url代码:

获取图片url连接

def get_parse_page(pn,name):

for i in range(int(pn)):

1.获取网页

print(‘正在获取第{}页’.format(i+1))

百度图片首页的url

name是你要搜索的关键词

pn是你想下载的页数

url = ‘https://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=%s&pn=%d’ %(name,i*20)

headers = {

‘User-Agent’: ‘Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.104 Safari/537.36 Core/1.53.4843.400 QQBrowser/9.7.13021.400’}

发送请求,获取相应

response = requests.get(url, headers=headers)

html = response.content.decode()

print(html)

2.正则表达式解析网页

“objURL”:“http://n.sinaimg.cn/sports/transform/20170406/dHEk-fycxmks5842687.jpg”

results = re.findall(‘“objURL”:“(.*?)”,’, html) # 返回一个列表

根据获取到的图片链接,把图片保存到本地

save_to_txt(results, name, i)

2.保存图片到本地代码:

保存图片到本地

def save_to_txt(results, name, i):

j = 0

在当目录下创建文件夹

if not os.path.exists(‘./’ + name):

os.makedirs(‘./’ + name)

下载图片

for result in results:

print(‘正在保存第{}个’.format(j))

try:

pic = requests.get(result, timeout=10)

time.sleep(1)

except:

print(‘当前图片无法下载’)

j += 1

continue

可忽略,这段代码有bug

file_name = result.split(‘/’)

file_name = file_name[len(file_name) - 1]

文末有福利领取哦~

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop】

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。