热门标签

热门文章

- 1如何本地安装gemma

- 2isis 网络 level 2 iih_大数据项目之电商数仓(2业务数据采集平台)V6.1.2 - 十一vs十一...

- 3【SpringCloud】Eureka注册中心 代码详细介绍

- 4一文搞定,RabbitMQ 从初识到精通_rabbitmq erlang processea

- 5【vue教程】keep-alive的使用方法

- 6再聊机器人设计:如何加速开发流程?

- 7物联网系统设计 8

- 8Mac M1通过homebrew安装Redis报错(perl: unknown or unsupported macOS version: :dunno)_warning: no remote 'origin' in /opt/homebrew/libra

- 9基于AIML的Python聊天机器人搭建_aiml python

- 10深度学习十大算法之深度Q网络(DQN)

当前位置: article > 正文

plug-中文大模型_plug模型

作者:从前慢现在也慢 | 2024-04-07 18:03:13

赞

踩

plug模型

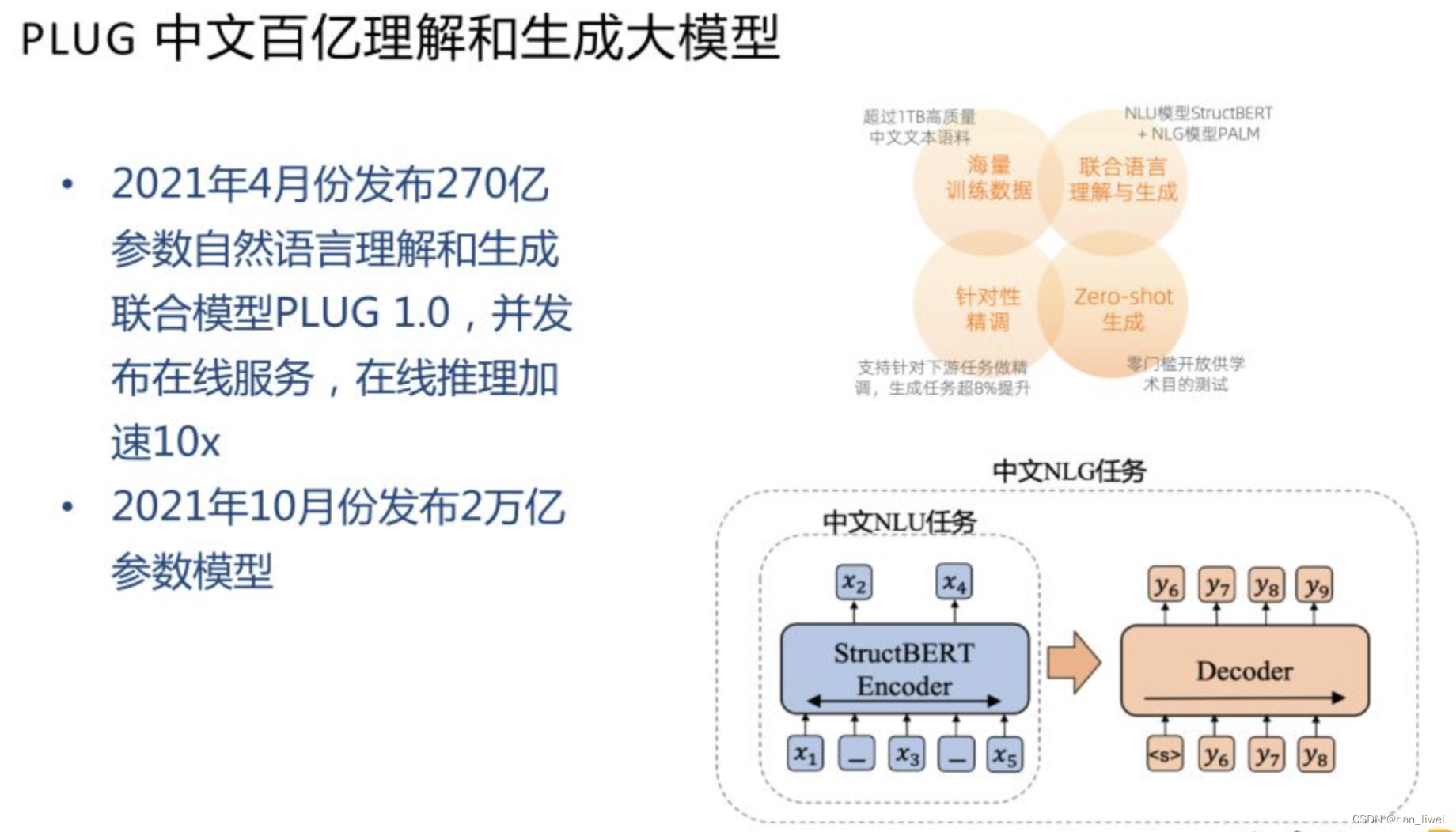

PLUG 中文大模型延续的是 PALM 的思路,结合 NLU 和 NLG 的任务,得到一个理解和生成同时做的模型。NLU 任务是我们自研的 StructBERT 模型,在 BERT的基础上引入三分类以及对词级别打乱。NLG 是 PALM 的自编码自回归结合。训练分为两个阶段,第一阶段是 StructBERT 的思路,把模型大小提升。第二阶段延续 PALM 的思路,用 encoder 做初始化,加上 decoder 之后做生成的训练。这样可以得到一个 Encoder-Decoder 统一理解生成模型。做理解相关任务,比如分类/预测时,只需要把 encoder 部分拿出来,沿用 BERT 的方法。做生成相关任务时,再使用全部的 Encoder-Decoder 架构。这里也做了一些推理加速的工作,和中文 GPT 是相同的技术,获得了 10x 加速的效果。

270 亿参数的 PLUG 模型已经在 ModelScope 上开放,大家可以按照流程申请获取下载链接,然后使用 Pipel

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/379889

推荐阅读

相关标签