- 1Flink CDC 系列(7)—— 从 MySQL 到 ElasticSearch_flink mysql 到 es

- 2手把手教你安装Altium designer 22 【超级详细】_ad22安装教程

- 3详解Hexo搭建博客的底层原理_hexo源码分析

- 4Hive 多数组合并 CONCAT_WS

- 5蓝桥杯岛屿个数dfs(已找到bug)

- 6超详细 | 遗传-粒子群自适应优化算法及其实现(Matlab)_用粒子群算法可以优化遗传算法嘛

- 7Hexo+github搭建个人博客网站_hexo github

- 8林子雨—大数据技术原理与应用—上机实验二_林子雨大数据实验报告

- 9EOS中BPS的WorkSpace启动不了解决方法

- 10OJ 连续数的和 球弹跳高度的计算【C判断是否为完全平方数】【格式输出%g输出全部小数部分】

谷歌开源语言模型Gemma服务器端部署化流程_gemama +open webui

赞

踩

开放模型 Gemma

Gemma 是先进的轻量级开放模型系列,采用了与创建 Gemini 模型相同的研究和技术。受到 Gemini 的启发,Google DeepMind 和 Google 其他团队合作开发了 Gemma,并用拉丁语中意为“宝石”的gemma为其命名。在发布模型权重的同时,我们还推出了一系列工具,旨在支持开发者创新,促进合作,并指导如何负责任地使用 Gemma 模型。

从今天起,Gemma 在全球范围内开放使用。以下是有关该模型的关键细节:

我们将发布两种权重规模的模型:Gemma 2B 和 Gemma 7B。每种规模都有预训练和指令微调版本。

新的 Responsible Generative AI Toolkit 为使用 Gemma 创建更安全的 AI 应用程序提供指导和必备工具。

我们通过原生 Keras 3.0 为所有主要框架(JAX、PyTorch 和 TensorFlow)提供推理和监督微调(SFT)的工具链。

上手即用 Colab 和 Kaggle notebooks,以及与 Hugging Face、MaxText 和 NVIDIA NeMo 等受欢迎的工具集成,让开始使用 Gemma 变得简单容易。

经过预训练和指令微调的 Gemma 模型可以在您的笔记本电脑、工作站或 Google Cloud 上运行,并可轻松部署在 Vertex AI 和 Google Kubernetes Engine(GKE)上。

基于多个 AI 硬件平台进行优化,确保业界领先的性能表现,其中包括 NVIDIA GPUs 和 Google Cloud TPUs。

使用条款允许所有组织(无论规模大小)负责任地进行商用和分发。

同等规模最领先的性能

Gemma 模型与我们规模最大、能力最强的 AI 模型 Gemini 共享技术和基础架构。这使得 Gemma 2B 和 7B 与其他开放模型相比,展现出同等规模最先进的性能。同时,Gemma 可以直接在开发者的笔记本电脑或台式机上运行。值得注意的是,Gemma 在关键基准测试集上大大超过了更大的模型,同时还严格遵守了我们对安全和负责任输出的标准。有关性能、数据集对比和建模方法的详细信息,请参见技术报告。

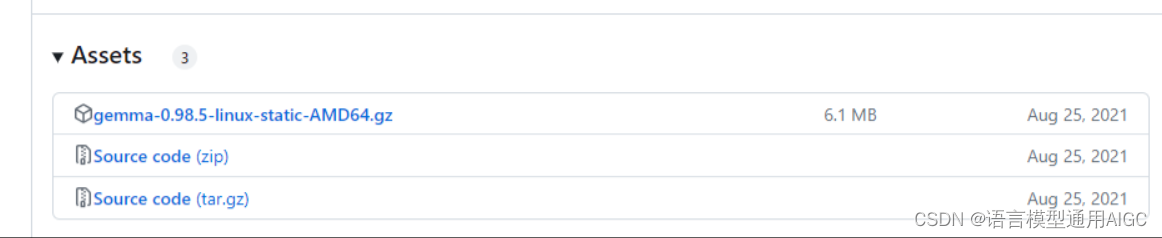

2. GEMMA下载地址

GEMMA的github地址:Releases · genetics-statistics/GEMMA · GitHub

3.下载安装方法

第一种方法,在github手动下载,然后上传到Linux系统:

第二种方法,也可以采用基于ollama方式直接在Linux上进行下载

直接将下面代码进行复制到Linux上

curl -fsSL https://ollama.com/install.sh | sh

然后等待安装完成,安装完成后,执行 ollama run gemma:2b 或者 ollama run gemma:7b 等模型下载完毕后,就进入字符界面,你就可以跟机器交流了。按ctrl-d可退出。

第三种,使用wget直接下载到Linux系统中:

如果你使用的是第一种和第三种,就接着解压

gzip -d gemma-0.98.5-linux-static-AMD64.gz

chmod +x gemma-0.98.5-linux-static-AMD64

然后测试

用ls查看结果,如果里面有这个代表成功

把数据上传到你的Linux服务器端系统中进入数据然后运行下面的代码

gemma-0.98.5-linux-static-AMD64 -bfile c -p p.txt -cc.txt-lm1

然后查看结果

一般下载好后

sudo nano /etc/systemd/system/ollama.service

在nano中,[Service]下面加一行 Environment="OLLAMA_HOST=0.0.0.0:11434"

保存退出后,执行 sudo systemctl daemon-reload 再执行 sudo systemctl restart ollama

PC端打开浏览器,访问http://你的服务器IP:11434 如果显示ollama表示已经成功了。

如果你用的第二种方法那么如下:

安装open-webui,如果你的Linux没有docker请先安装docker 然后运行

sudo docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

3000是默认接口,你可以修改成你想要的接口。然后访问你的服务器就可以了。

以上便是安装GEMMA的方法