热门标签

热门文章

- 1Linux基础(较全)

- 2【一种基于改进A*算法和CSA-APF算法的混合路径规划方法】—— 论文阅读_a hybrid path planning method based on improved a

- 3Mysql在项目中相关使用(简单操作数据库)_mysql在项目中的应用

- 4uni-app 小程序开发项目搭建_uniapp创建一个cli项目 cmd命令

- 5用“价值”的视角来看安全:《构建新型网络形态下的网络空间安全体系》

- 6java 日期加减运算_java时间加减计算方法

- 7zerotier内网穿透功能简要介绍及简明设置方法

- 8开源模型应用落地-LangChain高阶-Tools工具-集成agents(四)_serper

- 9PIBOT移植ROS2记录(7)-launch的参数_ros2 launch env

- 10PMBOK第六版工具与技术:数据收集数据分析数据表现_数据收集、数据分析、数据表现

当前位置: article > 正文

深度学习中的归一化:BN,LN,IN,GN的优缺点

作者:从前慢现在也慢 | 2024-05-06 19:38:18

赞

踩

深度学习中的归一化:BN,LN,IN,GN的优缺点

深度学习中归一化的作用

- 加速训练过程

归一化可以加速深度学习模型的训练过程。通过调整输入数据的尺度,归一化有助于改善优化算法的收敛速度。这是因为归一化后的数据具有相似的尺度,使得梯度下降等优化算法能够更快地找到误差函数的最小值。 - 提高模型泛化能力

归一化能够减少模型对输入特征尺度的依赖,从而提高模型的泛化能力。未归一化的数据可能导致模型对某些特征过度敏感,而忽略其他特征,从而影响模型在未见数据上的表现。通过归一化处理,可以使得不同特征对模型训练的贡献更加均衡。 - 防止梯度消失或梯度爆炸

在深度网络中,由于连续层的复合效应,梯度可能会迅速增大或减小,导致梯度爆炸或梯度消失问题。归一化技术通过规范化层的输入或输出,有助于维持梯度在合理范围内,从而缓解这一问题。 - 稳定训练过程

归一化有助于稳定深度学习模型的训练过程。通过规范化每一层的输入,可以减少输入分布的内部协变量偏移(Internal Covariate Shift),使得每一层可以在更加稳定的数据分布上学习,避免训练过程中的震荡或发散。 - 允许使用更高的学习率

由于归一化减少了参数更新中的尺度差异,使得模型在训练过程中可以使用更高的学习率而不会导致训练不稳定。这进一步加快了模型的收敛速度。 - 减少对初始化敏感

在未归一化的网络中,权重初始化的选择可能对模型的训练和收敛有很大影响。归一化减轻了模型对初始化权重的依赖,使得模型训练更加稳健。

归一化在深度学习中的应用包括批量归一化(Batch Normalization)、层归一化(Layer Normalization)、组归一化(Group Normalization)和实例归一化(Instance Normalization)等。这些技术在不同的网络结构和任务中有着广泛的应用,是现代深度学习架构中不可或缺的一部分。

常见归一化的优缺点

-

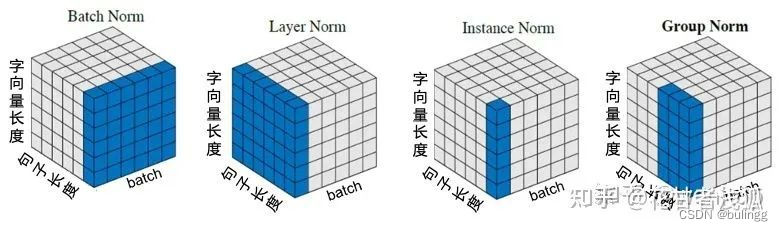

Batch Norm:把每个Batch中,每句话的相同位置的字向量看成一组做归一化。

-

Layer Norm:在每一个句子中进行归一化。

-

Instance Norm:每一个字的字向量的看成一组做归一化。

-

Group Norm:把每句话的每几个字的字向量看成一组做归一化。

其实只要仔细看上面的例子,就很容易能想到NLP中每一种norm的优缺点:

- Batch Normalization(Batch Norm):缺点:在处理序列数据(如文本)时,Batch Norm可能不会表现得很好,因为序列数据通常长度不一,并且一次训练的Batch中的句子的长度可能会有很大的差异;此外,Batch Norm对于Batch大小也非常敏感。对于较小的Batch大小,Batch Norm可能会表现得不好,因为每个Batch的统计特性可能会有较大的波动。

- Layer Normalization(Layer Norm):优点:Layer Norm是对每个样本进行归一化,因此它对Batch大小不敏感,这使得它在处理序列数据时表现得更好;另外,Layer Norm在处理不同长度的序列时也更为灵活。Instance Normalization(Instance Norm):优点:Instance Norm是对每个样本的每个特征进行归一化,因此它可以捕捉到更多的细节信息。

- Instance Norm在某些任务,如风格迁移,中表现得很好,因为在这些任务中,细节信息很重要。缺点:Instance Norm可能会过度强调细节信息,忽视了更宏观的信息。此外,Instance Norm的计算成本相比Batch Norm和Layer Norm更高。

- Group Normalization(Group Norm):优点:Group Norm是Batch Norm和Instance Norm的折中方案,它在Batch的一个子集(即组)上进行归一化。这使得Group Norm既可以捕捉到Batch的统计特性,又可以捕捉到样本的细节信息。此外,Group Norm对Batch大小也不敏感。缺点:Group Norm的性能取决于组的大小,需要通过实验来确定最优的组大小。此外,Group Norm的计算成本也比Batch Norm和Layer Norm更高。

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签