论文导读 | 事件因果关系抽取和识别

赞

踩

导读

目前,对事件因果关系的研究主要分为两类任务:事件因果关系识别(Event Causality Identification,ECI)和事件因果关系抽取(Event Causality Extraction)。事件因果关系识别旨在检测文本中两个事件提及之间是否存在因果关系。而事件因果关系抽取则是信息抽取中的一项具有挑战性的任务,其目标是自动提取事件描述并确定事件之间的因果关系。

研究事件之间的因果关系对于许多下游应用程序非常重要,例如知识获取、问答、情感分析和摘要等。

本文将介绍四篇研究事件因果关系的论文,论文的标题和信息如下所示:

文章列表:

[1] Joint event causality extraction using dual-channel enhanced neural network (Knowledge-Based Systems, 2022)

[2] KEPT: Knowledge Enhanced Prompt Tuning for event causality identification(Knowledge-Based Systems,2023)

[3] Explicit and implicit knowledge-enhanced model for event causality identification(Expert Systems With Applications,2024)

[4] Event causality identification via graph contrast-based knowledgeaugmented networks(Information Sciences,2024)

01

使用双通道增强神经网络进行联合事件因果抽取

Joint event causality extraction using dual-channel enhanced neural network (Knowledge-Based Systems, 2022)

动机

本文主要面向句子级的事件因果抽取任务。该任务的现有方法通常侧重于文本内容,而忽略了事件内部元素之间的转换以及事件之间的因果关系转换,本文提出了一种可以考虑全局事件提及和事件间因果关系转换关联的双通道增强神经网络模型。

方法

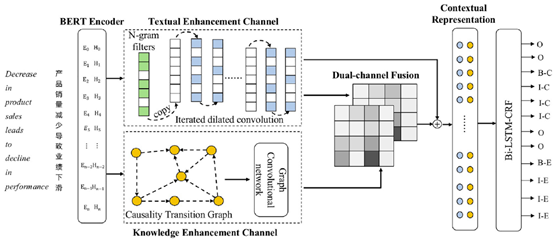

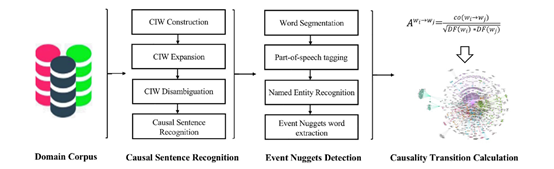

设计思路:如图1-1所示,首先构建了一个文本增强通道(TEC),以提取完整的事件提及。然后,利用图卷积网络(GCN)构建知识增强通道(KEC)整合外部因果关系转迁移知识,以提供事件因果关系的补充信息。最后,设计一个动态的注意机制融合双通道信息。

图1-1 模型图

具体模型

1、文本增强通道

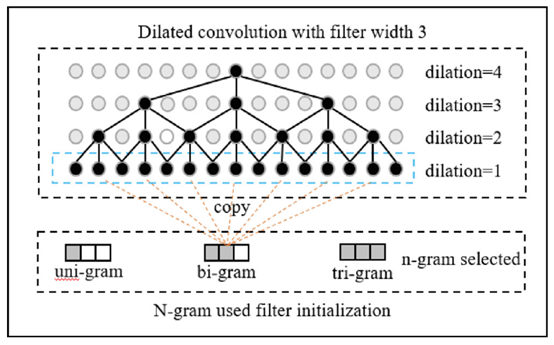

构建过程如图1-2所示,该模块利用迭代空洞卷积去提取完整的事件提及特征以及捕获句子中的上下文信息。具体可以分为n-gram挑选和过滤器初始化两个步骤。

图1-2 文本增强通道图

(1)n-gram挑选

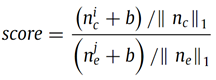

使用朴素贝叶斯的方法对标记数据中的因果 n-gram进行评分,具体的评分方法如下所示:

其中,c 和 e 分别表示因果关系的因果和效应。nci 表示在因果 c 中包含 n-gram i 的句子数量。||nc||1 表示因果 c 中的 n-gram 数量,b 是一个平滑参数。抽取前20%的n-gram输入BERT生成语义特征,然后利用聚类方法将语义上相似的 n-gram 的语义特征进行聚合,生成高级别的 n-gram 语义表示。

(2)过滤器初始化

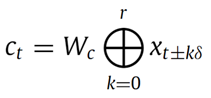

利用高级别的 n-gram 语义表示初始化部分迭代空洞卷积滤波器,对于每个词xt的卷积算子计算如下:

其中,⊕表示向量连接操作,Wc 是 r 个词的滤波器宽度,δ 表示空洞宽度。

2、知识增强通道

图1-3 因果关联转化图构建

(1)因果关联转化图(CTG)构建:CTG的构建如图1-3所示,分为三步:

a. 因果句子识别,使用因果指示词 (CIW) 从未标记的新闻文本中识别包含因果关系的句子,包括 CIW 构建、CIW 扩展、CIW 消歧;

b.事件核心检测,事件核心是一个可以描述一个事件的有意义语义单位,它可以是一个单词或一个短语;

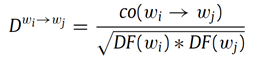

c.因果关联转化计算,给定一组通过事件块检测预处理的因果句子,我们通过以事件描述的关键词wi为节点,关键词间的因果关联转化权重为边可以构造CTG,详细的权重计算公式如下:

其中co(wi → wj) 表示从 cause 词 wi 到 effect 词 wj 的共现频率,DF(wi) 表示包含词 wi 的句子数量。

(2)基于CTG的图卷积网络(GCN)编码:本文使用图卷积网络(GCN)编码 CTG 中节点之间的因果关联转换信息。

3、双通道融合:使用多头注意力机制融合双通道信息。

4、目标函数:利用双向长短期记忆网络(BiLSTM)学习语义特征,然后使用条件随机场(CRF)对BiLSTM输出的标签序列进行解码。

实验

实验数据集:The Financial dataset、CEC (Chinese emergency corpus) dataset和SemEval-2010 task 8 dataset

实验评价指标:F1

实验结果与结论

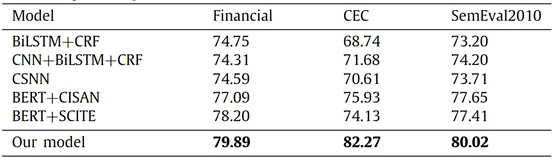

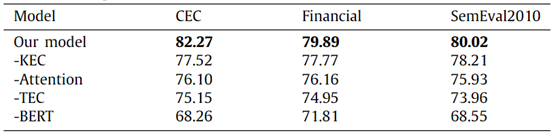

表1-1 整体实验结果

表1-2 消融实验结果

表1-1展示了本文方法与其他基线方法的结果比较表1-2展示了模型的消融实验结果,可以得到以下观察结果:

1)相比于BERT+CISA和BERT+SCITE的优越性验证了双通道增强方法的有效性。

2)基于BERT的方法明显优于非BERT方法。这主要是因为预训练模型BERT是从大规模语料库中训练得到的,其中包含大量的先验知识,并且已经被证明适用于许多NLP任务。

3)事件因果抽取是事件抽取和因果关系识别的联合提取任务。两种基于BERT的方法只考虑事件的先验知识,但忽略了互联网上存在的大量因果知识对模型的影响。我们的方法通过知识增强通道和文本增强通道将先验知识和数据特征整合到模型中,提高了模型抽取因果事件的能力。

4)通过模块消融实验,证明了模型的所有部分对于 ECE 任务都是有用的。其中BERT 的贡献对模型的影响最大,这得益于其在大规模语料库中的预训练。

02

用于事件因果识别知识增强的提示学习

KEPT: Knowledge Enhanced Prompt Tuning for event causality identification(Knowledge-Based Systems,2023)

动机

本文专注于句子级事件因果关系识别任务。现有方法存在两个主要问题:(1)缺乏足够的因果推理能力,限制了对隐含因果关系的识别;(2)微调和预训练之间存在显著差距,影响了对预训练语言模型(PLMs)的利用。为解决以上问题,本文提出了一种利用提示学习(Prompt Tuning)整合外部知识库(KBs)中的背景知识和关联知识,用于因果推理的方法。

方法

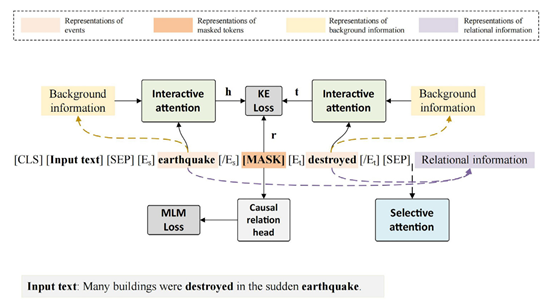

设计思路:本文提出了一种新的知识增强的提示学习(Prompt Tuning)框架。该框架首先根据事件对构建一个提示模板,然后从外部知识库获取背景信息和关系信息。紧接着,将输入文本、提示模板和关系信息拼接成一个序列,输入预训练语言模型生成上下文表示。最终,模型通过预测掩码位置上的答案词来输出因果关系结果。

图2-1 模型图

具体模型

1、提示构造

构建提示模板和答案词。给定earthquake和destroyed两个事件,提示模板设计如下:

![]()

其中 [Es],[/Es] 和 [Et],[/Et] 是分别指示源事件和目标事件边界的特殊指示词;[MASK] 表示预训练语言模型预测的掩码位置。本文利用在掩码位置预测是或否的概率来分别表示存在因关系或不存在因果关系的概率。

2、知识获取

(1)背景信息获取:给定一个句子中的事件对,模型首先从ConceptNet[1]中检索每个事件的相关三元组,然后将他们转化为文本描述,最终将这些描述组合形成事件的背景信息。

(2)关系信息获取:模型从ConceptNet中检索两个事件之间的路径作为关系路径,使用NetworkX工具包找到两个事件之间的最短路径,若存在多条则随机选择其中一条。然后,从关系路径中提取相关的三元组,并将它们转换为文本描述,最终将这些描述拼接形成事件对的关系信息。

3、编码模块

我们将输入文本xs、提示模板xt和关系信息xr拼接成输入序列,具体如下:

![]()

其中 [CLS] 和 [SEP] 是特殊占位符,⊕表示拼接操作,然后利用BERT对输入序列进行编码。

此外,采用另一个预训练的 BERT 模型对背景信息进行编码获取背景信息的表示,值得注意的是两个BERT模型参数共享。

4、知识注入

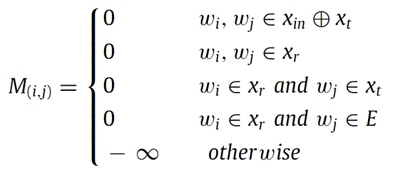

(1)选择性注意机制

为了减轻不相关知识的影响,本文设计了一种选择性注意机制,其中关系信息仅对模板和事件可见。注意掩码矩阵定义如下:

其中wi, wj是来自输入序列Xs的任意两个标记,0表示从令牌wi到令牌wj存在注意,−∞表示从令牌wi到令牌wj没有注意力,E表示来自输入文本的事件标记。

(2)交互式注意力机制:本文使用多头注意机制实现事件及其背景信息间的交互和融合。

5、因果关系表示

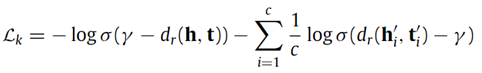

本文采用 TransE联合优化因果关系和事件的表示,以进一步捕获事件之间的隐式关系。其中,本模块定义了一个训练损失Lk,如下:

其中,σ(·)是sigmoid函数,(h′i, r, t′i) 代表负样本,γ是边界,dr(·)是评分函数。

6、模型训练和预测

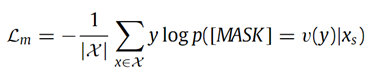

模型使用 [MASK] 的表示预测标签词,训练损失Lm,如下所示:

其中 X 是训练样本的集合,v(·) 是动词器,最终的损失如下:

其中 α 是权重系数。

实验

实验数据集:EventStoryLine (ESL)和Causal-TimeBank (CTB)

实验评价指标:P、R、F1

实验结果与结论

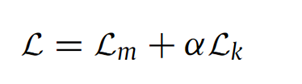

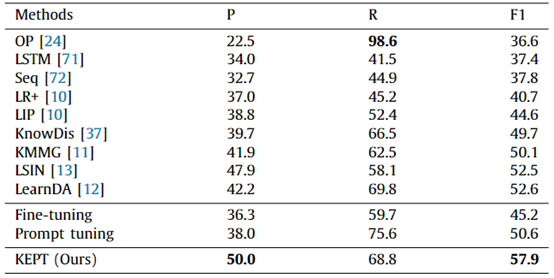

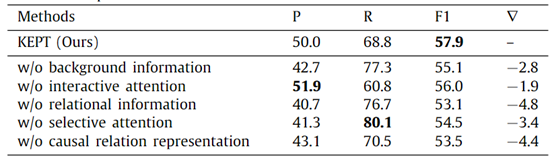

表2-1 ESL实验结果

表2-2 CTB实验结果

整体实验结果分析

1)本文所提的方法取得了最佳的F1,验证了方法的有效性;

2)相较于微调的方法,本文的模型有较大的提升,表明仅微调的方式并不足以解决ECI任务,同时验证了本文方法中提示调整和因果关系表示学习的有效性。

3)利用了BERT的方法表现优于未使用BERT的方法。这表明预训练语言模型具备较强的挖掘文本重要特征能力,同时本文的方法可以进一步提高BERT的因果推理能力,并为ECI任务引入丰富的外部知识。

4)本文的方法相较于仅提示学习方法的提升,证明了为事件引入背景信息和事件之间的关系信息对于ECI任务是有效的。

5)本文模型的结果远高于使用相同的外部知识库(KMMG和LSIN)的方法,这证明了本文将相关三元组转换为文本描述的方法可以充分利用外部知识,取得了更好的性能。

表2-3 ESL消融实验结果

消融实验结果分析

1)删除每个组件后性能都变差,这证明了模型的所有模块都是有效的。

2)在删除背景信息和交互式注意机制后性能下降,这说明背景信息可以为事件提供额外的背景知识,同时交互式注意机制可以促进事件与背景信息之间的交互,并使模型从外部知识中捕获重要特征。

3)删除关系信息后性能下降明显,可能的原因是关系信息包含有利于因果推理的事件之间的有用因果线索,而本文的模型可以充分利用ConceptNet中的因果线索,从而提高了模型的性能。

4)删除选择性注意机制时,模型性能下降,这表明关系信息的融合引入了噪音并改变了文本的文本含义,而选择性注意机制的引入可以减轻关系信息对输入文本的影响,并仅保留与因果推理相关的知识。

5)删除因果关系表示学习后,性能下降,表明知识表示学习可以有效优化因果关系的表示,并细化提示学习所预测的结果。

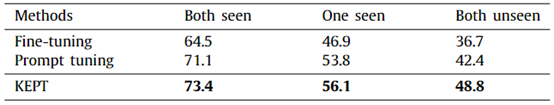

表2-4 ESL未见事件的实验结果

未见事件的影响

本文对EventStoryLine上的未见事件的模型性能进行评估,随机选择了1/3的文档构成训练集。依据训练集中的所有事件构建已见事件集。剩下的文档被分为三组:a.两个事件均出现在已见事件集;b.事件对中只有一个事件出现在已见事件集;c.两个事件均未出现在已见事件集。表2-4显示本文所提模型在三种测试集中均取得了最优结果,同时提示学习的结果优于微调,这说明提示学习可以挖掘预训练语言模型中的特定知识,而外部知识可以进一步提高模型的因果推理能力。

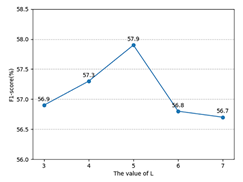

图2-2 ESL中不同最长关系路径长度下的性能

关系路径长度的影响

从图2-2中可以观察到,总体是先上升后下降的趋势,当最长关系路径设置为5时,模型达到了最佳性能。这可能是因为当关系路径大于5时,即表示两个事件关联性较低,将会包含大量无用信息。当最长关系路径小于5时,将导致许多事件对之间没有关系路径。

03

用于事件因果识别的显式和隐式知识增强模型

Explicit and implicit knowledge-enhanced model for event causality identification(Expert Systems With Applications,2024)

动机

本文专注于句子级事件因果关系识别任务。尽管现有工作大多侧重于上下文学习和外部知识整合,已有方法能够将隐式因果知识(如常识知识图等)或显式因果知识(如因果指示词等)整合到模型中,但尚未有工作能够同时融合显式和隐式因果知识。因此,本文提出了一种综合模型,能够将显式的因果指示词和隐式的因果知识与数据驱动模型相结合

方法

设计思路:整体模型如图3-1所示,首先通过BERT和BiLSTM对输入句子进行编码生成上下文感知词嵌入,然后分别输入数据驱动、显式因果指示词、隐式因果知识三个模块获取三种表示,最后拼接输入分类器。对于数据驱动模块,构建了一个事件对图,并采用关系图卷积网络(R-GCN)来学习事件对的表示。对于显式因果指示词模块,将因果指示词和卷积神经网络(CNN)结合起来挖掘文本中的因果线索。对于隐式因果知识模块,设计了一个因果匹配机制,并应用COMET[2]来捕获事件的隐式因果知识。

图3-1 模型图

具体模型

1、编码器

通过BERT和BiLSTM对原始句子进行编码,获取事件的表示。

2、数据驱动模块

依据输入句子,以事件对为节点构建一个无向事件对图,当两个事件对至少共享一个事件时进行连边,根据事件在原因和结果的位置设置不同的边类型,最后应用关系图卷积网络(R-GCN)学习新的事件表示。

3、显式因果指示词模块

从FrameNe[3]中获取包含因果信息的词汇单元形成因果指示词词汇表。基于因果指示词的词嵌入初始化CNN中的滤波器,一个因果指示词对应一个CNN滤波器,最后利用CNN为每个候选事件对生成语义表示。

4、隐式因果知识模块

对于事件对ei,ej, 本文利用COMET生成ei的可能结果和ej的潜在原因,采用余弦相似度设计了一种事件对的相似度计算方式,最后将最大相似度得分通过一个在训练过程中更新的可学习嵌入查找表映射成一个可学习的嵌入

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。