- 1植物大战僵尸杂交版2.088修改器+防闪退+高清补帧工具_植物大战僵尸2.088

- 2在 C# 中使用 MySQL 数据库进行连接和数据操作,连接 MySQL 数据库并进行添加、删除、替换、查找以及筛选。_怎么替换数据库的链接内容

- 3南开大学软件学院2023大三上期末考试各科回忆卷_南开大学软件学院研究生软件工程期末

- 4蓝桥杯【第14届国赛】Python B组_十四届蓝桥杯国赛pythonb组 偶串

- 5Linux安装Mysql(超详细,亲测)

- 6SparkSQL的3种Join实现_sparksql的三种join实现

- 7java安全——jsp一句话木马_java js一句话

- 8最全史上MySQL安装配置教程最细,一步一图解_mysql -uroot -p,华为远程视频面试经历_mysql安装教程

- 9字符串操作(strlen/strcpy/strcat/strcmp/strncpy/strncat/strncmp/strstr/strtok/strerror)_strtok,strcat

- 10安装Ubuntu18.04_ubuntu设置subnet

【机器学习】Voting集成学习算法:分类任务中的新利器_voting集成算法

赞

踩

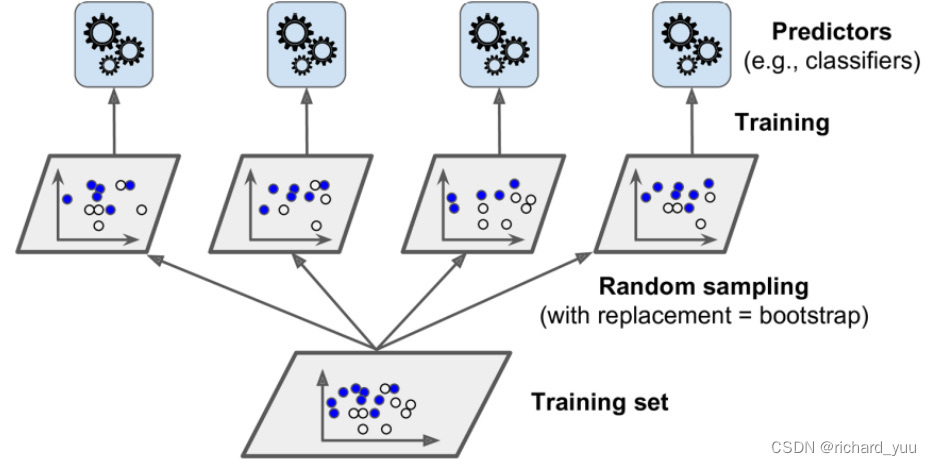

在机器学习领域,集成学习算法一直以其出色的性能提升能力而备受关注。其中,Voting集成学习算法以其简单高效的特点,在分类任务中脱颖而出。本文将详细探讨Voting集成学习算法的基本原理、应用场景,并通过实例和代码展示其在实际任务中的应用效果。

一、Voting集成学习算法概述

Voting集成学习算法的基本思想是通过将多个分类器的预测结果进行汇总,从而得出一个更加准确的分类结果。这一思想充分利用了不同分类器在特征提取和分类决策上的优势,实现了模型之间的互补和性能的提升。Voting算法不仅可以提高整体分类的准确率,还可以降低单一模型可能存在的过拟合或欠拟合风险。

二、Voting算法的分类方式

Voting算法主要分为硬投票和软投票两种方式。硬投票方式下,每个分类器只输出一个最可能的类别标签,然后根据这些标签进行投票,票数最多的类别即为最终分类结果。这种方式简单易行,但可能忽略了分类器对于不同类别的置信度信息。

相比之下,软投票方式则更为灵活和准确。在软投票中,分类器会输出每个类别的概率或置信度,然后按照这些概率或置信度进行加权投票。这种方式能够充分利用分类器对于不同类别的判断信息,从而得到更加准确的分类结果。

三、Voting算法在图像识别中的应用

以图像识别为例,我们可以使用多个不同的卷积神经网络模型进行训练,并通过Voting算法将它们的预测结果进行集成。每个卷积神经网络模型都可以从图像中提取出不同的特征信息,通过Voting算法将这些特征信息进行融合,可以显著提高图像识别的准确率。

下面是一个简单的Python代码示例,展示了如何使用scikit-learn库中的VotingClassifier实现Voting集成学习算法:

python from sklearn.datasets import load_digits from sklearn.model_selection import train_test_split from sklearn.linear_model import LogisticRegression from sklearn.svm import SVC from sklearn.ensemble import VotingClassifier from sklearn.metrics import accuracy_score # 加载数据集 digits = load_digits() X, y = digits.data, digits.target # 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 定义并训练模型 clf1 = LogisticRegression(random_state=1) clf2 = SVC(gamma=2, C=1, random_state=42) clf3 = SVC(gamma=2, C=10, random_state=42) eclf = VotingClassifier(estimators=[('lr', clf1), ('svc1', clf2), ('svc2', clf3)], voting='soft') for clf, label in zip([clf1, clf2, clf3, eclf], ['Logistic Regression', 'SVC 1', 'SVC 2', 'Ensemble']): scores = cross_val_score(clf, X, y, scoring='accuracy', cv=5) print("Accuracy: %0.2f (+/- %0.2f) [%s]" % (scores.mean(), scores.std(), label)) # 训练集成模型 eclf.fit(X_train, y_train) # 在测试集上进行预测 y_pred = eclf.predict(X_test) # 计算并输出准确率 accuracy = accuracy_score(y_test, y_pred) print("Ensemble Voting Classifier Accuracy: ", accuracy)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

在上面的代码中,我们使用了逻辑回归和两种不同参数的支持向量机作为基分类器,通过VotingClassifier将它们集成在一起。通过比较各个基分类器和集成模型的交叉验证准确率,我们可以看到集成模型在性能上有了显著的提升。

四、结论与展望

Voting集成学习算法通过结合多个模型的预测结果,提高了分类任务的准确率,降低了过拟合和欠拟合的风险。在图像识别、文本分类等任务中,Voting算法展现出了强大的应用潜力。随着机器学习技术的不断发展,Voting集成学习算法将会在更多领域得到应用和优化,为数据分析和模式识别提供更为准确和高效的解决方案。