热门标签

热门文章

- 1深入解析PHP函数

- 2一文彻底搞懂OSI七层模型和TCP/IP四层模型_osi网络协议

- 3优秀的 Verilog/FPGA开源项目介绍(三)- 大厂的项目_opentitan是什么

- 4.net8 blazor auto模式很爽(三)用.net8的Blazor自动模式测试,到底在运行server还是WebAssembly_blazor auto项目刷新后注入的service会失效

- 5RabbitMQ的五种工作模式和使用场景_rabbitmq五种消息模型及应用场景

- 6如何用python画长方形_python怎么画矩形

- 7信息管理系统三级等保的一些要求_三级等保对网站系统有什么要求

- 8通过C语言实现三种版本的快速排序

- 9PyTorch Mobile在端侧可堪大用?能否与TensorFlow Lite一较高下_pytorch lite flutter

- 10python中的 list (列表)append()方法 与extend()方法的用法 和 区别

当前位置: article > 正文

NLP-RNN_rnn与nlp

作者:代码探险家 | 2024-06-28 08:44:53

赞

踩

rnn与nlp

一、RNN引出

卷积神经网络 (CNN) 和普通的算法大部分都是输入和输出的一一对应,也就是一个输入得到一个输出。不同的输入之间是没有联系的。

但是在某些场景中,一个输入就不够了!为了填好下面的空,取前面任何一个词都不合适,我们不但需要知道前面所有的词,还需要知道词之间的顺序。

这种需要处理「序列数据 – 一串相互依赖的数据流」的场景就需要使用 RNN 来解决了。

二、RNN结构

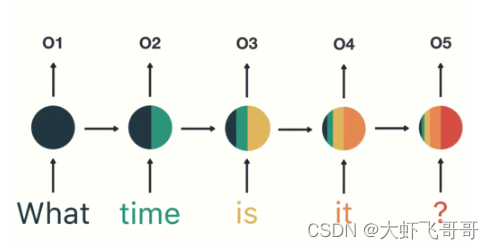

传统神经网络的结构比较简单:输入层 – 隐藏层 – 输出层。每一个时间步都会接收上一个时间步的隐层状态输入,如下图所示:

我们按照顺序,将“time”输入到 RNN 网络,得到输出「02」。这个过程我们可以看到,输入 “time” 的时候,前面 “what” 的输出也产生了影响(隐藏层中有一半是黑色的),因此 RNN 可以处理序列问题。

RNN多个时间步展如下:

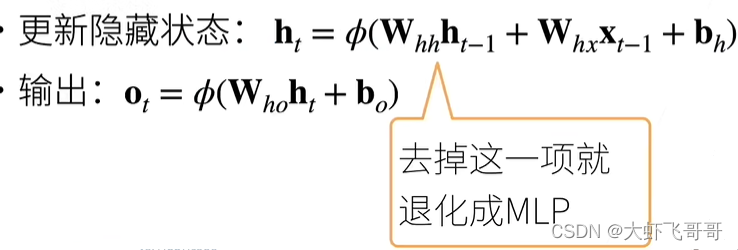

计算公式:

RNN 的缺点:

通过隐藏层中的颜色分布可以看出短期的记忆影响较大(如橙色区域),但是长期的记忆影响就很小(如黑色和绿色区域),这就是 RNN 存在的短期记忆问题,无法处理很长的输入序列,并且训练 RNN 需要投入极大的成本。

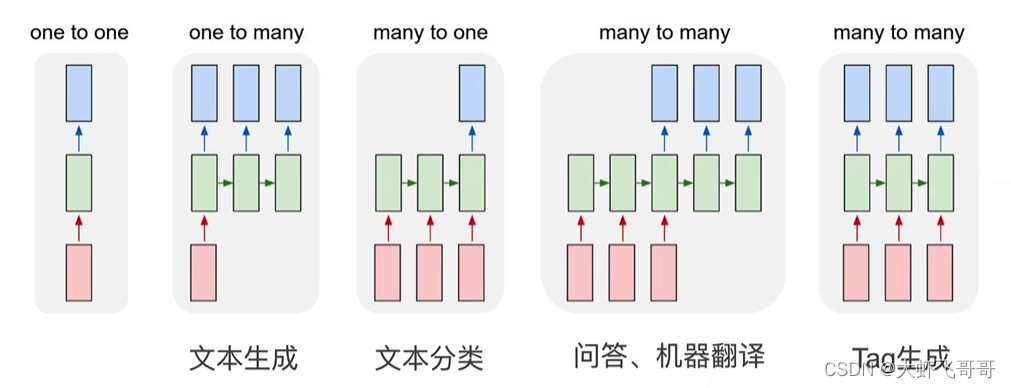

三、RNN 应用

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/代码探险家/article/detail/765444

推荐阅读

相关标签