- 1Springboot事务的7种传播行为_springboot事务传播行为

- 2数据结构和算法概述_og希冀平台数据结构与算法

- 3博弈树 极小极大分析法_极大极小分析法

- 4JSP眼镜销售系统购物系统jsp购物系统购物商城系统源码(jsp电子商务系统)网上眼镜在线销售_眼镜商城前端源码

- 5高效工作|Raycast一款可以取代Spotlight的快捷启动器_raycast中文版

- 6【云开发】小程序端操作数据库详解_小程序数据库

- 7vue项目依赖安装报错:Error: pngquant failed to build, make sure that libpng-dev is installed

- 8react-native 调用Settings.Secure.getstring获取了android_id / app上架违规获取android_id被拒_com.learnium.rndevicelnfo.rndevicemodule.getunique

- 9项目管理电子书_电子书丨决胜B端:产品经理升级之路

- 10修改Spark的日志级别_spark standolne 任务设置日志级别

Transformer详解_transformer的输入

赞

踩

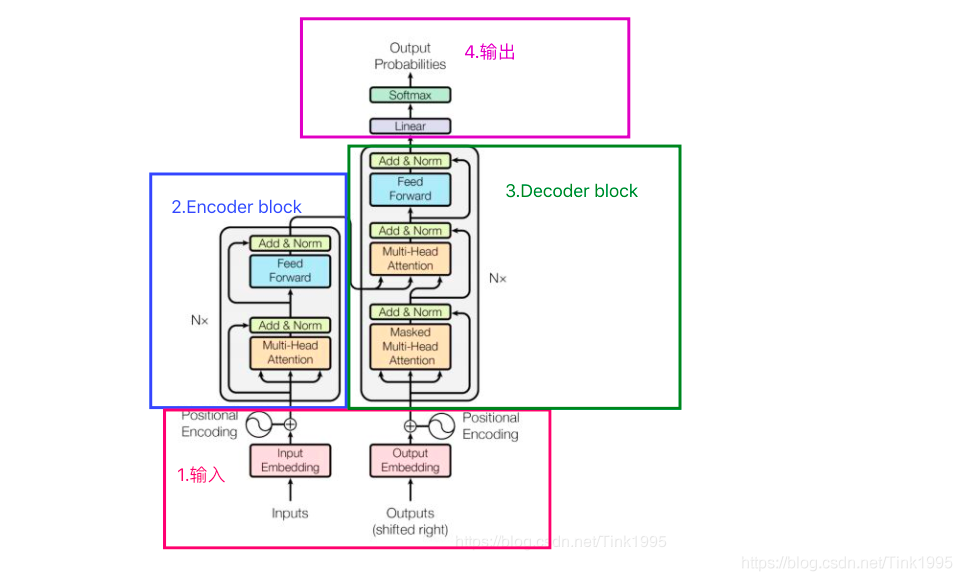

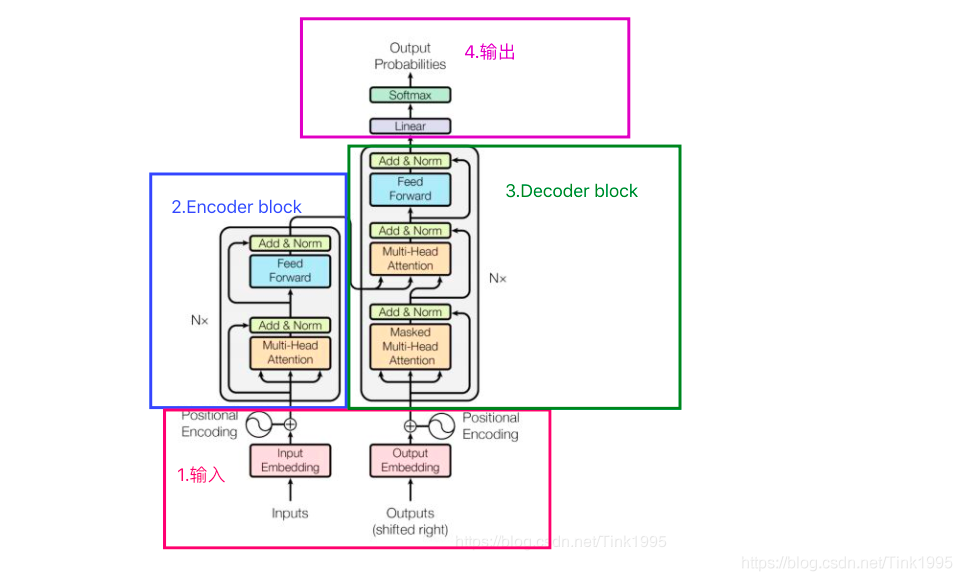

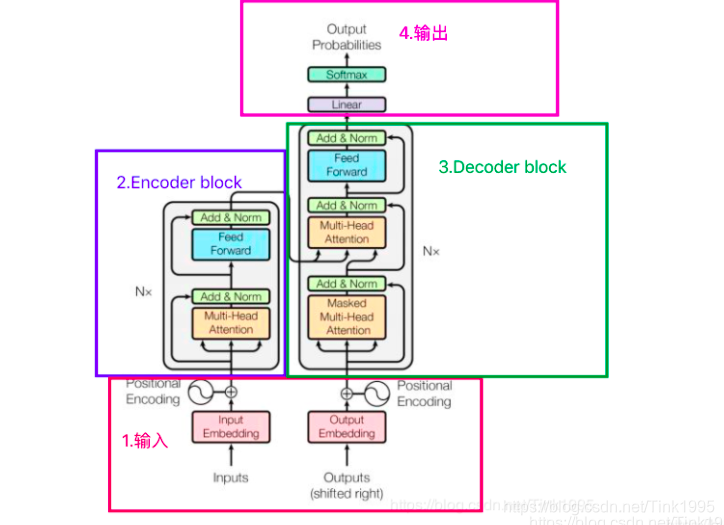

Transformer 原理

Transformer整体结构

Transformer是一个基于Encoder-Decoder框架的模型。

1.Transformer的inputs 输入

Transformer输入是一个序列数据。

Tokenizer:将单词转换为标记。

Embedding:将标记转换为多维向量。

Embedding是将文本转换为数字的桥梁,文本Embedding将每一段文本转换成一个数字向量(一个列表)。如果两段文本相似,那么它们对应向量中的数字应该也是彼此相似的。

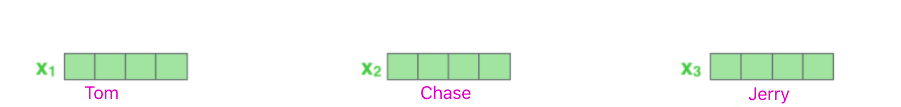

以"Tom chase Jerry" 翻译成中文"汤姆追逐杰瑞"为例:

假设上图中每一个词向量都是一个512维的词向量。

通过Embedding技术,我们将句子中的每个单词都转换成了向量,下一步就是将所有这些向量都变成一个向量来处理。将一堆向量变成一个向量的最常见方法就是进行分量相加。对于含有相同词的两个句子,词的排列顺序不一样,这两句话的意思也是不同的。Transformer 的是完全基于self-Attention,而self-attention是不能获取词语位置信息地,就算打乱一句话中词语的位置,每个词还是能与其他词之间计算attention值。因此,我们采用位置编码(Positional encoding),为这两个句子提供不同的向量。

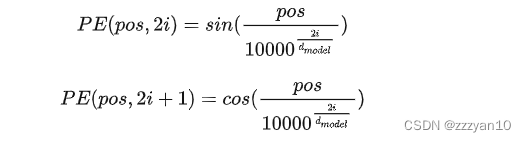

positional encoding 的获取:

1.可以通过数据训练学习得到positional encoding,类似于训练学习词向量,bert中的positional encoding便是由训练得到地。

2.《Attention Is All You Need》论文中Transformer使用的是正余弦位置编码。位置编码通过使用不同频率的正弦、余弦函数生成,然后和对应的位置的词向量相加,位置向量维度必须和词向量的维度一致。

pos表示单词在句子中的绝对位置,pos=0,1,2…,例如:Jerry在"Tom chase Jerry"中的pos=2;dmodel表示词向量的维度,在这里dmodel=512;2i和2i+1表示奇偶性,i表示词向量中的第几维,例如这里dmodel=512,故i=0,1,2…255。

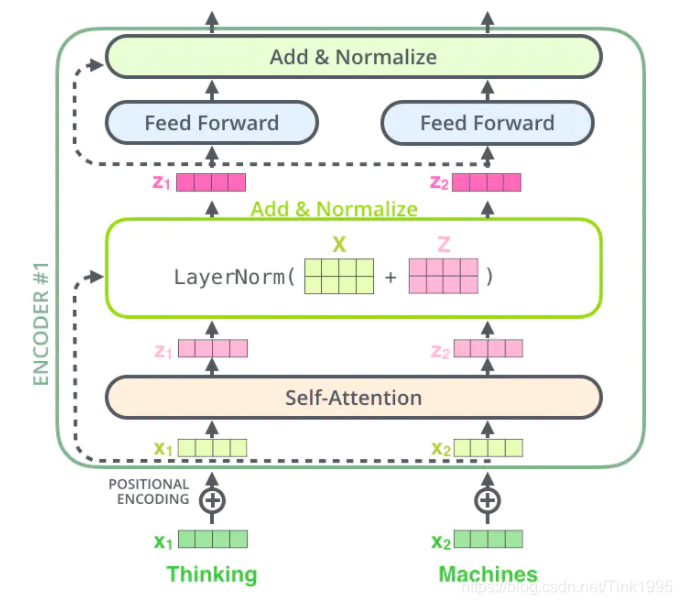

2.Transformer的Encoder

Encoder block是由6个encoder堆叠而成,Nx=6。上图2中的灰框部分就是一个encoder的内部结构,从图中我们可以看出一个encoder由Multi-Head Attention 和 全连接神经网络Feed Forward Network构成。

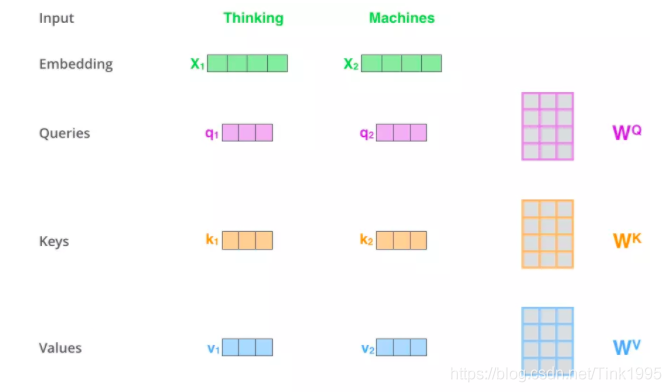

self-attention,假如输入序列是"Thinking Machines",x1,x2就是对应地"Thinking"和"Machines"添加过位置编码之后的词向量,然后词向量通过三个权值矩阵,转变成为计算Attention值所需的Query,Keys,Values向量。

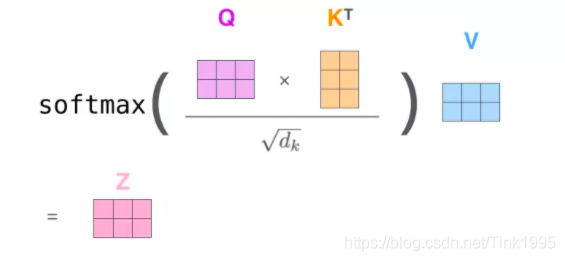

得到Q,K,V之后,接下来就是计算Attention值了。

步骤1:输入序列中每个单词之间的相关性得分,上篇中说过计算相关性得分可以使用点积法,就是用Q中每一个向量与K中每一个向量计算点积,具体到矩阵的形式:,socre是一个(2,2)的矩阵。

步骤2:对于输入序列中每个单词之间的相关性得分进行归一化,归一化的目的主要是为了训练时梯度能够稳定。,dk就是K的维度,以上面假设为例,dk=64

步骤3:通过softmax函数,将每个单词之间的得分向量转换成[0,1]之间的概率分布,同时更加凸显单词之间的关系。经过softmax后,score转换成一个值分布在[0,1]之间的(2,2)α概率分布矩阵

步骤4:根据每个单词之间的概率分布,然后乘上对应的Values值,α与V进行点积,,V的为维度是(2,64),(2,2)x(2,64)最后得到的Z是(2,64)维的矩阵。

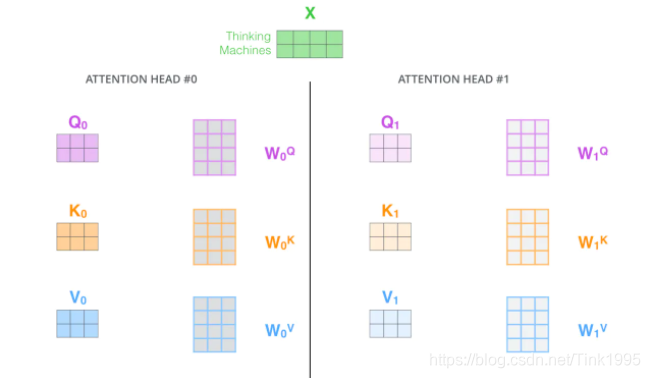

Multi-Head Attention:

Multi-Head Attention 很简单,就是在self-attention的基础上,对于输入的embedding矩阵,self-attention只使用了一组 来进行变换得到Query,Keys,Values。而Multi-Head Attention使用多组

得到多组Query,Keys,Values,然后每组分别计算得到一个Z矩阵,最后将得到的多个Z矩阵进行拼接。Transformer里面是使用了8组不同的

。

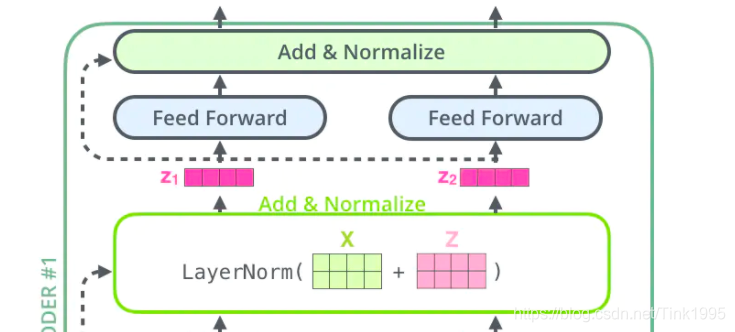

从上图中可以看到,在经过Multi-Head Attention得到矩阵Z之后,并没有直接传入全连接神经网络FNN,而是经过了一步:Add&Normalize。

Add(ResNet 残差神经网络)

Add,就是在Z的基础上加了一个残差块X,加入残差块X的目的是为了防止在深度神经网络训练中发生退化问题,退化的意思就是深度神经网络通过增加网络的层数,Loss逐渐减小,然后趋于稳定达到饱和,然后再继续增加网络层数,Loss反而增大。

Normalize(LN)

1.能够加快训练的速度。

2.提高训练的稳定性。

Feed-Forward Networks

这里的全连接层是一个两层的神经网络,先线性变换,然后ReLU非线性,再线性变换。

FFN 相当于将每个位置的Attention结果映射到一个更大维度的特征空间,然后使用ReLU引入非线性进行筛选,最后恢复回原始维度。

3.Transformer的Decoder

Transformer Decoder的输入

Decoder的输入分为两类:

一种是训练时的输入,一种是预测时的输入。训练时的输入就是已经对准备好对应的target数据。例如翻译任务,Encoder输入"Tom chase Jerry",Decoder输入"汤姆追逐杰瑞"。预测时的输入,一开始输入的是起始符,然后每次输入是上一时刻Transformer的输出。例如,输入"",输出"汤姆",输入"汤姆",输出"汤姆追逐",输入"汤姆追逐",输出"汤姆追逐杰瑞",输入"汤姆追逐杰瑞",输出"汤姆追逐杰瑞"结束。

Masked Multi-Head Attention

与Encoder的Multi-Head Attention计算原理一样,只是多加了一个mask码。mask 表示掩码,它对某些值进行掩盖,使其在参数更新时不产生效果。Transformer 模型里面涉及两种 mask,分别是 padding mask 和 sequence mask。

1.padding mask

每个批次输入序列长度是不一样的,我们要对输入序列进行对齐。具体来说,就是给在较短的序列后面填充 0。但是如果输入的序列太长,则是截取左边的内容,把多余的直接舍弃。因为这些填充的位置,其实是没什么意义的,所以我们的attention机制不应该把注意力放在这些位置上,所以我们需要进行一些处理。

具体的做法是,把这些位置的值加上一个非常大的负数(负无穷),这样的话,经过 softmax,这些位置的概率就会接近0!

2.sequence mask

sequence mask 是为了使得 decoder 不能看见未来的信息。对于一个序列,在 time_step 为 t 的时刻,我们的解码输出应该只能依赖于 t 时刻之前的输出,而不能依赖 t 之后的输出。因此我们需要想一个办法,把 t 之后的信息给隐藏起来。这在训练的时候有效,因为训练的时候每次我们是将target数据完整输入进decoder中地,预测时不需要,预测的时候我们只能得到前一时刻预测出的输出。

基于Encoder-Decoder 的Multi-Head Attention

Encoder中的Multi-Head Attention是基于Self-Attention地,Decoder中的第二个Multi-Head Attention就只是基于Attention,它的输入Quer来自于Masked Multi-Head Attention的输出,Keys和Values来自于Encoder中最后一层的输出。

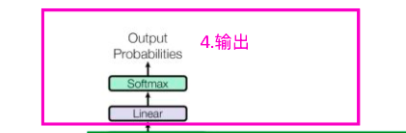

4.Transformer的输出

Output如图中所示,首先经过一次线性变换,然后Softmax得到输出的概率分布,然后通过词典,输出概率最大的对应的单词作为我们的预测输出。