- 1springboot web创建失败,解决Could not find artifact org.springframework.boot:spring-boot-starter-parent:pom

- 2从IT主管到CIO成长之路(2万字)

- 3JSON parse error: Cannot deserialize instance of `java.util.ArrayList` out of START_OBJECT token; ne

- 4ChatGPT使用案例之自然语言处理_chatgpt在自然语言处理中的应用

- 5[附源码]JAVA毕业设计高校校园社交网络(系统+LW)_javaweb校园社交系统

- 6SAP MB52改为ALV显示格式_sap mb52 alv

- 7Android 创建桌面组件Widget——构建应用微件(二)_android 10 自定义widget

- 8零基础学FPGA(六):FPGA时钟架构(Xilinx为例,完整解读)_fpga中的全局时钟

- 9hadoop启动缺少NameNode, 缺少ResourceManager, 缺少NodeManager_hadoop没有namenode

- 10Flutter运行MacOs网络请求报错Unhandled Exception: DioException [connection error]:...

kafka ack hw isr 记录_kafka ack和hw

赞

踩

Kafka 选择了第二种方案,原因如下:

1.同样为了容忍 n 台节点的故障,第一种方案需要 2n+1 个副本,而第二种方案只需要 n+1

个副本,而 Kafka 的每个分区都有大量的数据,第一种方案会造成大量数据的冗余。

2.虽然第二种方案的网络延迟会比较高,但网络延迟对 Kafka 的影响较小

2)ISR(保证数据的可靠性,leader 挂掉后从follower中选取leader)

采用第二种方案之后,设想以下情景:leader 收到数据,所有 follower 都开始同步数据,但有一个 follower,因为某种故障,迟迟不能与 leader 进行同步,那 leader 就要一直等下去,直到它完成同步,才能发送 ack。这个问题怎么解决呢?Leader 维护了一个动态的 in-sync replica set (ISR),意为和 leader 保持同步的 follower 集合。当 ISR 中的 follower 完成数据的同步之后,

leader 就会给 follower 发送 ack。如果 follower长时间 未 向 leader 同 步 数 据 , 则 该 follower 将 被 踢 出 ISR , 该 时 间 阈 值 由replica.lag.time.max.ms 参数设定。Leader 发生故障之后,就会从 ISR 中选举新的 leader。

0.9 之前进入ISR 机制

两个指标 1. follower 条数与leader 条数差距小的, 2:是时间 与kafka leader 交互时间快的follower

0.9之后:

只保留了一个指标就是时间,干掉了了第一个指标

移除原因(条数限定指标名称(0.9之前):replica.lag.max.messages:超过就移除isr):

首先ISR 维护在内存中, 同时ZK中也会维护一分,数据来源是kafka写入到ZK中,假设replica.lag.max.messages限定值是10条, 客户端每次批量提交12条那么所有的follower 与leader 之前的差距都大于设定值, 此时所有的follower 都将移除,同时会操作zk中的数据,与客户端不可能只操作一次,所有 就会导致ISR 频繁的移除,添加与操作ZK

3)ack 应答机制

对于某些不太重要的数据,对数据的可靠性要求不是很高,能够容忍数据的少量丢失所以没必要等 ISR 中的 follower 全部接收成功。

所以 Kafka 为用户提供了三种可靠性级别,用户根据对可靠性和延迟的要求进行权衡选择以下的配置。

acks 参数配置:

acks:

0:producer 不等待 broker 的 ack,这一操作提供了一个最低的延迟,broker 一接收到还没有写入磁盘就已经返回,当 broker 故障时有可能丢失数据;

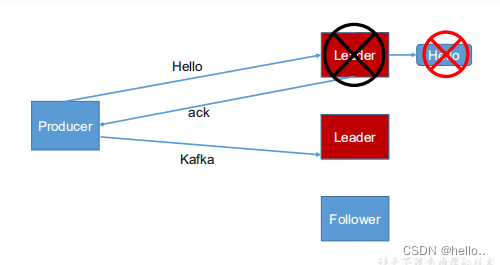

1:producer 等待 broker 的 ack,partition 的 leader 落盘成功后返回 ack,如果在 followe同步成功之前 leader 故障,那么将会丢失数据;

leader 挂掉 副本还没同步完成

-1(all):producer 等待 broker 的 ack,partition 的 leader 和 follower (ISR中)全部落盘成功后才返回 ack。但是如果在 follower 同步完成后,broker 发送 ack 之前,leader 发生故障,那么会造成数据重复。

重复数据(所有的leader ,follower 同步完成但是还没有发送ack 此时重新选择了一个leader 客户端重新发送一分数据,导致数据重复)

极限情况也有可能丢数据,比如 有个1leader 2个follower,但是follower 同步数据很慢不在ISR中,ISR中只有一个leader , 此时-1 就退化成1, leader 同步完成就会返回ack,

故常处理:

LEO:指的是每个副本最大的 offset;

HW:指的是消费者能见到的最大的 offset,ISR 队列中最小的 LEO。

(1)follower 故障follower 发生故障后会被临时踢出 ISR,待该 follower 恢复后,follower 会读取本地磁盘记录的上次的 HW,并将 log 文件高于 HW 的部分截取掉,从 HW 开始向 leader 进行同步。等该 follower 的 LEO 大于等于该 Partition 的 HW,即 follower 追上 leader 之后,就可以重新加入 ISR 了。

(2)leader 故障leader 发生故障之后,会从 ISR 中选出一个新的 leader,之后,为保证多个副本之间的 数据一致性,其余的 follower 会先将各自的 log 文件高于 HW 的部分截掉,然后从新的 leader同步数据。

注意:这只能保证副本之间的数据一致性,并不能保证数据不丢失或者不重复。

3 Exactly Once 语义

将服务器的 ACK 级别设置为-1,可以保证 Producer 到 Server 之间不会丢失数据,即 At

Least Once 语义。相对的,将服务器 ACK 级别设置为 0,可以保证生产者每条消息只会被

发送一次,即 At Most Once 语义。

At Least Once 可以保证数据不丢失,但是不能保证数据不重复;相对的,At Least Once

可以保证数据不重复,但是不能保证数据不丢失。但是,对于一些非常重要的信息,比如说

交易数据,下游数据消费者要求数据既不重复也不丢失,即 Exactly Once 语义。在 0.11 版

本以前的 Kafka,对此是无能为力的,只能保证数据不丢失,再在下游消费者对数据做全局

去重。对于多个下游应用的情况,每个都需要单独做全局去重,这就对性能造成了很大影响。

0.11 版本的 Kafka,引入了一项重大特性:幂等性。所谓的幂等性就是指 Producer 不论

向 Server 发送多少次重复数据,Server 端都只会持久化一条。幂等性结合 At Least Once 语

义,就构成了 Kafka 的 Exactly Once 语义。即:

At Least Once + 幂等性 = Exactly Once

要启用幂等性,只需要将 Producer 的参数中 enable.idompotence 设置为 true 即可。Kafka

的幂等性实现其实就是将原来下游需要做的去重放在了数据上游。开启幂等性的 Producer 在

初始化的时候会被分配一个 PID,发往同一 Partition 的消息会附带 Sequence Number。而

Broker 端会对<PID, Partition, SeqNumber>做缓存,当具有相同主键的消息提交时,Broker 只

会持久化一条。

但是 PID 重启就会变化,同时不同的 Partition 也具有不同主键,所以幂等性无法保证跨

分区跨会话的 Exactly Once。