- 1MySQL有哪些索引?_mysql索引有哪几种

- 2安装GPT 学术优化 (GPT Academic)@FreeBSD

- 3npm 常用命令详解

- 4卷积神经网络-批量归一化_批量归一化卷积神经网络

- 5【无标题】_outreg2安装显示connect

- 6unordered_map、unordered_set底层哈希表的实现机理_c++ unordered_map 底层实现

- 7Unity鼠标移动到物体上显示信息

- 82024最新计算机设计大赛选题推荐_中国大学生计算机设计大赛 赛题

- 9本地已安装Git。 但是VSCode提示:未找到 Git。点击Git侧边栏选项,按钮都是灰的_vscode没有git

- 102024网络安全(黑客)如何学习

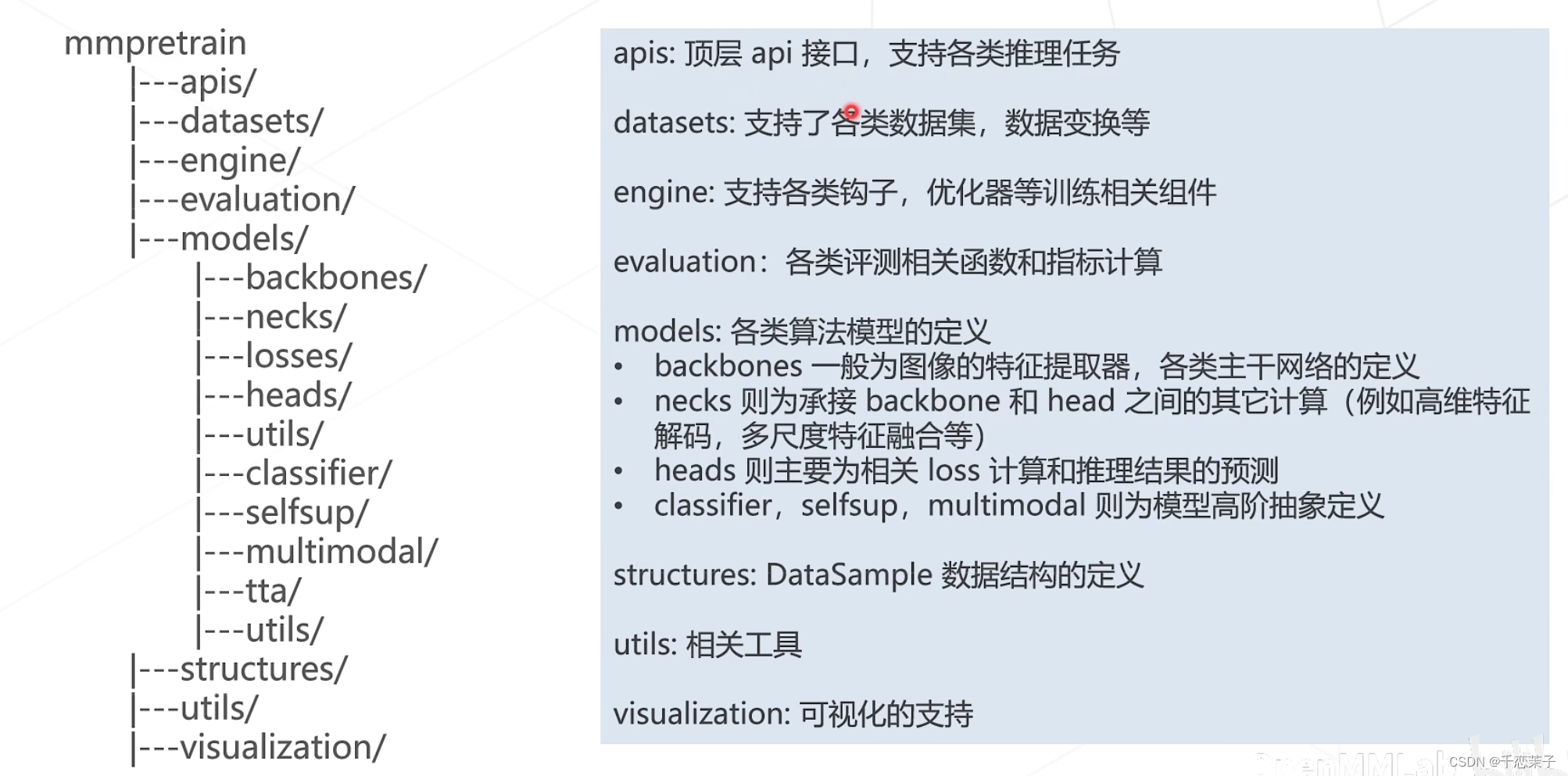

mmpretrain库理论叙述

赞

踩

以下部分比较熟悉,将会被少量摘录:

- 算法库与任务组成框架概览

- ResNet

- Vision Transformer

以下部分不够熟悉,我会多摘录些:

- 自监督学习:

SimCLR

MAE

- 多模态算法:

CLIP

BLIP

mmpretrain来自于mmcls和mmselfsup,新增了多模态部分的适配。

仓库内置如下功能性工具:

大量预置配置文件、预训练模型

Python 推理API

模型训练工具

模型参数计算

CAM 可解释性分析

各类可视化工具

部署工具 (配合MMDeploy)

mmpretrain主要处理以下任务:图像分类(lmage Classification)、图像描述(lmage Caption)、视觉问答(Visual Question Answering)、视觉定位 (Visual Grounding)、检索(Retrieval,lmage-To-lmage, Text-To-lmage,lmage-To-Text)。

pipeline设计:

model右侧部分,蓝色箭头(上半块)是训练流程,绿色箭头(下半块)是推理流程。

自监督学习:

基于掩码学习:mask掉image中的部分patch,通过剩余的特征进行重建;

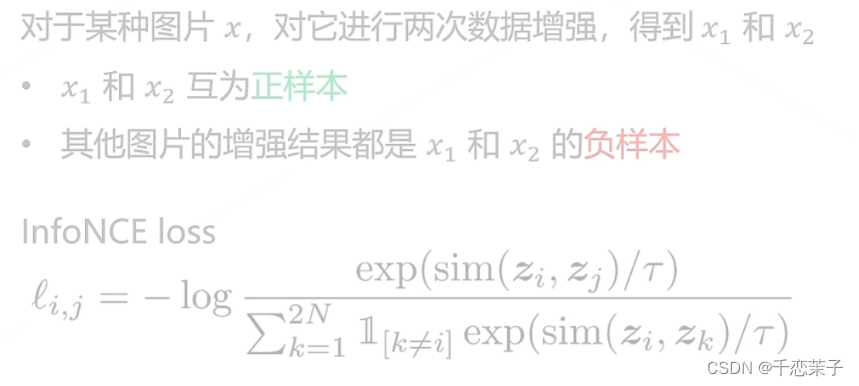

基于对比学习,SimCLR(ICML 2020):

基本假设:如果模型能很好地提取图片内容的本质,那么无论图片经过什么样的数据增强操作,提取出来的特征都应该极为相似。

loss意义:拉进正样本的特征距离,拉远负样本的特征距离。

基于掩码,Masked Autoencoders (MAE,CVPR 2022)

基本假设:模型只有理解图片内容、掌握图片的上下文信息,才能恢复出图片中被随机遮挡的内容。

iBOT,DINOv2期望结合基于掩码与基于对比的自监督学习。

老师对DINOv2有着很高的评价,非常值得看这篇论文。

多模态算法:

经典之作:CLIP

拉进正样本文本对(eg. I_1 & T_1),推远负样本文本对(eg. I_3 & T_N),以此来完成文本侧和图像侧结合后的特征表达优化。

BLIP(ICML2022)

BLIP: Bootstrapping Language-lmage Pre-training for Unified Vision-Language Understanding and Generation

BLIP对三种loss进行了结合,以此构建了新的vision language pre-training框架;

还有以下多模态算法推荐阅读:BLIP-2,Flamingo,Kosmos-1,LLaVA,