热门标签

热门文章

- 1直播预告 | ChatGPT会引领AI新范式吗?

- 2【DevPress】帮助客户在CSDN社区之上,建立完全自主可控的开发者社区

- 3PostgreSQL【部署 01】离线安装PostgreSQL+PostGIS踩坑及问题解决经验分享(含安装文件PostgreSQL+PostGIS及多个依赖+测试SQL)_pg离线安装debug

- 4Apusic下java.lang.OutOfMemoryError:PermGen space_如何修改apusic应用服务器的启动内存-csdn技术社区

- 5ELF 1技术贴|如何在Ubuntu上配置Samba服务器

- 6AI论文速读 | 2024[WWW]不只是路线:联合 GPS 和路线建模的轨迹表示学习

- 7Hadoop&Hive&Spark的本地安装全流程与踩坑实录_hadoop tsinghua

- 8Spring Boot+Flink CDC —— MySQL 同步 Elasticsearch (Table API方式)_flink cdc table api

- 9如何选择合适版本的Python?_python如何选择版本

- 10使用zookeeper作为分布式节点的配置中心

当前位置: article > 正文

卷积通用模型的剪枝、蒸馏---蒸馏篇--KD蒸馏(以deeplabv3+为例)

作者:你好赵伟 | 2024-05-05 19:15:13

赞

踩

卷积通用模型的剪枝、蒸馏---蒸馏篇--KD蒸馏(以deeplabv3+为例)

上篇文章介绍了剪枝篇,本文以上篇的剪枝模型为学生模型,以剪枝之前的模型为教师模型,进行KD逻辑蒸馏,之后会尝试特征蒸馏和关系蒸馏等。

一、KD逻辑蒸馏

1.1 大致过程

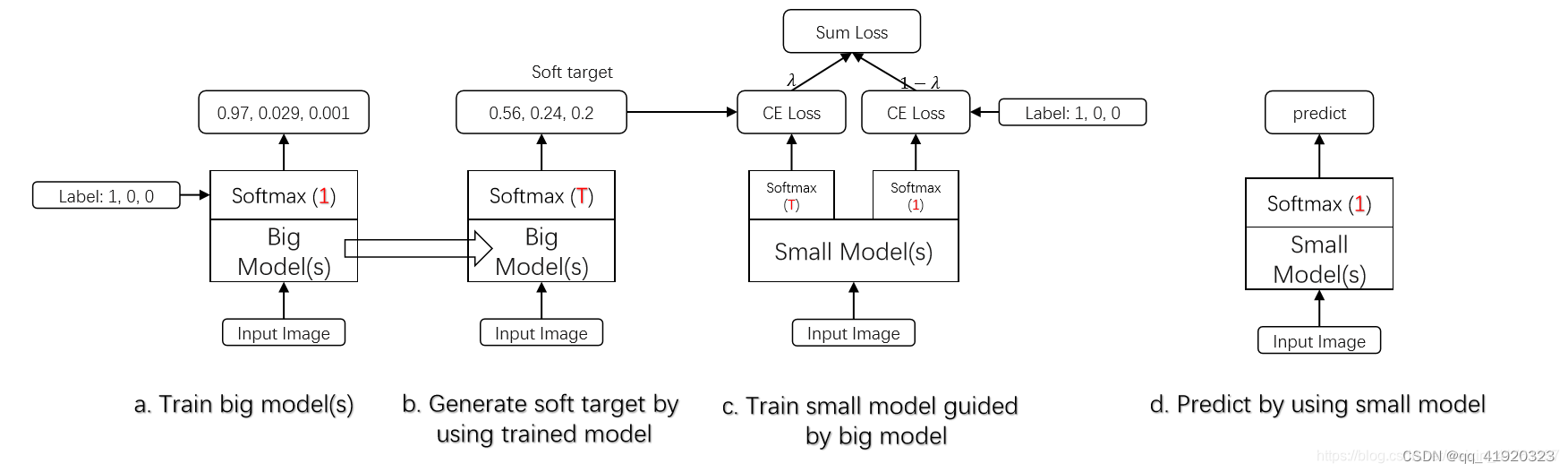

逻辑蒸馏,是基于分类问题设计的,因此非常适用于语义分割。模型最后会有一个softmax层,其输出值对应了相应类别的概率值。在知识蒸馏时,已经有了一个泛化能力较强的Teacher模型,我们在利用Teacher模型来蒸馏训练Student模型时,可以直接让Student模型去学习Teacher模型的泛化能力。一个很直白且高效的迁移泛化能力的方法就是:使用softmax层输出的类别的概率来作为“Soft-target”,对比Student模型的输出逐渐的向Teature模型靠近。

1.2 Softmax

关于分类问题,就会想到softmax(一个向量中的每一个分量先求指数,然后求所有分量指数分和,指数/和得到一个新的分量,组成新的向量,和为1),蒸馏中的softmax也是这样的处理思路,只是加了一个温度指数T,将e的指数再除以T;

1.3 蒸馏过程

step1、首先训练大模型(a),softmax(1),得到一个输出(0.97,0.029,0.001);

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/540403

推荐阅读

相关标签