- 1给定一个非空的整数数组,返回其中出现频率前 k 高的元素。(PHP)_给定一个非空的整数数组,请编程返回其中出现频率前k高的元素

- 2华为OD机试Java - 根据IP查找城市_某业务需要根据终端的ip地址获取该终端归属的城市,可以根据公开的ip地址池信息查

- 3算术运算符++和--的用法

- 4AI自然语言处理NLP原理与Python实战:50. NLP实战项目总结与展望_nlp ai

- 5linux 为普通用户配置sudo权限_修改普通用户权限

- 6程序员的吐槽大会,动机何在?_技术部门吐槽大会

- 7C++架构之美:设计卓越应用_c++ 开发架构

- 8The element or ID supplied is not valid. (videojs) elementui

- 9如何给开源项目做贡献?_博士开源社区做贡献有用吗

- 10模式识别判断题

点云方向论文阅读笔记(5)_点云偏移注意力的特征纬度

赞

踩

笔记(1)中是关于点云配准方向的,(2)和(3)(4)(5)中是点云变化检测和点云分割的,实际上我认为这两种任务的差别不大。都是密集的分类任务,主要是在变化检测中的双时相输入如何好的融合以及融合后映射到特征空间中。由于点云变化检测的论文较少,中间也看了不少的图像变化检测的论文。

CBL-2022-CVPR

Tang_Contrastive_Boundary_Learning_for_Point_Cloud_Segmentation_CVPR_2022_paper

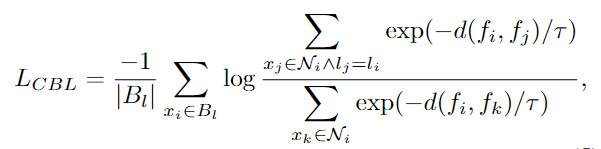

本文提出的是一种专注于边缘分割的损失函数。主要思想就是在所有的边界点执行CBL损失函数——拉进同类边界点的特征距离,拉远不同类边界点的特征距离。通过在不同尺度上的采样点的特征中执行CBL进行边缘分割的优化。损失函数的具体内容如下:

子采样后的边界点的标签由原始点中在该点覆盖区域的各类点的数量取最大值决定。

将该损失函数及架构用在不同的分割网络当中。

实验方法

数据集

室内场景(S3DIS、ScanNet)、室外场景(Semantic3D、NPM3D)

评价指标

mIoU,mIoU@boundary,mIoU@inner、B-IoU

问题介绍

下表是在常规的一些分割方法中的指标

可以看到相比于内点的mIoU,边界点是低很多的,从提出的边界点指标B-IoU也能够看出这一事实。而在使用的三个基本架构中加上了CBL后,能够看到一个明显的提升,这种提升不仅只改善边界点,在内点以及整体情况上同样有所改善。而相比于内点来说,边界点大大幅度改善也证明了并不是损失函数的约束改善了整个网络,而是通过改变边界点后进而提升了整个网络。

实验结果

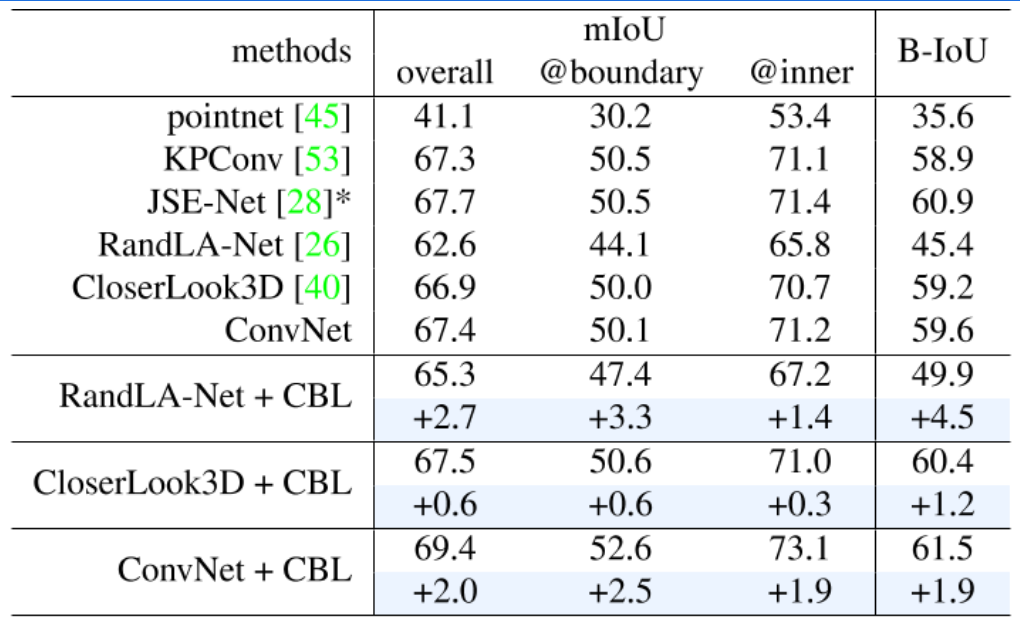

S3DIS室内

包含6个室内区域的3D RGB点云,覆盖272个房间。每个点都用13个语义类别中的一个注释,例如,天花板,地板,杂乱。具体类别在表二。

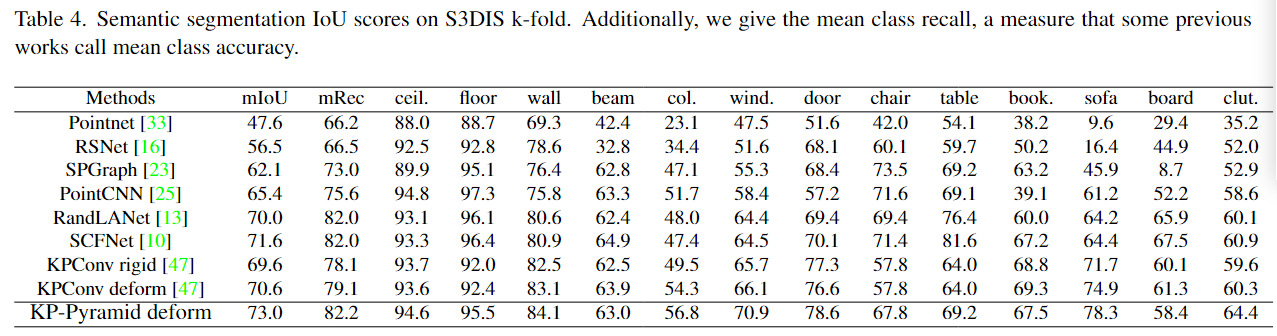

本文提到的方法在所有三个基线上持续改进,显示出对不同的本地聚合模块是有效的。值得注意的是,与其他具有较大区域的类(如墙壁和天花板)相比,在类(column)中(与ConvNet基线相比+13)的改进要显著得多。这样的观察显示了我们在边界地区的有效性;随着不同类别的持续改进,这也表明CBL不是在主要和次要类别之间权衡,而是更清楚地将它们分开。得益于更清晰的边界,卷积神经网络最终实现了69.4 mIoU的领先性能。

可视化结果如下图

在黑圈中标注了改善的点位,在最后一列中清楚的展现了不同的位置。与同样考虑边界的JSENet[28]相比,我们的基线相对于JSENet的基线(即KPConv[53])有了更大的改进,这证明了我们的优势,特别是在边界很重要的类别中,例如列、窗、沙发、书柜和杂物,以及整体性能。

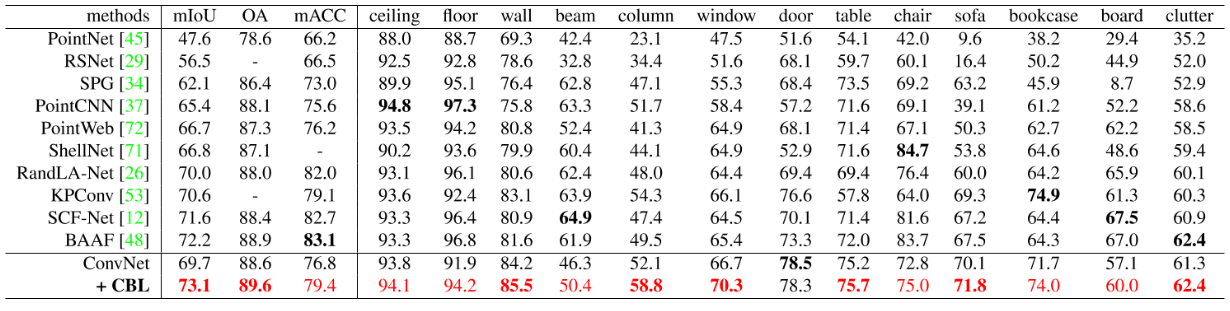

为了避免在S3DIS区域5上过拟合,本文进一步进行了6次交叉验证,结果见表3。列(+9.5)也显示了很大的改进,除了一个类(-0.2)之外,所有类都得到了一致的改进。因此,所提出的CBL确实可以被认为是一种通用而有效的方法,在共同的ConvNet基线下,在mIoU中达到73.1。

Semantic室外

个包含超过40亿个点的大规模数据集,提供了15个大型点云用于训练,每个点都标注为8个类中的一个,例如:汽车,建筑。本文使用了主要的8个类别作为标准。

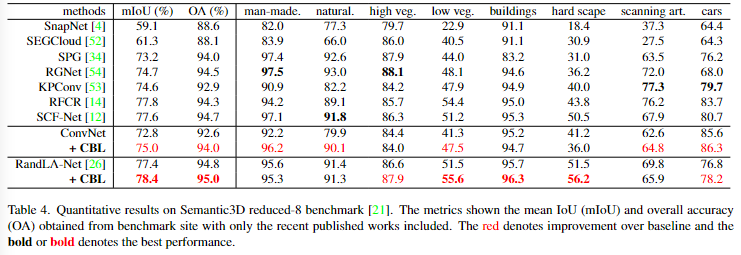

定量结果如下图

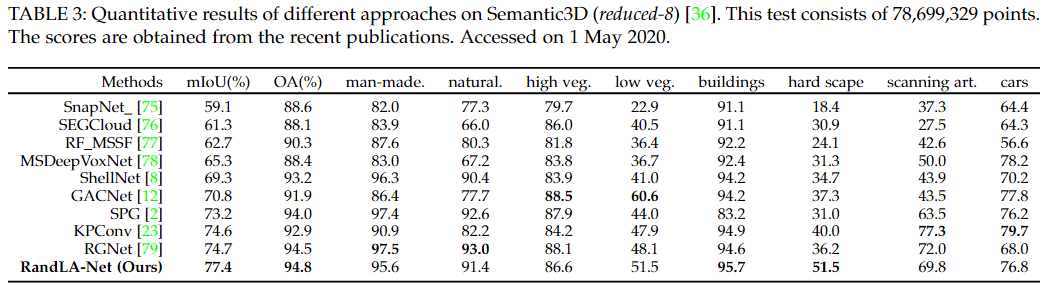

评估了使用ConvNet和RandLA-Net作为基线模型的CBL。观察到在两种基线模型上都有一致的改进。特别的是,RandLA-Net在多个室外数据集上已达到最先进的性能,对其进行的改进更能展示CBL的有效性。在高植被和低植被类别上取得了显著的改进,这两个类别通常是其他方法最容易混淆的。由于高/低植被通常在空间上非常接近,并且外观相似(例如,树木周围的灌木/草),使得这两类场景的分离具有挑战性。在这两个类别上的大幅度改进展示了CBL在场景边界上的有效改进。采用CBL后,RandLA-Net在平均交并比(mIoU)上获得了78.4的领先表现。

由于有着相似的情况,因此另两个数据集的分析附在附录中。

消融实验

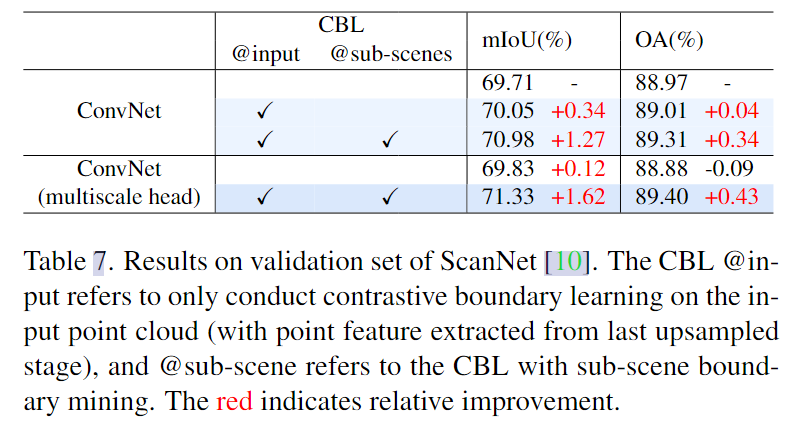

在ScanNet数据集中进行消融实验

CBL(单尺度/多尺度)+多尺度头

CBL:直接在输入点云上应用CBL(不进行子场景边界挖掘)可以提高性能,说明边界区域更值得关注。通过引入子场景边界挖掘,在CBL中实现了多尺度边界的识别和优化,获得了更显著的改进。

多尺度头:比较使用和不使用多尺度头部的ConvNet基线,我们发现直接使用多尺度头部甚至会损害性能(OA中-0.09)。结果表明,直接跨尺度拼接并不能带来很大的效益。相比之下,对于多尺度头部,CBL的ConvNet进一步增强,在mIoU和OA方面都获得了更大的改善。结果表明,改进的主要原因是CBL在不同的子采样点云上学习到更多的判别特征。

Stratified Transformer-2022-CVPR

Lai_Stratified_Transformer_for_3D_Point_Cloud_Segmentation_CVPR_2022_paper

一种用于点云语义分割的网络结构,主要通过提出的新模块——分层Transformer进行。相比于标准的Transformer在全局点云上进行注意力机制所耗费的O(N^2)的内存,本文将空间分为多个小立方体,在各个小正方体中进行Transformer,但是这种方法会具有有限的视觉野,因此提出了分层的概念——首先在点云中,先进行Q和V矩阵的求解,然后对于每个点的K并不像以前一样使用所有的点进行回应,而是找到该点所在小正方体的所有点,该点所在大正方体的所有点的并集(不重复),其中大正方体的长度设为小正方体的倍数,且其内的点为小正方体情况下的点进行FPS采样1/4,也就是密集局部点和稀疏长距离点。小正方体和大正方体的概念则是分层。同时由于网络的深度,考虑到xyz的特征可能会影响较低,因此在分层Transformer中提出了相对位置编码的概念,在q*k的权重计算时+相对位置偏置项,其中相对位置偏置项=qi * e_ij^q+kj * e_ij^k,表示相对位置编码根据查询矩阵和回答矩阵进行自适应,其中e_ij=tx[idx_x]+ty[idx_y]+tz[idx_z],表tx,ty,tz为可学习的参数,idx为相对距离的长度所对应的区间。这样分层Transformer能够在较低空间资源的消耗下达到较大视觉野的目的,同时根据查询矩阵和回答矩阵自适应得到的相对位置编码以及第一层的聚合性质的点嵌入方法也能够提升网络的性能,最终达到了SOTA

提出的原因

①在之前的网络当中存在着缺乏长期依赖的情况,而对于标准的Transformer来说,虽然能够有长期的依赖,但是内存消耗是比较大的O(n^2),而且这种全图的一个Transformer会导致特征一致化的问题产生。

②在Swin Transformer中,尽管有跨空间的思想,但是实际上在视觉野上还是有较大的局限性的。

网络架构

首先利用点嵌入进行一个局部一致性的先行提取(此处的网络的选择对于整体的收敛等有影响),然后进行Stratified Transformer,每一个encoder层中包括了两个这个Transformer,两个的区域划分会错开一半用于跨域。经过3层后再利用decoder进行还原。

Stratified Transformer:具体为首先进行Q,V矩阵的计算,然后将整个点云分为多个不重叠的3D立体窗口,找到当前这个点所在窗口,对于其内的所有点记录,然后进行对原点云进行FPS下采样,然后以更大的空间将采样后的点云分为多个不重叠的3D立体窗口,同样找到这个点所在的窗口,记录其内的所有采样后的点,将两者合并不重复作为key,然后进行注意力机制,但是由于这里添加了相对注意力机制,也就是e_ij,在每一个矩阵下计算eij,对于相对位置偏置项=提出的问题的点q_i*e_ij^q+回答的点k_j*e_ij^k,然后直接加在qi*kj表示添加了相对位置编码,最后在加权的时候也要在值矩阵上加上eij ^v,e_ij的计算为首先计算i点和j点的相对距离,然后将整个空间划分为L段,对于三个轴看相对位置分别在哪一段,每一段会对应一个特征D,得到各自轴的特征D,然后三者进行相加即可)

本文中的相对位置编码是每个QKV各自都拥有的。并且这种偏执项的求法可以让相对编码自适应的学习和询问矩阵和回答矩阵。如果是直接使用MLP对e_ij进行投影,则没有这种优势。

实验方法

数据集:S3DIS(构建四个块深度[2,2,6,2])和ScanNetv2(点数多所以构建了[3,9,3,3])

实验设置

S3DIS:76500个epoch,batchsize=8,首先经过网格采样法,格子大小为0.04m,初始的窗口大小为0.16,每个下采样层后加倍。每次分层下采样比例为8(稀疏窗口是稠密的8倍),FPS的数量为原来的1/4。

ScanNetv2:600epoch,权重衰减为0.1,batchsize为8,网格采样大小为0.02m,初始窗口大小为0.1,分层下采样比例为4。

实验结果

在S3DIS数据集上的性能显著优于其他方法,甚至比Point Transformer高出1.6%的平均交并比(mIoU)。

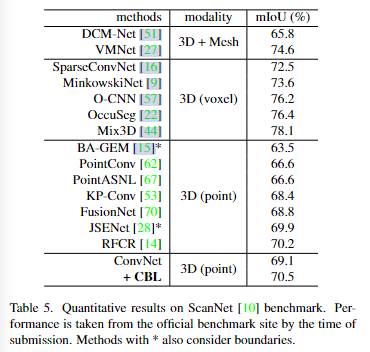

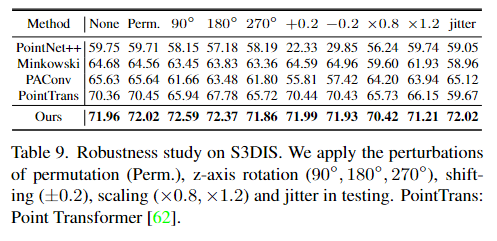

在ScanNetv2的验证集上,作者的方法超越了包括体素(voxel)基方法在内的其他方法,领先2.1%的mIoU。在测试集上,该方法略高于MinkowskiNet。本文认为,ScanNetv2数据集中的点相对稀疏,因此体素化方法在精度损失上不明显。然而,在点更密集的S3DIS数据集上,作者的方法比MinkowskiNet高出6.6%的mIoU。在测试时遇到各种扰动时比MinkowskiNet更健壮,如表9所示。值得注意的是,与ScanNetv2上基于体素的方法相比,基于点的方法首次实现了更高的性能。

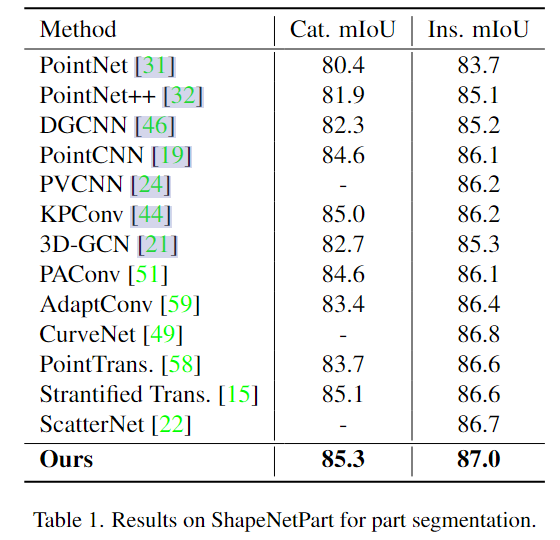

通过在ShapeNetPart中的实验进行泛化能力的测试。本文的方法在ShapeNetPart数据集上表现出色,刷新了类别平均交并比(category mIoU)和实例平均交并比(instance mIoU)两个方面的最佳记录,显示了其良好的泛化能力。尽管在实例mIoU方面,作者的方法与Point Transformer相当,但在类别mIoU方面,作者的方法比Point Transformer有较大的优势。这表明该方法在区分不同类别的部分方面表现更为突出。

实例是针对每个物体的交并比,而类别则是针对每个类别的交并比。

鲁棒性测试

在多种扰动(排列(改变点云中点的顺序)、旋转、位移、缩放、抖动)下进行测试评估模型的鲁棒性。

结果显示作者的方法对这些扰动非常鲁棒,而先前的方法在这些情况下性能波动很大。值得注意的是,当应用90度z轴旋转时,模型的性能甚至提高了0.63%的mIoU。尽管Point Transformer也使用自注意力机制,但其鲁棒性有限。可能的原因是Point Transformer使用了特殊的操作设计(如“向量自注意力”和“减法关系”),而不是标准的多头自注意力。

可视化结果

消融实验

①分层Transformer+②第一层点嵌入的方式+③上下文相对位置编码+④位移窗口+⑤数据增强

①比较 Exp。IV 和 V,我们注意到使用分层策略,模型在 S3DIS 上提高了 1.9% mIoU,在 ScanNetv2 上提高了 1.2% mIoU。结合图 1 中的可视化,我们注意到分层策略能够扩大有效的感受野并提高性能。不同的下采样尺度的效果如下图。

②通过比较实验I和实验II,发现引入首层点嵌入的模型性能有显著提升。在S3DIS数据集上,模型的平均交并比(mIoU)提高了2.0%,在ScanNetv2上提高了4.0%。这种对架构的小修改带来了显著的好处。因此进一步比较了不同局部聚合方法与线性投影在首层点嵌入中的效果,发现所有列出的局部聚合方法都优于线性投影。

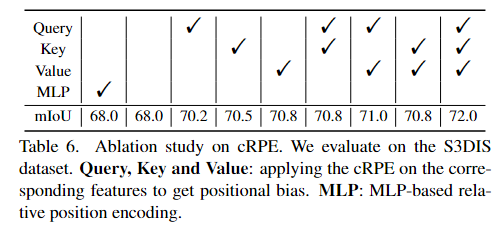

③使用cRPE后,模型在S3DIS数据集上的性能提升了2.9%的mIoU,在ScanNetv2上提升了1.9%的mIoU(实验III对比实验IV)。当结合使用分层Transformer和cRPE时,模型在S3DIS上的性能提升了4.0%的mIoU,在ScanNetv2上提升了2.3%的mIoU(实验VIII对比实验V)。应用cRPE在查询、键或值的任何一个特征上都能带来性能提升,同时应用在这三者上时,模型取得了最佳性能。此外,利用MLP直接作用在eij中,而不是自适应的根据q和k进行调节,我们发现基于mlp的方法(第一列)实际上与没有任何位置编码的模型没有区别(第二列)。结合图 5 中的可视化,我们得出结论,纯粹基于 xyz 坐标的相对位置信息没有帮助,因为网络的输入点特征已经合并了 xyz 坐标。相比之下,cRPE 基于 xyz 坐标和上下文特征。

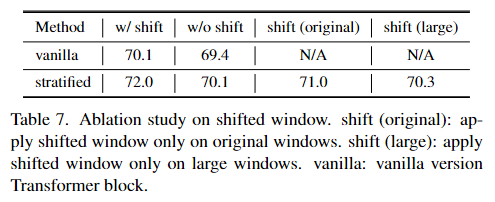

④使用移位窗口可以增强窗口间的信息交互,从而提高性能。在S3DIS数据集上,无论是标准版本还是分层Transformer,带有移位窗口的模型都比不带移位窗口的模型表现更好。即使没有移位窗口,分层Transformer仍然表现出更高的性能,例如实现了70.1%的mIoU。在原始大小和更大的窗口上都进行移位操作是有益的。具体的性能如下表。

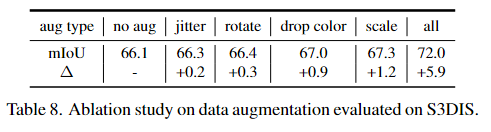

⑤数据增强在训练基于 Transformer 的网络中起着重要作用。在我们的框架中也是如此,如 Exp 所示。V 和 VII 以及 Exp。II和III。我们还研究了表8中每个增强的贡献。

BAAF-2021-CVPR

Semantic Segmentation for Real Point Cloud Scenes via Bilateral Augmentation and Adaptive Fusion

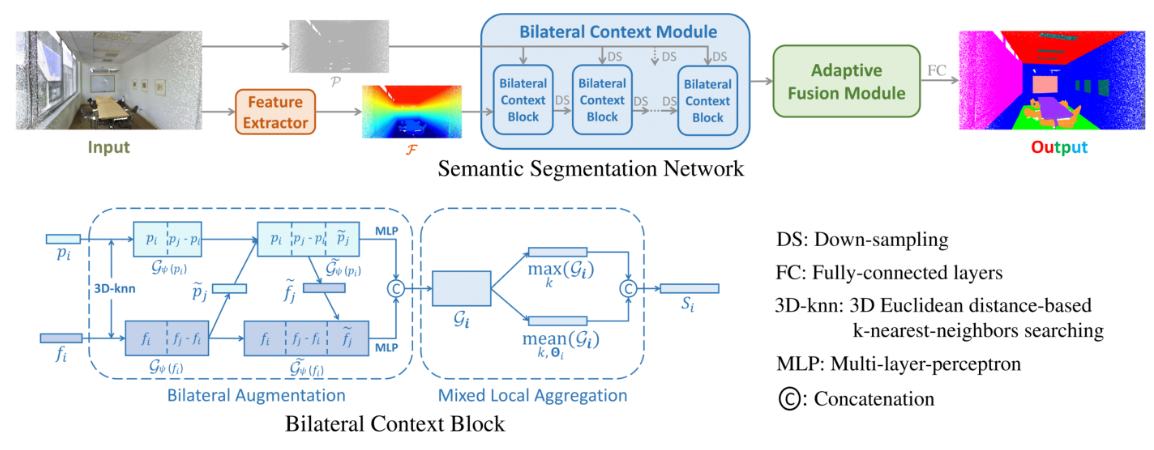

一种用于区分相似点邻域的点云语义分割的网络结构,首先通过简单的特征提取网络(本文仅使用了单层的MLP)提取点云特征后,对于某点特征,分为空间几何特征pi以及语义特征fi分支,首先对空间距离的k近邻的坐标以及特征进行拼接得到pi’ = [pi,pi-pj],fi’ = [fi,fi-fj],然后利用fi’通过MLP得到pj的偏移量pj和pi’拼接,并用pi’'通过MLP得到fj的偏移量fj,同样拼接,然后再对pi’‘和fi’'拼接并通过最大池化和平均池化后再次拼接得到Si。这样的特征可以通过不同的pi对于邻域特征相似的特征进行一个分离。比如对于树木的不同树干区域,初始提取的特征可能是在树干的不同位置但是会有着相似的特征,这导致了不同的空间坐标的点却因为邻域特征的相似性导致有着相似的特征。而这种方法能够充分的利用到几何位置去增强局部上下文达到不同的位置有不同的区分度。同时根据特征进行的坐标适应(有利于泛化),然后再用坐标进行特征的强化。对于提取的不同尺度下的特征图,通过自适应融合每个点的多分辨率特征(对某个尺度的特征图进行Conv1*1得到该点的权重,然后进行不同尺度的特征图的各点的加权求和),能够感受到不同尺度下的特征自身的点集信息。

提出的原因

①过去的方法在点的领域的定义通常是依靠距离来决定的,但是在密集点的情况下,确定哪些点属于一个点的邻域是很困难的,可能会错误的将附近的点划分为相同的语义类别。这种情况在离群点和边界点中尤为明显。

②在模型中可能会多次组合融合相似或者相同的特征导致产生大量的冗余特征。一方面使模型难以进行有效的特征的搜索和提取,另一方面增加了处理的复杂度。

③在网络模型中的一些采样/池化的操作会导致数据的全局信息的丢失。

解决方法:①提出了一个鲁棒的聚合过程用于细化增强局部上下文,提取有用的相邻信息用于点的表示,②将信息进行解耦,分为几何特征和语义特征,然后通过双边结构充分利用。③整合不同分辨率下的信息来重建感知,自适应的融合每个点的多分辨率特征,得到全面的表示用于语义分割。

网络架构

首先将输入点云通过常规的特征提取网络提取特征,此时会出现之前提到的问题(冗余、相似等),此时在提取的特征中通过本文提出的模块Bilateral Context Block和下采样,得到多尺度下经过了几何加强和语义特征融合的特征图。对于这些特征图,通过渐进的方式进行还原到原始图,最终得到了n个原始图大小的特征图,对于这些特征图通过加权求和得到最终的特征图。

Bilateral Context Block:首先对于特征和点坐标,提取空间中k近邻进行拼接得到附近k个值和该点进行拼接的特征,对于点坐标,对于利用特征做MLP后得到坐标偏移量然后和点坐标再次拼接(可以类比于KPConv中可偏移的情况,为了限制pj ~ 的移动情况,增加了一个损失函数让漂移量趋于pi),然后利用拼接后的点坐标做MLP得到特征偏移量然后和特征再次拼接(可以理解为利用空间几何对语义特征进行了增强),最终得到点坐标分支的输出[pi,pj-pi,pj~],同理特征分支的输出[fi,fj-fi,fj ~],将两个分支的输出拼接后做最大池化以及平均池化后再次拼接作为输出特征。

实验方法

实验设置

本文在特征提取模块直接使用的1x1的卷积块以及归一化层和激活函数。

在Bilateral Context Block中使用FPS下采样,点数从1-1/4-1/16-1/64-1/256,k=12。

自适应融合阶段,首先对于各尺寸下的特征图通过MLP进行特征转换,然后插值还原至原图大小后将k近邻特征进行拼接,然后再次进行MLP。得到最终的Si~,对于权重,则对于每一个Si ~,利用MLP总结每一个点的特征的信息,得到大小为N的φi,然后逐点和Si ~做乘积后对所有的特征图求和。注意这里的φi是进行了Softmax的。

100个epoch,batchsize = 4-6,adam,初始学习率为0.01,每10个epoch以50%的速率衰减。

数据集

S3DIS、Semantic3D、SemanticKITTI(基于著名的KITTI Vision[12]基准,描述了复杂的室外交通场景。有22个立体序列,密集地记录为扫描(每次扫描约10万个点),并精确地标注为19个语义类。特别是,22个序列中有11个提供了标签,而其他10个序列(超过20k次扫描)的结果用于在线评估。与[4]一样,我们将序列08作为验证集,而其余10个标记序列(约19k扫描)用于训练。)

评价指标

mIoU、OA、mAcc、以及各类别的mIoU

实验结果

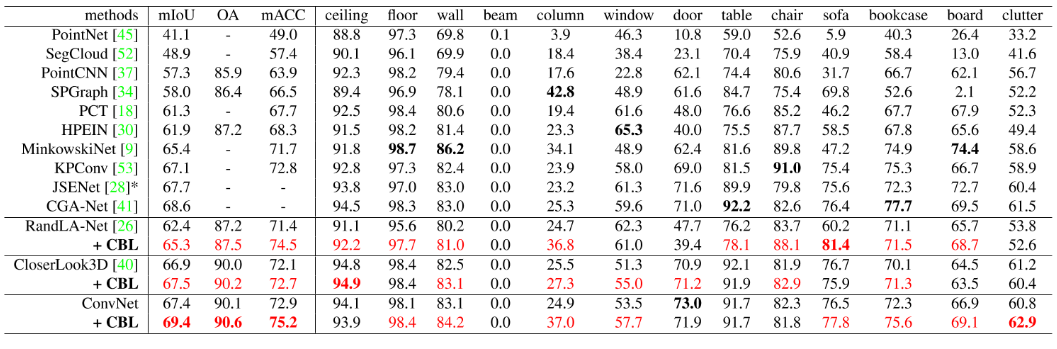

S3DIS

表格1(Tab. 1)中量化展示了该网络在S3DIS数据集上的性能,并与其他最先进的方法进行了比较。尽管最近的方法在总体准确率(overall accuracy)方面取得了不错的结果,但作者指出这个指标并不能完全反映语义分割的能力,原因是不同类别之间存在类别不平衡的问题。该网络在平均类别准确率(average class accuracy)和平均交并比(mean Intersection over Union,mIoU)两个指标上显著优于竞争对手。在这项研究中,平均类别准确率达到了83.1%,mIoU达到了72.2%。

可视化结果如下图

Semantic3D

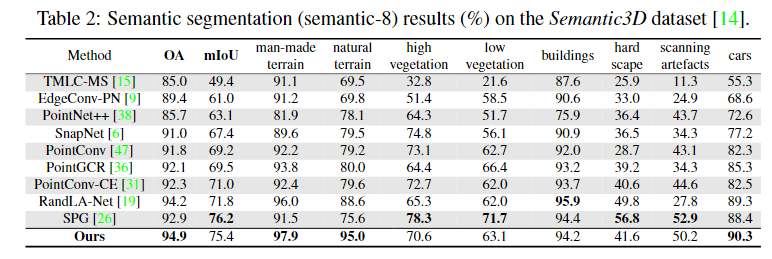

我们在八个类中的三个中超越了其他方法;我们的方法在三个类别上是准确的,即人造和自然地形、汽车,其 IoU 都高于 90%。考虑到在20亿个测试点上的总体准确率(94.9%)和mIoU (75.4%)的结果,我们的方法准确地对真实场景中点的语义标签进行分类,特别是对于大规模数据。

SemanticKITTI

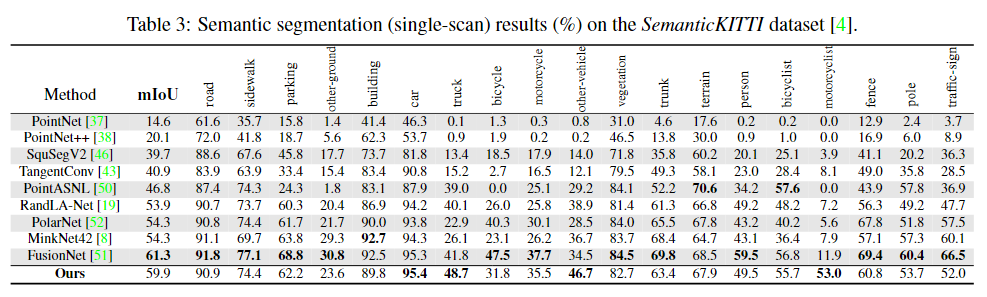

尽管由于交通环境中的复杂场景,SemanticKITTI具有挑战性,但我们的网络可以有效地识别点的语义标签。如表中所示。3,我们在所有 19 个类别中的 4 个中超过了其他高级方法。特别是,我们对汽车、卡车、其他车辆、摩托车等密集扫描中的小物体表现良好。出色的结果可以归功于我们的点级自适应融合方法,该方法彻底集成了不同的尺度。总体而言,与最新的基于点的方法[50,19,52]相比,我们的网络提高了很多(5.6% mIoU),而在使用稀疏张量的框架[8]的最先进的工作[51]上略落后。由于双边增强和自适应融合的主要思想相当适应性,未来将研究更多不同框架的实验。

消融实验

①双边上下文模块+②自适应可融合模块

①通过偏移量方向以及损失函数,以及聚合方式的消融,可以看到语义增强损失 L(fi) 没有影响,因为在嵌入空间中增强语义特征是隐式的。相比之下,具有几何增强损失 L(pi) 的双边偏移 ̃pi 提高了位(模型 B4&B5)。利用局部最大特征和均值特征的优点,我们得出结论,双边上下文块的最佳形式是使用混合局部聚合(B6)。

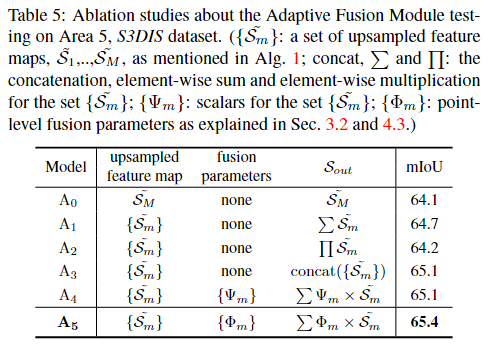

②通过不同的上采样特征图选取以及聚合参数以及聚合方式,我们注意到,利用来自多个分辨率的上采样特征映射可以提高性能。然而,融合方法决定了效果是否显著:常规的求和(A1)或乘法(A2)是不可取的,而串联(A3)更有助于最终的预测。对于每个特征映射进行广义融合(A4) w.r.t.,我们基于特征映射的压缩信息[18]回归一组标量{Ψm}。相反,由于语义分割更多地依赖于逐点特征表示,因此在点级(A5)上进行更灵活的自适应融合操作可以获得更好的结果。

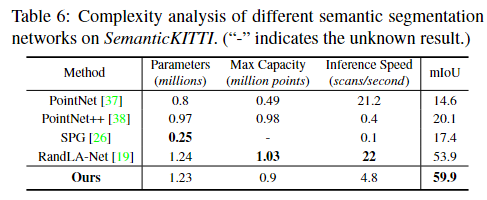

网络复杂度分析

我们使用与[19]相似的度量来研究使用训练模型的推理。我们的模型的复杂性和容量(即参数的数量和预测的最大点数)与[38,19]相当。虽然[19]对于一次性推理是有效的,但它们需要多次评估以最小化随机抽样的影响,而我们在不同的真实场景中获得更有效和稳定的语义分割结果,如图1所示的例子。在补充材料中提供了更多的可视化和实验结果。

RandLA-Net-2021-TPAMI

Learning Semantic Segmentation of Large-Scale Point Clouds with Random Sampling

基于UNet架构的点云语义分割网络,在Encoder中使用随机点下采样以及LFA模块进行编码,一个LFA中包括了两个连续的LocSE和AP模块,LocSE为局部空间编码,和上一篇一样包含了空间分支和特征分支,首先取K近邻,然后进行拼接,对于空间编码中由pi,pj,pi-pj,|pi-pj|进行拼接然后MLP,特征分支则是直接使用fj进行MLP,然后把两个特征拼接后得到输出的特征,在AP阶段进行得分计算,然后作为加权进行求和达到最终的特征,对于这个空间编码这里,本文后面有丰富的消融实验,其中pi-pj,|pi-pj|的拼接能够达到第二好的效果,仅差mIoU0.2%,而pi,pj,|pi-pj|能够达到第三号,仅差mIoU0.3%,我在这里认为使用pi,pi-pj,|pi-pj|就行,但是消融实验中并没有这一组。

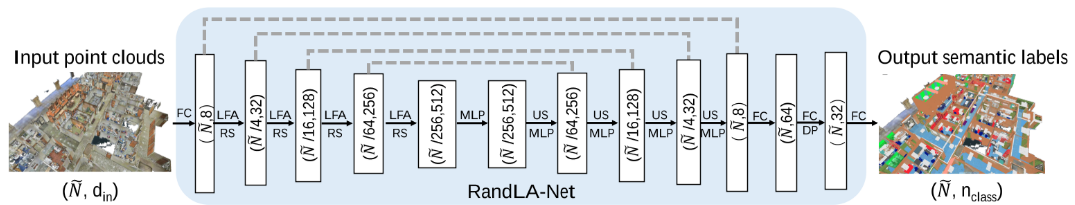

网络架构

UNet的基本架构,编码器中利用LFA进行局部特征提取。接码其中使用MLP进行解码。

具体的LFA的架构如图,分为两个模块进行叠加以及resnet得到。LocSE模块用于结合空间位置编码进行局部特征的提取,主要分为两个小分支,一个是提取空间编码信息,一个是提取局部特征,然后在最后两者拼接得到结合空间位置编码的局部特征。另一个模块是注意力池化,对于刚刚得到的局部特征,首先经过一个MLP得到各点的得分,然后进行点加权得到最终的单点局部特征。其中的所有特征变换的过程都是使用的MLP进行的。

可能是2021年的论文,而且是顶刊的论文,感觉这个论文有点滞后性的感觉,里面的架构已经不够新颖了。

输入为一个大规模点云,每层Encoder由LFA和RS组成,下采样的抽取率为4倍,也就是说点数量为1-1/4-…,同时增加逐点特征维度,8-32-128-156-512,解码器共有4层,每一层使用最近邻插值,跳跃连接后使用MLP。最终的语义分割使用使用三层MLP,从N,64-N,32-N,nclass和一个dropout层得到。

实验方法

数据集

Semantic3D、SemanticKITTI、Toronto-3D、NPM3D。S3DIS

Toronto-3D数据集由大约7830万个点构成,这些点是通过移动激光系统(MLS)采集的,覆盖了大约1公里的城市户外三维空间。数据集中的一个部分(区段L002)被用作测试集,其余三个部分用于训练。在评估时考虑了8个类别。这些类别包括道路、建筑物、车辆、行人等不同的城市环境要素。

NPM3D这个数据集包含了在法国三个城市(Neuilly-sur-Seine, Paris, Marseille)收集的点云数据。它覆盖了多种城市环境,包括街道、建筑物、车辆、行人等。

实验设置

adam,初始学习率设为0.01,每个epoch降低5%,训练100个epoch,KNN搜索,k=16,对于非常大的数据集,就会在输入之前把数据集切割成小的子点云。训练时,从每个点云中随机采样固定数量的点(约10万)作为输入。测试时重叠的推断子点云得到完整点云的推理结果。对于多次测试中多次推断的点,使用投票来选择最终的语义分割结果。损失函数使用加权交叉熵用于解决不平衡类。不进行数据增强,不过随机的下采样分割子点云可以认为是一种隐式的数据增强。

实验结果

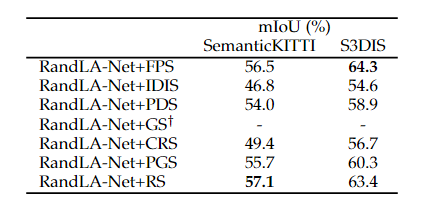

随机采样的效率

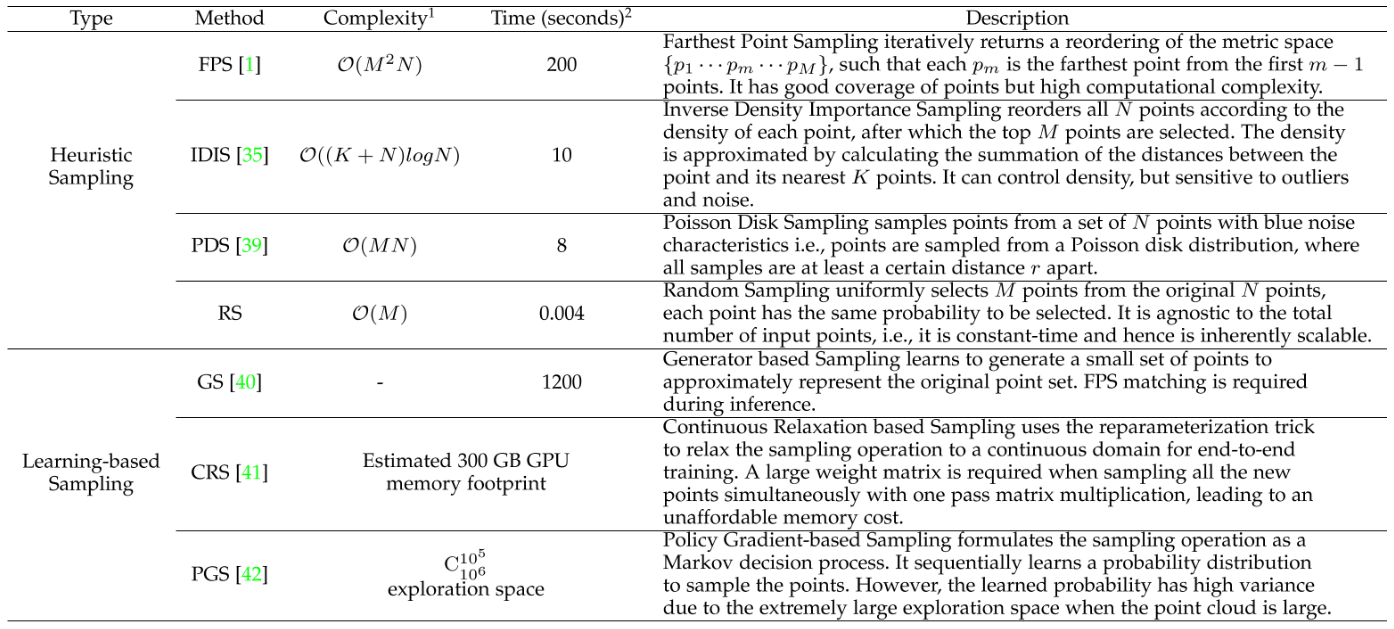

对于不同的采样方法(FPS、IDIS、PDS、RS、GS、CRS、PGS)进行了评测。

分别在1e3-6的大小的点云输入作为测试,可以看到随着点数的增加,在处理大规模点云时,FPS(最远点采样)、IDIS(反密度重要性子采样)、PDS(泊松盘采样)、GS(生成器采样)、CRS(不确定具体方法)、PGS(不确定具体方法)等方法要么耗时过长,要么内存成本过高。相比之下,随机采样在时间和内存效率方面表现更优越。

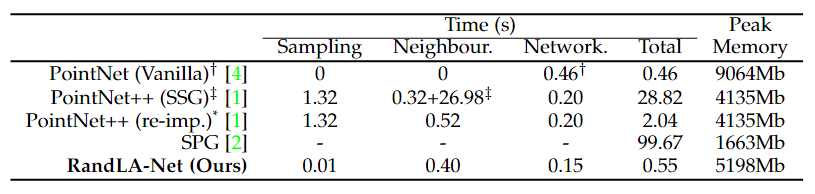

RandLA-Net的效率

SPG具有最低的GPU内存消耗,但由于昂贵的几何分割和超图(super-graph)构建步骤,SPG处理点云所需时间最长。PointNet++也是计算密集型的,主要是因为使用了最远点采样(FPS)操作。PointNet由于其内存效率低下的操作,无法在一次通过中获取超大规模的点云(例如1e6个点),通过简单的随机抽样和高效的基于mlp的局部特征聚合器,本文的RandLA-Net可以在0.5s左右的时间内推断出近100万个点云(12×81920点)的语义标签。

语义分割情况

首先遵循KPConv的方法,使用网格采样策略对所有输入点云进行预处理。评价指标:OA,mIoU。

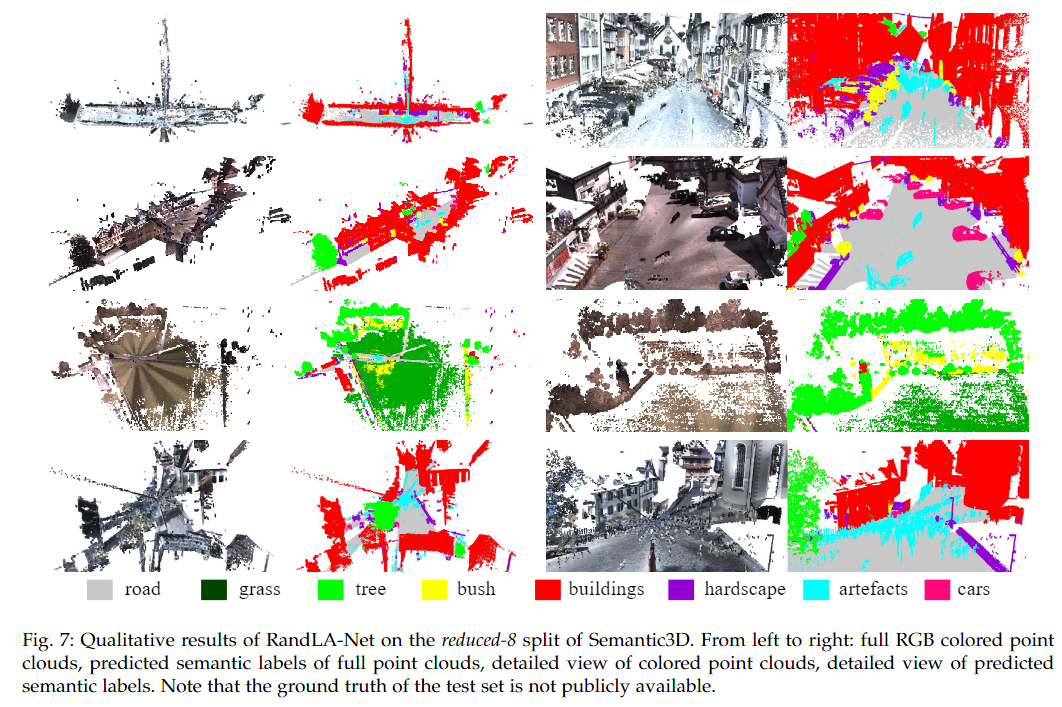

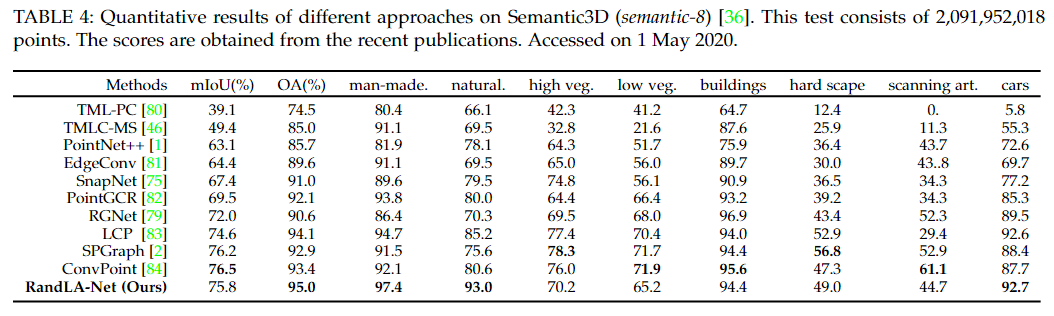

Semantic3D

在mIoU和OA两个指标上,RandLA-Net明显优于所有现有方法。

特别地,RandLA-Net在八个类别中的六个上表现出色,只有在低矮植被和扫描伪影两个类别上表现不佳。

可视化结果如下图

表4报告了在semantic-8子集上的结果。与reduced-8子集相比,semantic-8子集拥有更多的点(大约是10倍)并且类别不平衡问题更加严重,因此更具挑战性。在整体准确率方面,RandLA-Net同样取得了最佳性能。但在mIoU性能方面,RandLA-Net排名第三,这主要是因为ConvPoint和SPGraph在硬景观和扫描伪影两个类别上取得了更好的结果。

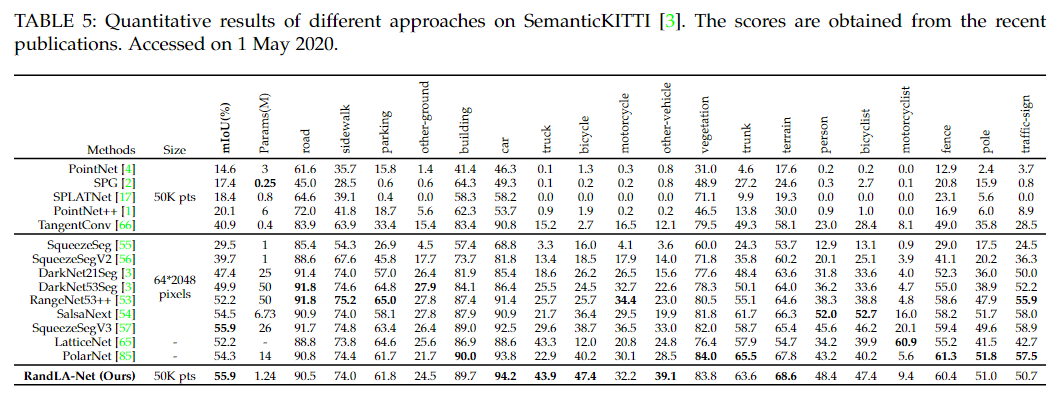

SemanticKITTI

可以看出,本文的RandLA-Net大大超过了所有基于点的方法,与次优方法相比,显著提高了15%。本文也优于大多数基于投影的方法,但并不明显,主要是因为SqueezeSegV3在小型对象类别(如摩托车手)上取得了更好的结果。然而,与基于投影的方法相比,我们的RandLA-Net更轻量,参数更少。

可视化结果如下图

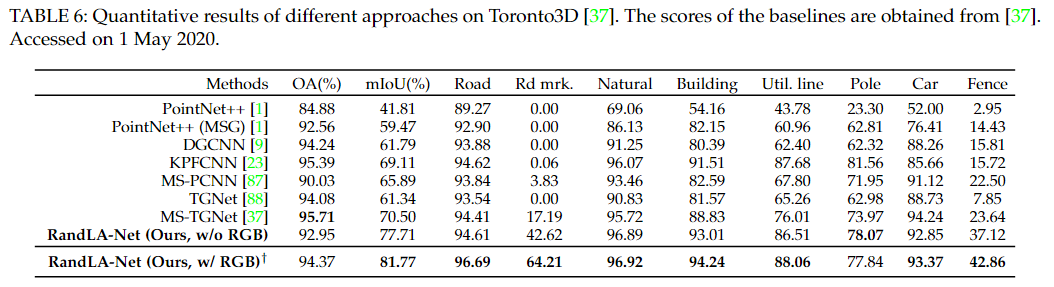

Toronto-3D

RandLA-Net在mIoU(平均交并比)方面取得了该数据集上最好的结果,将之前的最佳方法MS-TGNet的70.50%提高到了77.71%。为了确保公平的比较,所有网络仅以每个点的3D坐标作为输入。

可视化结果如下图

通过可视化分析可以知道,所有方法中最难以识别的是道路标记(Road marking)。这主要是因为道路标记的纯几何模式很难与周围环境区分开来。尤其是仅给定点的3D坐标时,几乎不可能区分道路标记和道路本身,如图9所示。为了提高准确性,作者考虑在RandLA-Net中加入点的外观信息(如颜色)。当使用3D坐标和颜色信息作为输入训练RandLA-Net时,道路标记的IoU分数显著提高了22%,这表明在这种困难情况下外观信息的重要性。

NPM3D

表7定量地显示了我们的RandLA-Net和现有基线[23]、[77]、[83]、[86]、[90]、[91]所获得的结果。在这个数据集中,只有每个点的三维坐标可用。由于垃圾桶和行人两个少数类的得分相对较低,我们的RandLANet平均IoU得分为78.5%,排名在最新的LightConvPoint[83]和KPConv[23]之后。本文认为垃圾桶和行人的点特征很可能在我们的RandLA-Net中被随机丢弃,因为这两个类别只有非常少的点被扫描。

S3DIS

表8定量地比较了我们的RandLA-Net与该数据集上现有基线的性能。我们的RandLA-Net实现了与最先进的方法相当或更好的性能。请注意,大多数基线[1]、[7]、[8]、[9]、[34]、[95]倾向于使用复杂但昂贵的操作或采样来优化点云小块(例如1×1米)上的网络,并且相对较小的房间有利于被划分为小块。相比之下,RandLA-Net能够将整个房间作为输入,并在一次传递中有效地推断每个点的语义。

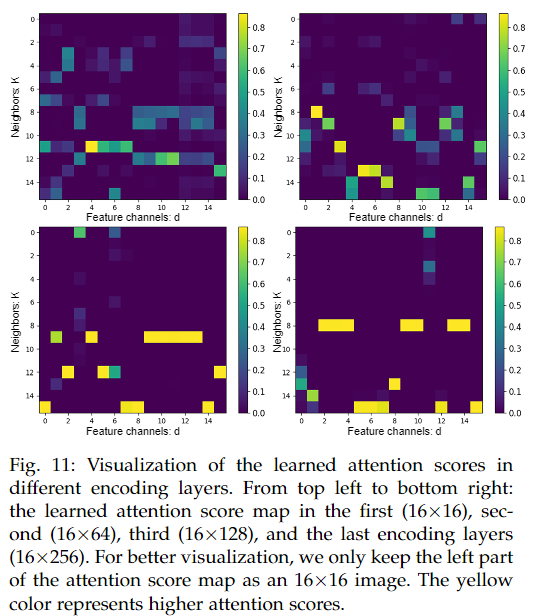

注意力得分的可视化

从第一层到第四层下采样的某点的注意力分布结果如上图,在第一层编码中,对于一个特定的中心点,其16个邻近点的学习到的注意力分数倾向于相似。在随后的层中,对于新的16个邻近点,学习到的注意力分数却有显著的不同。本文认为在第一层,邻近点可能在特征上相似并且同样有信息量,因此它们学习到的注意力分数也相似。当大规模点云被显著下采样并逐步聚合后,保留的点特征趋于高度紧凑,并具有不同的语义上下文。因此,那些与中心点语义意义不相似的邻近点的注意力分数倾向于为零,而最相似的邻近点则倾向于获得高注意力分数。

这种分析表明,RandLA-Net的注意力机制能够有效地区分不同的邻近点,并根据它们与中心点的语义相似度赋予不同的权重。这有助于模型更有效地聚合特征,并提高对复杂点云数据的处理能力。

消融实验

RandLA-Net架构的消融

分为五组,第一组去除LocSE,第二到四组在注意力池化处使用不同的池化方式,第五组在一个模块中只使用一次LocSE和AP。

对比可以看到每次resnet 中的连续使用两次LocSE和AP的影响是最大的。本文认为问题如下图

在单次的LA后,形成的还只是在局部邻域中的聚合特征,而对应随机采样来说,这种局部邻域的特征还是视觉野过小,而两次后视觉野能够达到k^2的级别。这对于随机抽样尤其重要,因为随机抽样不能保证保留特定的点集。2)去除局部空间编码单元对性能的影响次之,表明该模块对于有效学习局部和相对几何上下文是必要的。3)移除注意力模块会降低性能,因为它不能有效地保留有用的功能。从这项消融研究中,我们可以看到所提出的神经单元如何相互补充,以达到我们最先进的性能。

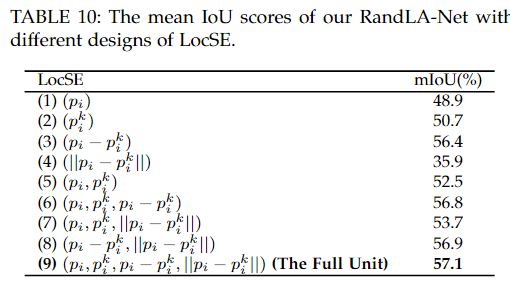

LocSE中的消融

共8组,1-4组为拼接的编码的单个情况(pi,pj,pi-pj,|pi-pj|),第五组为pi,pj,第六组为pi,pj,pi-pj,第七组为pi,pj,|pi-pj|,第八组为pi-pj,|pi-pj|。

从表10可以发现,相比于各个单独的编码,pi-pj提供的信息是最多的。因为pi-pj首先属于矢量,其包含了方向编码和距离编码,虽然距离编码没有明显给出,但是实际上网络是比较学习到这种信息的,因此可以看到3和8的差异实际并不大,而3和6的差异我认为将pj给删除了,只使用pi或者把pi删除了只留pj同样可以到达效果,因为只是一个加减法的特征差异pi=pj+(pi-pj)实际上在网络中是可以很好的模拟的。那么是否可以简化为pi,pi-pj,|pi-pj|这三个呢?本文中并没有探讨到,我认为是完全可以的。不过这种简化在MLP中也就是少了3*d的参数而已。

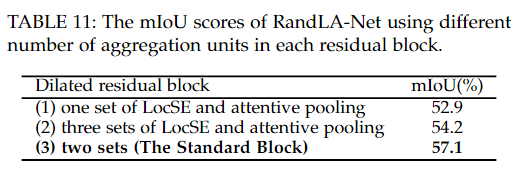

Resnet中数量的消融

1-2-3

表11显示了我们的RandLA-Net在每个扩展剩余块中具有不同数量的聚合单元时的mIoU分数。可以看出:1)由于接受野有限,在扩张残块中只有一组LocSE和细心池会导致mIoU分数显著下降。2)三组LocSE和细心池化并没有像预期的那样提高准确率。这是因为显著增加的接受域和大量的可训练参数倾向于过拟合。可以想一下这里的k设置为了16,k^2=256,k ^3 = 4096,显然可以感受到这后面的视觉野过大了。

不过这里的(1)和框架中的消融的(5)我觉得是一样的,但是最终的结果不太一样诶,我觉得可能有问题了。

下采样方法的消融

如表12所示,所有结果分别在SemanticKITTI数据集和S3DIS数据集(Area-5)的验证集(即序列08)上实现。可以看出,我们的框架的分割性能与随机抽样、最远点抽样或基于策略梯度的抽样相当,表明我们的局部特征聚合模块确实是有效的,并且适用于其他抽样方法。请注意,当使用逆密度重要性采样时,性能会显著下降,主要是因为所选点的密度较低,并且在实践中往往是异常值和噪声

邻居数量的消融(K的数量以及球形邻域选择方式)

直观地说,K越大,可以学习的局部几何模式就越复杂,所需的计算量也就越大。我们进行了7组实验,K在4到64之间变化。评估设置和协议与章节4.4中使用的相同。图10 (a)显示了在KNN中选择不同K时分割性能的变化。可以看出,当相邻点k的数量从4个增加到16个时,网络获得了显著的增益(mIoU分数从46%→57%),之后随着k的增大,平均IoU分数逐渐下降。这表明,1)由于接收域有限,很小的相邻点集合不利于网络学习有用的点局部特征;2)一个非常大的邻近点集也不太可能提高准确性,因为学习到的复杂局部特征往往会过拟合训练样例,并且不一般(具体可以类比三块LocSE和AP在一个Resnet块中)。

对于球半径查询,进行了7组实验,逐渐增加第一层编码层的查询半径,从0.1米增加到0.7米。在每个采样层之后,查询半径加倍。为了公平比较和更好的并行化,无论查询半径如何,都一致地在每个球形邻域中选择K=16个邻近点。这是通过遵循PointNet++的方法,在每组邻近点集内进行下采样或填充来实现的。当第一层的半径设置为0.6米时,网络达到了最佳性能,平均交并比(mean IoU)得分为55.08%。这个得分略低于使用KNN的最佳模型(55.08% vs 57.11%),表明RandLA-Net能够适应由KNN引起的空间不一致性。这主要是因为RandLA-Net中LocSE单元的注意力汇聚机制倾向于自动为所有邻近点学习不同的权重。并且所有点的空间位置已经被隐式地考虑在内。

局限性

①KNN的计算效率并不是呈线性增长的。可能是由于距离矩阵的求法的原因吧,本文提到可以尝试使用KDtree的数据结构进行。

②随机采样主要关注观察到的点,无法提供有关未被观察到区域的信息。本文想使用一种机制能够生成新的随机点云,不仅包含了原始点云中的点,还能推断出一些由于遮挡等情况未包含的点(点云生成)

③整个网络都是使用的MLP的方法进行的,相对于一些先进的点卷积(KPConv等)技术来说性能没有那么强大。

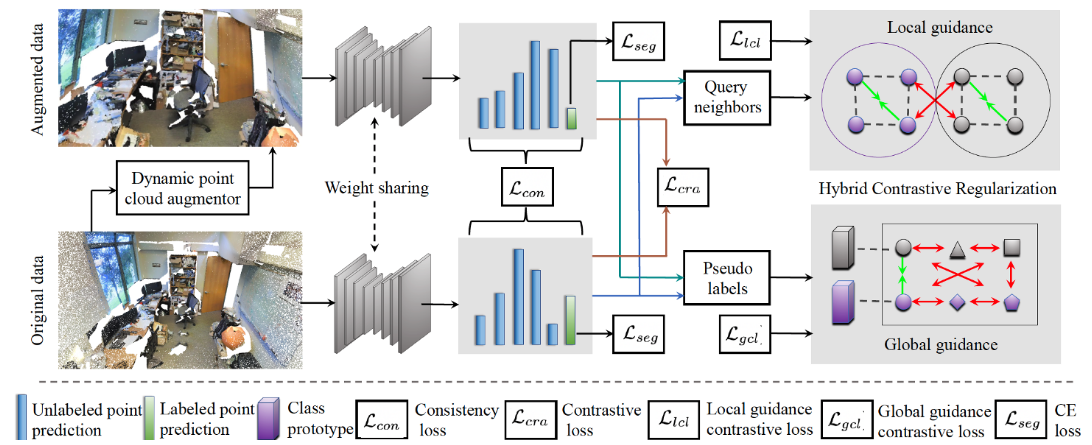

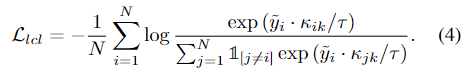

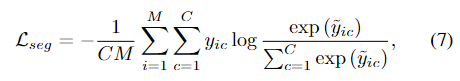

HybridCR-2022-CVPR

HybridCR: Weakly-Supervised 3D Point Cloud Semantic Segmentation via Hybrid Contrastive Regularization-2022-CVPR

这是一篇无监督框架的点云语义分割网络,通过一个动态点云增强器进行点云数据增强,然后利用一致性损失来进行鲁棒性的学习(对一些旋转,扰动等不敏感)的同时,使用三个对比学习的方法,①点级别的对比学习——原点云中某点特征和增强点云中对应点的特征拉近,和其他点的特征推远,其实也是让网络学到一致性,除此之外就是排开所有点的特征,如果仅仅是这个损失函数,显然是不行的,因为只有排开,没有靠近;②局部引导的对比学习——原点云中某点特征和增强点云中对应点的K近邻特征的均值拉近,和其他点的K近邻特征的均值推远,这是学的局部邻域信息,帮助一些存在遮挡和空洞的物体能够从其他完整对象中学习局部结构信息,能够在①的基础上将当前点和其他K近邻的点的均值拉近,也就是让非K近邻的点特征拉远和K近邻的点特征拉近,这就是在①上进行的一个拉近的操作;③全局引导的对比学习——原点云中某点特征和所有该类别中的点的特征的均值拉近,和其他类别中的点的特征的均值拉远,这个能够让每个类别的点聚集在一起,这个又是在①②上进行的一个拉近的操作,仅仅是②中拉近K近邻的点的特征还是不够的,因此这里又添加了一个拉近同一类别的特征再次拉近,对于不同类别的点的特征拉远。最终使用伪标签进行语义分割的多值交叉熵损失。细数一下这些拉近和拉远,可以看到拉近只有邻居拉近和同类别的点拉近,而拉远有 所有点拉远,所有非邻居点拉远,所有非同类别点拉远。拉近的都是应该的,而拉远中存在着两个不应该的,一个应该的。可以看到网络实际上可能还是拉的比较远的,或许可以通过一些权重的分配,让拉近多一点能够抵消不合理的拉远,或者再添加一些拉近的操作试试。

在点云分割中的弱监督学习的方法

①使用一致正则化:在输入数据中做出小的改变,输出应该保持不变。有利于增加鲁棒性(如点的抖动,点云的旋转)

②使用伪标签,也称作自我训练,首先先在有限的标注数据上训练,然后对未标注的数据进行预测,将得到的结果作为已知标签再次训练模型,迭代进行,是一个逐步优化的过程。

③对比预训练,在大量未标注数据上训练,然后再投入一些标签数据进行下游任务的微调。可以看家铭师兄写的CrossNet,这个点云理解就是很明显的对比学习。

提出的原因

①为了解决大规模点云语义分割中高昂的标注成本问题。弱监督学习能够最大化数据效率,减少对三维点云的注释工作。

②既有方法在考虑邻域语义属性和三维类别全局特征方面存在不足,尤其是在大规模场景中,未能充分利用有限的标注信息。

③目前的许多方法中使用手工特征作为输入放到网络模型中,但是这种方法实际上是次优的。同时也是泛化性较弱的。比如使用点法线作为输入特征,那么在只有一个平面时,这种方法性能可能较差。

④现有的网络大多没有端到端的训练方案,而那种pipeline中分开的方法,就有可能带来对输入数据敏感,以及训练收敛困难等问题。

新颖点

①在标签空间和特征空间中利用一致性以及对比性。并结合伪标签和一致性正则化策略。

②对于对比学习中锚点的正样本对和负样本对重新进行设计。

③使用了动态点云增强器,一种策略用于原始点云利用一致性和对比正则化的变换进行点云增强,不是一个用来进行点云特征增强的结构,且相比于以前的随机扰动、旋转等策略,能够针对不同点云有着更好的增强。

网络架构/损失函数

实际上是一个损失策略框架用于无监督的训练点云分割网络。首先是一致性损失,用来使经过了点云增强器的两个点云的点特征一样,达到鲁棒的目的;其次是三个对比损失,第一个是点对比损失,对于某点和他对应的增强点云中点特征相似,和其他点特征不相似达到点级别的拉进相似点拉远不相似点;第二个是局部对比损失,对于某点和他对应增强点云中该点k近邻的均值相似,和其他点k近邻的均值不相似,达到局部特征学习的目的;第三个是全局对比损失,首先计算所有有标记的点的嵌入按类区别的平均值也称作原型,然后对于每个点让其特征靠近自己的原型和其他人的原型远离;最终使用一个基于伪标签的多值交叉熵损失函数。伪标签由上一次的运行结果预测得到且最终在最大类的预测救过需要达到一个阈值才被选用,所以一开始是只使用少量的真实标签训练网络,然后过了一段时间后能被选择的标签开始出现,然后慢慢增加,最终趋于稳定。

其中点云增强器的网络架构如下

简单来说点云增强器就是对原来的所有点进行一个线性变换,然后再加上偏移量,也就是WX+b,这里的X为N*3,W为N*N,b为N*3,其中W和b的形成首先对原始点云进行MLP映射到高纬度空间中,然后分为两个分支,一个用于产生变换一个用于产生偏移,在这个高纬度空间中加入噪声,然后进行MLP还原到需要的维度。并进行点云增强。

损失函数如下图。

总:

一致性:

点级对比学习:

局部对比学习:

全局对比学习:

语义分割:

实验方法

数据集

S3DIS、ScanNetV2、Semantic3D、SemanticKITTI

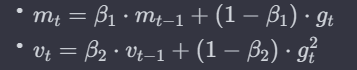

实验设置

adam,初始学习率α为0.001,动量β为0.9,具体公式如下图

100个epoch,K=16,batchsize=6,很奇怪,后面又提到了一次初始学习率为0.01,衰减率为0.98,一个epoch分500次把所有数据遍历一遍。

评价指标

mIoU,此外弱标签的方法使用了两种1pt(一个类别一个点)和1%(每个类别1%的点)。本文也尝试了使用完全监督的标签进行实验。

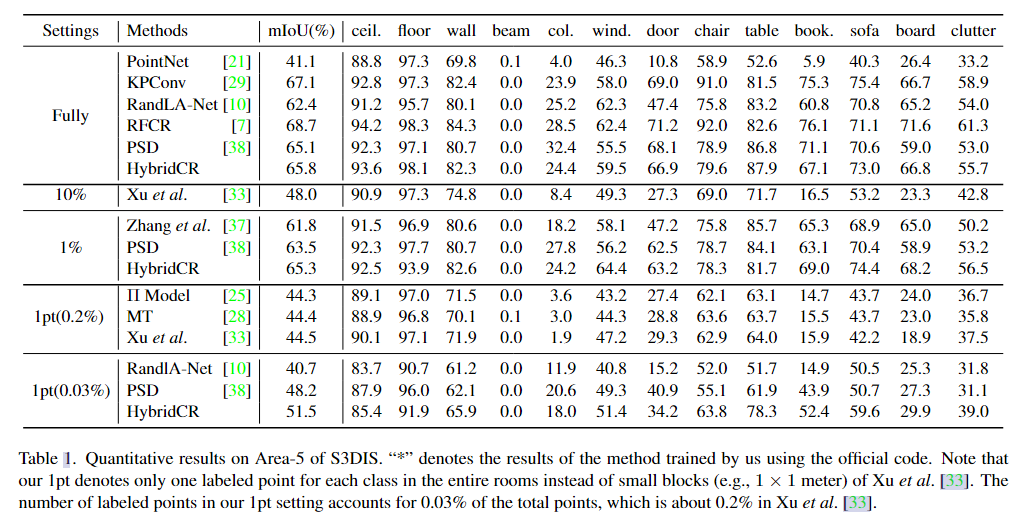

实验结果

S3DIS和ScanNet-V2

S3DIS中的5区域。

在完全监督下,HybridCR与其他方法(例如Zhang et al., PSD, Π Model, MT, Xu et al., RandLA-Net)在S3DIS Area-5数据集上进行了比较。在1pt(每个类别一个点的标签)和1%(每个类别1%的点被标记)的设置下,HybridCR实现了最高的平均交并比(mIoU)。例如,在1pt设置下,HybridCR的性能比PSD高出3.3%,比RandLA-Net高出10.8%。在1pt下HybridCR在“椅子”、“桌子”和“沙发”类别上分别比PSD提高了8.7%,16.4%和8.9%。在1%的设置下,HybridCR比PSD基线高出1.8%的mIoU,并且在10%的设置下甚至超过了Xu et al.

HybridCR通过添加所提出的混合对比正则化,从大规模点云数据中学习多样的几何结构。即使只使用1%的点标签,HybridCR的性能也超过了全监督的RandLA-Net和PSD。

为了公平比较,我们还在 S3DIS 中的6-Fold上的其他方法的比较,其结果如表2中所示

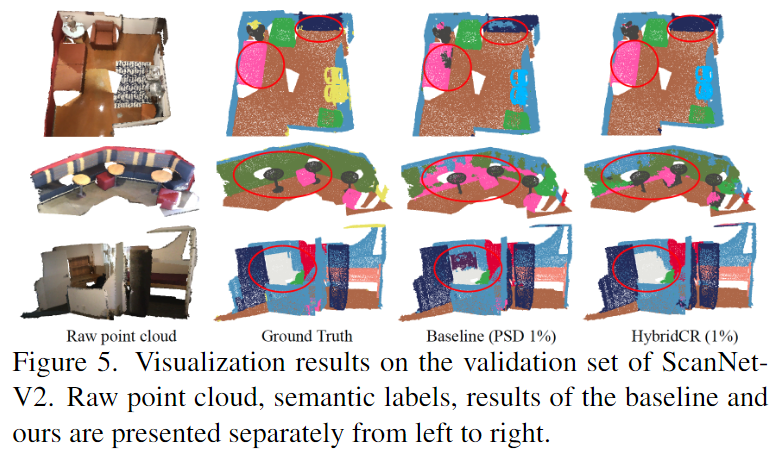

对于ScanNet-V2,与基于场景/子云级注释的WyPR[23]和MPRM[31]相比,HybridCR在测试集上1%设置下获得了最高的mIoU为56.8%。同时,HybridCR 在相同数量的标签注释下实现了 5.7% 的 mIoU 增益。此外,我们的方法在完全监督的情况下比 RandLA-Net 获得了 2.1% 的 mIoU 增益。

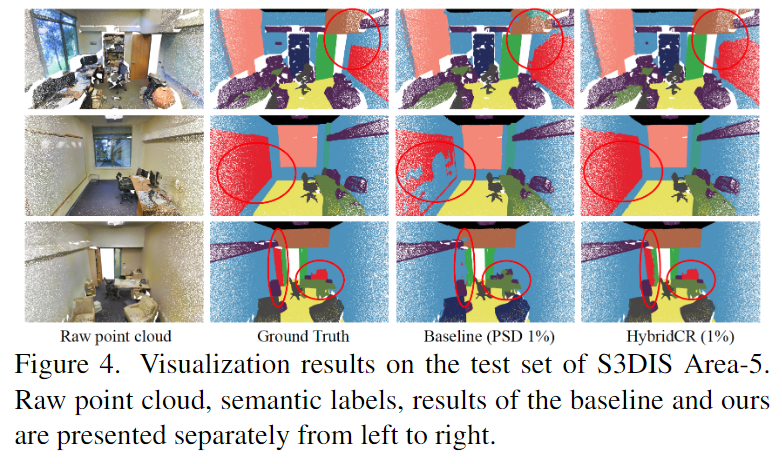

定性结果分析如下图

在S3DIS数据集上,HybridCR在“板”(board)和“椅子”(chair)的分割上比PSD(另一种方法)表现更好。

HybridCR的分割结果与真实情况(ground-truth)非常一致。这意味着HybridCR能够准确地识别和分割出不同的物体和结构。

在ScanNet-V2数据集上,HybridCR同样表现出良好且真实的分割结果。特别是在“沙发”(sofa)和“书桌”(desk)的分割上,HybridCR相比于PSD有更好的表现。本文认为可能是因为HybridCR可以有效地利用动态点云增强器生成的不同变换来提高表示能力,提高分割性能。

Semantic3D和SemanticKITTI

结果还是在表2中

在Semantic3D (reduced-8)数据集上,HybridCR在1%标签设置下与其他方法(如Zhang et al.和PSD)相比,展现了更好的性能。相较于Zhang et al.和PSD,HybridCR在平均交并比(mIoU)上分别提高了4.2%和1.0%。这表明HybridCR在处理有限标签的情况下依然能够实现较高的分割精度。

在SemanticKITTI数据集上,HybridCR在1%标签设置下在验证集和测试集上分别达到了51.9%和52.3%的mIoU。这说明HybridCR在这个数据集上也展现了良好的性能,特别是在有限标签的条件下。

可视化结果如下图

在Semantic3D数据集上,HybridCR方法相比PSD(一种其他的点云处理方法)有所提升,特别是在对“建筑物”(buildings)的精确分割方面表现得更为出色。

在SemanticKITTI数据集上,HybridCR方法展现了与真实情况(ground-truth)非常一致的分割结果。特别是在识别和分割“道路”(road)和“汽车”(car)这两类,在室外稀疏场景中难以区分但在自动驾驶应用中非常关键的对象上,HybridCR表现出色。

消融实验

动态点云增强器+局部对比学习+全局对比学习

①比较1和2,可以发现,在1pt和1%的数据量的情况下,分别增加了2.5%和1%;比较5和8,增加了0.4和0.3,说明了确实在数据不丰富的条件下能够从动态点云增强器中学到鲁棒性。

②局部对比学习,从 1pt 和 1% 设置下 #1 和 #3 之间的比较来看,它在 mIoU 上比 Base 高 1.6% 和 0.4%。对于 #7 和 #8,它比 HybridCR 分别提高了 0.5% 和 0.2%。这些结果表明,Local。进一步提高了性能,因为它在模型训练期间利用了相邻信息,同时增强了特征学习。

③同样,从 #1 和 #4 的比较来看,它优于 Base。在 1pt 和 1% 设置的设置下,分别提高了 2.0% 和 0.5%。对于 #6 和 #8,它比 HybridCR 分别提高了 1.3% 和 0.6%。结果表明,Global。有效地提高了弱监督语义分割任务与类原型的性能。

我的分析,对于上表的综合查看,同时对比1,2,5,8,4,7,3,6可以发现,在没有局部对比学习以及全局对比学习的损失加持下,是有着更加高的提升的,其实可以知道,三者的功能在一定的程度上是有所重合的,可能都有一部分是帮助网络学习点波动等影响的鲁棒性。同时可以发现,相比于Local和Global来说,Aug的提升是更加大的。且重合的情况来说Local和Aug重合的作用可能是更多的。三者大概率是这样的一个交叉图。

结果分析

可视化点嵌入

可以看到网络得到的特征的不同类别是各自聚成团的。但是在a图中是存在一些杂乱的点不小心搞混的,而在b图中则是比较标准的能够直接进行聚类得到准确分割结果的情况了。

真实标记点数量与性能关系图

c图中展现了关系图,可以看到对于HybridCR在1%的点的情况下基本已经达到了性能的瓶颈了,而PSD则还有这较大的提升,到了10%才能达到,且HybridCR能够在任何情况下比PSD的性能卓越。这说明了HybridCR不需要密集注释来获得有利的分割结果。

SCF-Net-2021-CVPR

SCF-Net Learning Spatial Contextual Features for Large-Scale Point Cloud Segmentation-CVPR-2021

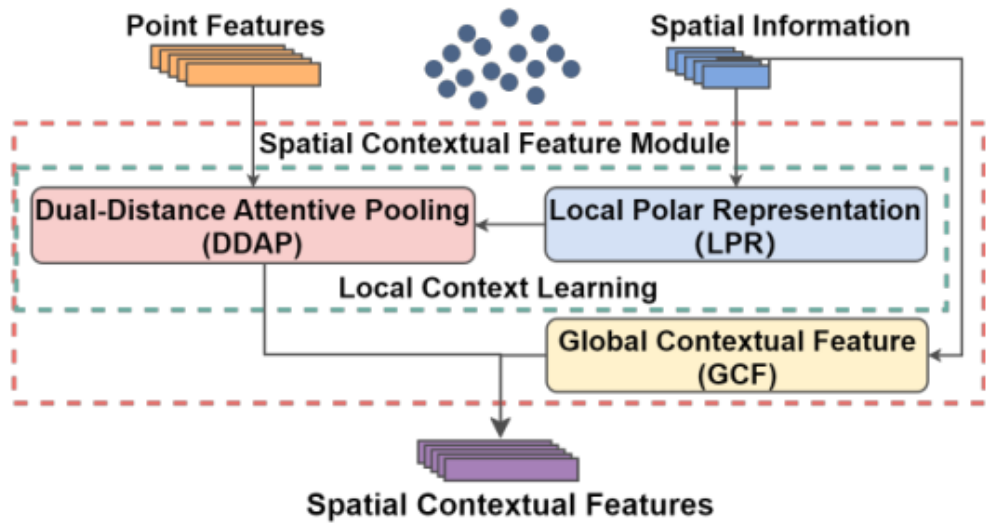

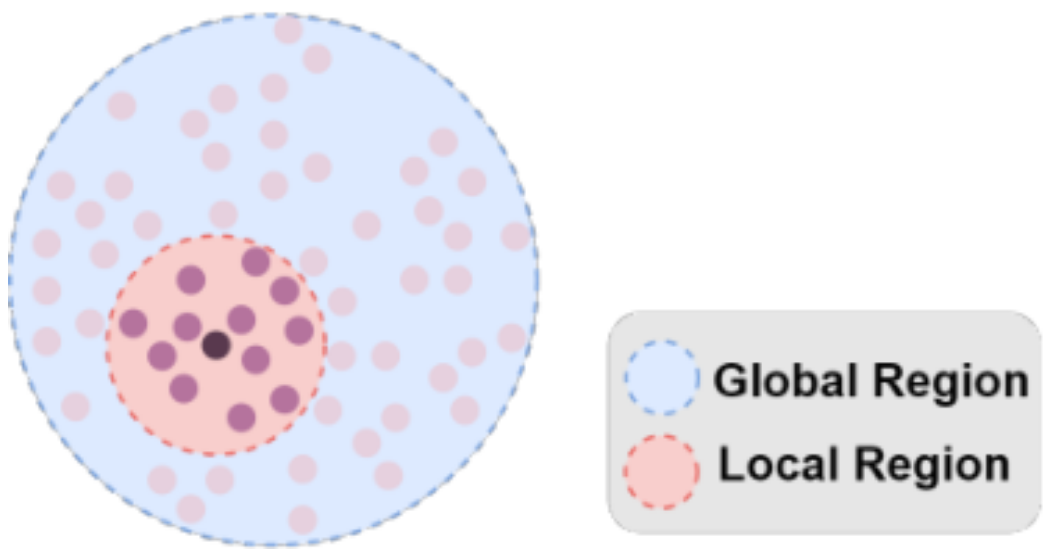

基于UNet的基础架构的点云分割网络,将下采样层中的模块换成SCF模块。SCF包括了三个子模块,第一子模块为局部极坐标表示,也就是将原始的笛卡尔系中的局部几何表示转变为局部极坐标表示,同时减去了该局部的一个大体方向相当于舍弃了局部的一些一致性的特征,得到更加具有区分度和细粒性的极坐标信息。第二个子模块为双距离注意力池化模块,对比于之前的注意力池化模块,一般都是直接采用了特征进行MLP得到特征的注意力,此时有着一些相似性的问题存在(具体在BAAF中讲过),在BAAF中,是利用特征计算几何位置的偏移量,然后再计算特征的偏移量后拼接进行池化。此处是将特征距离和几何距离以及特征进行拼接后进行MLP得到权重。可以看到的是两种方法在MLP之前的特征中都是会包含着特征本身的独特信息以及几何位置的信息进行MLP(称为自适应本身特征以及根据几何位置的独特性进行注意力分配),尽管具体的网络结构可能会存在差异。此时进行局部特征加权求和得到的特征称为该点的局部上下文特征。第三个子模块为全局上下文特征。使用该点k近邻形成的局部区域的球体积/整个点云的球体积作为该点的全局信息,这种信息对于同一类别的不同形状的物体有着一定的鲁棒性(比如大体大小相似但样式不同的椅子等),但是显然这种情况也会带来相似性的问题,因此本文在此基础上加上各点的位置信息进行一个特异化。将ri,xi,yi,zi进行拼接后通过MLP得到全局上下文特征和局部上下文特征拼接作为输出特征。

提出的原因

①为了解决对于方向变化敏感的问题,本文提出了LPR,局部极坐标表示(类似于配准中的LRF框架的作用),对每一个点构建了关于z轴旋转不变的表示,这个在点云变化检测中我觉得效果不大,当然这种旋转不变的表示能够让网络更加的鲁棒以及学到的特征表示更具有代表性,就比如对于抖动的鲁棒性,那么就可以确认产生不同特征的原始是由于高层语义或者一些东西的变化而产生的,而不是由于一些无关因素(你所鲁棒的对象)所导致的。

②本文认为过去的网络对于局部上下文以及全局上下文信息的提取和整合是不那么有效的。

网络架构

UNet的基本架构,其中下采样块使用SCF进行。

SCF包括三个模块,一个是局部极坐标表示模块用于产生对z轴旋转不敏感的特征。第二个模块是双距离注意力池化模块,用于提取局部特征。第三个模块是全局上下文特征。用于产生能够看见整个点云的特征。

LPR模块,只处理几何信息,①首先将该点和k近邻的点的中心点作差,产生一个和xy平面的角度以及和xz平面的角度。②对k近邻的所有点都作差计算这两个角度后,将②的结果减去①的结果,得到了关于z轴旋转不变的位置信息特征。③计算对k近邻的距离。将①②合成的结果和③进行拼接,可以得到z轴旋转不变的极坐标表示。

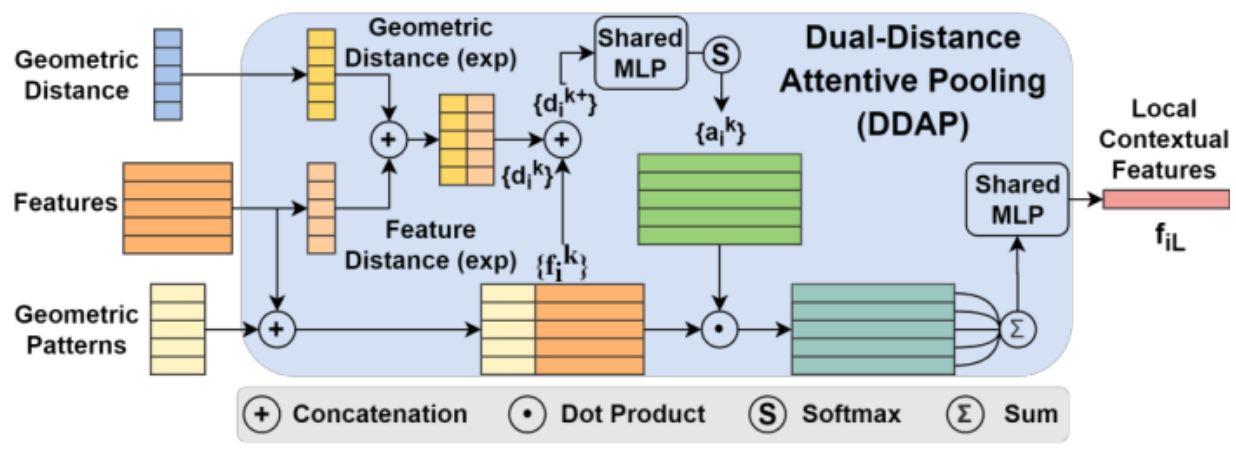

DDAP模块,首先对局部极坐标表示进行MLP,得到几何模式特征作为输入,以及特征输入和几何距离输入。该模块是一个局部注意力池化模块。那么注意力应该如何得来。本文使用了特征距离以及几何距离进行拼接,同时MLP去产生一个权重,但是这样得到的权重结果没有对特征进行一个自适应的分配(也就是没有看到特征的,即对于所有的差值一样的都会产生同样的结果),因此再加上特征进行拼接去进行权重的生成。此时的特征由原始特征和几何模式拼接得到。然后对局部的特征进行一个加权求和得到局部上下文特征fiL

GCF模块,该模块主要是通过邻域的球体体积和整个点云的球体体积的比得到一个全局的信息。但是考虑到一些独特性,拼接上了该点的几何位置坐标,然后进行MLP得到具有位置独特信息的全局上下文特征fiG。

将局部特征以及全局特征进行拼接后作为SCF输出的特征。

随机下采样,点数量从N到N/512,维度从8(首先利用MLP将特征从d到8)到512,最近邻插值进行上采样。在decoder结果使用三个连续的全连接层来预测语义标签。交叉熵损失函数用于训练。

实验方法

数据集

S3DIS、Semantic3D

实验设置

adam,初始学习率为0.01,batchsize分别为4和3,训练100epoch,每个epoch进行5%的衰减。k=16,从每个训练点云中先固定采样数量的点为1e5,进行训练,每个点由3D坐标以及颜色信息表示。

实验结果

S3DIS

6倍交叉验证法,评价指标mIoU、mAcc、OA。

可以看到,在这三个评价指标上都是最优的。在每个类别中的mIoU中在房梁、板子以及杂物上达到了最优性能。

可视化结果如下图

室内场景的语义分割通常较为困难,因为某些类别难以区分,例如白色的墙上的白色板。本文的方法在板类上表现良好(可以看到白板的结果基本都能识别),这从定量和定性结果中都可以看出。尽管如此,误分类仍然不可避免。例如,在图7的中间行展示的会议室场景中,中央区域的桌子被错误地分类为书架。

Semantic3D

可以看到mIoU具有最优性能,但是在OA上只有第二的性能,不过和第一的RandLA-Net相差较小。在Car类上达到了最佳性能。

可视化结果如下图

由于真值无法获取,只有预测的结果。通过混淆矩阵可以发现。大部分的错误来源于硬质景观和低矮植被类别,其中容易把低矮植被分类成高植被,把硬质景观分类为建筑、人工制品。事实上这些从直观上也是容易产生混淆的类别。

消融实验

在SCF中的消融

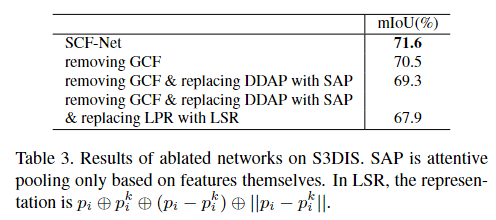

分为去除GCF的①,在①的基础上用SAP替换DDAP的②,在②的基础上用LSR替换LPR的③,其中SAP为直接使用特征进行MLP得到权重并进行加权求和,LSR为直接使用pi,pj,pi-pj,|pi-pj|,(都是RandLA-Net中的)

通过表中性能分析,可以看到全局的GCF引入确实能够给网络带兼顾全局上下文的能力。达到了设计的目的,且有着较大的提升。同时DDAP被替换为SAP的结果也可以看到,DDAP相对于SAP考虑到了几何距离以及几何模式的卓越性。同时能够证明这种优越性确实是由网络结构所带来的,而不是参数的堆积导致的模型功能的强大。相比于其他的模块,带来了最大的提升。这说明了相比于直接堆积的LSR特征来说,LPR能够更加深层次的挖掘出几何位置所带来的信息。并和局部特征进行融合,产生更加具有分辨能力的模型。

本文的解释:LPR和LSR都明确地编码了距离信息,但它们在表示相对位置时的方法不同。在LSR中,相对位置用笛卡尔坐标表示;而在LPR中,它表示为相对于局部方向的相对角度,这对于z轴旋转不敏感。

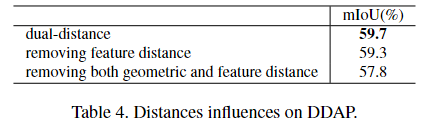

DDAP模块中的消融

①进行距离种类的消融

在mIoU最低的点云片段中进行性能的评估,结果显示,移除特征距离导致分割性能下降了0.4%,而移除几何距离导致性能下降了1.5%。这证明了双距离策略的有效性,并且表明几何距离在空间上下文特征中的重要性更大。

②双距离特征的连接方式

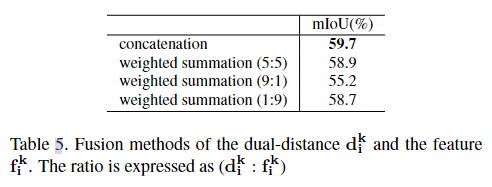

拼接以及加权求和。加权求和考虑了三种不同的权重比。实验结果显示,连接方法优于加权求和,其中5:5的加权求和在三种比例中表现最佳,证明了dk_i和fk_i两者的有效性。

③拼接时的特征距离的权重

可以看到0.1是一个普适的选择。

AF-GCN-2023-CVPR

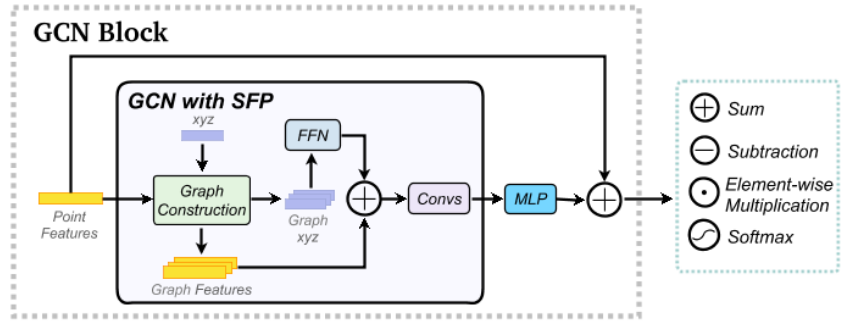

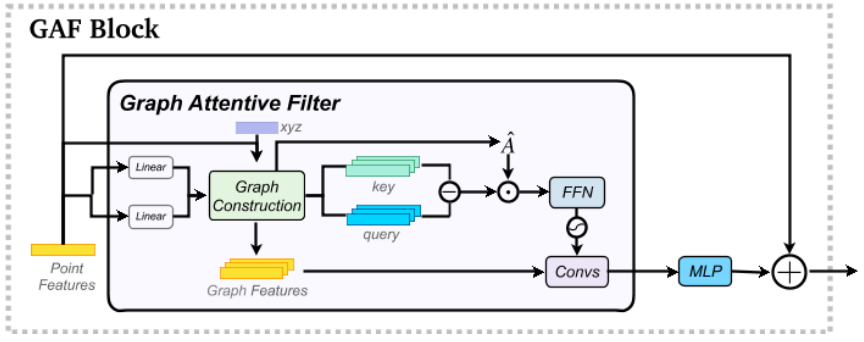

同样的UNet的架构,将下采样层中的模块低层换成GCN,深层换成了GAF,同样是在局部邻域中进行一个加权分配,同样是考虑到位置信息的影响进行权重计算,相比于之前的只用使用MLP进行权重的估计,本文中类比注意力机制的模块,结合了特征相似度以及几何空间进行权重的估计(之前的是直接将特征和空间位置进行结合等比较粗浅的糅合方法)。在GCN中,对某点来说,首先找到k近邻的点,将这些点的xyz坐标利用前馈神经网络投影到对应的特征维度,然后和特征进行相加的操作后,再进行图卷积的操作,这样相比于之前的直接将几何位置和特征拼接作为新特征进行图卷积的操作,这种方法始终保持着对几何特征的重视程度,而之前的方法随着特征维度的上升,几何特征的重视程度不断下降,这个是GCN的一个创新点。在GAF中,该模块类比于注意力的操作在于同样是尝试把注意力(权重)放在具有特征相似度的模块上(之前的方法是没有考虑特征相似度的),首先对特征通过两个线性映射投影得到新的两个特征k,q,进行差值得到相似度差异矩阵(注意力是内积得到差异矩阵),同时计算对数距离矩阵,然后逐点和相似度差异矩阵做内积,得到糅合了相似度信息以及局部邻域信息的矩阵进行FFN后softmax得到权重矩阵,相比于注意力中再次线性投影得到v,然后加权求和来说,本文中是直接加权求和,因此该模块中参数量下降1/3左右。通过这些论文的阅读,可以发现,貌似都是在寻求怎么样对深度特征以及几何特征进行更好的结合。本文的消融实验说明了深度的特征中对于几何特征的需求实际上是较大的(什么都没有直接加上SFP和只没有SFP加上SFP带来的增益由1.1%->1.9%),我可能会想着在网络中深处加上几何信息去进行一个特征的提取。

提出的原因

①由于自注意力机制通常将权重放在具有相似特征的点上,而在低级特征中,局部邻域的点通常相似性较低,这就会导致自注意力机制形成的特征对于局部信息的提取不好。而过去的论文如果使用Transformer模块提取网络则不分阶段的使用。

②对于逐渐增加的特征维度,之前的动态图生成(如DGCNN)的方法导致几何位置信息的权重逐渐降低,但是几何位置信息实际上是必不可少的,因此本文提出了一种新的图卷积方式的特征提取网络。

网络架构

整体采用UNet的架构,在低层次的特征以及decoder中使用GCN进行特征提取,在深层次的特征中使用GAF进行特征提取。

GCN模块相比于之前的基于图卷积的方法不同,GCN更加注重几何坐标的信息,对于某点来说,找到k近邻特征及坐标,将坐标利用FFN投影到和特征同一维度的特征空间中,然后两者相加再卷积加权MLP得到输出特征。

GAF模块模拟自注意力机制,尝试把注意力放在和特征相似度较大的点上,但是相比于简单的自注意力机制,考虑到了局部邻域位置信息。首先将特征进行两个线性投影得到两个特征,然后作差得到特征差异矩阵,这个矩阵代表着特征相似度信息,同时计算距离矩阵取对数得到局部邻域信息,通过逐元素乘积得到杂糅了两个信息的新的矩阵,投入到FFN后softmax得到注意力矩阵,对k近邻特征进行加权求和后MLP得到该点的输出特征。

对于上采样下采样层的操作,在下采样中,采样后的点找k近邻是在采样前的点中找的。在上采样中,对于某点,找到上一层中谁把他当成了k近邻,然后对于该点的所有这些点特征进行均值得到该点特征。对于一些空的点,就使用三线性插值得到空点的特征。

网络的架构,四个阶段[2,4,2,2]块,前两个阶段称为低级特征学习阶段,后两个特征为高级特征学习阶段,初始特征维度为32,分割头为简单的MLP。还构建了一个大版本,初始维度为64,块数为[3,6,3,3]

实验方法

数据集

零件分割:ShapeNetPart,语义分割:S3DIS,ScanNetV2,Toronto-3D

实验结果

零件分割

我们从ShapeNetPart中的每个形状中采样2048个点。初始半径r设为0.1m,每次降采样后半径r增大2.5倍。最大边数K设置为32。我们在四个NVIDIA GeForce RTX3090 gpu上训练了300个epoch的模型。

定量和定性结果如上图。

语义分割

对于S3DIS,输入点按照之前的工作[58]进行网格采样,网格大小设置为0.04m。每个阶段的采样率设置为4。初始半径r设为0.1m,每次下采样后半径r加倍。对于ScanNetV2,输入点是网格采样,网格大小设置为0.02m。初始半径r设为0.05m。对于上面提到的所有数据集,最大边数K设置为32。我们的模型在四个NVIDIA GeForce RTX3090 gpu上进行了100次epoch的训练。

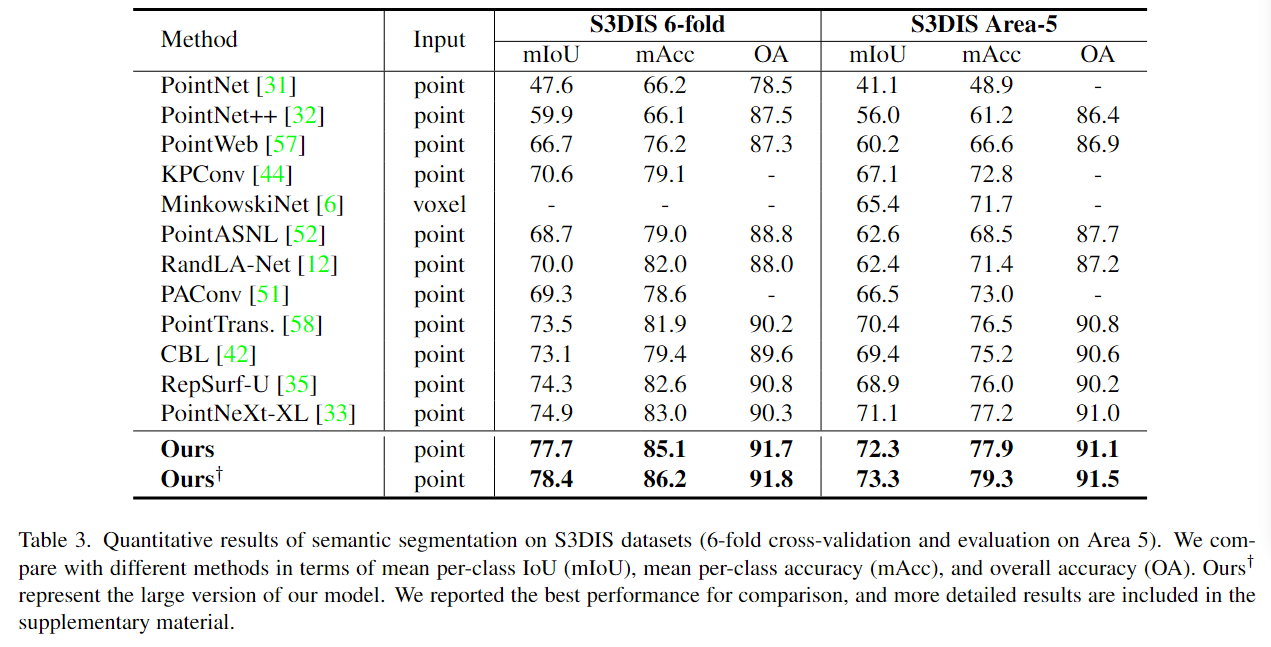

对于S3DIS:使用6折交叉验证(6-fold cross-validation)和Area-5测试来评估AF-GCN模型。在S3DIS的Area-5和6折交叉验证上,AF-GCN模型的性能超过了先前的方法。模型的大型版本(large version)在这些测试中也显示出良好的性能,表明AF-GCN在参数较多的情况下有潜力。

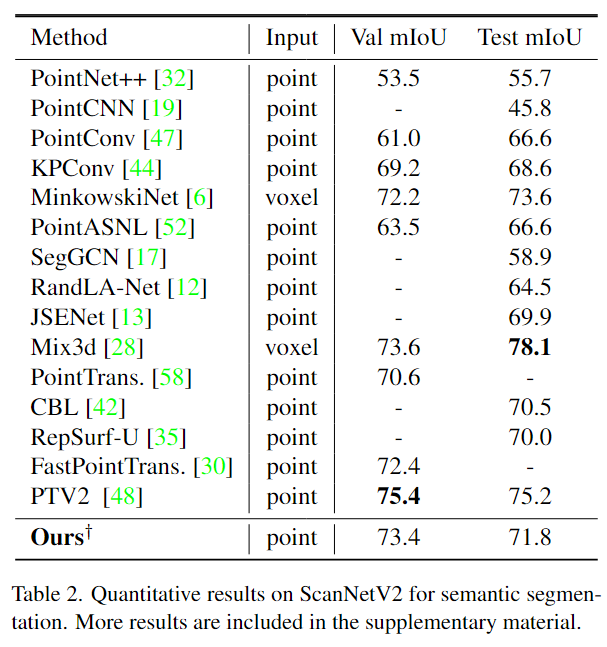

对于ScanNetV2:在ScanNetV2数据集上进行了广泛的实验来展示AF-GCN的泛化能力。在ScanNetV2的官方验证集和在线测试集上,AF-GCN模型取得了合理的结果,并且性能超过了大多数基于点的方法。尽管PTV2方法在使用基于划分的池化(partition-based pooling)和精心设计的变换网络(transformer networks)方面表现更佳,但它需要更长的训练时间和更大的训练输入。

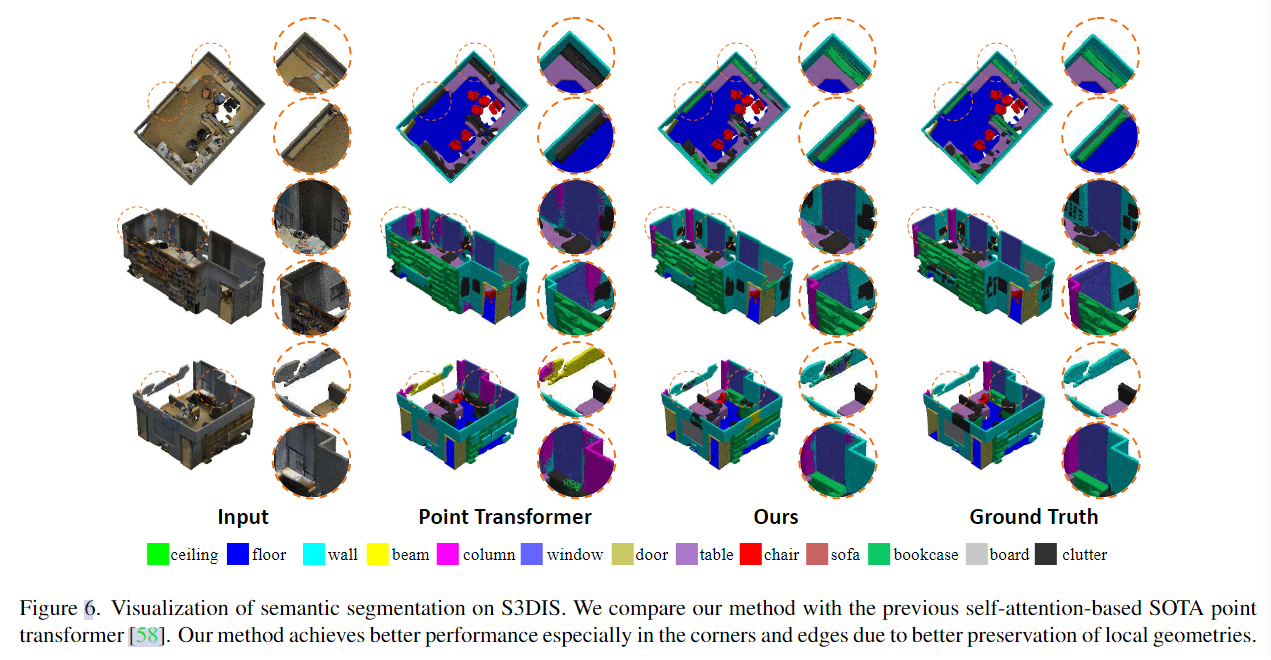

可视化结果如下图。

鲁棒性评估

在不同的抖动,旋转下都有着最佳的性能,这其实来源于图卷积结构对于旋转的鲁棒性。当然,本文中的网络对点特征提取并不是旋转不变的,这主要来自于在网络中直接使用到坐标的一些操作,比如SFP、以及三线性插值可能存在的问题。

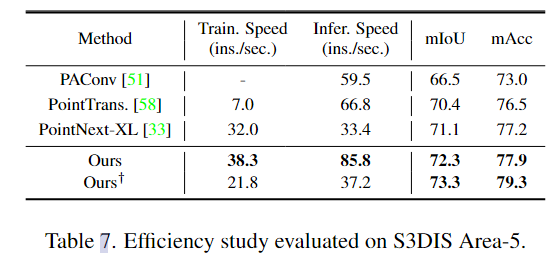

效率测试

表7中展示了与之前的方法如PAConv[51]、PointTransformer[58]和PointNext-XL[33]的训练速度和推理速度的比较。我们采用16×15,000点来评估NVIDIA GeForce RTX3090 GPU中的推理速度。请注意,我们的方法在推理方面比Point Transformer快28.4%,在训练方面快约5倍,而大版本的推理速度与PointNext-XL相当。主要的快捷来自于Transformer中的大量计算,而本文中使用了差值替代点积,以及在深处才使用注意力机制。

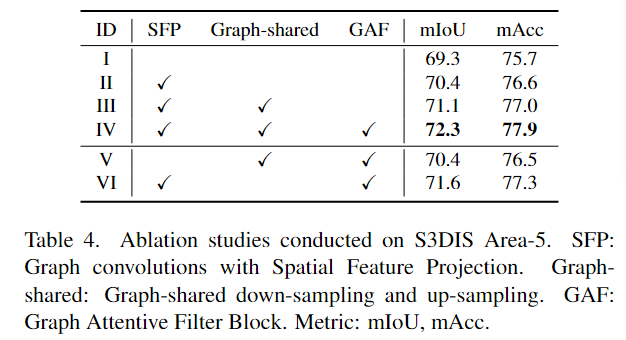

消融实验

①使用SFP(空间特征投影)+②上下采样的图共享机制+③GAF(图注意力过滤)

①从上述的结果表中,可以看到虽然单个的SFP加的并不多,只加了1.1%的mIoU以及0.9%的mAcc,但是实际上后面的两个模块都是基于SFP(查看后面的实验结果的话会发现实际上就是GAF对于SFP最看重了)才能有好的发挥的,在后两个加上的情况下,加上SFP模块,增加了1.9%mIoU以及1.4%的mAcc,这说明了设计的架构是并不是简单的堆叠产生了好的结果,而是互相之间通过了巧妙的互补达到了1+1>2的效果。考虑到GAF模块使用了距离以及特征差异模块进行,而SFP模块相当于加大了位置信息的权重,那么是否是GAF中对于距离的利用不够呢?可以尝试一下能不能在没有SFP的情况下把GAF中的位置信息更加充分的利用。

②对比实验二和实验三,我们发现采用图共享下采样和上采样可以提供0.7% mIoU和0.4% mAcc的性能增益。对比实验IV和实验VI,我们的方法在没有图共享下采样和上采样的情况下,性能损失了0.7% mIoU和0.6% mAcc。请注意,使用图共享的下采样和上采样,我们模型的参数只增加了大约4%的参数(0.35M)。

③为了更加明确的消融该模块,设计了从不同阶段开始使用GAF的消融实验。可以发现,确实应该在深处使用GAF才能有更好的一个性能。

Pyramid-2022-CVPR

Pyramid Architecture for Multi-Scale Processing in Point Cloud Segmentation-CVPR-2022

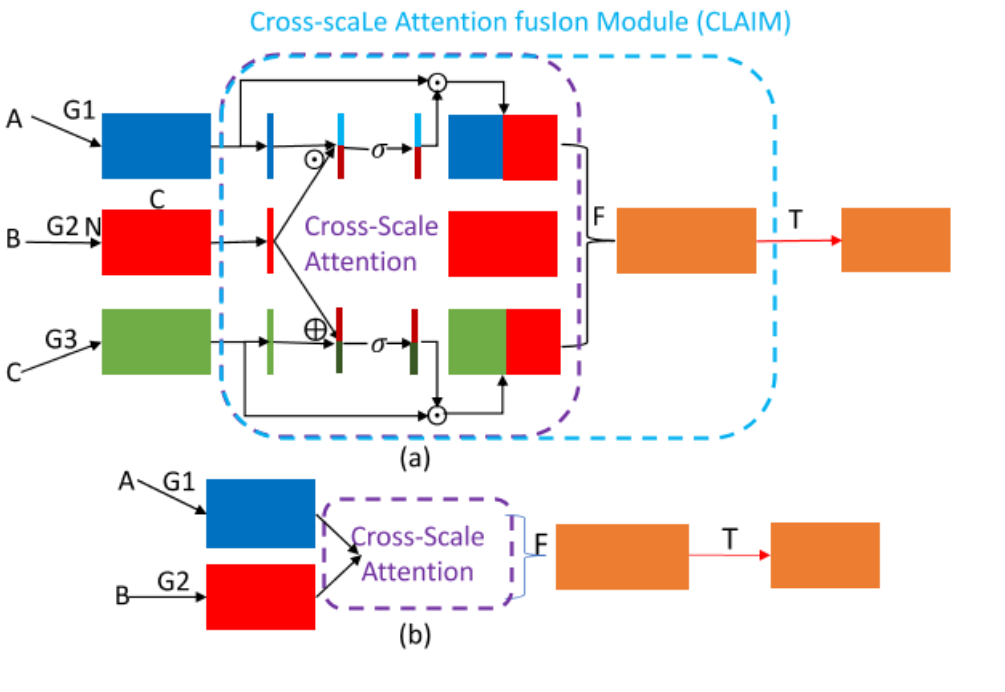

这是一种新的网络架构,我觉得是在UNet++上进行修改的,相比于UNet++的情况,本文为每个节点增加了一个特征从高分辨率到低分辨率的情况,因此每个节点包括了三个尺度的来源,分别是从高分辨率带来的清晰细节特征A,同一分辨率带来的聚合的特征B以及低分辨率带来的高级语义特征C,本文使用CLAIM模块去更有效的融合这三个模块(以前不注重这里,通常是简单的拼接,逐元素求和、乘积等),首先考虑到C的高级语义,直观上将B和C逐元素乘积(乘积能够突出两个特征的共同强调的语义,但是可能会抑制一些独特的特征,比如B中某点特征弱,导致最终结果也弱),因此并不直接作为结果输出,而是sigmoid后作为权重和C进行注意力的结果作为输出C‘,对于清晰细节A来说,将B和A进行逐元素求和(但是低分辨率的特征可能会平滑掉高分辨率中的细节和边缘信息),因此同样进行sigmoid后作为权重和A进行注意力的结果作为输出A’,(上述的逐点操作首先先对A、B、C特征压缩到特征为1维的情况下进行)并和B进行拼接后mlp进行特征维度降维度输出最终的 多尺度融合的特征。这种模块通过对高分辨率、低分辨率的特性进行分析帮助网络免去复杂的参数去得到注意力权重(可以类比于使用手工的特征去作为网络的输入),这种网络架构可以和轻易的用在现有的一些网络中(如KPConv,RandLA-Net),其实我觉得最大的创新可能就是这种三向特征流动的结构以及多尺度融合的方法,并且能够很好的将这两种情况结合起来,这种三向流动的结构势必带来一个较大的网络参数,因此在多尺度融合时,通过对不同尺度特性的分析,然后利用直接的计算操作去避免了过多参数的使用保证整个网络参数的适当。最终在当前的一些比较好的网络中有显著的提升。

提出的原因

①过去的一些网络专注于网络模块的构建,而非网络架构的构建,仅仅使用UNet的基本网络架构,这导致了特征的单向流动过程,而这种单向流动的特征实际上会较大程度上的限制点云数据的非规则的理解能力。

网络架构

本文提出了类似于UNet++充分进行多尺度上下文融合的方法进行。对于一个结点来说,包括了三个方向的特征,①是低分辨率尺度mlp上采样得到的,②是低分辨率尺度mlp下采样得到的,③是同一分辨率尺度使用特征提取方法得到的。

对于这三个尺度的特征进行融合,对于①有着更加高级的上下文语义,对于③有着更加清晰的细节信息。因此这个多尺度融合模块需要能够保留①中高级上下文语义的同时保留③中的清晰细节,那么直接拼接是否可行,显然如果直接拼接则意味着本文平等的认为A,B,C中的所有特征都是一样重要的,虽然可行,但是势必会带来性能的下降,因此本文使用注意力机制去对A和C中的特征进行有选择的关注,对于A来说,想要他的高级语义,因此直观上尝试使用乘积的结果去得到注意力,表示着A和B着两个尺度同时对什么地方有着更加突出的意义。然后将A*B进行sigmoid函数后作用在A上表示对A的注意力作用结果,同理对C也是,只是将乘积的操作改成了求和,这样子有利于保护C中的细节。将着两个注意力后的AC和B特征进行拼接然后mlp改变输出特征的维度,就能够得到多尺度特征的融合结果。

实验方法

数据集

PL3D:NPM3D挑战赛中的一个户外移动扫描数据集。它包含超过2公里的4个不同城市的街道,并且是一个在线基准测试。该数据集有1.6亿个点,被标注为10个语义类别,其中3000万点来自三个城市,作为测试集。

S3DIS、Semantic3D

实验设置

KPConv的基线进行修改,仅仅修改了网络架构,对于模块的参数并没有进行修改。比如例如K = 15、Σ = 1.0和ρ = 5.0。卷积半径的设置与KPConv在这三个数据集上的设置完全相同。第一个子采样单元的大小dl0由数据集决定,而后续的每个子采样单元大小dlj+1是前一个的两倍。

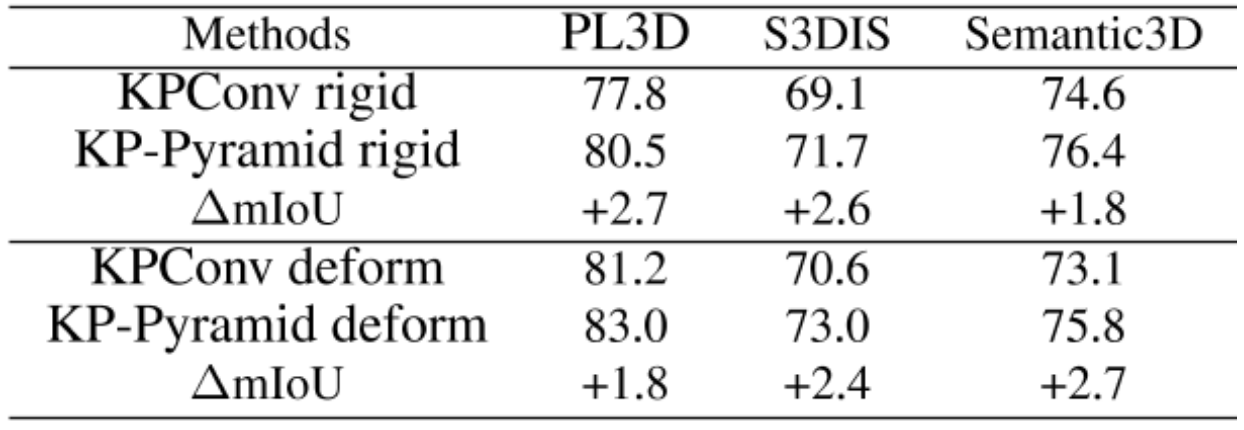

实验结果

和KPConv的UNet版本比较

实验结果表明,在所有数据集上,加入金字塔结构以处理和融合多尺度信息的网络性能都有所提升。在NPM3D数据集上,金字塔结构平均提供了超过2.2个mIoU(平均交并比)点的性能增益。在S3DIS数据集上,性能增益高达2.7点。在Semantic3D数据集上,平均增益超过2.0点。这些实验结果表明,所提出的金字塔架构通过更好的多尺度处理和融合,显著提高了基线模型的性能。

消融实验

①金字塔流信息的消融+②多尺度融合模块的消融

①表格中显示,“+lateral”配置在mIoU(平均交并比)上提供了0.6点的改进,表明通过为每个尺度添加直接链接(更多“卷积”阶段)可以获得适度的增益。在具有横向链接的网络基础上,向下和向上的信息流都可以进一步提升网络性能。与向上信息流相比,向下信息流更有益,这证实了向高分辨率处理提供上下文信息更为重要。当网络同时具有向下和向上的链接时,可以获得更大的性能提升,证明了在所有处理步骤中(包括前向、向上和向下方向)具有信息流的优势。

②通过融合前转换、融合、融合后转换中使用不同的函数方法进行消融实验,其中S3SE表示堆叠ABC后师兄通道注意力机制进行增强,S2SES表示首先将AB堆叠后进行SE得到AB‘结果,将BC堆叠后进行SE得到BC’结果,然后将AB’BBC‘拼接。S3CBAM表示将ABC堆叠后使用空间、通道注意力去增强。

“IM+CLAIM+MLP”的组合提供了最高的分数。对于预融合变换,有趣的是IM在适当的融合(如CAT或CLAIM)后的表现优于MLP,这表明使用更复杂的模块可能不会有帮助,因为存在过拟合的风险。在特征融合方面,提出的CLAIM是一个好的选择,CAT是直接融合的另一种选择。值得注意的是,图像识别中广泛使用的注意力模块在点云分割中可能不会直接有效,因为它们更容易过拟合。CLAIM成功的关键之一在于其(几乎)无参数的设计。CLAIM的好处还在于,尺度A包含丰富的语义信息,适合大型对象的表示,而C包含更多的局部细节,适合小型对象和边界。对于后融合变换,使用局部聚合器作为特征聚合后的转换似乎不是一个好选择;通道层面的转换更有效。这与图像分割实践一致,其中在特征融合后通常使用1x1的卷积。

金字塔结构的效率

采用金字塔结构进行多尺度信息处理和融合,推理时间增加约11%。在推理时,内存增加了大约15%。实验结果验证了我们提出的金字塔结构的有效性,即使我们在金字塔内部增加了几个多尺度的处理和融合操作。如前所述,提高效率的一个关键是重用邻域半径查询。

与最先进的结果对比

本文的模型在NPM3D和S3DIS数据集上均显著超越了所有现有方法。在NPM3D上达到了83.0的平均交并比(mIoU),在S3DIS上达到了73.0,均刷新了流行基准的记录。在Semantic3D上,他们也提升了KPConv的性能,达到了76.4的mIoU。对于S3DIS的类别细节,在表4中提供了详细结果。

本文的方法没有“弱点”,即没有任何类别的准确率非常低。

在处理小物体(如书本)和大物体(如天花板、地板)方面都表现出色,无论是在室内还是室外环境。这证明了多尺度融合架构的优势。对小物体的良好性能归因于第一层中的高分辨率特征表示;而对大物体的良好性能则得益于金字塔架构的设计,它允许在各个阶段“向上”流动更丰富的信息,而不仅仅是在单个编码器路径上。

DSA-Net-2021-IJPRS

提出的原因

这是一篇2021年的论文了,可能提到的问题有些落后(老生常谈)了。

①在VHR图像中涉及到了低类间变异性(不同类的物体但是有着相似的结构等,比如不同类型的建筑,商业和住宅)和高类内变异性(相同的类别的物体但是由于个性化有着相差较大的外观,这两种是需要解决的问题),因此需要将各个阶段中提取的特征进行差异比较结合获得更好的信息保留效果。

②深度监督的方法一方面能够让深层的网络较快达到收敛,同时提高准确性。

网络架构

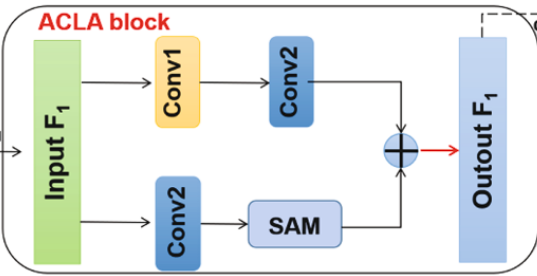

整体为伪Siamese UNet的架构,也就是说Encoder段的特征提取的权重是不同的,FEN模块包括三个子模块,首先进行跨步卷积模块提取特征,然后普通卷积,然后ACLA模块提取多层级特征并进行融合。将两个Encoder产生的特征图拼接后通过ASPP模块得到多尺度融合的特征。并通过decoder还原到原分辨率大小,在每一阶段中引入一个和最终层相同的结构产生变化检测图用于深度监督,通过每一阶段将encoder中的特征和decoder的特征通过ACon3拼接,整个跳跃连接和拼接的操作称为CLA-Con-SAM。

ACLA模块通过两个分支执行不同的卷积此时达到多层级融合的目的,一个分支使用两次卷积,另一分支使用一次卷积的同时使用空间注意力机制去注重变化的区域。

ASPP通过不同参数的卷积层达到多尺度融合的目的,四个分支中一个使用1*1,一个3*3的膨胀率为2的扩展卷积,一个膨胀率为4的扩展卷积以及一个池化上采样。将结果拼接后再次进行1*1的卷积进行融合操作。

ACon模块将两个encoder中的特征拼接后进行空间注意力进行得到输出结果。

实验方法

数据集

LEVIR-CD、WHU

评价指标:Pre、Recall、IoU、F1、Kappa、OA

对比的方法

FC-EF、FC-EF-res、ChangeNet(是一种结合了暹罗结构和反卷积的图像CD网络)、SegNet、UNet、Deeplabv3+

实验设置

1e-4初始学习率,30次以后乘0.1、权重衰减为1e-4,adam,batchsize=16,epoch=60,四个λ=0.2,0.2,0.2,0.4。

实验结果

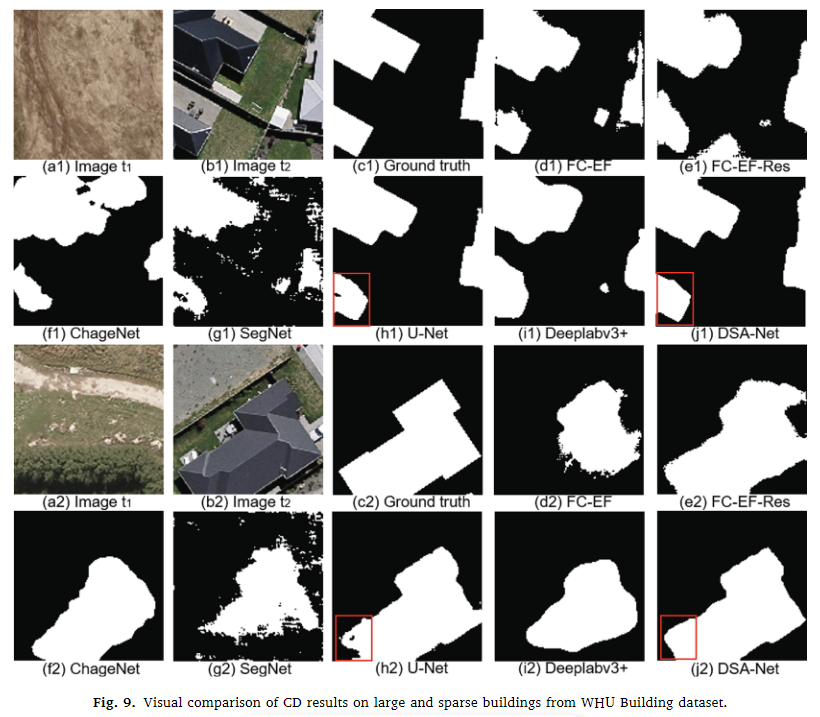

两个数据集中建筑实验结果分析

与其他方法相比,DSA-Net在减少误检和漏检方面取得了最佳的视觉效果。DSA-Net的结果与真实情况(ground truths)一致,变化区域的边界检测准确。其他方法如FC-EF、FC-EF-Res、ChangeNet和SegNet在未变化像素的分类上存在较多误差,导致建筑变化边界不准确。U-Net和DeepLabv3+结果中有很多漏检情况。DSA-Net取得了清晰的建筑边界、高内部紧凑性,并且漏检/误检较少。

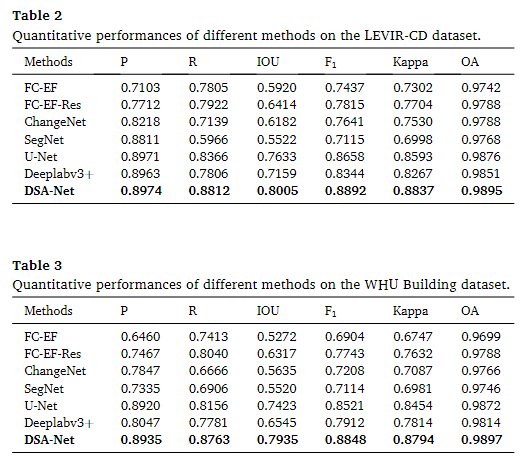

定量结果如下表

DSA-Net在所有评价指标中都处于领先地位,其中在LEVIR-CD数据集和WHU Building数据集上F1分别达到0.8892和0.8848。与其他竞争方法相比,DSA-Net在F1上的最大改进率分别为17.77%和19.44%。这种改进可以归因于它能够提取多层次和多尺度的特征,大大降低了变化像素的缺失率。

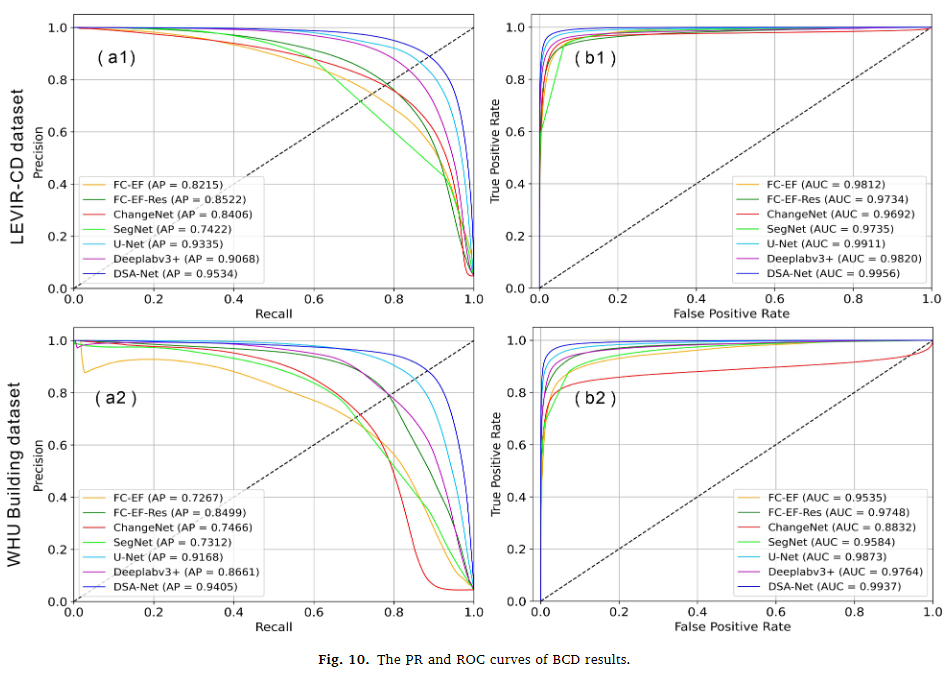

使用精确率-召回率(PR)曲线和接收者操作特征(ROC)曲线进一步比较模型性能。平均精度(AP)和曲线下面积(AUC)指标表明DSA-Net在这两个曲线下的面积最大,表明模型性能更佳,泛化能力更强。与其他方法相比,DSA-Net的ROC曲线与45度对角线偏离最大,AUC值最高。

在LEVIR-cd中的方法结果分析

具有较低的模型复杂度,训练速度最快(每周期约54秒)。没有跳跃连接(skip-connection),具有最差的收敛能力,F1分数最低(0.7115)。引入跳跃连接和残差块,F1比SegNet高7.00%。在所有竞争方法中达到最好的检测准确性,F1达到0.8658。具有高网络复杂度,参数数量为59.35M。在建筑变化检测(BCD)性能上表现最佳,输出损失最小(0.0298),F1最高(0.8892)。参数数量为38.53M,与U-Net相近,但远低于ChangeNet和DeepLabv3+。

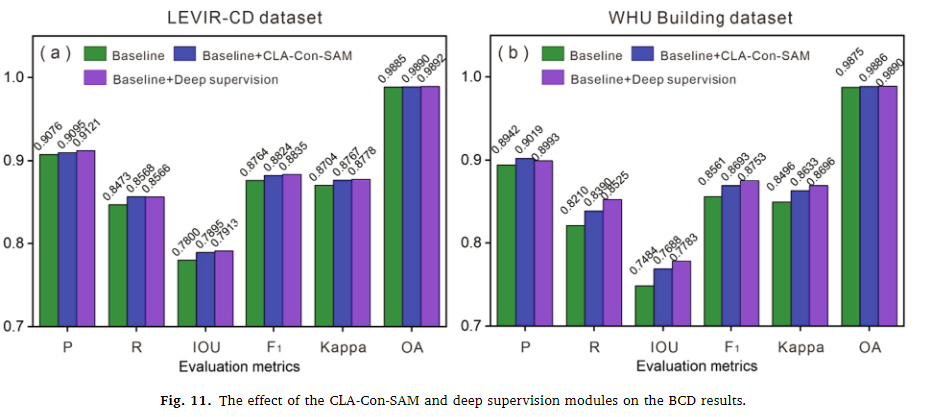

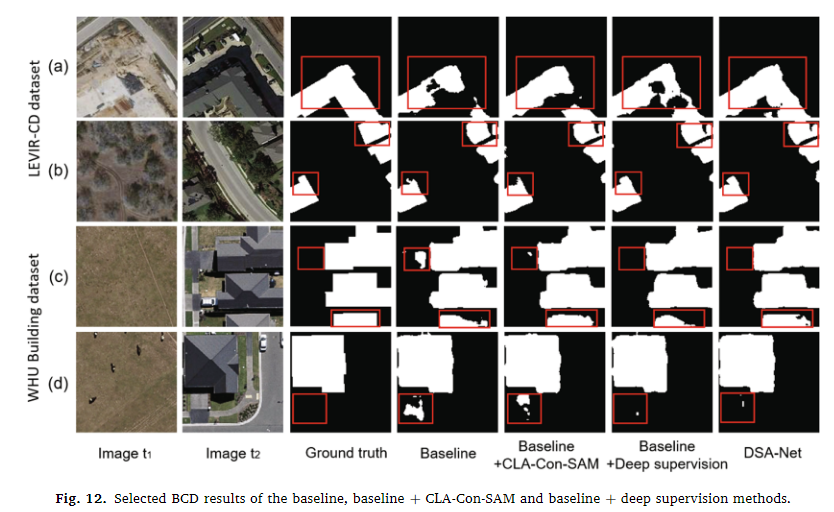

消融实验

①CLA-Con-SAM(ACLA和ACon块使用普通的3*3卷积和直接跳跃连接的方法替代)+②深度监督模块

实验结果显示,设计的CLA-Con-SAM和深度监督模块有效地提高了建筑变化检测(BCD)的准确度。引入CLA-Con-SAM模块后,在LEVIR-CD数据集上F1和Kappa分数分别提高了0.60%和0.63%,在WHU Building数据集上分别提高了1.32%和1.37%。当引入深度监督模块时,LEVIR-CD数据集上F1和Kappa的提升分别为0.71%和0.74%,WHU Building数据集上分别为1.92%和2.00%。

引入这些模块增加了变化像素的召回率(如图12(a)和(b)中的红色框所示)并减少了误检(如图12©和(d)中的红色框所示)。特别是,同时具有CLA-Con-SAM和深度监督模块的DSA-Net取得了最佳性能,表明这两个模块在提取有意义的特征和保留完整信息方面起着重要且相互关联的作用。

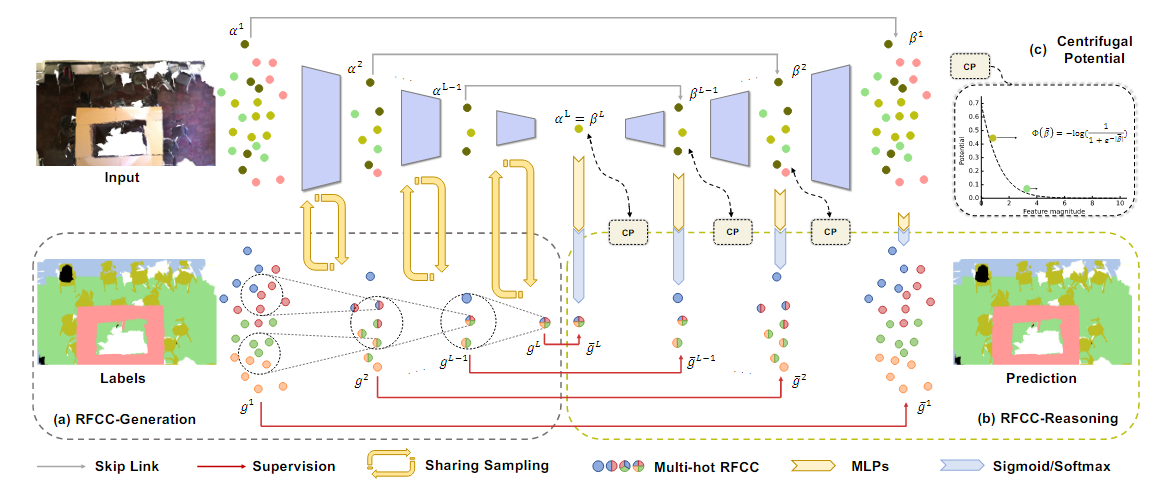

RFCR-2021-CVPR

提出的原因

①过去的网络通常只对最终的输出进行监督,而没有在一些中间层中进行多尺度的监督,导致最终网络的性能不高。

网络架构

本文主要提出一种全尺寸监督的网络架构,具体可以实施在各种不同的网络中,在Encoder中逐步下采样时,对于下采样后的点来说记录其上一层感受野中的点为什么类型称为RFCC,然后做并集,因此在一步一步采样后,对于最终的超点他包含了很多种类型,本文将整个decoder层认为是对特征进行由粗到细的一个渐进理解的过程,首先对于中间层只需要学到当前采样点的一个粗略的表示(很多类型,所以是一个粗的情况),然后随着decoder的还原,逐步从粗的情况中一步一步的把所有细节给理出来。

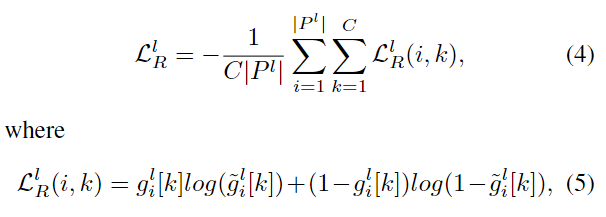

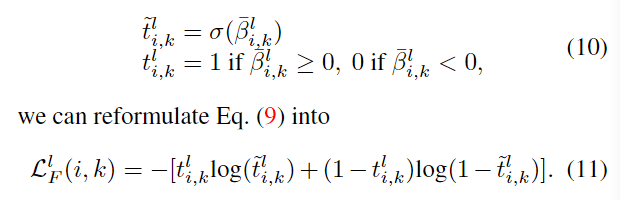

因此本文主要是添加了两个损失函数

一个是在全尺寸监督的损失函数,对于预测的结果进行多值交叉熵损失函数。

考虑到全尺寸监督的过程中引入的大量的监督,因此需要更多具有明确信号的主动特征。因此对于decoder中的每点的特征使用一个熵正则化损失函数进行监督,其目的在于让消极特征变小,让积极特征变大,从而达到去除模糊中间特征的。βi,k表示decoder中i点,k个通道的特征

实验方法

作用方法

deformable KPConv、rigid KPConv、RandLA、SceneEncoder

数据集

S3DIS、Semantic3D、ScanNet-V2

实验设置

选择deformable KPConv作为骨干网络在三个数据集上评估性能,

在ScanNet中选择deformable KPConv以及SceneEncoder作为骨干网络,KPConv训练从场景中随机采样半径为2m的球体,batchsize=10,SceneEncoder在训练场景中采样8个3*1.5*1.5m^3的立方体。

在S3DIS中选择deformable KPConv和RandLA作为骨干网络,KPConv同上,RandLA随机采样40960个点作为训练样本,batchsize=6。

在Semantic3D中选择deformable KPConv和rigid KPConv作为骨干网络,deformable的半径为3,rigid半径为4.

评价指标

mIoU

实验结果

ScanNet v2

相比于原本的KPConv提升了1.8%,KPConv在所有方法中达到了最佳性能。SceneEncoder提升了3.1%。

可视化结果如下图

可以看到加了全尺寸监督的方法在物体的完整度,正确性上都有着显著的改进。

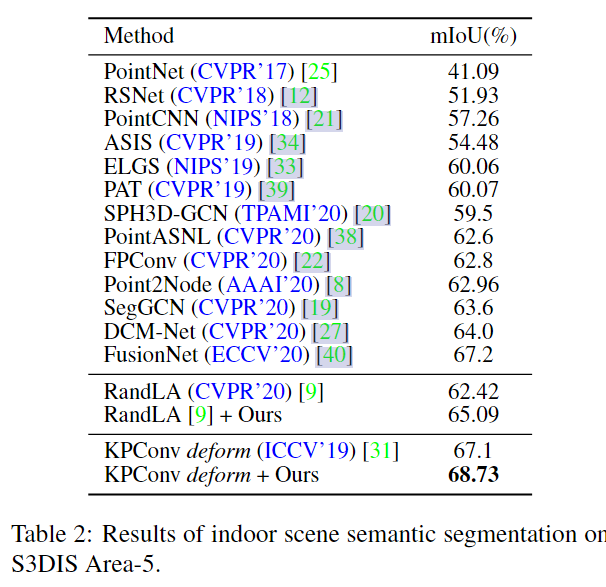

S3DIS

在S3DIS Area-5 [1] 数据集上,使用可变形KPConv作为骨干网络,所提方法在S3DIS Area-5任务中达到了68.73%的mIoU,推动了该领域的最先进性能。同样将可变形KPConv作为基线,并且还将方法应用于RandLA,mIoU提升了2.67%。

可视化结果如下图

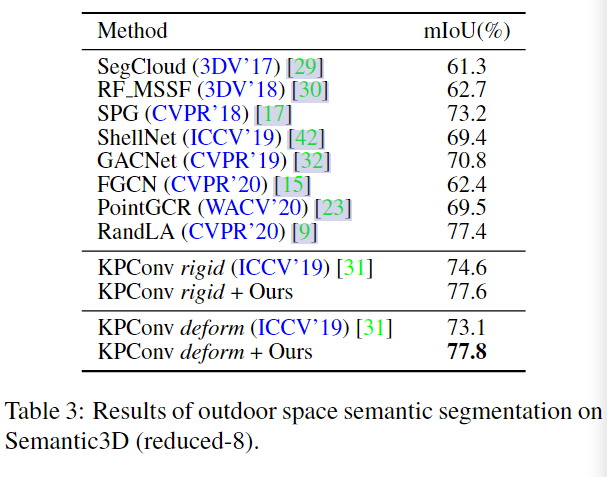

Semantic3D

在Semantic3D [7] 数据集上,所提方法达到了77.8%的mIoU,超越了所有最先进的竞争对手。使用可变形KPConv作为骨干网络时,方法使其mIoU提高了4.7%。当使用固定KPConv作为骨干网络时,方法也使mIoU提高了3.0%。

可视化结果如下图

消融实验

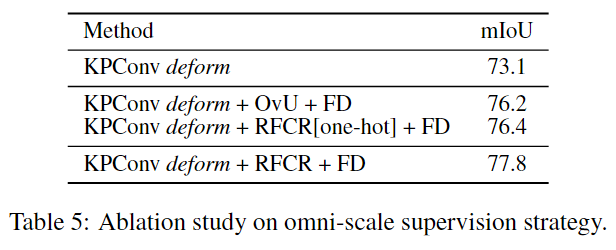

渐进式感受野成分推理

逐步加入全尺寸RFCC损失函数以及离心势损失函数,消融研究的结果表明,单独使用渐进式感受野组件推理可以使分割性能提高2.9%。当加入特征密集化后,可以进一步提高1.8%的性能。

全尺度监督上采样

使用OvU替代RFCR进行全尺度监督的损失,OvU即直接进行该点的语义监督,在原始点云中的标签就是其目前标签,也就是不存在那种从粗到细的渐进式推理的过程了。

One-hot RFCC

将感受野中所有点的类别中的最大数量作为该点的类别标签进行监督。结果显示,忽略次要类别的one-hot RFCC不能完全代表感受野中的信息,因此在分割任务中的性能较为次优(76.4%),比多热RFCC低1.4%。

PNAL-2023-TPAMI

提出的原因

①在实际的语义分割数据集中,同样存在着一些标注错误的噪声情况,这种噪声情况会导致网络学到一些错误的判断。导致网络拟合这种不准确的标准从而性能下降(边界噪声的影响尤为严重)。

②过去的图像识别中的噪声标签处理的方法放在点云分割中会由于不同的表示和空间变化的未知噪声率而失败。

在图像识别中针对噪声标签的方法

①样本选择方法:首先在样本中找到一些认为干净的样本标签用于网络训练,然后找出预测和标签高度一致的样本,认为这些样本的标签是正确的。

②鲁棒损失函数方法:设置损失函数对于预测错误的样本施加的惩罚较小,而不像之前那种平方的损失导致移向错误判断的步幅过大,如广义交叉熵GCE、对称交叉熵SCE、反向交叉熵RCE,但是这种方法依赖于大多数的标签都是正确的,只有小比率的噪声标签情况下适用(只是调整错误的学习的比例,但是对于错误的情况过多仍然会学到错误)。

③标签矫正方法:直接谢盖错误的标签,比如在样本选择方法中的一致性(多次迭代对于该点预测都是和标签不同)、利用外部知识、通过标签数据之间的关系(实例内部标签基本相同)。

④带噪声鲁棒层的方法:建模一个标签转换矩阵T,对于预测的输出进行调整,使其更加自信的指向某个标签,这种方法对于标签之间需要存在强相关性,模式较为固定(大多数实际为A的标签被噪声成了B这样的)。

本文使用的是样本选择方法以及损失矫正方法的扩展和混合体,和样本选择方法不同的是不需要提前知道噪声率这种先验知识,和损失矫正不同的是本文根据置信度矫正点簇的标签,考虑他们的局部相似区域

网络架构

首先通过热身阶段训练骨干网络(此时将所有点都用作训练),在经历了一部分的热身后,认为网络已经具备了分割的能力,此时进入噪声清理阶段,首先通过可靠样本点的选择阶段,对于所有点,计算其最近m次历史结果中的信息熵,由于通过*1/-log(1/M)放缩到0到1之间,当这个值越低意味着置信度越高。设置阈值后,可用于选择可靠样本点,对于各点通过DBSCAN方法进行聚类成簇,对于至少有着一个可靠样本点的簇进行标签纠正(找到簇中各点的历史结果中最多标签类别次数作为该簇中各点的标签的类别),然后对这些替换的标签进行网络更新,只有对从没有发生过标签替换的点才不进行网络更新,同时如果该点在簇标签纠正时变成了不可靠样本也不用于网络更新。

对于边界噪声版本的PNAL,边界点集的查找为通过k=20近邻获取边界点(边界为近邻中存在着其他类别的点的点)和邻近点的集合X视为边界点集,对于内部点保留所有的点的标签,也就是不进行矫正替换了,对于边界点集进行这种可靠样本点的选择,然后和内部点进行合并后用于网络的训练(不包括标签从未替换过的边界点或者是纠正后不可靠的点)。在每个迭代的过程中都会重新查找边界点集。

实验方法

数据集

ScanNetV2(存在着实例级别的噪声标签,验证集中的噪声标签通过手工进行了纠正)、S3DIS(场景复杂度更少,类标签中出现的错误明显少于前者。因此,我们将 S3DIS 数据集视为完全干净的数据集,即噪声率为 0,进行了实例级别的噪声标签的引入,随机对象实例级别的点标签,从而制造了对称噪声和非对称噪声的情况,对称表示完全不考虑是什么类别的噪声进行引入,而非对称噪声表示只进行沙发-椅子、门-墙、黑板-窗户这样的噪声引入)、S3DIS-boundary(为了测试PNAL-boundary的性能产生了边界S3DIS的数据集,作者随机选择一定比例的扫描数据进行形态学噪声生成,噪声水平为b,具体过程为,初始化标签,当噪声标签的数量少于由b 控制的阈值时,继续循环。随机选择一个类别y和该类别中的一个点,找到该点的最近邻居检查是否在边界上,如果在边界上则把i点的邻居点进行标签翻转,翻转的概率与点到边界的距离相关,越近翻转的概率越高)。

实验设置

DBSCAN算法进行聚类,其中ε=0.018,在处理ScanNetV2(真实世界噪声数据集)和S3DIS(人工创建噪声数据集)时,房间场景被划分成大小为1.0×1.0米,步长为0.5×0.5 米的房间块。训练过程中,每个房间块随机抽样4096个点。

评价指标:OA、mIoU

backbone:DGCNN、PointNet2、SparseConvNet

对于对称噪声,实验在噪声率t∈{20%,40%,60%,80%}下进行,对于非对称噪声,测试在较大噪声率t=60%,标签对噪声率tpair=40% 下进行。

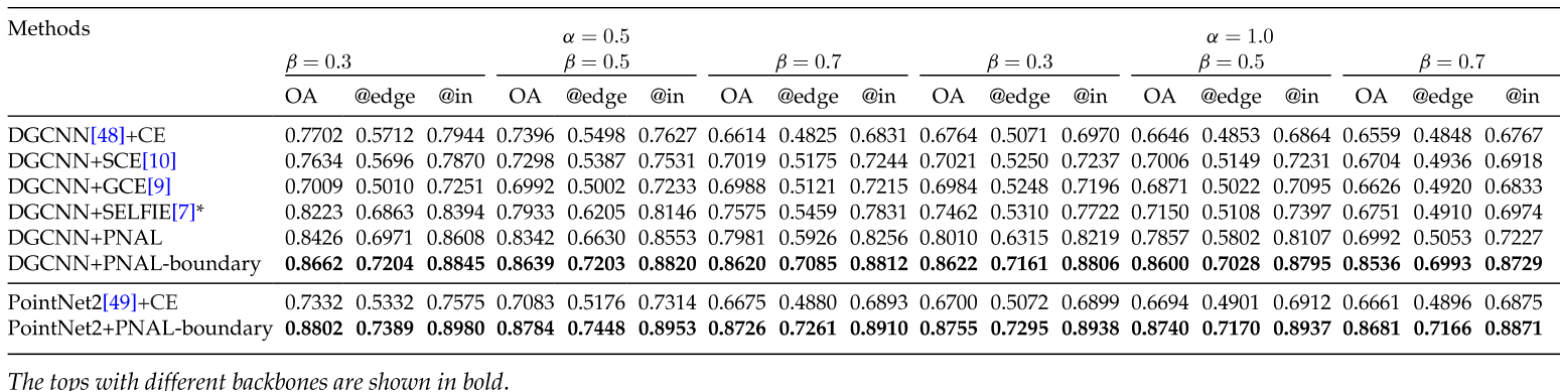

对于边界噪声,实验在数据集噪声率a∈{0.5,1.0} 和样本噪声率 b∈{0.3,0.5,0.7} 下进行。

所有在S3DIS上的结果都是在干净的第六区域(6th-Area)测试的。总共训练30个epoch,包括预热阶段和清理噪声阶段。

历史长度设置为4。

基线方法:CE交叉熵损失函数、GCE广义交叉熵损失函数(提高对噪声数据的鲁棒性)、SCE对称交叉熵损失函数(通过结合传统交叉熵和反向交叉熵来减少噪声标签的影响)、SELFIE(这是一种专门用于处理带有噪声标签的图像分类任务的方法,通过迭代地纠正噪声标签来提高模型的性能。具体就是网络训练中,预测结果和原始标签一致的为可靠样本,不一致的为不可靠样本,如果多次迭代后不可靠样本的标签一致没变,就将这个标签作为可靠标签进行训练了)

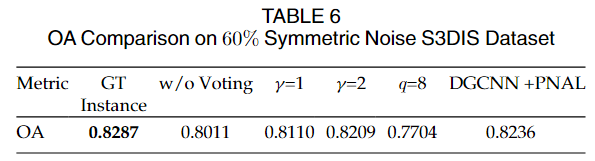

实验结果

S3DIS

(1)实例级标签噪声

①使用DGCNN网络架构和交叉熵(CE)损失函数时,随着噪声率的增加,模型性能显著下降。在20%噪声率下性能下降了11.86%,在60%对称噪声率下下降了23%,在混合非对称噪声下下降了30.58%,在40%纯非对称噪声率下下降了11.79%。纯非对称噪声下的性能下降不如混合噪声下显著,因为在传统的非对称噪声设置中,噪声仅存在于容易混淆的类别中,这些类别只占总数据的一小部分。

②对称交叉熵(SCE)和广义交叉熵(GCE)这两种旨在增强噪声鲁棒性的方法,在0%和20%噪声率下的表现与CE相似,没有明显改善或变差。在60%对称噪声率下,这些方法仅提高了1.19%和5.77%。在纯非对称噪声下,这些方法未能有效工作,甚至产生了更差的结果。这些结果是预期的,因为SCE和GCE更适合处理小的或恒定的噪声率,而点云训练面临极端的噪声率变化。此外,这些方法没有考虑局部区域的标签相关性,因此难以在点云分割任务中实现最优结果。

③在第四行数据中,SELFIE噪声校正方法在不同噪声环境下相较于交叉熵(CE)损失函数的基准结果表现出显著的性能提升。

在60%对称噪声环境下,SELFIE提高了13.35%;在混合非对称噪声环境下,提高了18.66%;在40%纯非对称噪声环境下,提高了5.82%。这些性能提升相比于对称交叉熵(SCE)和广义交叉熵(GCE)是相当显著的。SCE和GCE在这些噪声环境下的性能提升不如SELFIE明显。

尽管SELFIE在处理噪声数据方面表现出色,但所提出的PNAL框架的结果甚至超过了SELFIE。PNAL框架的优越性能归因于其对噪声不敏感的设计(noise-blind design)和对局部区域标签相关性的建模(local region correlation modeling)。

④DGCNN+PNAL,在所有噪声设置下,使用DGCNN网络架构配合PNAL方法相比于DGCNN+SELFIE方法,显示出超过4.11%的进一步性能提升。SELFIE方法需要知道噪声率,并且平均每个epoch的训练时间超过10小时。相比之下,DGCNN+PNAL的训练时间仅为3小时51分钟,这得益于其对噪声不敏感的设计和考虑局部区域标签相关性的投票设计。PNAL方法在20%、40%、60%、80%对称噪声,混合非对称噪声和40%纯非对称噪声环境下分别提升了10.63%、16.46%、18.46%、25.91%、23.34%和9.85%。当使用PointNet2作为网络架构时,PNAL的性能也显著提升,分别提升了13.77%、14.75%、22.17%、25.04%、25.54%和8.79%。

在混合非对称噪声数据上训练得到的可视化结果如下图

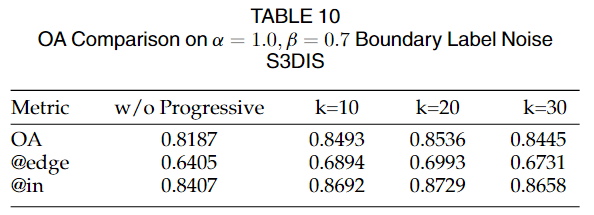

(2)边界级标签噪声(拆分出边界点集和内点集)

①在DGCNN+CE的情况下,随着边界噪声率的增加,模型性能显著下降。在数据集噪声率a=0.5和样本噪声率b=0.3下,性能下降了9.90%,而在a=1.0和b=0.7下,下降了21.33%。

②SCE和GCE在低噪声率下与CE表现相似,没有明显改善或变差。在最高噪声率a=1.0和b=0.7下,这些方法仅提高了1.45%和0.67%。

③SELFIE在最高噪声率下提高了1.92%。

与实例级别标签噪声的结论相似,这些方法在小的边界噪声下有效,但在极端噪声率下难以获得最优结果。

④相比于DGCNN+SELFIE框架,为实例标签噪声设计的DGCNN+PNAL框架在所有噪声设置下显示了大约3%的改善。

⑤引入PNAL-boundary后,与PNAL框架相比,平均性能提升了5.3%。在不同噪声水平下,PNAL-boundary分别提高了总体准确率9.60%、12.43%、20.06%、18.58%、19.54%和19.77%。在最高噪声率下,边界区域准确率的提升(从0.4848提高到0.6993)甚至超过了内部区域准确率的提升(从0.6767提高到0.8729),提升了1.83%。这表明PNAL-boundary对边界标签噪声具有较强的鲁棒性。当使用PointNet2作为后端网络时,PNAL-boundary的性能提升也很显著,分别提升了14.70%、17.01%、20.51%、20.55%、20.46%和20.20%。相比于PNAL来说,可以将PNAL-boundary看做是专注于边界噪声的情况,这种针对性的处理类似于注意力从PNAL中放在全局上变成了放在边界上,因此在边界标签噪声中得到了一个显著性的性能提升

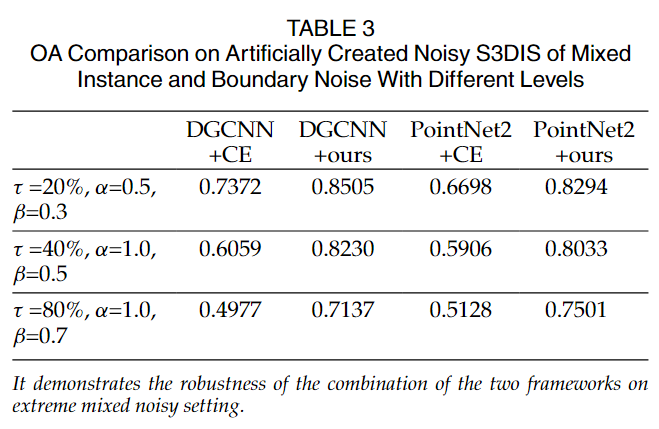

(3)混合标签噪声(都有)

结合了两种噪声模型:首先创建实例级别的标签噪声,然后再添加边界标签噪声。在S3DIS数据集上手动生成了这种混合噪声。对于每种噪声类型,使用了不同水平的噪声率。对于实例级别的对称噪声,使用了噪声率t;对于边界噪声,使用了噪声率a和b。为了应对混合噪声,首先应用PNAL框架训练30个epoch,然后应用PNAL-boundary框架训练10个epoch。

即使在极端混合噪声条件下(例如,80%的实例级别对称噪声和 a=1.0;b=0.7 的边界噪声),该方法仍然一致地提高了性能,超过了20%。

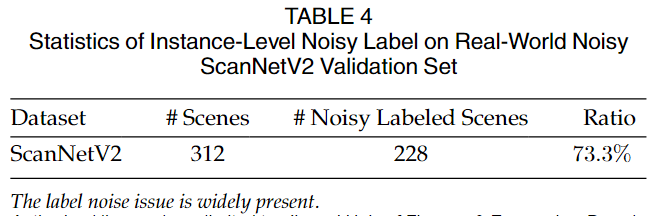

真实世界噪声数据集ScanNetV2

首先对数据集中的验证集进行了手动检查,每个场景至少由两名检查员进行检查,当他们都同意场景中存在实例级别的噪声类别标签时,该场景被计为标记错误。最终数据集结果如下表

因此,尽管ScanNetV2是ScanNet的重新标注版本,其验证集中仍广泛存在标签噪声问题。注意到ScanNetV2数据集在训练集和验证集中都存在实例级别和边界级别的标签噪声。

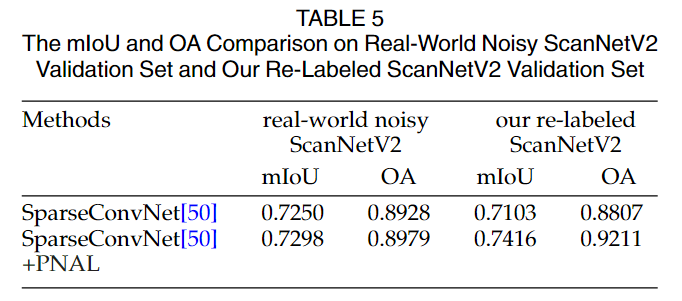

实验结果

尽管PNAL的结果没有显示出巨大优势,作者认为这可能是因为ScanNetV2验证集中仍然存在错误标签。因此进行了验证集的可视化结果分析,前7行中本文发现PNAL得到的结果甚至比GT更合理。因此本文在前文提到的完全重新标注的干净验证数据上进一步测试,并在表5后面报告了结果。在这些干净数据上,PNAL方法取得了显著的性能提升,证明了其在处理真实世界噪声数据集上的有效性。相比之下,基线SparseConvNet的性能下降,表明其对标签噪声的过拟合影响了在完全干净数据上的性能。

由于ScanNetV2验证集也受到边界噪声的影响,并且重新标注高质量、精确边界的数据非常耗时,因此研究者没有进行量化实验,而是展示了一些来自验证集的实例结果。

在后四行中为验证集实例的可视化结果,其中PNAL框架的结果比基线方法甚至比真实标签(GT)更合理。特别地,对于第8行和第9行,给定的标签中存在实例级别和边界级别的标签噪声,PNAL框架正确地校正了这两种噪声。这些可视化结果进一步说明了真实世界标签噪声的存在和复杂性。真实世界的GT标签错误,如图中第二行和第四行,是由于“照片与墙壁”和“浴帘与窗帘”等易混淆类别对造成的,符合非对称噪声模式。对于第一行和第三行,它们的标签错误模式与之前提到的噪声类型不同,是样本相关的,称为实例依赖和标签依赖噪声(第一行中的desk应该一部分变成cabinet,cabinet应该变成desk)。由于这种噪声类型的复杂性,目前还没有广泛研究对其进行建模。

消融实验

PNAL组件消融

所有实验结果都是在60%对称噪声条件下获得的。

①直接使用真实实例标签而不是使用聚类后的簇标签作为标签(即使用无噪声标签的数据),这代表了PNAL方法的上限性能。

与此相比,最后一列的基于聚类的结果只有小幅下降,说明使用聚类作为真实实例标签的替代方案是可行的。

②第二列省略了聚类级别投票步骤,进行逐点标签校正,而没有考虑附近点之间的标签一致性。结果显示与完整方法相比下降了2.25%,证明了聚类级别标签校正的有效性。

③第三第四列使用了不同的γ值进行消融实验,仅有小幅度的下降,说明了对于γ的选择是不敏感的,本文中设置γ=4。γ值为聚类标签纠正时的超参数,用于帮助网络选择纠正的标签,纠正后的标签为在所有标签类别数量>最大数量/γ的标签中随机抽取的一个。如果γ=1,则直接选取最大数量的标签。

④队列长度的消融,性能显著下降。

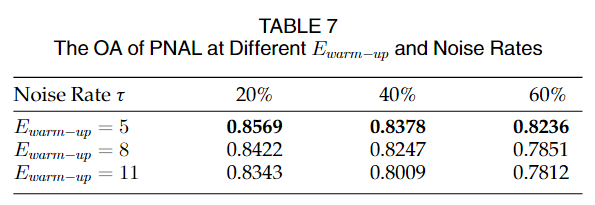

⑤对预热监督epoch长度的消融,可以发现不管在什么情况下,epoch长度设置为5就能达到最优的性能,表明Ewarm-up对噪声率变化不敏感。噪声率越大,如果Ewarm-up增加,性能下降越明显。这表明较长的Ewarm-up会导致网络过度拟合噪声数据,使得清理大噪声率数据变得困难。

⑥聚类方法的消融,表8展示了在不同聚类粒度(ε值为0.015,0.018,0.021)和不同聚类类型(如GMM,光谱聚类)下PNAL的结果。结果显示出接近的性能,表明PNAL对一定范围的聚类粒度鲁棒,且不敏感于所使用的聚类方法。

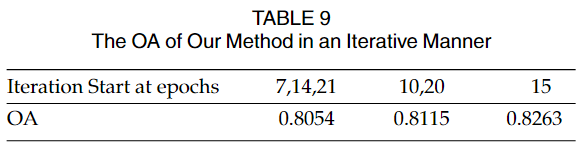

⑦迭代清理的消融,相比于30个epoch进行迭代来说,从epoch15开始迭代有着类似的性能。而迭代更加频繁则会性能下降,本文认为这可能是频繁的迭代妨碍模型充分学习和适应数据。

PNAL-Boundary的消融

①第一列是不进行渐进式边界矫正的结果,也就是边界点始终不变,都是相对于地面真值的标签得到的。可以看到非渐进式有着小的下降。

②k近邻的消融,当k取不同值时,性能变化不大,说明方法对k不敏感。当k取较大值时,性能有所下降,原因可能是允许纠正的边界范围过大,导致对非边界点的错误纠正。综上,渐进式边界纠正策略是有效的,且对关键参数k具有一定的稳健性,但k需要合理设定,避免错误纠正内部非边界点。

矫正过程分析

①PNAL的过程为上图第一行,可以看到随着训练迭代次数的增加,训练数据集中的整体标签错误趋向于减少,并逐步接近干净的真实标签。通常情况下,大面积的标签错误(如地板、墙壁、天花板等)会先被纠正。随着训练的进行,PNAL会逐步探索整个数据集,并尝试纠正一些较难的小目标的标签错误。图6显示,被替换标签的点的比例从0.936逐步增加到0.992,正确纠正的点的比例在噪声清理阶段开始时接近0.8,然后逐步增加到0.865。这表明PNAL的纠正过程会随着训练的进行而扩展到全部训练数据集上。注意这里考虑了纠正到原始标签的情况。

②PNAL-boundary为上图第二行,可以发现,随着训练的进行,所提出的PNAL-boundary框架将粗标注的边界标签以一种从粗到细的方式与墙和板之间的实际边界对齐。对于大多数内层点,它们的标签被保护以避免错误更正。

③在前30轮中,PNAL框架遵循此前的观察,先纠正大面积错误(如墙体),然后纠正小目标错误(如大桌子、小桌子、椅子等)。但是,不仅边界区域,内部区域也出现了错误纠正(如第29轮,桌子上的小物体被错误标记为桌子)。在后10轮中,PNAL-boundary框架逐步调整边界粗糙标注,使其与真实边界对齐。内部点标注可以避免错误纠正,但真正的纠正仅局限在一定范围内。

例如,PNAL错误重新标注为桌子(橙色)的桌上的小物体(黑色),在PNAL-boundary的有限迭代中无法完全纠正。

ESCNet-2023-ITNNLS

提出的原因

①在原先的变化检测中,基于像素的方法只能够在中低像素的情况下进行,当像素更高时,在对象内部以及边界会变得更加的富有细节,此时基于像素的方法会导致最终的输出结果中像素独立,存在内部孔洞以及边界锯齿状的情况产生。

②在过去的基于对象和深度神经网络的变化检测中,通常是将各个部件分开的。如先进行超像素分割,然后再利用神经网络进行CD,那么此时训练的过程是将超像素分割和神经网络CD两个部件分开进行,各取局部最优解,但是这并不一定是全局最优的,因此本文提出了一种端到端的超像素分割和CD的架构

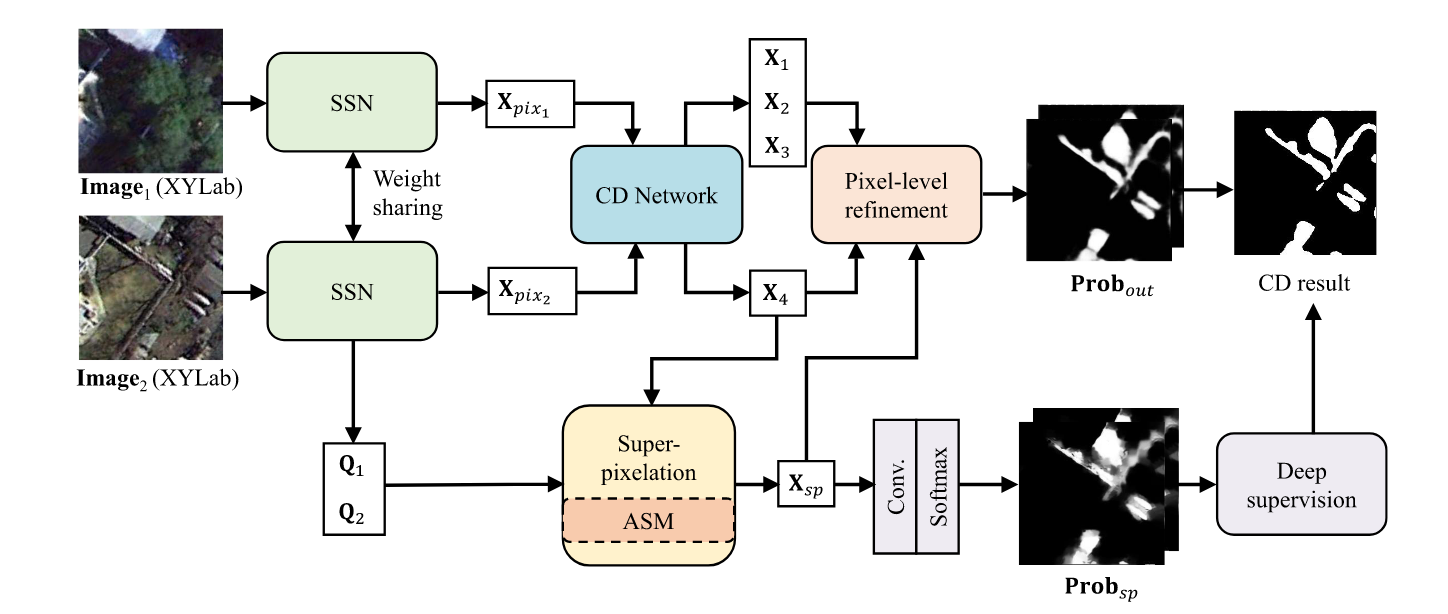

网络架构

整个网络分为两个阶段,首先是SSN的超像素分割阶段,然后是变化检测阶段,不同于其他方法的是,这两个阶段可以连接后进行端到端的训练。

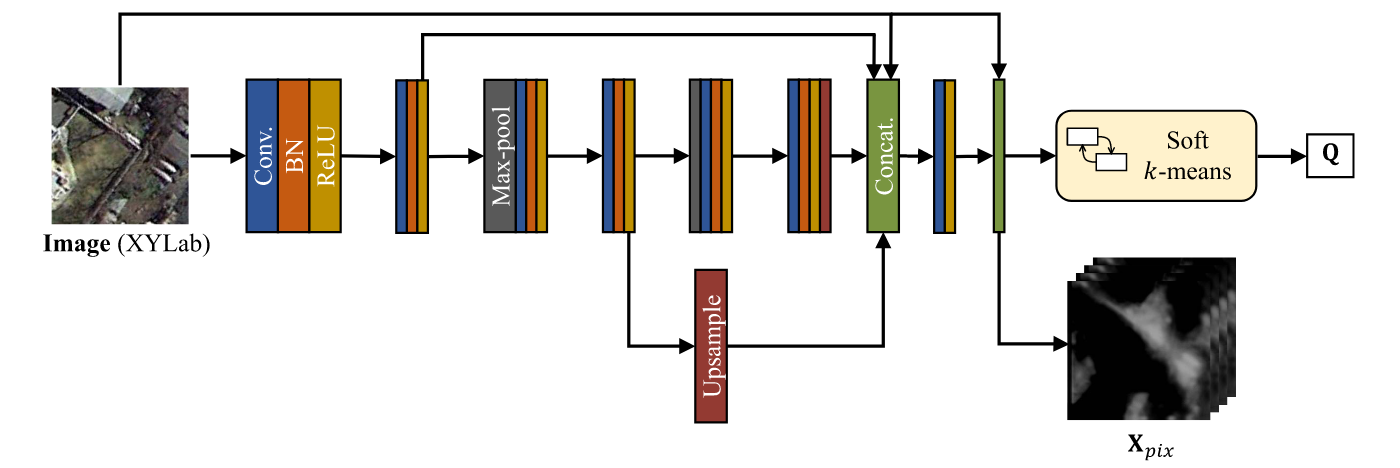

超像素分割SSN模块

在这个阶段,首先把图像特征(XY坐标和颜色)通过缩放(位置缩放以及颜色缩放,用于放置焦点)进行输入,然后通过卷积层提取特征,通过两个池化层提高感受野,再通过上采样层在最后将这些不同深度的特征进行拼接后,再次卷积进行语义融合后和原始图像特征拼接,作为像素的抽象特征,关于超像素分割,则是将这些像素的抽象特征用可微SLIC得到超体素和体素的关联矩阵Q。

具体的Q的计算如下,首先预设置超像素的数量为M,在对像素进行规则网格后,随机选择M个作为初始超像素中心,然后利用公式计算关联矩阵Q。

对Q进行列归一化后,更新S,然后再次计算Q,再次更新S,迭代t次后得到最终的Q。SLIC又有名称为soft k-means,可以看到这个过程确实是类似于K-means的迭代更新的过程。

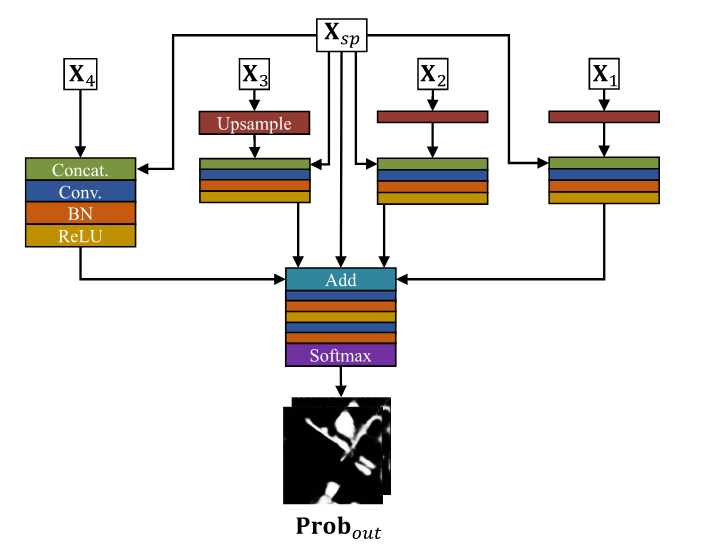

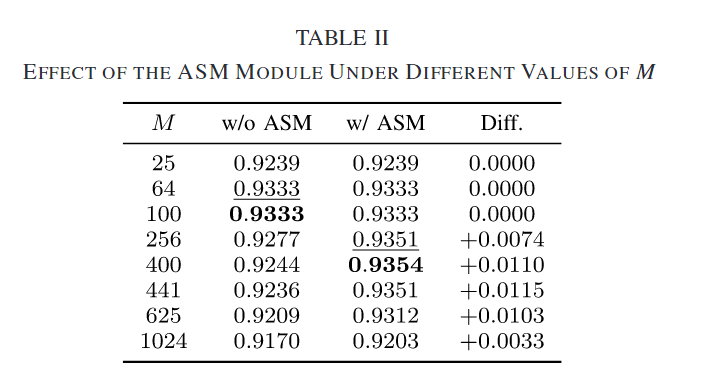

对于双时相的像素的抽象特征,输入到变化检测网络中,是比较常见的图像变化检测网络,卷积,UNet的组合。对于每个上采样层的输出都需要记录之后传到外面,分别为X1,X2,X3,X4。以前通常是X4则为最终的变化检测图,在此处,对于X4一方面传到超体素方向,另一方面和X1,X2,X3上采样还原的特征进行拼接后进行变化检测图的生成。当然另一方面的方法并不是初次见到,具体可以看CBL方法等。

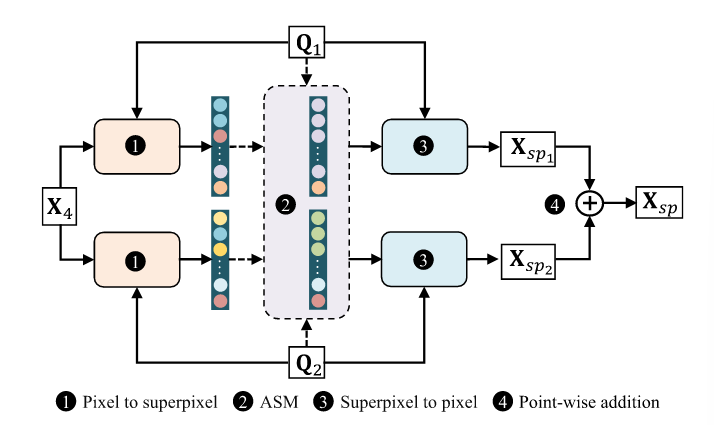

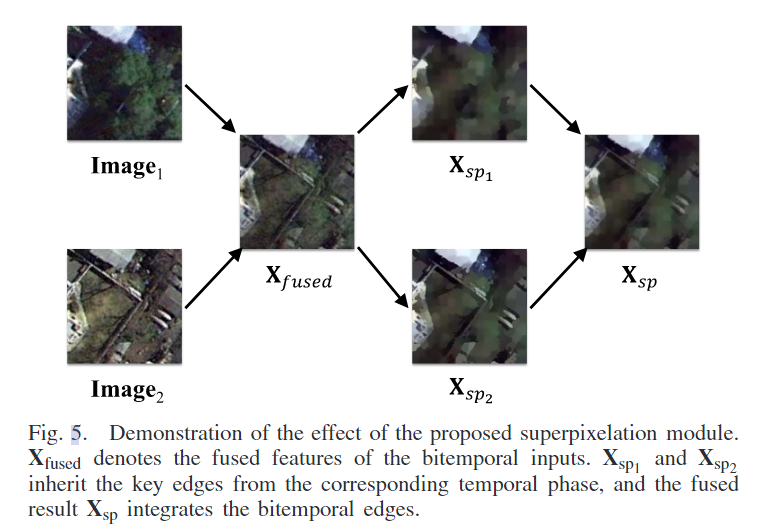

在超体素方向中,首先将像素结合的最终结果X4通过Q1和Q2映射到超体素特征空间中,这一步由于Q1和Q2是独立求到的,所以能够让像素结合的最终结果X4感知到双时相图像各自的边缘信息,同时这种映射的方法让超像素的特征为像素结合的加权求和,对于像素内部的噪声点能够很好的池化掉。这一步①可以称为由超像素引导的池化操作。②为ASM模块(自适应超体素融合模块),这一模块是可选的,合并相似的超像素以减少过度分割效果(开始设置的M大小可能过大了)。③步骤则是再通过Q1和Q2,把超体素特征空间逆映射回像素特征空间。假如没选②步骤,则为先映射到超像素空间后逆映射会像素空间,如果N=M的话,这一过程实际上是恒等变化,并不会损失信息,而N通常是远大于M的,那么就会存在信息损失的问题。而这个损失过程本文称为超像素的平滑效果,当然如果M的设置过小的话,会带来较大的损失,因此在soft k-means的时候需要稍微注意调大M。在④步骤中,将经过Q1和Q2不同损失的像素特征进行相加,得到融合后的特征图。

示例如图

ASM模块

和硬合并的策略不同,本文中使用的为软合并,使相似的超像素拉近,而不像硬合并的方法将相似的超像素变为同一个像素,尽管最终的超像素仍为M个,但是实际上是有部分的拉近了,可以看做为M‘个了。

具体的方法

首先计算各个超像素的相似度,然后得到相似度矩阵A,然后对原超像素特征进行加权求和,注意在加权求和的过程中引入nj,表示j超像素中的像素数量。

但是由于是soft K-means,所以像素数量实际也是模糊的,在此处定义。

最终有ASM后的超像素公式

对于另一方向的情况来说,将Xsp和各个阶段的输出进行拼接,然后进行卷积后求和再次进行卷积操作。这种方法是为了强调超像素Xsp的重要性,同时对于各个尺度下的输出拼接,能够帮助网络充分获得变化检测的边界(多尺度特征融合)。

损失函数

由于在过程中的一些可解释性约束,用了三个去约束网络,第一个是变化检测的损失函数:

加权二值交叉熵损失函数

重建损失函数

用于限制两个空间映射和逆映射过程中的信息损失。

紧凑损失

为了让两个空间的相邻位置保持一致性,也就是在像素空间中xy相邻的像素在超像素空间中的相邻的超像素也相邻。

实验方法

数据集

SVCD(季节变化变化检测)、SZTAKI(SZTAKI AirChange Benchmark Set)

SVCD

包含合成图像和真实图像。来自Google Earth的11对遥感图像,其中7对为季节变化图像对(4725×2700像素),用于手动创建地面真实标签;4对为季节变化图像对(1900×1000像素),用于手动添加额外对象。空间分辨率在3厘米到100厘米每像素之间变化。数据集通过随机裁剪和旋转256×256大小的片段生成,每个片段至少包含一个变化像素。使用10000个图像块进行训练,3000个用于测试。地面真实标签只考虑了场景中新对象的出现或消失的变化,而不考虑季节因素导致的变化。

SZTAKI

包含三个子集的核心注册的多时相光学航空图像对,分别是SZADA、TISZADOB和ARCHIVE,包含7、5和1对图像对。每张图像的尺寸为952×640像素,分辨率为1.5米/像素。根据之前的研究,SZADA集和TISZADOB集被视为两个完全独立的数据集,ARCHIVE集因数据量不足而未用于实验。对SZADA和TISZADOB数据集中的部分图像进行了特定区域的提取用于测试,其余图像用于训练。SZTAKI数据集的数据量相对于SVCD数据集较少,更容易出现过拟合现象。

评价指标

Pre、Rec、F1-score、OA

实验设置

随机梯度下降法SGD,每20个epoch学习率减半,设置了0.9的动量值,L2正则化项,batchsize=8, λ 1 = 0.5 , λ 2 = 0.01 , λ 3 = 0.1 λ_1=0.5,λ_2=0.01,λ_3=0.1 λ1=0.5,λ2=0.01,λ3=0.1,以及自适应超像素合并(ASM)模块的α=0.01,随机缩放、位移以及所有可能的翻转和90°的倍数旋转进行增强。

比较的方法

CDNet、FC-EF、FC-Siam-conc、FC-Siam-diff-res、FCN-PP、W-Net、CDGAN。

实验结果

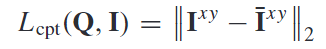

ASM效果

可视化结果可以看到,相比于像素特征的热力图,超像素能够让像素的各个模块更加的分离开来,但是可以看到,这里会分割为更多的块而没有那么的平滑,而加上了ASM模块,能够让相似的超像素变化看起来更加平滑,而不相似的超像素分割的也更加开。

表中能够看到,在M较大的时候,使用ASM模块能够有着更加优异的性能,这就是由于分割的超像素数量过多了导致的,而ASM则可以降低这种分割效果。ASM模块降低了模型对超像素数量选择的敏感性,并帮助充分发挥了所提模型的潜力。实际操作中,为了充分利用ASM模块,初始阶段指定的超像素数量应足够大以确保图像被过度分割。随后的ASM过程重新排列超像素,合并一些超像素同时保留其他超像素,以形成能够捕捉不同尺度地面对象空间关系的超像素表示。

消融实验

①只使用Xsp计算损失,②使用2X4计算损失,③使用X4计算损失。

可视化结果如上图。实验结果显示,ESCNet-spixel模型存在许多错误分类的像素,特别是在无法区分路面和地面特征的情况下。而ESCNet-pixel模型无法有效处理像素级噪声,结果受到误报的严重干扰。没有深度监督的ESCNet-w/o-DS模型也没有达到满意的视觉效果。相比之下,完整模型(即包含ESCNet所有部分,除了ASM模块)的结果在视觉上更干净,误报和漏检更少。这证明了所提出的像素级细化模块成功解决了前述问题,并强调了整个ESCNet框架各部分的重要性和有效性,特别是在处理复杂的变化检测任务时。

ESCNet-pixel模型,即唯一的“无超像素”模型,虽然在召回率上达到了最高(0.9866),但在精确度(0.8530)上表现相对较差。这很可能是由于结果中假警报的高数量造成的。对比ESCNet-pixel和ESCNet-spixel在精确度上的结果再次证明了超像素在抵抗伪变化方面的有效性。ESCNet-w/o-DS在精确度、F1分数和整体准确率(OA)上取得了最差的结果,表明深度监督在ESCNet训练中是不可或缺的部分。没有深度监督损失函数的指导,深度网络的中间层未能从输入中挖掘出更多有用的线索。完整模型在所有指标上表现最佳,获得了最高的精确度、F1分数和OA。

这里通过利用图相对的RGB特征和缩放Lab特征代替SSN的输出特征作为CD网络的输入,虽然在此时将SSN和CD网络断开了,虽然仍通过Q联系在一起。这里的梯度仍然可以计算,detach则是将梯度也删除了。可以看到尽管ESCNet-RGB的召回率略微超过了ESCNet-w/o-ASM,但无论是ESCNet-RGB、ESCNet-scaledLab还是ESCNet-detach,在精确度、F1分数和整体准确率(OA)方面的表现都不如端到端版本。这一发现证实了联合优化的有效性和重要性,表明了将SSN和CD网络整合为一个端到端可训练框架的优势,能够更好地优化模型性能。

实验结果

结果显示,除了ESCNet和ESCNet-w/o-ASM,其他所有方法中都频繁观察到假检测,一些对象只能粗略检测到。相比之下,ESCNet和ESCNet-w/o-ASM能够更准确地识别大多数变化对象,误分类的像素较少。

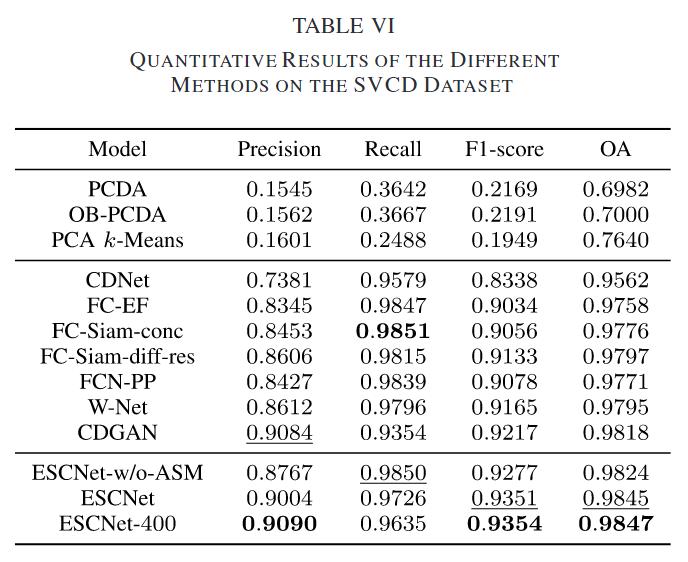

在SVCD数据集上,精确度、召回率、F1分数和总体准确率(OA)的结果在表VI中报告。此外,ESCNet还以不同的超像素数量(M=256和M=400,分别记为ESCNet和ESCNet-400)进行测试。传统的无监督CD方法相比深度学习基方法表现不佳,但对象基PCDA方法相对于像素基PCDA方法表现更好,这表明了SSN边界的有效性。在所有方法中,ESCNet-400在F1分数和OA上取得最佳结果,其次是ESCNet,ESCNet-w/o-ASM在召回率上取得第二高的结果。相较于其他方法,ESCNet-w/o-ASM和ESCNet在二进制变化图中获得了更精确和平滑的结果。在S ZADA和T ISZADOB数据集上的量化结果也显示了传统方法在不同指标上的得分较低,而ESCNet及其变体在两个小数据集上的表现进一步证明了所提框架的泛化能力,可能得益于SSN中的非监督聚类过程。

这主要是由于超像素操作造成的。给定固定数量的通道,矩阵操作的复杂度为O(N×M)。对于ASM模块,计算A和Q分别需要O(M×M)和O(N×M×M)的复杂度,而额外的操作(如公式(18)中描述的)也会带来O(N×M)的复杂度。

SemAffiNet-2022-CVPR

SemAffiNet: Semantic-Affine Transformation for Point Cloud Segmentation-2022-CVPR

提出的原因

①目前的解码器编码器的点云分割架构在提取几何信息时过度依赖类不可知的局部几何表示。导致在外观相似或空间邻近的不同类别的局部部分之间产生混淆。比如桌子和椅子的腿,或者是门框和墙壁的边界。

网络架构

首先通过常规的编码器-解码器的网络(用别人的主干网络就行),然后对于编码器的最终输出,先通过ISAM模块进行模态内特征加强和模态间信息交互,然后使用ESAM模块,在ESAM模块中会产生多个中间层的输出si和bi,这些中间层的输出用于和解码器中中间层的输出进行点积用于进行语义仿射变换。然后进入decoder的下一层。

ISAM模块通过注意力机制进行模态内的特征加强和模态间的信息交互。首先将不同模态通过encoder的高级特征拼接,然后进行自注意力机制即可。

ESAM模块通过多层注意力机制产生特征,输入为经过了ISAM融合了不同模态的混合特征。通过多层的Transformer,每层的Transformer中的Q为设计的参数,用于查询特定于语义的知识。

EPointDA-2021-AAAI

提出的原因

由于真实数据集的标注十分有限,而在模拟世界的数据集是无限的,因此本文提出了一种在模拟世界数据集中训练,但是能够在真实世界数据集进行点云分割的端到端的网络(之前的有一个这种的但不是端到端的)

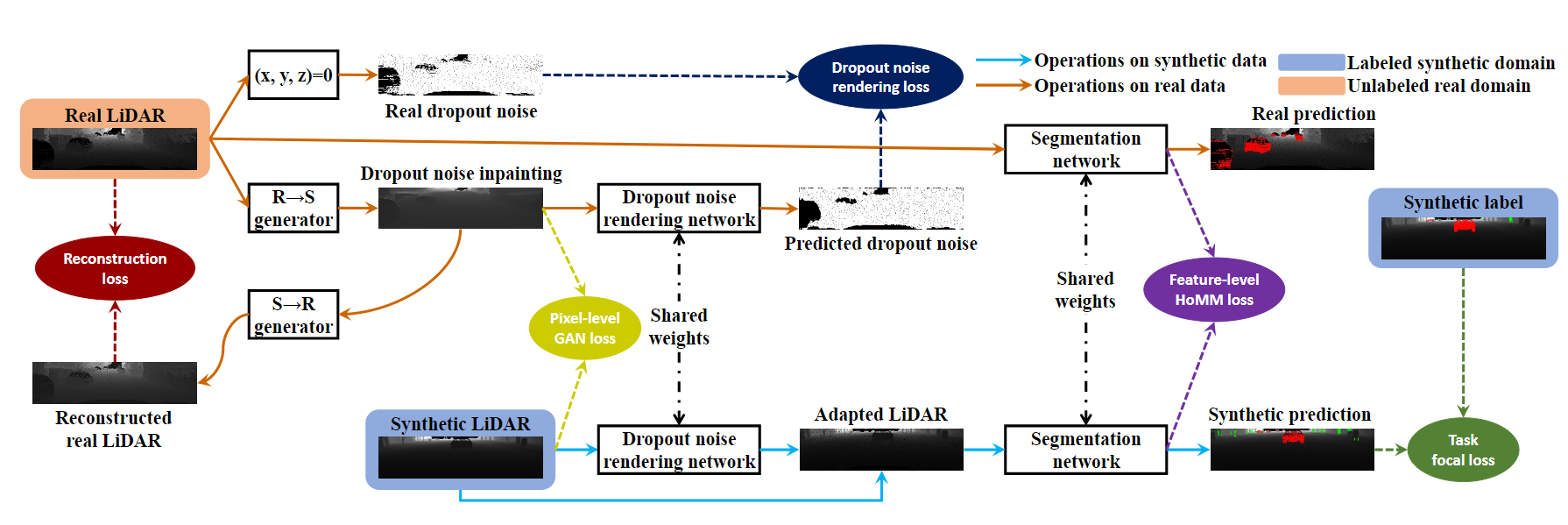

网络架构

首先对于真实世界的数据集通过CycleGAN进行域的转化还原的网络训练,对于由真实世界转化的点云图像,利用网络生成噪声并进行噪声掩码。得到的噪声掩码和真实世界的点云图像的噪声掩码进行损失函数训练。同时对于模拟世界的点云图像同样产生噪声掩码,然后将掩码后的虚拟世界点云图像和真实点云图像利用网络进行点云分割,在这个过程中进行特征的特征水平的域自适应损失函数。也就是在中间产生的特征通过归一化以及使两个图像的特征进行交叉熵损失函数。并对虚拟世界点云图像的分割结果进行交叉熵损失函数。

实验方法

数据集

GTALiDAR、KITTI、SemanticKITTI,使用从合成数据集GTALiDAR中训练的模型到真实数据集KITTI和SemanticKITTI中进行点云分割。由于合成数据集中仅包含车辆和行人,因此在真实数据集中也只报告这两个类别的分割结果。

评价指标

Pre、Rec、IoU

对比的方法

直接将模拟域中训练的模型转移到真实域中的Source-only、SqueezeSegV2、RGB图像方面最先进的DA方法、分割模型在仿真域和真实域上训练的结果作为上限。

实验设置

SDNR采用和SqueezeSegV2相同的架构,最终层变为二分类编码,SqueezeSegV2中的标准卷积和批量归一化用空间自适应卷积和实例归一化代替。SGD,动量为0.9,batchsize=20,初始学习率为0.05,两万个step衰减0.5,焦点参数为2,高阶张亮用蒙特卡罗估计作为近似。

实验结果

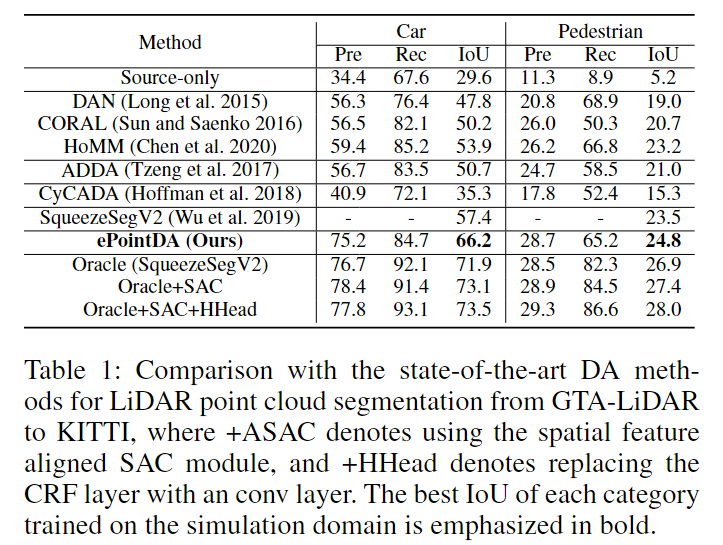

由于域之间的差异性,可以看到,直接转移的方法取得了最差的性能。RGB图像的方法取得了比直接转移更优异的结果。基于差异和对抗判别的方法比对抗生成的结果更好。CyCADA通过CycleGAN执行像素对齐,但是由于2DLiDAR图像主要是几何信息,和RGB图像由较大的差异,因此CyCleGAN转换的LiDAR图像质量不高。所以CyCADA的结果较差。而SqueezeSegV2虽然是多阶段的,但是由于其专门针对点云图特性设计的结构,达到了更好的性能。EPoint在SqueezeSegV2的基础上达到了更好的性能。提升了8.8和7.5%,得益于自监督的噪声渲染以及统计不变特征和域不变空间注意的高阶矩匹配。

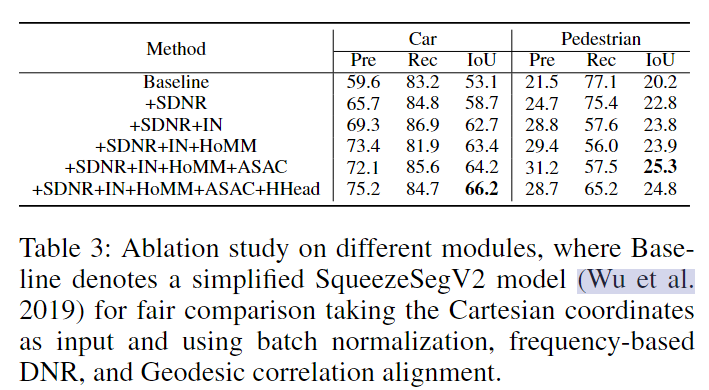

消融实验

①自监督噪声渲染模块(SDNR)+②实例归一化(IN)+③HOMM(高阶矩特征匹配)+④对齐的空间自适应卷积(ASAC)+⑤卷积层代替CRF层(HHead)

可以看到每个模块都对网络的性能有着提升。其中SDNR带来的提升是最为显著的,也就是说在域之间,最为主要的不同就是噪声点情况。

除此之外,还探索了不同的归一化的区别,相比于普通的批量归一化来说,所有的其他归一化(LN:层归一化,GN:组归一化)都比他更好,主要原因是由于真实域和模拟与之间的统计差距带来的,而IN、LN、GN都能一定程度上减少这种差距(也就是说BN过于全局了)。

ASAC和SAC的区别在于提取的特征注意力位置。在ASAC使用的是特征图进行空间注意力图的构建,而SAC则是使用原始图像进行空间注意力图的构建,简单的SAC会导致性能的下降。

在最终的结果处加入多个卷积层的性能情况,加入了两个时为最佳,本文认为随着卷积的层数增加带来的感受野的增加,对于分割网络来说,当感受野过大时会导致性能的下降。

EPointDA相比于SqueezeSeGV2来说,分割效果得到了显著的改善。如第一列中避免了错误检测一些行人,第二列中将骑自行车的人分类为了行人,但是由于合成数据集中没有骑自行车的人,隐藏是合理的。同时对于注释中的一些确实的对象,EPointDA也能够正确的分割出来。

GEP-2021-ITII

提出的原因

现有的点云分割方法对于点云中所有的点的关注度是一样的。但是在点云分割中,边界点的重要性相比于内部点是更加重要的。因此本文提出了一种GEP(基因表达编程)等效函数能够有效表现每个点关于边界的重要性。(在22年的一篇CVPR中也是提到了边界的重要性,CBL损失函数)

网络架构

本文提出的网络架构实际上可以看做是在PointNet中的分割架构中加上了一个损失函数中的权重。这个权重由伪网络架构(基因表达编程)完成。首先随机产生p个染色体,然后计算染色体的适应度(就是按照这个染色体结果训练的网络的准确率),然后根据适应度作为概率随机选择染色体,对于染色体进行三种基因变换(基因突变、片段交换、基因复制),重复过程。

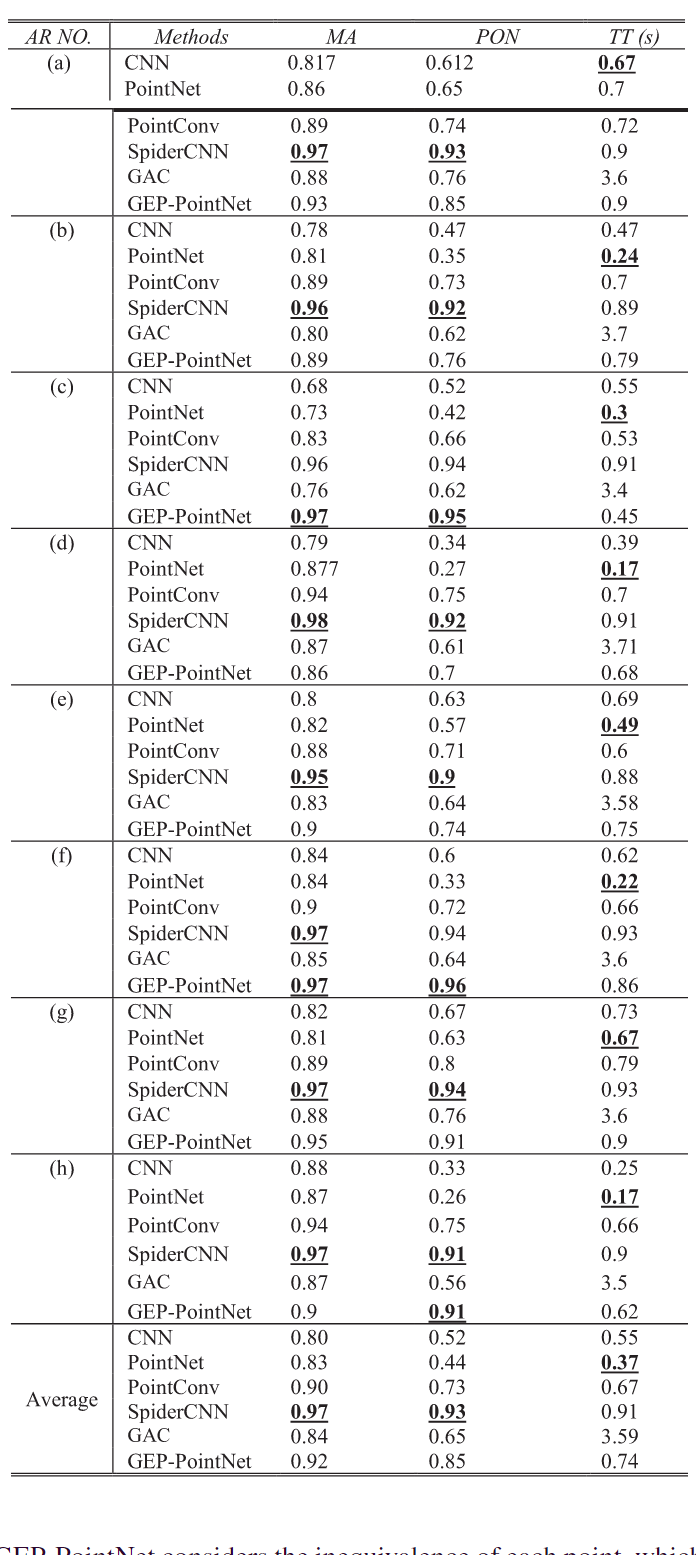

实验方法

评价指标

平均准确率(MA)、领域精度(PON)、测试时间(TT),其中领域精度的计算为对于和边界点距离低于某个阈值的点,计算这些点的准确率。

实验设置

adam,300个epoch,batchsize=20。

对比的方法

CNN、PointNet、PointConv、SpiderCNN、GAC等

实验结果

在18个数据集中,GEP-PointNet在12个数据集上获得了最高的MA,证明了其在3D点云分割方面的有效性。特别是与PointNet相比,GEP-PointNet展示了更高的MA,这说明GEP-PointNet在考虑点的不等价性方面具有优势,有助于提高分割精度。

GEP-PointNet在除了Table和Table lamp数据集外的所有数据集上表现最佳。在Table数据集上,其PON比SpiderCNN低0.02,在Table lamp数据集上比GAC低0.01,表明GEP-PointNet在边界附近点的分类上非常有效。

TT反映了算法的复杂度。在比较中,GAC的测试时间最长,而CNN的最短。GEP-PointNet的测试时间比PointNet略长,但在模型测试中,GEP-PointNet能够通过一次前向传播在一秒内完成分割任务。

GEP-PointNet在八种飞机方向舵上的平均准确率(MA)为92%,比PointNet高9%。这表明GEP-PointNet在处理边界引起的点不等价问题上是有效的,这一问题是3D点云对象分割中必须考虑的。

在模型结构方面,GEP-PointNet与PointNet、CNN、PointConv、SpiderCNN和GAC方法进行了比较。PointNet是一个具有变换网络和最大池化模块的深度神经网络(DNN)。GEP-PointNet在此基础上考虑了每个点的不等价性,这是一种局部邻域信息。PointConv是一个具有扩展动态滤波器的DNN模型。SpiderCNN是一个具有参数化卷积滤波器的CNN,用于提取带有局部邻域几何信息的特征。结合实验结果,考虑局部邻域信息的方法比其他方法具有更高的邻域精度(PON),这表明考虑局部邻域信息对于对象分割是有帮助的。

GEP-PointNet的准确率更高,但空气舱较低,为了确定原因,本文进行了统计分析。

其中67%的空气舵边界距离较小(0-0.2),接近分割边界。这意味着空气舵中的大多数点在 GEP-PointNet 方法中都很重要。当大多数点被赋予高权重时,它相当于没有所谓的关注边界点了。而空气舵在边界附近有一些斜角、角和焊接槽。因此,SpiderCNN 在空气舵中的准确率高于 GEP-PointNet,因为 SpiderCNN 更关注局部几何信息。

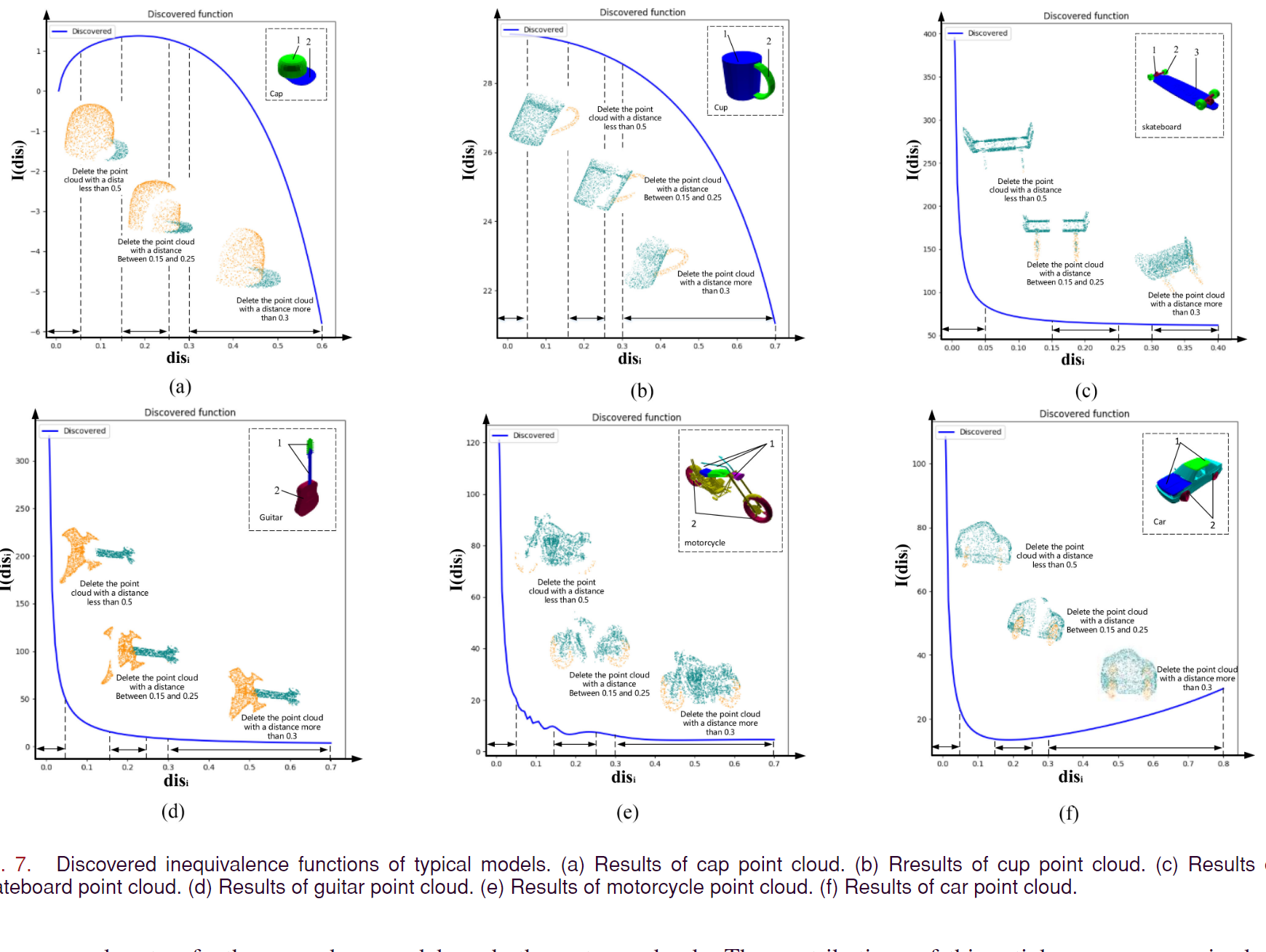

为了揭示不等价函数和距离的关系,进行了函数关系的示意图展示。

可以得到的结论

①所有点等价的情况确实会影响分割的性能。

从不等价函数的曲线性质来看,只有帽子和茶杯的是凸曲线。同时只有帽子和被子的连接表面法向量大于45°。因此得到②结论

②连接表面法向量的角度越大,随着边界距离的增加,点重要性就越慢。

通过不等价函数的单调性分析,只有帽子和汽车的模型呈现非单调性。而帽子和汽车的分割边界的曲率和长度较大,与其他的模型有显著差异,因此得到③结论。

③除了点到边界的距离以外,分割边界的曲率和长度是影响点不等价性的关键因素。且分布在分割边界周围的点的重要性与分割边界的曲率和长度呈正相关。