情感计算介绍

赞

踩

本文是本人对情感计算论文

A Systematic Review on Affective Computing: Emotion Models, Databases, and Recent Advances

进行研读后进行汇报的汇报文档,以及PPT的截图,供各位参考

2

这里是我今天汇报的目录,主要分为以下几块,简介,背景,情感模型,数据库,单形态情感识别,多形态情感分析,最后还有一个总结。

3

进入正题,首先我们要了解情感计算是个什么,

情感计算最早起源于美国MIT 媒体实验室皮卡德(Picard),皮卡德与1995年提出情感计算的概念,并于1997年正式出版《Affective Computing(情感计算)》。在书中,她指出“情感计算就是针对人类的外在表现,能够进行测量和分析并能对情感施加影响的计算”,其思想是使计算机拥有情感,能够像人一样识别和表达情感,从而使人机交互更自然。

回答了什么是情感计算这个问题后,我们来研究下情感计算的研究对象。

4

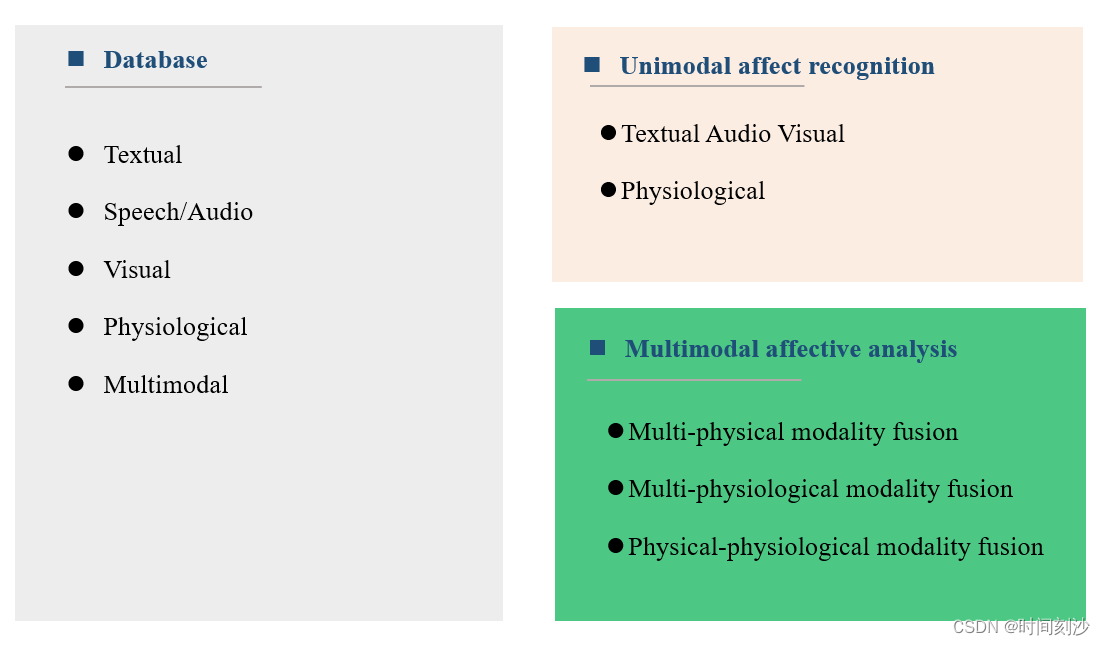

情感计算的研究对象有physical information物理信息和physiological signals生理信号,通过对这两者的研究搭建情感模型Discrete emotion model离散情感模型和

Dimensional emotion model维度情感模型,利用情感模型进行情感识别。

和其他人工智能方向一样,我们需要有数据库作为训练集进行训练。

5

主要使用到的数据库有,文字,语音,视觉,生理信号以及多形态综合,主要的研究方向也针对研究对象的不同划分为针对单个形态进行识别的Unimodal affect recognition即单峰情感和针对多模态进行分析的Multimodal affective analysis多模态情感识别。

6

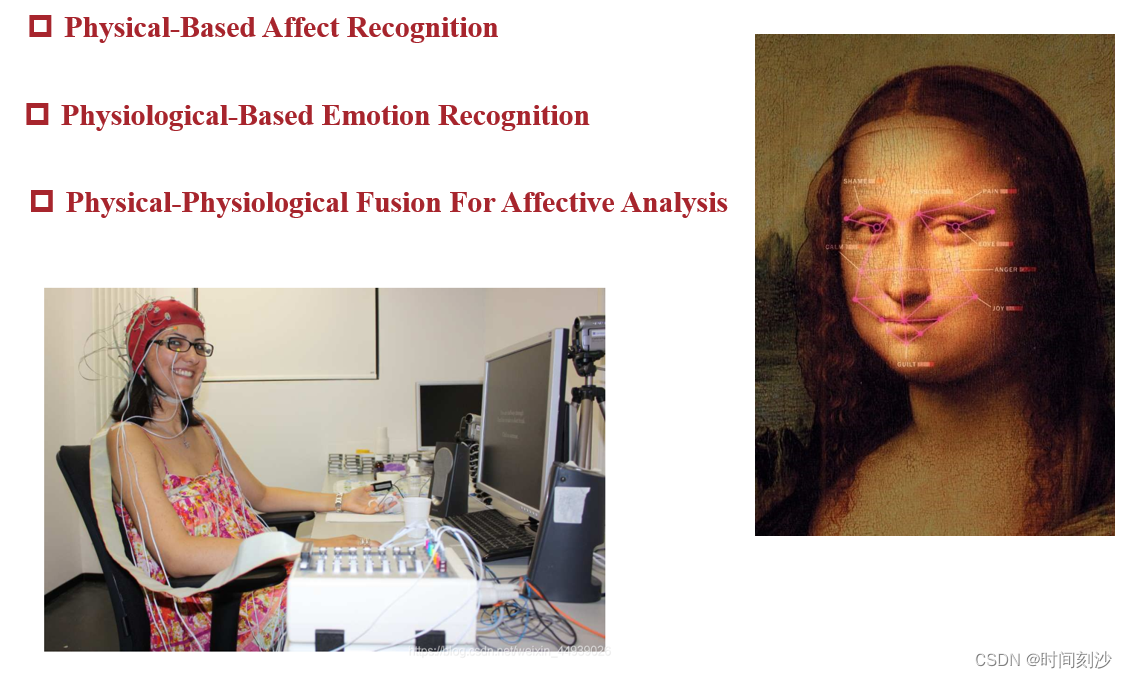

目前根据研究对象的不同,又可以将情感识别划分为这三种,分别是基于物理外在特征的情感识别,基于生理信号的情感识别,以及物理-生理融合的情感识别。

我们可以看到右边这个蒙拉丽莎的微笑,图中有很多点连成的线,这里就是FER即facial expression recognition中使用到的边界点,将人脸按照边界点进行划分获取人脸的几何模型,然后基于几何模型进行训练和情感分析。

下面这张图就是基于生理信号的情感识别,首先将很多传感器连在人身上获取人体生理信号,然后通过给被测试者观看不同的图片或者视频引导被测试者产生对应的情绪以进行生理信号的获取。

而物理-生理融合就是将这二者结合起来,即对外在物理特征进行分析,也对生理信号进行分析获得结果。

7.

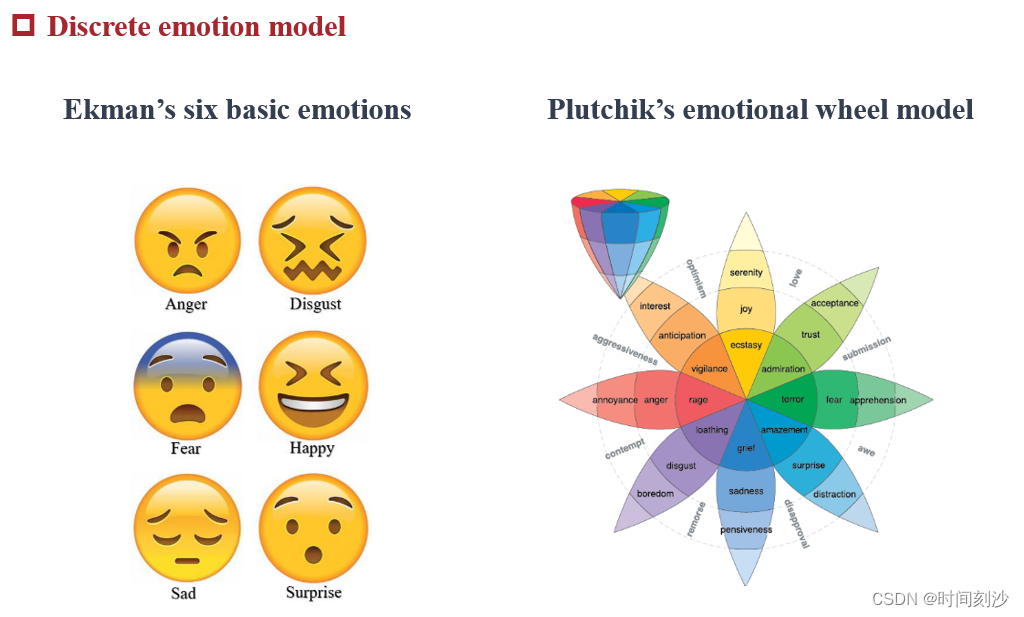

接下来我们介绍两个基本的情感模型,这里说的模型不是情感计算中用到的那种分类,训练的模型,而是对情感本身进行建模。首先是离散情感模型,离散情感模型主要有两种,一个是易克曼的六种基本情感,一个是普拉奇克的情感轮模型。

Ekman的六个基本情绪

anger,disgust,fear,happy,sad,suprise

遵循规则:

1)基本情绪都来源于人类天性

2)人类在同一的情况下会产生同样的情绪

3)人们在相同的语义下表达相同的基本情感

4)所有人表达基本情绪的方式相同

局限性:不同文化背景的人对不同情绪有不同的解读,不同的基本情绪会混合起来组成复杂的情绪。

Plutchik的情感轮模型

情感轮模型包含八种基本情绪,以及情绪之间的相互关联。情感轮模型将较强的情绪占据中心,而较弱的情绪占据极端,并且向外分化成更细粒度的情感,还将情感划分为三极(积极地,消极的,中性的)。为了便于描述细粒度的情感,使用了矛盾情感处理,增强了分类的性能。

8.

维度情感模型为了克服离散情感模型的挑战而建立的概念,目前最被认可的模型是PAD

P 代表愉悦度,表示个体情感状态的正负特性;

A 代表激活度,表示个体的神经生理激活水平

D 代表优势度,表示个体对情景和他人的影响或被影响状态

由于使用P和A两个维度已经可以表示大部分的情感了,所以Russell提出了基于Valence-Arousal的环状模式,是一个二维模型,x轴为V代号愉悦度,纵坐标为A代表激活度,总共有四个象限可以代表不同的情感状态。

通过维度情感模型,我们可以对情感的分析更加精细。

9.

然后是数据库,情感计算的数据库按照形态划分为文字数据库,语音数据库,视觉数据库,生理信号数据库和多形态数据库。其中由于当前人脸识别的发展以及面部表情包含较多的情感信息,视觉数据库又划分为面部表情数据库和肢体动作数据库。

这些数据库给出了我们能获取到的所有情感的数据。

文字数据库

Multi-domain sentiment (MDS)最早的文字情感数据库

包含超过十万条来自亚马逊的产品评论,划分为积极和消极两类以及五类情感类别(强积极,弱积极,中性,弱消极,强消极)。

语音数据库

划分为非自发性的和自发性的

早期使用非自发性的数据库,主要来源于专业演员的表演,代表有Berlin Database of Emotional Speech (Emo-DB)

后来为了减少表演导致的夸大的效果有了自发性的数据,主要有Belfast Induced Natural Emotion (Belfast)。

面部表情数据库

典型的有JAFFE,从213张图片含有7种面部表情

肢体动作情感数据库包含来自电影或者真实生活的肢体动作

EmoTV,FAce and BOdy database (FABO)等

生理数据库,使用生理信号更加有说服力主要使用的生理信号又EEG,ECG脑电图,心电图等。

多模式数据库

划分为两种,多重物理形态数据库以及物理和生理数据库。分别是将多个物理形态融合的数据库和将物理和生理信号共同包含在内的数据库。

10.

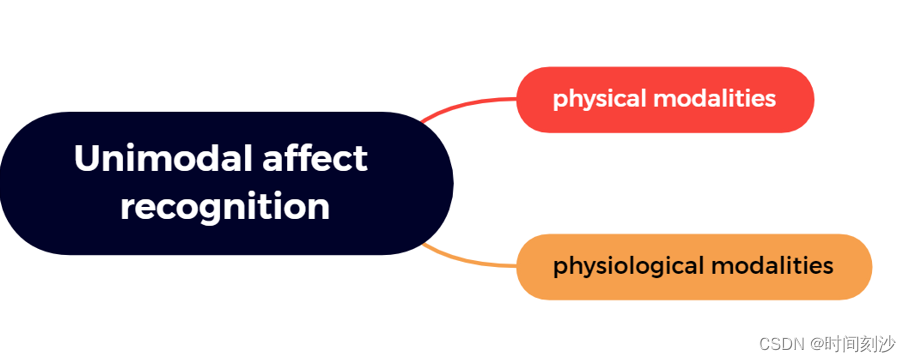

Unimodal affect recognition单峰情感识别,就是对单个形态进行情感分析,按照形态的不同,大类上分为物理形态和生理形态。

11.

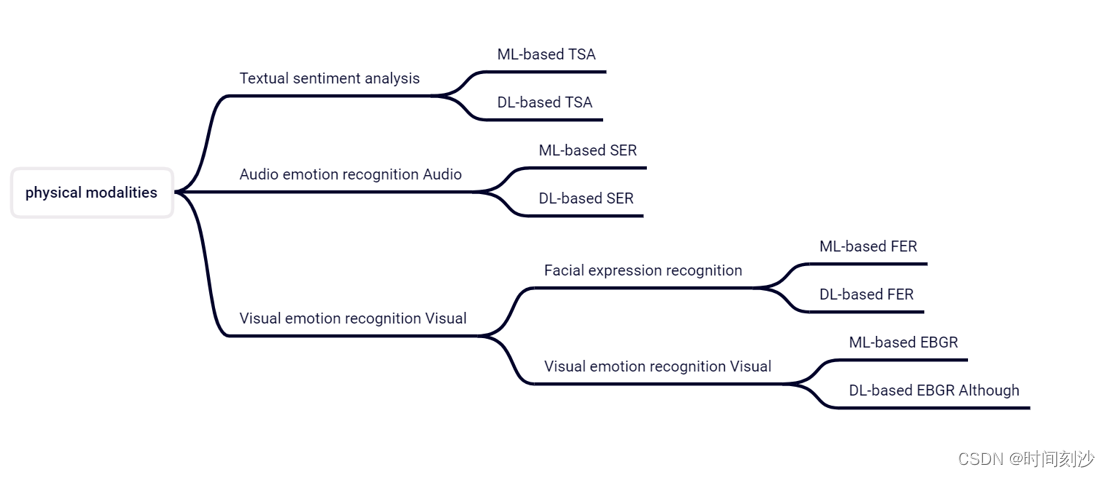

其中物理形态也划分为,基于文字的,基于语音的和基于视觉的,每个又由于使用的模型不同分为基于机器学习的和基于深度学习的。这里由于使用的方法过多,我不一一赘述,关于这两种方法的特点在最后总结我会统一介绍。

12.

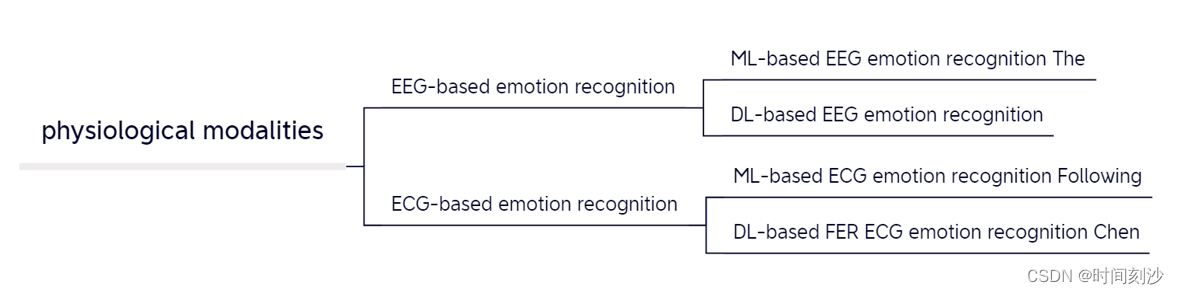

生理形态目前主要用的EEG和ECG也是按照处理方法不同划分为ML-based和DL-based.

13.

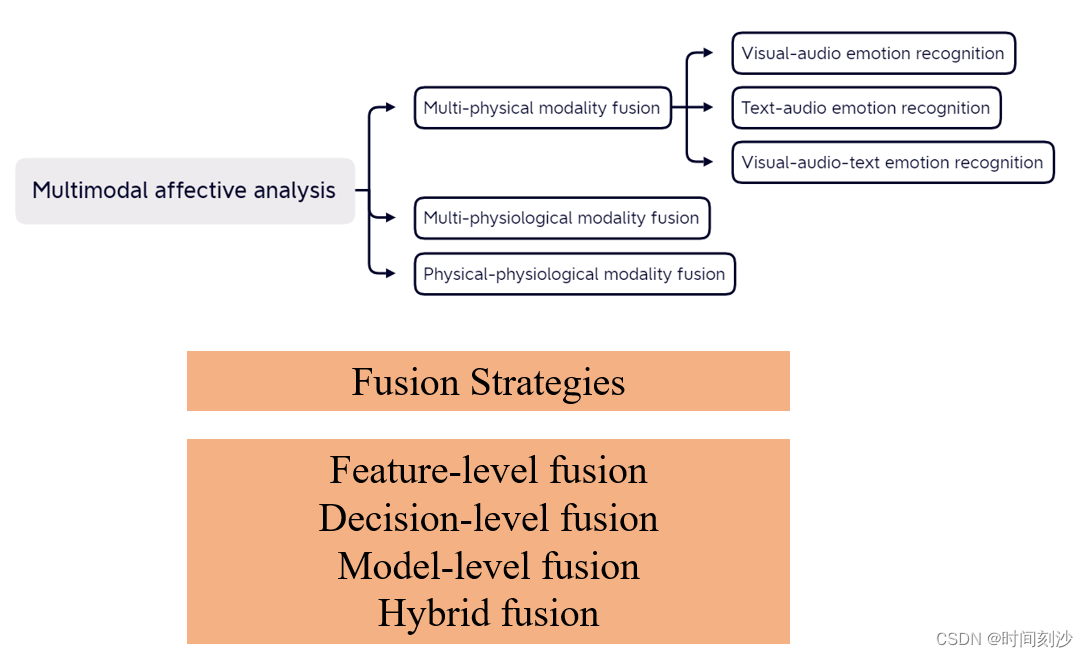

Multimodal affective analysis

多模态情感识别主要是将多个形态进行融合之后进行情感分析,主要也是按照形态的不同划分为,多物理模态融合,多生理模态融合和物理-生理模态融合。

融合的策略有

Feature-level fusion

将从多模态输入中提取的特征组合成一个一般的特征向量,然后将其发送到分类器中

Decision-level fusion

将每个模态独立生成的所有决策向量合并进行判断

Model-level fusion

发现从不同模式中提取的特征之间的相关特性,设计出性能更好的融合模型

Hybrid fusion将feature-level fusion and decision-level fusion结合起来。

14.

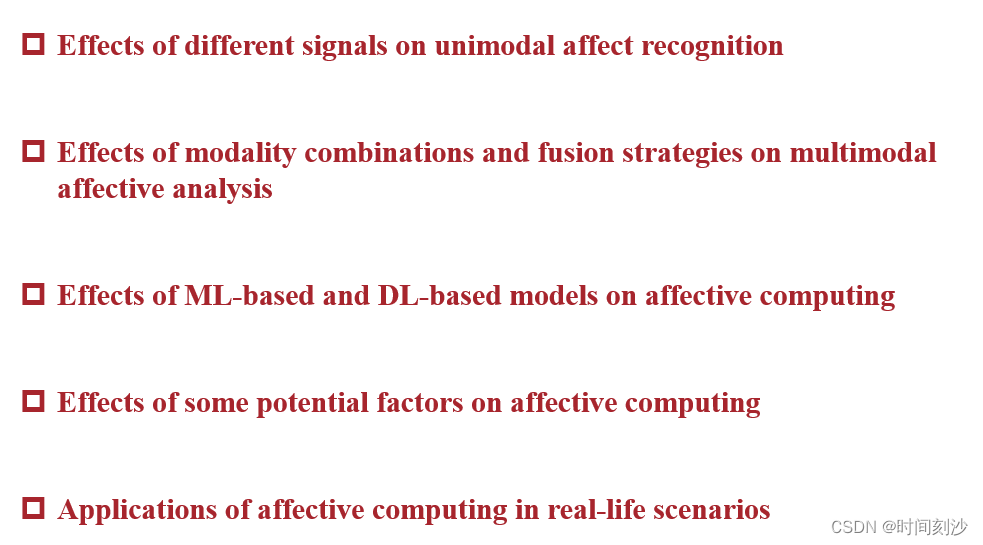

总结分为以下四点,首先是不同信号对单峰情感识别的影响

视觉模态最为常用,因为便于获取并且基于视觉的情感识别比基于音频的情感识别更有效,因为音频信号容易受到噪声的影响

又有研究表明,基于文字的情感分析的准确率最高

而且虽然可穿戴传感器采集的生理信号比物理信号更难获取,但由于其客观可靠的结果,许多基于eeg或基于ecg的情绪识别方法被研究和提出。

接着是第二点模态组合和融合策略对多模态情感分析的影响

多模态情感分析的两种基本融合策略是特征级融合和决策级融合

特征级融合明显比决策级融合更常见。

基于特征级融合的情感分类器的性能受到来自不同模式特征的时间尺度和度量级别的显著影响。

另一方面,在决策级融合中,将来自各个模态的输入独立建模,最后将这些单模态影响识别的结果进行合并。

与特征级融合相比,决策级融合更为容易,因为它只需要进行最后的决策融合但忽略了不同模式特征之间的相关性。

Hybrid-level融合将特征级和决策级结合起来,拥有两者的共同优点。

模型级融合使用HMM隐马尔可夫模型和贝叶斯网络建立不同模态特征之间的联系和一个宽松的融合模式,一般用于特殊的任务。

第三点是情感计算中基于机器学习和基于深度学习的模型的影响

ML包含信号预处理,手动特征提取和定制的分类器,泛用性不强。

SVM目前效果最好。

DL目前很火,由于其特征学习的功能。对于静态信息,CNN可以很好地提取特征,对于序列信号,RNN可以提取具有时间特性的特征,CNN-LSTM用于提取时间-空间特征,对抗学习用于提高模型的鲁棒性,此外注意力机制和自编码算法被嵌入到深度学习方法中用以提升全局性能。

但是ML在生理情感识别上比DL要强。

再讲一下一些潜在因素对情感计算的影响

目前数据库上的限制是情感计算发展失衡的原因之一,视觉-生理情感识别方法目前就较少,因为对应的数据库数量的限制。

最后是情感计算的日常应用。

基于文字的情感计算用于推荐系统

基于视频的情感分析用于教学,决策辅助等

由于音频/语音情绪信号的可靠性和稳定性,以及可穿戴设备生理信号的可达性,音频和生理信号常被用于检测临床抑郁和应激。

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。