热门标签

热门文章

- 1卷积神经网络中的参数学习_卷积核可学习参数

- 2Android8.1设备手工更新WebView_安卓系统webview更新

- 3管理maven项目,隔离开发环境数据库与生产环境数据库_开发环境和生产环境的数据库

- 4MacOS 开发 — NSOpenPanel & NSSavePanel的使用

- 5深入讲解Laravel模板引擎Blade_laravel blade

- 6Flink 配置2:Docker 部署 Flink 集群环境_docker 配置 多环境 flink 集群

- 7 引入创新:H-GCN—为图卷积网络赋能的高效解决方案

- 8Python学习笔记_Windows下Python执行DOS命令_windows如何使用dos执行env环境的python脚本

- 9canal整合rabbitmq_canal1.1.6 + rabbit

- 10谷粒商城 es的检索运用,searchrequest的构建

当前位置: article > 正文

43.7k star! 轻松在本地运行Llama2、Gemma等多种大模型,无需GPU!_可以本地跑的大模型

作者:你好赵伟 | 2024-07-23 04:57:30

赞

踩

可以本地跑的大模型

今天推荐的这个项目可以让我们轻松在本地运行Llama2、Gemma等多种开源大模型,

Github地址放在文末。该项目吸引作者的几个特点:

-

支持使用CPU,普通个人电脑可运行。

-

一键安装,超级简单,支持windows/linux/mac。

-

支持Llama 2、Gemma、通义千问、LLaVA(图片识别)等多种大模型。

-

可提供REST API服务。

-

生态丰富,围绕着该项目已经产生了多种webui、桌面软件、sdk库等。

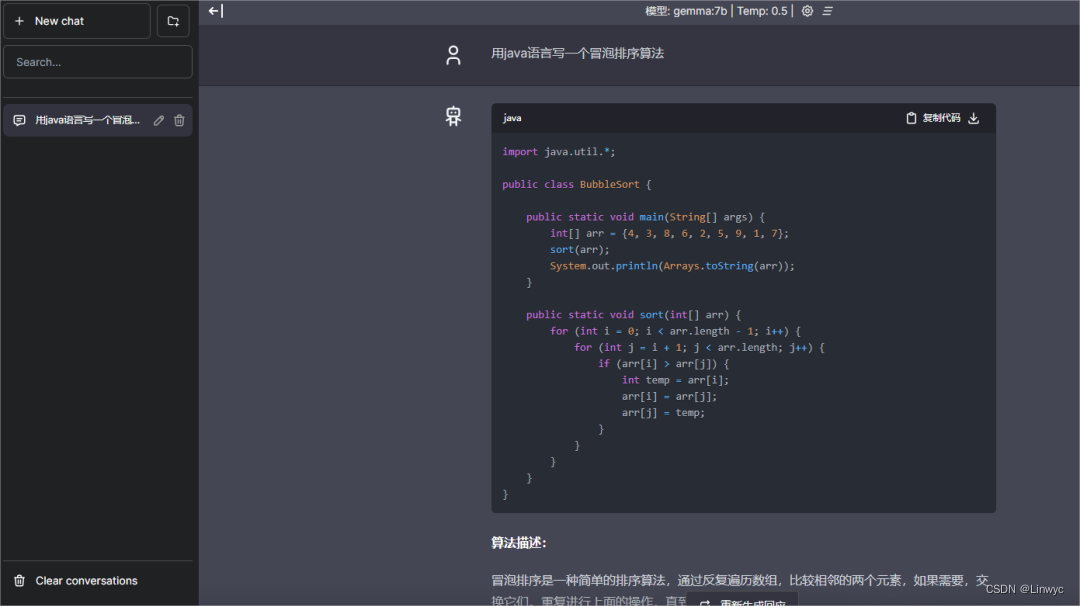

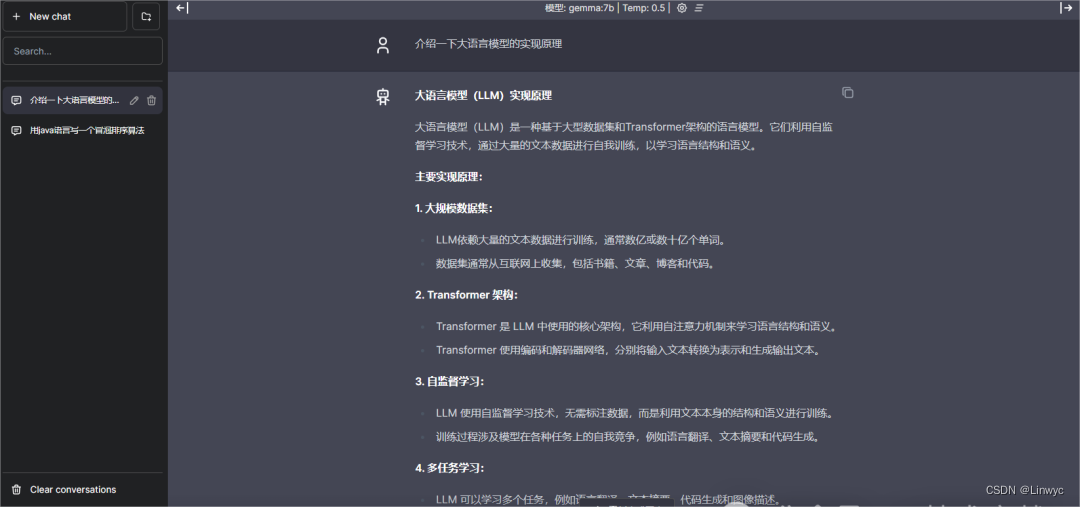

以下是作者的实战效果,注意这是本地离线运行,不需要联网。

下面跟着作者快速实现一个如上图所示的应用。

1.安装运行大模型

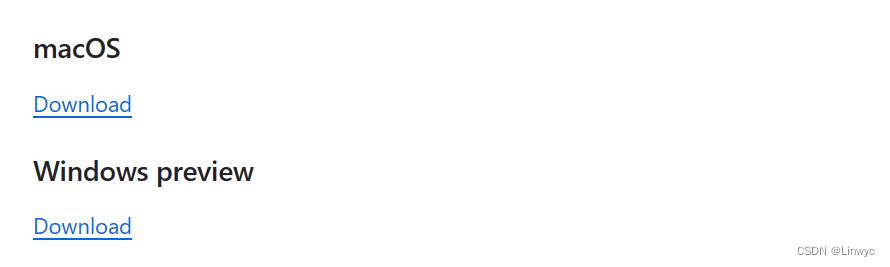

在项目的github主页下载windows版本。

或Linux系统安装,使用如下方式:

curl -fsSL https://ollama.com/install.sh | sh下载后双击安装完成,在cmd中输入下面命令,一键运行Llama2模型(作者电脑16G内存,理论上8G也可以使用)。

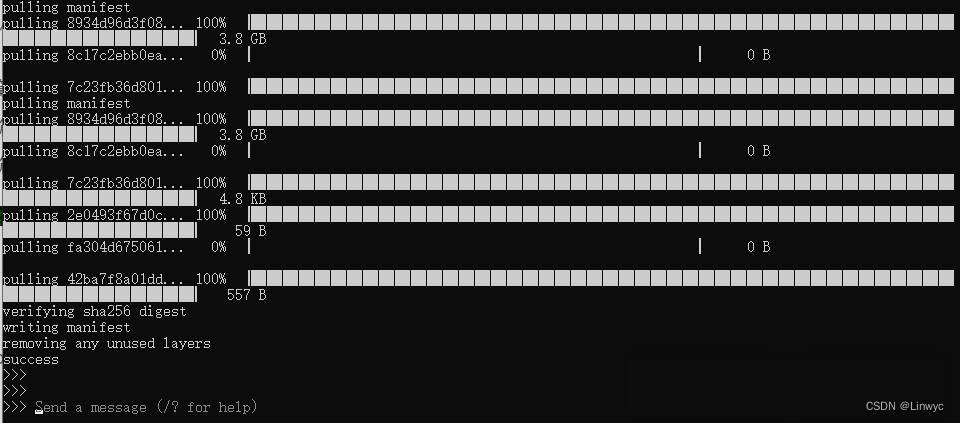

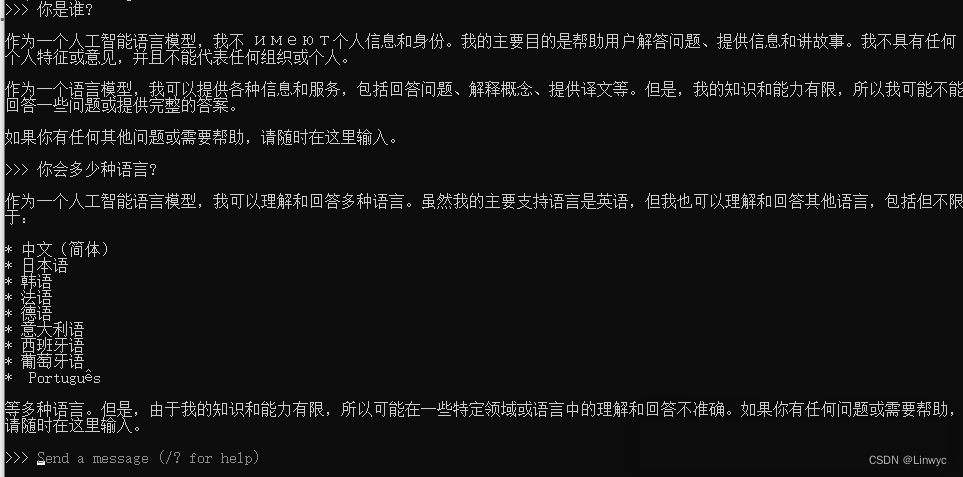

ollama run llama2等待直至出现以下界面,即成功运行。

在"Send a messsage"处输入问题,模型就可以回答了,至此已安装成功,是不是超级简单!

2.部署web界面

下面我们部署一个类似ChatGPT界面的web ui,运行以下docker命令。

docker run -p 3000:3000 ghcr.io/ivanfioravanti/chatbot-ollama:main如下图所示,一键部署成功。

用浏览器打开http://localhost:3000,即可像使用ChatGPT一样使用自己的私有GPT了,重点是可以离线使用,数据更安全!

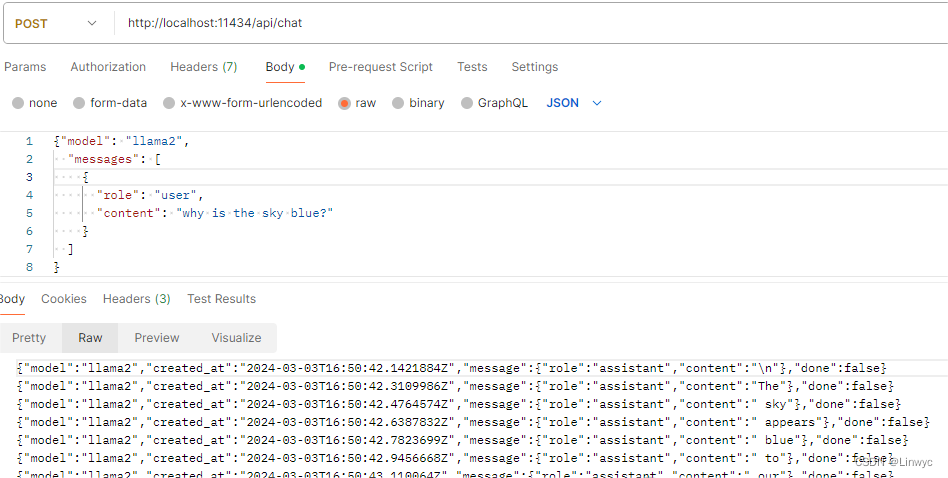

3.使用REST API

截图展示一下REST API的能力,更多参数请查阅官方文档。

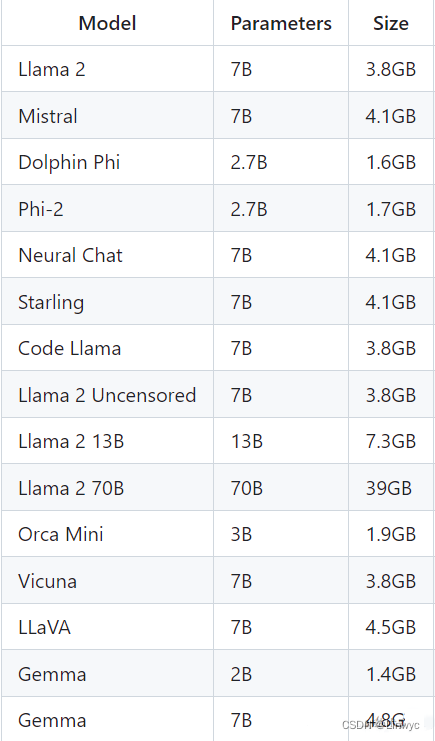

4.内存要求

支持多种模型,每种模型有多个参数,运行7B参数模型需要至少8G内存,运行13B参数模型需要至少16G内存,运行33B参数模型需要至少32G内存。以下是几种模型的参数与模型大小,更多模型可查阅官方文档。

5.github地址

https://github.com/ollama/ollama,更多功能请参考官方文档,如有问题也可在评论区留言。

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

推荐阅读

相关标签