热门标签

热门文章

- 1【区块链+绿色低碳】雄韬智慧锂电储能管理系统 | FISCO BCOS应用案例

- 2istio介绍(二)

- 3【转贴】Error Handling in SQL Server

- 4PostgreSQL 编译安装通用步骤_postgresql编译安装

- 5广州数控机器人编程讲解视频_广州数控工业机器人如何编程,使用什么语言?...

- 6Spring boot 2.0 升级到 3.3.1 的相关问题 (五)

- 7【Leetcode单调队列】- 洛谷P1714切蛋糕_切蛋糕差值最小leetcode

- 8智能排水解决方案,设备实时监控+预测分析,真正实现“无人值守”!_引、制水损耗分析

- 9深入理解Symbol之用法及其应用场景探索_symbol标签

- 10ControlNet 1.1重磅发布,14个模型全部开源!_controlnet模型下载

当前位置: article > 正文

【AI实践】Ollama本地安装大模型服务_ollama下模型

作者:你好赵伟 | 2024-07-30 13:36:38

赞

踩

ollama下模型

Ollama安装运行

安装与配置

安装默认在C盘,成功后,window任务栏图标会有Ollama Logo

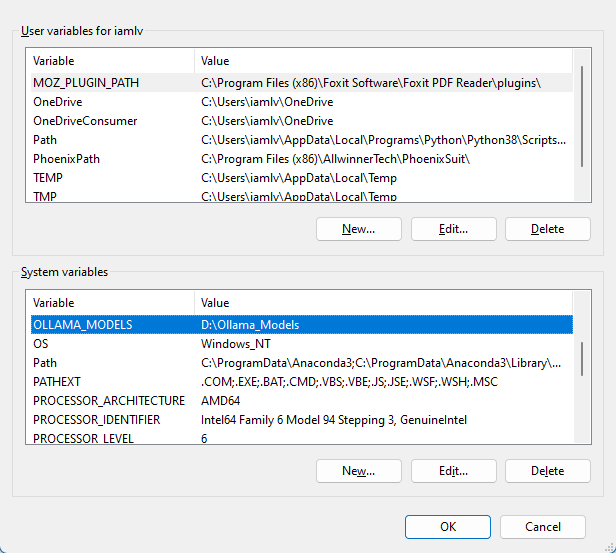

为了不占用C盘更大的空间,修改模型下载路径,修改环境变量

下载模型

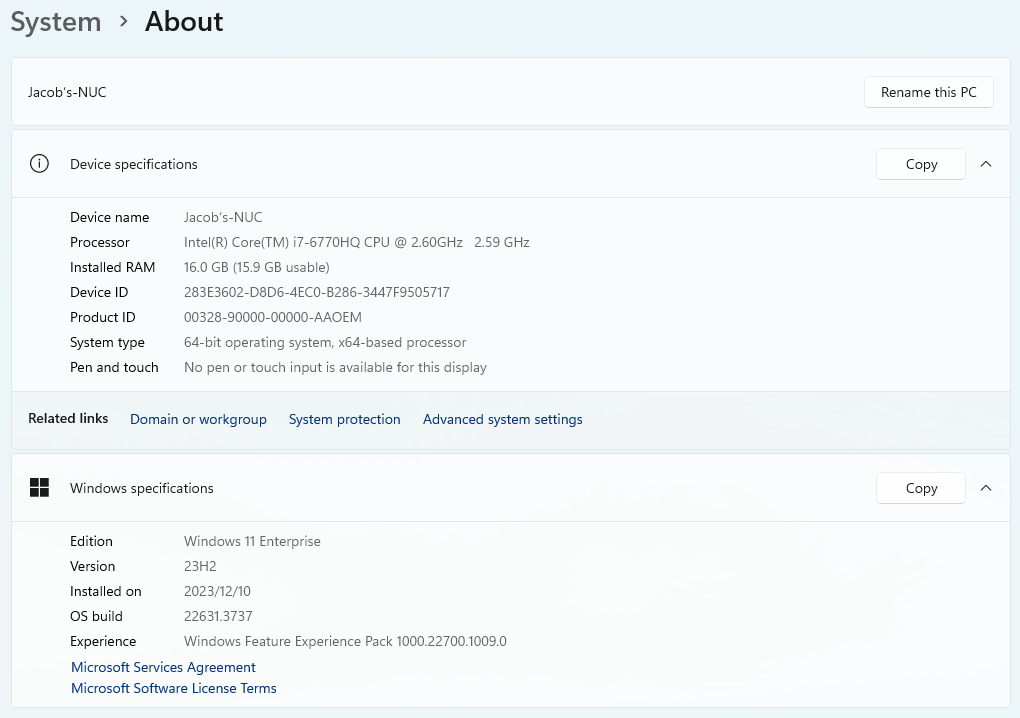

由于我电脑是第六代Intel,集显,没有独立显卡;这里选择3B比较小的模型,防止模型太大响应太慢;

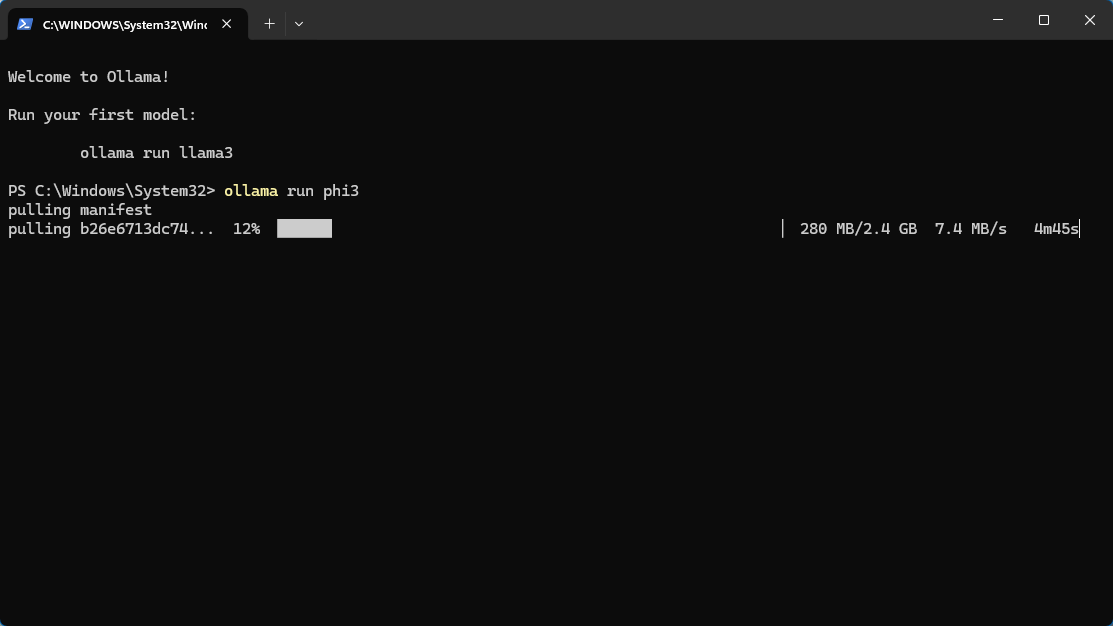

在Window系统的PowerShell软件,或者Windows Terminal中输入命令

ollama run phi3此处使用微软的phi3模型,3B的版本,2.4GB大小;

下载完成

首次安装完成,就进入了,运行模型的窗口

后续运行模型

- PS C:\Users\iamlv> ollama run phi3

- >>>

回复速度如下图

另外安装运行模型llama3, 7B版本

- PS C:\Users\iamlv> ollama run llama3

- >>>

网页界面交互

open WebUI提供web网页

open WebUI的安装有很多方法,如下文,推荐docker容器安装,

推荐阅读

相关标签