热门标签

热门文章

- 1【人工智能】Transformers之Pipeline(五):深度估计(depth-estimation)_模型pipeline

- 2嵌入式蓝桥杯单按键,双击按键,长按键的实现(含按键消抖)_蓝桥杯嵌入式双击

- 3《数据结构(C语言版)第二版》第五章-树和二叉树(5.4-5.5.1)

- 4android模拟器不玩游戏,安卓模拟器哪个玩游戏最流畅?

- 5负载均衡 LVS vs Nginx 对比!还傻傻分不清?

- 6【优化】Vue项目如何优化?这篇文章就够了!超全优化方面_vue项目优化

- 7shell 编程大全

- 8IPD(集成产品开发)_ipd流程

- 9云计算在大数据处理中的核心优势

- 10c语言实现动态顺序表的增删查改_实现动态可扩容的顺序表类模板,并使用自定义类型进行增删查改测试

当前位置: article > 正文

️ LangChain +Streamlit+ Llama :将对话式人工智能引入您的本地设备(下篇)

作者:你好赵伟 | 2024-08-08 20:15:47

赞

踩

️ LangChain +Streamlit+ Llama :将对话式人工智能引入您的本地设备(下篇)

引言:种下一棵树最好的时间是十年前,其次是现在

书接上回:将对话式人工智能引入您的本地设备成为可能CSDN![]() https://mp.csdn.net/mp_blog/creation/editor/140865426

https://mp.csdn.net/mp_blog/creation/editor/140865426

目的:在这个大模型横行的时候,我们常用电脑如何开展大模型的工作,上篇文章已经提到,那么这篇文章我教大家怎么去实践。

1、首先官方合作的Github地址供你们参考下载:DocQAGitHub - afaqueumer/DocQA: Question Answering with Custom FIles using LLMsQuestion Answering with Custom FIles using LLMs. Contribute to afaqueumer/DocQA development by creating an account on GitHub.![]() https://github.com/afaqueumer/DocQA?tab=readme-ov-file

https://github.com/afaqueumer/DocQA?tab=readme-ov-file

2、本文引入的大模型地址下载:llama-7b.ggmlv3.q3_K_S.bin

https://huggingface.co/TheBloke/LLaMa-7B-GGML/tree/main

3、运行setup_env.bat

4、运行run_app.bat

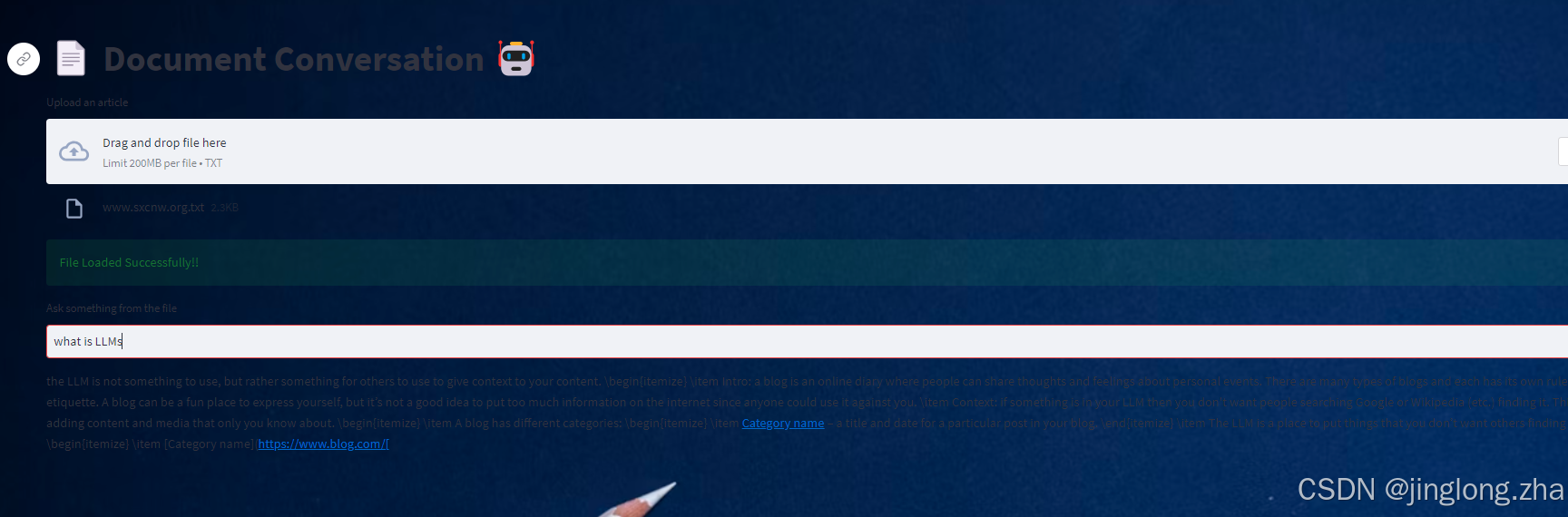

5、结果展示,运行成功

6、上传txt文件(Tips,目前英文的,中文报错,大家可以调试)

7、文本框里边提问:下面是跑的结果,跟你训练的数据有关系,数据量太小的话,有可能造成幻读,大家可以多跑一些数据,测试一下效果,毕竟cpu电脑跑数据还是挺差劲的,太慢了!!!

好了,今天就先到这里,如果有什么不懂的?可以私聊一下老师,欢迎大家一键三连啊!!!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/949762

推荐阅读

相关标签