热门标签

热门文章

- 1jenkins自动化部署_jenkins打包,发布,部署

- 2opencv图像美化_opencv 图像美化

- 3计算机基础知识和实践技能300分,2019年河北省普通高职单招考试十类和对口电子电工类、计算机类联考考试内容...

- 4VideoCrafter - 文本生成视频

- 5openMP编程详解(囊括所有基本指令)

- 6函授大专计算机考证_函授大专计算机专业可以考什么证

- 7一分钟教你把Notion变为中文版_notion怎么变成中文版

- 8axios详解以及完整封装方法_axios封装

- 9esxi6.7安装MacOS 10.15_esxi6.7安装mac os 卡住

- 10Android HAL层添加HIDL实例实现串口通信_android 新增hidl接口

当前位置: article > 正文

“源神”-马斯克,打脸OpenAI,如期开源Grok大模型

作者:凡人多烦事01 | 2024-03-20 00:40:59

赞

踩

“源神”-马斯克,打脸OpenAI,如期开源Grok大模型

ChatGPT狂飙160天,世界已经不是之前的样子。

新建了人工智能中文站https://ai.weoknow.com

每天给大家更新可用的国内可用chatGPT资源

“源神”-马斯克

就在刚刚,马斯克的xAI正式开源了Grok大模型的代码、权重和架构。该模型有3140亿参数,是Llama 2的4倍。这也是它成为,迄今为止参数量最大的开源大模型。

发布10个小时,Github上狂揽1万Star、1000Fork。

Grok基本信息

- 训练时间为2023年10月,使用Rust和JAX从零开始训练

- 参数量3140亿(是不是很熟悉的数字,没错就是π)

- 混合专家模型,8个混合专家(Mo8E)

- 64层神经网络

- 8k最大上下文

- 6144的Embedding长度

教程

硬件要求:

由于该模型参数巨大,劝退了绝大部分个人开发者(土豪除外)。还没有详细的硬件要求清单,但大体上对显卡的要求是:4-bit量化需要320G显存、8-bit量化版需要600G显存。

(后续再更新详细硬件要求)

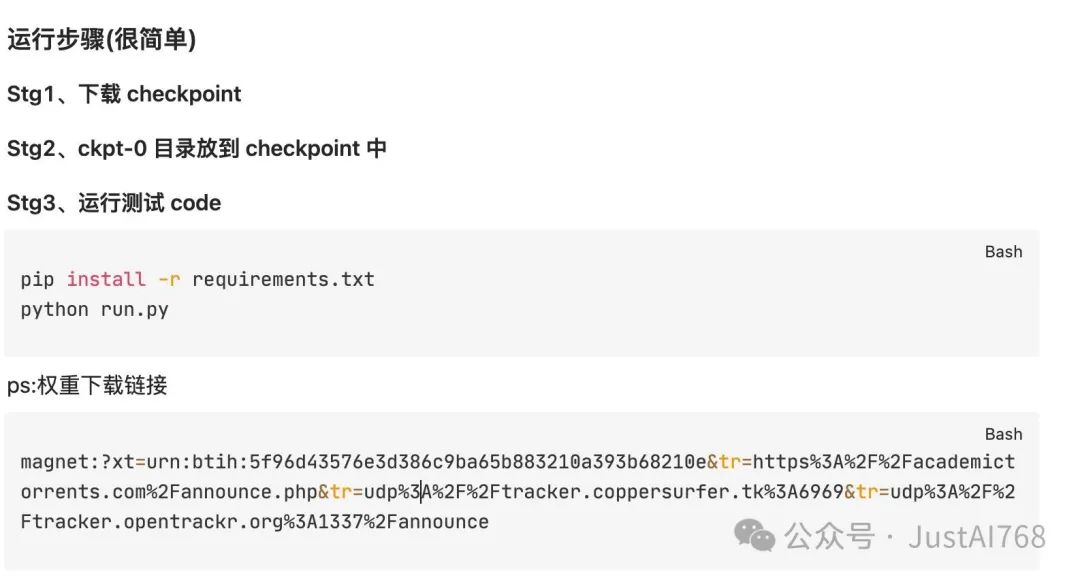

运行步骤(很简单)

Stg1、下载checkpoint

Stg2、ckpt-0目录放到checkpoint中

Stg3、运行测试code

pip install -r requirements.txt python run.py

ps:权重下载链接

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

ChatGPT狂飙160天,世界已经不是之前的样子。

新建了人工智能中文站https://ai.weoknow.com

每天给大家更新可用的国内可用chatGPT资源

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/269416

推荐阅读

相关标签