- 1改进YOLO系列 | ICLR2022 | OMNI-DIMENSIONAL DYNAMIC CONVOLUTION: 全维动态卷积

- 2yolov8和yolov5对比_yolov5和yolov8

- 3【深度学习:Foundation Models】基础模型完整指南_foundation model有哪些

- 4chatgpt赋能python:Python求mse——介绍和步骤详解_python mse

- 5backgroundremover使用_background remove

- 6长度外推性(指我们在短序列上训练的模型,能否不用微调地用到长序列上并依然保持不错的效果)【ALIBI位置编码】(像RoPE算是外推能力较好的位置编码,也只能外推10%到20%左右的长度而保持效果不变)_位置编码 外推 内扩

- 7链路追踪详解(四):分布式链路追踪的事实标准 OpenTelemetry 概述_调用链追踪技术opentelemetry

- 801_推荐系统简介

- 9Unable to start debugging. Unexpected GDB output from command “-environment -cd xxx“ No such file or_unable to start debugging unexpected gdb output fr

- 10机器翻译技术的含义、发展和应用

ChatGPT 最好的替代品_chatgpt识别技术是否有更合适的技术替代

赞

踩

前两天我们邀请了微软工程师为我们揭秘 ChatGPT,直播期间有个读者问到:有了 ChatGPT,BERT 未来还有发展前途吗?我想起来最近读过的一篇博客“最好的 ChatGPT 替代品”。

不过聊到这俩模型,就不得不提到 Transformer。

作为当下最先进的深度学习架构之一,Transformer 被广泛应用于自然语言处理领域。它不但替代了以前流行的 RNN 和 LSTM,并且以它为基础衍生出了诸如 BERT、GPT-3、T5 等知名架构,最近爆火的 ChatGPT 就是基于 GPT-3.5 。

那 Transformer 是如何工作的呢?我们通过一个文本翻译实例来解释。

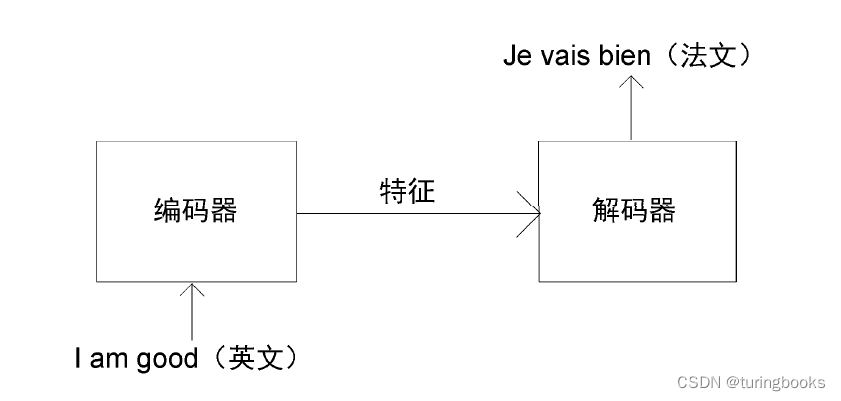

Transformer 由编码器和解码器两部分组成。假设我们需要将一个句子从英文翻译为法文。首先,我们需要将这个英文句子(原句)输进编码器。编码器将提取英文句子的特征并提供给解码器。最后,解码器通过特征完成法文句子(目标句)的翻译。

此方法看起来很简单,如何实现呢?Transformer 中的编码器和解码器是如何将英文转换为法文的呢?编码器和解码器的内部又是怎样工作的呢?

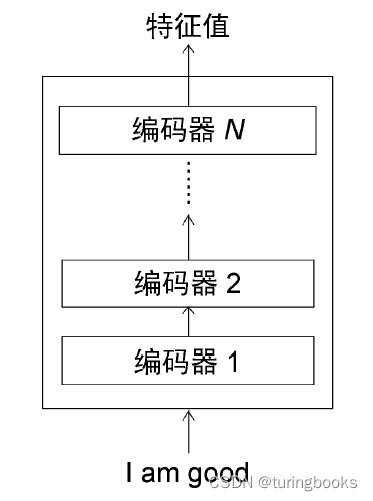

在 Transformer 中,编码器不止一个,而是由 N 个编码器串联而成。一个编码器的输出作为下一个编码器的输入。以此类推,原句中的特征会由最后一个编码器输出。编码器模块的主要功能就是提取原句中的特征。

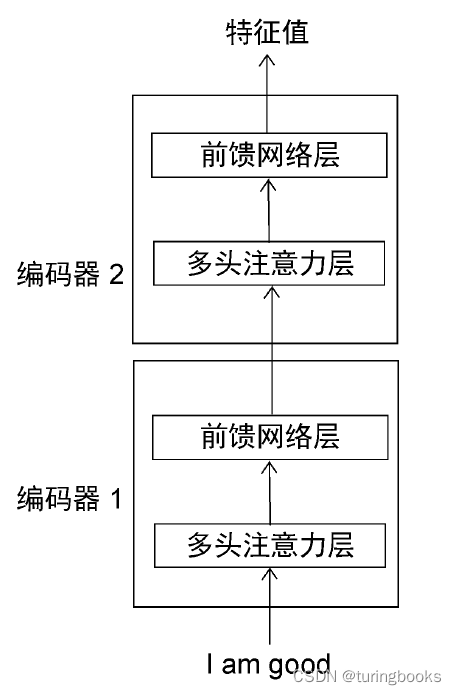

然后我们将编码器分解,每一个编码器的构造都是相同的,包含多头注意力层和前馈网络层两部分:

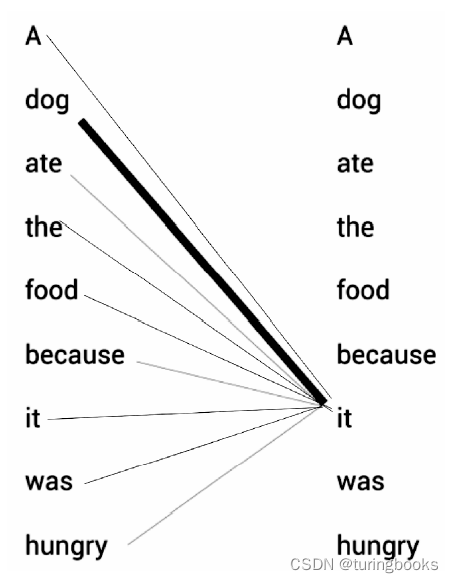

这两部分是如何工作的?我们先来看多头注意力层,很显然,要了解多头注意力机制的工作原理,我们首先需要理解什么是自注意力机制。请看下面的例句:

A dog ate the food because it was hungry

(一只狗吃了食物,因为它很饿)

代词 it 可以指代 dog 或者 food。当读这段文字的时候,会自然而然地认为 it 指代的是 dog,而不是 food。但是计算机模型在面对这两种选择时该如何决定呢?这时,自注意力机制有助于解决这个问题。

我们的模型首先计算出句子中每个单词的特征值,即首先计算 A 的特征值,其次计算 dog 的特征值,然后计算 ate 的特征值……当计算每个词的特征值时,模型都需要遍历每个词与句子中其他词的“关系”,这个“关系”就能帮助计算机更好地理解当前词的意思。

比如计算 it 的特征值时,模型会将 it 与句子中的其他词一一关联,it 的特征值由它本身与句子中其他词的关系计算所得。通过关系连线,模型可以明确知道原句中 it 所指代的是 dog 而不是 food,这是因为 it 与 dog 的关系更紧密,关系连线相较于其他词也更粗。

到这里,我们已经初步了解了什么是自注意力机制,那它具体是如何实现的呢?

大家可以继续阅读《BERT基础教程:Transformer大模型实战》,作为 ChatGPT 的“同胞兄弟”,本书会带你理解与整合编码器、解码器,训练Transformer,简化自然语言处理任务!

这本书从深入解析Transformer 的编码器和解码器的组成部分开始,帮你理解自然语言处理模型的工作原理,同时由浅入深地介绍了 BERT 自然语言处理模型的工作原理、BERT 的各种变体及其应用。如果你希望了解:

如何训练 BERT 模型?

如何使用 BERT 模型执行自然语言推理任务、文本摘要任务、问答任务、命名实体识别任务等各种下游任务?

如何将 BERT 模型应用于不同的语言?

那么《BERT 基础教程》这本书将通过大量示意图、代码、实例,给你答案!

循序渐进,轻松上手

本教程由浅入深地介绍了有关 BERT 的各种概念、术语,能让你感受到是一个老师在一步步去引导你,然后亲手训练和理解BERT模型。

以简驭繁,逐步拆解

这本书对小白非常友好,通过大量的示意图,逐步拆解复杂原理

全面系统,技巧灵动

本书为大家呈现了多种下游任务,同时详细讲解十余种BERT变体的原理,随处可见作者实战多年凝练出的小技巧,让你运用起来更灵活

大量练习,运用自如

自己不上手试试,理论总会浮在书本上。本教程中包含了大量作者精心挑选的示例和习题,让你不仅能够全面了解有关BERT 的各种概念、术语和原理,还能够使用BERT 模型及其变体执行各种自然语言处理任务。

希望利用 BERT 超强的理解能力来简化自然语言处理任务的伙伴们,本书预售已开启,到手价 49.8!

小编提到的博客,详见:

https://www.digitaltrends.com/computing/the-best-chatgpt-alternatives-according-to-chatgpt/