AI基础知识(3)--神经网络,支持向量机

赞

踩

1.什么是误差逆传播算法(error BackPropagation,简称BP)?

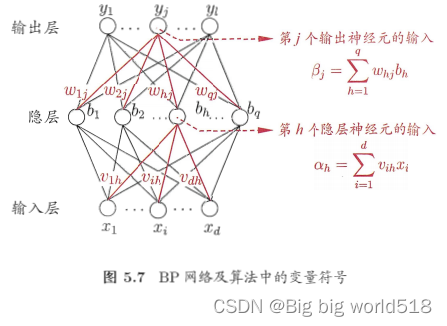

是神经网络通用训练算法,BP算法的基础是基于梯度下降(gradient descent)的误差函数优化,梯度是基于误差对每一个权重值的梯度。因为利用了神经网络的层次结构,所以显著提高了计算效率。BP的算法工作流程大致是:先将输入样本输入给输入层神经元,再将误差逆向传播至隐层神经元,最后根据隐层神经元的误差来对连接权(connection weight)和阈值(threshold)进行调整,这也是“基于误差”的思想所在,该过程迭代调整,直到训练误差达到一个很小的值。

2.如何解决误差函数中参数寻优陷入局部极小的问题?

(1)以多组不同的值初始化多个神经网络,按标准方法训练之后,取其中误差最小的解作为参数。这相当于从不同的初始点开始搜索,这样就可能陷入不同的局部最小。

(2)使用“模拟退火”(simulated annealing)技术,模拟退火每一步都在以一定的概率接受比当前更差的结果,从而有助于“跳出”局部极小。

(3)使用随机梯度下降,与标准梯度下降计算机误差精度不同,随机梯度下在计算梯度时加入了随机因素,即使陷入局部极小点,它计算出的梯度仍可能不为0,这样就有机会跳出局部极小。

3.什么是预训练(pre-training)?

由于多隐层神经网络在多隐层逆传播时,往往会“发散”(diverse)而不能收敛到稳定状态,所以采用预训练方法,训练时将上一层隐结点的输出作为输入,而本层隐结点的输出作为下一层隐结点的输入。在预训练结束后,再对整个网络进行微调(fine-tuning)。

4.什么是支持向量机(support vector machine)?

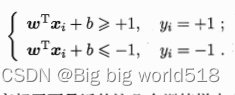

首先解释支持向量(support vector),是指距离超平面,最近的几个点使得下面公式的等号成立,他们被称为“支持向量”。

两个异类支持向量到超平面的距离称为间隔(margin),欲找到具有“最大间隔”(maximum margin)的划分超平面,也就是找到能满足上面约束条件的参数w和b,使得margin最大,这就是支持向量机(SVM)的基本型:对于二分类问题,找到一个超平面,使得margin最大。