热门标签

热门文章

- 1Mac系统IDEA-tomcat的配置_mac idea配置tomcat

- 2【git】git@github.com: Permission denied (publickey).报错问题_git permission denied (publickey).

- 3【学习记录】Open-WebUI 非Docker安装_openwebui 非容器化部署

- 4基于React的低代码开发:探索应用构建的新模式_react 实现低代码开发

- 5git(3)Git 分支

- 6华为云安装tomcat后配置安全组并且开放8080端口依然无法访问解决_华为云开放8080端口

- 72022高教社杯国赛B题C题如何解决?_2022国赛b题无人机遂行编队飞行中的纯方位无源定位数学建模范文

- 8git pull报错“您对下列文件的本地修改将被合并操作覆盖”_error: 您对下列文件的本地修改将被合并操作覆盖:

- 9Spring Boot整合Elasticsearch完整版之es索引库完整操作篇_springboot整合elasticsearch创建索引

- 107月10日币圈空投糖果推荐_18692296627

当前位置: article > 正文

每天五分钟深度学习:逻辑回归算法的损失函数和代价函数是什么?

作者:凡人多烦事01 | 2024-04-15 12:48:37

赞

踩

每天五分钟深度学习:逻辑回归算法的损失函数和代价函数是什么?

本文重点

前面已经学习了逻辑回归的假设函数,训练出模型的关键就是学习出参数w和b,要想学习出这两个参数,此时需要最小化逻辑回归的代价函数才可以训练出w和b。那么本节课我们将学习逻辑回归算法的代价函数是什么?

为什么不能平方差损失函数

线性回归的代价函数我们使用的是预测值和实际值的平方差或者平方差的一半,但是逻辑回归我们并不能使用这样的代价函数,因为当学习逻辑回归参数的时候,我们会发现我们的优化目标不是凸优化问题,会有多个局部最优值,梯度下降法很有可能找不到全局最优值,虽然平方差是一个不错的损失函数,但是在逻辑回归不行,所以我们要在逻辑回归中定义另外一个代价函数。

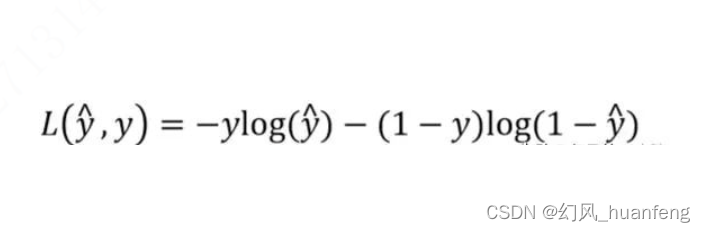

逻辑回归的单样本损失函数

这个就是逻辑回归的损失函数(一个样本的损失),为什么逻辑回归使用这个损失函数呢?

当y=1时,损失函数为L=-log(y^),要想让L尽可能地小,那么y^就要尽可能地大,因为sigmoid函数取值为【0,1】,所以y^会无限接近1,这样y^≈1

当y=0时,损失函数L=-log(1-y^),如果想要让L尽可能地小,那么y^就要尽可能地小,为sigmoid函数取值为【0,1】,所以y^会无限接近0,这样y^≈=0

这个就是sigmoid地作用,其实在很多函数和sigmoid效果类似,就是y=1时,我们就尽可

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/427958

推荐阅读

相关标签