热门标签

热门文章

- 1Vue3实战笔记(36)—粒子特效完成炫酷的404

- 2用wireshark抓取HTTP的get和post方法流量包_wireshark http get

- 3unity5x+UGUI屏幕自适应(多分配率适配)_ue5分屏显示

- 4GenerateAllSetter插件使用方法

- 5MongoDB中的_id和ObjectId

- 6大智能:大数据+大模型+大算力_大数据 大模型 大算力 大智能

- 7物联网行业定位应用场景及其解决方案_物联网定位技术应用案例场景及功能展示

- 8Idea中解决Git冲突问题及merge代码消失问题【git常用tips】_idea git merge

- 9政安晨:【Keras机器学习示例演绎】(四十九)—— 利用 KerasNLP 实现语义相似性

- 10Node.js入门 03:模块化规范 CommonJS 与 ES Module_commonjs规范

当前位置: article > 正文

Execution Error, return code 3 from org.apache.hadoop.hive.ql.exec.spark.SparkTask. Spark job faile_failed: execution error, return code 3 from org.ap

作者:凡人多烦事01 | 2024-05-31 06:05:18

赞

踩

failed: execution error, return code 3 from org.apache.hadoop.hive.ql.exec.s

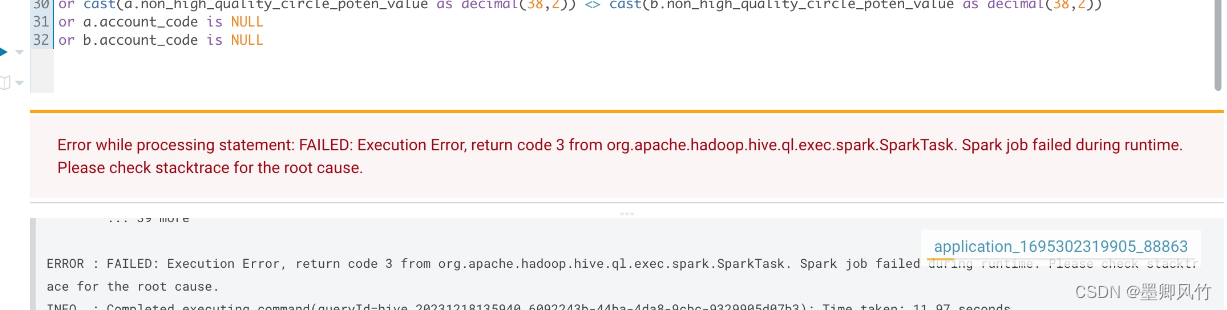

hive on spark 错误Error while processing statement: FAILED: Execution Error, return code 3 from org.apache.hadoop.hive.ql.exec.spark.SparkTask. Spark job failed during runtime. Please check stacktrace for the root cause.

表明Spark任务执行失败,返回了错误代码3。这可能是由于多种原因导致的,例如内存不足、JSON数据格式错误、缺少JSON Serde等。

还有一些其他可能的原因,例如内存不足、Hive配置参数等。可以尝试调整Hive on Spark的相关配置参数,例如mapred.map.child.java.opts和mapred.reduce.child.java.opts,以及hive.auto.convert.join等参数,来解决内存不足的问题。

最后,建议查看Spark任务的详细日志,以获取更多关于作业失败的具体原因。可以通过Spark History Server或YARN Resource Manager UI来查看作业的详细日志,以便更好地定位和解决问题。

set mapred.map.tasks.speculative.execution=true

set mapred.reduce.tasks.speculative.execution=true

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/650729

推荐阅读

相关标签