- 1【网络服务&数据库教程】10 MySQL 数据类型_用mysql统计各类商品对应的类型数量(类型名称,类型数量)

- 2Windows Hook原理与实现(转载)_windows hook框架

- 3禁止 Android SystemUI 下拉状态栏展开 Quick QS Panel_android7 systemui 禁止状态栏下拉 详解

- 4浅谈数组与指针的区别_数组指针和普通指针区别

- 5Oracle集合运算

- 6浙江大学计算机学院软件学院,浙江大学软件学院

- 7python:logistic,softmax函数_logistic函数 softmax函数

- 8【云计算学习教程】云计算虚拟化技术和容器技术详解_云计算虚拟化技术与容器技术(1)

- 9uni-app自定义多环境配置,动态修改appid_uniapp项目中如何配置环境变量

- 10Hadoop之MapReduce(实践篇)_mapreduce应用广泛的原因之一就是其易用性,提供了一个高度抽象化而变得非常简单的

论文阅读【用监督对比学习建模域外检测(OOD Detection) 的 鉴别表示】_ooddetection

赞

踩

论文题目:Modeling Discriminative Representations for Out-of-Domain Detection with Supervised Contrastive Learning

论文链接:

代码链接: https://github.com/parZival27/supervised-contrastive-learning-for-out-of-domain-detection

Abstract

传统的交叉熵损失(cross-entropy loss)只关注一个样本是否被正确分类,而没有明确区分不同类别之间的边界。本篇论文针对这个问题进行了解决,提出了一个有监督的对比学习目标(supervised contrastive learning objective)【SCL】,通过将属于同一类的域内意图集合起来来最小化类内方差,并通过将来自不同类的样本拉开来最大化类间方差。

除此之外,采用对抗性增强机制(adversarial augmentation mechanism)来获得潜在空间(latent space)中样本的 pseudo diverse views。

Introduction

从用户查询中检测域外(OOD)或未知意图(unknown intents)是面向任务的对话框系统中的一个重要组成部分.。

与正常的意图检测任务不同,OOD意图检测不知道实际场景中未知意图的确切数量,也几乎不能注释大量的OOD样本。

以往OOD检测方法一般可分为两种类型:Supervised OOD detection (有监督OOD检测)和无监督OOD检测

总体来说,论文的贡献有下面三个方面:

(1)是第一个将监督对比学习应用于OOD检测。

(2)与cross-entropy(CE)损失相比,作者提出的SCL+CE可以最大限度地提高类间方差,最小化类内方差,以学习区别性语义表示。

(3)在两个公共数据集上的大量实验和分析证明了作者提出的方法的有效性。

Methodology

Overall Architecture

(1)首先使用 CE 或者 SCL+CE objectives 在训练阶段训练一个域内意图分类器。

(2)在测试阶段提取了一个测试样本的意图特征,并使用检测算法MSP、LOF或GDA来检测OOD。

Supervised Contrastive Learning

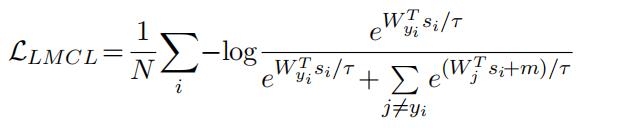

2、CE的改进版本 large margin cosine loss (LMCL)

m 是 cosine margin(余弦边缘) 。与CE相比,LMCL在negative class上增加了一个 normalized decision margin(标准化的决策边界),使模型明确地区分正类和负类。

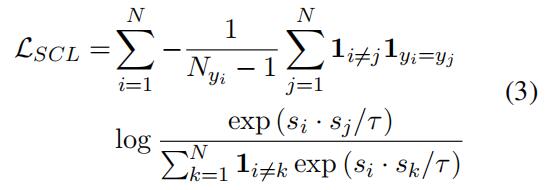

3、a supervised contrastive learning objective (SCL)

目的:最小化类内方差,最大化类间方差。

首先使用SCL对意图分类器进行预训练,然后使用CE或LMCL进行微调。

Adversarial Augmentation

【这一部分没有特别理解】!!!

数据增强对于对比学习有重要意义,可以应用对抗性攻击生成pseudo positive samples(伪正样本),以增加对比学习的the diversity of views(观点多样性)。

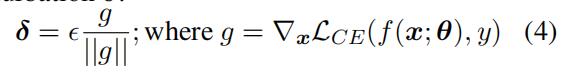

应用Fast Gradient Value 【快速梯度值(FGV)】来近似扰动:

对

最后,就可以得到latent space中的的 pseudo augmented samples(伪增强样本)

生成的伪样本被用来在SCL中增加每个锚点(anchor)的positive views。

Experiments

Datasets

同时作者还进行了一些了的实验来分析相应的结果,具体可以阅读论文。

Conclusion

通过对域内数据学习区别性语义意图表示,提出了一种新的监督对比学习损失(SCL)。

SCL的目标是通过将属于同一类的意图聚集在一起来最小化类内方差,并通过将来自不同类的样本拉开来最大化类间方差。

思考:将对比学习应用于OOD意图检测的想法很新颖,后续是否可以采用一下别的方法进行改进?【可以联系前面写的两篇博客】