- 1CCF稀疏向量100分代码(利用输入的顺序,使用队列巧解)_ccfint a[100][100]

- 2Pytorch - CNN、RNN、GRU 分类_pytorch中gru时间序列分类

- 3讲解Canvas中的一些重要方法

- 4模型压缩整理2020.5.6_sparsity ratio

- 5手机运营商二要素验证接口:确保业务操作安全可靠_手机运营商二要素验证接口:确保业务操作安全可靠

- 6基于FPGA的计算器(含源码)_基于fpga的多功能计算器的设计

- 7Java中的内部类(如果想知道Java中有关内部类的知识点,那么只看这一篇就足够了!)

- 8SpringBoot系列之搭建WebSocket应用_spring boot 开放websocket

- 9【重点突破】—— React应用中封装axios(转),2024年最新腾讯+华为+阿里面试真题分享_axios react

- 10基于java中的springboot框架实现智慧图书管理系统设计演示【附项目源码+论文说明】_图书管理系统javaspringboot

Stable Diffusion安装(非秋叶包一键部署)_conda activate stable-diffusion-webui

赞

踩

Stable Diffusion安装与配置详细步骤

一 、下载前置资源

下载CUDA

1. 查看CUDA版本

通过以下命令查看CUDA版本:

nvidia-smi

复制

确保CUDA版本符合要求。

2. 下载CUDA

-

访问NVIDIA官网获取当前版本CUDA:CUDA Toolkit Downloads

-

获取旧版本CUDA:CUDA Toolkit Archive

下载Visual Studio和visual-cpp-build-tools

官网:

Visual Studio 2022 IDE - 适用于软件开发人员的编程工具 (microsoft.com)

Microsoft C++ Build Tools - Visual Studio

3. 下载和安装MiniConda

4. 安装Visual Studio和CUDA

安装Visual Studio和CUDA,确保环境配置完整。

二、安装stable-diffusion-webui

1. 克隆webui

使用以下命令克隆webui项目:

git clone git@github.com:AUTOMATIC1111/stable-diffusion-webui.git

复制

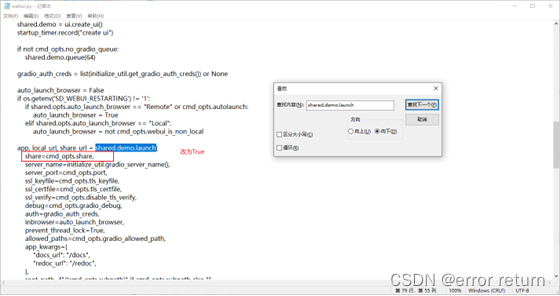

2. 解决bug

-

在文件webui.py中搜索“shared.demo.launch”并进行必要的修改。

-

下载必要文件到openai文件夹,例如:

git clone https://www.modelscope.cn/AI-ModelScope/clip-vit-large-patch14.git

复制

-

编辑webui-user.bat文件,添加修改显卡参数

跳转到显存优化命令写法

-

修改端口号位置防止和ollama冲突

在/stable-diffusion-webui/webui-user.sh文件中,修改端口号位置,例如:

export COMMANDLINE_ARGS="--xformers --medvram --theme=dark --port=8888"

复制

3 安装依赖和运行

打开cmd到相应路径

conda create -n StableDiffusion python=3.10.6

conda activate StableDiffusion

pip install insightface==0.7.3

复制

运行服务:

conda activate StableDiffusion

webui-user.bat

复制

-

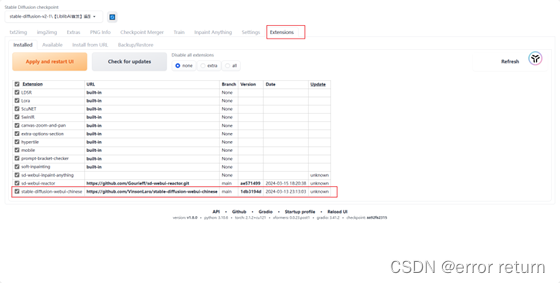

安装汉化插件

汉化包我们选择 stable-diffusion-webui-chinese,

-

(Extensions -> Install from URL),

-

https://github.com/VinsonLaro/stable-diffusion-webui-chinese

-

点击安装时

安装完成后, 点击页面底部的 Reload UI

安装完成后, 点击页面底部的 Reload UI

使用翻译插件

-

选中

-

应用

-

重启

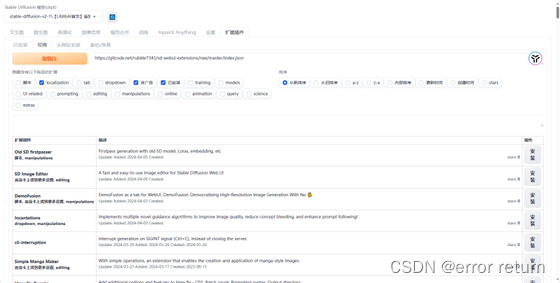

8. 安装插件和下载模型

-

安装插件路径:插件路径

-

https://gitcode.net/rubble7343/sd-webui-extensions/raw/master/index.json

-

下载基础模型地址:Stable Diffusion Models

其他问题的解决办法

1 pip问题

如果出现ModuleNotFoundError: No module named ‘pip’错误,可以通过以下命令修复:

python -m ensurepip

python -m pip install --upgrade pip

复制

2.onnxruntime问题

查看对应cuda版本的onnxruntime

NVIDIA - CUDA | onnxruntime

在onnxruntime版本与CUDA等版本均对应,但却出现上面的警告信息,且没有查看到GPU调用。

考虑是不是onnxruntime压根没找到GPU,所以尝试了下面的代码:

import onnxruntime

onnxruntime.get_device() # 得到的输出结果是GPU,所以按理说是找到了GPU的

print("use"+onnxruntime.get_device())

复制

如果是cpu,就那么就删除所有onnxruntime相关的库文件,重新安装

python -m pip install -U pip

pip uninstall -y onnxruntime onnxruntime-gpu onnxruntime-silicon onnxruntime-extensions

pip install "onnxruntime-gpu>=1.16.1"

复制

参考:ONNX模型推理 | ONNX Runtime 找不到 CUDA,推理只能用 CPU 时的解决方案 - 知乎 (zhihu.com)

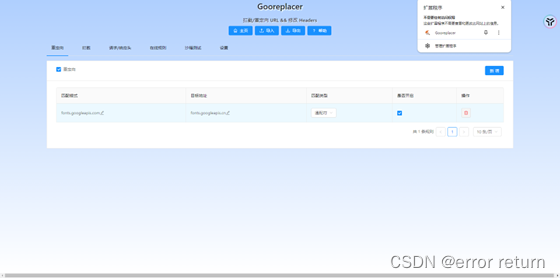

3. 解决网页无法打开问题

这种情况把提前网路全部断开也可以成功启动

若启动成功但网页无法打开,可尝试下载插件:

以下是对各个显存优化命令的写法:

一、低显存优化命令示例

-

如果您有 4GB VRAM 并且想要制作 512x512(或最高 640x640)的图像,使用以下命令:

set COMMANDLINE_ARGS=--medvram

复制

-

如果您有 4GB VRAM 并且想要制作 512x512 图像,但遇到内存不足错误,尝试以下命令:

set COMMANDLINE_ARGS=--medvram --lowvram --always-batch-cond-uncond

复制

-

如果您有 4GB VRAM 并且想要生成比通常使用的显存容量更大的图像,尝试以下命令:

set COMMANDLINE_ARGS=--medvram --lowvram

复制

二、性能优化参数表

-

--opt-sdp-attention:可能比在某些系统上使用 xformer 的速度更快,但需要更多的 VRAM。

-

--xformers:使用xformers库,内存消耗和速度有显著改进。

-

--force-enable-xformers:无论程序认为您是否可以运行它,都启用 xformers。

-

--medvram:使稳定扩散模型消耗更少的 VRAM,降低性能。

-

--lowvram:对上述内容进行更彻底的优化,对性能有破坏性。

-

--no-half:不将模型切换到 16 位浮点数。

三、个人总结优化命令

根据您的个人总结,您可以尝试以下命令来生成图像:

set COMMANDLINE_ARGS=--lowvram --xformers --no-half --autolaunch

复制

通过以上优化命令,您可以在低显存环境下尝试生成图像,平衡速度和显存消耗,提高稳定扩散模型的性能和效率。请根据您的实际情况和需求选择合适的优化参数。

参考:原生Stable Diffusion本地部署伪保姆级(第六篇)--开启SD之旅(3)-性能优化 - 知乎 (zhihu.com)