- 1大脑与反向传播

- 2adb工具下载及安装_adb下载

- 3Flutter零基础入门学习资料集合_mk甄选-2024年flutter零基础极速入门到进阶实战[同步更新中]

- 4消息队列基础篇_消息队列cnds

- 5全国青少年信息素养大赛图形化编程复赛·模拟一卷,含答案解析_图形画编程 竞赛

- 6大数据再出发-06Hadoop(优化&特性&HA)_hadoop的数据压缩和编码技术可以帮助减少存储空间和提高数据传输效率。以下哪个选

- 7了解AIGC:让AI创造内容,改变未来

- 8自然语言处理(NLP)原理、用法、案例、注意事项_nlp如何使用

- 9资深老鸟,自动化测试分层模型与落地总结,“我“该如何提升?_性能测试分层模型是什么

- 10ElasticSearch的Update By Query的坑(使用注意事项及其方案)_updatebyquery的坑

【大模型应用篇7】新一代程序员需要掌握的智能体脚手架是?_dify和coze

赞

踩

大模型让智能体成为更多可能性, 很多公司开始押注下一轮应用形式,其中包括OpenAI、字节、科大讯飞、百度等公司都押注了智能体这个方向。其实,学习大模型到现在,个人也在一直想,大模型未来应用场景方向有哪些?我觉得智能体可能是一个相当比较确定的方向。

上一篇《【大模型应用篇6】私有化智能体平台,为了数据更安全…》介绍了智能体(AI-Agent)平台私有化部署, 这节就带大家实操一下dify这款脚手架私有化部署, 相对langchain开发库,dify更接近生产需要的完整方案.如果大家对智能是什么不了解,可以看一下我之前《【大模型应用篇3】LLM时代下的智能体》和《【大模型应用篇4】普通人构建智能体的工具》文章,希望对你有启发。

01 给你会dify的理由

大家都知道现在很多公司都喊出“降本增效”的口号, 据我了解,很多公司之前上马了“低代码(无代码)”,目标让业务人员也可以开发应用, 降低开发成本。

如今智能体出现,会进一步降低开发应用的难度, 让应用更加智能, 同时未来应用可能就是以智能体方式出现, 用户无需通过很多应用完成一件事, 而是通过一个大入口完成所有操作。智能体可以构建 MVP(最小可用产品)或通过 POC(概念验证)快速验证idea, 同时dify作为开源产品, 很适合有开发实力的公司进行私有化部署, 开发者节省了许多重复造轮子的时间,使其可以专注在创新和业务需求上,成为公司降本增效有力抓手,当然最终目的是为自己赢得好绩效。在“996”内卷中脱颖而出。

02 dify技术矩阵

| LM 推理引擎 | Dify Runtime ( 自 v0.4 起移除了 LangChain) |

| 商业模型支持 | 10家以上, 包括 OpenAI 与 Anthropic新的主流模型通常在 48 小时内完成接入 |

| MaaS 供应商支持 | Hugging Face,Replicate,AWS Bedrock,NVIDIA,GroqCloud,together.ai,OpenRouter |

| 本地模型推理 Runtime 支持 | Xoribits(推荐),OpenLLM,LocalAI,ChatGLM,Ollama,NVIDIA TIS |

| 多模态技术 | ASR 模型GPT-4V 规格的富文本模型 |

| Prompt | 广受好评的可视化的 Prompt 编排界面,在同一个界面中修改 Prompt 并预览效果 编排模式简易模式编排Assistant 模式编排Flow 模式编排Multi-Agent 模式(Q2 即将推出)Prompt 变量类型字符串单选枚举外部 API文件(Q2 即将推出) |

| Agentic Workflow 特性 | 行业领先的可视化流程编排界面,所见即所得的节点调试,可插拔的 DSL,原生的代码运行时,构建更复杂、可靠、稳定的 LLM 应用。支持节点LLM知识库检索问题分类条件分支代码执行模板转换HTTP 请求工具 |

| RAG 特性 | 首创的可视化的知识库管理界面,支持分段预览和召回效果测试。索引方式关键词文本向量由 LLM 辅助的问题-分段模式检索方式关键词文本相似度匹配混合检索N 选 1 模式多路召回召回优化技术使用 ReRank 模型 |

| ETL 技术 | 支持对 TXT、Markdown、PDF、HTML、DOC、CSV 等格式文件进行自动清洗,内置的 Unstructured 服务开启后可获得最大化支持。支持同步来自 Notion 的文档为知识库。 |

| 向量数据库支持 | Qdrant(推荐),Weaviate,Zilliz |

| Agent 技术 | ReAct,Function Call 工具支持可调用 OpenAI Plugin 标准的工具可直接加载 OpenAPI Specification 的 API 作为工具内置工具30+ 款 |

| 日志 | 支持,可基于日志进行标注 |

| 标注回复 | 基于经人类标注的 Q&A 对,可用于相似度对比回复 可导出为供模型微调环节使用的数据格式 |

| 内容审查机制 | OpenAI Moderation 或外部 API |

| API 规格 | RESTful,已覆盖大部分功能 |

| 部署方式 | Docker,Helm |

之前在《【大模型应用篇5】应对裁员潮,突发奇想,打造“收割offer”智能体…》介绍coze平台的大部分组件,dify基本都有,比如工作流、知识库等,不过我觉得比coze平台更具优势的是,用户可以选择更多模型, 不像coze平台仅仅支持云雀和moonshot, 这个给了很多开发者更多的转型dify的冲动, 包括未来可以引入自己公司针对某个领域微调的LLM。

03 实操dify部署

Dify 为所有人提供了云服务(这个优点类似coze),但是数量和空间大小都有限制, 同时dify也支持私有部署, dify支持docker部署和源码部署,个人也比较建议使用docker部署, 不然安装环境会浪费很多时间。

3.1 准备好资源环境

由于我使用的《平民如何体验一把大模型知识库》文章中介绍免费的阿里云PAI服务器,由于本身是docker镜像, 所以无法使用docker启动, 我们就采用真正源码安装(中间件也是采用非docker方式进行安装),顺便也了解dify的依赖和整体架构。其他人我还是建议使用docker方式部署。

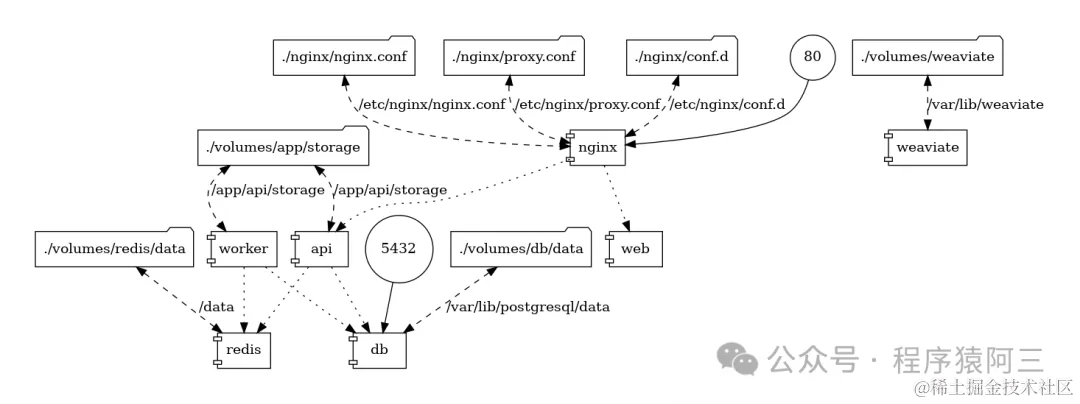

3.2 dify的架构

dify依赖PostgresSQL / Redis / Weaviate中间件,首先在服务器安装这些中间件, 才能启动dify业务, 如果是docker可以直接采用compose方式进行安装:

cd docker

docker compose -f docker-compose.middleware.yaml up -d

- 1

- 2

以下是我非docker方式安装参考的文章和技术博客:

3.3 效果如下

04总结

Dify可以使用他自带的用户页面和用户体系, 也可以单独使用他的api, 自己定义用户体验页面。dify和coze使用基本类似,同样支持知识库、工作流、工具等功能。发布渠道也在逐渐完善,支持微信等常用渠道,方便用户触达,由于它是开源的,大家可以根据自己公司的特点和需求,集成自己公司特色的工具或者渠道。

所以对于一位开发者而言,这个开源项目值得大家深入研究,可以引入到企业里面,为公司探索一些LLM结合的应用或者产品。

现在智能体处于初级阶段,大家可以探索更多应用场景,大家可以关注我的公众号,就可以与他进行对话,起码现在24小时智能客服没啥问题,我也对比了之前方式客服,从使用体验来说,知识库问答和闲聊功能实用性更强。

推荐阅读:

【大模型应用篇5】应对裁员潮,突发奇想,打造“收割offer”智能体…

更多合集文章请关注我的公众号,一起学习一起进步: