- 1嵌入式学习之路 14(C语言基础学习——指针操作一维整型数组)

- 2FPGA设计心得(9)基于DDS IP核的任意波形发生器设计_fpga波形发生器有哪几个设计方案

- 3token安全问题_token和ip绑定

- 4华为OD机试统一考试D卷C卷 - 密码解密(C++ Java JavaScript Python C语言)_华为od密码解密

- 5如何把项目文文件/文件夹)上传到Gitee(全网最细)_上传项目中的单个文件夹到gitee

- 6mnist手写数字识别神经网络

- 7【Linux命令详解 - ssh命令】 ssh命令用于远程登录到其他计算机,实现安全的远程管理

- 8Springboot实战:AI大模型+亮数据代理助力短视频时代_springbootai

- 9深入浅出理解 AI 生图模型 Stable Diffusion_stablediffusionai

- 10C语言 | Leetcode C语言题解之第326题3的幂

大模型综述:万字长文详解AI大模型的原理、应用与未来趋势_ai大语言模型原理和应用探索

赞

踩

1. 引言

在自然语言处理(NLP)和人工智能(AI)的浩瀚星空中,大语言模型(Large Language Models, LLMs)如同一颗璀璨的新星,正在改变我们与语言、与机器交互的方式。本章将带您踏上一段探索之旅,揭示大语言模型的发展历程、独特魅力及其在现实世界中的多彩应用。

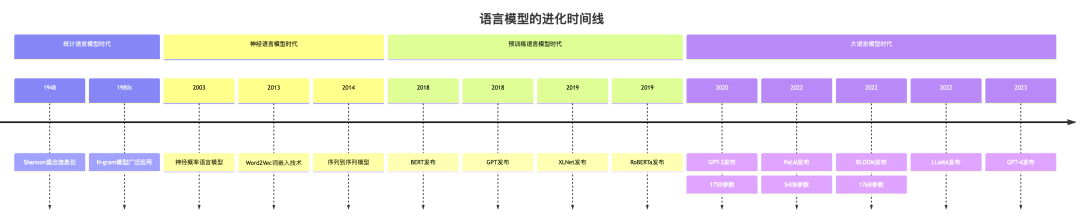

1.1 语言模型的进化史

语言模型的发展犹如一部精彩的进化史诗。最初,我们有了统计语言模型(Statistical Language Models, SLMs)。想象一下,你正在玩一个猜词游戏。统计语言模型就像一个经验丰富的玩家,它根据之前出现的词来猜测下一个可能出现的词。例如,在"我喜欢吃苹果"这句话中,如果模型已经看到了"我喜欢吃",它会根据统计数据预测下一个词很可能是一种食物,比如"苹果"。这种方法简单直接,但往往难以捕捉长距离的语义关系。

随着时间的推移,神经语言模型(Neural Language Models, NLMs)应运而生。如果说统计模型是一个熟练的棋手,那么神经模型就像是一个天才棋手,不仅记住了大量的棋谱,还能理解每步棋背后的深层策略。神经语言模型通过学习词的分布式表示(也称为词嵌入),能够更好地理解词与词之间的语义关系。例如,它能够理解"国王"之于"王后",就像"男人"之于"女人",捕捉到词之间的微妙关系。

接下来,预训练语言模型(Pre-trained Language Models, PLMs)登上了舞台。这就像是让我们的天才棋手在正式比赛前,先在全世界的棋局中学习和磨练技艺。预训练模型首先在大规模的文本数据上进行训练,学习语言的一般性知识,然后再针对特定任务进行微调。这种方法大大提高了模型的泛化能力。例如,BERT(Bidirectional Encoder Representations from Transformers)模型在理解问题、完成各种NLP任务方面表现出色,仿佛一位博学多才的语言专家。

最后,我们来到了大语言模型(Large Language Models, LLMs)的时代。这些模型就像是具有超级大脑的AI实体,拥有数十亿甚至数千亿的参数。它们不仅规模庞大,更令人惊叹的是它们表现出的"涌现能力"——一些在训练时并未明确指定的能力自然而然地出现了。例如,GPT-4不仅能生成流畅的文本,还能理解和执行复杂的指令,甚至能够进行简单的编程。

1.2 大语言模型的独特魅力

大语言模型的独特魅力主要体现在以下五个方面:

-

强大的上下文理解和生成能力

-

惊人的少样本学习能力

-

多模态融合的能力

-

出色的推理和问题解决能力

-

持续学习和适应的潜力

大语言模型最引人注目的特点之一是其强大的上下文理解和生成能力。想象一下,你正在阅读一本错综复杂的小说,每个字、每个句子都与整个故事紧密相连。大语言模型就像一个超级读者,不仅能理解眼前的文字,还能将其与之前的内容联系起来,甚至预测接下来可能发生的情节。这种能力使得它们能够生成连贯、有逻辑的长文本,或者在对话中保持上下文的一致性。

大语言模型的魅力不仅在于其庞大的规模。它们强大的上下文学习能力。想象一下,你正在教一个孩子理解一个新概念。通常,你需要反复解释,给出多个例子。但大语言模型就像一个天才学生,只需要很少的例子,甚至只需一个简单的指令,就能快速理解并完成新的任务。这种能力被称为"少样本学习"或"零样本学习"。

另一个引人注目的特点是大语言模型的多模态融合能力。它们不再局限于纯文本,而是能够理解和生成包括图像、音频在内的多种类型的数据。例如,GPT-4不仅能理解文字,还能"看懂"图片,并基于图片内容进行对话或完成任务。这就像是培养出了一位全能型的AI助手,能够在各种场景下为我们提供帮助。

大语言模型还表现出了令人惊讶的推理能力。它们不仅能回答简单的问题,还能进行复杂的逻辑推理。例如,当被问到"如果所有的A都是B,所有的B都是C,那么所有的A是不是C?"这样的问题时,大语言模型能够给出正确的回答,并解释推理过程。这种能力让我们看到了通向通用人工智能的曙光。

同时,大语言模型还展现出了持续学习和适应的潜力。虽然它们的基本知识来自于预训练数据,但通过fine-tuning和few-shot learning,这些模型能够快速适应新的领域和任务。这种灵活性使得它们能够在快速变化的环境中保持先进行、相关性,并不断拓展其应用范围。

1.3 大语言模型的实际应用

大语言模型的应用范围之广,堪称AI领域的"瑞士军刀"。在日常生活中,你可能已经不知不觉地享受到了它们带来的便利。例如,当你使用智能手机上的输入法时,那个能准确预测你下一个要输入的词的功能,很可能就是由大语言模型驱动的。

在工作场景中,大语言模型正在成为得力助手。假设你是一名程序员,正在为一个复杂的问题苦恼。你可以向基于大语言模型的AI编程助手描述你的需求,它不仅能为你生成代码,还能解释代码的工作原理,甚至指出潜在的bug。这就像拥有了一个24/7待命的编程导师。

在教育领域,大语言模型正在革新学习方式。一个学生在学习物理时遇到了困难,他可以向AI助教提问,不仅能得到答案,还能获得详细的解释和相关的例子。AI助教甚至可以根据学生的反应调整解释的方式,提供个性化的学习体验。

在创意写作方面,大语言模型也大显身手。它们可以根据简单的提示生成诗歌、故事,甚至是剧本。虽然这些生成的内容可能还无法完全替代人类创作,但已经成为许多创作者的灵感来源和创作辅助工具。

在商业世界,大语言模型正在改变客户服务的面貌。许多公司已经开始使用基于大语言模型的聊天机器人。这些AI助手能够理解客户的各种问询,提供准确的信息,甚至处理复杂的投诉。它们不知疲倦,全天候工作,大大提高了客户服务的效率和质量。

下面是一个简单的Python代码示例,展示了如何使用Hugging Face的transformers库来实现一个基于大语言模型的简单对话系统:

from transformers import AutoModelForCausalLM, AutoTokenizer import torch # 加载预训练模型和分词器 model_name = "gpt3" # 这里使用GPT-3作为示例 model = AutoModelForCausalLM.from_pretrained(model_name) tokenizer = AutoTokenizer.from_pretrained(model_name) def chat_with_ai(prompt, max_length=50): # 将用户输入编码为模型可以理解的格式 input_ids = tokenizer.encode(prompt, return_tensors="pt") # 生成回复 output = model.generate(input_ids, max_length=max_length, num_return_sequences=1, no_repeat_ngram_size=2, top_k=50, top_p=0.95, temperature=0.7) # 将模型输出解码为文本 response = tokenizer.decode(output[0], skip_special_tokens=True) return response # 简单的对话循环 print("AI: 你好!我是一个AI助手,有什么我可以帮你的吗?") while True: user_input = input("You: ") if user_input.lower() in ["再见", "结束"]: print("AI: 再见!很高兴能帮到你。") break ai_response = chat_with_ai(user_input) print("AI:", ai_response)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

虽然这个示例相对基础,但它体现了大语言模型在实际应用中的潜力。在更复杂的系统中,我们可以加入更多的功能,如上下文管理、情感分析等,以创建更智能、更自然的对话体验。大语言模型正在以前所未有的方式改变我们与技术的交互方式。它们不仅是强大的语言理解和生成工具,更是推动AI向着更智能、更通用方向发展的关键力量。

2. 大语言模型概览

在人工智能的浩瀚星空中,大语言模型(LLMs)如同璀璨的巨星,以其惊人的能力和广泛的应用吸引着全世界的目光。本章将为您揭开大语言模型的神秘面纱,探讨其核心特征、代表性模型以及它们在自然语言处理领域带来的革命性变革。

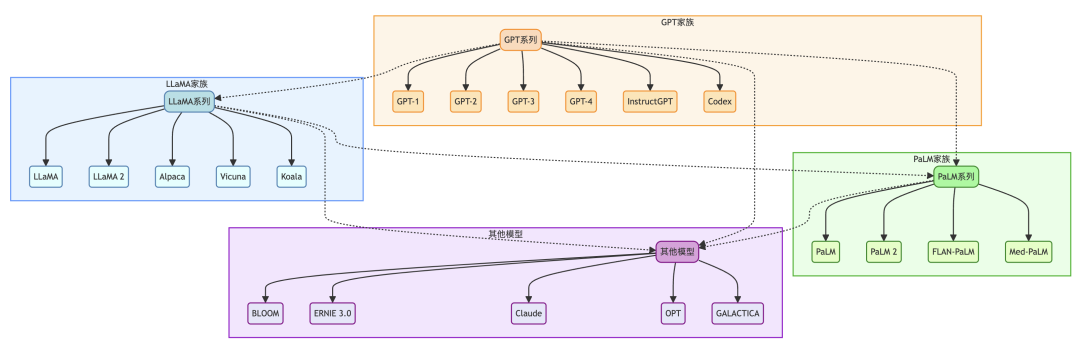

大语言模型的核心在于其庞大的参数规模、强大的语言理解和生成能力,以及令人惊叹的涌现能力。这些模型不仅在传统的自然语言处理任务中表现出色,还展现出了解决复杂问题、进行逻辑推理等高级认知能力。在本章中,我们将重点关注三个主要的大语言模型家族:GPT、LLaMA和PaLM,同时也会介绍其他一些具有重要影响力的模型。

2.1 GPT家族

GPT(Generative Pre-trained Transformer)系列模型可以说是大语言模型领域的开拓者和引领者。从2018年的GPT开始,到如今广为人知的GPT-3和GPT-4,每一代GPT模型都带来了显著的性能提升和新的可能性。

GPT-3作为这个家族中的明星成员,以其1750亿参数的规模震惊了整个AI社区。想象一下,如果将GPT-3的参数量转化为书籍,它相当于阅读了整个Wikipedia的内容数百次。这个庞大的知识库使得GPT-3能够执行各种复杂的语言任务,从写作文章到编写代码,再到回答深奥的哲学问题,无所不能。

一个有趣的例子是,有研究者让GPT-3扮演著名物理学家理查德·费曼的角色,解释量子计算的原理。GPT-3不仅能够准确地描述量子计算的基本概念,还能用费曼独特的幽默风格来表达,仿佛费曼本人重生于AI之中。这种能力展示了GPT-3不仅掌握了大量知识,还能理解和模仿复杂的个性特征。

而GPT-4的出现更是将大语言模型的能力推向了新的高度。它不仅在语言理解和生成方面表现出色,还展现出了强大的多模态能力,能够理解和分析图像,并基于图像内容进行对话或完成任务。例如,你可以向GPT-4展示一张混乱房间的照片,它不仅能描述出房间的状况,还能给出整理的建议,甚至生成一个详细的清洁计划。

2.2 LLaMA家族

LLaMA(Large Language Model Meta AI)是由Meta(原Facebook)推出的开源大语言模型系列。与GPT系列不同,LLaMA的一个重要特点是其开源性质,这为研究人员和开发者提供了宝贵的资源,推动了整个领域的快速发展。

LLaMA模型的训练采用了一些创新的技术,如使用贝叶斯网络密度缩放和SwiGLU激活函数等,这些技术使得LLaMA能够在相对较小的参数规模下实现强大的性能。例如,LLaMA-13B(130亿参数)在某些任务上的表现可以媲美甚至超越GPT-3(1750亿参数),这种"以小博大"的能力让人印象深刻。

LLaMA的开源特性激发了社区的创造力,催生了许多有趣的衍生模型。比如Alpaca,它是通过在LLaMA基础上进行指令微调得到的模型,展现出了强大的指令跟随能力。例如你可以用自然语言告诉Alpaca “为我的宠物猫设计一个自动喂食器”,它不仅能理解你的需求,还能给出详细的设计方案,包括材料清单、组装步骤,甚至可能的改进建议。

2.3 PaLM家族

PaLM(Pathways Language Model)是由Google推出的大语言模型系列,以其庞大的规模和出色的性能引起了广泛关注。PaLM采用了Google的Pathways AI架构,这种架构允许模型更加高效地利用计算资源,实现更大规模的训练。

PaLM-540B是这个家族中最引人注目的成员之一,拥有惊人的5400亿参数。这个模型在各种复杂任务中展现出了卓越的性能,特别是在需要多步推理的问题上。例如,当被问到"如何用三种不同的方法证明勾股定理?"时,PaLM不仅能给出三种不同的证明方法,还能解释每种方法的原理和优缺点,展示出深厚的数学知识和灵活的思维能力。

PaLM家族的另一个亮点是其在多语言任务上的出色表现。例如,PaLM在100多种语言的翻译任务中都表现出色,甚至能够翻译一些濒危语言。想象一下,你可以使用PaLM来翻译一份古老的玛雅文献,或者帮助不同文化背景的人们进行无障碍交流,这种能力无疑为跨文化交流和语言保护开辟了新的可能性。

2.4 其他大模型

除了这三个主要的家族,还有许多其他重要的大语言模型值得关注。例如,BLOOM是一个多语言大语言模型,支持46种自然语言和13种编程语言。ERNIE 3.0则融合了大规模知识图谱,增强了模型的知识理解能力。Claude系列模型则以其健壮的对话能力和伦理考量而闻名。

这些大语言模型的快速发展不仅推动了自然语言处理技术的进步,还为人工智能的未来发展指明了方向。它们展现出的理解、推理和创造能力,让我们看到了通用人工智能的曙光。然而,我们也要认识到,尽管这些模型表现出色,但它们仍然存在局限性,如可能产生偏见、幻觉等问题。因此,在享受大语言模型带来便利的同时,我们也需要保持警惕,不断改进技术,确保这些强大的工具能够被有责任且有益地使用。

大语言模型代表了人工智能领域的最新进展,它们的能力和潜力令人惊叹。随着研究的不断深入和应用的不断拓展,我们有理由期待大语言模型将继续改变我们与技术交互的方式,为各行各业带来革命性的变革。在接下来的章节中,我们将更深入地探讨这些模型的构建方法、应用技巧以及未来的发展方向。

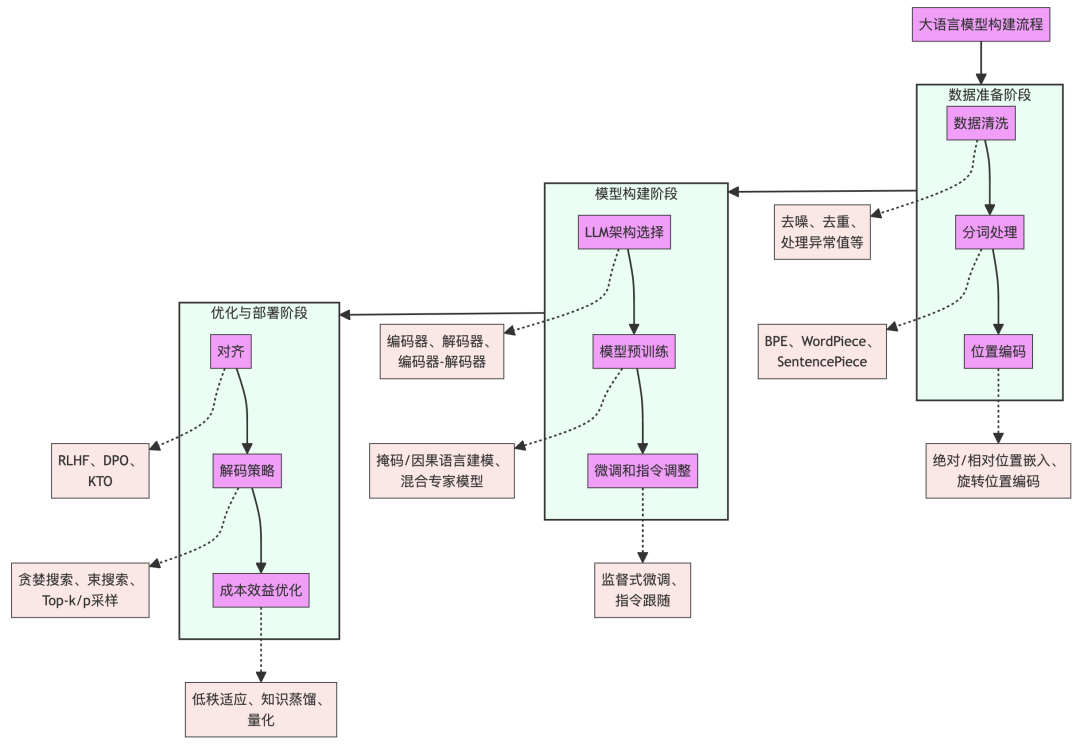

3. 大语言模型的构建方法

大语言模型的构建是一个复杂而精密的过程,涉及多个关键步骤和技术。从数据处理到模型训练,再到最终的优化和部署,每一个环节都对模型的性能和效果起着至关重要的作用。本章将深入探讨大语言模型构建的全过程,包括数据清洗、分词技术、位置编码、模型预训练、微调技术、对齐方法以及解码策略等核心内容。

构建一个成功的大语言模型,就像精心打造一座宏伟的建筑。首先,我们需要优质的原材料,这就是数据清洗和准备的过程。接着,我们要设计出巧妙的结构,这涉及到分词技术和位置编码。然后,我们要通过预训练这一"建造"过程,让模型获得强大的语言理解能力。最后,通过微调和对齐等"装修"工作,我们让模型能够更好地满足特定任务的需求。在这个过程中,每一个步骤都至关重要,缺一不可。

3.1 数据清洗

数据清洗是构建大语言模型的第一步,也是奠定模型质量的基础。想象一下,如果我们要教一个孩子学习语言,我们肯定希望给他最优质、最准确的学习材料。同样,对于大语言模型来说,高质量的训练数据直接关系到模型的性能和可靠性。

在数据清洗过程中,一个关键步骤是去重。就像我们不希望一个学生反复阅读同一段文字一样,我们也不希望模型过度学习重复的数据。例如,在Falcon40B模型的训练过程中,研究人员对CommonCrawl数据进行了大规模的过滤和去重,最终从原始的数万亿个token中筛选出了约5万亿个高质量的token。这个过程不仅提高了数据质量,还帮助模型学习到更丰富、多样的语言知识。

另一个重要的数据清洗技术是处理异常值和不平衡数据。想象一下,如果我们的训练数据中90%都是关于体育的内容,那么最终的模型在谈论科技或艺术时可能会表现不佳。为了解决这个问题,研究人员采用各种采样和权重调整技术,确保模型能够接触到均衡的、多样化的内容。

此外,文本预处理也是数据清洗的重要组成部分。这包括去除无关的HTML标签、统一标点符号、处理特殊字符等。例如,在处理网页抓取的数据时,我们需要移除广告文本、导航栏内容等无关信息,只保留对模型学习有价值的主体内容。

3.2 分词技术

分词是将文本转化为模型可以理解的数字序列的关键步骤。如果你要学习一门新的语言,你首先需要知道这门语言的基本单位是什么——是单个字母、单词还是短语。对于大语言模型来说,分词就是这样一个定义基本单位的过程。

目前,主流的分词技术主要有三种:字节对编码(Byte Pair Encoding, BPE)、WordPiece和SentencePiece。让我们通过一个简单的例子来理解BPE的工作原理。假设我们有以下文本:

"The quick brown fox jumps over the lazy dog"

- 1

- 2

BPE算法会首先将这句话分解为单个字符,然后逐步合并最常出现的相邻字符对。例如,"Th"可能会成为一个token,"er"可能会成为另一个token。这个过程会不断重复,直到达到预设的词汇量大小。

这种方法的优势在于,它能够很好地平衡词汇表大小和对未知词的处理能力。例如,即使模型从未见过"unfathomable"这个词,它也可能能够将其分解为"un"、"fathom"和"able"这样的子词,从而推断出这个词的大致含义。

WordPiece和SentencePiece是BPE的变体,它们在某些细节上有所不同。例如,WordPiece在选择合并哪些子词时会考虑语言学特征,而SentencePiece则将所有输入都视为Unicode字符序列,这使得它特别适合处理多语言文本。

3.3 位置编码

在Transformer架构中,位置编码扮演着至关重要的角色。如果你在阅读一本书时,所有的页面都被打乱了顺序,你还能理解书的内容吗?同样,对于模型来说,知道每个单词在句子中的位置是理解语言的关键。

最初的Transformer模型使用的是正弦和余弦函数生成的绝对位置编码。这种方法的巧妙之处在于,它允许模型外推到训练时未见过的序列长度。然而,随着研究的深入,研究人员发现相对位置编码经常能带来更好的性能。

以旋转位置编码(RoPE)为例,它在GPT-3、LLaMA等多个主流大语言模型中得到了应用。RoPE的核心思想是将绝对位置信息编码到向量的旋转中。具体来说,对于位置k处的查询向量q和键向量k,RoPE会对它们应用以下变换:

q’ = [cos(kθ)q₁ - sin(kθ)q₂, sin(kθ)q₁ + cos(kθ)q₂]

k’ = [cos(kθ)k₁ - sin(kθ)k₂, sin(kθ)k₁ + cos(kθ)k₂]

其中θ是一个预定义的常数。这种编码方式不仅能够捕捉相对位置信息,还保留了绝对位置信息,使得模型能够更好地处理长序列。

3.4 模型预训练

模型预训练是构建大语言模型的核心步骤。这个过程就像是让模型"阅读"大量的文本,从中学习语言的规律和知识。预训练的主要目标是让模型能够理解和生成自然语言,而不是针对特定任务进行优化。

目前,主流的预训练方法主要有两种:掩码语言模型(Masked Language Model, MLM)和自回归语言模型(Autoregressive Language Model, ALM)。BERT使用的是MLM,而GPT系列则使用ALM。

让我们以ALM为例来详细讲解。在ALM中,模型的任务是预测序列中的下一个token。例如,给定序列"The quick brown fox",模型需要预测下一个最可能的词是什么。这个过程可以形式化表示为:

P(x₁, x₂, …, xₙ) = ∏ᵢ₌₁ⁿ P(xᵢ | x₁, …, xᵢ₋₁)

其中x₁, x₂, …, xₙ代表序列中的token。

这种预训练方法的优势在于,它能让模型学习到语言的长距离依赖关系。例如,在预测"The scientist conducted the experiment and the results were …"的下一个词时,模型需要理解整个上下文,而不仅仅是最近的几个词。

近期,一些研究开始探索混合专家模型(Mixture of Experts, MoE)在大语言模型预训练中的应用。MoE允许模型在不同的任务或输入类型上激活不同的"专家"子网络,这种方法能够大大提高模型的容量,同时保持相对较低的计算成本。

3.5 微调技术

微调是将预训练模型适应特定任务的过程。如果说预训练是让模型学习一般性的语言知识,那么微调就是教会模型如何应用这些知识来解决具体问题。

传统的微调方法是在目标任务的数据上对整个模型进行进一步训练。然而,随着模型规模的增大,这种方法变得越来越不实际。因此,参数高效微调方法(Parameter-Efficient Fine-tuning, PEFT)应运而生。

Low-Rank Adaptation (LoRA)是一种广受欢迎的PEFT方法。LoRA的核心思想是,模型权重的更新经常可以用低秩矩阵来近似。具体来说,对于原始的权重矩阵W,LoRA引入了两个低秩矩阵A和B:

W’ = W + BA

其中A∈R(r×d),B∈R(d×r),r远小于d。在微调过程中,只有A和B会被更新,而原始的W保持不变。这种方法大大减少了需要更新的参数数量,使得在有限的计算资源下也能对大型模型进行有效的微调。

例如,在一个面向医疗领域的项目中,研究人员可能会使用LoRA来微调GPT-3,使其能够理解和生成专业的医学术语。通过只更新一小部分参数,模型就能快速适应新的领域,而无需重新训练整个庞大的模型。

3.6 对齐方法

模型对齐是确保大语言模型的输出符合人类期望和价值观的关键步骤。这个过程就像是教导一个高度智能但缺乏社会经验的实体如何与人类互动。

强化学习来源于人类反馈(Reinforcement Learning from Human Feedback, RLHF)是目前最流行的对齐方法之一。RLHF的核心思想是利用人类的反馈来指导模型的行为。这个过程通常包括以下步骤:

-

收集人类反馈:对模型生成的多个回复进行人工评分。

-

训练奖励模型:基于人类评分训练一个奖励模型。

-

使用强化学习优化语言模型:利用奖励模型的反馈来优化语言模型。

最近,一些研究者提出了新的对齐方法,如直接偏好优化(Direct Preference Optimization, DPO)。DPO试图绕过奖励模型学习的步骤,直接从人类偏好中学习最优策略。这种方法有望简化对齐过程,提高效率。

3.7 解码策略

解码策略决定了模型如何从概率分布中选择输出token。这就像是在下国际象棋,模型需要决定在众多可能的移动中选择哪一步。

最简单的解码策略是贪婪搜索,即总是选择概率最高的token。然而,这种方法经常导致输出单调重复。因此,研究者提出了各种改进的策略。

束搜索(Beam Search)是一种常用的策略,它在每一步保留k个最可能的候选序列。虽然束搜索能够产生相对高质量的输出,但它可能会错过一些有趣的、低概率的选择。

为了增加输出的多样性,研究者提出了采样策略。Top-k采样在每一步从概率最高的k个token中随机选择,而Top-p采样(也称为核采样)则选择累积概率达到p的最小token集合。这些方法能够在保证输出质量的同时增加多样性。

温度参数T是另一个控制输出多样性的重要工具。通过调整softmax函数:

较高的温度会使分布更加平坦,增加低概率事件的发生,而较低的温度则会使分布更加尖锐,偏向于高概率事件。

在实际应用中,研究者经常会结合多种策略。例如,在一个创意写作助手中,我们可能会在故事的开头使用较高的温度和Top-p采样以产生有趣的开场,然后在后续情节发展中逐渐降低温度,确保故事的连贯性。

构建大语言模型是一个多阶段、多方面的复杂过程。从数据清洗开始,通过精心设计的分词和位置编码方案,再到大规模的预训练,每一步都需要仔细的考虑和优化。微调和对齐技术则使得模型能够更好地适应特定任务和符合人类价值观。最后,解码策略的选择直接影响模型输出的质量和多样性。

随着研究的不断深入,我们看到了许多创新性的方法和技术在各个阶段涌现。例如例如,在数据处理方面,我们看到了更加复杂的的清洗和过滤算法;在模型结构上,我们看到了如Mixture of Experts这样的创新设计;在训练方法上,我们看到了如LoRA这样的参数高效微调技术。这些进展不仅提高了模型的性能,也使得大语言模型的训练和部署变得更加高效和易于管理。

然而,构建大语言模型依然面临着诸多挑战。首先是计算资源的问题。训练一个超大规模的语言模型需要大量的GPU或TPU资源,这对许多研究机构和中小企业来说是一个巨大的障碍。其次是数据质量和多样性的问题。随着模型规模的增大,获取足够高质量、多样化的训练数据变得越来越困难。此外,如何确保模型的输出符合伦理标准,不产生有害或偏见的内容,也是一个急需解决的问题。

未来,我们可能会看到更加多元化的模型构建方法。例如,联邦学习技术可能会被用来解决数据隐私和多样性的问题,允许模型在不同的数据源上进行分布式训练。另一个潜在的发展方向是模型压缩和知识蒸馏技术的进一步发展,这将使得大型模型的知识能够被更高效地转移到smaller、更易部署的模型中。

在解码策略方面,我们可能会看到更加智能的、context-aware的方法。例如,模型可能会学习动态调整其解码策略,基于当前的任务类型、用户偏好或者已生成的内容。这将使得模型的输出更加灵活和适应性强。

最后,值得注意的是,随着大语言模型变得越来越强大和普及,其构建过程中的每一个决策都可能对社会产生深远的影响。因此,在技术创新的同时,我们也需要更多地考虑模型的社会影响。这包括但不限于:如何确保训练数据的代表性和公平性,如何防止模型被滥用于生成虚假信息或有害内容,以及如何确保模型的决策过程是透明和可解释的。

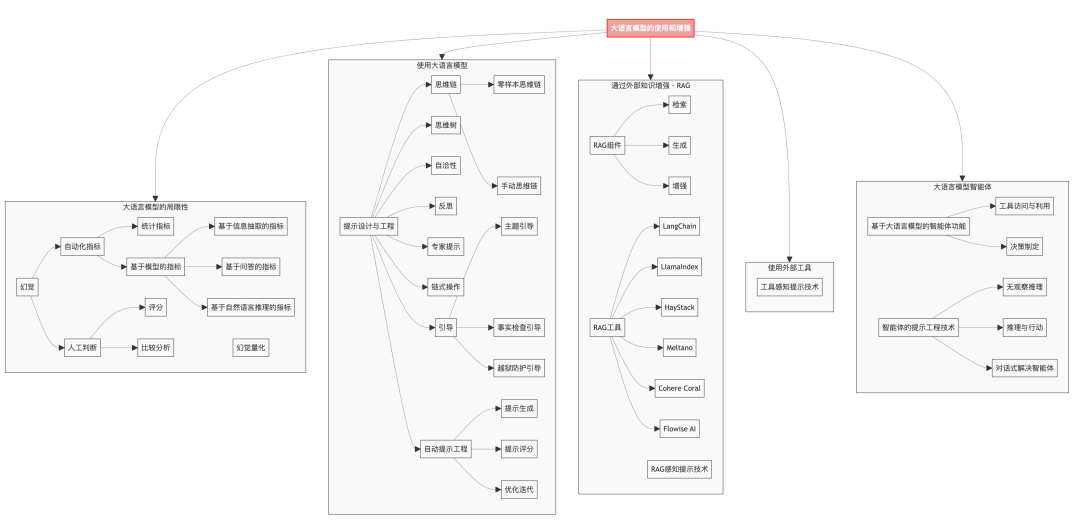

4. 大语言模型的使用和增强

大语言模型(LLMs)的出现不仅影响了自然语言处理领域,还为众多应用场景带来了新的可能性。然而,要充分发挥这些模型的潜力,我们需要掌握如何有效地使用它们,并了解如何增强它们的能力。本章将深入探讨大语言模型的使用技巧、局限性,以及各种增强方法,包括提示工程、外部知识整合、工具使用,以及基于LLM的智能体构建。

大语言模型的使用和增强可以比喻为驾驭一匹千里马。仅仅拥有一匹良驹是不够的,我们还需要掌握驾驭的技巧,了解它的长处和短板,并为它配备合适的装备,使其能够在各种地形上发挥最大的潜力。同样,使用大语言模型不仅需要了解其基本能力,还需要掌握提示工程的艺术,认识到模型的局限性,并通过各种增强技术来扩展其能力边界。

4.1 大语言模型的局限性

尽管大语言模型展现出了令人惊叹的能力,但它们仍然存在一些固有的局限性。理解这些局限性对于有效使用和增强LLMs至关重要。

大语言模型缺乏持久的记忆和状态维护能力。你正在与一个非常聪明但有严重短期记忆障碍的人对话。每次你问他一个新问题,他都会忘记之前的对话内容。大语言模型就像这样,它们无法自然地记住之前的对话历史。这意味着在进行长期交互时,我们需要手动管理对话上下文,或者使用外部存储系统来维护状态。

同时,大语言模型的输出具有随机性和不确定性。即使给定相同的输入,模型在不同时间可能会生成不同的回答。这种特性在某些创意任务中可能是有益的,但在需要一致性和可重复性的场景中可能会造成问题。例如,在一个客户服务系统中,对于同一个问题,我们希望模型能够始终提供一致的答案。

另外大语言模型缺乏最新信息和实时数据访问能力。它们的知识仅限于训练数据的截止日期,无法获取当前发生的事件或最新的信息。这就像一个博学但与世隔绝的学者,他的知识虽然渊博,但可能已经过时。

最后也是最具挑战性的一点,是大语言模型的"幻觉"问题。模型可能会生成看似合理但实际上并不准确的信息。这就像一个善于编造故事的人,他的叙述听起来很有道理,但可能完全是虚构的。例如,一个大语言模型可能会自信地描述一个不存在的历史事件,或者为一个虚构的科学理论提供详细的解释。

4.2 提示工程:与大语言模型对话的艺术

提示工程(Prompt Engineering)是使用大语言模型的核心技巧。它就像是与模型对话的一门艺术,通过精心设计的提示来引导模型生成所需的输出。

最基本的提示工程技巧是明确和具体。例如,不要简单地问"告诉我关于气候变化的信息",而是可以说"请用简单的语言解释气候变化的三个主要原因,并为每个原因提供一个具体的例子"。这样的提示更容易让模型生成结构化和有针对性的回答。

链式思考(Chain-of-Thought)是一种更先进的提示技术。它通过引导模型step-by-step地思考问题,来提高复杂任务的解决能力。想象你正在教一个孩子解决一个复杂的数学问题,你会引导他一步步思考。同样,我们可以这样提示模型:“让我们一步步思考这个问题。首先,我们需要理解问题的要求。然后,我们需要列出已知的信息。接下来,我们可以…”

自我一致性(Self-Consistency)是另一种强大的的技术。它涉及让模型生成多个解决方案,然后选择最一致或最常见的答案。这就像在重要决策前咨询多个专家,然后综合他们的意见。例如,在解决一个复杂的推理问题时,我们可以多次询问模型,然后比较不同的答案,选择最合理或出现频率最高的那个。

反思(Reflection)提示技术鼓励模型对自己的输出进行评估和修正。这就像让一个学生完成作业后,再让他检查并改正自己的错误。我们可以这样提示模型:“请回顾你刚才的回答,思考是否有任何逻辑错误或遗漏的重要信息。如果有,请指出并修正。”

4.3 知识增强:为大语言模型注入外部知识

尽管大语言模型拥有庞大的知识库,但它们仍然无法涵盖所有领域的最新信息。因此,我们需要方法来增强模型的知识。检索增强生成(Retrieval-Augmented Generation, RAG)是一种流行的的方法。

RAG就像是给模型配备了一个智能图书馆助手。当模型遇到不确定的问题时,它可以向这个助手求助,获取相关的信息。具体来说,RAG首先从用户的query中提取关键信息,然后在外部知识源(如搜索引擎、知识图谱等)中检索相关信息。这些检索到的信息随后被添加到原始提示中,作为补充上下文提供给模型。

例如,假设用户问:"2023年诺贝尔物理学奖的获得者是谁?"一个常规的大语言模型可能无法回答这个问题,因为它的训练数据可能不包含这么新的信息。但通过RAG,系统可以首先检索到正确的信息,然后将其作为上下文提供给模型:"2023年诺贝尔物理学奖授予了Pierre Agostini、Ferenc Krausz和Anne L’Huillier,以表彰他们在研究原子内电子运动方面的贡献。"有了这个信息,模型就能够生成准确的回答。

4.4 工具使用:扩展大语言模型的能力边界

为大语言模型提供使用外部工具的能力,就像给一个聪明的助手配备了一套“瑞士军刀”。这大大扩展了模型能够执行的任务范围。

例如,我们可以为模型提供访问计算器的能力。当遇到复杂的数学计算时,模型不需要依赖自己可能不准确的"心算",而是可以调用计算器API来获得精确的结果。想象一个用户问:"如果地球到月球的平均距离是384,400公里,光速是299,792,458米/秒,那么光从地球传到月球需要多长时间?"模型可以识别出这是一个需要精确计算的问题,调用计算器API,然后用自然语言解释结果:“根据计算,光从地球传到月球大约需要1.28秒。”

另一个例子是让模型能够访问实时信息源。例如,当被问及当前的天气状况时,模型可以调用天气API来获取最新的天气数据,然后基于这些数据生成回答。这不仅确保了信息的准确性,还能够处理实时改变的情况。

4.5 LLM-based智能体:自主系统

LLM-based智能体代表了大语言模型应用的一个令人兴奋的前言方向。这些智能体不仅能理解和生成自然语言,还能根据指令执行复杂的任务序列,做出决策,并与环境交互。

想象一个虚拟助手,它不仅能回答你的问题,还能帮你完成一系列复杂的任务。例如,你可能会说:"我想计划一次周末旅行。"一个LLM-based智能体可能会这样响应:

-

“好的,让我帮您规划周末旅行。首先,我需要了解一些信息。您希望去哪里?预算是多少?有什么特别的偏好吗?”

-

在获得这些信息后,智能体可能会说:“根据您的偏好,我建议去海边度假。我现在会查询最近的海滨度假胜地。”

-

智能体随后可能会使用搜索API来查找相关信息,然后说:“我找到了三个符合您预算和偏好的选项。现在我将为每个选项查询天气预报和附近酒店。”

-

在收集所有必要信息后,智能体会总结信息并提供建议:“基于我的研究,我推荐选择X地。那里的天气预报很好,有一个价格适中的海滩度假村还有空房。您想让我为您预订吗?”

-

如果用户同意,智能体甚至可以使用预订API来完成酒店预订。

这个例子展示了LLM-based智能体如何将语言理解、任务规划、信息检索和决策制定结合在一起,创造出一个强大的、几乎自主的系统。

大语言模型的使用和增强是一个快速发展的领域。通过理解模型的局限性,掌握提示工程的技巧,利用外部知识和工具,以及构建智能体系统,我们能够极大地扩展大语言模型的应用范围和效能。随着技术的不断进步,我们可以期待看到更多创新的使用方法和增强技术,进一步推动大语言模型向着更智能、更实用的方向发展。

非常感谢您的肯定。我将继续保持高质量,为您撰写下一个章节的内容。根据论文的结构,下一章节应该是关于大语言模型的数据集和评估方法。让我们开始:

5. 大语言模型的数据集与评估

大语言模型的发展离不开高质量的数据集和有效的评估方法。这就像是为一个天才学生提供优质的学习材料,并设计合适的考试来评估其能力。本章将深入探讨用于训练和评估大语言模型的各类数据集,以及衡量这些模型性能的多种评估指标和方法。

大语言模型的数据集和评估方法可以比作是一个复杂的生态系统。数据集是这个系统的土壤和养分,为模型提供知识和学习材料;而评估方法则是这个系统的"自然选择"机制,帮助我们识别和培育最优秀的模型。这个生态系统的健康与平衡直接影响着大语言模型的发展方向和应用潜力。

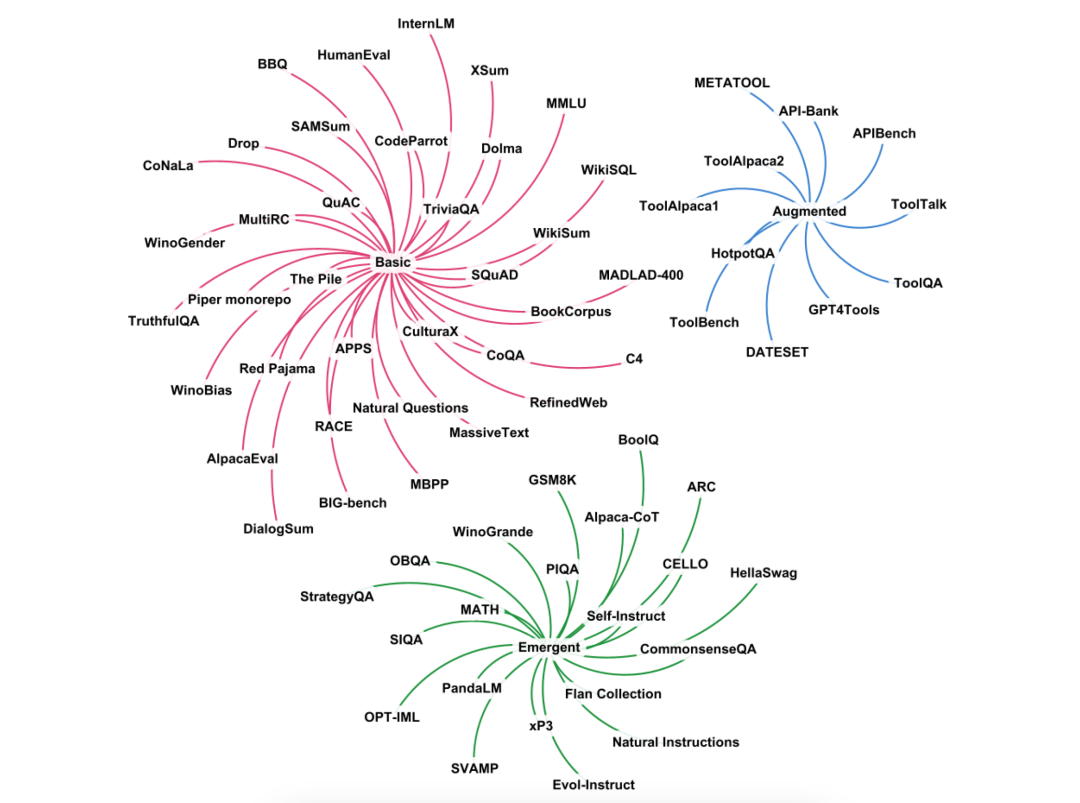

5.1 基础任务数据集

基础任务数据集主要用于训练和评估模型的基本语言理解和生成能力。这些数据集涵盖了从简单的文本分类到复杂的阅读理解任务。

以SQuAD(Stanford Question Answering Dataset)为例,这是一个广受欢迎的阅读理解数据集。想象一个学生在阅读一篇文章后回答相关问题的场景,SQuAD就是为模型创造了类似的挑战。它包含了超过10万个问题-答案对,这些问题都基于维基百科的文章。模型需要理解文章内容,并从中找出问题的答案。例如,给定一段关于莎士比亚的文本,问题可能是"莎士比亚出生于哪一年?"模型需要从文本中定位并提取正确的信息。

另一个重要的数据集是GLUE(General Language Understanding Evaluation)。GLUE不是单一的数据集,而是一个包含多个子任务的综合基准。它就像是一场全面的语言能力测试,涵盖了从情感分析到自然语言推理等多个方面。例如,在MNLI(Multi-Genre Natural Language Inference)子任务中,模型需要判断两个给定句子之间的逻辑关系是蕴涵、矛盾还是中性。这个任务考验的是模型的逻辑推理能力。

5.2 涌现能力数据集

随着大语言模型规模的增大,研究者们发现这些模型展现出了一些意想不到的"涌现能力"。为了评估这些能力,一些特殊的数据集应运而生。

MMLU(Massive Multitask Language Understanding)是一个典型的例子。这个数据集涵盖了从初等教育到专业领域的57个学科,包括数学、物理、法律、医学等。它不仅测试模型的知识广度,还考验模型的推理能力。想象一个高中生参加各种学科的奥林匹克竞赛,MMLU就是为大语言模型设计的类似挑战。

另一个有趣的数据集是GSM8K(Grade School Math 8K)。这个数据集包含了8000多道小学数学应用题。乍看之下,小学数学题似乎很简单,但实际上它们考验的是模型的多步推理能力。例如,一道题目可能是:"小明有5个苹果,他给了小红2个,然后又从商店买了3个。现在小明有多少个苹果?"模型需要理解问题,分步骤进行计算,最后得出正确答案。这个过程不仅需要基本的算术能力,还需要理解自然语言描述的场景并进行逻辑推理。

5.3 指令跟随数据集

随着大语言模型在对话和任务执行中的广泛应用,评估模型理解和执行指令的能力变得越来越重要。指令跟随数据集就是为了这个目的而设计的。

FLAN(Fine-tuned LAnguage Net)数据集是一个代表性的例子。它包含了大量的指令-响应对,涵盖了各种任务类型。使用FLAN数据集就像是在训练一个通用的智能助手,它需要理解并执行各种不同的指令。例如,一个指令可能是"用一句话总结这篇文章的主要内容",或者"将以下英文句子翻译成法语"。模型需要正确理解指令,并给出适当的响应。

另一个值得关注的是AlpacaEval数据集。这个数据集的特别之处在于它不仅包含了人类编写的指令,还包含了模型生成的指令。这种方法可以创造出更加多样化和具有挑战性的指令集合。例如,数据集中可能包含"解释量子纠缠理论,但要用一个5岁孩子能理解的方式"这样的指令。这不仅测试模型的知识,还考验其解释复杂概念的能力。

5.4 评估指标

评估大语言模型的性能是一个复杂的任务,需要多种指标来全面衡量模型的各个方面。

对于生成任务,BLEU(Bilingual Evaluation Understudy)分数是一个经典的指标。BLEU主要用于评估机器翻译的质量,但也适用于其他文本生成任务。它通过比较模型生成的文本与人类参考文本的n-gram重叠度来计算分数。然而,BLEU也有其局限性,例如它不考虑语义相似性,只关注表面的词语匹配。

ROUGE(Recall-Oriented Understudy for Gisting Evaluation)是另一个常用于评估文本摘要的指标。它有多个变体,如ROUGE-N(考虑n-gram重叠)、ROUGE-L(考虑最长公共子序列)等。ROUGE不仅考虑精确度,还考虑召回率,因此能更全面地评估生成文本的质量。

对于问答和阅读理解任务,F1分数和Exact Match(EM)是常用的评估指标。F1分数是精确度和召回率的调和平均,而EM则要求答案完全匹配。这两个指标结合使用,可以给出模型性能的全面评估。

然而,随着大语言模型能力的不断提升,传统的自动评估指标往往无法fully捕捉模型的所有方面。因此,人工评估仍然plays重要角色。例如,对于开放式问答或创意写作任务,人类评估者可能会根据回答的相关性、连贯性、创造性等多个维度进行打分。

此外,一些新的评估方法也在不断涌现。例如,使用大语言模型自身来评估其他模型的输出质量。这种方法的思想是,如果一个强大的语言模型难以区分人类生成的文本和AI生成的文本,那么这个AI生成的文本就可以被认为是高质量的。

5.5 挑战与未来方向

尽管在数据集和评估方法上已经取得了显著进展,但仍然存在诸多挑战。

首先是数据集的多样性和代表性问题。大多数现有的数据集主要集中在英语,缺乏对其他语言和文化的充分覆盖。这可能导致模型在处理非英语任务时表现不佳。未来,我们需要更多的多语言、多文化数据集来训练真正的通用语言模型。其次是评估指标的局限性。大多数自动评估指标都难以捕捉语言的微妙之处,如幽默、讽刺或创意表达。开发能够评估这些高级语言特征的指标仍然是一个重大挑战。

如何评估模型的道德性和安全性也是一个重要问题,我们需要开发专门的数据集和评估方法来确保模型不会产生有害、偏见或不当的内容。

最后,随着大语言模型向着多模态方向发展,如何设计能够全面评估模型在文本、图像、音频等多种模态之间交互能力的数据集和评估方法,将是未来的一个重要研究方向。

大语言模型的数据集与评估方法正在经历快速的发展和革新。高质量、多样化的数据集为模型提供了丰富的学习资源,而不断完善的评估方法则为模型性能的提升指明了方向。然而,我们仍需要记住,无论数据集多么全面,评估方法多么精细,它们最终都是为了让语言模型更好地服务于人类需求。因此,在追求技术进步的同时,我们也需要不断思考如何让这些进步更好地对齐人类价值观和社会需求。

6. 大语言模型在基准测试上的表现

大语言模型的能力究竟有多强?它们在各种任务上的表现如何?这些问题不仅吸引着研究者的注意,也是产业界和公众关心的焦点。本章将深入探讨主流大语言模型在各种基准测试中的表现,通过对比分析,我们将更清晰地了解这些模型的优势与局限性。

评估大语言模型的表现,就像是对一个全能运动员进行全面的体能测试。每一项基准测试都像是一个特定的运动项目,考验模型在某一方面的能力。通过这些多样化的测试,我们可以全面地评估模型的性能,发现它们的优势和不足,为未来的改进指明方向。

6.1 语言理解与生成能力

在基础的语言理解和生成任务中,大语言模型展现出了令人印象深刻的能力。以GLUE(General Language Understanding Evaluation)基准为例,它包含了多个子任务,涵盖了从情感分析到自然语言推理等多个方面。

GPT-3在GLUE基准上的表现就十分出色。例如,在CoLA(The Corpus of Linguistic Acceptability)任务中,GPT-3达到了接近人类水平的性能。这个任务要求模型判断一个给定的英语句子在语法上是否可接受。GPT-3能够准确地识别出微妙的语法错误,这展示了它对语言结构的深刻理解。

在生成任务方面,BLOOM模型在多语言摘要生成任务上表现出色。例如,给定一篇长文章,BLOOM能够生成简洁而准确的摘要,不仅捕捉了文章的主要内容,还能保持语言的流畅性和多样性。这种能力在新闻摘要、文献综述等应用中具有巨大潜力。

6.2 推理与问题解决能力

大语言模型在需要复杂推理的任务中也表现出了惊人的能力。GSM8K(Grade School Math 8K)是一个典型的例子,它包含了8000多道需要多步推理的小学数学应用题。

在这个基准测试中,PaLM(Pathways Language Model)展现出了强大的推理能力。例如,面对这样一道题目:

“一家商店周一卖出了36个苹果,周二卖出的苹果数量是周一的1.5倍,周三卖出的苹果数量比周二少12个。这三天总共卖出了多少个苹果?”

PaLM能够step-by-step地解决这个问题:

-

周一卖出36个苹果

-

周二卖出36 * 1.5 = 54个苹果

-

周三卖出54 - 12 = 42个苹果

-

总共卖出36 + 54 + 42 = 132个苹果

这种清晰的推理过程不仅给出了正确答案,还展示了模型是如何一步步解决问题的,这对于教育应用来说极具价值。

6.3 知识与常识推理

评估大语言模型的知识广度和常识推理能力是一个挑战性的任务。MMLU(Massive Multitask Language Understanding)基准测试就是为此设计的。它涵盖了57个学科,从基础的小学知识到高度专业的领域知识都有涉及。

在这个基准测试中,GPT-4展现出了惊人的表现。例如,在回答"哪个粒子负责传递电磁力?“这样的物理学问题时,GPT-4不仅能够正确回答"光子”,还能解释光子的性质和它在电磁相互作用中的角色。这种深度的理解和解释能力,显示了GPT-4不仅拥有广泛的知识,还能进行深入的推理。

6.4 多语言能力

随着全球化的深入,大语言模型的多语言能力越来越受到重视。XTREME(Cross-lingual TRansfer Evaluation of Multilingual Encoders)基准就是专门设计来评估模型的跨语言迁移能力的。

在这个基准测试中,XLM-R(XLM-RoBERTa)表现出色。例如,在零样本跨语言迁移设置下,即模型只在英语数据上训练,但需要在其他语言上执行任务,XLM-R在多个语言的命名实体识别任务中都取得了良好的效果。这种能力意味着,即使对于资源匮乏的语言,我们也可能通过跨语言迁移来构建有效的NLP系统。

6.5 代码生成与理解

近年来,大语言模型在代码相关任务上的表现也引起了广泛关注。HumanEval是一个评估模型编程能力的基准测试,它包含了164个编程问题,涵盖了各种编程概念和算法。

在这个基准上,Codex模型展现出了强大的代码生成能力。例如,给定这样一个问题描述:

“编写一个函数,接受一个整数列表作为输入,返回该列表中第二大的数。如果没有第二大的数,则返回None。”

Codex能够生成如下的Python代码:

def second_largest(numbers):

if len(numbers) < 2:

return None

largest = max(numbers)

second = max(num for num in numbers if num < largest)

return second if second < largest else None

- 1

- 2

- 3

- 4

- 5

- 6

- 7

这段代码不仅正确实现了所需的功能,还考虑了边界情况,展示了模型对编程逻辑和Python语言特性的深入理解。

6.6 挑战与局限性

尽管大语言模型在许多基准测试上表现出色,但它们仍然面临着诸多挑战。

-

是模型的不一致性。在某些情况下,模型可能对相同的问题给出不同的答案,或者在简单问题上出错而在复杂问题上表现出色。这种不一致性降低了模型的可靠性,特别是在需要高度准确性的应用场景中。

-

是模型的"幻觉"问题。在TruthfulQA这样的基准测试中,即便是最先进的模型也时常会生成看似合理但实际上并不正确的信息。这突显了确保模型输出真实性和准确性的重要性。

-

大语言模型在处理需要实时信息或专业领域知识的任务时仍然面临挑战。例如,在回答"现任联合国秘书长是谁?"这样的问题时,模型可能会给出过时的答案。

-

模型的伦理和偏见问题也值得关注。在一些评估公平性和包容性的基准测试中,大语言模型有时会表现出一定的社会偏见,这提醒我们在开发和使用这些模型时需要特别注意伦理问题。

大语言模型在多个基准测试上展现出了让人印象深刻的性能,从基础的语言理解到复杂的推理任务,从多语言处理到代码生成,这些模型都显示出了强大的能力。然而,我们也需要清醒地认识到这些模型的局限性,继续改进模型的一致性、真实性和公平性。

7. 挑战与未来方向

尽管大语言模型在众多领域取得了令人瞩目的成就,但它们仍然面临着诸多挑战。同时,这些挑战也为未来的研究指明了方向。本章将深入探讨大语言模型当前面临的主要挑战,以及研究社区正在探索的有希望的未来方向。

大语言模型的发展犹如一场漫长的探险之旅。我们已经攀登到了令人惊叹的高度,但在通往真正的人工智能的道路上,仍有许多未知的山峰等待我们去征服。每一个挑战都是一座新的山峰,而每一个研究方向都是一条可能通向顶峰的路径。

7.1 更小、更高效的语言模型

虽然"更大就是更好"这一理念在过去几年推动了大语言模型的快速的发展,但模型的巨大规模也带来了显著的挑战。训练和部署这些模型需要更多的计算资源,这不仅造成了高昂的经济成本,还带来了环境影响。

因此,研究社区正在积极探索如何开发更小、更高效的语言模型。例如,微软研究院的Phi-1系列模型展示了小型模型也能实现令人印象深刻的性能。Phi-1只有13亿参数,但在某些任务上的表现可以媲美有着数百亿参数的大型模型。

未来的研究方向可能包括:

-

模型压缩技术:如何在不显著降低性能的情况下减少模型的参数量。

-

知识蒸馏:如何将大模型的知识有效地转移到小模型中。

-

稀疏激活:研究如何只激活模型中的一小部分参数来完成特定任务,从而提高效率。

这些研究不仅可以降低模型的使用成本,还可能使大语言模型技术在资源受限的设备(如移动设备)上得到更广泛的应用。

7.2 新的后注意力架构范式

Transformer架构自2017年提出以来,一直是大语言模型的主导架构。然而,随着模型规模的不断增大,Transformer架构的一些限制也逐渐显现,尤其是在处理长序列时的效率问题。

研究者们正在探索新的架构范式,以客服这些限制。例如,State Space Models (SSMs)就是一个有希望的方向。像Mamba这样基于SSM的模型展示了处理长序列时的优势,它能够高效地建模长距离依赖关系,同时保持较低的计算复杂度。

未来的研究方向可能包括:

-

改进的注意力机制:如何设计更高效的注意力机制,以更好的处理长序列。

-

混合架构:如何结合Transformer和其他架构的优点,创造更强大的模型。

-

动态架构:研究能够根据输入自动调整结构的模型架构。

这些新的架构范式可能会带来大语言模型在效率和能力上的质的飞跃。

7.3 多模态模型

语言是人类交流和理解世界的重要方式,但it’s not 唯一的方式。视觉、听觉等其他感官也在我们的认知过程中起着关键作用。因此,研究社区正在积极探索如何将语言模型与其他模态结合,创造真正的多模态AI。

GPT-4已经展示了处理图像和文本的能力,而像DALL-E这样的模型则能够根据文本描述生成图像。未来的研究方向可能包括:

-

跨模态理解:如何让模型better理解不同模态之间的关系和互动。

-

多模态生成:如何同时生成多种模态的内容,例如自动为视频生成配音和字幕。

-

多模态推理:如何利用多种模态的信息进行更复杂的推理任务。

多模态模型的发展可能会让AI系统在理解和交互方面更接近人类的认知方式。

7.4 改进的LLM使用和增强技术

尽管大语言模型本身已经很强大,但如何更有效地使用和增强这些模型仍然是一个重要的研究方向。

例如,检索增强生成(RAG)技术已经证明了其在提高模型输出准确性和时效性方面的潜力。未来的研究方向可能包括:

-

更智能的检索策略:如何更准确地识别和检索与当前任务相关的信息。

-

动态知识更新:如何让模型能够实时更新其知识库,而不需要完全重新训练。

-

个性化增强:如何根据用户的特定需求和背景知识来定制模型的输出。

此外,提示工程(Prompt Engineering)的发展也值得关注。如何设计更有效的提示来引导模型生成所需的输出,这本身就是一个富有挑战性的研究课题。

7.5 安全性和伦理AI

随着大语言模型在各个领域的广泛应用,确保这些模型的安全性和伦理性变得越来越重要。

目前的研究已经揭示了一些潜在的风险,如模型生成有害或偏见内容、被滥用于生成虚假信息等。未来的研究方向可能包括:

-

对齐技术:如何确保模型的行为与人类价值观保持一致。

-

可解释性:如何让模型的决策过程更加透明和可解释。

-

隐私保护:如何在利用大规模数据训练模型的同时,保护个人隐私。

-

公平性:如何减少模型在不同人群中的表现差异,确保AI技术的公平使用。

这些研究不仅关乎技术本身,还涉及法律、伦理、社会学等多个领域,需要多领域的合作。

大语言模型的未来发展方向是多元化的。从技术角度看,我们需要努力提高模型的效率、扩展其能力范围;从应用角度看,我们需要探索如何更好地利用和增强这些模型;从社会角度看,我们需要确保这些强大的技术工具被负责地使用。

这些挑战是巨大的,但也充满机遇。它们不仅推动着AI技术的进步,也促进着我们对智能本质的深入思考。随着研究的不断深入,我们有理由期待大语言模型将继续进化我们与技术交互的方式,并在解决复杂的现实问题方面发挥越来越重要的作用。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

#### 一、全套AGI大模型学习路线

#### 一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案