热门标签

热门文章

- 1移动办公挂机两不误,手机平板如何远程登录云服务器?_平板连接阿里云服务器

- 2Android Studio常用技巧汇总_android studio 使用技巧

- 3第3章 虚拟存储器 摘录_超标量处理器设计姚永斌 pdf

- 4GUROBI之数学启发式算法Matheuristics_gurobi 设置 heuristics=0.5

- 5R语言学习-tidyverse-ggplot2入门

- 6win10系统定时关机_setsuspendstate rtc

- 7AI学习_概率问题_矩阵乘法_线代概念_三维矩阵 概率

- 8dv4 安装linux,linux安装中的问题

- 9双击bat文件不能运行_bat文件双击不能运行

- 10C1小笔记【任务训练篇一】_a.b.c.d/x,其中 /x 表示前 x 位属于网络号

当前位置: article > 正文

基于MacBook Pro M1芯片运行chatglm2-6b大模型_mac m1 部署 chatglm2 量化

作者:小丑西瓜9 | 2024-03-16 19:19:19

赞

踩

mac m1 部署 chatglm2 量化

1. 参考

2. ChatGLM2-6B 介绍

ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 引入了如下新特性:

- 更强大的性能。

- 更长的上下文。

- 更高效的推理。

- 更开放的协议。

详细介绍参考官方README介绍。

3. 本地运行

3.1 硬件配置

- 芯片:Apple M1 Pro

- 内存:32 GB

3.2 下载ChatGLM2-6B代码

cd /Users/joseph.wang/llm

git clone https://github.com/THUDM/ChatGLM2-6B

- 1

- 2

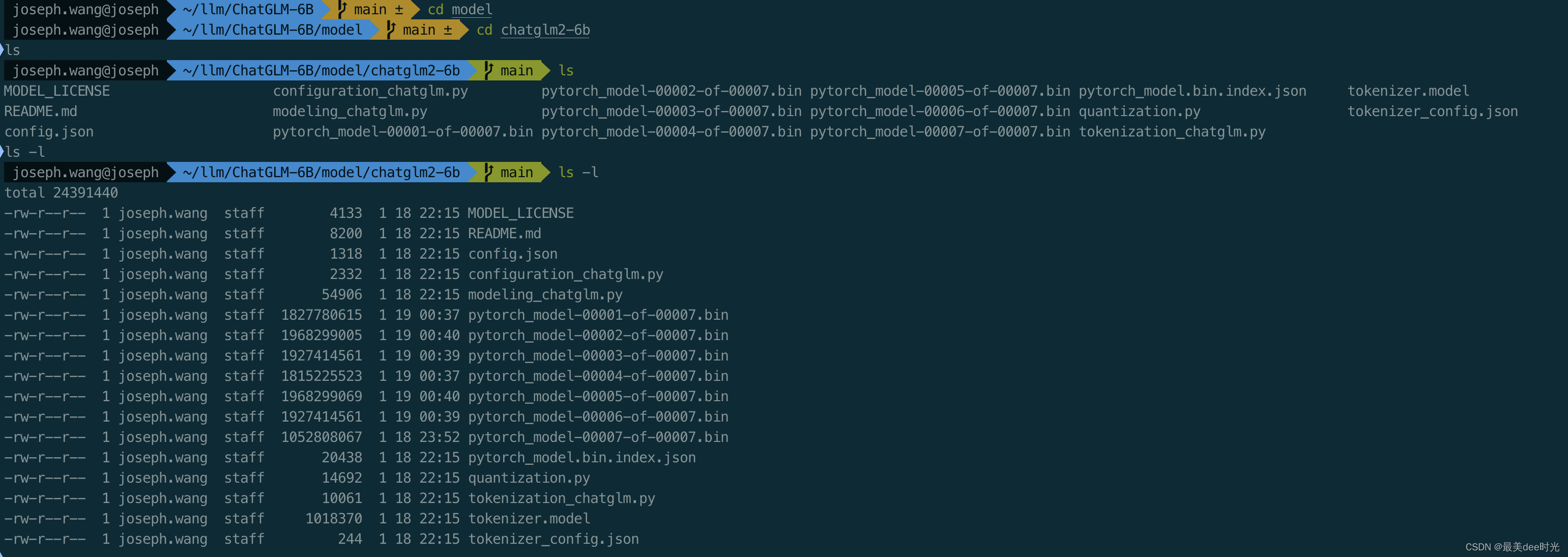

3.3 下载需要加载的模型

此步骤下载模型需要科学上网,同时需要耐心,因为下载的时间会比较长。

cd /Users/joseph.wang/llm/ChatGLM2-6B

mkdir model

cd model

git lfs install

git clone https://huggingface.co/THUDM/chatglm2-6b

- 1

- 2

- 3

- 4

- 5

3.4 运行大模型

3.4.1 安装依赖

cd /Users/joseph.wang/llm/ChatGLM-6B

pip install -r requirements.txt

- 1

- 2

其中 transformers 库版本推荐为 4.30.2,torch 推荐使用 2.0 及以上的版本,以获得最佳的推理性能。

3.4.2 编辑web_demo.py

cd /Users/joseph.wang/llm/ChatGLM-6B

- 1

...

...

# 修改为通过本地加载大模型,这里改本地下载后大模型的路径即可。

tokenizer = AutoTokenizer.from_pretrained("/Users/joseph.wang/llm/ChatGLM-6B/model/chatglm2-6b", trust_remote_code=True)

# 参考 [Mac M1 部署](https://github.com/THUDM/ChatGLM2-6B/blob/main/README.md#mac-%E9%83%A8%E7%BD%B2) 即可

model = AutoModel.from_pretrained("/Users/joseph.wang/llm/ChatGLM-6B/model/chatglm2-6b", trust_remote_code=True).to('mps')

...

...

# 修改本地启动的端口

demo.queue().launch(share=True, inbrowser=True, server_port=1185)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

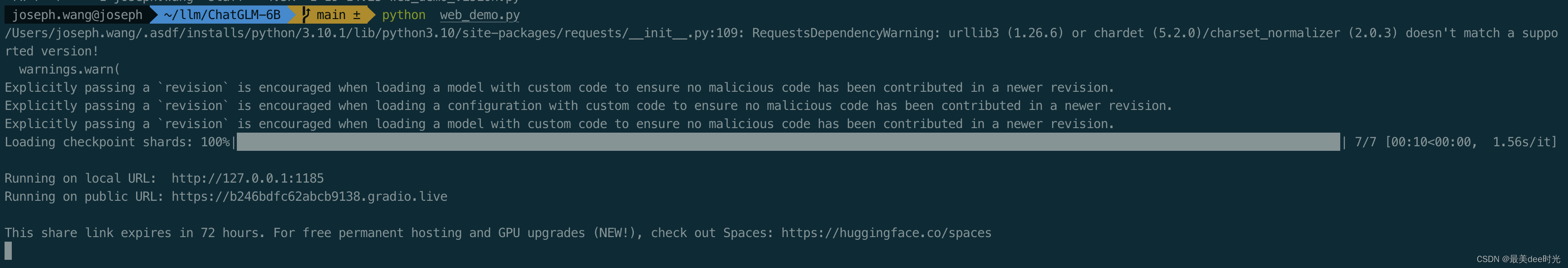

3.4.3 启动

python web_demo.py

- 1

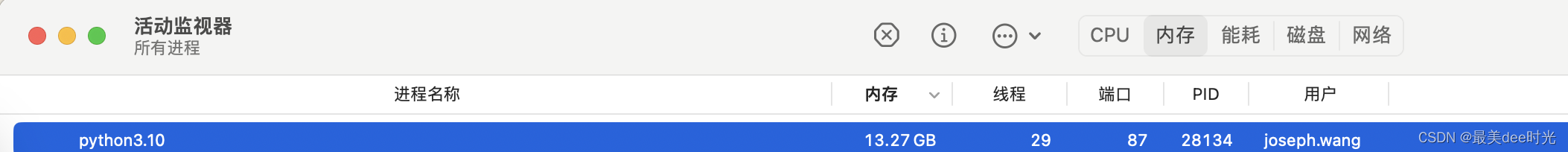

内存消耗

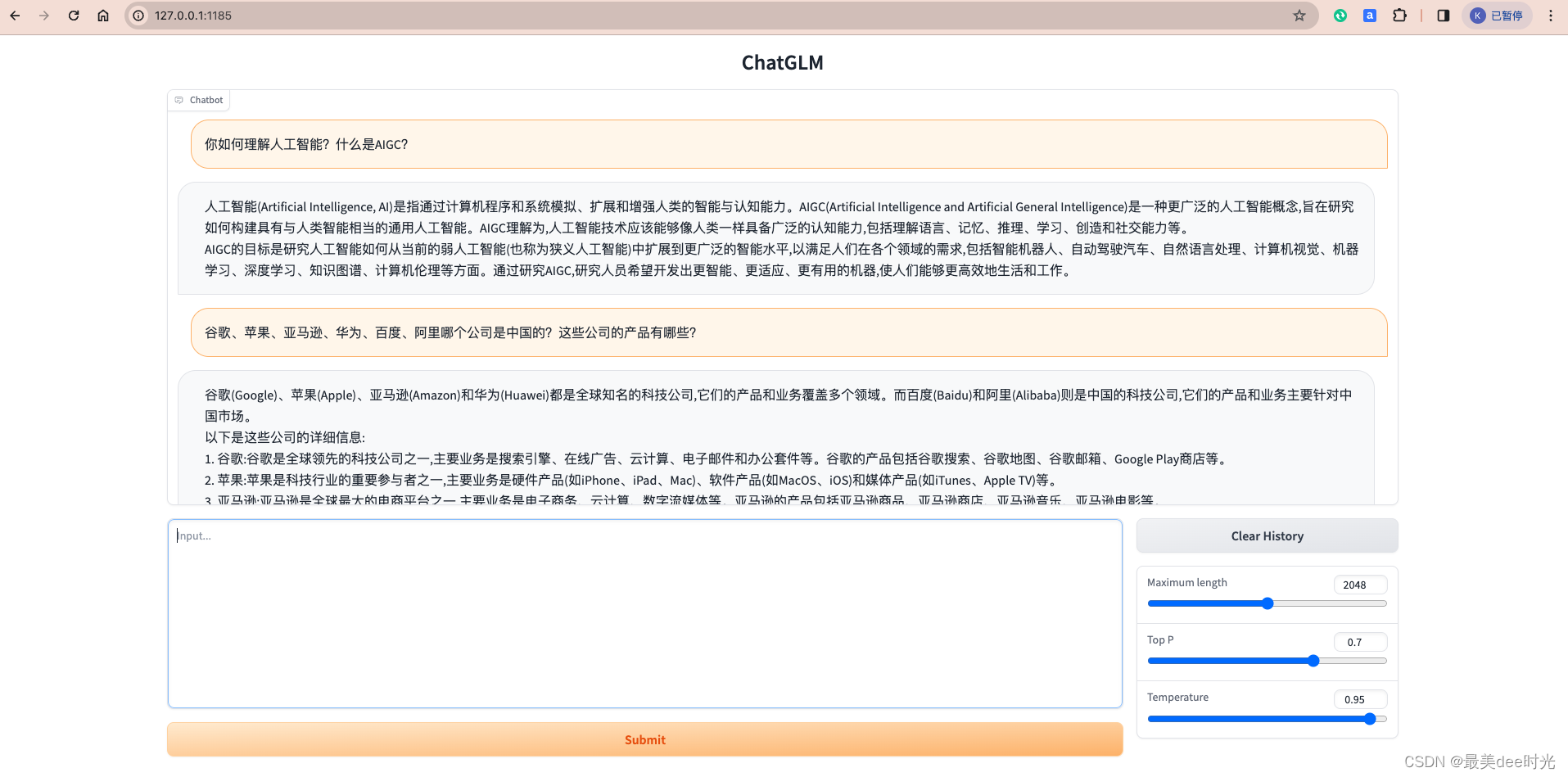

4. 测试

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/251541

推荐阅读

相关标签