- 1【Super Resolution】超分辨率——SRGAN_userwarning: discrepancy between trainable weights

- 2【SpringCloud-1】注册中心-Eureka_注册中心,springcloud

- 3Android studio计算器

- 4逻辑卷的创建、扩容、缩容,以及raid0/5的创建_逻辑卷缩容

- 5yolov5的工业缺陷检测_yolov5缺陷检测

- 6命令注入漏洞(Command Injection)_system漏洞

- 7JAVA面试大全之基础篇

- 8AIGC内容分享(三十):推荐四本人工智能和AIGC相关的书籍_aigc书籍推荐

- 9什么是命令注入?其原理是什么?_命令注入漏洞攻击原理

- 10CSDN的会员等级和推荐卡规则_csdn达到什么等级才能推广公众号

GPT4-All 本地模型下载_gpt4all无法识别本地模型

赞

踩

ChatGPT狂飙160天,世界已经不是之前的样子。

新建了人工智能中文站https://ai.weoknow.com

每天给大家更新可用的国内可用chatGPT资源

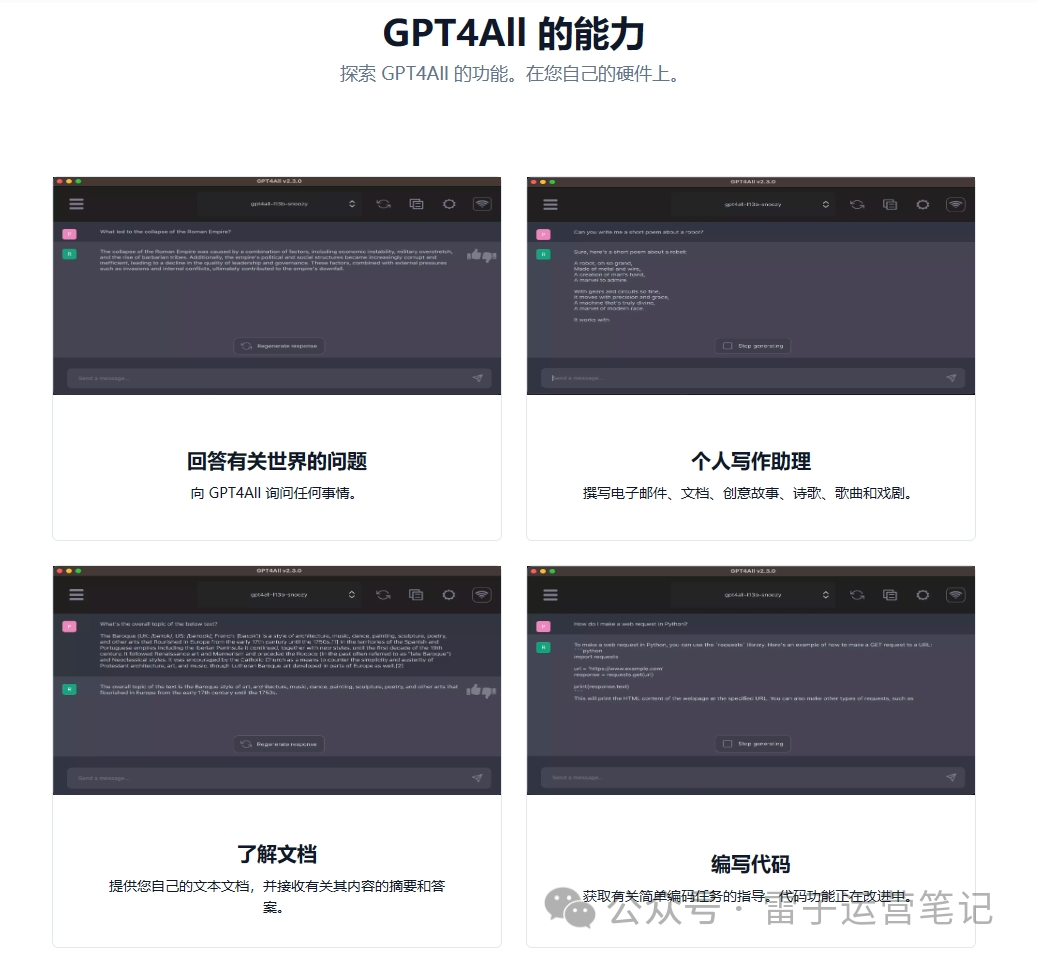

一个无限使用、可以加载大语言模型的聊天机器人,无需联网本地可运行。由Nomic AI 支持和维护这个软件生态系统,以加强质量和安全性,同时可以训练和部署自己的大型语言模型。

GPT4All 安装包请前往TB下载

Windows 安装程序

下载并安装后,您应该能够在安装程序中指定的目录中找到该应用程序。安装后,您会找到 GPT4All 的桌面图标。

注意:以安装在C盘为例(建议C盘),

放置模型的路径在:

C:\Users\Administrator\AppData\Local\nomic.ai\GPT4All (需要提前打开隐藏的文件夹)

模型下载:

模型推荐:Mistral OpenOrca 【点击下载】或者软件内下载,在GPU的加速下,速度非常快!

下载地址:

https://gpt4all.io/models/gguf/mistral-7b-openorca.Q4_0.gguf

另外值得注意的是,通常来说模型越大效果越好,由于大语言模型是被各大AI机构训练出来的,有些暂时还不支持中文输出,用不上的可以删掉。另外软件内部也支持直接下载,不过模型都是存储在外网空间上的,所以需要先开魔法再下载哦~

VPN推荐:https://www.feixunx.org/auth/register?code=Sxgv

密斯特拉尔-7b-openorca.Q4_0.gguf

最佳整体快速聊天模型

-

快速响应

-

基于聊天的模型

-

由 Mistral AI 训练

-

在通过Nomic Atlas管理的 OpenOrca 数据集上进行了微调

-

已获得商业用途许可

下载

https://gpt4all.io/models/gguf/mistral-7b-openorca.Q4_0.gguf

大小:3.83 GB内存:8GB

米斯特拉尔-7b-指令-v0.1.Q4_0.gguf

最佳整体快速指令跟随模型

-

快速响应

-

由 Mistral AI 训练

-

未经审查

-

已获得商业用途许可

下载

https://gpt4all.io/models/gguf/mistral-7b-instruct-v0.1.Q4_0.gguf

大小:3.92 GB内存:8GB

gpt4all-falcon-q4_0.gguf

模型速度非常快,质量很好

-

最快的响应

-

基于指令

-

由TII培训

-

由 Nomic AI 微调

-

已获得商业用途许可

下载

https://gpt4all.io/models/gguf/gpt4all-falcon-q4_0.gguf

大小:3.56 GB内存:8GB

orca-2-7b.Q4_0.gguf

-

基于指令

-

由微软培训

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/orca-2-7b.Q4_0.gguf

大小:6.86 GB内存:16GB

orca-2-13b.Q4_0.gguf

-

基于指令

-

由微软培训

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/orca-2-13b.Q4_0.gguf

大小:6.86 GB内存:16GB

Wizardlm-13b-v1.2.Q4_0.gguf

最佳整体较大型号

-

基于指令

-

给出很长的回复

-

仅用 1k 高质量数据进行微调

-

微软和北京大学培训

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/wizardlm-13b-v1.2.Q4_0.gguf

大小:6.86 GB内存:16GB

努斯-爱马仕-llama2-13b.Q4_0.gguf

非常好的模型

-

基于指令

-

给出很长的回应

-

包含 300,000 条未经审查的说明

-

由 Nous Research 培训

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/nous-hermes-llama2-13b.Q4_0.gguf

大小:6.86 GB内存:16GB

gpt4all-13b-snoozy-q4_0.gguf

整体模型非常好

-

基于指令

-

基于与 Groovy 相同的数据集

-

比 Groovy 慢,但响应质量更高

-

由 Nomic AI 培训

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/gpt4all-13b-snoozy-q4_0.gguf

大小:3.54 GB内存:8GB

mpt-7b-聊天-合并-q4_0.gguf

模型不错,架构新颖

-

快速响应

-

基于聊天

-

由 Mosaic ML 训练

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/mpt-7b-chat-merges-q4_0.gguf

大小:1.84 GB内存:4GB

虎鲸-mini-3b-gguf2-q4_0.gguf

具有新颖数据集的新模型的小版本

-

基于指令

-

解释调整后的数据集

-

Orca 研究论文数据集构建方法

-

不能用于商业用途

下载

https://gpt4all.io/models/gguf/orca-mini-3b-gguf2-q4_0.gguf

大小:1.74 GB内存:4GB

重复代码-v1_5-3b-q4_0.gguf

在堆栈的子集上进行训练

-

基于代码完成

-

已获得商业用途许可

-

警告:不适用于聊天 GUI

下载

https://gpt4all.io/models/gguf/replit-code-v1_5-3b-q4_0.gguf

大小:8.37 GB内存:4GB

starcoder-q4_0.gguf

在堆栈的子集上进行训练

-

基于代码完成

-

警告:不适用于聊天 GUI

下载

https://gpt4all.io/models/gguf/starcoder-q4_0.gguf

大小:3.56 GB内存:8GB

裂痕编码器-v0-7b-q4_0.gguf

接受过 Python 和 TypeScript 集合培训

-

基于代码完成

-

警告:不适用于聊天 GUI

下载

https://gpt4all.io/models/gguf/rift-coder-v0-7b-q4_0.gguf

大小:0.04 GB内存:1 GB

全MiniLM-L6-v2-f16.gguf

LocalDocs 文本嵌入模型

-

LocalDocs 功能所必需的

-

用于检索增强生成(RAG)

下载

https://gpt4all.io/models/gguf/all-MiniLM-L6-v2-f16.gguf

大小:3.83 GB内存:8GB

em_german_mistral_v01.Q4_0.gguf

基于 Mistral 的德语应用模型

-

快速响应

-

基于聊天的模型

-

由埃拉米德培训

-

对德语指令和聊天数据进行了微调

-

已获得商业用途许可

下载

https://huggingface.co/TheBloke/em_german_mistral_v01-GGUF/resolve/main/em_german_mistral_v01.Q4_0.gguf

ChatGPT狂飙160天,世界已经不是之前的样子。

新建了人工智能中文站https://ai.weoknow.com

每天给大家更新可用的国内可用chatGPT资源