- 1杭电acm-1874畅通工程续_java实现acm畅通工程续

- 2消息队列:Kafka入门学习笔记_卡夫卡消息

- 3uniapp使用vue-i18n国际化多国语言_前端国际化uniapp

- 4【搞机记录】如何基于 Chat GPT 搭建微信聊天机器人?_chatgpt-on-wechat

- 5bash: sqlplus: command not found 问题解决方法

- 6Git下载部署并加入IDEA操作运行提交(详细笔记)_git下载的代码怎么在idea运行

- 7GitHub 创建自己的Token图文详细介绍

- 8如何选择终端桌面管理软件?

- 9招聘全球视野:跨境电商的人才策略

- 10JAVA面试题分享一百六十四:消息堆积如何解決?_消息太多处理不过来javaweb处理方式

关于机器学习/深度学习的一些事-答知乎问(二)

赞

踩

进化算法与深度强化学习算法结合如何进行改进?

(1)进化算法普遍存在着样本效率低下的问题,虽然其探索度较高,但其本质为全局随机性搜索,需要在整个回合结束后才能更新其种群,而深度强化学习在每个回合步中都会得到大量的信息并使用这些信息进行梯度更新,因此进化算法相较于深度强化学习来说样本效率较低.针对进化算法样本效率的问题,可以使用深度强化学习中的梯度和回合步中的其它信息对其进行指导,指引进化算法种群在解空间中的位置与下一代进化的方向。

(2)进化算法与深度强化学习的兼容性较差,目前进化算法与深度强化学习的组合与耦合方式较为单一,可以从探索和利用的角度进一步的分析和探究两者的其它结合方式。平衡强化学习中的探索和利用一直是强化学习领域中的一个重要问题,在与进化算法结合的深度强化学习中也需要对两者进行更为合理的平衡,如引人新颖度与探索度等一些度量方式在进化算法的探索和深度强化学习的利用中自动调节也是未来的方向之一。

(3)目前结合进化算法与深度强化学习的方法中均与最新的同类方法进行了比较,但很少有进行消融实验并进行进一步分析其算法获得提升的工作。进化算法本身为一种启发式算法,其理论基础较为薄弱,且与深度强化学习一样均不能保证其收敛性,因此需要加强对算法性能提升的分析与实验,从而为进一步的研究打下基础。

如何解决神经网络灾难性遗忘的问题?

1)探索生物怎样避免灾难性遗忘的机制,并根据该机制设计相似的神经网络模型。

2) 探索神经网络模型存储信息的新机制,如果神经网络模型在学习新知识后仍能保持对之前学习的知识不遗忘,必然需要存储一些关于之前学习的知识的一些信息,怎样高效地存储和利用这些信息值得研究。

3) 选取具有代表性的样本也是一种方法。该方法不仅存在于生物的认知中,也广泛存在于社会生活中。如社会生活中的选举,某一社会团体通常推选出该团体中的某几位成员而不是全体成员代表该社会团体,这也从另一个角度说明,部分样本往往可以近似代表总体样本。对比到神经网络模型中,选取某一任务中具有代表性的样本,而不是使用所有样本代表该任务; 该方法需要确定推选机制,即怎样确定样本集中的某些样本具有代表该样本集的能力。一个显而易见的事实是,神经网络模型是对生物神经网络的模仿,而现在神经网络模型出现灾难性遗忘的问题,说明对生物的神经网络研究的并不彻底,还有很多盲点。思路1) 进一步研究生物的避免研究灾难性遗忘的机制,应该是研究的重点和趋势。

随机梯度下降算法如何进一步改进?

1) 与二阶算法相比, 随机梯度下降算法的收敛速度相对较慢, 且需要更多的迭代次数。第2代和第3代改进算法虽然有效地提升了收敛速度, 但耗费了较大的时间成本和内存成本。随着数据规模的扩大和模型复杂度的提升, 单线程下的随机梯度下降算法已经不能满足大规模机器学习应用的需求。并行式随机梯度下降算法SimuParallelSGD适合于大规模学习范式和MapReduce 框架;Hogwild 算法对稀疏数据采用无锁异步更新策略, 从而有效地减少了特征更新时的冲突。目前, 研究者们已经实现了SVRG、SAGA 和MiG等改进算法的分布式和并行化版本, 但收敛速度却有待进一步提升。如何根据算法特点、数据对象和应用平台,设计并实现不同改进策略下的随机梯度下降算法的分布式与并行化版本, 使其在实际应用中发挥出较高的性能水平, 这是未来值得探索的问题。

2)随机梯度下降算法在每轮迭代过程中计算复杂度较低, 但只利用了一阶梯度, 忽略了目标函数的二阶信息及曲率, 从而限制了实际性能和收敛速度。如何结合一阶与二阶方法各自的长处,进一步设计迭代效率俱佳的随机梯度下降算法,是未来值得研究的问题。

3) 近年来, 研究者们将目光投向非凸的ERM模型, 并且提出了一些行之有效的解决方案, 其中具有代表性的策略包括添加动量跳出局部最优解、使用方差缩技术减少梯度方差和添加梯度噪声逃离鞍点等。然而, 对于更为一般的非凸、非光滑的优化问题却并未取得太大的突破, 目前仅有Prox-SAGA、Prox-SVRG+等算法, 但性能并不理想。随机梯度下降算法在非凸、非光滑条件下的策略研究, 不仅是当前面临的困局, 也是未来最具有应用价值的研究方向。

4) 对于非凸的优化问题, 梯度下降法通常存在两个缺陷: 易于陷入局部最优、无法逃离鞍点。而演化计算/智能计算无需计算梯度和确定步长, 且往往具有较好的全局收敛性。如何将随机梯度下降算法与演化计算/智能计算方法相结合, 将是一个非常值得关注的研究方向。

可解释人工智能方法的细粒度划分?

独立于模型的解释方法:特征相关解释,特征相关解释,代理模型解释等

特征相关解释包括:部分依赖图、个体条件期望、累计局部效应、特征交互、置换特征重要性、Shapley Values

基于样本的解释:对抗样本、原型、有影响力的样本

代理模型解释:全局代理模型、LIME及其变种

依赖于模型的解释方法:自解释模型和特定模型的解释等

自解释模型:线性回归、逻辑回归、决策树、朴素贝叶斯、RuleFIt

特定模型的解释:DeepLIFT、LRP、激活最大化、基于梯度的方法、类激活映射

因果解释方法:反事实解释

如何做可解释人工智能方法的定性评估?

定性评估方法依靠人的视觉感观来评价解释结果是否符合人的认知,该方法简单清晰,易于理解,对用户来说是更友好的。对于XAI方法的定性评估,主要从解释的基本单位和可视化效果两个方面进行评估。

解释的基本单位指解释是由什么组成的,可以是特征重要性值、训练集的实例,规则列表和像素等。 因此对于解释的基本单位我们想要知道其构成形式与数量。如果解释是由特征组成的,那么它是包含所有特征还是仅包含少数特征。如果提供的是反事实解释, 那么提供的解释与决策结果之间是否具有因果关系以及反事实结果对用户来说是否可行。

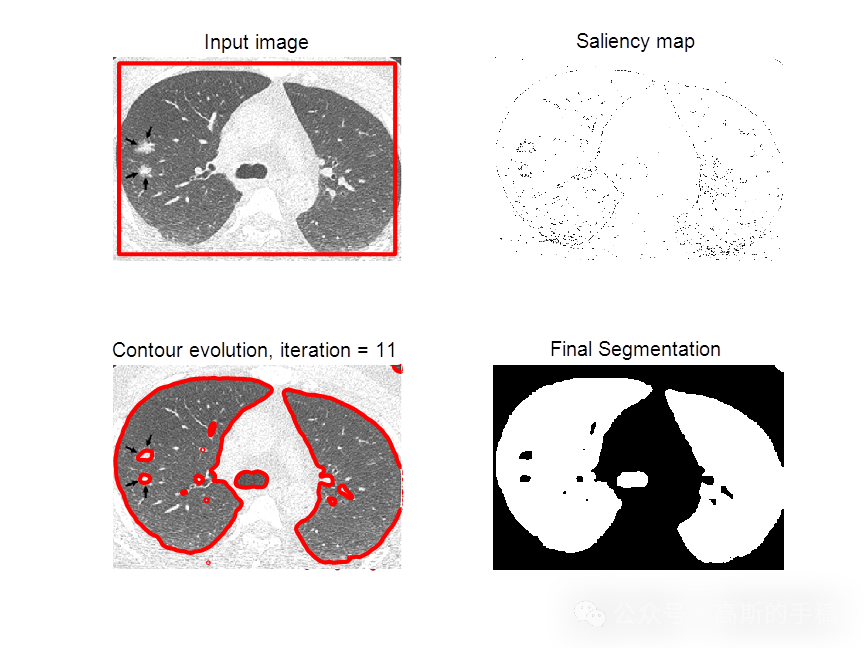

目前对于深度神经网络,更多采用可视化的方式进行解释,即构建显著性图来突出显示最相关的信息, 从而提供可解释性。因此对于可解释性的定性评估方法,主要从可视化效果方面考虑,包括两方面的问题: 一方面是观察目标区域的集中度和覆盖面,显著性图需要重点关注感兴趣的目标区域,而忽略其它不相关区域。显著性图中突出的区域对感兴趣目标的覆盖越全面,表明可视化效果越好。另一方面是考查多目标的可视化效果。当多个同一类别的目标同时出现在图像中时,可视化方法能够同时定位多个目标,而不会遗漏其中的某个目标。

如何做可解释人工智能方法的定量评估?

依靠人的主观度量评估模型的可解释性方法是不够的,定量评估为比较不同的解释提供了一种客观的方法,一般将可解释性定量评估方法分为两类:

一类是无特定方法的一般评估指标。 常用的指标包括:保真度,衡量解释对黑盒模型预测的近似程度;一致性,衡量相同任务产生的相似模型的解释结果是否会有差异;稳定性,衡量特征的微小变化是否会改变解释;完整性,衡量解释所包含的实例数所覆盖的解释范围。

另一类是特定方法的评估指标。

对于特征交互解释方法,比如特征的数量、特征之间的交互强度和特征的主效应复杂性来衡量用于解释的事后模型的复杂性。对于扰动的解释方法,比如可以用失真度和敏感性两个度量指标去评估模型的可解释性。还比如像素扰动定量评价指标,通过删除k个最不突出的像素后衡量分类器输出的变化。 对于因果解释方法的评估,目前的因果解释方法大多是基于反事实的解释,因此这类方法的评估是通过衡量生成反事实解释的好坏来衡量。常用的评估指标包 括:稀疏性,衡量反事实的大小;数据流性相近性,衡量反事实解释是否接近模型训练数据分布; 接近度,衡量对反事实样本的模型预测是否接近于预定义的输出;多样性,为数据实例生成的反事实 解释应该彼此不同。

对于可解释性的评估方法而言,未来我们一方面要从从应用场景、人类认知等角度来设计定性的评估指标,另一方面需要从解释结果的一致性、稳定性以及不同解释方法的差异性等角度设计评价指标,对解释方法进行综合评估。总之,模型的解释是否可靠真实并且能否提高用户的决策能力始终是评估方法需要聚焦的问题。

知乎学术咨询:

工学博士,担任《Mechanical System and Signal Processing》等期刊审稿专家,擅长领域:现代信号处理,机器学习,深度学习,数字孪生,时间序列分析,设备缺陷检测、设备异常检测、设备智能故障诊断与健康管理PHM等。