- 1am命令基本知识_am start

- 2ccfcsp201312-2 ISBN号码

- 3分享 GitHub 上的敏感词汇工具类:sensitive-word_sensitive word 开源

- 4MK+Sen趋势检验(长时间栅格数据)_遥感影像theil-sen趋势分析mk检验

- 5【BUG解决】vscode debug python launch.json添加args不起作用_launch.json args

- 6Java多线程面试题_java面试 多线程

- 7检测和解决 SQL Server 2000 SP 4 中的延迟和阻塞 I/O 问题_sql server has encomtered 3 ocurence of i/o reques

- 8【论文泛读】4. 机器翻译:Neural Machine Translation by Jointly Learning to Align and Translate_src_train_data和trg_train_data

- 9redis设置缓存时间一般多少_redis缓存涉及到商品时时间控制多久

- 10VM虚拟机 Linux网络配置(Center os 6.8)。_vm虚拟机 linux6.8更改网络配置

Text to Image综述阅读(1.2)发展与基本方法 Adversarial Text-to-Image Synthesis: A Review(基于GAN的文本生成图像)

赞

踩

本系列是根据2021年的一篇论文《Adversarial Text-to-Image Synthesis: A Review》理解所写,主要在于总结和归纳基于GAN的“文本生成图像”(text to image)方向的研究情况。很多内容为个人理解,仅供学习参考。

论文地址:https://arxiv.org/abs/2101.09983

三、发展与基本方法

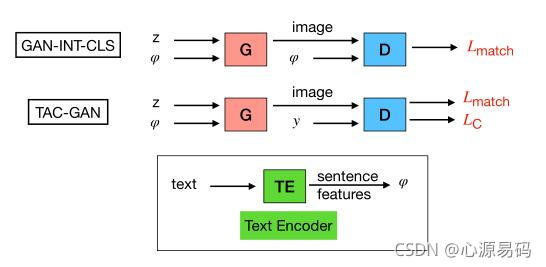

1、起源:GAN-INT-CLS和TAC-GAN

GAN-INT-CLS:输入TE后的文本和一定噪声,使用GAN的生成器拥有的图片合成能力合成一张图像传给辨别器,辨别器根据生成的图像和TE的文本来识别真假,这是初始最简单的模型。

TAC-GAN:在辨别器上面做出改动,他加了一个辅助分类任务y,从而辨别生成的图像是否符合y类。

文本理解采用:pre-trained char-CNN-RNN text encoder

y:TAC-GAN使用的一个辅助分类任务

φ:TE的文本,Embedding φ

z:噪声

TE:Text Encoder

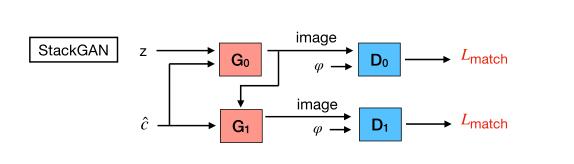

2、栈的引入

2.1、StackGAN

StackGAN采用了两级的GAN,第一个生成器G0生成6464,第二个生成器G1在此基础上生成256256。

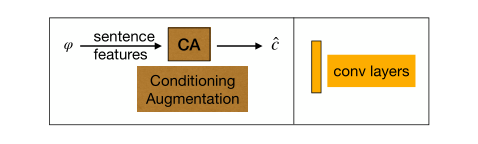

CA:Conditioning Augmentation(CA),一个文本理解模块

c:CA后的文本

z:噪声

φ:Embedding文本

CA:Conditoning Augmentation,一种条件增强技术,帮助在不同的分辨率下生成更一致的图像

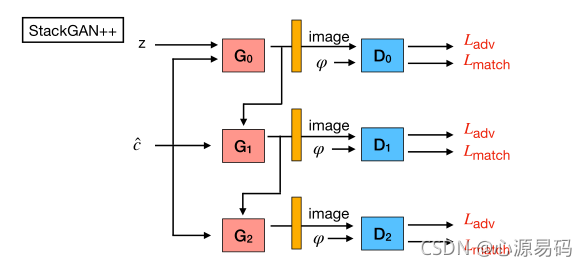

2.2、StackGAN++

StackGAN++将级数提高到了多层,依然是逐级提高分辨率,但采用端到端的方式进行训练。

2.3、其他

FusedGAN、HDGAN、PPGAN、HfGAN,文章中也有介绍,这里暂时不展开。

2.4、创新与不足

改进:把生成高质量图片这个复杂问题,分解成了一些更好控制的子问题;

不足:输入是全局的句子向量,丢失了细粒度的单词级别的信息,即丢失了相应的细节。

3、注意力机制的引入

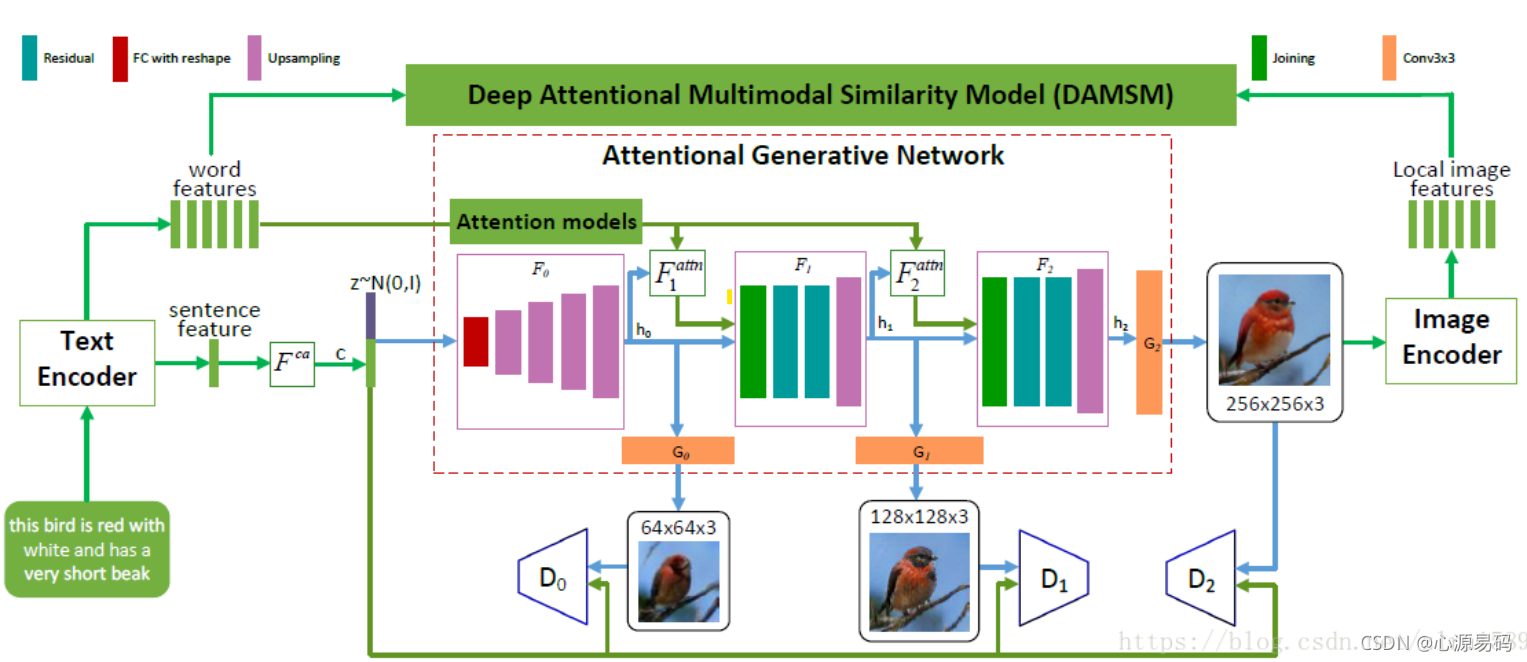

3.1、AttnGAN

AttnGAN是在Stack++GAN进行了延伸,加入了一个attention module来关注自然语言描述中的相关单词,进而合成图像不同子区域的细粒度细节。

w:单词特征 z:噪声 c:CA后的文本

attention module:包括word features和sentence features;

一个具体例子:

3.2、其他

SEGAN、ControlGAN,文章中也有介绍,这里暂时不展开。

3.3、创新

提出了一种注意力集中的多模态相似度模型,以计算出细粒度的图像-文本匹配损失。效果明显提高,在CUB数据集上比之前的最优结果提升14.14%,在更具挑战性的COCO数据集上提高了170.25%。

4、孪生(siamese)网络的引入

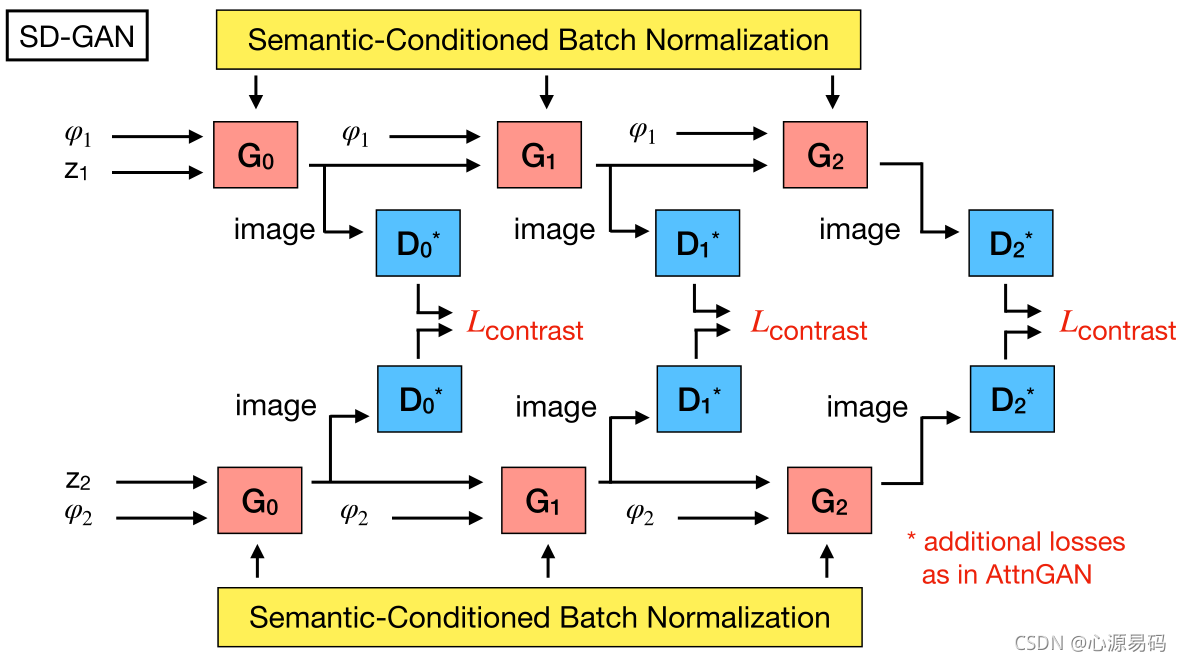

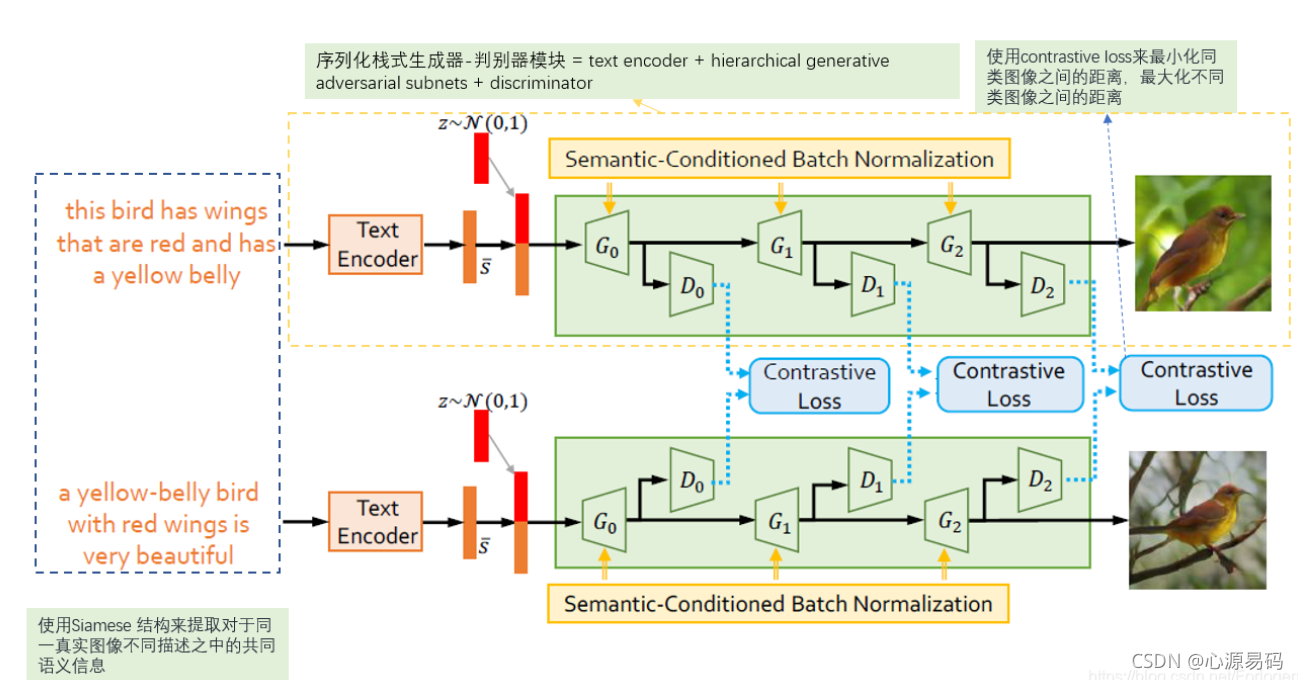

4.1、SD-GAN

SD-GAN的每个分支对不同的输入进行操作,采用对比损失来最小化由同一真实图像的不同描述生成图像的距离,同时最大化不同真实图像的生成图像距离。

简单的来说就是,设置两个并行的GAN,输入相同真实图像的不同文字描述,如果他们两个生成图像差不多则鼓励模型,如果生成的图像相差甚远则抑制。这样既可以提取出语义的一致性部分,又可以保留描述的多样性和细节部分。

举个例子:

4.2、其他

SEGAN、Text-SeGAN:在文章中有介绍,其增加一个与语义相近的真实图像距离处理、增加语义逐渐变难。

4.3、创新

提出了新的思路,而且SDGAN可以对描述文本中小的变化做出相应的改变。

5、循环(cycle)网络的引入

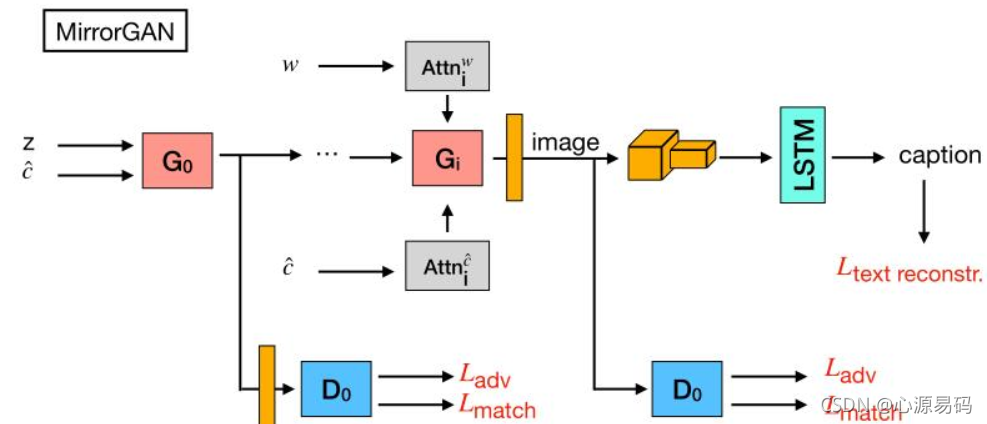

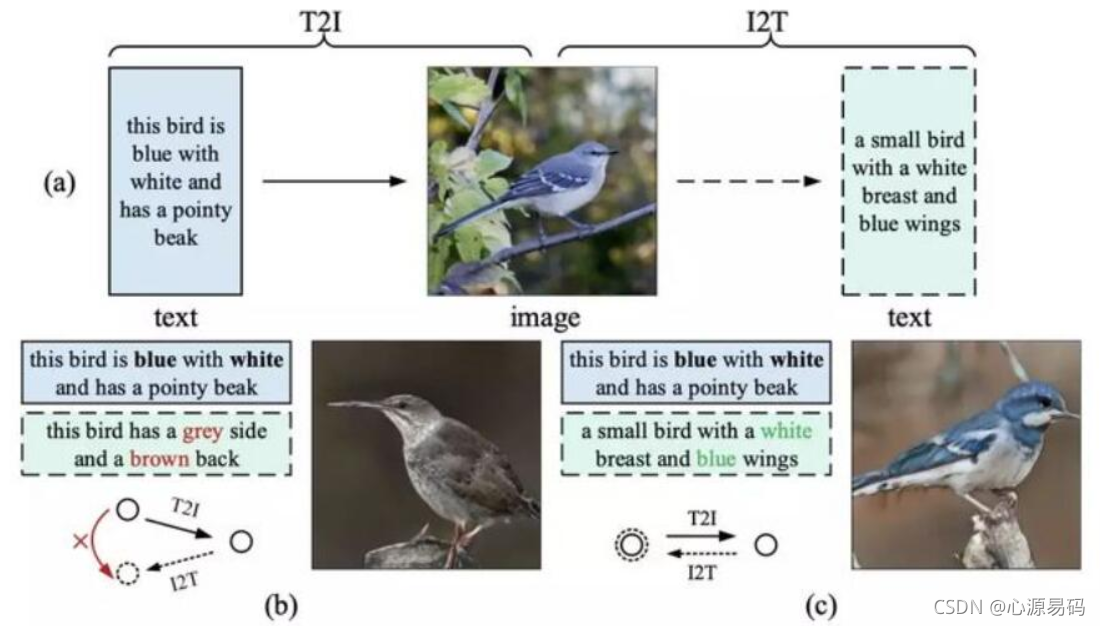

5.1、MirrorGAN

MirrorGAN:才有了循环的架构,使T2I–>I2T–>T2I–>I2T…加入了语义文本再生和对齐模块,以从生成的图像重新生成文本描述,使其在语义上与给定的文本描述对齐。达到文本和图像的语义一致性判别。

简单来说,MirrorGAN先从文本生成图像,然后以生成的图像重新再生成文本,使两次的文本尽可能的靠近。

如果一个模型具有语义一致性,那么从输入文本就应该与文本生成图像再生成的文本一致。

举个例子:

5.2 创新

解决文本和视觉之间语义一致性,COCO 数据集上成绩最佳,生成的高质量图像具有与输入文本描述一致的语义。

6、记忆(memory)网络的引入

6.1、DM-GAN

DM-GAN,添加一个记忆机制,来处理 badly-generated initial images,将初始图像和单词特征作为输入,比较文本和图像特征计算每个单词的重要性,引入一个 memory writing gate 来动态的选择和产生图像相关的单词

6.2、创新

1)提出一个新颖的 GNA model 组合了 dynamic memory component 来产生高质量的图像,即使初始图像很差;

2). 提出一个 memory writing gate 来根据初始图像,选择相关的单词;

3). 提出 response gate 来自适应的融合来自图像和记忆中的信息;

4). 实验结果顶尖;

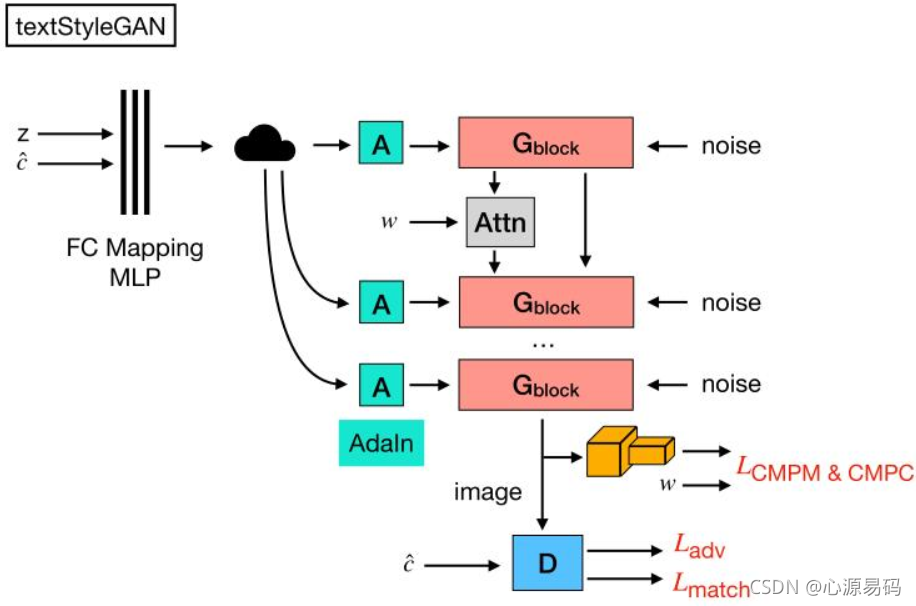

7、无条件模型的引入

7.1、StyleGAN

z:噪声 c:文本特征 w:中间级潜在特征

基于风格驱动,每次加入noise控制风格和潜在语义,即可以生成更加多样化的图像。

7.2、创新

提高了图像的多样性:对高级属性和随机变化(的多样性)方面的分离、中间潜在空间的线性研究增进了我们对GAN的理解和可控性生成。

下一篇:Text to Image综述阅读(1.3)度量标准与未来研究方向 Adversarial Text-to-Image Synthesis: A Review(基于GAN的文本生成图像)