热门标签

热门文章

- 1maven 基础用法 (终端界面和IDEA界面)

- 2【机器学习】详解 BERT_bert 回归

- 3kafka_3.7.0(sasl+acl)+管理工具redpanda_kafka 3.7

- 4Pycharm集成Gitee及使用_pycharm giteee协同

- 5unordered_set

- 6Android service(服务)中的绑定服务(binderService)详解与使用_bindservice

- 7使用org.apache.pdfbox 2.x PDF 转Doc 转图片 转字符串

- 8【NLP | 自然语言处理】BERT Prompt文本分类(含源代码)_promptbert

- 9BT_spec_Core_v4.2_蓝牙物理层的指标_蓝牙deviation和offset

- 10连接mysql数据库出现The last packet sent successfully to the server was 0 milliseconds ago.问题解决方案

当前位置: article > 正文

【python爬虫案例】用python爬豆瓣电影TOP250排行榜!_top250爬虫实例

作者:小丑西瓜9 | 2024-04-26 00:56:22

赞

踩

top250爬虫实例

一、爬虫对象-豆瓣电影TOP250

前几天,我分享了一个python爬虫案例,爬取豆瓣读书TOP250数据:【python爬虫案例】用python爬豆瓣读书TOP250排行榜!

今天,我再分享一期,python爬取豆瓣电影TOP250数据!

爬虫大体流程和豆瓣读书TOP250类似,细节之处见逻辑。

首先,打开豆瓣电影TOP250的页面:https://movie.douban.com/top250

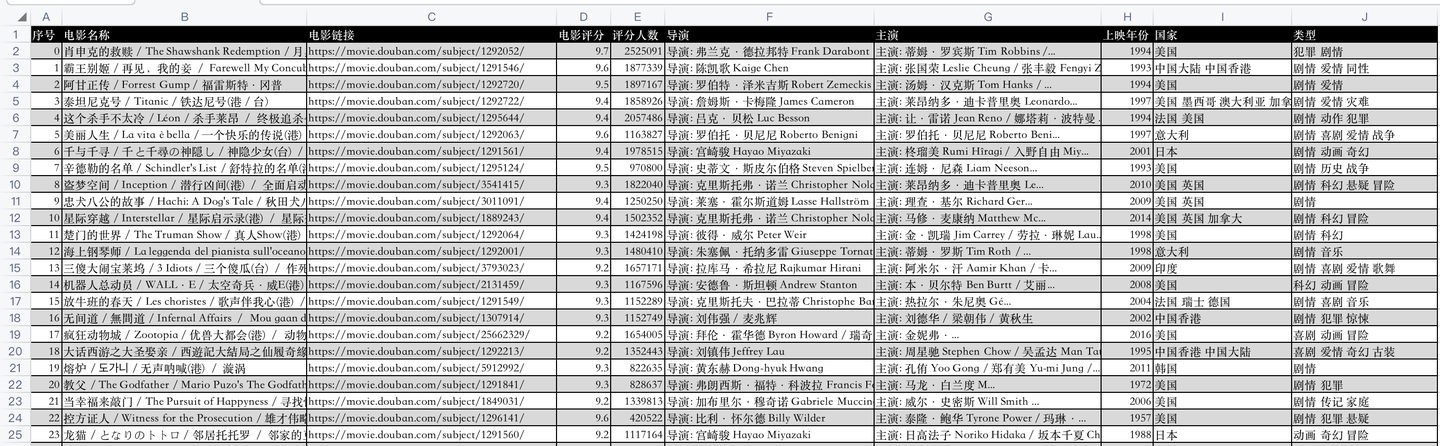

开发好python爬虫代码后,爬取成功后的csv数据,如下:

代码是怎样实现的爬取呢?下面逐一讲解python核心代码。

二、python爬虫代码讲解

首先,导入需要用到的库:

import requests # 发送请求

from bs4 import BeautifulSoup # 解析网页

import pandas as pd # 存取csv

from time import sleep # 等待时间

- 1

- 2

- 3

- 4

然后,向豆瓣电影网页发送请求:

res = requests.get(url, headers=headers)

- 1

利用BeautifulSoup库解析响应页面:

soup = BeautifulSoup(res.text, 'html.parser')

- 1

用BeautifulSoup的select函数,(css解析的方法)编写代码逻辑,部分核心代码:

for movie in soup.select('.item'):

name = movie.select('.hd a')[0].text.replace('\n', '') # 电影名称

movie_name.append(name)

url = movie.select('.hd a')[0]['href'] # 电影链接

movie_url.append(url)

star = movie.select('.rating_num')[0].text # 电影评分

movie_star.append(star)

star_people = movie.select('.star span')[3].text # 评分人数

star_people = star_people.strip().replace('人评价', '')

movie_star_people.append(star_people)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

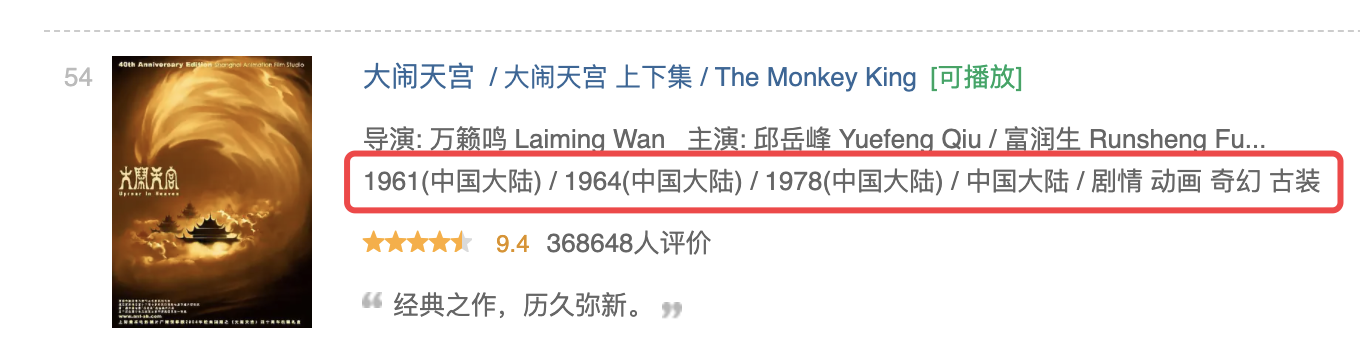

其中,需要说明的是,《大闹天宫》这部电影和其他电影页面排版不同:

它的上映年份有3个(其他电影只有1个上映年份),并且以"/"分隔,正好和国家、电影类型的分割线冲突,

所以,这里特殊处理一下:

if name == '大闹天宫 / 大闹天宫 上下集 / The Monkey King': # 大闹天宫,特殊处理

year0 = movie_infos.split('\n')[1].split('/')[0].strip()

year1 = movie_infos.split('\n')[1].split('/')[1].strip()

year2 = movie_infos.split('\n')[1].split('/')[2].strip()

year = year0 + '/' + year1 + '/' + year2

movie_year.append(year)

country = movie_infos.split('\n')[1].split('/')[3].strip()

movie_country.append(country)

type = movie_infos.split('\n')[1].split('/')[4].strip()

movie_type.append(type)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

最后,将爬取到的数据保存到csv文件中:

def save_to_csv(csv_name): """ 数据保存到csv :return: None """ df = pd.DataFrame() # 初始化一个DataFrame对象 df['电影名称'] = movie_name df['电影链接'] = movie_url df['电影评分'] = movie_star df['评分人数'] = movie_star_people df['导演'] = movie_director df['主演'] = movie_actor df['上映年份'] = movie_year df['国家'] = movie_country df['类型'] = movie_type df.to_csv(csv_name, encoding='utf_8_sig') # 将数据保存到csv文件

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

其中,把各个list赋值为DataFrame的各个列,就把list数据转换为了DataFrame数据,然后直接to_csv保存。

这样,爬取的数据就持久化保存下来了。

三、同步视频

同步讲解视频:【python爬虫】利用python爬虫爬取豆瓣电影TOP250的数据!

四、获取完整源码

附完整源码:【python爬虫案例】利用python爬虫爬取豆瓣电影TOP250的数据!

我是 @马哥python说 ,一名10年程序猿,持续分享python源码干货中!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/488142

推荐阅读

相关标签