- 1物联网数据处理技术课程设计——基于python实现的智能图书馆借阅管理系统(OpenCV+MySQL)_图书管理系统python

- 2码云Gitee 上传代码出现的错误(一)_error: cannot pull with rebase: you have unstaged

- 3Flink:详细的不能再详细的安装步骤(三)[安装步骤]

- 4『现学现忘』Git基础 — 36、标签tag(一)_python git tag

- 5什么是PSD(功率谱密度)_psd谱

- 6重装操作系统win10+重装sqlserver+数据库可视化工具_sql server可视化工具

- 7TransE模型的简单介绍&TransE模型的python代码实现

- 8微信小程序自定义tabbar导航栏,中间凸出样式_微信小程序底部tab栏特殊样式

- 9程序员如何通过被动收入实现“暴富”_程序员 被动收入

- 10ChatGPT爆火网络背后的故事?_chatgpt 故事背景

AIGC|OpenAI文生视频大模型Sora技术拆解(含全网资料汇总)

赞

踩

OpenAI出手就是王炸!!2月16日,OpenAI 正式发布其首个文生视频模型 Sora,继 Runway、Pika、谷歌和 Meta 之后,OpenAI 终于加入视频生成领域的战争,无疑是对全球AI视频 Startups 的一次降维打击!

它有多震撼呢?这么说吧,上一次这么疯狂的刷屏可能还是人类第一次见到ChatGPT的时候。

可以用三个词来总结:“60s超长长度”、“单视频多角度镜头”和“世界模型”!!

官方地址:

https://openai.com/sora

技术报告:

https://openai.com/research/video-generation-models-as-world-simulators

何为Sora

Sora是OpenAI最新发布的其首个文生视频大模型,引起全网疯狂刷屏!其强大之处,不仅可以生成长达一分钟的视频,还实现了视频画质的跨越式提升!在可变持续时间、分辨率和纵横比的视频和图像上联合训练文本条件扩散模型。

Sora 是一种扩散模型,它从看起来像静态噪声的视频开始生成视频,然后通过多个步骤消除噪声来逐渐转换视频。Sora 能够一次生成整个视频或扩展生成的视频以使其更长。通过让模型一次看到许多帧,解决了一个具有挑战性的问题,即确保一个主题即使暂时离开视野也能保持不变。

与 GPT 模型类似,Sora 使用 transformer 架构,释放出卓越的扩展性能。将视频和图像表示为称为Patches的较小数据单元的集合,每个Patches都类似于 GPT 中的一个tokens。通过统一表示数据的方式,可以在比以前更广泛的视觉数据上训练扩散transformers,跨越不同的持续时间、分辨率和纵横比。

Sora建立在DALL·E 和 GPT 模型。它使用了 DALL·E 3,涉及为视觉训练数据生成高度描述性的标题。因此,该模型能够更忠实地遵循生成视频中用户的文本说明。

OpenAI 的真正强大在于要实现AGI,做 World Simulators(世界模拟器),帮助人们解决需要现实世界交互的问题。

效果如何

60s超长视频

完美碾压RunwayGen2和pika1.0,Sora直接把生成视频的时长拉长到了1分钟!

提示:一位时尚的女人走在东京的街道上,街道上到处都是温暖的发光霓虹灯和动画城市标志。她身穿黑色皮夹克,红色长裙,黑色靴子,背着一个黑色钱包。她戴着墨镜,涂着红色口红。她自信而随意地走路。街道潮湿而反光,营造出五颜六色的灯光的镜面效果。许多行人四处走动。

单视频多角度镜头

Prompt: A movie trailer featuring the adventures of the 30 year old space man wearing a red wool knitted motorcycle helmet, blue sky, salt

提示:电影预告片,讲述了 30 岁的太空人戴着红色羊毛针织摩托车头盔的冒险经历,蓝天,盐沙漠,电影风格,用 35 毫米胶片拍摄,色彩鲜艳。

与现实世界的物理关系

提示词中的轮胎扬起的尘土,是在汽车后面。

提示:镜头跟随一辆带有黑色车顶行李架的白色老式 SUV 在陡峭的山坡上被松树包围的陡峭土路上加速,轮胎上扬起灰尘,阳光照在 SUV 上,因为它沿着土路飞驰,为场景投下温暖的光芒。土路缓缓蜿蜒向远处,看不到其他汽车或车辆。道路两旁的树木都是红杉,到处都是绿色植物。从后方可以看到这辆车可以轻松地沿着弯道行驶,看起来好像是在崎岖的地形上崎岖不平地行驶。土路本身被陡峭的丘陵和山脉所环绕,上面是湛蓝的天空和轻薄的云彩

复杂的场景

Prompt: A Chinese Lunar New Year celebration video with Chinese Dragon.

提示:中国龙的中国农历新年庆祝视频。

精致的细节

提示:一个60多岁留着胡子的白发男子的特写镜头,他坐在巴黎的一家咖啡馆里,沉思着宇宙的历史,当人们走着的时候,他的眼睛聚焦在屏幕外的人身上,他几乎一动不动地坐着,他穿着羊毛外套西装外套和纽扣衬衫,戴着棕色贝雷帽和眼镜,看起来很有教授风范,最后,他微微一笑,仿佛找到了生命之谜的答案,灯光非常像电影,背景是金色的灯光和巴黎的街道和城市,景深,35毫米电影胶片。

同时存在缺陷,不完美的效果

目前,Sora在视频生成过程中也存在着一些缺陷,比如复杂环境中的物理效果,因果关系,空间和时间上推理上。

- 有时会产生身体上难以置信的动作

Prompt: Step-printing scene of a person running, cinematic film shot in 35mm.

提示:一个人奔跑的步印场景,以 35 毫米拍摄的电影胶片。

- 动物或人可以自发出现,尤其是在包含许多实体的场景中

Prompt: Five gray wolf pups frolicking and chasing each other around a remote gravel road, surrounded by grass. The pups run and leap, chasing each other, and nipping at each other, playing. 提示:五只灰狼幼崽在一条偏远的碎石路上嬉戏和追逐,周围环绕着草地。幼崽们奔跑跳跃,互相追逐,互相啃咬,玩耍。

- 不准确的物理建模和非自然物体“变形”的例子

Prompt: Basketball through hoop then explodes.

提示:篮球穿过篮筐然后爆炸。

- 未能将椅子建模为一个刚性物体,导致不准确的物理交互

Prompt: Archeologists discover a generic plastic chair in the desert, excavating and dusting it with great care.

提示:考古学家在沙漠中发现了一把普通的塑料椅子,正在仔细挖掘和除尘。

- 模拟对象和多个角色之间的复杂交互对模型来说通常具有挑战性,有时会导致幽默的生成

提示:一位头发梳得整整齐齐的祖母站在木制餐桌旁的五颜六色的生日蛋糕后面,上面摆放着许多蜡烛,表情是纯粹的喜悦和幸福,她的眼睛里闪耀着幸福的光芒。她身体前倾,轻轻地吹灭蜡烛,蛋糕上有粉红色的糖霜和洒水,蜡烛不再闪烁,祖母穿着一件装饰着花卉图案的浅蓝色衬衫,可以看到坐在桌子旁的几个快乐的朋友和家人在庆祝,失焦。这个场景被精美地捕捉,电影般的,显示了祖母和餐厅的 3/4 视图。温暖的色调和柔和的灯光增强了气氛。

与其他主流视频生成模型的比较

图片来源:

https://twitter.com/i/status/1758282791547232482

Sora背后的底层技术

Sora 是一种通用的视觉数据模型,它可以生成跨越不同持续时间、纵横比和分辨率的视频和图像,最多可生成一整分钟的高清视频。总结来说:扩散模型、Transformer架构,是一种“扩散Transformer”。

在OpenAI发布的技术细节中,提到以下6个方面:

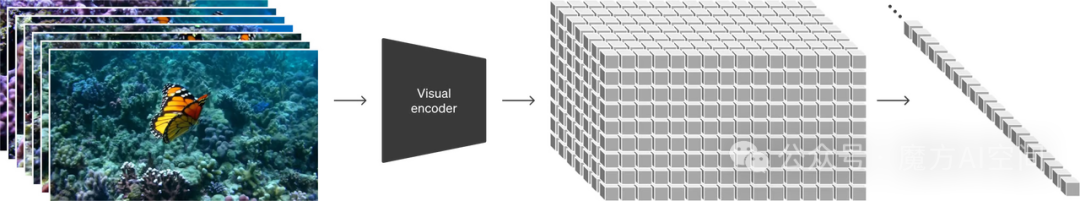

1、将可视化数据转换为Patches

从大型语言模型中汲取灵感,这些模型通过对互联网规模的数据进行训练来获得通才功能。但不同于大语言模型的“Tokens”,Sora采用视觉“Patches”,一种高度可扩展且有效的表示,用于在不同类型的视频和图像上训练生成模型。

在高层次上,首先将视频压缩为低维潜在空间,然后将表示分解为时空“Patches”,从而将视频转换为“Patches”。

2、视频压缩网络

训练一个网络,可以降低视觉数据的维度。该网络将原始视频作为输入,并输出在时间和空间上都经过压缩的潜在表示。

Sora在这个压缩的潜在空间中接受训练并随后生成视频。还训练了一个相应的解码器模型,该模型将生成的潜在对象映射回像素空间。

3、时空潜在Patches

给定一个压缩的输入视频,提取一系列时空Patches,这些Patches充当transformer tokens。此方案也适用于图像,因为图像只是单帧视频。

基于Patches的表示使 Sora 能够对可变分辨率、持续时间和纵横比的视频和图像进行训练。在推理时,可以通过在适当大小的网格中排列随机初始化的Patches来控制生成的视频的大小。

4、扩展 transformers 用于视频生成

Sora 是一个扩散模型。给定输入的噪声Patches(以及文本提示等条件信息),它被训练来预测原始的“干净”Patches。重要的是,Sora是一个扩散Transformers。Transformer 在语言建模、计算机视觉和图像生成等多个领域都表现出了显著的缩放特性。

5、可变持续时间、分辨率、纵横比

采样灵活性

Sora 可以对宽屏 1920x1080p 视频、垂直 1080x1920 视频以及介于两者之间的所有视频进行采样。这使 Sora 可以直接以原始纵横比为不同设备创建内容。它还能够在以全分辨率生成之前以较小的尺寸快速制作内容原型,所有这些都使用相同的模型。

改进的取景和构图

根据经验发现,以原始纵横比对视频进行训练可以改善构图和取景。将 Sora 与模型的一个版本进行了比较,该模型将所有训练视频裁剪为正方形,这是训练生成模型时的常见做法。在方形裁剪上训练的模型(左)有时会生成视频,其中主体仅部分可见。相比之下,Sora(右)的视频改善了取景。

6、语言理解

训练文本到视频生成系统需要大量带有相应文本标题的视频。OpenAI应用DALL·E 3到视频。首先训练一个高度描述性的字幕器模型,然后使用它为训练集中的所有视频生成文本字幕。发现对高度描述性视频字幕的培训可以提高文本保真度以及视频的整体质量。

与DALL·E 3,还利用 GPT 将简短的用户提示转换为更长的详细字幕,然后发送到视频模型。这使 Sora 能够准确遵循用户提示生成高质量的视频。

汇总Sora全网优秀技术拆解

1、周鸿祎谈视频模型Sora:AGI实现不远了,中美AI差距将进一步拉大

最近,OpenAI发布的视频模型Sora,再次点燃了全球科技界的激情。360董事长周鸿祎对此发表了自己的看法,他认为,Sora的出现预示着通用人工智能(AGI)的实现可能已经不远,而中美在AI领域的竞争差距,可能会进一步拉大。

公众号:前沿科技学习分享圈周鸿祎谈视频模型Sora:AGI实现不远了,中美AI差距将进一步拉大

2、OpenAI 的 Sora 技术报告详解

Sora 详细的技术报告发布了,相关从业者可能都需要看看。里面有 Open AI的训练思路以及 Sora 详细的技术特性,我从里面找了一些要点,详细的可以去看完整内容。简单来说 Sora 的训练量足够大也产生了类似涌现的能力。

知白,公众号:白话AI编程OpenAI 的 Sora 技术报告详解

3、OpenAI首个AI视频模型炸裂登场,彻底端掉行业饭碗!60秒一镜到底惊人,世界模型真来了?

Runway Gen 2、Pika等AI视频工具,都还在突破几秒内的连贯性,而OpenAI,已经达到了史诗级的纪录。60秒的一镜到底,视频中的女主角、背景人物,都达到了惊人的一致性,各种镜头随意切换,人物都是保持了神一般的稳定性。

4、OpenAI 大杀四方,Sora 彻底革了视频的命

OpenAI 发布了全新的 Sora 以其极强的视频生成之力大杀四方,看着 OpenAI 官方发布的各种视频效果,真的太震撼了!Sora 一出,现有的视频生成顿时黯然失色。行走在大模型前线的周鸿祎就评价「Sora 意味着 AGI 实现将从 10 年缩短到 1 年」。

智能之境,公众号:CSDNOpenAI 大杀四方,Sora 彻底革了视频的命

5、48个文生视频+技术报告,揭秘OpenAI最强视频GPT

相比以往的视频模型,Sora的亮点非常明显,不仅对文本理解更深刻,可以准确地呈现提示词,而且能在一个生成的视频中创建多个镜头,准确地保留角色和视觉风格。

ZeR0,公众号:智东西48个文生视频+技术报告,揭秘OpenAI最强视频GPT

本文内容由网友自发贡献,转载请注明出处:【wpsshop博客】

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。