热门标签

热门文章

- 1Docker-13:Docker安装Hbase

- 2关于快速排序算法的学习心得_排序实验实训总结

- 3OceanBase 分布式数据库【信创/国产化】- OceanBase 数据库整体架构

- 4RK3588 & Android12 调试 RTL8852BE(wifi篇)_rk8852be

- 5VHDL实现数字频率计的设计_数字频率计设计vhdl

- 6基于SSM的文化遗产的保护与旅游开发系统(有报告)。Javaee项目。ssm项目。

- 7讲真,做Python一定不要只会一个方向!

- 8PC电脑 VMware安装的linux CentOs7如何扩容磁盘?_linux虚拟机安装好之后还能设置磁盘大小码

- 9机器学习介绍_setlabelcol

- 10Cesium 核心概念 核心接口_cesuim可以实现的功能

当前位置: article > 正文

增量预训练baichuan-13b-chat遇到的那些坑_百川13b需要多少显存

作者:小丑西瓜9 | 2024-05-16 05:34:35

赞

踩

百川13b需要多少显存

前言

资源

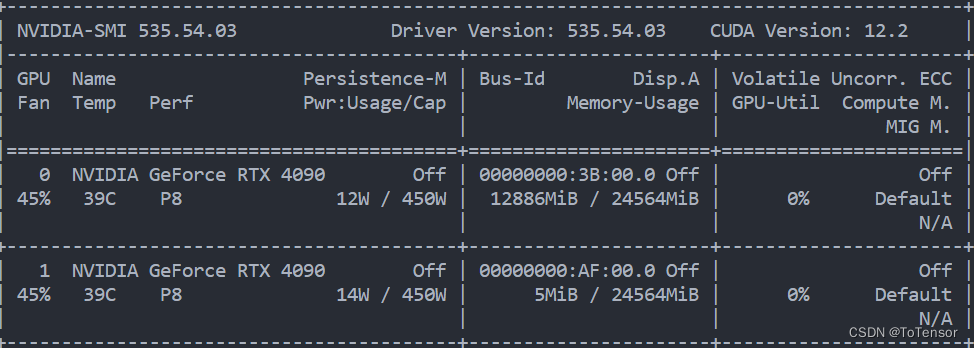

单机两4090,如图

单卡24G,baichuan-13b-chat单卡推理需要至少26G,因此仅用一张卡,我们是无法加载百川13B的模型,所以,无论是推理还是训练,我们都必须并行!

deepspeed

核心思想:GPU显存不够,CPU内存来凑

虽然我们两张卡加起来有48G,按理说显存是足够的,实则不是。

就两张卡而言,分别为GPU0和GPU1,两块GPU上分别有一半模型参数,即6.5B,占用13G,在使用

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/577167

推荐阅读

相关标签