热门标签

热门文章

- 1前端数据加密(Base64、MD5、AES、RSA)_前端加密

- 2android gatt阻塞,android – 更改蓝牙低能量gatt超时或刷新读取流以更快地检测断开连接事件...

- 3一个优秀的可定制化Flutter相册组件,看这一篇就够了

- 4【jQuery知识点整理】(复习第五天)_jqueryid选择器正确用法

- 5随机游走笔记(一)

- 6BI软件之Tableau学习心得之一——基础入门_tableau心得体会

- 7SpringBoot实现第三方QQ登录_springboot3实现qq登录

- 82分钟搭建FastGPT训练企业知识库AI助理(Docker部署)_fastgpt 宝塔怎么安装

- 9【yolov8&yolov5驾驶员抽烟-打电话-喝水-吃东西检测&疲劳驾驶检测&分心驾驶检测】_yolov8 吃东西算法

- 10AI综述专栏 | 多模态学习研究进展综述_朱文武论文情感识别

当前位置: article > 正文

【AI实战】基于 bert-base-chinese 预训练模型的多标签文本分类模型,BCEWithLogLoss解决样本不均衡问题_bert-base-chinese情感多标签

作者:小丑西瓜9 | 2024-05-17 08:22:03

赞

踩

bert-base-chinese情感多标签

多标签文本多分类

-

文本分类

文本分类用电脑对文本集(或其他实体或物件)按照一定的分类体系或标准进行自动分类标记。 它根据一个已经被标注的训练文档集合, 找到文档特征和文档类别之间的关系模型, 然后利用这种学习得到的关系模型对 新的文档进行类别判断 。 -

其应用场景众多,包括:

情感分析(Sentiment Analyse)

主题分类(Topic Labeling)

问答任务(Question Answering)

意图识别(Dialog Act Classification)

自然语言推理(Natural Language Inference) -

多标签分类

多标签分类是样本可以同时属于多个类别(或者标签)、类别间可以相互重叠的模式识别问题,其特殊性主要体现在样本到标签的一对多映射关系和标签间的相关性。如文本可能同时涉及任何宗教,政治,金融或教育,也可能不属于任何一种。

bert-base-chinese 预训练模型

bert-base-chinese

This model has been pre-trained for Chinese, training and random input masking has been applied independently to word pieces (as in the original BERT paper).

- Developed by: HuggingFace team

- Model Type: Fill-Mask

- Language(s): Chinese

- License: [More Information needed]

- Parent Model: See the BERT base uncased model for more information about the BERT base model.

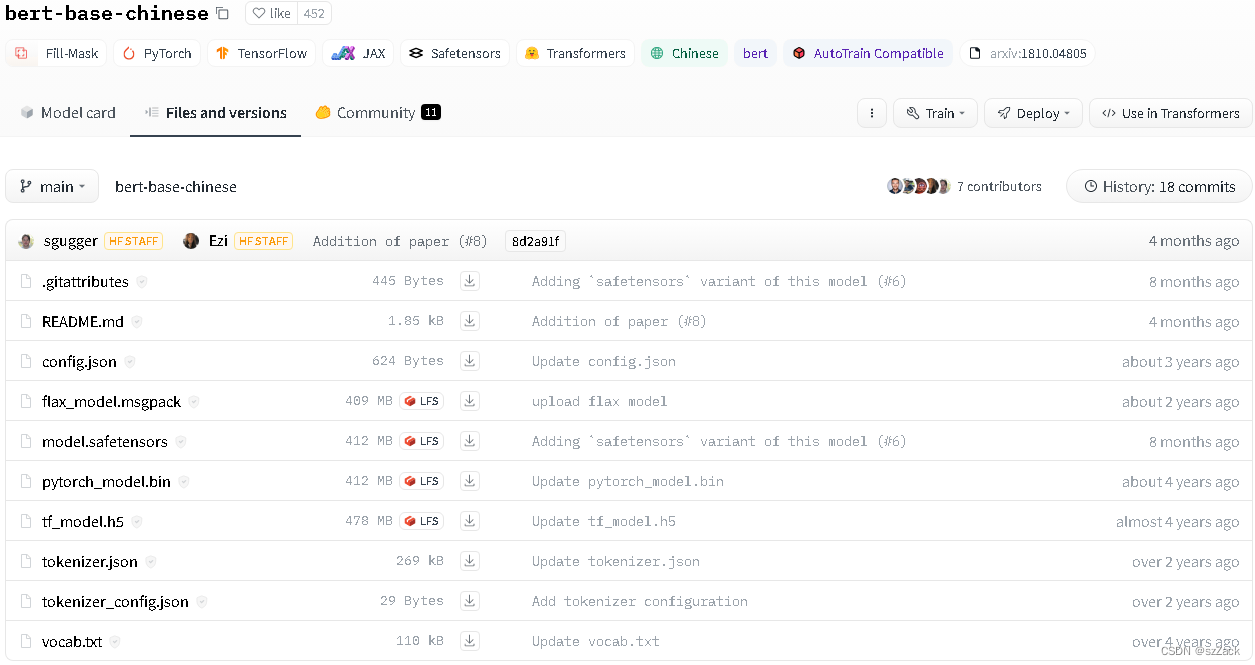

模型地址

https://huggingface.co/bert-base-chinese

模型拉取

git clone https://huggingface.co/bert-base-chinese

- 1

样本不均衡问题

解决样本不均衡问题方法

- 1.数据过采样、欠采样

对样本数量特别少的类别进行过采样;

对样本数量特别多的类别进行欠采样;

对样本数量较少的类别借助其他文本生成模型进行数据生成; - 2.修改loss函数

使用 focus loss 代替 交叉熵损失函数 Cross entropy loss

使用 GHM 代替 交叉熵损失函数 Cross entropy loss

多标签分类时,使用 BCE Loss 代替 交叉熵损失函数 Cross entropy loss; - 3.数据过采样 + loss修改

结合方法1 和方法2

BCEWithLogLoss解决样本不均衡问题

1.对样本数量特别少的类别进行过采样

比如我对样本数量少的声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/582729

推荐阅读

相关标签