- 1Android Studio音乐播放器(使用sqlite创建数据库)_音乐播放器android studio

- 2Java NIO编程实例_java nio编程案例

- 3全网首发亲测有用:python免费将chatgpt机器人接入个人微信(同时支持钉钉、QQ 以及别的语言模型如文心一言等)_chatgpt怎么接入微信

- 4逻辑回归——牛顿法矩阵实现方式

- 5[ELK实战] Elasticsearch 聚合查询二: Bucketing/桶聚合_elk es查询时间查询

- 6辅警考试怎么搜题答案?八个受欢迎的搜题分享了 #学习方法#学习方法#媒体_千鸟搜题

- 7最优化算法之粒子群算法PSO_粒子群算法是谁提出的

- 8H3C SSH远程登录配置_h3c ssh配置

- 9第23篇 Android Studio第一个程序HelloWorld_android studio 4.2.2 helloworld

- 10Ubuntu20.04安装微信等软件全过程_ubantu20.04 安装微信

超级干货,自学AI绘画stable diffusion,看完这篇就够了!_sd模型下载

赞

踩

上一期我们讲解了stable diffusion的安装部署,这期我们要讲一讲它的一些实用插件、模型下载、提示词等。

1、sd提示词怎么写

提示词之间要用英文逗号隔开

提示词之间是可以换行的

正向提示词例如:

主体描述:一个女孩,长卷发,头发散开,五官精致,纤瘦。

场景描述:山顶的寺庙,山,水,树,云,太阳,天。

风格描述:中国风,禅意,浪漫主义。

画面需求描述(常规提示词,可通用):柔和的光线,8k质量,超级详细,伟大的杰作,壁纸,生动的色彩,逼真,美丽,好看。

补充描述:正常的的手指,完美的五官。

反向提示词:

常规提示词:

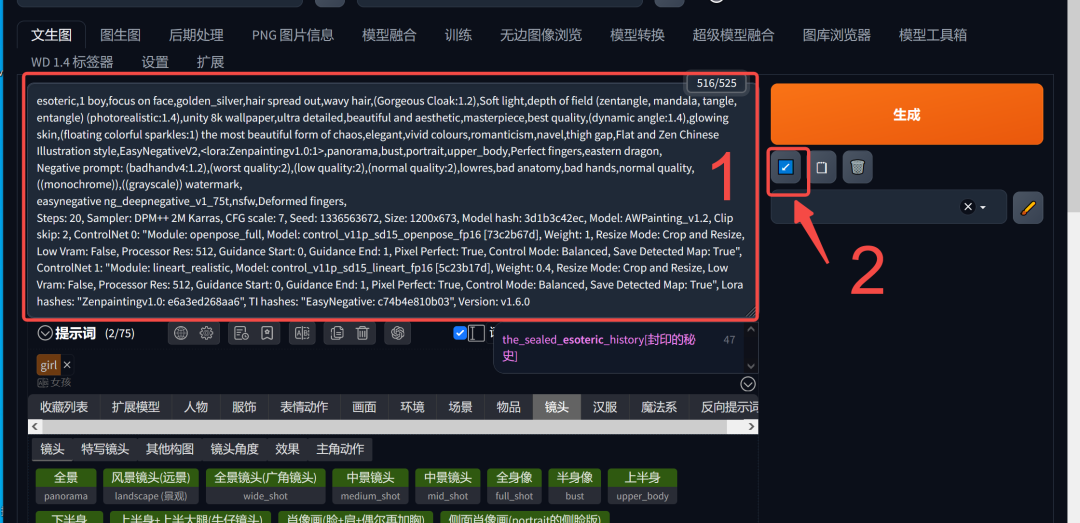

(badhandv4:1.2),(worst quality:2),(low quality:2),(normal quality:2),lowres,bad anatomy,bad hands,normal quality,((monochrome)),((grayscale)) watermark, easynegative ng_deepnegative_v1_75t,nsfw,

上面主要说的是一些质量差,丑,颜色单一之类的, 通用反向提示词,这个可以直接拿去用就行。

基于画面的需求进行详细反向描述:

例如这次的主体是人:畸形的手指,丑陋的五官,丑的。

*左图没写反向提示词的,右图增加了反向提示词的

提示词的权重:

提示词默认权重为1,如果你不进行权重的调整的话越靠前的提示词权重越高,但是如果你需要突出画面中某个元素,或者某个元素AI没有给你生成出来的话,就需要提高这个描述词的权重来突出这个内容。

加权重有两种方式:

1.加括号(), 增加一个括号就增加0.1的权重, (美丽的)就是1.1的权重,((美丽的))就是1.2的权重。

2.加括号和冒号( : ),例如:(美丽的:1.5),就是1.5的权重。

比如我想要画面里有花,但是因为描述词比较多, 花的权重没有突出,ai就可能自己取舍或者没有很明显的花,这时候我们就增加花的权重, 让花在画面里的比例更大。

下方左图提示词:

a girl, with long curly hair, loose hair, delicate facial features, and slender features, (Temple on the mountaintop:1.5), mountains, water, trees, clouds, sun, sky,flowerChinese style, Zen, Romanticism Soft lighting, 8k quality, super detailed, great masterpiece, wallpaper, vivid colors, realistic, beautiful, and good-looking

下方右图提示词:

a girl, with long curly hair, loose hair, delicate facial features, and slender features, (Temple on the mountaintop:1.5), mountains, water, trees, clouds, sun, sky,(flower:2)Chinese style, Zen, Romanticism Soft lighting, 8k quality, super detailed, great masterpiece, wallpaper, vivid colors, realistic, beautiful, and good-looking

2、sd模型下载

常用模型下载网址:

https://civitai.com/

https://huggingface.co/

模型分为:

基础模型(大模型)

VAE模型(滤镜)

control net模型(插件辅助模型)

Lora模型(基于基础模型的风格调整模型)

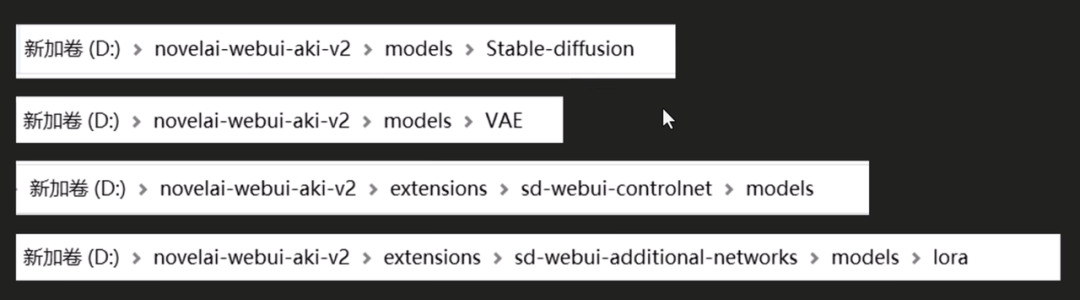

模型安装位置:

模型放置位置记得要放一张相同同命名模型效果图片,这样stable diffusion就会识别到,展示的时候会展示这个图片,能快速找到需要的模型,没有放图片的话就会像第一个这样,显示图片缺失,要靠看下面的模型名称来分辨模型的作用。

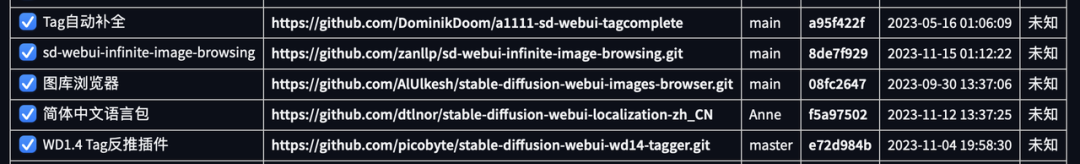

3、sd实用插件

插件安装方法+地址:

一、Tag自动补全: (插件下载请看文末扫描获取)

词库, 输入中文后会跳出适合AI理解的英文选项。

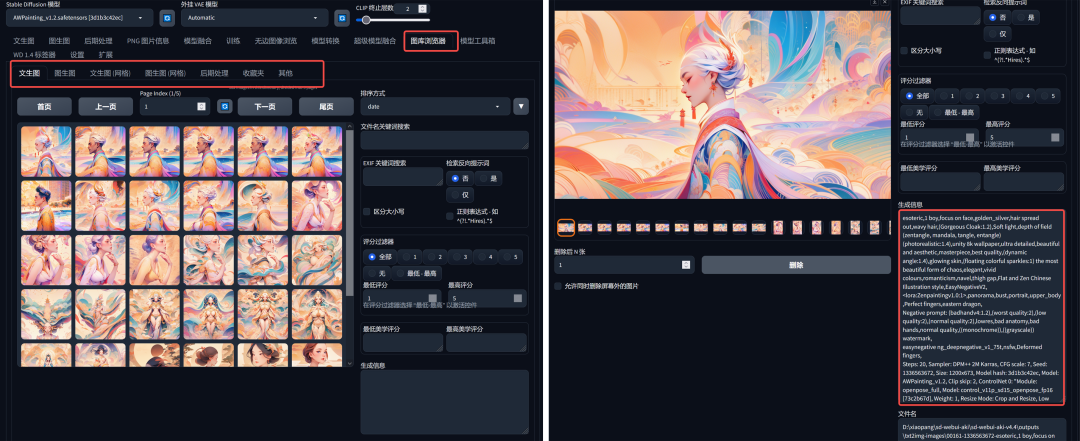

二、图库浏览器: (插件下载请看文末扫描获取)

1.存留自己往期生成过的效果图,并保留该效果图的生成参数(模型,lore,迭代步数,采样,宽高等都会保留,插件数据不会保留),把图片信息完全复制到正向提示里,然后点击生成底部的箭头,这张图片的所有参数就会自己匹配到相应的位置。

2.对图片进行评级,便于后期筛选。

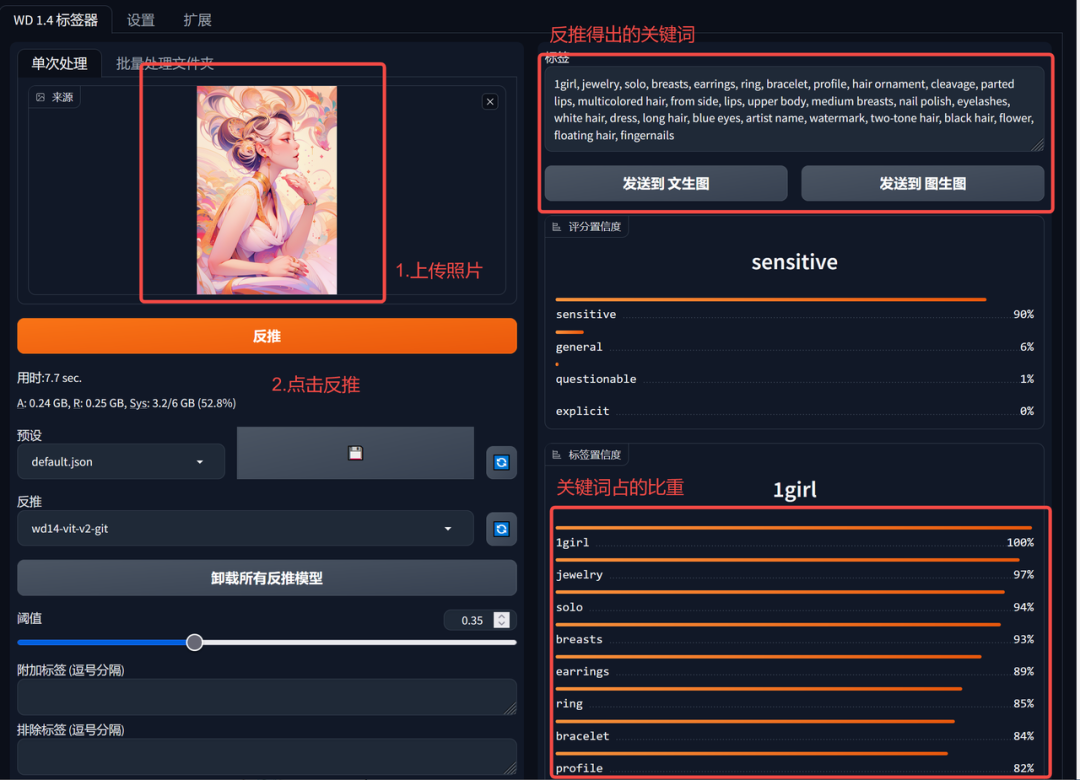

三、WD1.4 Tag反推插件: (插件下载请看文末扫描获取)

把图片给到AI,AI反推完成后记得点击卸载所有反推模型,不然会占内存。

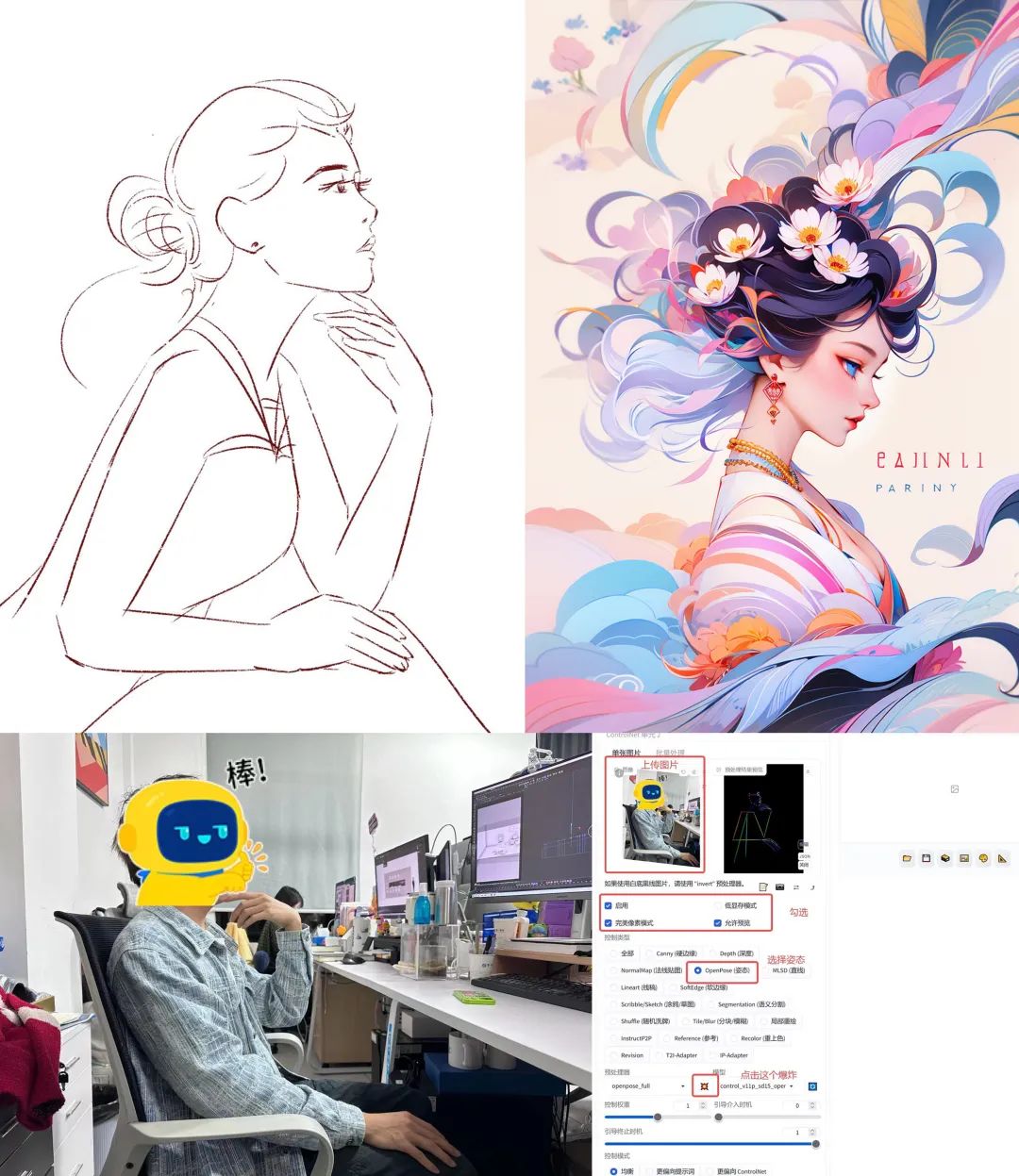

给反推插件的图像

选用同款模型后,直接用反推的关键词生成的结果

加入一个动作要求,生成的结果(结合ControlNet )

四.sd-webui-prompt-all-in-one (插件下载请看文末获取)

4、Control Net插件讲解

一、控制网络(ControlNet插件):

https://github.com/Mikubill/sd-webui-controlnet

(如无法下载,请看文末扫描获取安装包文件)

Sd生成图片图片的三个要素:描述、模型、controlnet

二、Control Net有什么用?

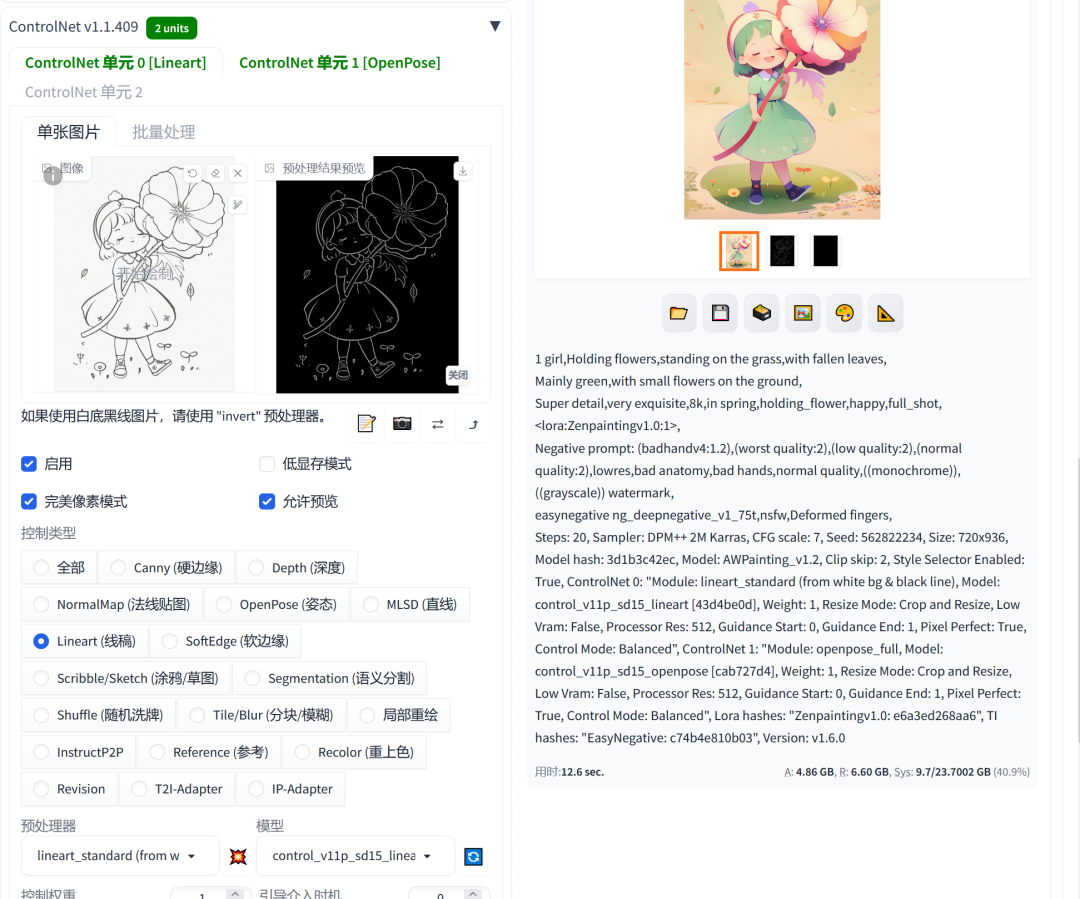

1.线稿上色

2.小色稿-成稿

3.照片动作提取

4.线稿提取

1.线稿-上色(文生图)

首先准备一个线稿(干净一点的,因为sd不知道你什么线是要的,什么是不要的)。

2.小色稿-成稿(图生图)

要用没有线条或者同色系线条的小色稿来进行生成效果会更好

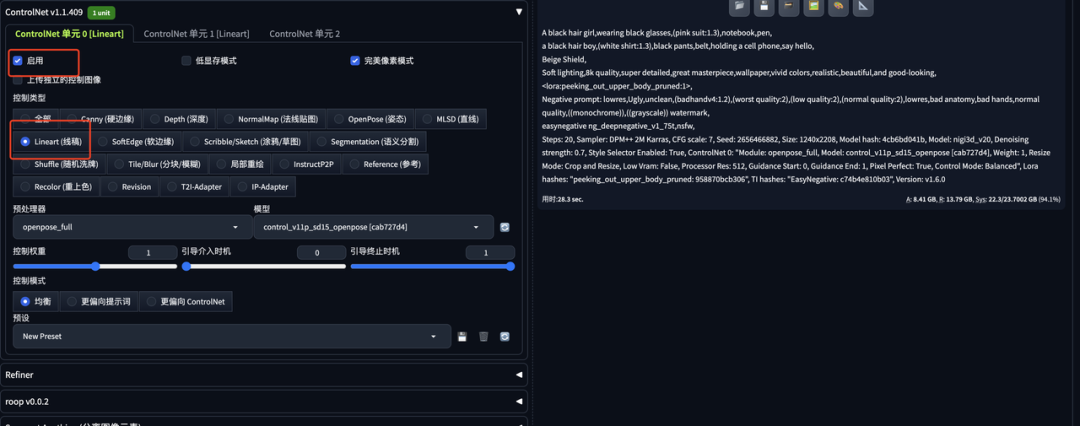

3.动作提取

根据具体需求绘制一个草图;

确定风格(找模型和Lora),直接对着sd说自己要的内容,输入关键词生成的结果;

点击编辑,调整一下动作,让它更像草图;

加入一个动作要求,生成的结果(结合ControlNet );

调整动作结构图+换一个模型得到的结果(需要锁定种子)。

4.线稿提取

写在最后

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

若有侵权,请联系删除