- 1快速入门Win+R命令(附图)_win r

- 2入门篇:如何快速安装和破解Confluence, 打造您的完美知识库_confluence安装

- 3Python实现新年快乐的效果_python新年快乐代码

- 4人工智能、机器学习、深度学习和神经网络的关系_人工智能 机器学习 神经网络 关系

- 5linux java setting,setting java_home and path environmental variables in linux [duplicate]

- 6抓包工具:Fiddler下载、安装、使用 教程

- 7字符集编码转换--MFC_mfc判断char字符串编码

- 8tf.keras 11: 时间序列预测之LSTM天气预测_lstm预测未来多天数据

- 9VS + QT安装及配置开发环境_vs+qt

- 10嵩天python语言程序设计Python123_python编程:如果输入值大于0,以两个字符一行方式输出"hello world"(空格也是字符)

深度学习:使用UNet做图像语义分割,训练自己制作的数据集并推理测试(详细图文教程)_图像分割训练自己的数据集

赞

踩

语义分割(Semantic Segmentation)是图像处理和机器视觉一个重要分支。与分类任务不同,语义分割需要判断图像每个像素点的类别,进行精确分割。语义分割目前在自动驾驶、自动抠图、医疗影像等领域有着比较广泛的应用。我总结了使用UNet网络做图像语义分割的方法,教程很详细,学者耐心学习。

一、 源码包下载

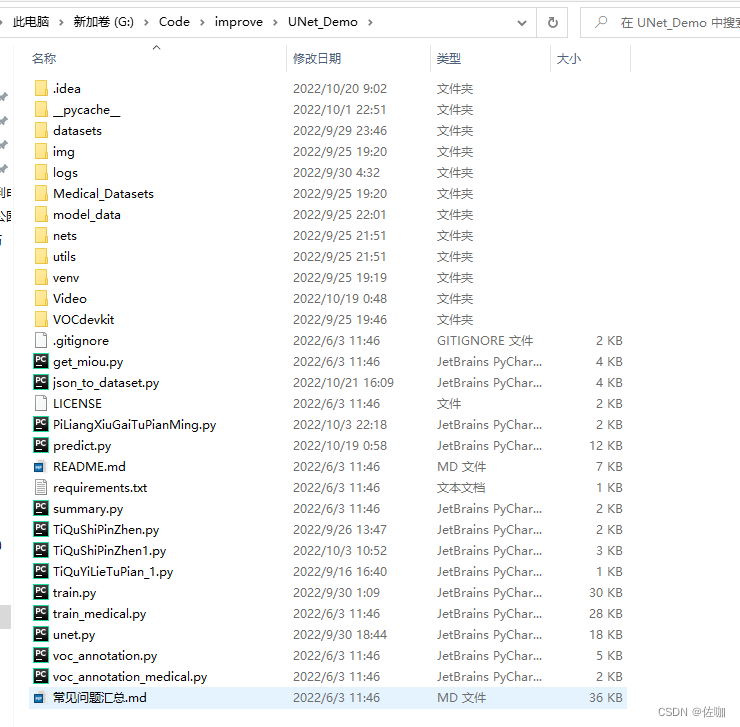

配套教程的源码包,下载方法为文章末扫码到公众号中回复关键字:语义分割UNet。获取下载链接。当然官网也给了源码包,官网下载链接为:官网。学者也可以下载官网提供的,建议学者直接下载我提供的学习,我已经补了一些坑,添加过一些实用代码。下载好我提供的源码包,解压后的样纸见下:

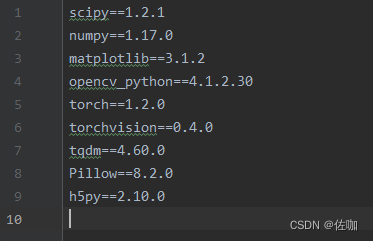

二、安装训练必要的库文件

Python的版本选用3.7或者3.8都可以。

三、 准备数据集

3.1 打标签

数据集的准备,看学者自己个人想要识别什么物体,自行准备即可。我提供的源码包中有我自己喷血已经打好标签的数据集,打标签需要用到的工具叫作labelme,关于labelme工具的具体使用教程,学者看我的另外一篇博客,链接为:Labelme使用教程

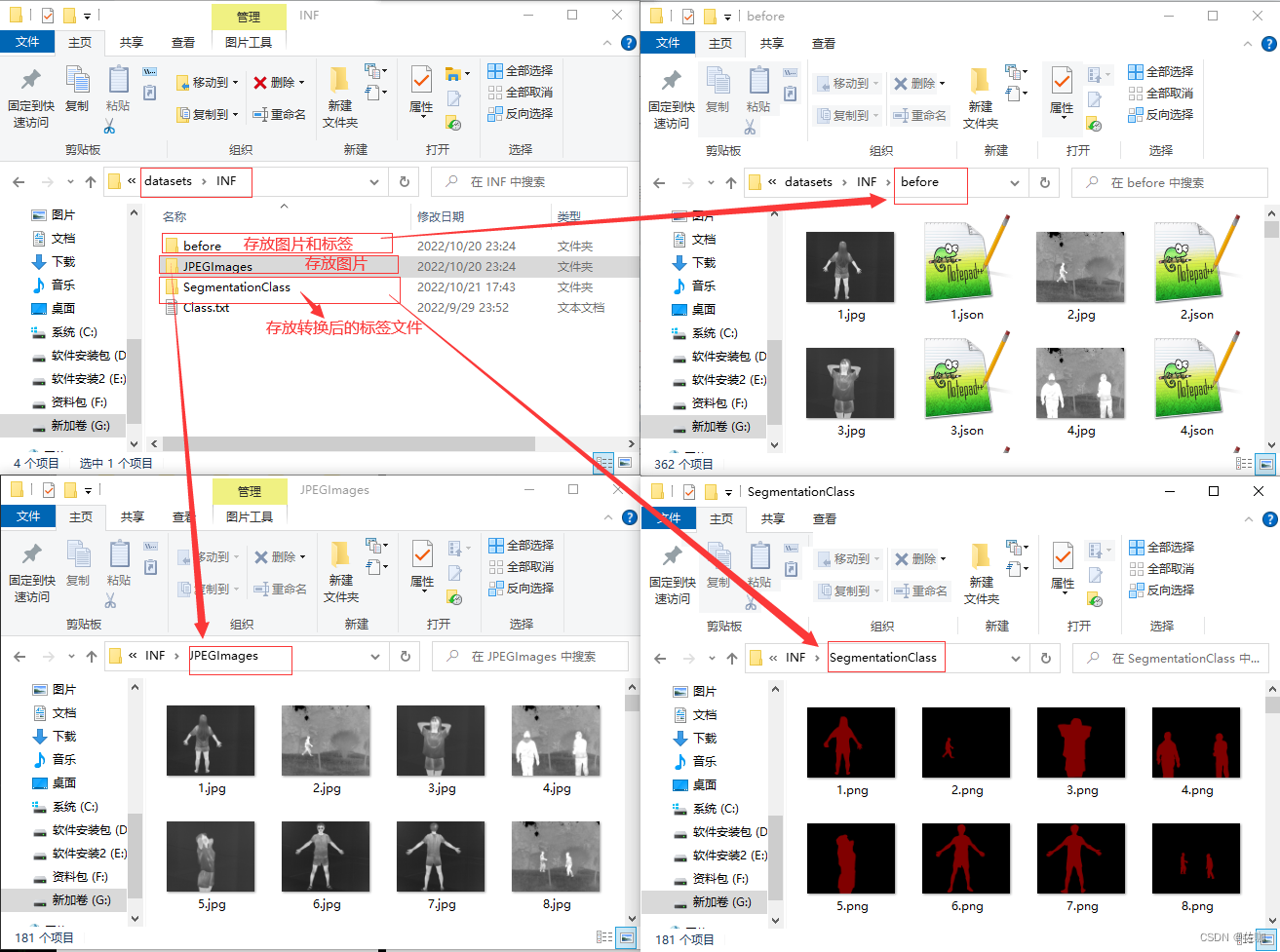

准备好的数据集先存放到工程文件夹下的datasets文件下,具体的文件存放位置关系见下:

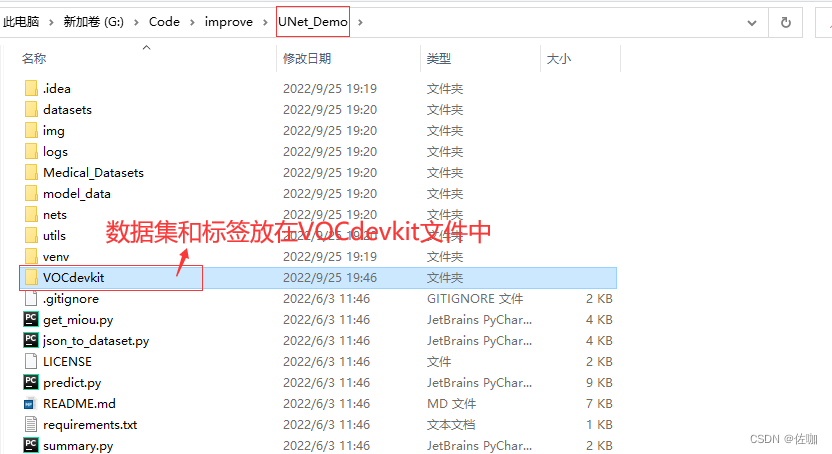

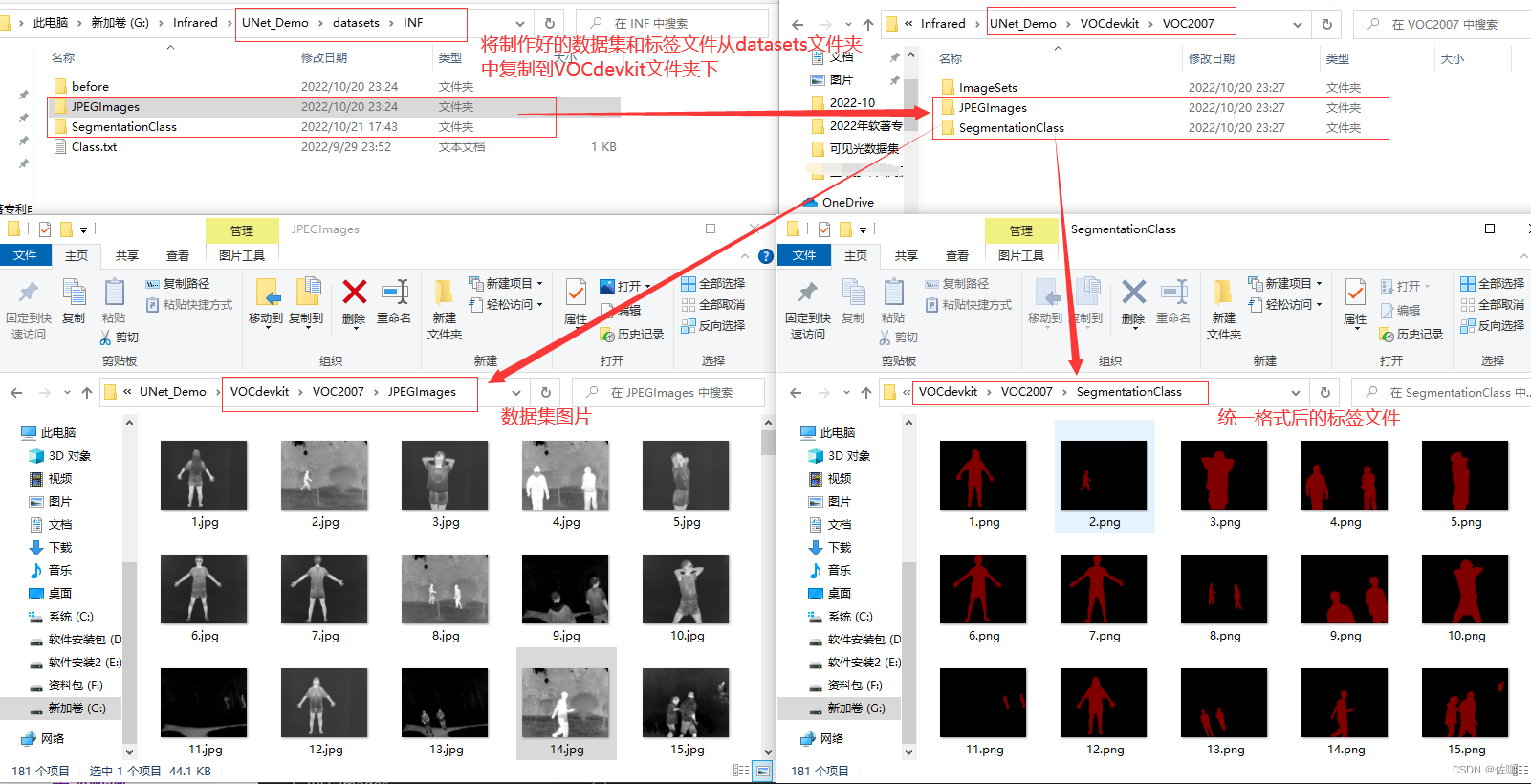

3.2 复制数据集和标签文件到VOCdevkit文件中

通过上面步骤制作好标签文件后,将数据集和标签文件从datasets文件中复制一份到VOCdevkit文件中,具体见下:

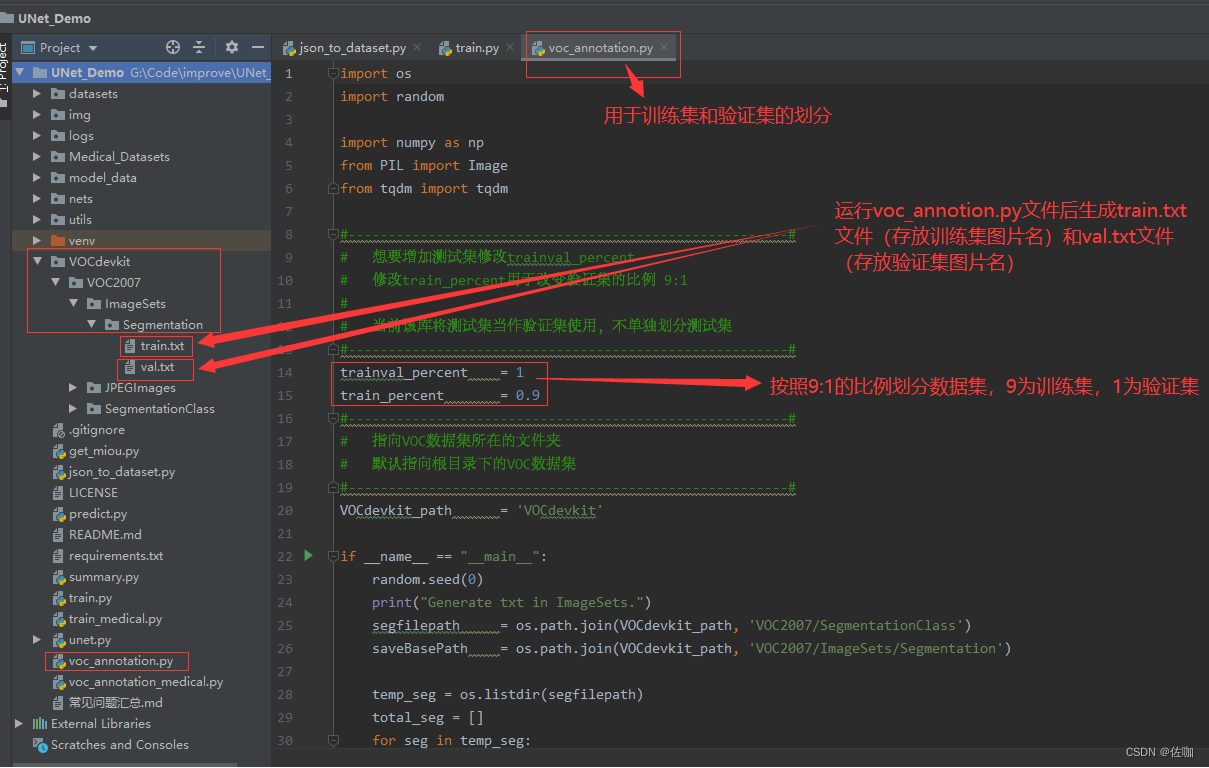

3.3 提取训练集和验证集图片名称

代码中需要修改到的地方见下:

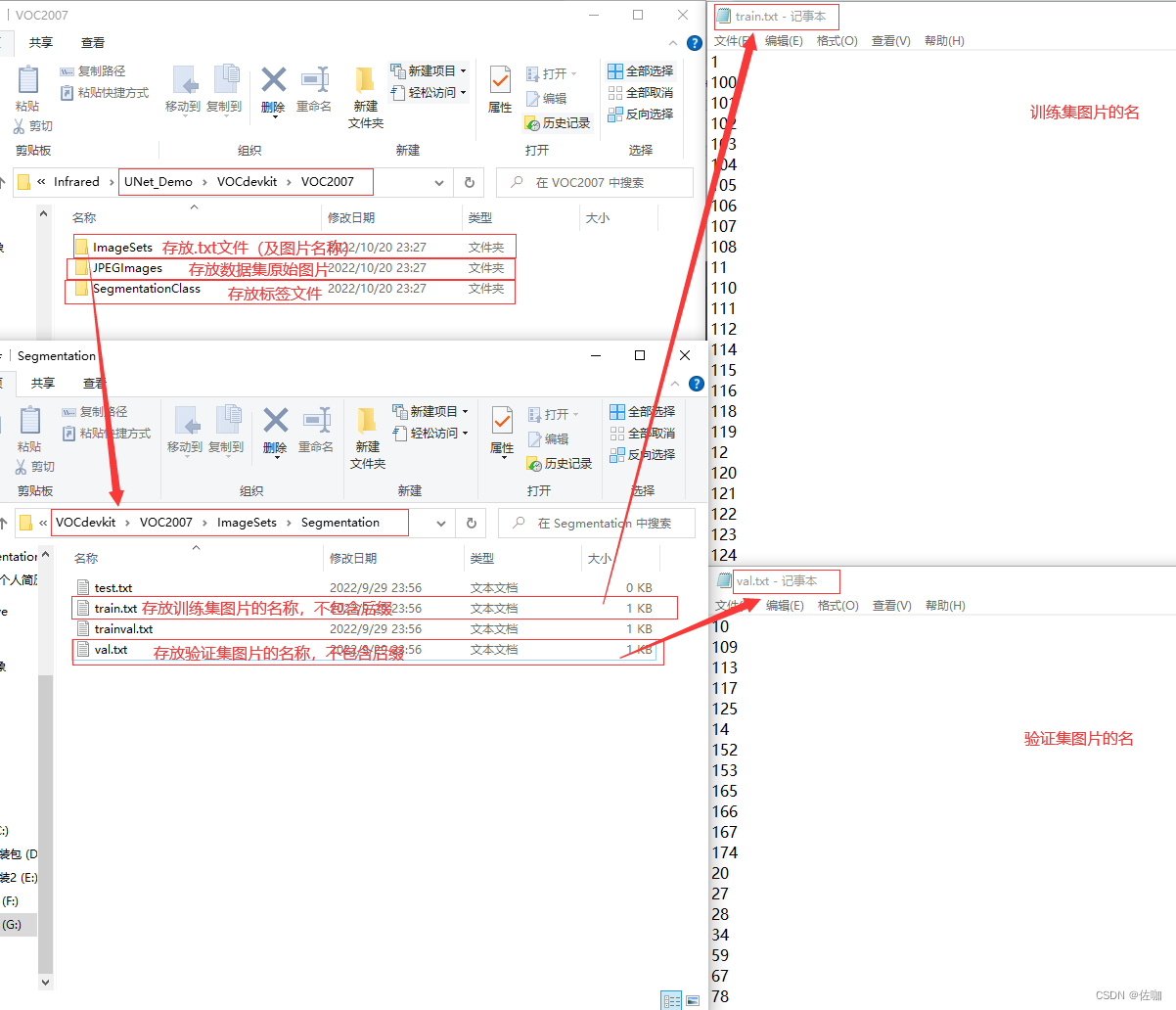

学者只要运行源码包中的voc_annotion.py文件后,就可以在 ./VOCdevkit/VOC2007/ImageSets/Segmentation目录下自动生成train.txt和val.txt文件,具体见下:

四、训练

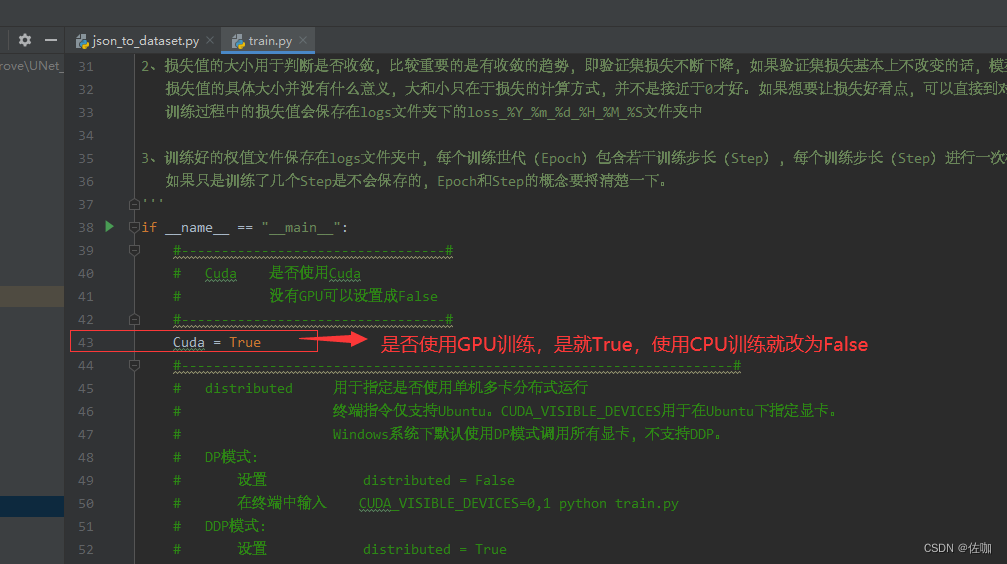

4.1 训练参数的修改

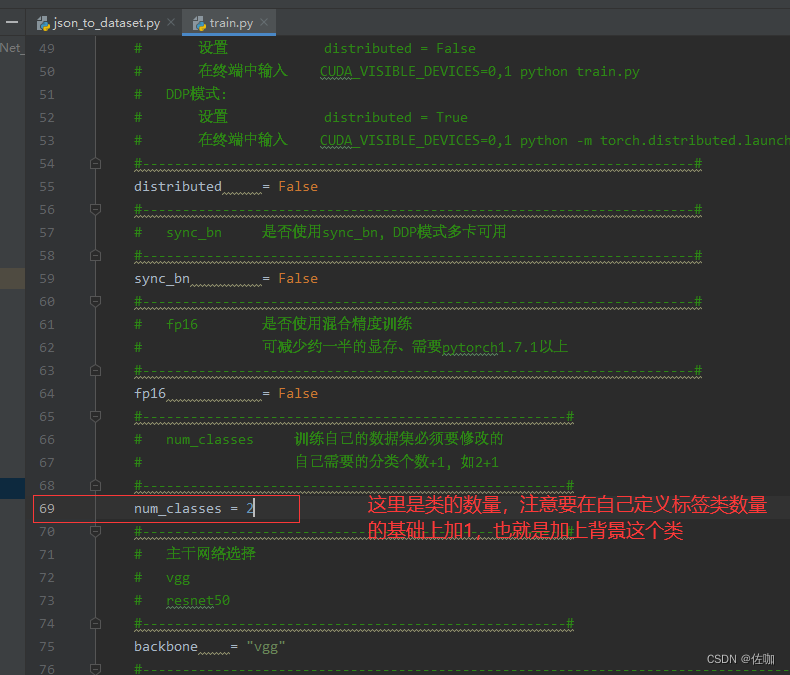

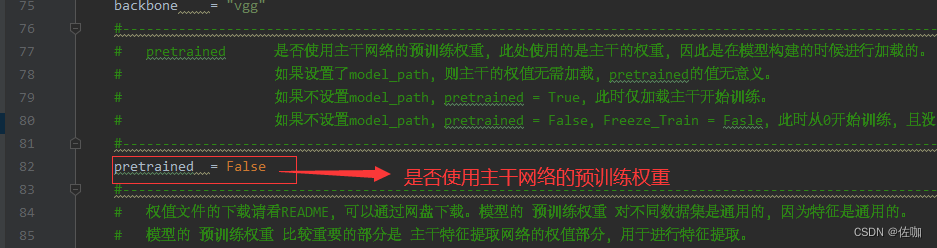

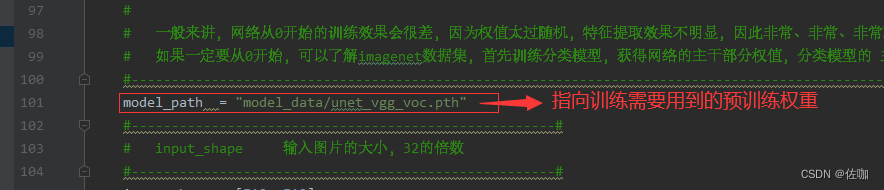

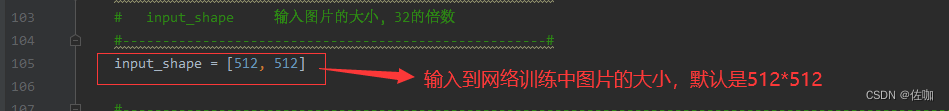

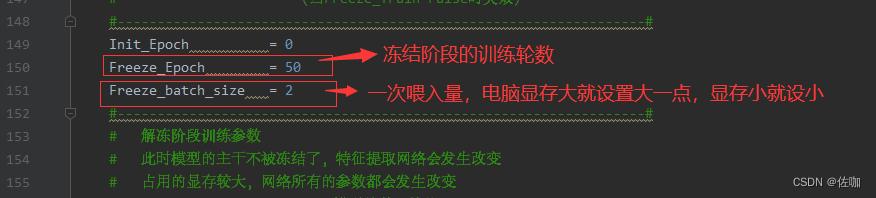

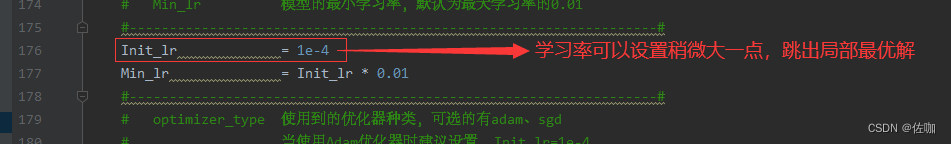

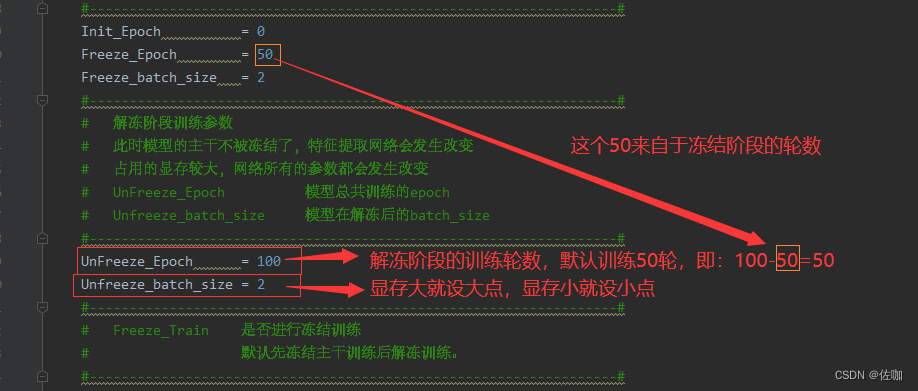

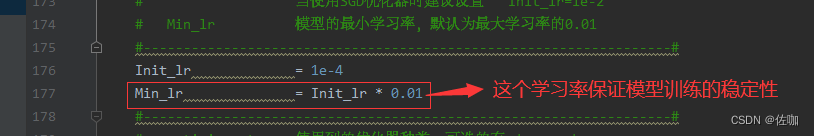

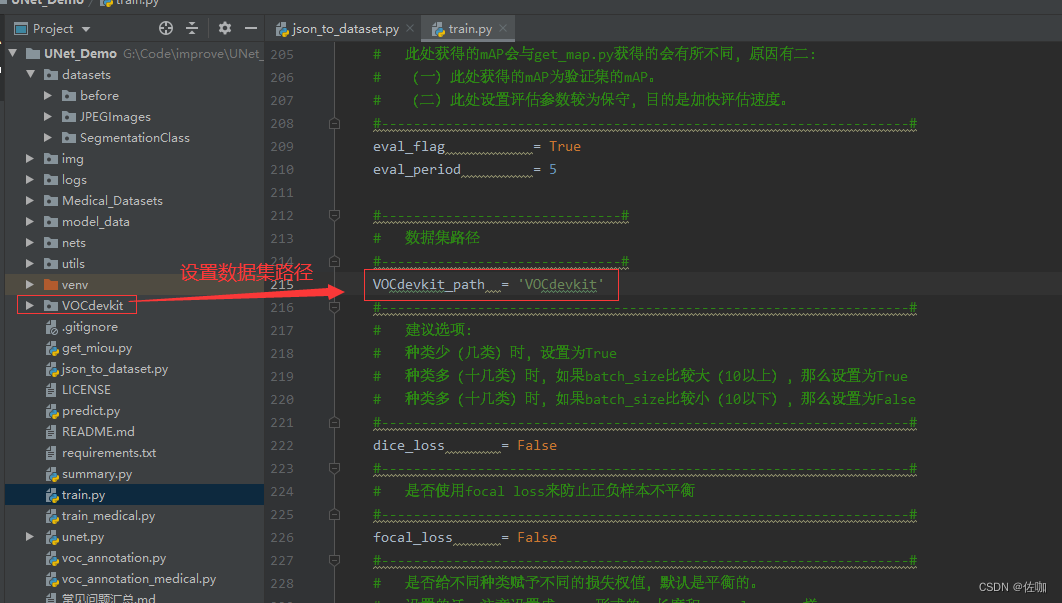

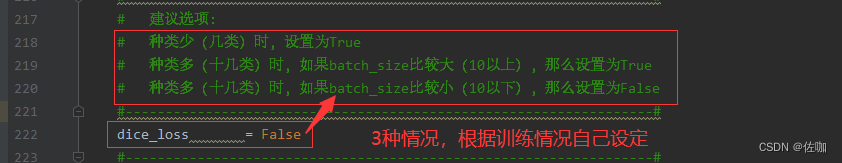

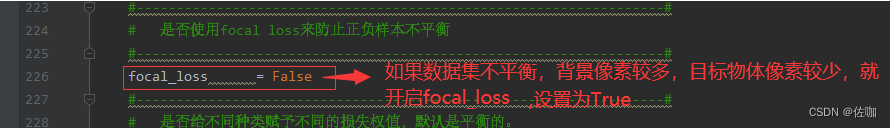

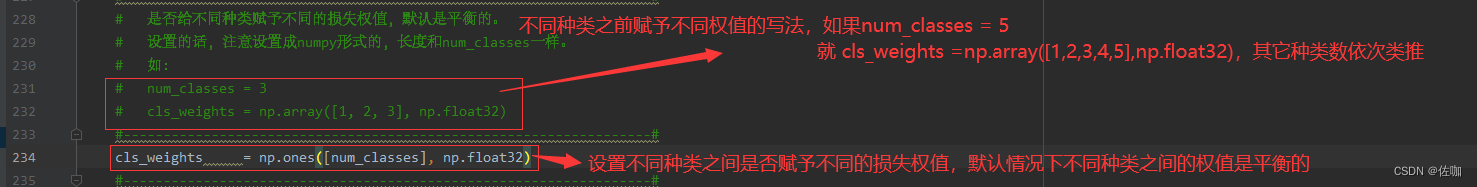

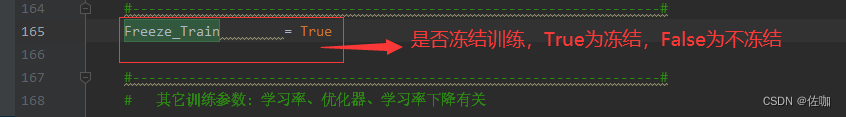

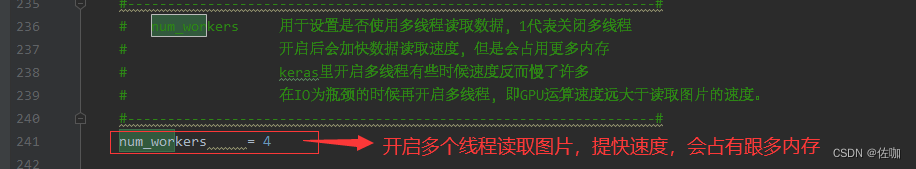

下面有很多的参数可以修改,学者根据自己的训练情况进行修改即可,训练修改的参数都在train.py文件中,具体见下:

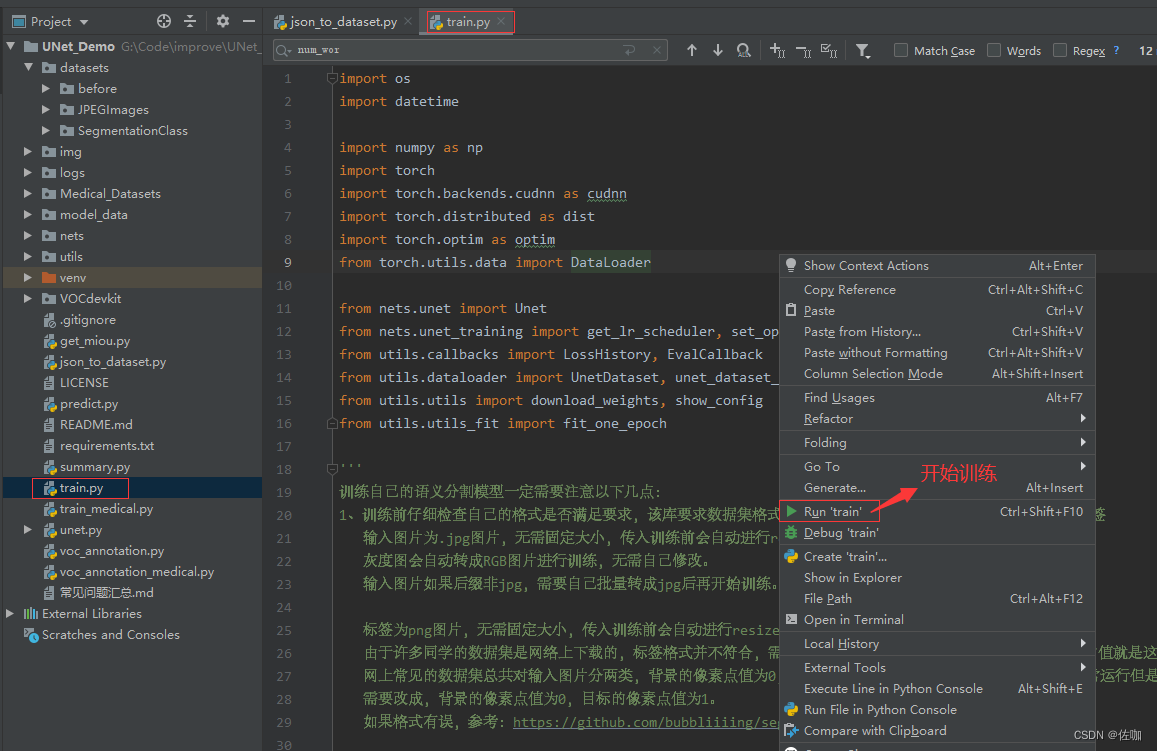

4.2 开始训练

上面的参数修改好后,直接运行train.py文件就开始训练了,见下:

五、模型测试

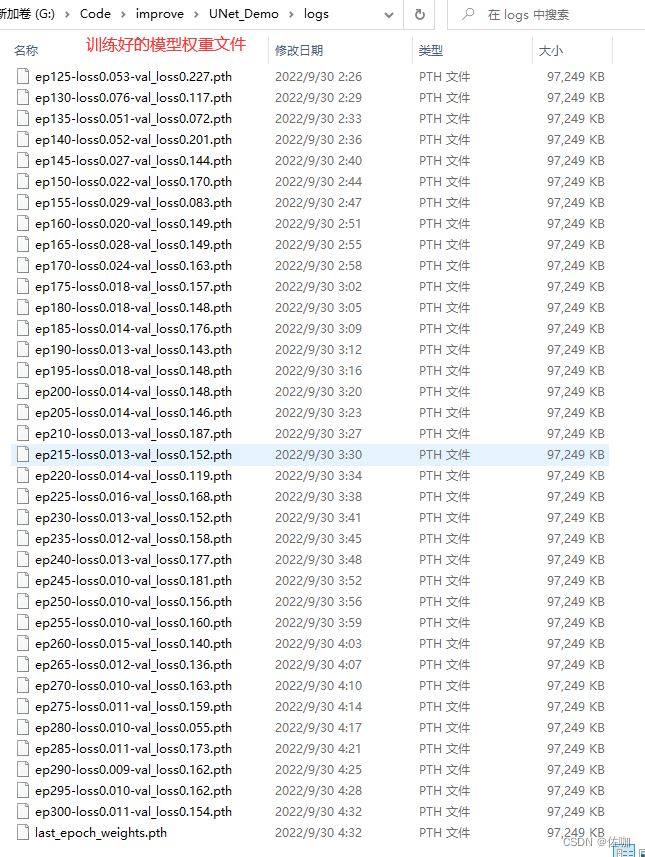

5.1 保存模型权重文件

上面的训练好后,模型都会被保存到工程文件夹根目录中的logs文件中,见下:

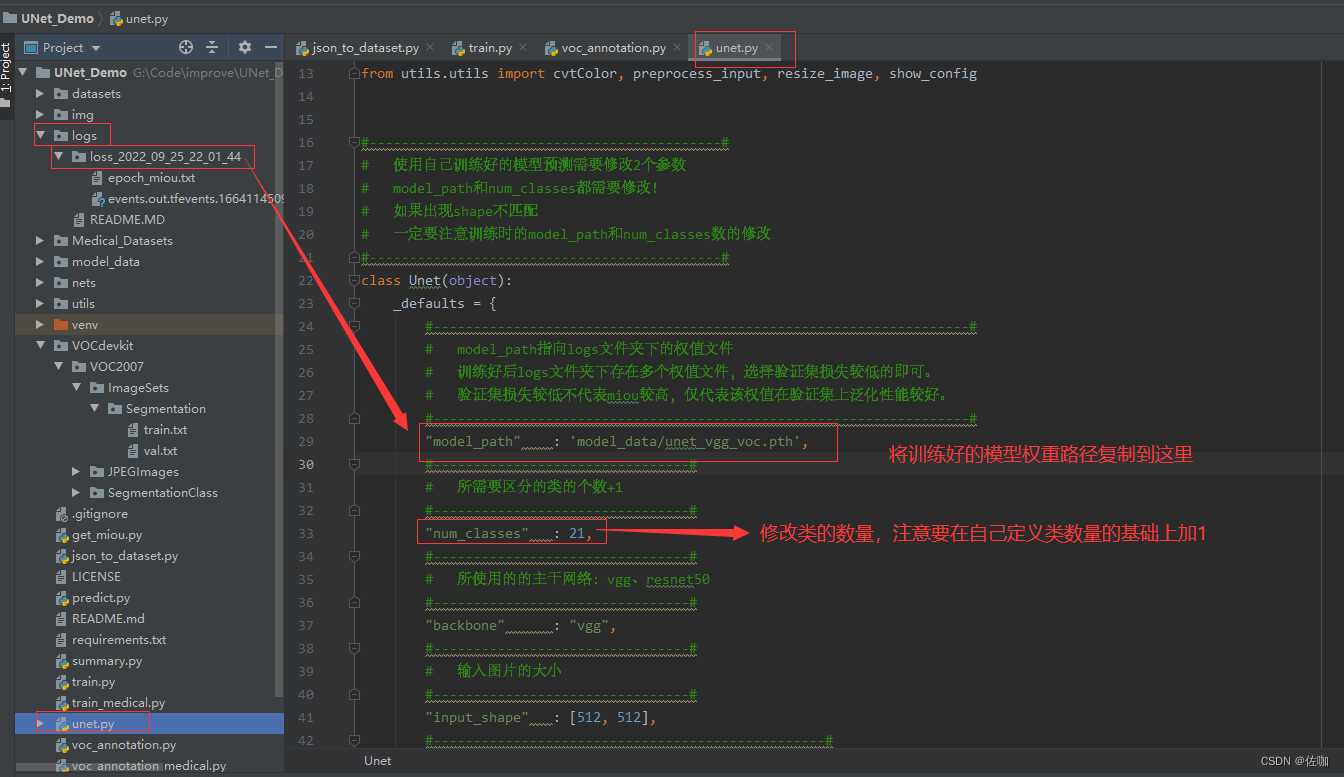

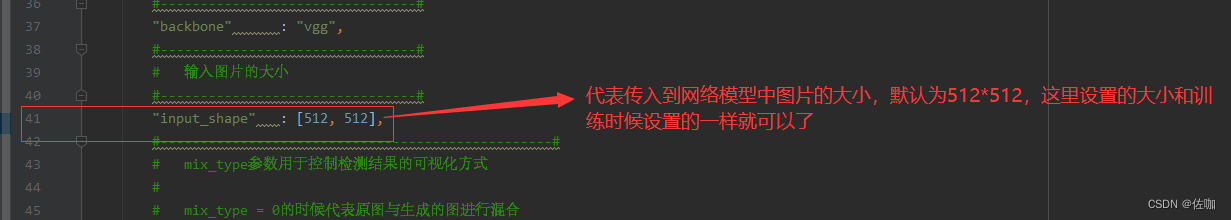

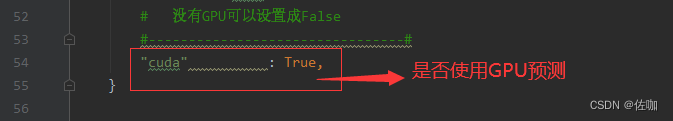

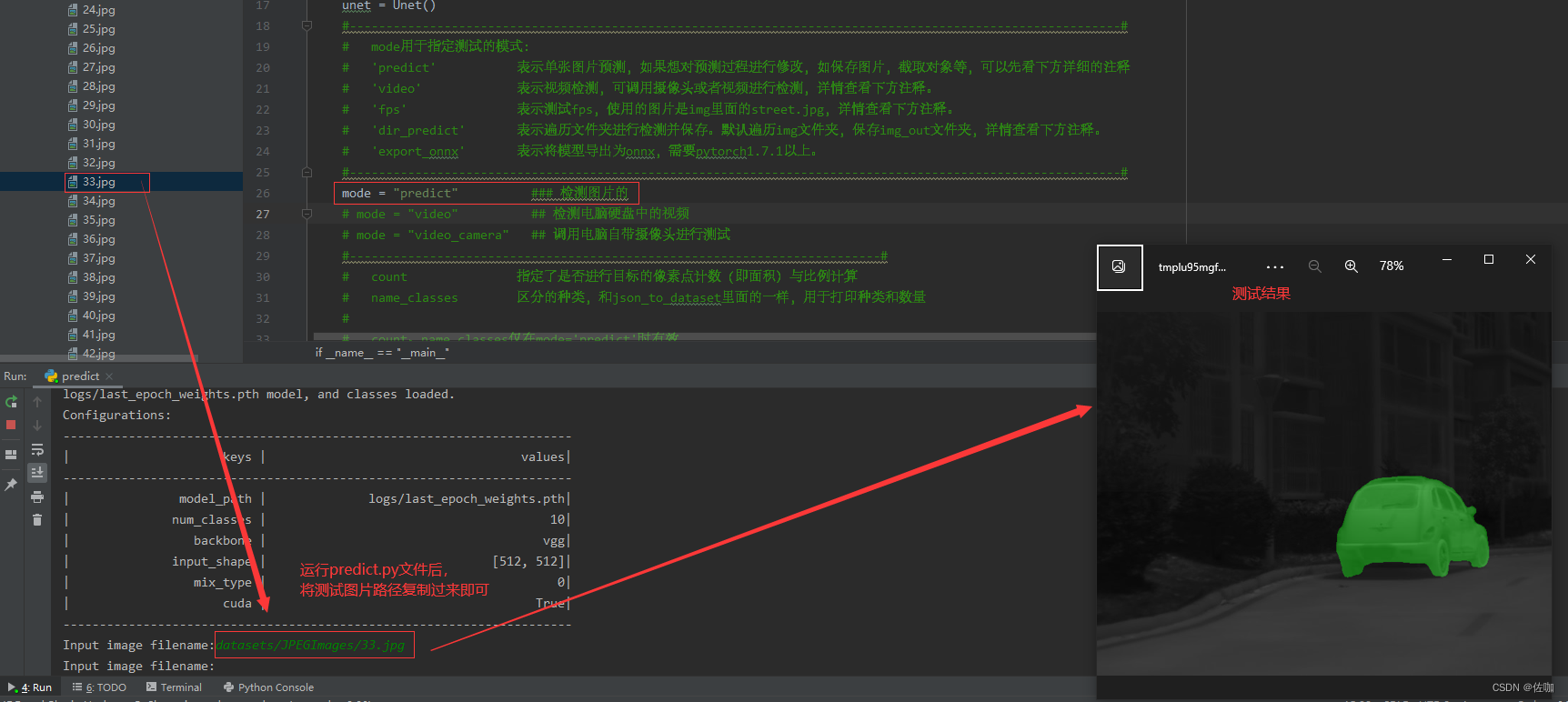

5.2 修改模型测试参数

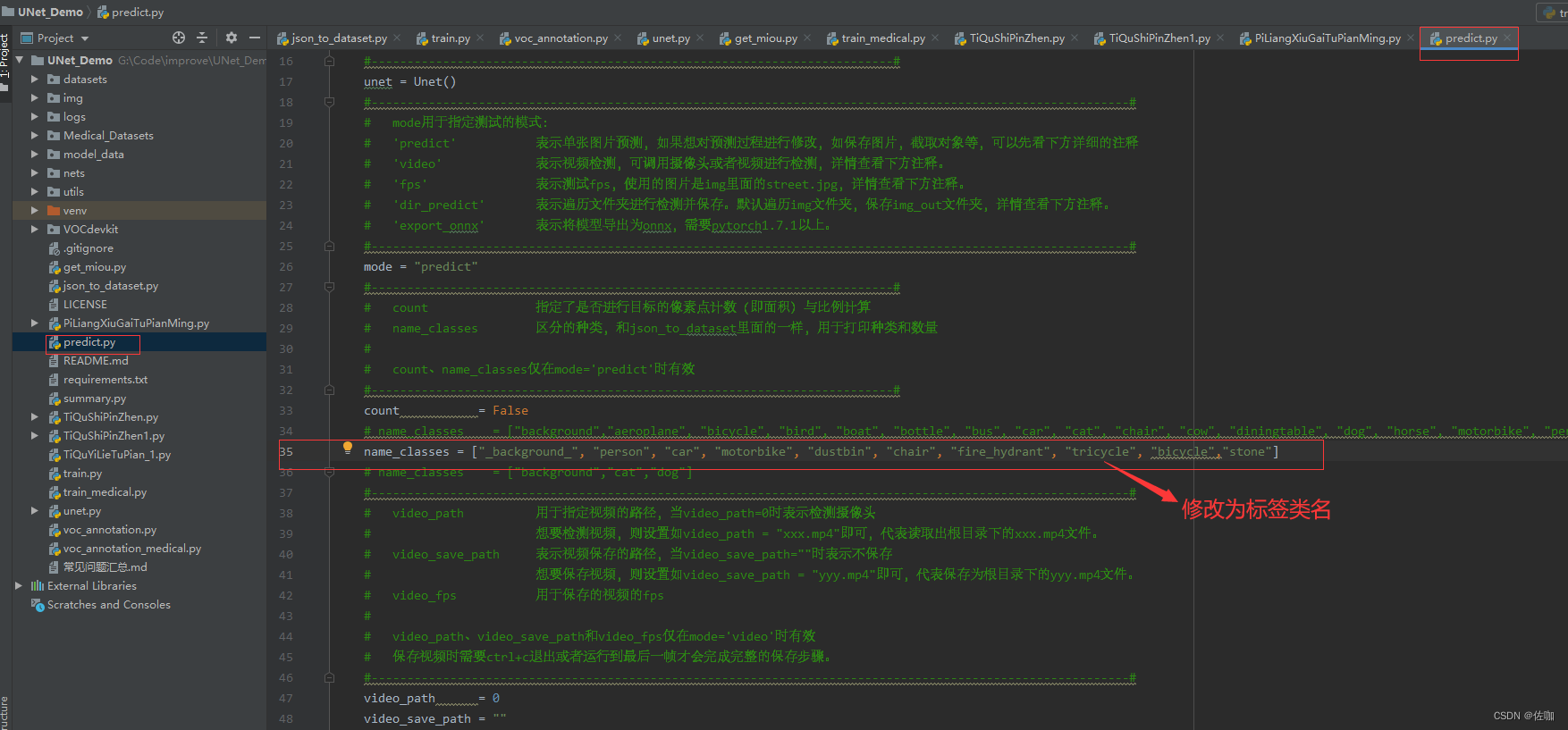

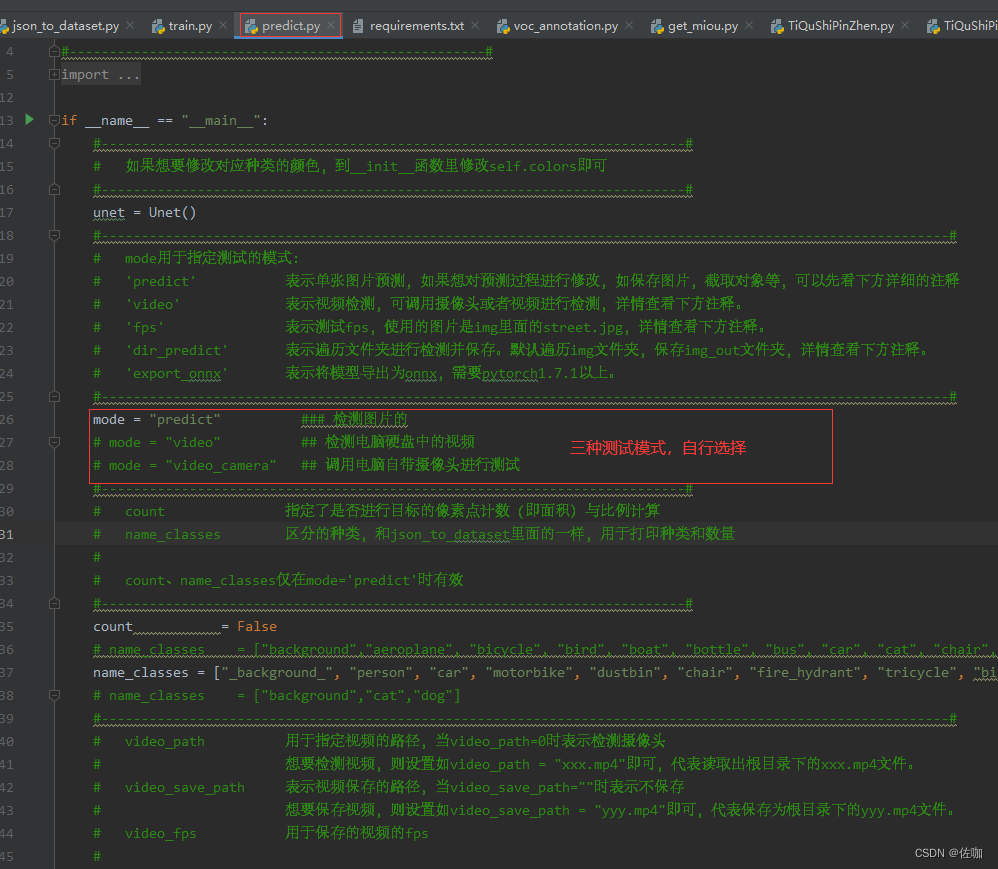

测试模型时,需要修改到的地方见下:

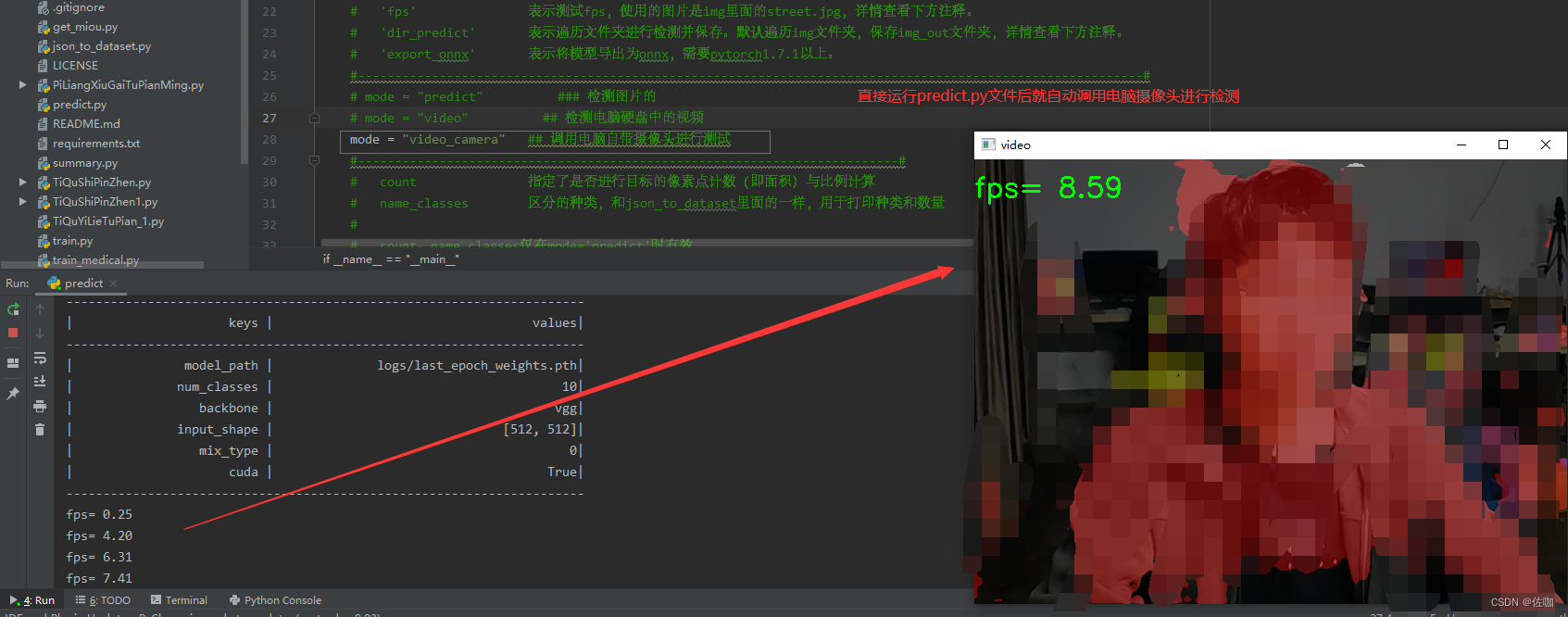

学者在测试的时候,有三种模式可以选择,(1)测试图片;(2)测试电脑硬盘中的视频;(3)调用电脑自带摄像头测试。三种模式的选择,学者修改下面代码即可,见下:

5.3 模型推理测试

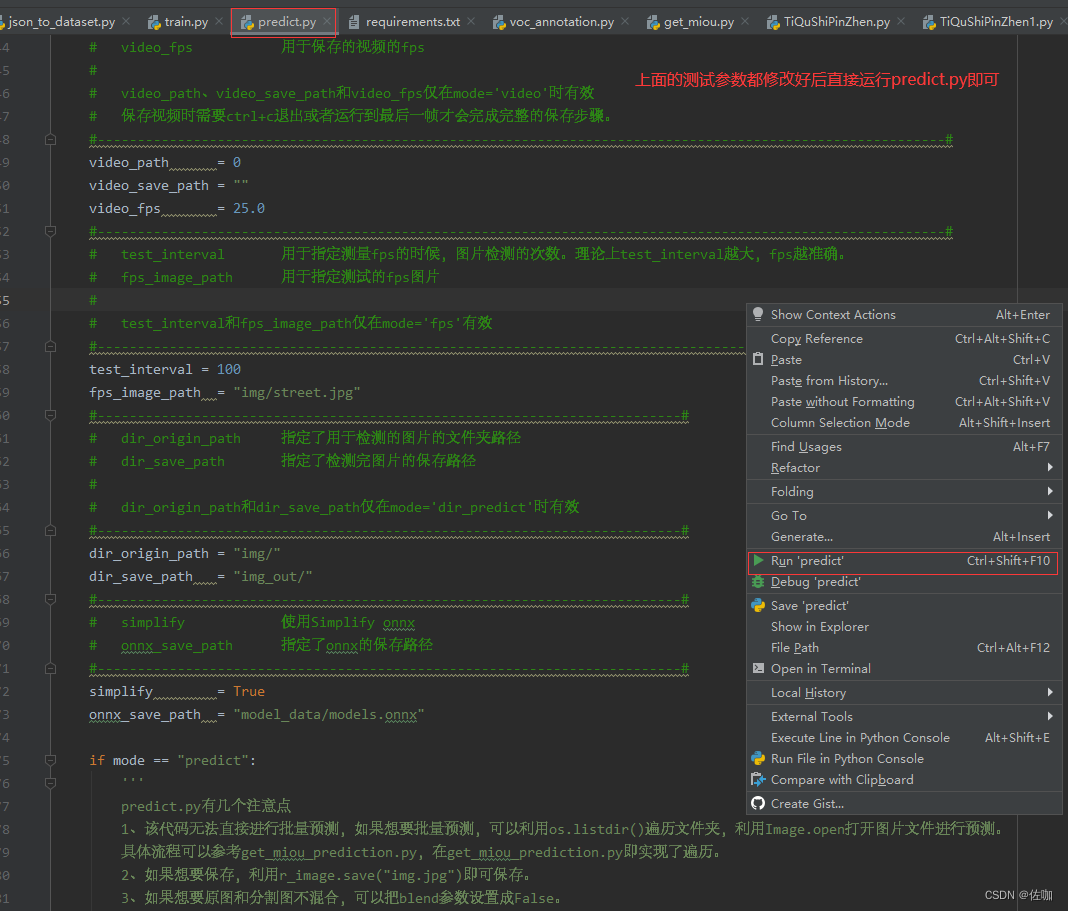

上面的模型测试参数修改好后,直接运行predict.py即可开始预测:

5.3.1 单帧图片测试

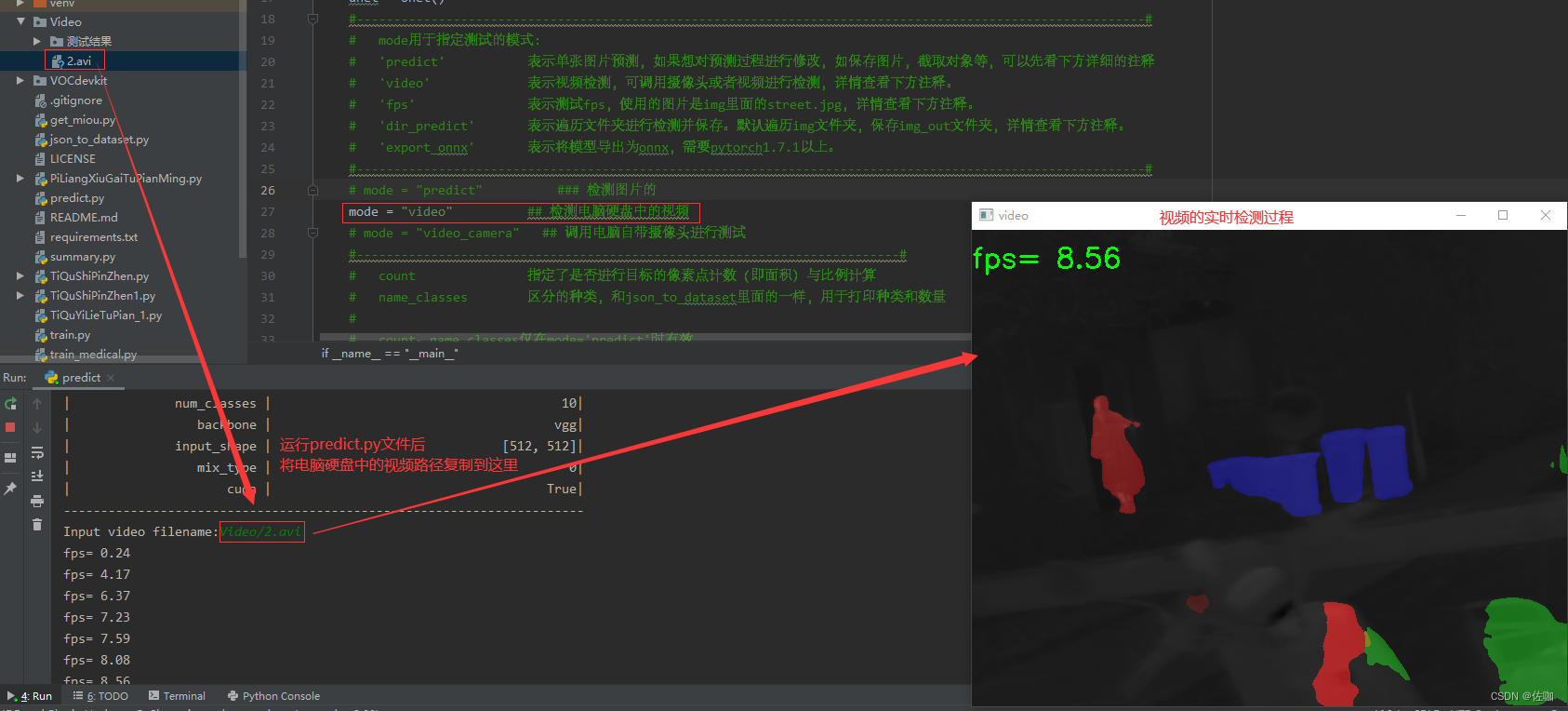

5.3.2 电脑硬盘中视频测试

5.3.3 调用电脑自带摄像头测试

六、总结

以上就是使用UNet做图像语义分割,自己打标签训练的详细教程,参数调整部分,学者根据需求自行调整,很多参数保持默认即可,参数name_classes的数量和类名一定要根据自己数据集修改。希望我总结的教程帮你快速上手使用。

总结不易,多多支持,谢谢!