- 1Android进阶——AIDL详解_android aidl

- 2【Python】成功解决ValueError: not enough values to unpack (expected 2, got 1)_python中出现value error:not enough values to unpack 怎

- 3Metaio in Unity3d 教学--- 四.再谈谈图片扫描之tracking配置文件

- 4yolov9目标检测可视化图形界面GUI源码

- 5stm32的hal库软件模拟iic通信学习(以M24C02/AT24C02为例) 从数据手册到配置到代码看这一个就够啦

- 6Android开发中遇到的报错及解决方法_@defaultvalue' not applicable to field

- 7Cisco:DHCP自动获取IP地址_思科dhcp自动获取ip地址

- 8【WMCA】《Biometric Face Presentation Attack Detection with Multi-Channel Convolutional Neural Network》_wmca数据集

- 9C++ 疑难点

- 10给一段文本提出重点内容,并完成摘要,用python写成代码

数据分析——最小二乘法建立线性回归方程(最简单的一元线性模型为例)

赞

踩

概述

别看公式多,其实很简单

最小二乘法其实又叫最小平方法,是一种数据拟合的优化技术。实质上是利用最小误差的平方寻求数据的最佳匹配函数,利用最小二乘法可以便捷的求得未知的数据,起到预测的作用,并且是的这些预测的数据与实际数据之间的误差平方和达到最小。一般应用在曲线拟合的目的上。

原理

本篇文章不考虑其他方面的应用,我们用最简单的实例说明最小二乘法的工作原理与其内在含义。

当我们在研究两个变量(x,y)之间的相互关系时,往往会有一系列的数据对[(x1,y1),(x2,y2)... (xm,ym)],那么将这些数据描绘到x-y直系坐标中若发现这些点都在一条直线附近时,那么初始令这条直线方程的表达式为

其中 是任意的实数,现在需要让当 x 取值为

预测值

与回归方程所预测的

之间的差值平方最小,但是对于整个回归方程而言,就是所有预测值与实际值之间差值平方之和最小。

如果你要是问我,为什么要用预测值与真实值之间的差值。因为想要需要比较两个Y值,必须有个不变的因子那就是X,在同一个X下比较两种Y才有意义。如果你又问,为什么要平方,那是因为两个Y值之间做差值总会有正负的性质,而这是一个距离问题,是一个标量,所以平方。

故建立一下方程:

Q为关于预测方程中两个参数的函数而已,此时将预测方程(有的人也叫拟合函数)带入以上公式得到以下方程:

要使的方程Q的取值最小,那么需要对函数Q分别对求一阶偏导数,并且零偏导之后的值为0。即

然后,郁闷了一波,为什么要等于0才行啊?哎!因为函数Q是一个进行平方擦操作了的,那么Q大致的曲线就是一个凹形曲线咯,当分别对两个变量求偏导之后等于零时Q肯定处于曲线的最低点,这样也满足了预测值与真实值距离最近的条件了。

接下来就需要对两个参数进行变换求解了,经过一顿移项变换操作之后得到两个参数关于x和y的表达式。

我靠,敲得我头都晕了眼也花了,公式很难敲,关键是态度要到位。

实例应用

该例子数据引用于SPSS生活统计学。

某市欲对货运总量与工业总产值的数量关系进行研究,以便通过工业总产值预测货运总量。现将1991-2000年的数据,列入表中,根据这些数据建立回归方程。

货运总量 2.8 2.9 3.2 3.2 3.4 3.2 3.3 3.7 3.9 4.2

工业总值 25 27 29 32 34 36 35 39 42 45

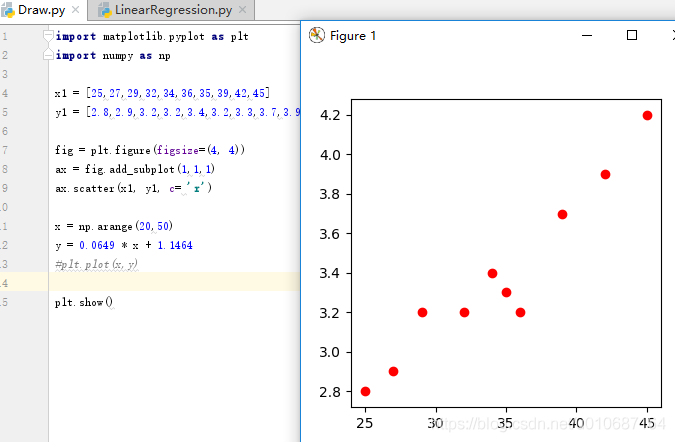

首先观测这些数据是否具有某种直观上的特征,

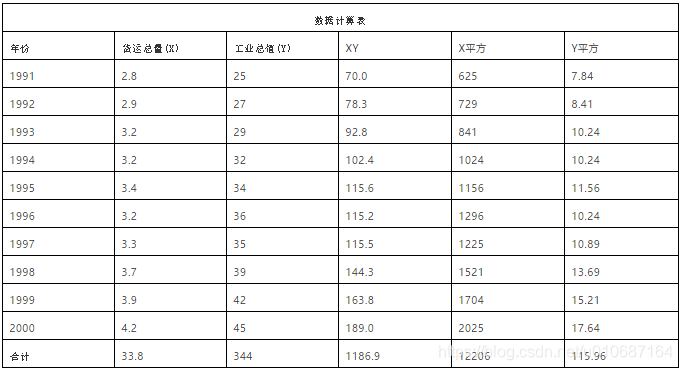

由上图可以直接看出,x与y之间存在着大致的线性关系,所以权当两者就是线性关系。接下来我们计算我们需要用到的数据计算结果xy,x平方与y平方,详见下图。

将这些结果带入公式:

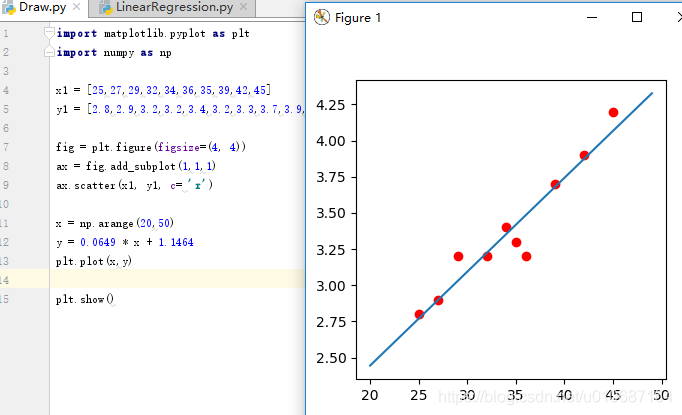

那么线性回归的方程即为

顺便配个图:

这样线性回归的方程就出来了。OK最小二乘法也说了(不是很深,也不是很广,因为自己很菜),例子应用也说了。那么本篇到此结束。