热门标签

热门文章

- 12023华为od机试C卷【分配土地】C语言 实现_华为 od 题库 土地分配 c语言

- 2python汉诺塔编程代码_汉诺塔python代码

- 3工业机器人技术基础及其应用总结_悬臂式搬运机器人的大多数结构为

- 4HarmonyOS 鸿蒙开发DevEco Studio:命令行hdc使用指导_鸿蒙hdc命令事件输入

- 5节日里程序员的朋友圈里,个个都是戏精

- 6【业务功能篇57】Springboot + Spring Security 权限管理 【上篇】_springboot springsecurity权限控制

- 7visual studio code + react 开发环境搭建(转载)_visual studio code 配置rn环境

- 8毕设分享 基于Python大数据的电影可视化分析系统(源码+论文)

- 9循环生成el-descriptions-item_el-descriptions-item v-for

- 10蜣螂算法DBO多无人机协同集群避障路径规划(目标函数:路径、高度、威胁、转角)【含Matlab源码 4124期】

当前位置: article > 正文

重磅!Grok-1开源,下载地址_grok下载

作者:小小林熬夜学编程 | 2024-04-14 04:57:26

赞

踩

grok下载

重磅!Grok-1开源,下载地址

2024年3月19日凌晨,马斯克旗下大模型公司 xAI 宣布正式开源 3140 亿参数的混合专家(MoE)模型「Grok-1」,以及该模型的权重和网络架构。

这也使得Grok-1成为当前参数量最大的开源大语言模型。

Grok-1 的模型细节包括如下:

- 基础模型基于大量文本数据进行训练,没有针对任何具体任务进行微调;

- 3140 亿参数的 MoE 模型,在给定 token 上的激活权重为 25%;

- 2023 年 10 月,xAI 使用 JAX 库和 Rust 语言组成的自定义训练堆栈从头开始训练。

xAI 遵守 Apache 2.0 许可证来开源 Grok-1 的权重和架构。Apache 2.0 许可证允许用户自由地使用、修改和分发软件,无论是个人还是商业用途。项目发布短短四个小时,已经揽获 3.4k 星标,热度还在持续增加。

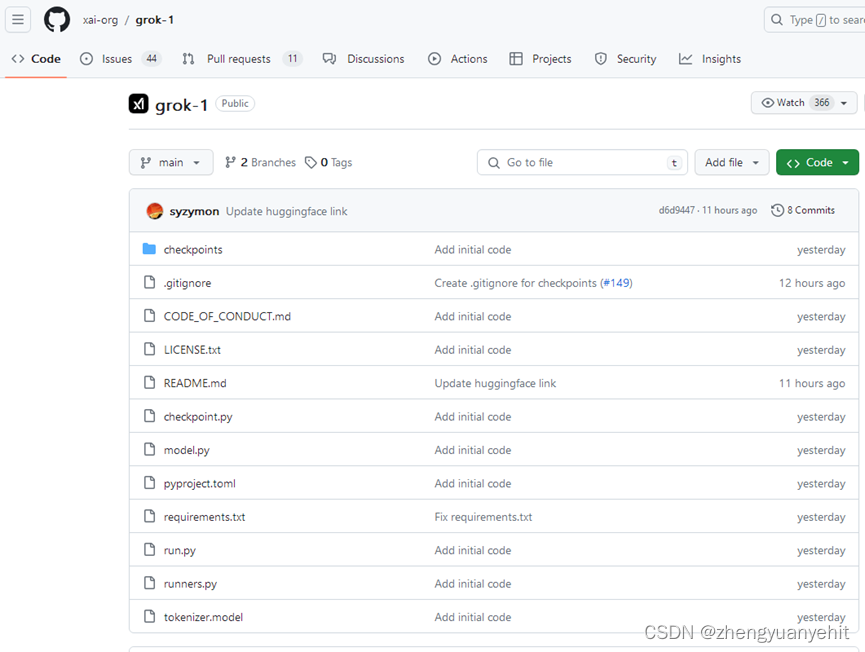

xAI Grok 开源地址:

https://github.com/xai-org/grok-1

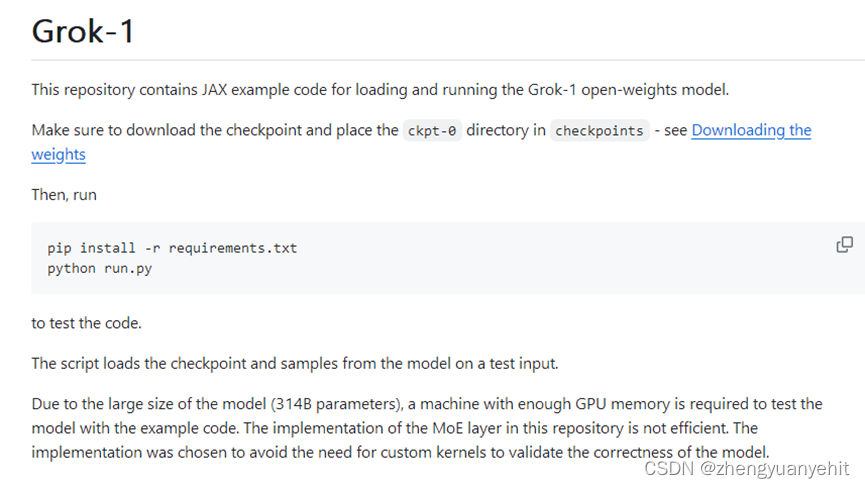

该存储库包含用于加载和运行 Grok-1 开放权重模型的 JAX 示例代码。使用之前,用户需要确保先下载 checkpoint,并将 ckpt-0 目录放置在 checkpoint 中, 然后,运行下面代码进行测试:

pip install -r requirements.txt

python run.py

项目说明中明确强调,由于 Grok-1 是一个规模较大(314B 参数)的模型,因此需要有足够 GPU 内存的机器才能使用示例代码测试模型。此外,该存储库中 MoE 层的实现效率并不高,之所以选择该实现是为了避免需要自定义内核来验证模型的正确性。

可能需要一台拥有 628 GB GPU 内存的机器(每个参数 2 字节)。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/420299

推荐阅读

相关标签